In unserem Bestreben, das zerstörerische Potenzial künstlicher Intelligenz zu begrenzen, schlägt ein neues Papier der Universität Cambridge vor, Fernauslöser und -sperren, wie sie entwickelt wurden, um den unbefugten Abschuss von Atomwaffen zu verhindern, in die Hardware zu integrieren, die sie antreibt.

Das Papier [PDF], in dem Stimmen von zahlreichen akademischen Institutionen und mehreren von OpenAI enthalten sind, vertritt die Ansicht, dass die Regulierung der Hardware, auf die diese Modelle angewiesen sind, der beste Weg sein könnte, ihren Missbrauch zu verhindern.

„KI-relevante Berechnungen sind ein besonders effektiver Eingriffspunkt: Sie sind nachweisbar, ausschließbar und quantifizierbar und werden über eine extrem konzentrierte Lieferkette produziert“, argumentieren die Forscher.

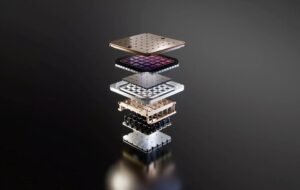

Das Training der produktivsten Modelle, von denen angenommen wird, dass sie eine Billion Parameter überschreiten, erfordert eine immense physische Infrastruktur: Zehntausende GPUs oder Beschleuniger und Wochen oder sogar Monate Verarbeitungszeit. Dies macht es den Forschern zufolge schwer, die Existenz und relative Leistung dieser Ressourcen zu verbergen.

Darüber hinaus werden die fortschrittlichsten Chips, die zum Trainieren dieser Modelle verwendet werden, von einer relativ kleinen Anzahl von Unternehmen wie Nvidia, AMD und Intel hergestellt, was es den politischen Entscheidungsträgern ermöglicht, den Verkauf dieser Waren an betroffene Personen oder Länder zu beschränken.

Diese Faktoren, zusammen mit anderen wie Einschränkungen der Lieferkette bei der Halbleiterfertigung, bieten politischen Entscheidungsträgern die Möglichkeit, besser zu verstehen, wie und wo KI-Infrastruktur eingesetzt wird, wer darauf zugreifen darf und wer nicht, und Strafen für deren Missbrauch durchzusetzen, heißt es in dem Papier .

Kontrolle der Infrastruktur

Das Papier beleuchtet zahlreiche Möglichkeiten, wie politische Entscheidungsträger die Regulierung von KI-Hardware angehen könnten. Viele der Vorschläge – darunter solche, die darauf abzielen, die Sichtbarkeit zu verbessern und den Verkauf von KI-Beschleunigern einzuschränken – werden bereits auf nationaler Ebene umgesetzt.

Im vergangenen Jahr legte US-Präsident Joe Biden einen Vorschlag vor oberster Befehl Ziel war es, Unternehmen zu identifizieren, die große Dual-Use-KI-Modelle entwickeln, sowie die dazu in der Lageen Infrastrukturanbieter sie auszubilden. Falls Sie sich nicht auskennen: „Dual-Use“ bezieht sich auf Technologien, die bei zivilen und militärischen Anwendungen doppelte Aufgaben erfüllen können.

In jüngerer Zeit das US-Handelsministerium vorgeschlage Regulierung, die amerikanische Cloud-Anbieter dazu verpflichten würde, strengere „Know-Your-Customer“-Richtlinien einzuführen, um zu verhindern, dass betroffene Personen oder Länder Exportbeschränkungen umgehen.

Forscher weisen darauf hin, dass diese Sichtbarkeit wertvoll sei, da sie dazu beitragen könnte, ein weiteres Wettrüsten zu verhindern, wie es durch die Kontroverse um die Raketenlücke ausgelöst wurde, bei der fehlerhafte Berichte zu einer massiven Ansammlung ballistischer Raketen führten. Obwohl dies wertvoll ist, warnen sie davor, dass die Einhaltung dieser Meldepflichten die Privatsphäre der Kunden verletzen und sogar dazu führen kann, dass vertrauliche Daten verloren gehen.

Unterdessen hat das Handelsministerium an der Handelsfront seine Arbeit fortgesetzt steigern Beschränkungen, die die Leistung der nach China verkauften Beschleuniger einschränken. Aber wie wir bereits berichtet haben, haben diese Bemühungen es für Länder wie China zwar schwieriger gemacht, an amerikanische Chips zu kommen, sie sind aber alles andere als perfekt.

Um diese Einschränkungen zu beseitigen, haben die Forscher die Einführung eines globalen Registers für KI-Chipverkäufe vorgeschlagen, das diese über ihren gesamten Lebenszyklus hinweg verfolgen würde, selbst nachdem sie ihr Herkunftsland verlassen haben. Ein solches Register, so schlagen sie vor, könnte eine eindeutige Kennung in jeden Chip integrieren, was bei der Bekämpfung hilfreich sein könnte Schmuggel von Komponenten.

Am extremeren Ende des Spektrums haben Forscher vorgeschlagen, dass Kill-Schalter in das Silizium integriert werden könnten, um deren Verwendung in böswilligen Anwendungen zu verhindern.

Theoretisch könnte dies es den Regulierungsbehörden ermöglichen, schneller auf den Missbrauch sensibler Technologien zu reagieren, indem sie den Zugriff auf Chips aus der Ferne sperren. Die Autoren warnen jedoch, dass dies nicht ohne Risiko sei. Dies bedeutet, dass ein solcher Kill-Switch bei falscher Umsetzung zum Ziel von Cyberkriminellen werden könnte.

Ein anderer Vorschlag würde erfordern, dass mehrere Parteien potenziell riskante KI-Trainingsaufgaben absegnen, bevor sie in großem Maßstab eingesetzt werden können. „Atomwaffen nutzen ähnliche Mechanismen, sogenannte permissive action links“, schrieben sie.

Bei Atomwaffen sollen diese Sicherheitsschlösser verhindern, dass eine Person unkontrolliert vorgeht und einen Erstschlag ausführt. Bei der KI besteht die Idee jedoch darin, dass eine Einzelperson oder ein Unternehmen, wenn es ein Modell über einem bestimmten Schwellenwert in der Cloud trainieren möchte, zunächst eine Genehmigung dafür einholen muss.

Obwohl es sich um ein wirksames Werkzeug handelt, beobachten die Forscher, dass dies nach hinten losgehen könnte, indem es die Entwicklung wünschenswerter KI verhindert. Das Argument scheint zu sein, dass der Einsatz von Atomwaffen zwar ein ziemlich eindeutiges Ergebnis hat, KI aber nicht immer so schwarz und weiß ist.

Aber wenn Ihnen das etwas zu dystopisch vorkommt, widmet das Papier einen ganzen Abschnitt der Umverteilung von KI-Ressourcen zum Wohle der Gesellschaft als Ganzes. Die Idee dahinter ist, dass politische Entscheidungsträger zusammenkommen könnten, um KI-Rechnungen für Gruppen zugänglicher zu machen, die sie wahrscheinlich nicht für böse Zwecke nutzen, ein Konzept, das als „Zuteilung“ bezeichnet wird.

Was ist falsch daran, die KI-Entwicklung zu regulieren?

Warum sich all diese Mühe machen? Nun, die Autoren des Papiers gehen davon aus, dass physische Hardware von Natur aus einfacher zu kontrollieren ist.

Im Vergleich zur Hardware „sind andere Inputs und Outputs der KI-Entwicklung – Daten, Algorithmen und trainierte Modelle – leicht gemeinsam nutzbare, nicht konkurrierende immaterielle Güter, was ihre Kontrolle von Natur aus schwierig macht“, heißt es in dem Papier.

Das Argument ist, dass es, sobald ein Modell veröffentlicht wird, sei es öffentlich oder durchgesickert, nicht mehr möglich ist, den Geist wieder in die Flasche zu stecken und seine Verbreitung im Netz zu stoppen.

Die Forscher betonten außerdem, dass sich die Bemühungen zur Verhinderung des Missbrauchs von Modellen als unzuverlässig erwiesen hätten. In einem Beispiel hoben die Autoren die Leichtigkeit hervor, mit der Forscher in Metas Llama 2 Sicherheitsvorkehrungen abbauen konnten, die verhindern sollten, dass das Modell anstößige Sprache erzeugt.

Im Extremfall wird befürchtet, dass ein hinreichend fortgeschrittenes Dual-Use-Modell zur Beschleunigung eingesetzt werden könnte Entwicklung von chemischen oder biologischen Waffen.

Das Papier räumt ein, dass die Regulierung von KI-Hardware kein Allheilmittel ist und die Notwendigkeit einer Regulierung in anderen Bereichen der Branche nicht beseitigt.

Allerdings ist die Beteiligung mehrerer OpenAI-Forscher angesichts der Beteiligung von CEO Sam Altman kaum zu ignorieren Versuche um die Erzählung rund um die KI-Regulierung zu kontrollieren. ®

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://go.theregister.com/feed/www.theregister.com/2024/02/16/boffins_propose_regulating_ai_hardware/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 7

- a

- Fähig

- Missbrauch

- AC

- akademisch

- beschleunigen

- Beschleuniger

- Zugang

- zugänglich

- über

- Action

- Adresse

- advanced

- Nach der

- AI

- KI-Modelle

- KI-Training

- gezielt

- Algorithmen

- Alle

- Zuteilung

- erlauben

- erlaubt

- Zulassen

- entlang

- bereits

- ebenfalls

- immer

- AMD

- amerikanisch

- an

- und

- Ein anderer

- Anwendungen

- Ansatz

- SIND

- argumentieren

- Argument

- Waffen

- um

- künstlich

- künstliche Intelligenz

- AS

- Aspekte

- At

- Genehmigung

- Autoren

- vermeiden

- Zurück

- BE

- werden

- Bevor

- Sein

- angenommen

- BESTE

- Besser

- Besserung

- Biden

- Schwarz

- bauen

- aber

- by

- namens

- Cambridge

- CAN

- fähig

- Häuser

- CEO

- sicher

- Kette

- chemisch

- China

- Chip

- Pommes frites

- Zivilist

- Cloud

- CO

- Bekämpfung

- wie die

- Geschäfte

- Unternehmen

- Unternehmen

- Komponenten

- Berechnen

- Konzentriert

- konzept

- Hautpflegeprobleme

- Berücksichtigung

- Einschränkungen

- weiter

- Smartgeräte App

- Kontroverse

- könnte

- Ländern

- Land

- Kurs

- Kunde

- Schneiden

- Cyber-Kriminelle

- technische Daten

- Abteilung

- Einsatz

- beschrieben

- entworfen

- entwickelt

- Entwicklung

- Entwicklung

- schwer

- do

- doesn

- Dabei

- doppelt

- dystopischen

- jeder

- erleichtern

- einfacher

- leicht

- Effektiv

- Bemühungen

- entweder

- beseitigen

- beschäftigt

- Ende

- erzwingen

- Ganz

- Sogar

- Beispiel

- überschreiten

- Ausführung

- Existenz

- exportieren

- Extrem

- äußerst

- Faktoren

- vertraut

- weit

- beschleunigt

- gefürchtet

- fühlt sich

- Vorname

- Aussichten für

- vorwärts

- für

- Materials des

- Lücke

- Erzeugung

- Genie

- bekommen

- bekommen

- Global

- Go

- gehen

- Waren

- GPUs

- Gruppen

- Hände

- hart

- Schwerer

- Hardware

- Haben

- Hilfe

- Verbergen

- Besondere

- Highlights

- Ultraschall

- aber

- HTTPS

- Idee

- Kennzeichnung

- Identifizierung

- if

- ignorieren

- immens

- implementieren

- umgesetzt

- Umsetzung

- zu unterstützen,

- in

- In anderen

- Dazu gehören

- Einschließlich

- integrieren

- falsch

- Krankengymnastik

- Energiegewinnung

- Infrastruktur

- von Natur aus

- Eingänge

- Institutionen

- immaterielle

- Intel

- Intelligenz

- Intervention

- in

- isn

- IT

- SEINE

- JOE

- Joe Biden

- jpg

- Töten

- Art

- Sprache

- grosse

- starten

- Start

- führen

- geführt

- links

- Niveau

- Lebenszyklus

- Gefällt mir

- LIMIT

- Einschränkungen

- Begrenzung

- Links

- wenig

- Lama

- Schlösser

- gemacht

- um

- MACHT

- Making

- böswilligen

- Herstellung

- viele

- massiv

- Kann..

- Mittel

- gemeint

- Mechanismen

- Meta

- könnte

- Militär

- Militärische Anwendungen

- Raketen

- Missbrauch

- Modell

- für

- Monat

- mehr

- vor allem warme

- mehrere

- NARRATIVE

- National

- Need

- Netto-

- Neu

- nicht

- beachten

- Kernenergie

- Anzahl

- und viele

- Nvidia

- beobachten

- of

- WOW!

- Offensive

- bieten

- on

- einmal

- EINEM

- XNUMXh geöffnet

- OpenAI

- or

- Herkunft

- Andere

- Anders

- UNSERE

- Ergebnis

- Ausgänge

- übrig

- Papier

- Parameter

- Frage der Teilnhabe

- besonders

- Parteien

- Strafen

- perfekt

- Leistung

- person

- Personen

- physikalisch

- Plato

- Datenintelligenz von Plato

- PlatoData

- spielend

- Points

- Politik durchzulesen

- Politiker

- potent

- Potenzial

- möglicherweise

- Kräfte

- Präsident

- Präsident Joe Biden

- ziemlich

- verhindern

- Verhütung

- vorher

- Datenschutz

- Verarbeitung

- Produziert

- produktiv

- Angebot

- vorgeschlage

- zuverlässig

- Anbieter

- veröffentlicht

- setzen

- Putting

- quantifizierbar

- Suche

- Rennen

- RE

- kürzlich

- bezieht sich

- Registratur

- Regulieren

- Regel

- Rechtliches

- Regulators

- relativ

- verhältnismäßig

- verlassen

- entfernt

- entfernt

- Berichtet

- Reporting

- Meldungen

- erfordern

- Voraussetzungen:

- erfordert

- Forscher

- Downloads

- Reagieren

- eine Beschränkung

- Einschränkungen

- Risiko

- Risiken

- Riskant

- s

- Schutzmaßnahmen

- Salz

- Vertrieb

- Sam

- Sam Altman

- Skalieren

- Abschnitt

- Sicherheitdienst

- scheint

- Halbleiter

- empfindlich

- brauchen

- mehrere

- Schild

- Silizium

- Silbermedaille

- ähnlich

- klein

- So

- Gesellschaft

- verkauft

- Spektrum

- Verbreitung

- Anfang

- Stoppen

- Einstellung

- Streik

- stringent

- so

- vorschlagen

- liefern

- Supply Chain

- Schalter

- Target

- und Aufgaben

- Geschmack

- Technologies

- Zehn

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Theorie

- Dort.

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- diejenigen

- Tausende

- Schwelle

- Zeit

- zu

- gemeinsam

- auch

- Werkzeug

- verfolgen sind

- Handel

- Training

- trainiert

- Ausbildung

- ausgelöst

- Billion

- Ärger

- unbefugt

- verstehen

- einzigartiges

- Universität

- Universität von Cambridge

- unwahrscheinlich

- us

- Amerikanischer Präsident

- -

- benutzt

- wertvoll

- Ve

- Anbieter

- Sichtbarkeit

- STIMMEN

- wollte

- Weg..

- Wege

- we

- Waffen

- Wochen

- GUT

- waren

- welche

- während

- Weiß

- WHO

- ganze

- mit

- ohne

- würde

- Falsch

- schrieb

- Jahr

- Du

- Ihr

- Zephyrnet