- 20. Januar 2014

- Vasilis Vryniotis

- . 5 Kommentare

Bei der Textklassifikation ist die Merkmalsauswahl der Prozess der Auswahl einer bestimmten Teilmenge der Begriffe des Trainingssatzes und der ausschließlichen Verwendung dieser im Klassifikationsalgorithmus. Der Merkmalsauswahlprozess findet vor dem Training des Klassifikators statt.

Update: Das Datumbox Machine Learning Framework ist jetzt Open Source und kostenlos für herunterladen. Sehen Sie sich das Paket com.datumbox.framework.machinelearning.featureselection an, um die Implementierung der Chi-Quadrat- und Mutual Information Feature Selection-Methoden in Java zu sehen.

Die Hauptvorteile für die Verwendung von Merkmalsauswahlalgorithmen sind die Tatsache, dass es die Dimension unserer Daten reduziert, das Training beschleunigt und die Genauigkeit verbessern kann, indem verrauschte Merkmale entfernt werden. Infolgedessen kann uns die Merkmalsauswahl helfen, eine Überanpassung zu vermeiden.

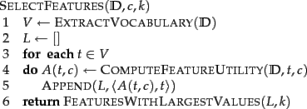

Der grundlegende Auswahlalgorithmus zum Auswählen der k besten Merkmale ist unten dargestellt (Manninget al., 2008):

In den nächsten Abschnitten stellen wir zwei verschiedene Merkmalsauswahlalgorithmen vor: die Gegenseitige Information und das Chi-Quadrat.

Gegenseitige Information

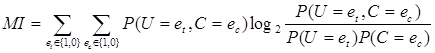

Eine der gebräuchlichsten Methoden zur Merkmalsauswahl ist die Mutual Information of term t in class c (Manninget al., 2008). Dies misst, wie viele Informationen das Vorhandensein oder Fehlen eines bestimmten Begriffs dazu beiträgt, die richtige Klassifizierungsentscheidung für c zu treffen. Die gegenseitige Information kann mit der folgenden Formel berechnet werden:

[1]

[1]

Da wir in unseren Berechnungen die Maximum-Likelihood-Schätzungen der Wahrscheinlichkeiten verwenden, können wir die folgende Gleichung verwenden:

![]() [2]

[2]

Wobei N die Gesamtzahl der Dokumente ist, Ntcsind die Anzahl der Dokumente mit den Werten et (Vorkommen des Terms t im Dokument; er nimmt den Wert 1 oder 0 an) und ec(Vorkommen des Dokuments in Klasse c; es nimmt den Wert 1 oder 0 an), das durch zwei Indizes angezeigt wird, ![]() und

und ![]() . Schließlich müssen wir beachten, dass alle oben genannten Variablen nicht negative Werte annehmen.

. Schließlich müssen wir beachten, dass alle oben genannten Variablen nicht negative Werte annehmen.

Chi Platz

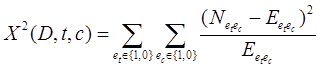

Eine weitere gängige Methode zur Auswahl von Merkmalen ist die Chi Platz. Das x2 test wird unter anderem in der Statistik verwendet, um die Unabhängigkeit zweier Ereignisse zu testen. Genauer gesagt verwenden wir es bei der Merkmalsauswahl, um zu testen, ob das Vorkommen eines bestimmten Begriffs und das Vorkommen einer bestimmten Klasse unabhängig sind. Daher schätzen wir die folgende Menge für jeden Begriff und ordnen sie nach ihrer Punktzahl:

[3]

[3]

Highscores auf x2 weisen darauf hin, dass die Nullhypothese (H0) der Unabhängigkeit abzulehnen und damit das Auftreten von Begriff und Klasse abhängig sind. Wenn sie abhängig sind, wählen wir das Feature für die Textklassifizierung aus.

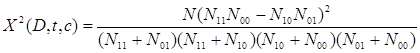

Die obige Formel lässt sich wie folgt umschreiben:

[4]

[4]

Wenn wir die Chi-Quadrat-Methode verwenden, sollten wir nur eine vordefinierte Anzahl von Merkmalen auswählen, die ax haben2 Testergebnis größer als 10.83, was eine statistische Signifikanz auf dem Niveau von 0.001 anzeigt.

Zu guter Letzt sollten wir anmerken, dass die Auswahl der Chi-Quadrat-Merkmale aufgrund des einen Freiheitsgrads und aus statistischer Sicht ungenau ist Yates-Korrektur sollte stattdessen verwendet werden (was es schwieriger macht, statistische Signifikanz zu erreichen). Daher sollten wir erwarten, dass von den insgesamt ausgewählten Merkmalen ein kleiner Teil von ihnen unabhängig von der Klasse ist). Daher sollten wir erwarten, dass von den insgesamt ausgewählten Merkmalen ein kleiner Teil von ihnen unabhängig von der Klasse ist. Trotzdem wie Manning et al. (2008) Wie sich gezeigt hat, beeinträchtigen diese verrauschten Merkmale die Gesamtgenauigkeit unseres Klassifikators nicht ernsthaft.

Entfernen von lauten/seltenen Funktionen

Eine weitere Technik, die uns helfen kann, Überanpassung zu vermeiden, den Speicherverbrauch zu reduzieren und die Geschwindigkeit zu verbessern, besteht darin, alle seltenen Begriffe aus dem Vokabular zu entfernen. Beispielsweise kann man über alle Kategorien hinweg alle Begriffe eliminieren, die nur einmal vorkommen. Das Entfernen dieser Begriffe kann die Speichernutzung um einen erheblichen Faktor reduzieren und die Geschwindigkeit der Analyse verbessern. Schließlich sollte nicht erwähnt werden, dass diese Technik in Verbindung mit den obigen Merkmalsauswahlalgorithmen verwendet werden kann.

Hat dir der Artikel gefallen? Bitte nehmen Sie sich eine Minute Zeit, um es auf Twitter zu teilen. 🙂

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- Bezugsbox

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Maschinelles Lernen & Statistik

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet