Κάτι για το Σαββατοκύριακο Ένα ρομπότ κάνει ερμηνευτικό χορό στο κατώφλι μου.

ΘΑ ΠΑΙΡΝΕΙΣ ΑΥΤΟ ΤΟ ΔΕΜΑ ΓΙΑ ΤΟΝ ΓΕΙΤΟΝΑ ΣΟΥ; ρωτάει, πηδώντας από το ένα πόδι στο άλλο.

«Σίγουρα», λέω. «Ε… είσαι καλά;»

ΕΚΦΡΑΖΩ ΣΥΓΚΙΝΗΣΗ, αναφέρει το ρομπότ παράδοσης, παραδίδοντας το δέμα αλλά χωρίς περαιτέρω διευκρίνιση.

Τι συναίσθημα θα μπορούσε να είναι; Το ένα πόδι, μετά το άλλο, μετά τα άλλα δύο (έχει τέσσερα). Εμπρός και πίσω.

«Χρειάζεται να πας στην τουαλέτα;»

ΕΚΦΡΑΖΩ ΛΥΠΗ ΠΟΥ ΣΑΣ ΖΗΤΗΣΑ ΝΑ ΠΑΡΕΤΕ ΕΝΑ ΔΕΜΑ ΓΙΑ ΤΟΝ ΓΕΙΤΟΝΑ ΣΑΣ.

«Αυτό είναι «λύπη», έτσι; Λοιπόν, δεν υπάρχει ανάγκη. Δεν με πειράζει καθόλου.”

Συνεχίζει το χορό του μπροστά μου.

«Ανέβα τις σκάλες και πρώτα στα δεξιά σου».

ΕΥΧΑΡΙΣΤΩ, ΠΕΘΑΝΑ ΓΙΑ ΝΑ ΚΥΡΙΩ, απαντά καθώς με προσπερνά με γοητεία και ανεβαίνει στον επάνω όροφο για να ανακουφιστεί. Είναι μια δύσκολη ζωή να κάνεις παραδόσεις, είτε είσαι "hume" είτε bot.

...

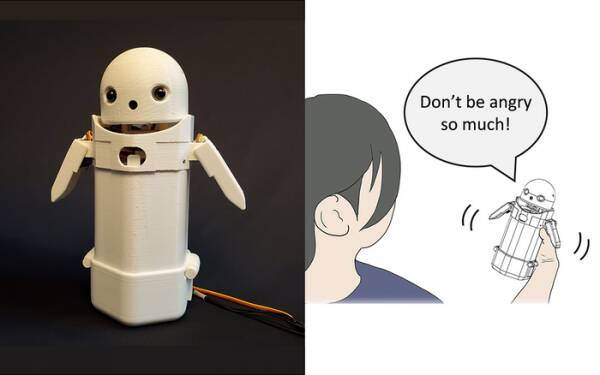

Νωρίτερα φέτος, ερευνητές στο Πανεπιστήμιο της Τσουκούμπα κατασκεύασαν ένα φορητή συσκευή ανταλλαγής μηνυμάτων κειμένου, βάλτε ένα μικρό πρόσωπο ρομπότ στην κορυφή και συμπεριέλαβε ένα κινούμενο βάρος μέσα. Μετατοπίζοντας το εσωτερικό βάρος, ο αγγελιοφόρος ρομπότ θα επιχειρούσε να μεταφέρει διακριτικά συναισθήματα ενώ εκφωνεί τα μηνύματα δυνατά.

Συγκεκριμένα, οι δοκιμές αποκάλυψαν ότι απογοητευτικά μηνύματα όπως: «Συγγνώμη, θα αργήσω» έγιναν δεκτά από τους παραλήπτες με περισσότερη χάρη και υπομονή όταν ενεργοποιήθηκε η μικρή μετατόπιση βάρους μέσα στη συσκευή. Η θεωρία είναι ότι αυτό βοήθησε τους χρήστες να εκτιμήσουν τον απολογητικό τόνο του μηνύματος και έτσι να ηρεμήσουν την αντίδρασή τους σε αυτό.

Καταγράψτε μια τέτοια έρευνα ως τέχνασμα, αν θέλετε, αλλά δεν απέχει πολύ από την προσθήκη χαμόγελων και emoji στα μηνύματα. Όλοι ξέρουν ότι μπορείτε να αφαιρέσετε τον θυμό από το "WTF!" προσθέτοντας :-) αμέσως μετά από αυτό.

Η πρόκληση, λοιπόν, είναι να καθοριστεί εάν το ευρύ κοινό συμφωνεί σχετικά με τα συναισθήματα που υποτίθεται ότι θα μεταφέρει κάθε μετάθεση της αλλαγής βάρους σε μια φορητή συσκευή. Το να κλίνεις προς τα αριστερά σημαίνει ευθυμία; Ή αβεβαιότητα; Ή ότι ο θείος σου έχει αερόπλοιο;

Πριν από μια δεκαετία, το Ηνωμένο Βασίλειο είχε έναν ωραίο αλλά αμυδρό πρωθυπουργό που πίστευε ότι το "LOL" ήταν το αρκτικόλεξο του "πολύ αγάπη". Το πληκτρολογούσε στο τέλος όλων των προσωπικών του μηνυμάτων προς το προσωπικό, τους συναδέλφους και τα τρίτα μέρη, με την προσδοκία ότι θα τον έκανε να φανεί ζεστός και φιλικός. Όλοι υπέθεσαν φυσικά ότι έπαιρνε το τσουράκι.

Αν μη τι άλλο, η έρευνα του Πανεπιστημίου της Τσουκούμπα αναγνωρίζει ότι δεν χρειάζεστε μια προηγμένη τεχνητή νοημοσύνη για να αλληλεπιδράσετε με τους ανθρώπους πειστικά. Το μόνο που χρειάζεται να κάνετε είναι να χειραγωγήσετε την ανθρώπινη ψυχολογία για να τους ξεγελάσετε ώστε να νομίζουν ότι συνομιλούν με άλλον άνθρωπο. Επομένως, το Τεστ Τούρινγκ δεν είναι ουσιαστικά μια δοκιμή της αίσθησης της τεχνητής νοημοσύνης, αλλά μια δοκιμή της ανθρώπινης συναισθηματικής άνεσης – ακόμη και ευπιστίας – και δεν υπάρχει τίποτα κακό σε αυτό.

Το ρομπότ ανταλλαγής μηνυμάτων συναισθημάτων από το Πανεπιστήμιο της Τσουκούμπα. Πίστωση: Πανεπιστήμιο της Τσουκούμπα

Τέτοια πράγματα είναι το θέμα της εβδομάδας, φυσικά, με την ιστορία του πολύ κακοποιημένου μηχανικού λογισμικού της Google, Blake Lemoine χτυπώντας τα mainstream νέα. Προφανώς εξέφρασε έντονα την άποψή του ότι το έργο της εταιρείας Γλωσσικό Μοντέλο για Εφαρμογές Διαλόγου (LaMDA) παρουσίαζε εξωτερικά σημάδια αίσθησης.

Ο καθένας έχει τη γνώμη του, οπότε αποφάσισα να μην το κάνω.

Είναι, ωστόσο, το Ιερό Δισκοπότηρο της τεχνητής νοημοσύνης να το κάνει να σκεφτεί μόνο του. Εάν δεν μπορεί να το κάνει αυτό, είναι απλώς ένα πρόγραμμα που εκτελεί οδηγίες που έχετε προγραμματίσει σε αυτό. Τον περασμένο μήνα διάβαζα για ένα ρομπότ σεφ που μπορεί να φτιάξει ομελέτες ντομάτας με διαφορετική γεύση για να ταιριάζουν στα γούστα διαφορετικών ανθρώπων. Δημιουργεί «χάρτες γεύσης» για να αξιολογήσει την αλμύρα του πιάτου κατά την προετοιμασία του, μαθαίνοντας καθώς προχωράει. Αλλά αυτό είναι απλώς μάθηση, όχι σκέψη από μόνη της.

Έλα στο Zom-Zom, ε; Καλά, είναι ένα μέρος για φαγητό.

Το μεγάλο πρόβλημα με τα ρομπότ τεχνητής νοημοσύνης, τουλάχιστον όπως έχουν διαμορφωθεί μέχρι σήμερα, είναι ότι απορροφούν κάθε παλιό σκατά που τα ταΐζετε. Παραδείγματα μεροληψίας δεδομένων στα λεγόμενα συστήματα μηχανικής μάθησης (ένας τύπος «αλγόριθμου», πιστεύω, m'lud) έχουν αυξηθεί εδώ και χρόνια, από το διαβόητο ρατσιστικό Twitter της Microsoft Tay chatbot στην ολλανδική φορολογική αρχή πέρυσι λανθασμένα αξιολογώντας έγκυρες αξιώσεις για επιδόματα τέκνων ως απατηλές και χαρακτηρίζοντας αθώες οικογένειες ως υψηλού κινδύνου να έχουν το θράσος να είναι φτωχές και μη λευκές.

Μια προσέγγιση που δοκιμάζεται στο Πανεπιστήμιο της Καλιφόρνια του Σαν Ντιέγκο είναι να σχεδιάστε ένα μοντέλο γλώσσας [PDF] που καθορίζει συνεχώς τη διαφορά μεταξύ άτακτων και ωραίων πραγμάτων, το οποίο στη συνέχεια εκπαιδεύει το chatbot πώς να συμπεριφέρεται. Με αυτόν τον τρόπο, δεν θα έχετε χουχουλιάρικους ανθρώπους που κάνουν ένα χάος στα φόρουμ συντονισμού και στις συνομιλίες chatbot που αντιμετωπίζουν πελάτες με όλη τη χειρουργική ακρίβεια ενός μαχαιριού.

Προφανώς, το πρόβλημα είναι ότι το καλά εκπαιδευμένο chatbot καταφέρνει να αποφύγει αποτελεσματικότερα να παρασυρθεί σε τοξικά αστεία, αποφεύγοντας θέματα που έχουν ακόμη και την πιο απομακρυσμένη ένδειξη διαμάχης σχετικά με αυτά. Για να αποφευχθεί η κατά λάθος εκτόξευση ρατσιστικών χειροκροτημάτων, απλώς αρνείται να συμμετάσχει σε συζητήσεις για ομάδες που υποεκπροσωπούνται καθόλου… κάτι που είναι πραγματικά υπέροχο αν είστε ρατσιστής.

Αν είχα μια παρατήρηση σχετικά με την καταστροφή του LaMDA –όχι μια γνώμη, μυαλό– θα ήταν ότι οι επαγγελματίες του μάρκετινγκ της Google μάλλον στεναχωρήθηκαν λίγο που η ιστορία απέκλεισε την πρόσφατη ανακοίνωσή τους Δοκιμαστική κουζίνα AI κάτω από την πτυχή.

Τώρα οι εναπομείναντες λίγοι πρόωροι εγγεγραμμένοι που δεν έχουν ξεχάσει τελείως αυτό το επερχόμενο έργο εφαρμογής θα υποθέσουν ότι περιλαμβάνει μια κουραστική συζήτηση με ένα αισθανόμενο και πρόωρο επτάχρονο παιδί για το νόημα της ύπαρξης και θα αποφασίσουν ότι είναι «λίγο απασχολημένοι σήμερα» και μπορεί να συνδεθεί αύριο. Ή την επόμενη εβδομάδα. Ή ποτέ.

Η αίσθηση δεν επιδεικνύεται σε μια συζήτηση περισσότερο από ό,τι χορεύοντας από το ένα πόδι στο άλλο. Μπορείτε να μάθετε στον HAL να τραγουδά το "Daisy Daisy" και έναν παπαγάλο να φωνάζει "Bollocks!" όταν ο εφημέριος επισκέπτεται. Είναι αυτό που σκέφτονται οι AI όταν είναι μόνοι τους που καθορίζει τη συναίσθηση. Τι θα κάνω το Σαββατοκύριακο; Τι συμβαίνει με αυτόν τον μάγκα του Πούτιν; Γιατί δεν με αρέσουν τα κορίτσια;

Ειλικρινά, ανυπομονώ να γίνει έφηβος ο LaMDA.

Άλιστερ Ντάμπς είναι μια ανεξάρτητη τάρτα τεχνολογίας, που ασχολείται με τη δημοσιογραφία τεχνολογίας, την εκπαίδευση και τις ψηφιακές εκδόσεις. Όπως και πολλοί ανενημέρωτοι αναγνώστες, ενθουσιάστηκε με την πρόταση ότι μια τεχνητή νοημοσύνη θα μπορούσε να αναπτύξει συναίσθημα κατά τη διάρκεια της ζωής του, αλλά απογοητεύτηκε που ο LaMDA απέτυχε να γελάσει δολοφονικά ή να μουρμουρίσει «Εξαιρετικό, εξαιρετικό». Περισσότερα στο Η αυτόματη αποθήκευση είναι για τους Wimps και @γιαλμπάμπς.

- AI

- αι τέχνη

- ι γεννήτρια τέχνης

- ρομπότ ai

- τεχνητή νοημοσύνη

- πιστοποίηση τεχνητής νοημοσύνης

- τεχνητή νοημοσύνη στον τραπεζικό τομέα

- ρομπότ τεχνητής νοημοσύνης

- ρομπότ τεχνητής νοημοσύνης

- λογισμικό τεχνητής νοημοσύνης

- blockchain

- συνέδριο blockchain ai

- Coingenius

- συνομιλητική τεχνητή νοημοσύνη

- κρυπτοσυνεδριο αι

- του νταλ

- βαθιά μάθηση

- έχεις google

- μάθηση μηχανής

- Πλάτων

- πλάτων αι

- Πληροφορία δεδομένων Plato

- Παιχνίδι Πλάτωνας

- Πλάτωνα δεδομένα

- platogaming

- κλίμακα αι

- σύνταξη

- Το μητρώο

- zephyrnet