Σήμερα, ξεκινάμε Amazon Sage Maker συμπέρασμα για AWS Graviton για να μπορέσετε να επωφεληθείτε από τα πλεονεκτήματα τιμής, απόδοσης και αποδοτικότητας που προέρχονται από τα τσιπ Graviton.

Στιγμιότυπα που βασίζονται στο Graviton είναι διαθέσιμα για εξαγωγή συμπερασμάτων μοντέλων στο SageMaker. Αυτή η ανάρτηση σάς βοηθά να μετεγκαταστήσετε και να αναπτύξετε έναν φόρτο εργασίας συμπερασμάτων μηχανικής εκμάθησης (ML) από το x86 σε παρουσίες που βασίζονται στο Graviton στο SageMaker. Παρέχουμε έναν οδηγό βήμα προς βήμα για την ανάπτυξη του εκπαιδευμένου μοντέλου σας στο SageMaker σε περιπτώσεις που βασίζονται στο Graviton, καλύπτουμε τις βέλτιστες πρακτικές όταν εργάζεστε με το Graviton, συζητάμε τα πλεονεκτήματα απόδοσης τιμής και παρουσιάζουμε πώς να αναπτύξετε ένα μοντέλο TensorFlow σε μια παρουσία του SageMaker Graviton.

Σύντομη επισκόπηση του Graviton

Το AWS Graviton είναι μια οικογένεια επεξεργαστών σχεδιασμένων από την AWS που παρέχουν την καλύτερη απόδοση τιμής και είναι πιο ενεργειακά αποδοτικοί από τους αντίστοιχους x86. Οι επεξεργαστές AWS Graviton 3 είναι οι πιο πρόσφατοι στην οικογένεια επεξεργαστών Graviton και είναι βελτιστοποιημένοι για φόρτους εργασίας ML, συμπεριλαμβανομένης της υποστήριξης για bfloat16 και διπλάσιο εύρος ζώνης Single Instruction Multiple Data (SIMD). Όταν συνδυάζονται αυτά τα δύο χαρακτηριστικά, το Graviton 3 μπορεί να προσφέρει έως και τρεις φορές καλύτερη απόδοση σε σύγκριση με τις περιπτώσεις Graviton 2. Το Graviton 3 χρησιμοποιεί επίσης έως και 60% λιγότερη ενέργεια για την ίδια απόδοση με το αντίστοιχο Amazon Elastic Compute Cloud (Amazon EC2) περιπτώσεις. Αυτό είναι ένα εξαιρετικό χαρακτηριστικό εάν θέλετε να μειώσετε το αποτύπωμα άνθρακα και να επιτύχετε τους στόχους βιωσιμότητας.

Επισκόπηση λύσεων

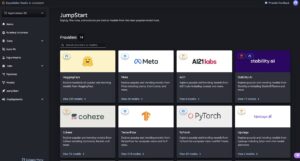

Για να αναπτύξετε τα μοντέλα σας σε περιπτώσεις Graviton, μπορείτε να χρησιμοποιήσετε είτε Εμπορευματοκιβώτια βαθιάς μάθησης AWS or φέρτε τα δικά σας δοχεία συμβατό με την αρχιτεκτονική Arm v8.2.

Η μετεγκατάσταση (ή η νέα ανάπτυξη) των μοντέλων σας από παρουσίες που τροφοδοτούνται από x86 σε παρουσίες Graviton είναι απλή, επειδή το AWS παρέχει κοντέινερ για φιλοξενία μοντέλων με PyTorch, TensorFlow, Scikit-learn και XGBoost και τα μοντέλα είναι αγνωστικά αρχιτεκτονικής. Ωστόσο, εάν είστε πρόθυμοι να φέρετε τις δικές σας βιβλιοθήκες, μπορείτε επίσης να το κάνετε, απλώς βεβαιωθείτε ότι το κοντέινερ σας είναι κατασκευασμένο με περιβάλλον που υποστηρίζει την αρχιτεκτονική Arm64. Για περισσότερες πληροφορίες, βλ Δημιουργήστε το δικό σας κοντέινερ αλγορίθμου.

Πρέπει να ολοκληρώσετε τρία βήματα για να αναπτύξετε το μοντέλο σας:

- Δημιουργία μοντέλου SageMaker: Αυτό θα περιέχει, μεταξύ άλλων παραμέτρων, τις πληροφορίες σχετικά με τη θέση του αρχείου μοντέλου, το κοντέινερ που θα χρησιμοποιηθεί για την ανάπτυξη και τη θέση του σεναρίου συμπερασμάτων. (Εάν έχετε ένα υπάρχον μοντέλο που έχει ήδη αναπτυχθεί σε μια παρουσία συμπερασμάτων που βασίζεται σε x86, μπορείτε να παραλείψετε αυτό το βήμα.)

- Δημιουργία διαμόρφωσης τελικού σημείου: Θα περιέχει πληροφορίες σχετικά με τον τύπο εμφάνισης που θέλετε για το τελικό σημείο (για παράδειγμα, ml.c7g.xlarge για το Graviton3), το όνομα του μοντέλου που δημιουργήσατε στο βήμα 1 και τον αριθμό των παρουσιών ανά τελικό σημείο.

- Εκκινήστε το τελικό σημείο με τη διαμόρφωση τελικού σημείου που δημιουργήθηκε στο βήμα 2.

Προϋποθέσεις

Πριν ξεκινήσετε, εξετάστε τις ακόλουθες προϋποθέσεις:

- Συμπληρώστε τα προαπαιτούμενα όπως αναφέρονται στο Προϋποθέσεις.

- Το μοντέλο σας θα πρέπει να είναι είτε PyTorch, TensorFlow, XGBoost ή Scikit-learn. Ο παρακάτω πίνακας συνοψίζει τις εκδόσεις που υποστηρίζονται αυτήν τη στιγμή από τη στιγμή της σύνταξης. Για τις πιο πρόσφατες ενημερώσεις, ανατρέξτε στο SageMaker Framework Containers (μόνο υποστήριξη SM).

. Python TensorFlow PyTorch Scikit-μάθετε XGBoost Υποστηριζόμενες εκδόσεις 3.8 2.9.1 1.12.1 1.0-1 1.3-1 σε 1.5-1 - Το σενάριο συμπερασμάτων αποθηκεύεται στο Απλή υπηρεσία αποθήκευσης Amazon (Amazon S3).

Στις επόμενες ενότητες, σας καθοδηγούμε στα βήματα ανάπτυξης.

Δημιουργήστε ένα μοντέλο SageMaker

Εάν έχετε ένα υπάρχον μοντέλο που έχει ήδη αναπτυχθεί σε μια παρουσία συμπερασμάτων που βασίζεται σε x86, μπορείτε να παραλείψετε αυτό το βήμα. Διαφορετικά, ολοκληρώστε τα παρακάτω βήματα για να δημιουργήσετε ένα μοντέλο SageMaker:

- Εντοπίστε το μοντέλο που αποθηκεύσατε σε έναν κάδο S3. Αντιγράψτε το URI.

Χρησιμοποιείτε το μοντέλο URI αργότερα στοMODEL_S3_LOCATION. - Προσδιορίστε την έκδοση πλαισίου και την έκδοση Python που χρησιμοποιήθηκε κατά την εκπαίδευση του μοντέλου.

Πρέπει να επιλέξετε ένα κοντέινερ από τη λίστα με τα διαθέσιμα AWS Deep Learning Containers ανά πλαίσιο και την έκδοση Python. Για περισσότερες πληροφορίες, ανατρέξτε στο Παρουσιάζουμε εικόνες κοντέινερ πολλαπλών αρχιτεκτονικών για το Amazon ECR. - Εντοπίστε το URI σεναρίου Python συμπερασμάτων στον κάδο S3 (το κοινό όνομα αρχείου είναι

inference.py).

Το URI σεναρίου συμπερασμάτων απαιτείται στοINFERENCE_SCRIPT_S3_LOCATION. - Με αυτές τις μεταβλητές, μπορείτε στη συνέχεια να καλέσετε το SageMaker API με την ακόλουθη εντολή:

Μπορείτε επίσης να δημιουργήσετε εικόνες πολλαπλών αρχιτεκτονικών και να χρησιμοποιήσετε την ίδια εικόνα αλλά με διαφορετικές ετικέτες. Μπορείτε να υποδείξετε σε ποια αρχιτεκτονική θα αναπτυχθεί η παρουσία σας. Για περισσότερες πληροφορίες, ανατρέξτε στο Παρουσιάζουμε εικόνες κοντέινερ πολλαπλών αρχιτεκτονικών για το Amazon ECR.

Δημιουργήστε μια διαμόρφωση τελικού σημείου

Αφού δημιουργήσετε το μοντέλο, πρέπει να δημιουργήσετε μια διαμόρφωση τερματικού εκτελώντας την ακόλουθη εντολή (σημειώστε τον τύπο της παρουσίας που χρησιμοποιούμε):

Το ακόλουθο στιγμιότυπο οθόνης δείχνει τις λεπτομέρειες διαμόρφωσης τελικού σημείου στην κονσόλα SageMaker.

Εκκινήστε το τελικό σημείο

Με τη διαμόρφωση τελικού σημείου που δημιουργήθηκε στο προηγούμενο βήμα, μπορείτε να αναπτύξετε το τελικό σημείο:

Περιμένετε μέχρι να αναπτυχθεί το τελικό σημείο του μοντέλου σας. Οι προβλέψεις μπορούν να ζητηθούν με τον ίδιο τρόπο που ζητάτε προβλέψεις για τα τελικά σημεία σας που αναπτύσσονται σε περιπτώσεις που βασίζονται σε x86.

Το ακόλουθο στιγμιότυπο οθόνης δείχνει το τελικό σημείο σας στην κονσόλα SageMaker.

Τι υποστηρίζεται

Το SageMaker παρέχει βαθιά δοχεία Graviton με βελτιστοποίηση απόδοσης για πλαίσια TensorFlow και PyTorch. Αυτά τα κοντέινερ υποστηρίζουν όραση υπολογιστή, επεξεργασία φυσικής γλώσσας, συστάσεις και γενικές περιπτώσεις χρήσης συμπερασμάτων σε βάθος και ευρεία βάση βάσει μοντέλων. Εκτός από τα δοχεία βαθιάς εκμάθησης, το SageMaker παρέχει επίσης κοντέινερ για κλασικά πλαίσια ML, όπως το XGBoost και το Scikit-learn. Τα δοχεία είναι δυαδικά συμβατά σε περιπτώσεις c6g/m6g και c7g, επομένως η μετάβαση της εφαρμογής συμπερασμάτων από τη μια γενιά στην άλλη είναι απρόσκοπτη.

Το C6g/m6g υποστηρίζει fp16 (πλωτήρας μισής ακρίβειας) και για συμβατά μοντέλα παρέχει ισοδύναμη ή καλύτερη απόδοση σε σύγκριση με τις περιπτώσεις c5. Το C7g αυξάνει σημαντικά την απόδοση ML διπλασιάζοντας το πλάτος SIMD και υποστηρίζοντας το bfloat-16 (bf16), που είναι η πιο οικονομική πλατφόρμα για την εκτέλεση των μοντέλων σας.

Τόσο το c6g/m6g όσο και το c7g παρέχουν καλή απόδοση για την κλασική ML (για παράδειγμα, το XGBoost) σε σύγκριση με άλλες παρουσίες CPU στο SageMaker. Η υποστήριξη Bfloat-16 στο c7g επιτρέπει την αποτελεσματική ανάπτυξη εκπαιδευμένων μοντέλων bf16 ή εκπαιδευμένων μοντέλων AMP (Automatic Mixed Precision). Το backend Arm Compute Library (ACL) στο Graviton παρέχει πυρήνες bfloat-16 που μπορούν να επιταχύνουν ακόμη και τους τελεστές fp32 μέσω γρήγορης λειτουργίας μαθηματικών, χωρίς την κβαντοποίηση του μοντέλου.

Συνιστώμενες βέλτιστες πρακτικές

Σε περιπτώσεις Graviton, κάθε vCPU είναι ένας φυσικός πυρήνας. Δεν υπάρχει διαμάχη για τους κοινούς πόρους της CPU (σε αντίθεση με το SMT) και η κλιμάκωση της απόδοσης του φόρτου εργασίας είναι γραμμική με κάθε προσθήκη vCPU. Επομένως, συνιστάται η χρήση συμπερασμάτων παρτίδας όποτε το επιτρέπει η περίπτωση χρήσης. Αυτό θα επιτρέψει την αποτελεσματική χρήση των vCPU με παράλληλη επεξεργασία της παρτίδας σε κάθε φυσικό πυρήνα. Εάν το συμπέρασμα παρτίδας δεν είναι δυνατό, απαιτείται το βέλτιστο μέγεθος παρουσίας για ένα δεδομένο ωφέλιμο φορτίο για να διασφαλιστεί ότι η επιβάρυνση του προγραμματισμού νημάτων του λειτουργικού συστήματος δεν υπερβαίνει την υπολογιστική ισχύ που παρέχεται με τα πρόσθετα vCPU.

Το TensorFlow έρχεται με πυρήνες Eigen από προεπιλογή και συνιστάται να μεταβείτε στο OneDNN με ACL για να λάβετε το πιο βελτιστοποιημένο backend συμπερασμάτων. Το backend του OneDNN και η γρήγορη λειτουργία μαθηματικών bfloat-16 μπορούν να ενεργοποιηθούν κατά την εκκίνηση της υπηρεσίας κοντέινερ:

Η προηγούμενη εντολή εξυπηρέτησης φιλοξενεί ένα τυπικό μοντέλο resnet50 με δύο σημαντικές διαμορφώσεις:

Αυτά μπορούν να περάσουν στο κοντέινερ συμπερασμάτων με τον ακόλουθο τρόπο:

Παράδειγμα ανάπτυξης

Σε αυτήν την ανάρτηση, σας δείχνουμε πώς να αναπτύξετε ένα μοντέλο TensorFlow, εκπαιδευμένο στο SageMaker, σε μια παρουσία συμπερασμάτων SageMaker που λειτουργεί με Graviton.

Μπορείτε να εκτελέσετε το δείγμα κώδικα είτε σε μια παρουσία σημειωματάριου SageMaker, ή Στούντιο Amazon SageMaker σημειωματάριο ή σημειωματάριο Jupyter σε τοπική λειτουργία. Πρέπει να ανακτήσετε τον ρόλο εκτέλεσης του SageMaker εάν χρησιμοποιείτε ένα σημειωματάριο Jupyter σε τοπική λειτουργία.

Το ακόλουθο παράδειγμα εξετάζει το σύνολο δεδομένων CIFAR-10. Μπορείτε να ακολουθήσετε το παράδειγμα του σημειωματάριου από τα παραδείγματα του SageMaker GitHub repo για να αναπαράγετε το μοντέλο που χρησιμοποιείται σε αυτήν την ανάρτηση. Χρησιμοποιούμε το εκπαιδευμένο μοντέλο και το cifar10_keras_main.py Σενάριο Python για συμπέρασμα.

Το μοντέλο αποθηκεύεται σε έναν κάδο S3: s3://aws-ml-blog/artifacts/run-ml-inference-on-graviton-based-instances-with-amazon-sagemaker/model.tar.gz

Η cifar10_keras_main.py Το σενάριο, το οποίο μπορεί να χρησιμοποιηθεί για το συμπέρασμα, αποθηκεύεται στη διεύθυνση:s3://aws-ml-blog/artifacts/run-ml-inference-on-graviton-based-instances-with-amazon-sagemaker/script/cifar10_keras_main.py

Χρησιμοποιούμε το us-east-1 Περιφερείστε και αναπτύξτε το μοντέλο σε ένα στιγμιότυπο ml.c7g.xlarge που βασίζεται στο Graviton. Με βάση αυτό, το URI του AWS Deep Learning Container είναι 763104351884.dkr.ecr.us-east-1.amazonaws.com/tensorflow-inference-graviton:2.9.1-cpu-py38-ubuntu20.04-sagemaker

- Ρυθμίστε με τον ακόλουθο κωδικό:

- Κατεβάστε το σύνολο δεδομένων για δοκιμή τελικού σημείου:

- Δημιουργήστε τη διαμόρφωση μοντέλου και τελικού σημείου και αναπτύξτε το τελικό σημείο:

- Προαιρετικά, μπορείτε να προσθέσετε το σενάριο συμπερασμάτων σας

Environmentincreate_modelεάν δεν το προσθέσατε αρχικά ως τεχνούργημα στο μοντέλο SageMaker κατά τη διάρκεια της εκπαίδευσης:Πρέπει να περιμένετε μερικά λεπτά για να πραγματοποιηθεί η ανάπτυξη.

- Επαληθεύστε την κατάσταση τελικού σημείου με τον ακόλουθο κωδικό:

Μπορείτε επίσης να ελέγξετε το Κονσόλα διαχείρισης AWS για να δείτε πότε θα αναπτυχθεί το μοντέλο σας.

- Ρυθμίστε το περιβάλλον χρόνου εκτέλεσης για να καλέσετε τα τελικά σημεία:

Τώρα προετοιμάζουμε το ωφέλιμο φορτίο για να καλέσουμε το τελικό σημείο. Χρησιμοποιούμε τον ίδιο τύπο εικόνων που χρησιμοποιούνται για την εκπαίδευση του μοντέλου. Η λήψη αυτών έγινε σε προηγούμενα βήματα.

- Ρίξτε το ωφέλιμο φορτίο στους τανυστές και ορίστε τη σωστή μορφή που αναμένει το μοντέλο. Για αυτό το παράδειγμα, ζητάμε μόνο μία πρόβλεψη.

Λαμβάνουμε την έξοδο του μοντέλου ως πίνακα.

- Μπορούμε να μετατρέψουμε αυτήν την έξοδο σε πιθανότητες εάν εφαρμόσουμε ένα softmax σε αυτό:

Εκκαθάριση πόρων

Οι υπηρεσίες που εμπλέκονται σε αυτή τη λύση επιβαρύνονται με κόστος. Όταν ολοκληρώσετε τη χρήση αυτής της λύσης, καθαρίστε τους ακόλουθους πόρους:

Σύγκριση τιμής-απόδοσης

Οι περιπτώσεις που βασίζονται στο Graviton προσφέρουν τη χαμηλότερη τιμή και την καλύτερη απόδοση τιμής σε σύγκριση με περιπτώσεις που βασίζονται σε x86. Παρόμοια με τις περιπτώσεις EC2, τα τελικά σημεία συμπερασμάτων SageMaker με στιγμιότυπα ml.c6g (Graviton 2) προσφέρουν 20% χαμηλότερη τιμή σε σύγκριση με τα στιγμιότυπα ml.c5 και τα στιγμιότυπα Graviton 3 ml.c7g είναι 15% φθηνότερα από τα στιγμιότυπα ml.c6. Για περισσότερες πληροφορίες, ανατρέξτε στο Τιμολόγηση του Amazon SageMaker.

Συμπέρασμα

Σε αυτήν την ανάρτηση, παρουσιάσαμε τη νέα δυνατότητα SageMaker που κυκλοφόρησε για την ανάπτυξη μοντέλων σε περιπτώσεις συμπερασμάτων που τροφοδοτούνται από Graviton. Σας δώσαμε καθοδήγηση σχετικά με τις βέλτιστες πρακτικές και συζητήσαμε εν συντομία τα πλεονεκτήματα τιμής-απόδοσης των νέων περιπτώσεων συμπερασμάτων.

Για να μάθετε περισσότερα για το Graviton, ανατρέξτε στο Επεξεργαστής AWS Graviton. Μπορείτε να ξεκινήσετε με παρουσίες EC2 που βασίζονται στο AWS Graviton στην κονσόλα Amazon EC2 και ανατρέχοντας στο Τεχνικός οδηγός AWS Graviton. Μπορείτε να αναπτύξετε ένα τελικό σημείο μοντέλου Sagemaker για συμπέρασμα σχετικά με το Graviton με το δείγμα κώδικα σε αυτήν την ανάρτηση ιστολογίου.

Σχετικά με τους συγγραφείς

Victor Jaramillo, PhD, είναι Senior Machine Learning Engineer στις AWS Professional Services. Πριν από το AWS, ήταν καθηγητής πανεπιστημίου και ερευνητής στην προγνωστική συντήρηση. Στον ελεύθερο χρόνο του, του αρέσει να οδηγεί τη μοτοσικλέτα του και να κάνει DIY μηχανικούς μοτοσικλετών.

Victor Jaramillo, PhD, είναι Senior Machine Learning Engineer στις AWS Professional Services. Πριν από το AWS, ήταν καθηγητής πανεπιστημίου και ερευνητής στην προγνωστική συντήρηση. Στον ελεύθερο χρόνο του, του αρέσει να οδηγεί τη μοτοσικλέτα του και να κάνει DIY μηχανικούς μοτοσικλετών.

Zmnako Awrahman, PhD, είναι μέλος Practice Manager, ML SME και Machine Learning Technical Field Community (TFC) στο Amazon Web Services. Βοηθά τους πελάτες να αξιοποιήσουν τη δύναμη του cloud για να εξάγουν αξία από τα δεδομένα τους με ανάλυση δεδομένων και μηχανική εκμάθηση.

Zmnako Awrahman, PhD, είναι μέλος Practice Manager, ML SME και Machine Learning Technical Field Community (TFC) στο Amazon Web Services. Βοηθά τους πελάτες να αξιοποιήσουν τη δύναμη του cloud για να εξάγουν αξία από τα δεδομένα τους με ανάλυση δεδομένων και μηχανική εκμάθηση.

Sunita Nadampalli είναι Διευθυντής Ανάπτυξης Λογισμικού στην AWS. Οδηγεί τις βελτιστοποιήσεις απόδοσης λογισμικού Graviton για κλίση μηχανών, HPC και φόρτους εργασίας πολυμέσων. Είναι παθιασμένη με την ανάπτυξη ανοιχτού κώδικα και την παροχή οικονομικών λύσεων λογισμικού με Arm SoC.

Sunita Nadampalli είναι Διευθυντής Ανάπτυξης Λογισμικού στην AWS. Οδηγεί τις βελτιστοποιήσεις απόδοσης λογισμικού Graviton για κλίση μηχανών, HPC και φόρτους εργασίας πολυμέσων. Είναι παθιασμένη με την ανάπτυξη ανοιχτού κώδικα και την παροχή οικονομικών λύσεων λογισμικού με Arm SoC.

Τζόνα Λιου είναι Μηχανικός Ανάπτυξης Λογισμικού στην ομάδα του Amazon SageMaker. Η τρέχουσα δουλειά της επικεντρώνεται στο να βοηθά τους προγραμματιστές να φιλοξενούν αποτελεσματικά μοντέλα μηχανικής εκμάθησης και να βελτιώνουν την απόδοση συμπερασμάτων. Είναι παθιασμένη με την ανάλυση χωρικών δεδομένων και τη χρήση της τεχνητής νοημοσύνης για την επίλυση κοινωνικών προβλημάτων.

Τζόνα Λιου είναι Μηχανικός Ανάπτυξης Λογισμικού στην ομάδα του Amazon SageMaker. Η τρέχουσα δουλειά της επικεντρώνεται στο να βοηθά τους προγραμματιστές να φιλοξενούν αποτελεσματικά μοντέλα μηχανικής εκμάθησης και να βελτιώνουν την απόδοση συμπερασμάτων. Είναι παθιασμένη με την ανάλυση χωρικών δεδομένων και τη χρήση της τεχνητής νοημοσύνης για την επίλυση κοινωνικών προβλημάτων.

Άλαν Ταν είναι Ανώτερος Διευθυντής Προϊόντων με το SageMaker, ο οποίος ηγείται των προσπαθειών για εξαγωγή συμπερασμάτων μεγάλων μοντέλων. Είναι παθιασμένος με την εφαρμογή της μηχανικής μάθησης στον τομέα της ανάλυσης. Εκτός δουλειάς, απολαμβάνει την ύπαιθρο.

Άλαν Ταν είναι Ανώτερος Διευθυντής Προϊόντων με το SageMaker, ο οποίος ηγείται των προσπαθειών για εξαγωγή συμπερασμάτων μεγάλων μοντέλων. Είναι παθιασμένος με την εφαρμογή της μηχανικής μάθησης στον τομέα της ανάλυσης. Εκτός δουλειάς, απολαμβάνει την ύπαιθρο.

- AI

- αι τέχνη

- ι γεννήτρια τέχνης

- ρομπότ ai

- Amazon Sage Maker

- τεχνητή νοημοσύνη

- πιστοποίηση τεχνητής νοημοσύνης

- τεχνητή νοημοσύνη στον τραπεζικό τομέα

- ρομπότ τεχνητής νοημοσύνης

- ρομπότ τεχνητής νοημοσύνης

- λογισμικό τεχνητής νοημοσύνης

- AWS Deep Learning AMI

- Μηχανική εκμάθηση AWS

- βέλτιστες πρακτικές

- blockchain

- συνέδριο blockchain ai

- Coingenius

- συνομιλητική τεχνητή νοημοσύνη

- κρυπτοσυνεδριο αι

- του νταλ

- βαθιά μάθηση

- έχεις google

- μάθηση μηχανής

- Πλάτων

- πλάτων αι

- Πληροφορία δεδομένων Plato

- Παιχνίδι Πλάτωνας

- Πλάτωνα δεδομένα

- platogaming

- κλίμακα αι

- σύνταξη

- Τεχνικός τρόπος

- Tensorflow στο AWS

- zephyrnet