Καθώς η μηχανική μάθηση (ML) γίνεται ολοένα και πιο διαδεδομένη σε ένα ευρύ φάσμα βιομηχανιών, οι οργανισμοί βρίσκουν την ανάγκη να εκπαιδεύσουν και να εξυπηρετήσουν μεγάλο αριθμό μοντέλων ML για να καλύψουν τις διαφορετικές ανάγκες των πελατών τους. Ειδικά για τους παρόχους λογισμικού ως υπηρεσίας (SaaS), η ικανότητα εκπαίδευσης και εξυπηρέτησης χιλιάδων μοντέλων αποτελεσματικά και οικονομικά είναι ζωτικής σημασίας για να παραμείνουμε ανταγωνιστικοί σε μια ταχέως εξελισσόμενη αγορά.

Η εκπαίδευση και η εξυπηρέτηση χιλιάδων μοντέλων απαιτεί μια στιβαρή και επεκτάσιμη υποδομή, σε αυτό ακριβώς το σημείο Amazon Sage Maker μπορώ να βοηθήσω. Το SageMaker είναι μια πλήρως διαχειριζόμενη πλατφόρμα που επιτρέπει στους προγραμματιστές και τους επιστήμονες δεδομένων να δημιουργούν, να εκπαιδεύουν και να αναπτύσσουν γρήγορα μοντέλα ML, ενώ προσφέρει επίσης τα οφέλη εξοικονόμησης κόστους από τη χρήση της υποδομής AWS Cloud.

Σε αυτήν την ανάρτηση, διερευνούμε πώς μπορείτε να χρησιμοποιήσετε τις λειτουργίες του SageMaker, συμπεριλαμβανομένων Επεξεργασία Amazon SageMaker, εργασίες εκπαίδευσης SageMaker και τερματικά σημεία πολλαπλών μοντέλων SageMaker (MME), για την εκπαίδευση και εξυπηρέτηση χιλιάδων μοντέλων με οικονομικά αποδοτικό τρόπο. Για να ξεκινήσετε με την περιγραφόμενη λύση, μπορείτε να ανατρέξετε στο συνοδευτικό σημειωματάριο στο GitHub.

Περίπτωση χρήσης: Πρόβλεψη ενέργειας

Για αυτήν την ανάρτηση, αναλαμβάνουμε το ρόλο μιας εταιρείας ISV που βοηθά τους πελάτες της να γίνουν πιο βιώσιμοι παρακολουθώντας την κατανάλωση ενέργειας και παρέχοντας προβλέψεις. Η εταιρεία μας έχει 1,000 πελάτες που θέλουν να κατανοήσουν καλύτερα τη χρήση ενέργειας και να λάβουν τεκμηριωμένες αποφάσεις σχετικά με τον τρόπο μείωσης των περιβαλλοντικών τους επιπτώσεων. Για να γίνει αυτό, χρησιμοποιούμε ένα συνθετικό σύνολο δεδομένων και εκπαιδεύουμε ένα μοντέλο ML με βάση Προφήτης για κάθε πελάτη να κάνει προβλέψεις κατανάλωσης ενέργειας. Με το SageMaker, μπορούμε να εκπαιδεύσουμε αποτελεσματικά και να εξυπηρετήσουμε αυτά τα 1,000 μοντέλα, παρέχοντας στους πελάτες μας ακριβείς και πρακτικές πληροφορίες σχετικά με τη χρήση της ενέργειας τους.

Υπάρχουν τρία χαρακτηριστικά στο σύνολο δεδομένων που δημιουργείται:

- Κωδικός πελάτη – Αυτό είναι ένα ακέραιο αναγνωριστικό για κάθε πελάτη, που κυμαίνεται από 0–999.

- timestamp – Αυτή είναι μια τιμή ημερομηνίας/ώρας που υποδεικνύει την ώρα κατά την οποία μετρήθηκε η κατανάλωση ενέργειας. Οι χρονικές σημάνσεις δημιουργούνται τυχαία μεταξύ των ημερομηνιών έναρξης και λήξης που καθορίζονται στον κώδικα.

- κατανάλωση – Αυτή είναι μια κινητή τιμή που υποδεικνύει την κατανάλωση ενέργειας, μετρούμενη σε κάποια αυθαίρετη μονάδα. Οι τιμές κατανάλωσης παράγονται τυχαία μεταξύ 0-1,000 με ημιτονοειδή εποχικότητα.

Επισκόπηση λύσεων

Για να εκπαιδεύσουμε αποτελεσματικά και να εξυπηρετήσουμε χιλιάδες μοντέλα ML, μπορούμε να χρησιμοποιήσουμε τις ακόλουθες δυνατότητες του SageMaker:

- Επεξεργασία SageMaker – Το SageMaker Processing είναι μια πλήρως διαχειριζόμενη υπηρεσία προετοιμασίας δεδομένων που σας δίνει τη δυνατότητα να εκτελείτε εργασίες επεξεργασίας δεδομένων και αξιολόγησης μοντέλων στα δεδομένα εισόδου σας. Μπορείτε να χρησιμοποιήσετε το SageMaker Processing για να μετατρέψετε τα ανεπεξέργαστα δεδομένα στη μορφή που απαιτείται για εκπαίδευση και εξαγωγή συμπερασμάτων, καθώς και για να εκτελέσετε ομαδικές και διαδικτυακές αξιολογήσεις των μοντέλων σας.

- Θέσεις εργασίας εκπαίδευσης SageMaker – Μπορείτε να χρησιμοποιήσετε εργασίες εκπαίδευσης του SageMaker για να εκπαιδεύσετε μοντέλα σε μια ποικιλία αλγορίθμων και τύπων δεδομένων εισόδου και να καθορίσετε τους υπολογιστικούς πόρους που απαιτούνται για την εκπαίδευση.

- SageMaker MME – Τα τελικά σημεία πολλαπλών μοντέλων σάς επιτρέπουν να φιλοξενείτε πολλά μοντέλα σε ένα μόνο τελικό σημείο, γεγονός που καθιστά εύκολη την προβολή προβλέψεων από πολλά μοντέλα χρησιμοποιώντας ένα μόνο API. Τα MME του SageMaker μπορούν να εξοικονομήσουν χρόνο και πόρους μειώνοντας τον αριθμό των τελικών σημείων που απαιτούνται για την προβολή προβλέψεων από πολλά μοντέλα. Τα MME υποστηρίζουν τη φιλοξενία μοντέλων που υποστηρίζονται από CPU και GPU. Σημειώστε ότι στο σενάριο μας, χρησιμοποιούμε 1,000 μοντέλα, αλλά αυτό δεν αποτελεί περιορισμό της ίδιας της υπηρεσίας.

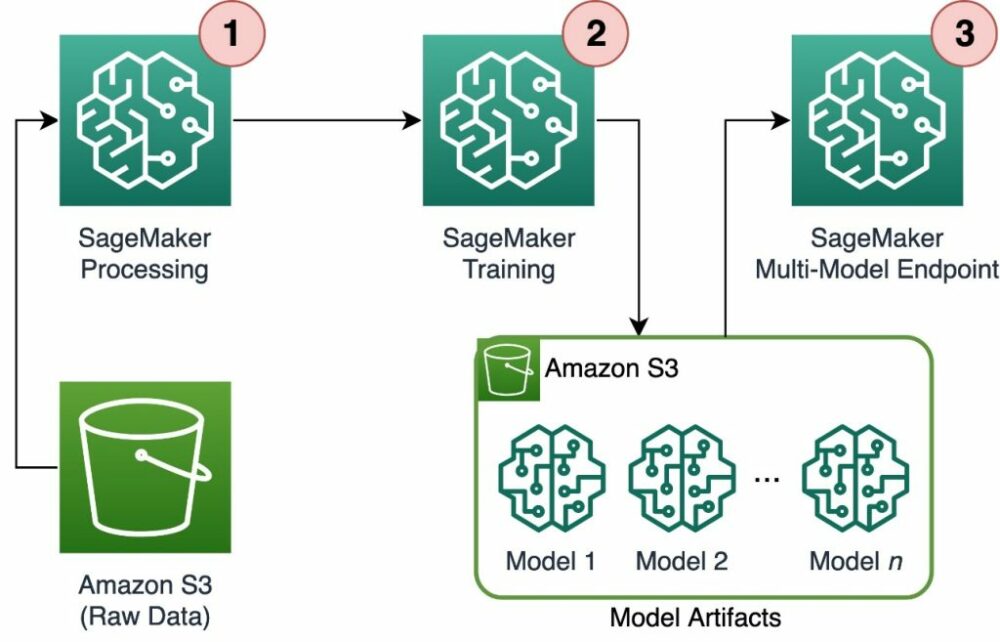

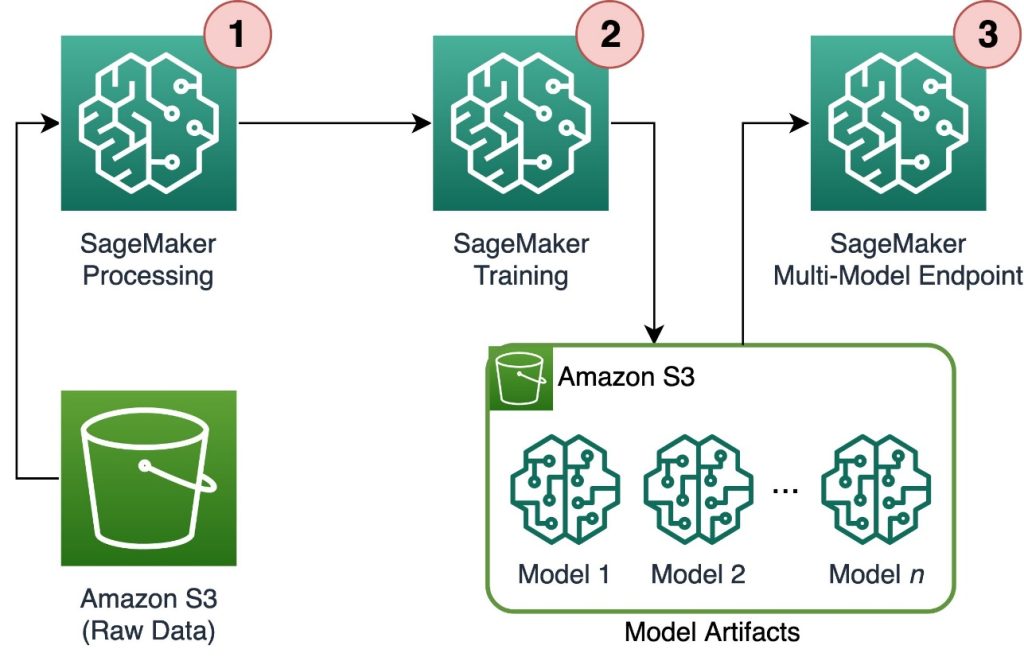

Το παρακάτω διάγραμμα απεικονίζει την αρχιτεκτονική λύσεων.

Η ροή εργασίας περιλαμβάνει τα ακόλουθα βήματα:

- Χρησιμοποιούμε το SageMaker Processing για την προεπεξεργασία δεδομένων και τη δημιουργία ενός μόνο αρχείου CSV ανά πελάτη και την αποθήκευση του σε Απλή υπηρεσία αποθήκευσης Amazon (Amazon S3).

- Η εργασία εκπαίδευσης του SageMaker έχει ρυθμιστεί ώστε να διαβάζει την έξοδο της εργασίας Επεξεργασίας SageMaker και να τη διανέμει με κυκλικό τρόπο στις παρουσίες εκπαίδευσης. Σημειώστε ότι αυτό μπορεί να επιτευχθεί και με Αγωγοί Amazon SageMaker.

- Τα τεχνουργήματα μοντέλων αποθηκεύονται στο Amazon S3 από την εργασία εκπαίδευσης και εξυπηρετούνται απευθείας από το SageMaker MME.

Κλιμακώστε την εκπαίδευση σε χιλιάδες μοντέλα

Η κλιμάκωση της εκπαίδευσης χιλιάδων μοντέλων είναι δυνατή μέσω του distribution παράμετρος του TrainingInput κλάση στο SageMaker Python SDK, το οποίο σας επιτρέπει να καθορίσετε πώς τα δεδομένα διανέμονται σε πολλαπλές παρουσίες εκπαίδευσης για μια εργασία εκπαίδευσης. Υπάρχουν τρεις επιλογές για το distribution παραμέτρου: FullyReplicated, ShardedByS3Key, να ShardedByRecord. ο ShardedByS3Key Η επιλογή σημαίνει ότι τα δεδομένα εκπαίδευσης μοιράζονται από το κλειδί αντικειμένου S3, με κάθε παράδειγμα εκπαίδευσης να λαμβάνει ένα μοναδικό υποσύνολο δεδομένων, αποφεύγοντας την αντιγραφή. Αφού αντιγραφούν τα δεδομένα από το SageMaker στα δοχεία εκπαίδευσης, μπορούμε να διαβάσουμε τη δομή του φακέλου και των αρχείων για να εκπαιδεύσουμε ένα μοναδικό μοντέλο ανά αρχείο πελάτη. Το παρακάτω είναι ένα παράδειγμα αποσπάσματος κώδικα:

Κάθε εργασία εκπαίδευσης του SageMaker αποθηκεύει το μοντέλο που είναι αποθηκευμένο στο /opt/ml/model φάκελο του κοντέινερ εκπαίδευσης πριν το αρχειοθετήσετε σε α model.tar.gz αρχείο και, στη συνέχεια, το ανεβάζει στο Amazon S3 μετά την ολοκλήρωση της εργασίας εκπαίδευσης. Οι ισχυροί χρήστες μπορούν επίσης να αυτοματοποιήσουν αυτή τη διαδικασία με το SageMaker Pipelines. Όταν αποθηκεύετε πολλά μοντέλα μέσω της ίδιας εργασίας εκπαίδευσης, το SageMaker δημιουργεί ένα ενιαίο model.tar.gz αρχείο που περιέχει όλα τα εκπαιδευμένα μοντέλα. Αυτό θα σήμαινε ότι, για να εξυπηρετήσουμε το μοντέλο, θα πρέπει πρώτα να αποσυσκευάσουμε το αρχείο. Για να το αποφύγουμε αυτό, χρησιμοποιούμε σημεία ελέγχου για να σώσει την κατάσταση μεμονωμένων μοντέλων. Το SageMaker παρέχει τη λειτουργία αντιγραφής σημείων ελέγχου που δημιουργήθηκαν κατά τη διάρκεια της εργασίας εκπαίδευσης στο Amazon S3. Εδώ, τα σημεία ελέγχου πρέπει να αποθηκευτούν σε μια προκαθορισμένη τοποθεσία, με την προεπιλογή /opt/ml/checkpoints. Αυτά τα σημεία ελέγχου μπορούν να χρησιμοποιηθούν για την επανέναρξη της εκπαίδευσης αργότερα ή ως μοντέλο για ανάπτυξη σε ένα τελικό σημείο. Για μια σύνοψη υψηλού επιπέδου του τρόπου με τον οποίο η πλατφόρμα εκπαίδευσης SageMaker διαχειρίζεται διαδρομές αποθήκευσης για σύνολα δεδομένων εκπαίδευσης, τεχνουργήματα μοντέλων, σημεία ελέγχου και εξόδους μεταξύ αποθήκευσης AWS Cloud και εργασιών εκπαίδευσης στο SageMaker, ανατρέξτε στο Amazon SageMaker Training Storage Folders for Training Datasets, Checkpoints, Model Artifacts και Outputs.

Ο παρακάτω κώδικας χρησιμοποιεί ένα εικονικό model.save() λειτουργία μέσα στο train.py σενάριο που περιέχει τη λογική εκπαίδευσης:

Κλιμακώστε τα συμπεράσματα σε χιλιάδες μοντέλα με SageMaker MME

Τα MME του SageMaker σάς επιτρέπουν να προβάλλετε πολλά μοντέλα ταυτόχρονα δημιουργώντας μια διαμόρφωση παραμέτρων τελικού σημείου που περιλαμβάνει μια λίστα με όλα τα μοντέλα προς προβολή και, στη συνέχεια, δημιουργώντας ένα τελικό σημείο χρησιμοποιώντας αυτήν τη διαμόρφωση τερματικού σημείου. Δεν χρειάζεται να αναπτύσσετε ξανά το τελικό σημείο κάθε φορά που προσθέτετε ένα νέο μοντέλο, επειδή το τελικό σημείο θα εξυπηρετεί αυτόματα όλα τα μοντέλα που είναι αποθηκευμένα στις καθορισμένες διαδρομές S3. Αυτό επιτυγχάνεται με Διακομιστής πολλαπλών μοντέλων (MMS), ένα πλαίσιο ανοιχτού κώδικα για την εξυπηρέτηση μοντέλων ML που μπορεί να εγκατασταθεί σε κοντέινερ για να παρέχει τη διεπαφή που πληροί τις απαιτήσεις για τα νέα API κοντέινερ MME. Επιπλέον, μπορείτε να χρησιμοποιήσετε άλλους διακομιστές μοντέλων συμπεριλαμβανομένων TorchServe και Τρίτωνος. MMS μπορεί να εγκατασταθεί στο προσαρμοσμένο κοντέινερ μέσω του SageMaker Inference Toolkit. Για να μάθετε περισσότερα σχετικά με τον τρόπο διαμόρφωσης του αρχείου Docker ώστε να περιλαμβάνει MMS και να το χρησιμοποιείτε για την εξυπηρέτηση των μοντέλων σας, ανατρέξτε στο Δημιουργήστε το δικό σας κοντέινερ για τα τελικά σημεία πολλαπλών μοντέλων του SageMaker.

Το ακόλουθο απόσπασμα κώδικα δείχνει πώς να δημιουργήσετε ένα MME χρησιμοποιώντας το SageMaker Python SDK:

Όταν το MME είναι ζωντανό, μπορούμε να το επικαλεστούμε για να δημιουργήσουμε προβλέψεις. Οι κλήσεις μπορούν να γίνουν σε οποιοδήποτε AWS SDK καθώς και με το SageMaker Python SDK, όπως φαίνεται στο παρακάτω απόσπασμα κώδικα:

Κατά την κλήση ενός μοντέλου, το μοντέλο φορτώνεται αρχικά από το Amazon S3 στην περίπτωση, κάτι που μπορεί να οδηγήσει σε ψυχρή εκκίνηση κατά την κλήση ενός νέου μοντέλου. Τα μοντέλα που χρησιμοποιούνται συχνά αποθηκεύονται προσωρινά στη μνήμη και στο δίσκο για να παρέχουν συμπεράσματα χαμηλής καθυστέρησης.

Συμπέρασμα

Το SageMaker είναι μια ισχυρή και οικονομικά αποδοτική πλατφόρμα για εκπαίδευση και εξυπηρέτηση χιλιάδων μοντέλων ML. Τα χαρακτηριστικά του, συμπεριλαμβανομένου του SageMaker Processing, των εργασιών εκπαίδευσης και των MME, επιτρέπουν στους οργανισμούς να εκπαιδεύουν αποτελεσματικά και να εξυπηρετούν χιλιάδες μοντέλα σε κλίμακα, ενώ επωφελούνται επίσης από τα πλεονεκτήματα εξοικονόμησης κόστους της χρήσης της υποδομής AWS Cloud. Για να μάθετε περισσότερα σχετικά με τον τρόπο χρήσης του SageMaker για εκπαίδευση και εξυπηρέτηση χιλιάδων μοντέλων, ανατρέξτε στο Δεδομένα διεργασίας, Εκπαιδεύστε ένα μοντέλο με το Amazon SageMaker και Φιλοξενήστε πολλά μοντέλα σε ένα κοντέινερ πίσω από ένα τελικό σημείο.

Σχετικά με τους Συγγραφείς

Davide Gallitelli είναι Ειδικός Αρχιτέκτονας Λύσεων για AI/ML στην περιοχή EMEA. Εδρεύει στις Βρυξέλλες και συνεργάζεται στενά με πελάτες σε όλη τη Μπενελούξ. Είναι προγραμματιστής από πολύ μικρός, ξεκινώντας να κωδικοποιεί σε ηλικία 7 ετών. Άρχισε να μαθαίνει AI/ML στο πανεπιστήμιο και από τότε το ερωτεύτηκε.

Davide Gallitelli είναι Ειδικός Αρχιτέκτονας Λύσεων για AI/ML στην περιοχή EMEA. Εδρεύει στις Βρυξέλλες και συνεργάζεται στενά με πελάτες σε όλη τη Μπενελούξ. Είναι προγραμματιστής από πολύ μικρός, ξεκινώντας να κωδικοποιεί σε ηλικία 7 ετών. Άρχισε να μαθαίνει AI/ML στο πανεπιστήμιο και από τότε το ερωτεύτηκε.

Maurits de Groot είναι αρχιτέκτονας λύσεων στην Amazon Web Services, με έδρα το Άμστερνταμ. Του αρέσει να εργάζεται σε θέματα που σχετίζονται με τη μηχανική μάθηση και έχει προτίμηση στις νεοφυείς επιχειρήσεις. Στον ελεύθερο χρόνο του, του αρέσει να κάνει σκι και να παίζει σκουός.

Maurits de Groot είναι αρχιτέκτονας λύσεων στην Amazon Web Services, με έδρα το Άμστερνταμ. Του αρέσει να εργάζεται σε θέματα που σχετίζονται με τη μηχανική μάθηση και έχει προτίμηση στις νεοφυείς επιχειρήσεις. Στον ελεύθερο χρόνο του, του αρέσει να κάνει σκι και να παίζει σκουός.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Αυτοκίνητο / EVs, Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- BlockOffsets. Εκσυγχρονισμός της περιβαλλοντικής αντιστάθμισης ιδιοκτησίας. Πρόσβαση εδώ.

- πηγή: https://aws.amazon.com/blogs/machine-learning/scale-training-and-inference-of-thousands-of-ml-models-with-amazon-sagemaker/

- :έχει

- :είναι

- :δεν

- :που

- 000

- 000 Πελάτες

- 1

- 10

- 100

- 12

- 15%

- 20

- 7

- a

- ικανότητα

- ΠΛΗΡΟΦΟΡΙΕΣ

- ακριβής

- επιτευχθεί

- απέναντι

- προσθέτω

- Επιπλέον

- πλεονεκτήματα

- Μετά το

- την ηλικία του

- AI / ML

- αλγόριθμοι

- Όλα

- επιτρέπουν

- επιτρέπει

- ήδη

- Επίσης

- Amazon

- Amazon Sage Maker

- Amazon υπηρεσίες Web

- Άμστερνταμ

- an

- και

- κάθε

- api

- APIs

- αρχιτεκτονική

- Αρχείο

- ΕΙΝΑΙ

- επιχείρημα

- AS

- υποθέτω

- At

- αυτοματοποίηση

- αυτομάτως

- αποφύγετε

- αποφεύγοντας

- AWS

- βασίζονται

- BE

- επειδή

- γίνονται

- γίνεται

- ήταν

- πριν

- πίσω

- είναι

- ωφελώντας

- οφέλη

- Καλύτερα

- μεταξύ

- και οι δύο

- Βρυξέλλες

- χτίζω

- αλλά

- by

- κλήση

- CAN

- περίπτωση

- τάξη

- στενά

- Backup

- cloud infrastructure

- αποθήκευσης σύννεφο

- κωδικός

- κρύο

- εταίρα

- ανταγωνιστική

- ολοκλήρωση

- Υπολογίστε

- διαμόρφωση

- έχει ρυθμιστεί

- κατανάλωση

- Δοχείο

- Εμπορευματοκιβώτια

- αποδοτική

- δημιουργία

- δημιουργήθηκε

- δημιουργεί

- δημιουργία

- κρίσιμος

- έθιμο

- πελάτης

- Πελάτες

- ημερομηνία

- Προετοιμασία δεδομένων

- επεξεργασία δεδομένων

- σύνολα δεδομένων

- Ημερομηνίες

- αποφάσεις

- Προεπιλογή

- ορίζεται

- ορισμός

- παρατάσσω

- περιγράφεται

- Εργολάβος

- προγραμματιστές

- κατευθείαν

- οθόνες

- διανέμω

- διανέμονται

- διάφορα

- do

- γίνεται

- κατά την διάρκεια

- κάθε

- εύκολος

- αποτελεσματικά

- ΕΜΕΑ

- ενεργοποιήσετε

- δίνει τη δυνατότητα

- τέλος

- Τελικό σημείο

- ενέργεια

- Κατανάλωση Ενέργειας

- περιβάλλοντος

- εκτίμηση

- αξιολογήσεις

- Κάθε

- εξελίσσεται

- παράδειγμα

- διερευνήσει

- Πεσμένος

- Μόδα

- Χαρακτηριστικά

- Αρχεία

- Αρχεία

- εύρεση

- Όνομα

- φλοτέρ

- Εξής

- Για

- Για εκκινήσεις

- προβλέψεις

- μορφή

- Πλαίσιο

- συχνά

- από

- εμπρός

- εμπρόσθιο άκρο

- πλήρως

- λειτουργία

- λειτουργικότητα

- παράγουν

- παράγεται

- παίρνω

- GitHub

- he

- βοήθεια

- βοηθά

- εδώ

- υψηλού επιπέδου

- του

- οικοδεσπότης

- φιλοξενία

- Πως

- Πώς να

- HTML

- http

- HTTPS

- αναγνωριστικό

- απεικονίζει

- Επίπτωση

- εισαγωγή

- in

- περιλαμβάνουν

- περιλαμβάνει

- Συμπεριλαμβανομένου

- όλο και περισσότερο

- υποδηλώνει

- ατομικές

- βιομηχανίες

- ενημερώνεται

- Υποδομή

- αρχικά

- εισαγωγή

- είσοδοι

- μέσα

- ιδέες

- εγκατασταθεί

- παράδειγμα

- σε

- IT

- ΤΟΥ

- εαυτό

- Δουλειά

- Θέσεις εργασίας

- jpg

- json

- Κλειδί

- large

- αργότερα

- ΜΑΘΑΊΝΩ

- μάθηση

- συμπαθεί

- περιορισμός

- Λιστα

- ζω

- τοπικά

- τοποθεσία

- λογική

- αγάπη

- μηχανή

- μάθηση μηχανής

- κάνω

- ΚΑΝΕΙ

- διαχειρίζεται

- διαχειρίζεται

- αγορά

- εννοώ

- μέσα

- Γνωρίστε

- Μνήμη

- ML

- μοντέλο

- μοντέλα

- στιγμή

- περισσότερο

- πολλαπλούς

- όνομα

- Ανάγκη

- που απαιτούνται

- ανάγκες

- Νέα

- Όχι.

- σημειωματάριο

- αριθμός

- αριθμοί

- αντικείμενο

- of

- προσφορά

- on

- ONE

- διαδικτυακά (online)

- ανοικτού κώδικα

- Επιλογή

- Επιλογές

- or

- τάξη

- οργανώσεις

- OS

- ΑΛΛΑ

- δικός μας

- Η Εταιρεία μας

- έξω

- παραγωγή

- δική

- παράμετρος

- Ειδικότερα

- passieren

- μονοπάτι

- για

- Εκτελέστε

- περίοδος

- εικόνα

- πλατφόρμες

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- παιχνίδι

- δυνατός

- Θέση

- δύναμη

- ισχυρός

- Προβλέψεις

- Predictor

- προετοιμασία

- επικρατών

- διαδικασια μας

- μεταποίηση

- παρέχουν

- Παρόχους υπηρεσιών

- παρέχει

- χορήγηση

- Python

- γρήγορα

- δημιουργήθηκε τυχαία

- σειρά

- κυμαίνεται

- ταχέως

- Ακατέργαστος

- Διάβασε

- σε πραγματικό χρόνο

- λήψη

- μείωση

- μείωση

- περιοχή

- απαιτήσεις

- Απαιτεί

- Υποστηρικτικό υλικό

- αποτέλεσμα

- περίληψη

- εύρωστος

- Ρόλος

- τρέξιμο

- SaaS

- σοφός

- Αγωγοί SageMaker

- ίδιο

- Αποθήκευση

- επεκτάσιμη

- Κλίμακα

- σενάριο

- επιστήμονες

- SDK

- εξυπηρετούν

- Διακομιστές

- υπηρεσία

- Υπηρεσίες

- εξυπηρετούν

- σειρά

- θραύσμα

- παρουσιάζεται

- Δείχνει

- Απλούς

- αφού

- ενιαίας

- Απόσπασμα

- λογισμικό

- λογισμικό ως υπηρεσία

- λύση

- Λύσεις

- μερικοί

- ειδικός

- καθορίζεται

- Εκκίνηση

- ξεκίνησε

- Ξεκινήστε

- Startups

- Κατάσταση

- Βήματα

- χώρος στο δίσκο

- κατάστημα

- αποθηκεύονται

- καταστήματα

- εναποθήκευση

- δομή

- ΠΕΡΙΛΗΨΗ

- υποστήριξη

- βιώσιμης

- συνθετικός

- στόχος

- εργασίες

- ότι

- Η

- Το κράτος

- τους

- τότε

- Εκεί.

- Αυτοί

- αυτό

- χιλιάδες

- τρία

- παντού

- ώρα

- προς την

- Θέματα

- Παρακολούθηση

- Τρένο

- εκπαιδευμένο

- Εκπαίδευση

- Μεταμορφώστε

- τύποι

- καταλαβαίνω

- μοναδικός

- μονάδα

- πανεπιστήμιο

- επάνω σε

- Χρήση

- χρήση

- μεταχειρισμένος

- Χρήστες

- χρησιμοποιεί

- χρησιμοποιώντας

- αξία

- Αξίες

- ποικιλία

- πολύ

- μέσω

- W

- θέλω

- ήταν

- Τρόπος..

- we

- ιστός

- διαδικτυακές υπηρεσίες

- ΛΟΙΠΌΝ

- πότε

- Ποιό

- ενώ

- Ο ΟΠΟΊΟΣ

- ευρύς

- Ευρύ φάσμα

- θα

- με

- εντός

- Εργασία

- ροής εργασίας

- λειτουργεί

- θα

- Εσείς

- νέος

- Σας

- zephyrnet