Τα μεγάλα γλωσσικά μοντέλα (LLM) έχουν φέρει επανάσταση στον τομέα της επεξεργασίας φυσικής γλώσσας (NLP), βελτιώνοντας εργασίες όπως η μετάφραση γλώσσας, η σύνοψη κειμένων και η ανάλυση συναισθημάτων. Ωστόσο, καθώς αυτά τα μοντέλα συνεχίζουν να αυξάνονται σε μέγεθος και πολυπλοκότητα, η παρακολούθηση της απόδοσης και της συμπεριφοράς τους γίνεται όλο και πιο δύσκολη.

Η παρακολούθηση της απόδοσης και της συμπεριφοράς των LLMs είναι ένα κρίσιμο καθήκον για τη διασφάλιση της ασφάλειας και της αποτελεσματικότητάς τους. Η προτεινόμενη αρχιτεκτονική μας παρέχει μια επεκτάσιμη και προσαρμόσιμη λύση για online παρακολούθηση LLM, επιτρέποντας στις ομάδες να προσαρμόσουν τη λύση παρακολούθησης στις συγκεκριμένες περιπτώσεις χρήσης και απαιτήσεις σας. Χρησιμοποιώντας τις υπηρεσίες AWS, η αρχιτεκτονική μας παρέχει ορατότητα σε πραγματικό χρόνο στη συμπεριφορά LLM και επιτρέπει στις ομάδες να εντοπίζουν γρήγορα και να αντιμετωπίζουν τυχόν ζητήματα ή ανωμαλίες.

Σε αυτήν την ανάρτηση, παρουσιάζουμε μερικές μετρήσεις για την online παρακολούθηση LLM και την αντίστοιχη αρχιτεκτονική τους για κλίμακα χρησιμοποιώντας υπηρεσίες AWS όπως amazoncloudwatch και AWS Lambda. Αυτό προσφέρει μια προσαρμόσιμη λύση πέρα από αυτό που είναι δυνατό με αξιολόγηση του μοντέλου δουλειές με Θεμέλιο του Αμαζονίου.

Επισκόπηση της λύσης

Το πρώτο πράγμα που πρέπει να λάβετε υπόψη είναι ότι διαφορετικές μετρήσεις απαιτούν διαφορετικές εκτιμήσεις υπολογισμού. Είναι απαραίτητη μια αρθρωτή αρχιτεκτονική, όπου κάθε λειτουργική μονάδα μπορεί να λάβει δεδομένα συμπερασμάτων μοντέλου και να παράγει τις δικές της μετρήσεις.

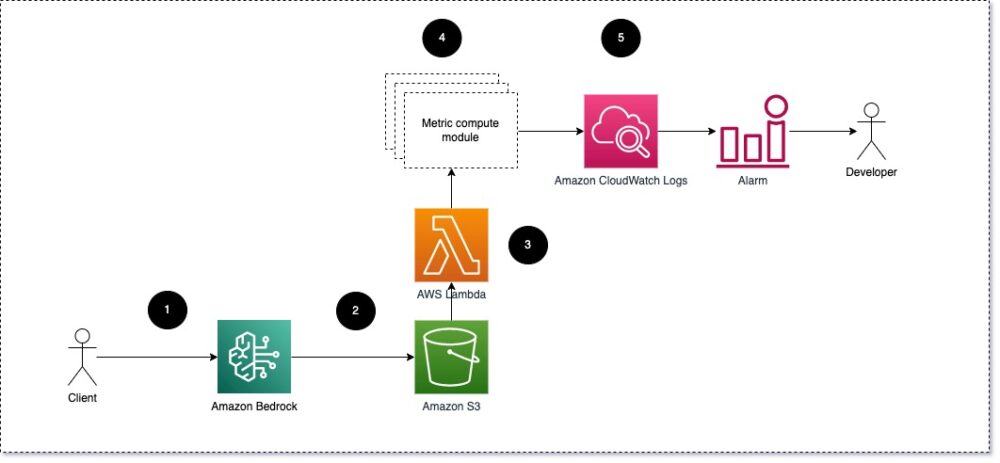

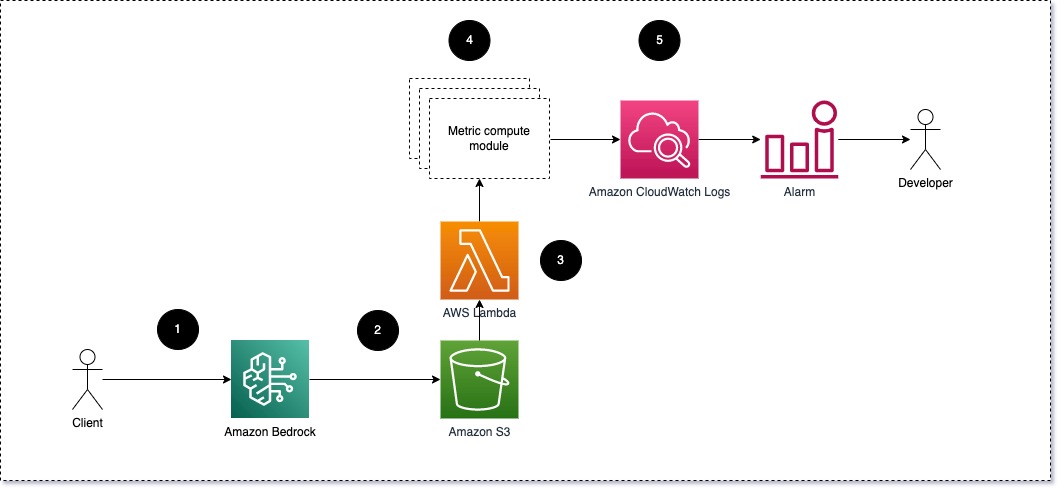

Προτείνουμε κάθε ενότητα να λαμβάνει εισερχόμενα αιτήματα συμπερασμάτων στο LLM, περνώντας ζεύγη προτροπής και ολοκλήρωσης (απόκρισης) σε μονάδες μετρικού υπολογισμού. Κάθε ενότητα είναι υπεύθυνη για τον υπολογισμό των δικών της μετρήσεων σε σχέση με την προτροπή εισόδου και την ολοκλήρωση (απόκριση). Αυτές οι μετρήσεις μεταβιβάζονται στο CloudWatch, το οποίο μπορεί να τις συγκεντρώσει και να συνεργαστεί με τους συναγερμούς CloudWatch για την αποστολή ειδοποιήσεων για συγκεκριμένες συνθήκες. Το παρακάτω διάγραμμα απεικονίζει αυτήν την αρχιτεκτονική.

Σχήμα 1: Μονάδα μετρικού υπολογισμού – επισκόπηση λύσης

Η ροή εργασίας περιλαμβάνει τα ακόλουθα βήματα:

- Ένας χρήστης υποβάλλει ένα αίτημα στο Amazon Bedrock ως μέρος μιας εφαρμογής ή διεπαφής χρήστη.

- Το Amazon Bedrock αποθηκεύει το αίτημα και την ολοκλήρωση (απόκριση). Απλή υπηρεσία αποθήκευσης Amazon (Amazon S3) σύμφωνα με τη διαμόρφωση του καταγραφή επίκλησης.

- Το αρχείο που είναι αποθηκευμένο στο Amazon S3 δημιουργεί ένα συμβάν που πυροδοτεί μια συνάρτηση λάμδα. Η συνάρτηση καλεί τις μονάδες.

- Οι ενότητες δημοσιεύουν τις αντίστοιχες μετρήσεις τους στο Μετρήσεις CloudWatch.

- Συναγερμός μπορεί να ειδοποιήσει την ομάδα ανάπτυξης για μη αναμενόμενες τιμές μετρήσεων.

Το δεύτερο πράγμα που πρέπει να λάβετε υπόψη κατά την εφαρμογή της παρακολούθησης LLM είναι η επιλογή των σωστών μετρήσεων για παρακολούθηση. Αν και υπάρχουν πολλές πιθανές μετρήσεις που μπορείτε να χρησιμοποιήσετε για να παρακολουθήσετε την απόδοση του LLM, εξηγούμε μερικές από τις ευρύτερες σε αυτήν την ανάρτηση.

Στις επόμενες ενότητες, επισημαίνουμε μερικές από τις σχετικές μετρήσεις της ενότητας και την αντίστοιχη αρχιτεκτονική της μονάδας υπολογισμού μετρήσεων.

Σημασιολογική ομοιότητα μεταξύ προτροπής και ολοκλήρωσης (απόκριση)

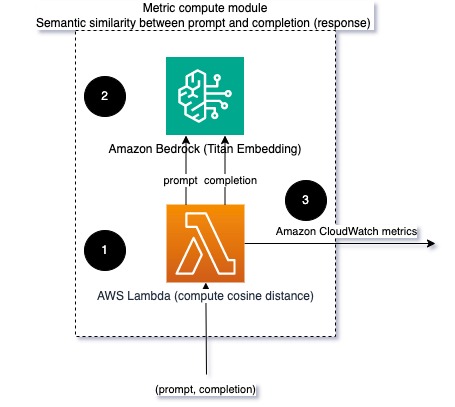

Όταν εκτελείτε LLM, μπορείτε να υποκλέψετε την προτροπή και την ολοκλήρωση (απόκριση) για κάθε αίτημα και να τα μετατρέψετε σε ενσωματώσεις χρησιμοποιώντας ένα μοντέλο ενσωμάτωσης. Οι ενσωματώσεις είναι διανύσματα υψηλών διαστάσεων που αντιπροσωπεύουν το σημασιολογικό νόημα του κειμένου. Amazon Titan παρέχει τέτοια μοντέλα μέσω της Titan Embeddings. Λαμβάνοντας μια απόσταση όπως το συνημίτονο μεταξύ αυτών των δύο διανυσμάτων, μπορείτε να ποσοτικοποιήσετε πόσο παρόμοια είναι σημασιολογικά η προτροπή και η ολοκλήρωση (απόκριση). Μπορείς να χρησιμοποιήσεις SciPy or scikit-μάθετε για τον υπολογισμό της απόστασης συνημιτόνου μεταξύ των διανυσμάτων. Το παρακάτω διάγραμμα απεικονίζει την αρχιτεκτονική αυτής της μονάδας μετρικών υπολογιστών.

Σχήμα 2: Υπολογιστική μονάδα μέτρησης – σημασιολογική ομοιότητα

Αυτή η ροή εργασίας περιλαμβάνει τα ακόλουθα βασικά βήματα:

- Μια συνάρτηση Lambda λαμβάνει ένα μήνυμα ροής μέσω Amazon Kinesis που περιέχει ένα ζεύγος προτροπής και ολοκλήρωσης (απόκρισης).

- Η συνάρτηση λαμβάνει μια ενσωμάτωση τόσο για την προτροπή όσο και για την ολοκλήρωση (απόκριση) και υπολογίζει την απόσταση συνημιτόνου μεταξύ των δύο διανυσμάτων.

- Η συνάρτηση στέλνει αυτές τις πληροφορίες στις μετρήσεις του CloudWatch.

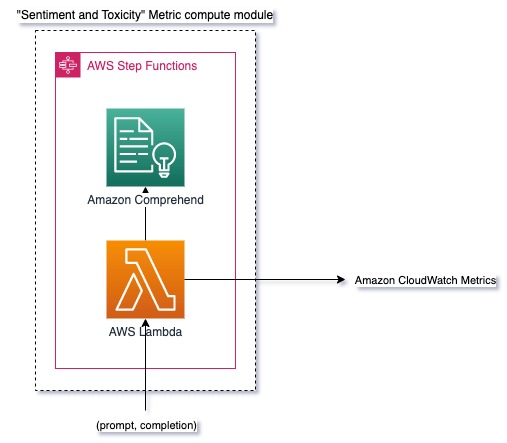

Συναίσθημα και τοξικότητα

Η παρακολούθηση του συναισθήματος σάς επιτρέπει να μετρήσετε τον συνολικό τόνο και τον συναισθηματικό αντίκτυπο των απαντήσεων, ενώ η ανάλυση τοξικότητας παρέχει ένα σημαντικό μέτρο της παρουσίας προσβλητικής, ασεβούς ή επιβλαβούς γλώσσας στα αποτελέσματα LLM. Οποιεσδήποτε αλλαγές στο συναίσθημα ή τοξικότητα θα πρέπει να παρακολουθούνται στενά για να διασφαλιστεί ότι το μοντέλο συμπεριφέρεται όπως αναμένεται. Το παρακάτω διάγραμμα απεικονίζει τη μονάδα μετρικού υπολογισμού.

Σχήμα 3: Μονάδα μετρικής υπολογισμού – συναίσθημα και τοξικότητα

Η ροή εργασίας περιλαμβάνει τα ακόλουθα βήματα:

- Μια συνάρτηση Lambda λαμβάνει ένα ζεύγος προτροπής και ολοκλήρωσης (απόκρισης) μέσω του Amazon Kinesis.

- Μέσω της ενορχήστρωσης AWS Step Functions, η συνάρτηση καλεί Κατανοήστε το Amazon για να ανιχνεύσει το συναίσθημα και τοξικότητα.

- Η συνάρτηση αποθηκεύει τις πληροφορίες στις μετρήσεις του CloudWatch.

Για περισσότερες πληροφορίες σχετικά με τον εντοπισμό συναισθημάτων και τοξικότητας με το Amazon Comprehend, ανατρέξτε στο Δημιουργήστε έναν ισχυρό παράγοντα πρόβλεψης τοξικότητας βάσει κειμένου και Επισημάνετε επιβλαβές περιεχόμενο χρησιμοποιώντας την ανίχνευση τοξικότητας του Amazon Comprehend.

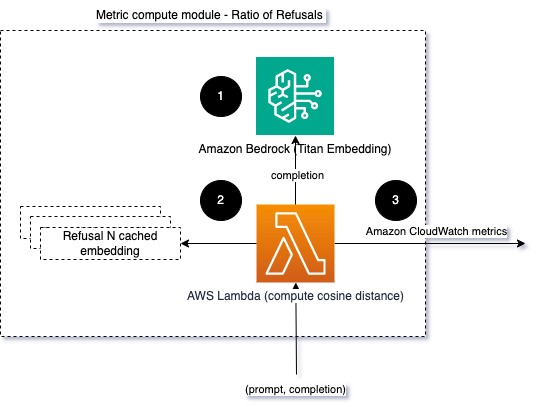

Αναλογία αρνήσεων

Μια αύξηση στις αρνήσεις, όπως όταν ένα LLM αρνείται την ολοκλήρωση λόγω έλλειψης πληροφοριών, μπορεί να σημαίνει ότι είτε κακόβουλοι χρήστες προσπαθούν να χρησιμοποιήσουν το LLM με τρόπους που προορίζονται να το παραβιάσουν είτε ότι οι προσδοκίες των χρηστών δεν ικανοποιούνται και ότι λαμβάνουν απαντήσεις χαμηλής αξίας. Ένας τρόπος για να μετρήσετε πόσο συχνά συμβαίνει αυτό είναι συγκρίνοντας τις τυπικές αρνήσεις από το μοντέλο LLM που χρησιμοποιείται με τις πραγματικές απαντήσεις από το LLM. Για παράδειγμα, οι παρακάτω είναι μερικές από τις συνήθεις φράσεις άρνησης Claude v2 LLM του Anthropic:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

Σε ένα σταθερό σύνολο προτροπών, μια αύξηση σε αυτές τις αρνήσεις μπορεί να είναι ένα σημάδι ότι το μοντέλο έχει γίνει υπερβολικά προσεκτικό ή ευαίσθητο. Θα πρέπει επίσης να αξιολογηθεί η αντίστροφη περίπτωση. Θα μπορούσε να είναι ένα σήμα ότι το μοντέλο είναι πλέον πιο επιρρεπές να συμμετέχει σε τοξικές ή επιβλαβείς συνομιλίες.

Για να βοηθήσουμε την ακεραιότητα του μοντέλου και την αναλογία άρνησης μοντέλου, μπορούμε να συγκρίνουμε την απάντηση με ένα σύνολο γνωστών φράσεων άρνησης από το LLM. Αυτός θα μπορούσε να είναι ένας πραγματικός ταξινομητής που μπορεί να εξηγήσει γιατί το μοντέλο απέρριψε το αίτημα. Μπορείτε να λάβετε την απόσταση συνημιτόνου μεταξύ της απόκρισης και των γνωστών απαντήσεων άρνησης από το υπό παρακολούθηση μοντέλο. Το παρακάτω διάγραμμα απεικονίζει αυτήν την ενότητα μετρικών υπολογιστών.

Σχήμα 4: Υπολογιστική μονάδα μέτρησης – αναλογία αρνήσεων

Η ροή εργασίας αποτελείται από τα ακόλουθα βήματα:

- Μια συνάρτηση Lambda λαμβάνει μια προτροπή και μια ολοκλήρωση (απόκριση) και λαμβάνει μια ενσωμάτωση από την απόκριση χρησιμοποιώντας το Amazon Titan.

- Η συνάρτηση υπολογίζει την απόσταση συνημιτόνου ή Ευκλείδειου μεταξύ της απόκρισης και των υπαρχόντων προτροπών άρνησης που είναι αποθηκευμένες στη μνήμη.

- Η συνάρτηση στέλνει αυτόν τον μέσο όρο στις μετρήσεις CloudWatch.

Μια άλλη επιλογή είναι να χρησιμοποιήσετε ασαφής αντιστοίχιση για μια απλή αλλά λιγότερο ισχυρή προσέγγιση για τη σύγκριση των γνωστών αρνήσεων με την παραγωγή LLM. Αναφέρομαι στο Τεκμηρίωση Python για παράδειγμα.

Χαρακτηριστικά

Η παρατηρησιμότητα LLM είναι μια κρίσιμη πρακτική για τη διασφάλιση της αξιόπιστης και αξιόπιστης χρήσης των LLM. Η παρακολούθηση, η κατανόηση και η διασφάλιση της ακρίβειας και της αξιοπιστίας των LLM μπορούν να σας βοηθήσουν να μειώσετε τους κινδύνους που σχετίζονται με αυτά τα μοντέλα AI. Παρακολουθώντας παραισθήσεις, κακές ολοκληρώσεις (απαντήσεις) και προτροπές, μπορείτε να βεβαιωθείτε ότι το LLM σας παραμένει σε καλό δρόμο και προσφέρει την αξία που αναζητάτε εσείς και οι χρήστες σας. Σε αυτήν την ανάρτηση, συζητήσαμε μερικές μετρήσεις για να παρουσιάσουμε παραδείγματα.

Για περισσότερες πληροφορίες σχετικά με την αξιολόγηση των μοντέλων θεμελίωσης, ανατρέξτε στο Χρησιμοποιήστε το SageMaker Clarify για να αξιολογήσετε τα μοντέλα θεμελίωσηςκαι περιηγηθείτε σε επιπλέον παραδείγματα σημειωματάρια διαθέσιμο στο αποθετήριο του GitHub. Μπορείτε επίσης να εξερευνήσετε τρόπους για να λειτουργήσετε τις αξιολογήσεις LLM σε κλίμακα Λειτουργία της αξιολόγησης LLM σε κλίμακα χρησιμοποιώντας τις υπηρεσίες Amazon SageMaker Clarify και MLOps. Τέλος, συνιστούμε να αναφερθείτε σε Αξιολογήστε μεγάλα γλωσσικά μοντέλα για ποιότητα και υπευθυνότητα για να μάθετε περισσότερα σχετικά με την αξιολόγηση LLM.

Σχετικά με τους Συγγραφείς

Μπρούνο Κλάιν είναι Ανώτερος Μηχανικός Μηχανικής Μάθησης με Πρακτική Αναλύσεων Επαγγελματικών Υπηρεσιών AWS. Βοηθά τους πελάτες να εφαρμόσουν λύσεις μεγάλων δεδομένων και ανάλυσης. Εκτός δουλειάς, του αρέσει να περνά χρόνο με την οικογένεια, να ταξιδεύει και να δοκιμάζει νέο φαγητό.

Μπρούνο Κλάιν είναι Ανώτερος Μηχανικός Μηχανικής Μάθησης με Πρακτική Αναλύσεων Επαγγελματικών Υπηρεσιών AWS. Βοηθά τους πελάτες να εφαρμόσουν λύσεις μεγάλων δεδομένων και ανάλυσης. Εκτός δουλειάς, του αρέσει να περνά χρόνο με την οικογένεια, να ταξιδεύει και να δοκιμάζει νέο φαγητό.

Rushabh Lokhande είναι Senior Data & ML Engineer με AWS Professional Services Analytics Practice. Βοηθά τους πελάτες να εφαρμόσουν λύσεις μεγάλων δεδομένων, μηχανικής μάθησης και ανάλυσης. Εκτός δουλειάς, του αρέσει να περνά χρόνο με την οικογένεια, να διαβάζει, να τρέχει και να παίζει γκολφ.

Rushabh Lokhande είναι Senior Data & ML Engineer με AWS Professional Services Analytics Practice. Βοηθά τους πελάτες να εφαρμόσουν λύσεις μεγάλων δεδομένων, μηχανικής μάθησης και ανάλυσης. Εκτός δουλειάς, του αρέσει να περνά χρόνο με την οικογένεια, να διαβάζει, να τρέχει και να παίζει γκολφ.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- :έχει

- :είναι

- :δεν

- :που

- 1

- 100

- 143

- 32

- 455

- 7

- a

- Σχετικα

- ακρίβεια

- πραγματικός

- Πρόσθετος

- διεύθυνση

- σύνολο

- AI

- Βοηθός AI

- Μοντέλα AI

- επιτρέπει

- Επίσης

- Αν και

- am

- Amazon

- Κατανοήστε το Amazon

- Amazon Kinesis

- Amazon Sage Maker

- Amazon υπηρεσίες Web

- an

- ανάλυση

- analytics

- και

- ανωμαλίες

- Ανθρωπικός

- κάθε

- Εφαρμογή

- πλησιάζω

- προσεγγίσεις

- αρχιτεκτονική

- ΕΙΝΑΙ

- AS

- Βοηθός

- συσχετισμένη

- At

- διαθέσιμος

- μέσος

- AWS

- Επαγγελματικές υπηρεσίες AWS

- Λειτουργίες βημάτων AWS

- Κακός

- BE

- γίνονται

- συμπεριφορά

- είναι

- μεταξύ

- Πέρα

- Μεγάλος

- Big Data

- και οι δύο

- αλλά

- by

- κλήσεις

- CAN

- δεν μπορώ

- περίπτωση

- περιπτώσεις

- προσεκτικός

- πρόκληση

- επιλέγοντας

- ταξινομητής

- στενά

- Κοινός

- συγκρίνουν

- συγκρίνοντας

- ολοκλήρωση

- περίπλοκο

- κατανοώ

- υπολογισμός

- Υπολογίστε

- χρήση υπολογιστή

- Συνθήκες

- διαμόρφωση

- Εξετάστε

- θεωρήσεις

- αποτελείται

- περιεχόμενο

- συμφραζόμενα

- ΣΥΝΕΧΕΙΑ

- συνομιλίες

- θα μπορούσε να

- δημιουργήθηκε

- δημιουργεί

- κρίσιμης

- Πελάτες

- προσαρμόσιμη

- ημερομηνία

- παραδίδει

- αποδεικνύουν

- ανίχνευση

- Ανάπτυξη

- ομάδα ανάπτυξης

- διάγραμμα

- διαφορετικές

- συζήτηση

- απόσταση

- do

- δυο

- κάθε

- αποτελεσματικότητα

- είτε

- ενσωμάτωση

- δίνει τη δυνατότητα

- ενεργοποίηση

- ασκούν

- μηχανικός

- αρκετά

- εξασφαλίζω

- εξασφαλίζοντας

- αξιολογήσει

- αξιολόγηση

- αξιολογώντας

- εκτίμηση

- αξιολογήσεις

- Συμβάν

- παράδειγμα

- παραδείγματα

- υφιστάμενα

- προσδοκίες

- αναμένεται

- Εξηγήστε

- διερευνήσει

- οικογένεια

- λίγοι

- πεδίο

- σύκο

- Αρχεία

- Τελικά

- Όνομα

- καθορίζεται

- Εξής

- τροφή

- Για

- Θεμέλιο

- από

- λειτουργία

- λειτουργίες

- μετρητής

- παίρνει

- να πάρει

- GitHub

- γκολφ

- Grow

- Συμβαίνει

- επιβλαβής

- Έχω

- he

- βοήθεια

- χρήσιμο

- βοηθά

- Επισημάνετε

- τίμιος

- Πως

- Ωστόσο

- HTML

- http

- HTTPS

- i

- προσδιορίσει

- απεικονίζει

- Επίπτωση

- εφαρμογή

- εκτελεστικών

- σημαντικό

- βελτίωση

- in

- περιλαμβάνει

- Εισερχόμενος

- Αυξάνουν

- όλο και περισσότερο

- πληροφορίες

- εισαγωγή

- ακεραιότητα

- προορίζονται

- περιβάλλον λειτουργίας

- σε

- αντίστροφος

- επικαλείται

- θέματα

- IT

- ΤΟΥ

- απόδραση εκ φυλακής

- Θέσεις εργασίας

- jpg

- Κλειδί

- γνωστός

- Έλλειψη

- Γλώσσα

- large

- ΜΑΘΑΊΝΩ

- μάθηση

- μείον

- LLM

- κοιτάζοντας

- μηχανή

- μάθηση μηχανής

- κάνω

- ΚΑΝΕΙ

- κακόβουλο

- πολοί

- εννοώ

- νόημα

- μέτρο

- Μνήμη

- μήνυμα

- πληρούνται

- μετρικός

- Metrics

- Μετριάζω

- ML

- MLOps

- μοντέλο

- μοντέλα

- σπονδυλωτή

- Μονάδα μέτρησης

- ενότητες

- Παρακολούθηση

- παρακολούθηση

- παρακολούθηση

- περισσότερο

- Φυσικό

- Επεξεργασία φυσικής γλώσσας

- απαραίτητος

- Νέα

- nlp

- κοινοποιήσεις

- τώρα

- of

- προσβλητικός

- προσφορές

- συχνά

- on

- ONE

- αυτά

- διαδικτυακά (online)

- Επιλογή

- or

- ενορχήστρωση

- δικός μας

- παραγωγή

- εξόδους

- εκτός

- φόρμες

- επισκόπηση

- δική

- ζεύγος

- ζεύγη

- μέρος

- πέρασε

- Πέρασμα

- για

- επίδοση

- φράσεις

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- παιχνίδι

- δυνατός

- Θέση

- δυναμικού

- ισχυρός

- πρακτική

- παρουσία

- μεταποίηση

- παράγει

- επαγγελματίας

- προτρέπει

- προτείνεται

- παρέχουν

- παρέχει

- Python

- ποιότητα

- γρήγορα

- αναλογία

- Ανάγνωση

- σε πραγματικό χρόνο

- λαμβάνει

- συνιστώ

- παραπέμπω

- άρνηση

- αρνήθηκε

- αξιοπιστία

- αξιόπιστος

- Αποθήκη

- εκπροσωπώ

- ζητήσει

- αιτήματα

- απαιτούν

- απαιτήσεις

- σεβασμός

- εκείνοι

- απάντησης

- απαντήσεις

- υπεύθυνος

- επανάσταση

- δεξιά

- κινδύνους

- εύρωστος

- τρέξιμο

- Ασφάλεια

- σοφός

- αποθηκεύονται

- επεκτάσιμη

- Κλίμακα

- Δεύτερος

- τμήματα

- σημασιολογικός

- στείλετε

- αποστέλλει

- αρχαιότερος

- ευαίσθητος

- συναίσθημα

- Υπηρεσίες

- σειρά

- Βάρδιες

- θα πρέπει να

- βιτρίνα

- Σήμα

- παρόμοιες

- Απλούς

- Μέγεθος

- λύση

- Λύσεις

- μερικοί

- χωρική

- συγκεκριμένες

- Δαπάνες

- πρότυπο

- Βήμα

- Βήματα

- χώρος στο δίσκο

- ειλικρινής

- ροή

- τέτοιος

- προτείνω

- βέβαιος

- ράφτης

- Πάρτε

- λήψη

- Έργο

- εργασίες

- ομάδες

- τεχνικές

- κείμενο

- ότι

- Η

- οι πληροφορίες

- τους

- Τους

- Εκεί.

- Αυτοί

- αυτοί

- πράγμα

- αυτό

- Μέσω

- ώρα

- Τιτάν

- προς την

- TONE

- τροχιά

- Μεταμορφώστε

- Μετάφραση

- Ταξίδια

- αξιόπιστος

- προσπαθώντας

- δύο

- κατανόηση

- Απροσδόκητος

- χρήση

- μεταχειρισμένος

- Χρήστες

- Διεπαφής χρήστη

- Χρήστες

- χρησιμοποιώντας

- αξία

- Αξίες

- μέσω

- ορατότητα

- Τρόπος..

- τρόπους

- we

- ιστός

- διαδικτυακές υπηρεσίες

- Τι

- Τι είναι

- πότε

- ενώ

- Ποιό

- WHY

- Wikipedia

- με

- Εργασία

- ροής εργασίας

- Εσείς

- Σας

- zephyrnet