Esta es una publicación de blog invitada de Danny Brock, Rajeev Govindan y Krishnaram Kenthapadi en Fiddler AI.

tú Amazon SageMaker Los modelos están en vivo. Manejan millones de inferencias cada día y generan mejores resultados comerciales para su empresa. Están funcionando exactamente tan bien como el día en que se lanzaron.

Eh, espera. ¿Son ellos? Quizás. Tal vez no.

Sin clase empresarial seguimiento del modelo, tus modelos pueden estar decayendo en silencio. Es posible que sus equipos de aprendizaje automático (ML) nunca sepan que estos modelos en realidad se han transformado de milagros de generación de ingresos a pasivos que toman decisiones incorrectas que le cuestan tiempo y dinero a su empresa.

No te preocupes. La solución está más cerca de lo que crees.

Fiddler, una solución de gestión del rendimiento de modelos de clase empresarial disponible en el AWS Marketplace, ofrece monitoreo de modelos e inteligencia artificial explicable para ayudar a los equipos de ML a inspeccionar y abordar una amplia gama de problemas de modelos. A través de la supervisión de modelos, la explicabilidad de modelos, el análisis y la detección de sesgos, Fiddler proporciona a su empresa un único panel de control fácil de usar para garantizar que sus modelos se comporten como deberían. Y si no lo son, Fiddler también proporciona funciones que le permiten inspeccionar sus modelos para encontrar las causas subyacentes de la disminución del rendimiento.

Esta publicación muestra cómo su MLOps El equipo puede mejorar la productividad de los científicos de datos y reducir el tiempo para detectar problemas en sus modelos implementados en SageMaker mediante la integración con Fiddler Model Performance Management Platform en unos simples pasos.

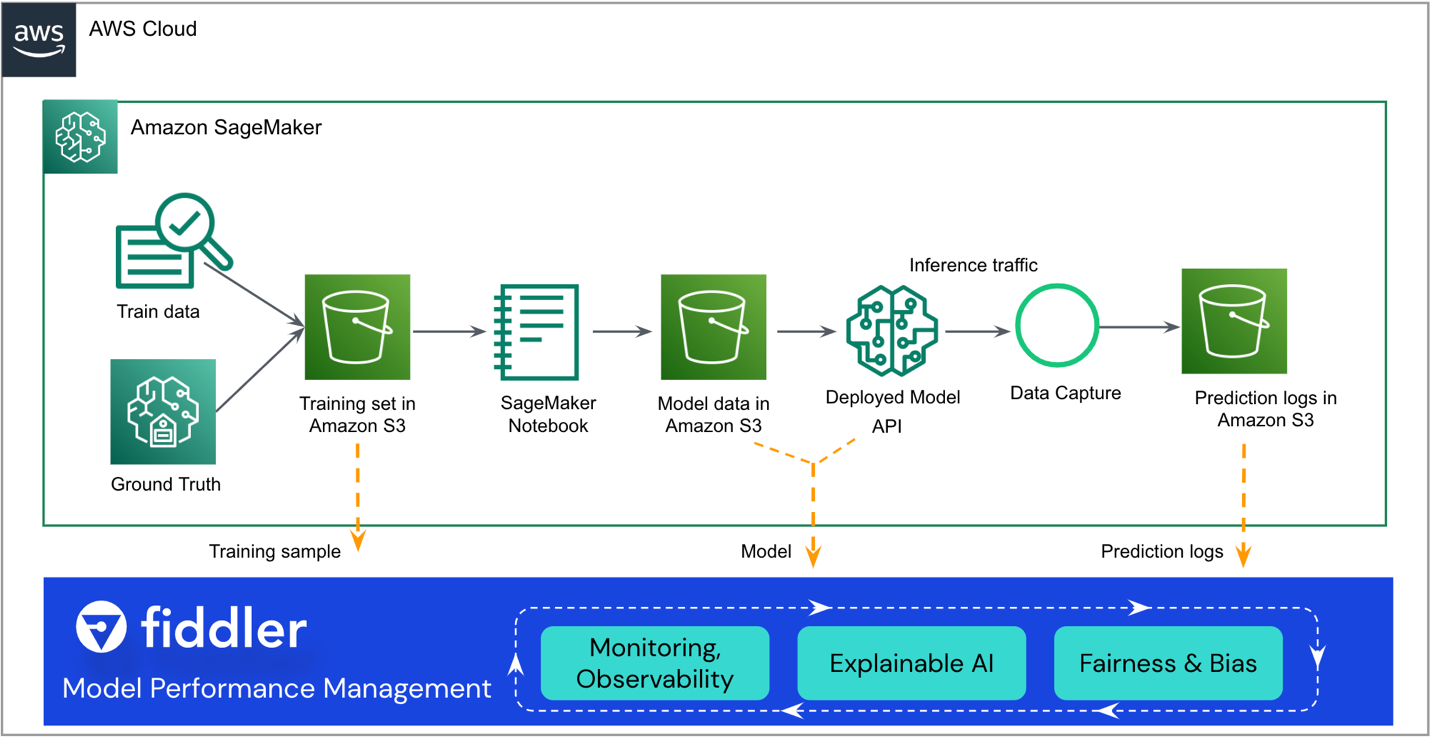

Resumen de la solución

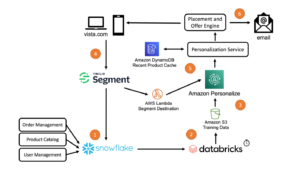

La siguiente arquitectura de referencia destaca los principales puntos de integración. Fiddler existe como un "acompañante" para su flujo de trabajo existente de SageMaker ML.

El resto de esta publicación lo guía a través de los pasos para integrar su modelo de SageMaker con el de Fiddler. Plataforma de gestión del rendimiento del modelo:

- Asegúrese de que su modelo tenga habilitada la captura de datos.

- Cree un entorno de prueba de Fiddler.

- Registre información sobre su modelo en su entorno Fiddler.

- Crear una AWS Lambda Función para publicar inferencias de SageMaker en Fiddler.

- Explore las capacidades de supervisión de Fiddler en su entorno de prueba de Fiddler.

Requisitos previos

Esta publicación asume que configuró SageMaker e implementó un punto final modelo. Para obtener información sobre cómo configurar SageMaker para la publicación de modelos, consulte Implementar modelos para inferencia. Algunos ejemplos también están disponibles en el Repositorio GitHub.

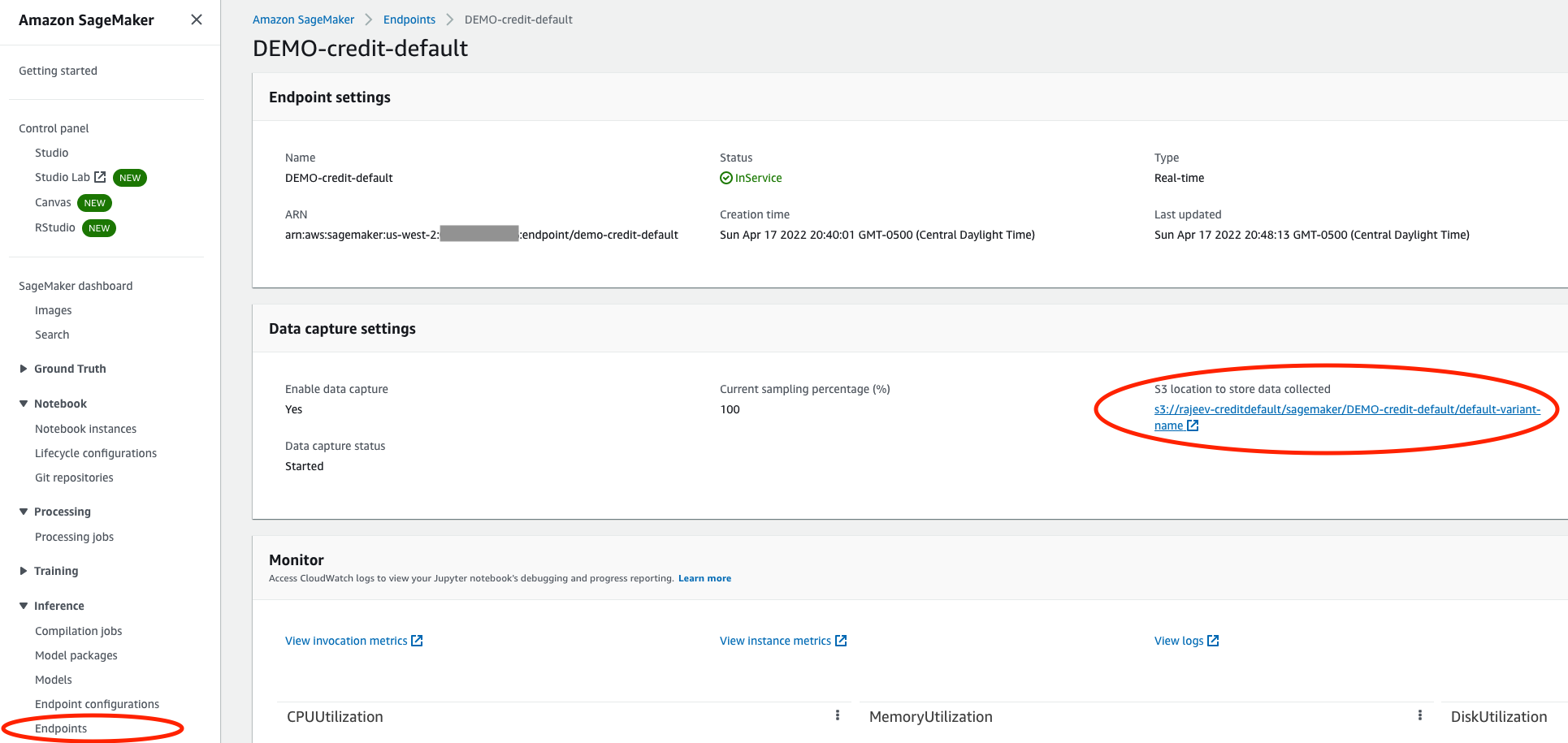

Asegúrese de que su modelo tenga habilitada la captura de datos

En la consola de SageMaker, navegue hasta el extremo de servicio de su modelo y asegúrese de haber habilitado captura de datos en una Servicio de almacenamiento simple de Amazon (Amazon S3) cubeta. Esto almacena las inferencias (solicitudes y respuestas) que su modelo hace cada día como Archivos de líneas JSON (.jsonl) en Amazon S3.

Crear un entorno de prueba de Fiddler

Desde el violinista.ai sitio web, puede solicitar una prueba gratuita. Después de completar un formulario rápido, Fiddler se comunicará con usted para comprender los detalles de las necesidades de administración del rendimiento de su modelo y tendrá un entorno de prueba listo para usted en unas pocas horas. Puede esperar un entorno dedicado como https://yourcompany.try.fiddler.ai.

Registre información sobre su modelo en su entorno Fiddler

Antes de que pueda comenzar a publicar eventos desde su modelo alojado de SageMaker en Fiddler, debe crear un proyecto dentro de su entorno de prueba de Fiddler y proporcionar detalles de Fiddler sobre su modelo a través de un paso llamado registro de modelo. Si desea utilizar un portátil preconfigurado desde dentro Estudio Amazon SageMaker en lugar de copiar y pegar los siguientes fragmentos de código, puede hacer referencia al cuaderno de inicio rápido de Fiddler en GitHub. Studio proporciona una única interfaz visual basada en web donde puede realizar todos los pasos de desarrollo de ML.

Primero, debe instalar el Cliente de Fiddler Python en su cuaderno SageMaker e instanciar el cliente Fiddler. Puedes obtener el AUTH_TOKEN del desplegable Ajustes en su entorno de prueba de Fiddler.

A continuación, cree un proyecto dentro de su entorno de prueba de Fiddler:

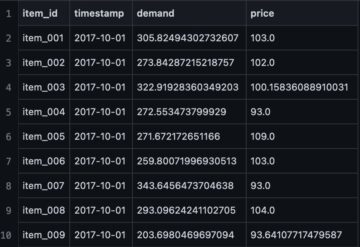

Ahora cargue su conjunto de datos de entrenamiento. El cuaderno también proporciona un conjunto de datos de muestra para ejecutar Fiddler's explicabilidad algoritmos y como línea de base para monitorear métricas. El conjunto de datos también se usa para generar el esquema para este modelo en Fiddler.

Por último, antes de que pueda comenzar a publicar inferencias en Fiddler para monitoreo, análisis de causa raíz y explicaciones, debe registrar su modelo. Primero vamos a crear un model_info objeto que contiene los metadatos sobre su modelo:

Luego puede registrar el modelo usando su nuevo model_info :

¡Excelente! Ahora puede publicar algunos eventos en Fiddler para observar el rendimiento del modelo.

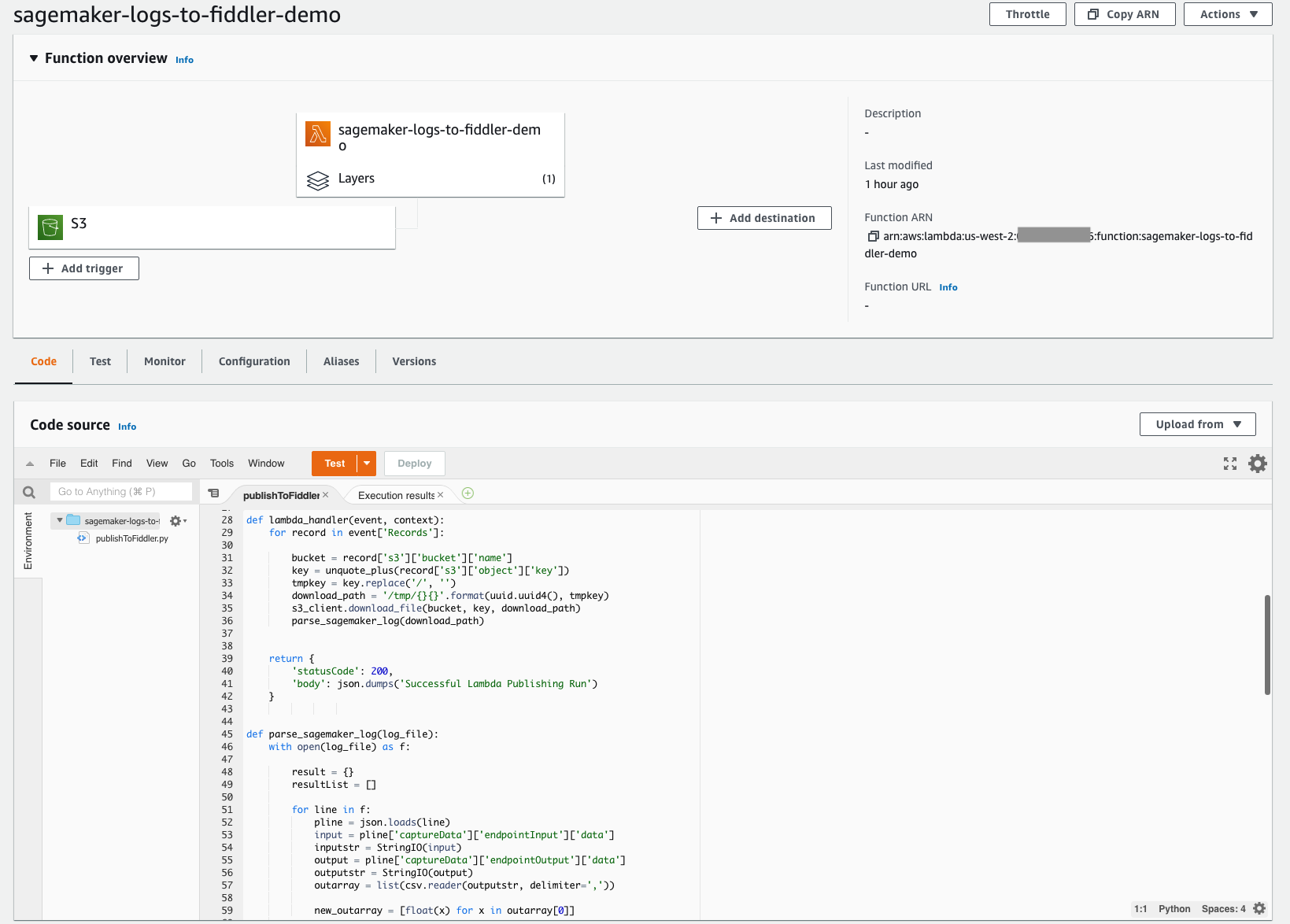

Cree una función Lambda para publicar inferencias de SageMaker en Fiddler

Con la arquitectura sin servidor de Lambda fácil de implementar, puede crear rápidamente el mecanismo necesario para mover sus inferencias desde el depósito de S3 que configuró anteriormente a su entorno de prueba de Fiddler recién aprovisionado. Esta función Lambda es responsable de abrir cualquier archivo de registro de eventos JSONL nuevo en el depósito S3 de su modelo, analizar y formatear el contenido JSONL en un marco de datos y luego publicar ese marco de datos de eventos en su entorno de prueba de Fiddler. La siguiente captura de pantalla muestra los detalles del código de nuestra función.

La función Lambda debe configurarse para que se active a partir de archivos recién creados en su depósito S3. El seguimiento tutoriales lo guía a través de la creación de un Puente de eventos de Amazon activador que invoca la función Lambda cada vez que se carga un archivo en Amazon S3. La siguiente captura de pantalla muestra la configuración del disparador de nuestra función. Esto simplifica garantizar que cada vez que su modelo haga nuevas inferencias, los eventos almacenados en Amazon S3 se carguen en Fiddler para impulsar la observabilidad del modelo que su empresa necesita.

Para simplificar esto aún más, el código para esta función de Lambda está disponible públicamente en Sitio de documentación de Fiddler. Este ejemplo de código actualmente funciona para modelos de clasificación binaria con entradas estructuradas. Si tiene tipos de modelos con diferentes características o tareas, comuníquese con Fiddler para obtener ayuda con cambios menores en el código.

La función Lambda debe hacer referencia al cliente Fiddler Python. Fiddler ha creado una capa Lambda disponible públicamente a la que puede hacer referencia para asegurarse de que import fiddler as fdl paso funciona a la perfección. Puede hacer referencia a esta capa a través de un ARN en la región us-west-2: arn:aws:lambda:us-west-2:079310353266:layer:fiddler-client-0814:1, como se muestra en la siguiente captura de pantalla.

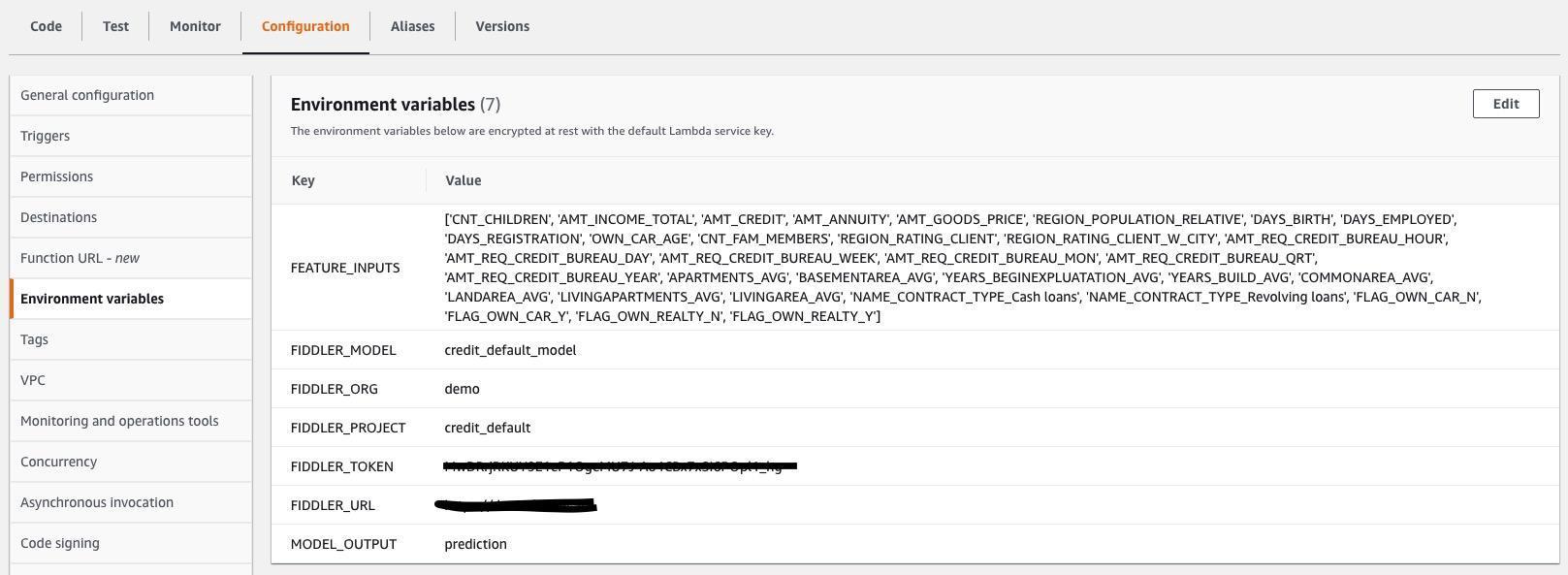

También debe especificar las variables de entorno de Lambda para que la función de Lambda sepa cómo conectarse a su entorno de prueba de Fiddler y cuáles son las entradas y salidas dentro de los archivos .jsonl que captura su modelo. La siguiente captura de pantalla muestra una lista de las variables de entorno requeridas, que también están en Sitio de documentación de Fiddler. Actualice los valores de las variables de entorno para que coincidan con su modelo y conjunto de datos.

Explore las capacidades de monitoreo de Fiddler en su entorno de prueba de Fiddler

¡Lo has hecho! Con sus datos de referencia, modelo y tráfico conectados, ahora puede explicar deriva de datos, valores atípicos, sesgo del modelo, problemas de datos y problemas de rendimiento, y comparta paneles con otros. Completa tu viaje por viendo una demostración sobre las capacidades de gestión del rendimiento del modelo que ha introducido en su empresa.

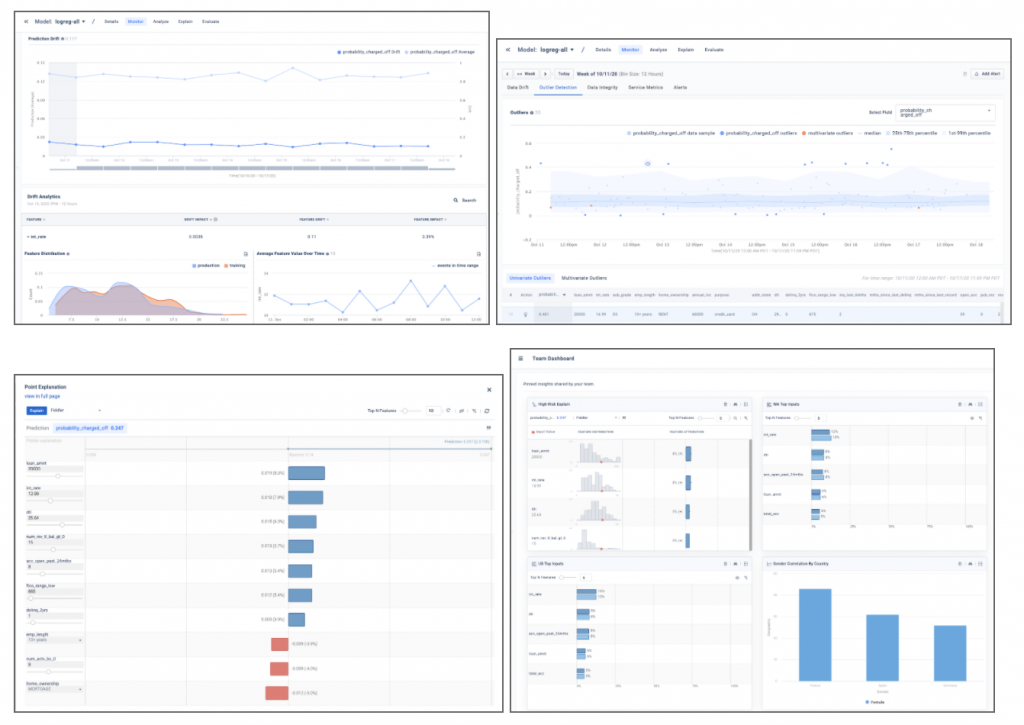

Las capturas de pantalla de ejemplo a continuación brindan una idea de la información del modelo, como la deriva, la detección de valores atípicos, las explicaciones de puntos locales y el análisis del modelo que se encontrará en su entorno de prueba de Fiddler.

Conclusión

Esta publicación destacó la necesidad de clase empresarial seguimiento del modelo y mostró cómo puede integrar sus modelos implementados en SageMaker con el Plataforma de gestión del rendimiento del modelo Fiddler en solo unos pocos pasos. Fiddler ofrece funcionalidad para el monitoreo de modelos, IA explicable, detección de sesgos y análisis de causa raíz, y está disponible en el AWS Marketplace. Al proporcionar su MLOps equipo con un único panel de vidrio fácil de usar para garantizar que sus modelos se comporten como se espera y para identificar las causas subyacentes de la degradación del rendimiento, Fiddler puede ayudar a mejorar la productividad de los científicos de datos y reducir el tiempo para detectar y resolver problemas.

Si desea obtener más información sobre Fiddler, visite violinista.ai o si prefiere configurar una demostración personalizada y un correo electrónico de discusión técnica ventas@fiddler.ai.

Acerca de los autores

danny brock es ingeniero de soluciones sénior en Fiddler AI. Danny tiene una larga experiencia en el espacio de análisis y ML, dirigiendo equipos de preventa y posventa para nuevas empresas como Endeca e Incorta. Fundó su propia empresa de consultoría de análisis de big data, Branchbird, en 2012.

danny brock es ingeniero de soluciones sénior en Fiddler AI. Danny tiene una larga experiencia en el espacio de análisis y ML, dirigiendo equipos de preventa y posventa para nuevas empresas como Endeca e Incorta. Fundó su propia empresa de consultoría de análisis de big data, Branchbird, en 2012.

Rajeev Govindan es ingeniero de soluciones sénior en Fiddler AI. Rajeev tiene una amplia experiencia en ingeniería de ventas y desarrollo de software en varias empresas empresariales, incluida AppDynamics.

Rajeev Govindan es ingeniero de soluciones sénior en Fiddler AI. Rajeev tiene una amplia experiencia en ingeniería de ventas y desarrollo de software en varias empresas empresariales, incluida AppDynamics.

Krishnaram Kenthapadi es el científico jefe de Fiddler AI. Anteriormente, fue científico principal en Amazon AWS AI, donde lideró las iniciativas de equidad, explicabilidad, privacidad y comprensión de modelos en la plataforma de Amazon AI, y antes de eso, ocupó cargos en LinkedIn AI y Microsoft Research. Krishnaram recibió su doctorado en Ciencias de la Computación de la Universidad de Stanford en 2006.

Krishnaram Kenthapadi es el científico jefe de Fiddler AI. Anteriormente, fue científico principal en Amazon AWS AI, donde lideró las iniciativas de equidad, explicabilidad, privacidad y comprensión de modelos en la plataforma de Amazon AI, y antes de eso, ocupó cargos en LinkedIn AI y Microsoft Research. Krishnaram recibió su doctorado en Ciencias de la Computación de la Universidad de Stanford en 2006.

- AI

- arte ai

- generador de arte ai

- robot ai

- Amazon SageMaker

- inteligencia artificial

- certificación de inteligencia artificial

- inteligencia artificial en banca

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- Aprendizaje automático de AWS

- AWS Marketplace

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- deep learning

- google ai

- máquina de aprendizaje

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- escala ia

- sintaxis

- zephyrnet