Datos de los usuarios: alimento vital de los LLM

¡Sí! RT @bryce Me encanta esta cita: “Si no pagas por ello, no eres el cliente; tú eres el producto que se vende”. http://bit.ly/93JYCJ

- Tim O'Reilly (@timoreilly) 2 de septiembre de 2010

Manténgase al tanto de las noticias criptográficas, obtenga actualizaciones diarias en su bandeja de entrada.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- :posee

- :es

- :no

- 7

- 8

- a

- capacidad

- Absoluto

- Conforme

- preciso

- adaptación

- direccionamiento

- Añade

- avanzado

- .

- Está de acuerdo

- AI

- Servicios de IA

- Sistemas de IA

- paquete de capacitación DWoVH

- Alexa

- Alinea

- Todos

- permite

- también

- hacerlo

- Amazon

- an

- y

- Antrópico

- anticiparse a

- cualquier

- aplicable

- somos

- AS

- asumir

- At

- Hoy Disponibles

- evitar

- conscientes

- basado

- BE

- porque

- "Ser"

- creído

- beneficioso

- mejores

- entre

- by

- PUEDEN

- reclamaciones

- clientes

- completo

- compromiso

- confirma

- Empresas

- compañía

- competitivos

- concepto

- Inquietudes

- constantemente

- contenido

- contexto

- continuamente

- control

- Conveniente

- conversaciones

- derechos de autor,

- podría

- crucial

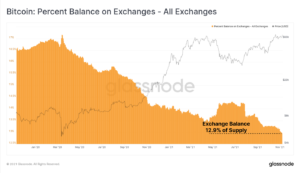

- cripto

- Crypto Noticias

- Current

- cliente

- Clientes

- todos los días

- Oscuro

- datos

- privacidad de datos

- debate

- décadas

- Descifrar

- profundo

- deep learning

- Predeterminado

- La defensa de

- entregar

- depende

- renuncia

- disputas

- Diversidad

- do

- documento

- sí

- dólares

- No

- durante

- Ganancias

- Southern Implants

- eficacia

- ya sea

- de su negocio.

- mejorar

- asegura

- esencial

- ético

- ética

- ejemplo

- Intercambio

- experience

- en los detalles

- grado

- externo

- tener problemas con

- Ex

- Fundado

- Gratuito

- Desde

- ganando

- generar

- generado

- genera

- generativo

- IA generativa

- obtener

- conseguir

- gigantes

- Donar

- Go

- conceder

- agarrar

- crece

- fuertemente

- honesto

- honor

- Sin embargo

- http

- HTTPS

- humana

- ideales

- if

- mejorar

- in

- INSTRUMENTO individual

- información

- propiedad

- la propiedad intelectual

- intenciones

- interacciones

- interno

- IP

- IT

- SUS

- sí mismo

- Clave

- idioma

- large

- más reciente

- de derecho criminal

- Lead

- APRENDE:

- aprendizaje

- Legal

- Apalancamiento

- como

- Llama

- LLM

- amar

- para lograr

- Realizar

- Puede..

- Medios

- Meta

- millones

- modelo

- modelos

- más,

- MEJOR DE TU

- telecomunicaciones

- neural

- redes neuronales

- Nuevo

- noticias

- obtención

- of

- on

- OpenAI

- or

- aparentemente

- de otra manera

- nuestros

- salir

- salidas

- Más de

- EL DESARROLLADOR

- Posee

- dinero

- partes

- fiesta

- .

- Pagar

- pago

- (PDF)

- con

- personalización

- Personalizado

- Fotos

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- política

- posible

- industria

- poderoso

- prácticas

- predecir

- Predicciones

- preferencias

- frecuente

- política de privacidad

- privada

- producido

- Producto

- ideas

- perfecta

- proporcionar

- proporciona un

- público

- confianza pública

- en público

- cotización inicial

- carreras

- RE

- mundo real

- recibe

- FILTRO

- Considerar

- relativo

- ,

- reportado

- solicitudes

- investigadores

- responsable

- Revelado

- derechos

- rivales

- rt

- Ryan

- s

- dices

- dice

- escena

- de coches

- Servicios

- set

- Compartir

- tienes

- Escepticismo

- So

- Social

- redes sociales

- vendido

- HECHIZO

- portavoz

- inicio

- Posicionamiento

- quedarse

- paso

- Todas las funciones a su disposición

- Tandem

- tecnología

- los gigantes tecnológicos

- técnicas

- términos

- texto

- esa

- La

- su

- Les

- Estas

- ellos

- así

- Tim

- a

- hoy

- parte superior

- Entrenar

- entrenado

- Formación

- Transparencia

- Tendencias

- Confía en

- bajo

- entender

- comprensión

- próximos

- actualizado

- Actualizaciones

- actualizado

- subido

- utilizan el

- usado

- Usuario

- usuarios

- usando

- Valioso

- diversos

- versión

- Videos

- vital

- Voz

- volumen

- fue

- we

- tuvieron

- cuando

- sean

- que

- porque

- seguirá

- Palabra

- se

- Usted

- tú

- zephyrnet