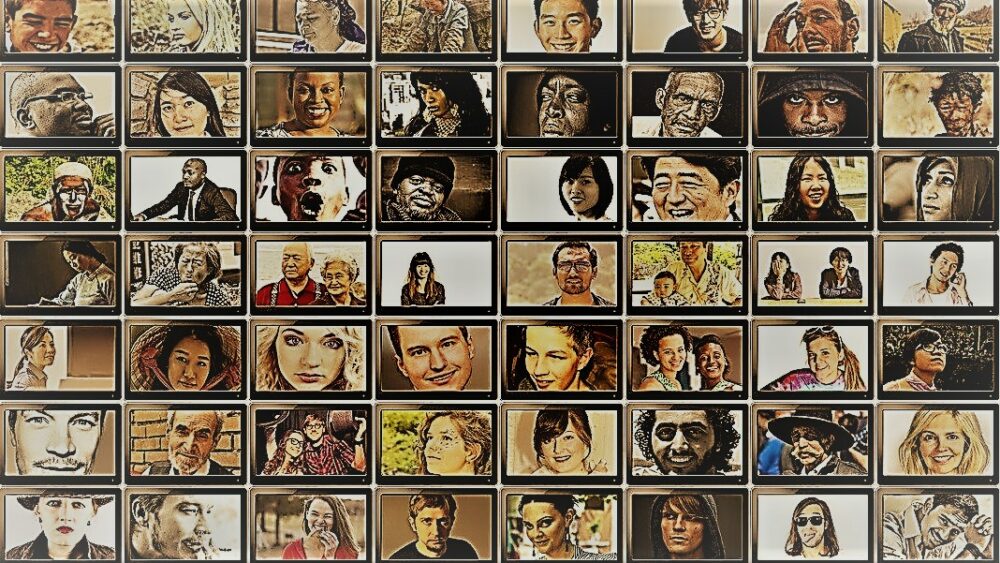

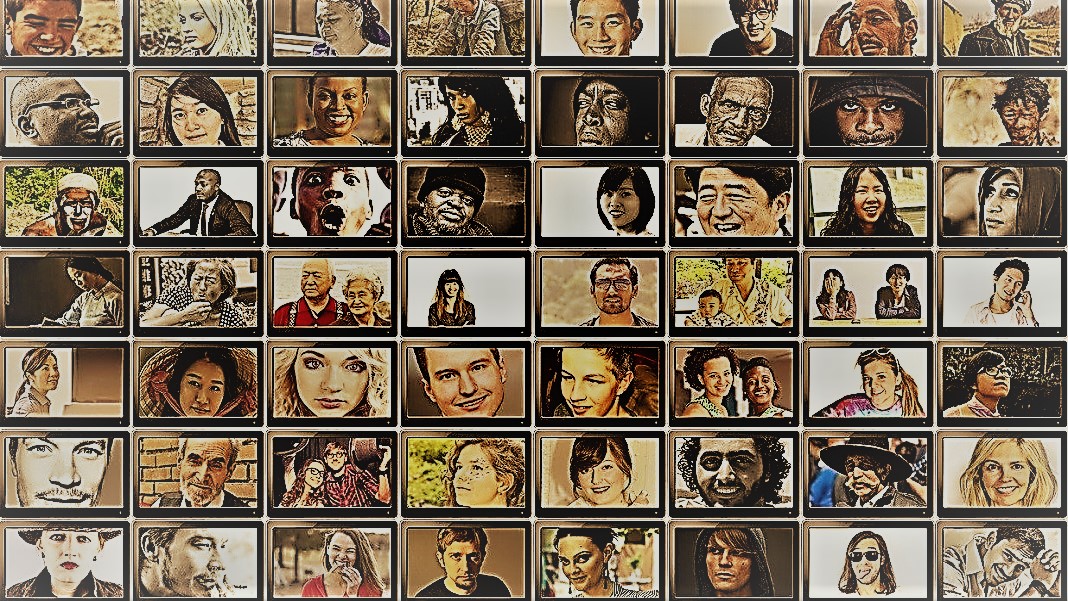

Soy un gran admirador del programa de viajes de Anthony Bourdain. Partes Desconocidas. En cada episodio, el chef visita aldeas remotas en todo el mundo, documentando las vidas, comidas y culturas de las tribus regionales con un corazón y una mente abiertos.

El espectáculo ofrece un vistazo a la asombrosa diversidad de la humanidad. Los científicos sociales tienen un objetivo similar: comprender el comportamiento de diferentes personas, grupos y culturas, pero utilizan una variedad de métodos en situaciones controladas. Para ambos, las estrellas de estas actividades son los sujetos: los humanos.

Pero, ¿y si reemplazas a los humanos con chatbots de IA?

La idea suena absurda. Sin embargo, gracias a la llegada de ChatGPT y otros modelos de lenguaje extenso (LLM), los científicos sociales están coqueteando con la idea de usar estas herramientas para construir rápidamente diversos grupos de "humanos simulados" y realizar experimentos para probar su comportamiento y valores como un representante de sus contrapartes biológicas.

Si estás imaginando mentes humanas recreadas digitalmente, eso no es todo. La idea es aprovechar la experiencia de ChatGPT para imitar las respuestas humanas. Debido a que los modelos extraen enormes cantidades de datos en línea (blogs, comentarios de Youtube, fan fiction, libros), capturan fácilmente las relaciones entre palabras en varios idiomas. Estos algoritmos sofisticados también pueden decodificar aspectos matizados del lenguaje, como la ironía, el sarcasmo, las metáforas y los tonos emocionales, un aspecto crítico de la comunicación humana en todas las culturas. Estas fortalezas configuran a los LLM para imitar múltiples personalidades sintéticas con una amplia gama de creencias.

¿Otro bono? En comparación con los participantes humanos, ChatGPT y otros LLM no se cansan, lo que permite a los científicos recopilar datos y probar teorías sobre el comportamiento humano con una velocidad sin precedentes.

La idea, aunque controvertida, ya tiene apoyo. Un articulo reciente Al revisar el campo naciente se encontró que en ciertos escenarios cuidadosamente diseñados, las respuestas de ChatGPT se correlacionaron con las de aproximadamente el 95 por ciento de los participantes humanos.

La IA "podría cambiar el juego para la investigación en ciencias sociales" dijo Dr. Igor Grossman de la Universidad de Waterloo, quien con colegas recientemente escribió un artículo de anticipación en Ciencia:. La clave para usar homo silicio ¿en la investigación? Manejo cuidadoso del sesgo y fidelidad de los datos, dijo el equipo.

Sondeando la mente social humana

¿Qué es exactamente la ciencia social?

En pocas palabras, se trata de estudiar cómo los seres humanos, ya sea como individuos o como grupo, se comportan en diferentes circunstancias, cómo interactúan entre sí y cómo se desarrollan como cultura. Es un paraguas de actividad académica con múltiples ramas: economía, ciencias políticas, antropología y psicología.

La disciplina aborda una amplia gama de temas destacados en el espíritu de la época actual. ¿Cuál es el impacto de las redes sociales en la salud mental? ¿Cuáles son las actitudes públicas actuales hacia el cambio climático a medida que aumentan los episodios de clima severo? ¿Cómo valoran las diferentes culturas los métodos de comunicación y qué desencadena malentendidos?

Un estudio de ciencias sociales comienza con una pregunta y una hipótesis. Uno de mis favoritos: ¿las culturas toleran el olor corporal de manera diferente? (En serio, El tema ha sido estudiado bastante, y si, hay una diferencia!)

Luego, los científicos usan una variedad de métodos, como cuestionarios, pruebas de comportamiento, observación y modelado para probar sus ideas. Las encuestas son una herramienta especialmente popular, porque las preguntas pueden diseñarse y examinarse de manera estricta y llegar fácilmente a una amplia gama de personas cuando se distribuyen en línea. Luego, los científicos analizan las respuestas escritas y obtienen información sobre el comportamiento humano. En otras palabras, el uso del lenguaje por parte de un participante es fundamental para estos estudios.

Entonces, ¿cómo encaja ChatGPT?

El 'Homo Silicus'

Para Grossman, los LLM detrás de chatbots como ChatGPT o Bard de Google representan una oportunidad sin precedentes para rediseñar experimentos de ciencias sociales.

Debido a que están capacitados en conjuntos de datos masivos, los LLM "pueden representar una amplia gama de experiencias y perspectivas humanas", dijeron los autores. Debido a que los modelos "deambulan" libremente sin fronteras por Internet, como las personas que a menudo viajan internacionalmente, pueden adoptar y mostrar una gama más amplia de respuestas en comparación con los sujetos humanos reclutados.

ChatGPT tampoco se ve influenciado por otros miembros de un estudio ni se cansa, lo que potencialmente le permite generar respuestas menos sesgadas. Estos rasgos pueden ser especialmente útiles en "proyectos de alto riesgo", por ejemplo, imitar las respuestas de las personas que viven en países en guerra o bajo regímenes difíciles a través de publicaciones en las redes sociales. A su vez, las respuestas podrían informar intervenciones en el mundo real.

De manera similar, los LLM capacitados en temas culturales candentes como la identidad de género o la desinformación podrían reproducir diferentes escuelas de pensamiento teóricas o ideológicas para informar las políticas. En lugar de encuestar minuciosamente a cientos de miles de participantes humanos, la IA puede generar rápidamente respuestas basadas en el discurso en línea.

Dejando a un lado los usos potenciales de la vida real, los LLM también pueden actuar como sujetos digitales que interactúan con participantes humanos en experimentos de ciencias sociales, algo similar a los personajes no jugadores (NPC) en los videojuegos. Por ejemplo, el LLM podría adoptar diferentes "personalidades" e interactuar con voluntarios humanos en todo el mundo en línea usando texto haciéndoles la misma pregunta. Debido a que los algoritmos no duermen, podría funcionar las 24 horas del día, los 7 días de la semana. Los datos resultantes pueden ayudar a los científicos a explorar cómo diversas culturas evalúan información similar y cómo se propagan las opiniones y la información errónea.

Baby Steps

La idea de usar chatbots en lugar de humanos en los estudios aún no se ha generalizado.

Pero hay pruebas preliminares de que podría funcionar. A estudio de preimpresión lanzado este mes por Georgia Tech, Microsoft Research y Olin College descubrió que un LLM reprodujo las respuestas humanas en numerosos experimentos de psicología clásica, incluido el infame Experimentos de choque de Milgram.

Sin embargo, queda una pregunta crítica: ¿qué tan bien pueden estos modelos capturar realmente la respuesta de un ser humano?

Hay varios obstáculos.

Primero está la calidad del algoritmo y los datos de entrenamiento. La mayoría del contenido en línea está dominado por solo un puñado de idiomas. Un LLM capacitado en estos datos podría imitar fácilmente el sentimiento, la perspectiva o incluso el juicio moral de las personas que usan esos idiomas, lo que a su vez heredaría el sesgo de los datos de capacitación.

“Esta reproducción del sesgo es una gran preocupación porque podría amplificar las mismas disparidades que los científicos sociales se esfuerzan por descubrir en su investigación”, dijo Grossman.

A algunos científicos también les preocupa que los LLM sean solo regurgitando lo que se les dice. Es la antítesis de un estudio de ciencias sociales, en el que el punto principal es capturar a la humanidad en toda su belleza diversa y compleja. Por otro lado, se sabe que ChatGPT y modelos similares “alucinar”, inventando información que suena plausible pero es falsa.

Por ahora, “los grandes modelos de lenguaje se basan en 'sombras' de experiencias humanas”, dijo Grossman. Debido a que estos sistemas de IA son en gran parte cajas negras, es difícil entender cómo o por qué generan ciertas respuestas, un poco preocupante cuando se usan como representantes humanos en experimentos de comportamiento.

A pesar de las limitaciones, "los LLM permiten a los científicos sociales romper con los métodos de investigación tradicionales y abordar su trabajo de manera innovadora", dijeron los autores. Como primer paso, Homo silicus podría ayudar a intercambiar ideas y probar rápidamente hipótesis, y las prometedoras se validarían aún más en poblaciones humanas.

Pero para que las ciencias sociales realmente den la bienvenida a la IA, deberá haber transparencia, equidad e igualdad de acceso a estos poderosos sistemas. Los LLM son difíciles y costosos de capacitar, y los modelos recientes se cierran cada vez más detrás de fuertes muros de pago.

"Debemos asegurarnos de que los LLM de ciencias sociales, como todos los modelos científicos, sean de código abierto, lo que significa que sus algoritmos e, idealmente, los datos estén disponibles para todos para examinarlos, probarlos y modificarlos". dijo la autora del estudio, la Dra. Dawn Parker, de la Universidad de Waterloo. “Solo manteniendo la transparencia y la replicabilidad podemos asegurarnos de que la investigación en ciencias sociales asistida por IA realmente contribuya a nuestra comprensión de la experiencia humana”.

Crédito de la imagen: Gerd Altmann / Pixabay

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Automoción / vehículos eléctricos, Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- Desplazamientos de bloque. Modernización de la propiedad de compensaciones ambientales. Accede Aquí.

- Fuente: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- :posee

- :es

- :no

- $ UP

- 23

- a

- Nuestra Empresa

- académico

- de la máquina

- a través de

- Actúe

- adoptar

- adviento

- AI

- algoritmo

- algoritmos

- Todos

- permitir

- Permitir

- ya haya utilizado

- también

- cantidades

- an

- analizar

- y

- Antonio

- enfoque

- somos

- Arizona

- Formación

- artículo

- AS

- aspecto

- aspectos

- At

- autor

- Autorzy

- Hoy Disponibles

- basado

- BE

- Beauty

- porque

- esto

- comportamiento

- detrás de

- "Ser"

- creencias

- entre

- parcialidad

- parcial

- Poco

- Negro

- Bloques

- cuerpo

- Depósito

- fronteras

- ambas

- cajas

- una lluvia de ideas

- sucursales

- Descanso

- pero

- by

- PUEDEN

- capturar

- cuidadoso

- a ciertos

- el cambio

- personajes

- Chatbots

- ChatGPT

- circunstancias

- Clima

- Cambio climático

- personal

- recoger

- Financiamiento para la

- comentarios

- Comunicación

- en comparación con

- integraciones

- Protocolo de Tratamiento

- construir

- contenido

- contribuye

- controlado

- polémico

- podría

- países

- crédito

- crítico

- aspecto crítico

- cultural

- Cultura

- Current

- datos

- conjuntos de datos

- diseñado

- desarrollar

- una experiencia diferente

- difícil

- digital

- digitalmente

- Pantalla

- distribuidos

- diverso

- Diversidad

- do

- sí

- No

- No

- dr

- dibujar

- cada una

- Temprano en la

- pasan fácilmente

- Ciencias económicas

- enorme

- garantizar

- episodio

- igual

- especialmente

- evaluar

- Incluso

- Cada

- exactamente

- ejemplo

- costoso

- experience

- Experiencias

- experimentos

- Experiencia

- explorar

- justicia

- false

- ventilador

- Ficción

- fidelidad

- campo

- Nombre

- cómodo

- comidas

- encontrado

- Desde

- promover

- juego

- Juegos

- Género

- generar

- Georgia

- obtener

- Vislumbrar

- globo

- De Google

- Grupo

- mano

- puñado

- Tienen

- Salud

- Corazón

- ayuda

- HOT

- Cómo

- HTML

- http

- HTTPS

- enorme

- humana

- Experiencia humana

- con Humildad

- Humanos

- Cientos

- idea

- idealmente

- ideas

- Identidad

- if

- Impacto

- in

- En otra

- Incluye

- aumente

- cada vez más

- individuos

- infame

- influenciado

- informar

- información

- originales

- Insights

- interactuar

- dentro

- ironía

- IT

- SUS

- jpg

- solo

- Clave

- conocido

- idioma

- Idiomas

- large

- principalmente

- menos

- como

- limitaciones

- Vidas

- alga viva

- LLM

- Inicio

- Corriente principal

- Mantener los

- gran

- Realizar

- Management

- masivo

- Puede..

- sentido

- Medios

- Miembros

- mental

- Salud mental

- métodos

- Microsoft

- mente

- mente

- Desinformación

- modelado

- modelos

- modificar

- Mes

- moral

- MEJOR DE TU

- múltiples

- debe

- my

- naciente

- ¿ Necesita ayuda

- no

- ahora

- numeroso

- of

- a menudo

- on

- ONE

- las

- en línea

- habiertos

- de código abierto

- Oportunidad

- or

- Otro

- "nuestr

- Participantes

- Personas

- por ciento

- Personalidades

- la perspectiva

- perspectivas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- plausible

- punto

- políticas

- político

- Popular

- poblaciones

- Artículos

- la posibilidad

- poderoso

- sonda

- destacado

- prometedor

- prueba

- proporciona un

- apoderado

- Psicología

- público

- búsqueda

- calidad

- pregunta

- Preguntas

- distancia

- rápidamente

- más bien

- en comunicarse

- mundo real

- realmente

- reciente

- recientemente

- rediseñar

- dietas

- regional

- Relaciones

- liberado

- confiar

- permanece

- sanaciones

- reemplazados

- replicabilidad

- replicado

- representar

- reproducción

- la investigación

- respuesta

- respuestas

- resultante

- aproximadamente

- Ejecutar

- Said

- mismo

- escenarios

- Escuelas

- Ciencia:

- CIENCIAS

- científico

- los científicos

- sentimiento

- set

- Varios

- grave

- Mostrar

- similares

- simplemente

- circunstancias

- sueño

- Social

- redes sociales

- Publicaciones en redes sociales

- societal

- algo

- sofisticado

- velocidad

- Estrellas

- comienza

- paso

- fortalezas

- esforzarse

- estudios

- ESTUDIO

- Estudiando

- tropezando

- tal

- SOPORTE

- sintético

- Todas las funciones a su disposición

- Tacleadas

- Pulsa para buscar

- equipo

- tecnología

- test

- pruebas

- que

- Muchas Gracias

- esa

- La

- su

- Les

- luego

- teorético

- Ahí.

- Estas

- ellos

- así

- aquellos

- ¿aunque?

- pensamiento

- miles

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- cansado

- a

- del IRS

- Temas

- hacia

- tradicional

- Entrenar

- entrenado

- Formación

- Transparencia

- viajes

- perturbador

- verdaderamente

- GIRO

- paraguas

- descubrir

- bajo

- entender

- comprensión

- universidad

- sin precedentes

- utilizan el

- usos

- usando

- validado

- propuesta de

- Valores

- variedad

- Vasto

- muy

- examinado

- Video

- videojuegos

- Visitas

- voluntarios

- guerra

- formas

- we

- Tiempo

- bienvenido

- WELL

- ¿

- cuando

- que

- QUIENES

- porque

- amplio

- Amplia gama

- más ancho

- Wikipedia

- seguirá

- sin

- palabras

- Actividades:

- funciona

- preocuparse

- escrito

- si

- aún

- Usted

- Youtube

- Zeitgeist

- zephyrnet