El aprendizaje automático (ML) está revolucionando muchas industrias a un ritmo sin precedentes. La industria de la salud y las ciencias de la vida (HCLS) ha experimentado una rápida evolución en los últimos años y ha adoptado el aprendizaje automático en una multitud de casos de uso para brindar atención de calidad y mejorar los resultados de los pacientes.

En un ciclo de vida típico de ML, los ingenieros de datos y los científicos dedican la mayor parte de su tiempo a los pasos de preparación de datos e ingeniería de características antes incluso de comenzar con el proceso de creación y capacitación de modelos. Tener una herramienta que pueda reducir la barrera de entrada para la preparación de datos, mejorando así la productividad, es una solicitud muy deseable para estas personas. Wrangler de datos de Amazon SageMaker está diseñado específicamente por AWS para reducir la curva de aprendizaje y permitir que los profesionales de datos realicen tareas de preparación, limpieza e ingeniería de características de datos en menos esfuerzo y tiempo. Ofrece una interfaz GUI con muchas funciones integradas e integraciones con otros servicios de AWS, como Servicio de almacenamiento simple de Amazon (Amazon S3) y Tienda de funciones de Amazon SageMaker, así como fuentes de datos de socios, incluidos Snowflake y Databricks.

En esta publicación, demostramos cómo usar Data Wrangler para preparar datos de atención médica para entrenar un modelo para predecir la insuficiencia cardíaca, dada la demografía del paciente, las condiciones médicas previas y el historial de resultados de pruebas de laboratorio.

Resumen de la solución

La solución consta de los siguientes pasos:

- Adquiera un conjunto de datos de atención médica como entrada para Data Wrangler.

- Utilice las funciones de transformación integradas de Data Wrangler para transformar el conjunto de datos. Esto incluye soltar columnas, caracterizar datos/tiempo, unir conjuntos de datos, imputar valores faltantes, codificar variables categóricas, escalar valores numéricos, equilibrar el conjunto de datos y más.

- Utilice la función de transformación personalizada de Data Wrangler (código Pandas o PySpark) para complementar las transformaciones adicionales necesarias más allá de las transformaciones integradas y demostrar la extensibilidad de Data Wrangler. Esto incluye filtrar filas, agrupar datos, formar nuevos marcos de datos basados en condiciones y más.

- Utilice las funciones de visualización integradas de Data Wrangler para realizar un análisis visual. Esto incluye fuga de objetivos, correlación de características, modelo rápido y más.

- Utilice las opciones de exportación integradas de Data Wrangler para exportar el conjunto de datos transformado a Amazon S3.

- Inicie un cuaderno Jupyter para usar el conjunto de datos transformado en Amazon S3 como entrada para entrenar un modelo.

Generar un conjunto de datos

Ahora que nos hemos decidido por la declaración del problema de ML, primero nos fijamos en adquirir los datos que necesitamos. Estudios de investigación como Predicción de insuficiencia cardíaca puede proporcionar datos que ya están en buen estado. Sin embargo, a menudo nos encontramos con escenarios en los que los datos están bastante desordenados y requieren unión, limpieza y varias otras transformaciones que son muy específicas del dominio de la atención médica antes de que puedan usarse para el entrenamiento de ML. Queremos encontrar o generar datos que sean lo suficientemente desordenados y guiarlo a través de los pasos para prepararlos usando Data Wrangler. Con eso en mente, elegimos Synthea como una herramienta para generar datos sintéticos que se ajusten a nuestro objetivo. Sintea es un generador de pacientes sintéticos de código abierto que modela el historial médico de los pacientes sintéticos. Para generar su conjunto de datos, complete los siguientes pasos:

- Siga las instrucciones según el guía de inicio rápido documentación para crear un Estudio Amazon SageMaker dominio e inicie Studio.

Este es un paso previo. Es opcional si Studio ya está configurado en su cuenta. - Después de iniciar Studio, en el lanzador pestaña, elegir terminal del sistema.

Esto inicia una sesión de terminal que le brinda una interfaz de línea de comando para trabajar. - Para instalar Synthea y generar el conjunto de datos en formato CSV, ejecute los siguientes comandos en la sesión de terminal iniciada:

Suministramos un parámetro para generar los conjuntos de datos con un tamaño de población de 10,000. Tenga en cuenta que el parámetro de tamaño indica el número de miembros vivos de la población. Además, Synthea también genera datos para los miembros muertos de la población, lo que podría agregar algunos puntos de datos adicionales además del tamaño de muestra especificado.

Espere hasta que se complete la generación de datos. Este paso suele tardar alrededor de una hora o menos. Synthea genera múltiples conjuntos de datos, incluidos patients, medications, allergies, conditions, y más. Para esta publicación, usamos tres de los conjuntos de datos resultantes:

- pacientes.csv – Este conjunto de datos tiene aproximadamente 3.2 MB y contiene aproximadamente 11,000 25 filas de datos de pacientes (XNUMX columnas que incluyen ID de paciente, fecha de nacimiento, género, dirección y más)

- condiciones.csv – Este conjunto de datos tiene aproximadamente 47 MB y contiene aproximadamente 370,000 filas de datos de condiciones médicas (seis columnas que incluyen la ID del paciente, la fecha de inicio de la condición, el código de la condición y más)

- observaciones.csv – Este conjunto de datos tiene aproximadamente 830 MB y contiene aproximadamente 5 millones de filas de datos de observación (ocho columnas que incluyen la identificación del paciente, la fecha de observación, el código de observación, el valor y más)

Existe una relación de uno a muchos entre el patients y conditions conjuntos de datos También existe una relación de uno a muchos entre el patients y observations conjuntos de datos Para obtener un diccionario de datos detallado, consulte Diccionario de datos del archivo CSV.

- Para cargar los conjuntos de datos generados en un depósito de origen en Amazon S3, ejecute los siguientes comandos en la sesión de terminal:

Lanzamiento de Data Wrangler

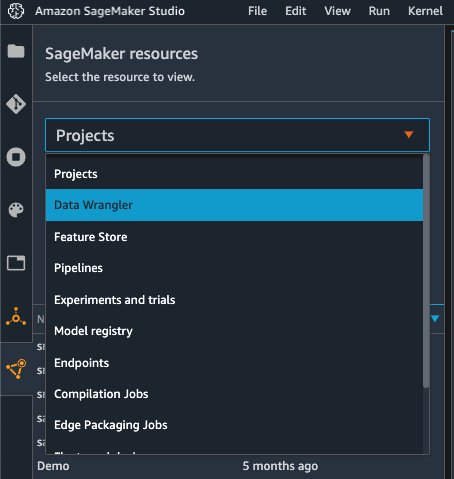

Elige Recursos de SageMaker en la página de navegación en Studio y en la Proyectos menú, seleccione Wrangler de datos para crear un flujo de datos de Data Wrangler. Para conocer los pasos detallados sobre cómo iniciar Data Wrangler desde Studio, consulte Comience con Data Wrangler.

Importar fechas

Para importar sus datos, complete los siguientes pasos:

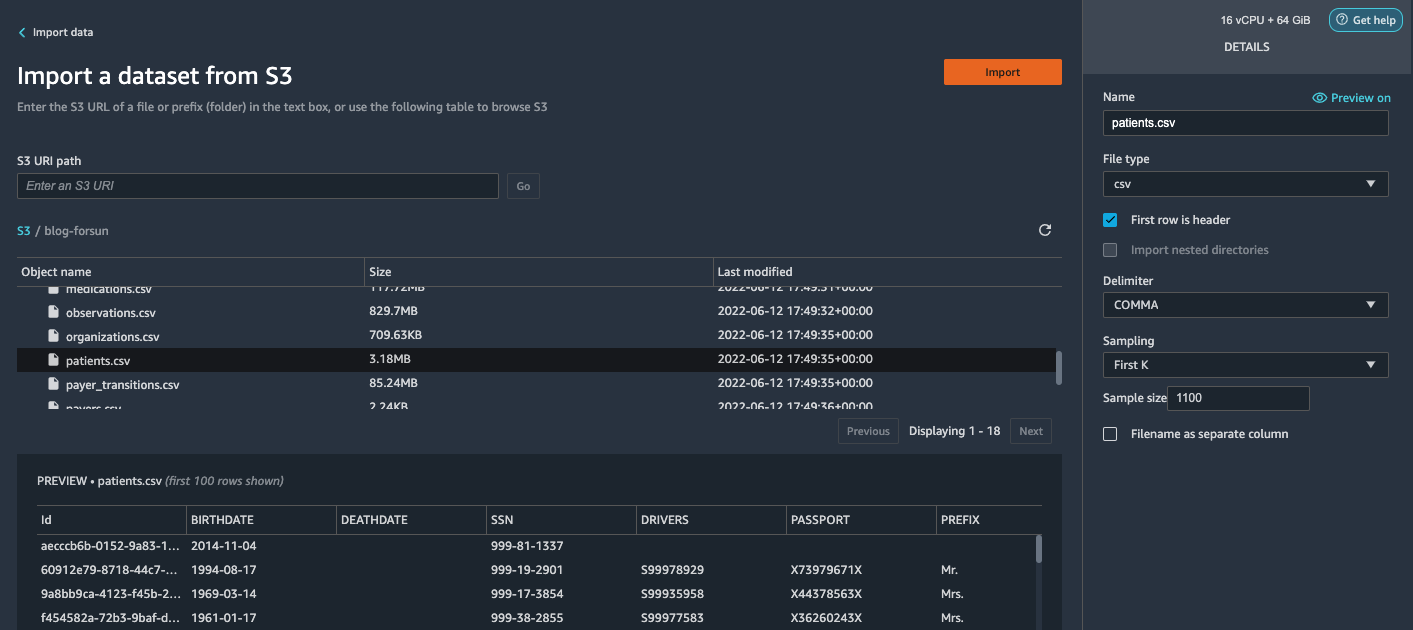

- Elige Amazon S3 y ubique el archivopatients.csv en el depósito S3.

- En Detalles panel, elija primera k para Muestreo.

- Participar

1100para Tamaño de la muestra.

En el panel de vista previa, Data Wrangler extrae las primeras 100 filas del conjunto de datos y las muestra como una vista previa. - Elige Importa.

Data Wrangler selecciona los primeros 1,100 pacientes del total de pacientes (11,000 XNUMX filas) generados por Synthea e importa los datos. El enfoque de muestreo permite que Data Wrangler solo procese los datos de muestra. Nos permite desarrollar nuestro flujo de datos con un conjunto de datos más pequeño, lo que da como resultado un procesamiento más rápido y un ciclo de retroalimentación más corto. Después de crear el flujo de datos, podemos enviar la receta desarrollada a un Procesamiento de SageMaker trabajo para escalar horizontalmente el procesamiento para el conjunto de datos completo o más grande de forma distribuida.

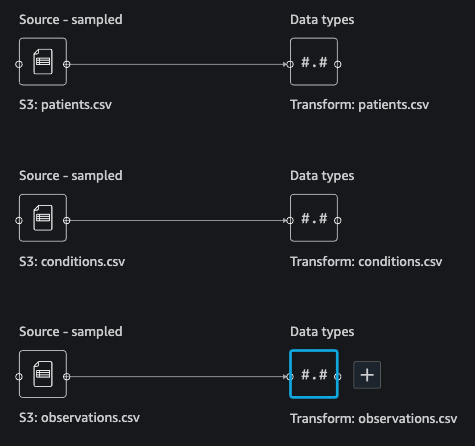

- Repita este proceso para el

conditionsyobservationsconjuntos de datos- Para el

conditionsconjunto de datos, ingrese37000para Tamaño de la muestra, que es 1/10 del total de 370,000 XNUMX filas generadas por Synthea. - Para el

observationsconjunto de datos, ingrese500000para Tamaño de la muestra, que es 1/10 del total de observaciones de 5 millones de filas generadas por Synthea.

- Para el

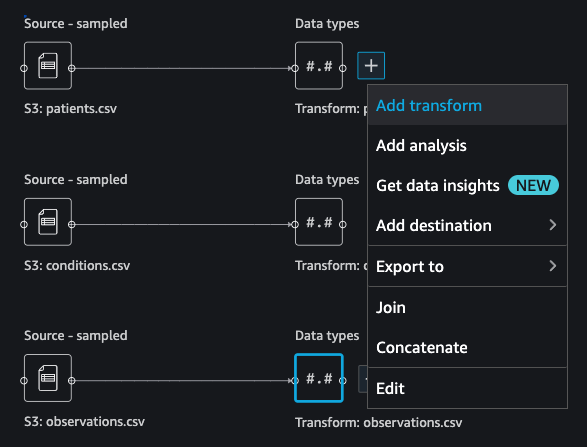

Debería ver tres conjuntos de datos como se muestra en la siguiente captura de pantalla.

Transforma los datos

La transformación de datos es el proceso de cambiar la estructura, el valor o el formato de una o más columnas en el conjunto de datos. El proceso generalmente lo desarrolla un ingeniero de datos y puede ser un desafío para las personas con un conjunto de habilidades de ingeniería de datos más pequeño para descifrar la lógica propuesta para la transformación. La transformación de datos es parte del proceso de ingeniería de características más amplio, y la secuencia correcta de pasos es otro criterio importante a tener en cuenta al diseñar tales recetas.

Data Wrangler está diseñado para ser una herramienta de código bajo para reducir la barrera de entrada para una preparación de datos efectiva. Viene con más de 300 transformaciones de datos preconfiguradas para que elija sin escribir una sola línea de código. En las siguientes secciones, vemos cómo transformar los conjuntos de datos importados en Data Wrangler.

Soltar columnas enpatients.csv

Primero soltamos algunas columnas del patients conjunto de datos Eliminar las columnas redundantes elimina la información no relevante del conjunto de datos y nos ayuda a reducir la cantidad de recursos informáticos necesarios para procesar el conjunto de datos y entrenar un modelo. En esta sección, eliminamos columnas como SSN o número de pasaporte según el sentido común de que estas columnas no tienen valor predictivo. En otras palabras, no ayudan a nuestro modelo a predecir la insuficiencia cardíaca. Nuestro estudio tampoco se preocupa por otras columnas, como el lugar de nacimiento o la influencia de los gastos de atención médica en la insuficiencia cardíaca de un paciente, por lo que también las eliminamos. Las columnas redundantes también se pueden identificar mediante la ejecución de los análisis integrados, como la fuga de objetivos, la correlación de características, la multicolinealidad y más, que están integrados en Data Wrangler. Para obtener más detalles sobre los tipos de análisis admitidos, consulte Analizar y Visualizar. Además, puede utilizar el Informe de información y calidad de datos para realizar análisis automatizados en los conjuntos de datos para llegar a una lista de columnas redundantes para eliminar.

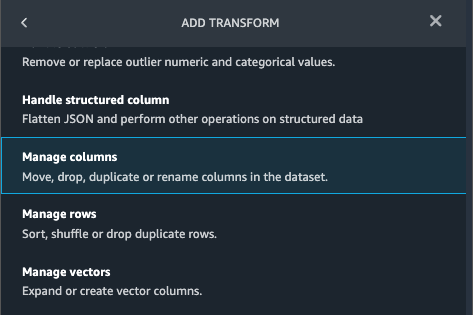

- Elija el signo más junto a Tipos de datos para el conjunto de datos depatients.csv y elija Agregar transformación.

- Elige Agregar paso y elige Administrar columnas.

- Transformarescoger Columna de caída.

- Columnas para soltar, elija las siguientes columnas:

SSNDRIVERSPASSPORTPREFIXFIRSTLASTSUFFIXMAIDENRACEETHNICITYBIRTHPLACEADDRESSCITYSTATECOUNTYZIPLATLONHEALTHCARE_EXPENSESHEALTHCARE_COVERAGE

- Elige Vista previa para revisar el conjunto de datos transformado, luego elija Añada.

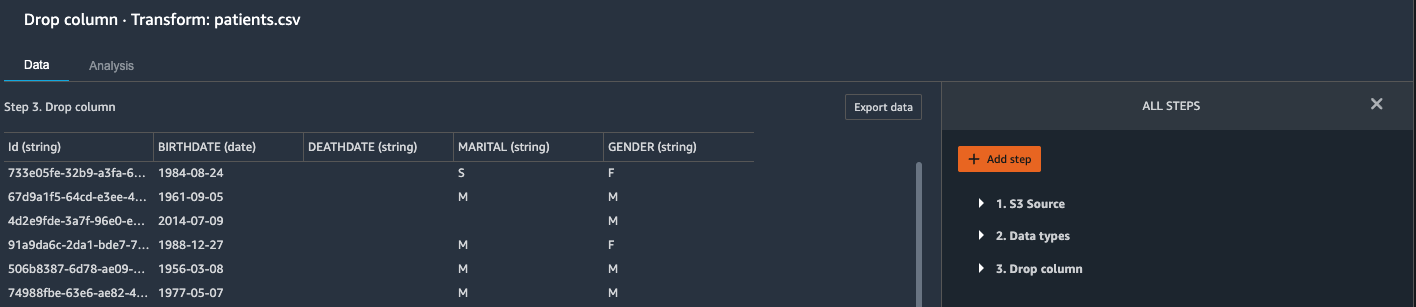

Deberías ver el paso Columna de caída en su lista de transformaciones.

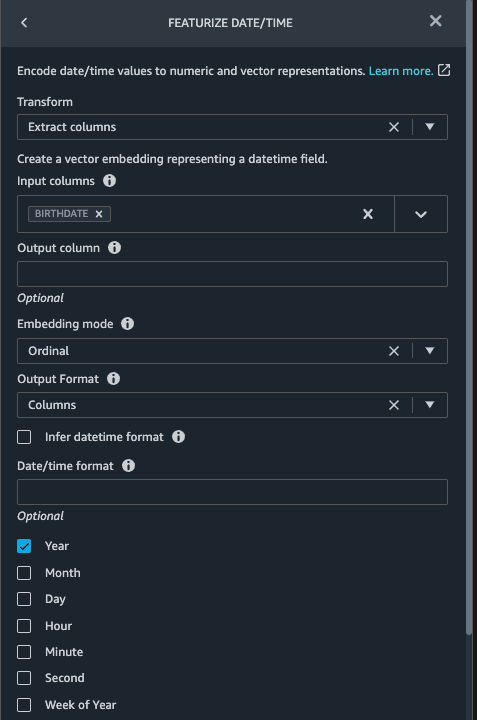

Destacar fecha/hora enpatients.csv

Ahora usamos la función Featurize date/time para generar la nueva característica Year del desplegable BIRTHDATE columna en el patients conjunto de datos Usamos la nueva función en un paso posterior para calcular la edad de un paciente en el momento en que se lleva a cabo la observación.

- En Transforma panel de su Columna de caída página para el

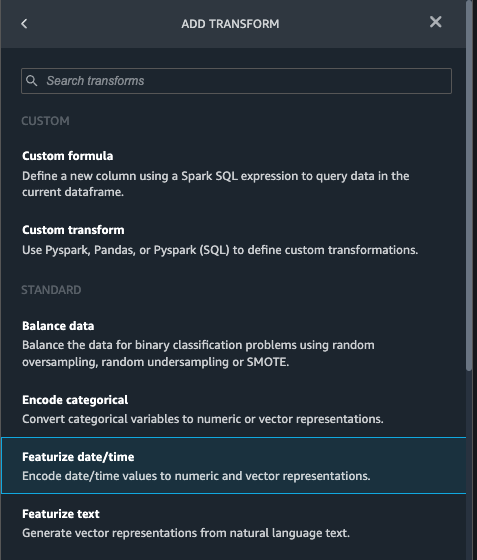

patientsconjunto de datos, elija Agregar paso. - Elija el Destacar fecha/hora transformar.

- Elige Extraer columnas.

- Columnas de entrada, agrega la columna

BIRTHDATE. - Seleccione Año y deseleccionar Mes, Día, Hora, Minutos, En segundo lugar.

- Elige Vista previa, A continuación, elija Añada.

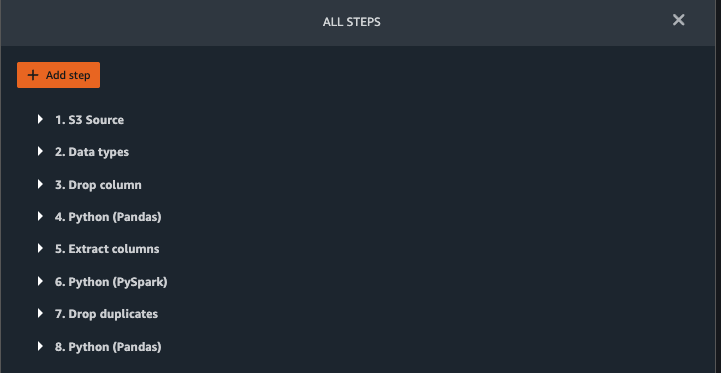

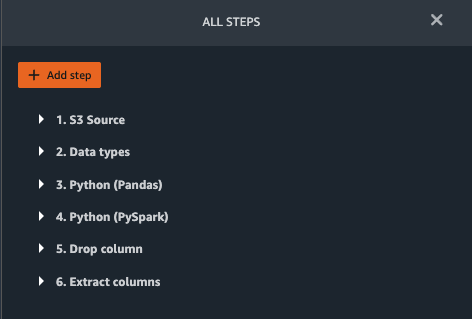

Agregar transformaciones en las observaciones.csv

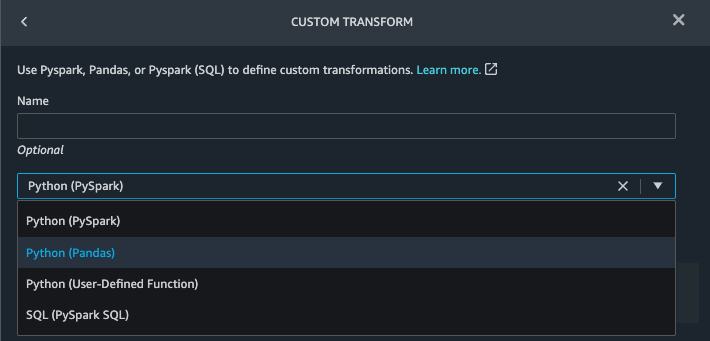

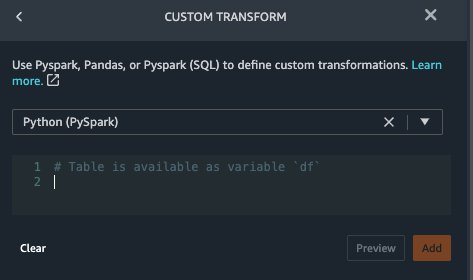

Data Wrangler admite transformaciones personalizadas mediante Python (funciones definidas por el usuario), PySpark, Pandas o PySpark (SQL). Puede elegir su tipo de transformación en función de su familiaridad con cada opción y preferencia. Para las últimas tres opciones, Data Wrangler expone la variable df para que pueda acceder al marco de datos y aplicar transformaciones en él. Para obtener una explicación detallada y ejemplos, consulte Transformaciones personalizadas. En esta sección, agregamos tres transformaciones personalizadas al observations conjunto de datos

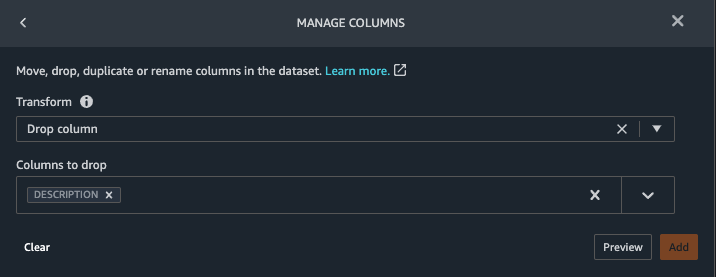

- Agregue una transformación a las observaciones.csv y suelte el

DESCRIPTIONcolumna.

- Elige Vista previa, A continuación, elija Añada.

- En Transforma panel, elija Agregar paso y elige Transformación personalizada.

- En el menú desplegable, elija Python (pandas).

- Ingrese el siguiente código:

Estos son códigos LONIC que corresponden a las siguientes observaciones que nos interesa utilizar como características para predecir la insuficiencia cardíaca:

- Elige Vista previa, A continuación, elija Añada.

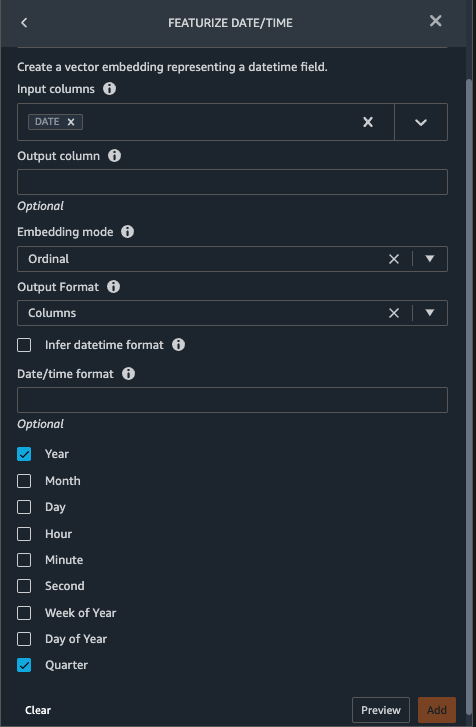

- Agregar una transformación para extraer

YearyQuarterdel desplegableDATEcolumna.

- Elige Vista previa, A continuación, elija Añada.

- Elige Agregar paso y elige Transformación personalizada.

- En el menú desplegable, elija Pitón (PySpark).

Es posible que los cinco tipos de observaciones no siempre se registren en la misma fecha. Por ejemplo, un paciente puede visitar a su médico de familia el 21 de enero y medir y registrar su presión arterial sistólica, presión arterial diastólica, frecuencia cardíaca e índice de masa corporal. Sin embargo, es posible que se realice una prueba de laboratorio que incluya plaquetas en una fecha posterior, el 2 de febrero. Por lo tanto, no siempre es posible unir marcos de datos antes de la fecha de observación. Aquí unimos marcos de datos en una granularidad gruesa por trimestre. - Ingrese el siguiente código:

- Elige Vista previa, A continuación, elija Añada.

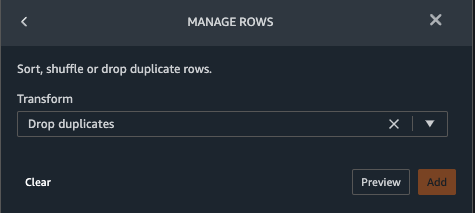

- Elige Agregar paso, A continuación, elija Administrar filas.

- Transformar, escoger Soltar duplicados.

- Elige Vista previa, A continuación, elija Añada.

- Elige Agregar paso y elige Transformación personalizada.

- En el menú desplegable, elija Python (pandas).

- Ingrese el siguiente código para tomar un promedio de los puntos de datos que comparten el mismo valor de tiempo:

- Elige Vista previa, A continuación, elija Añada.

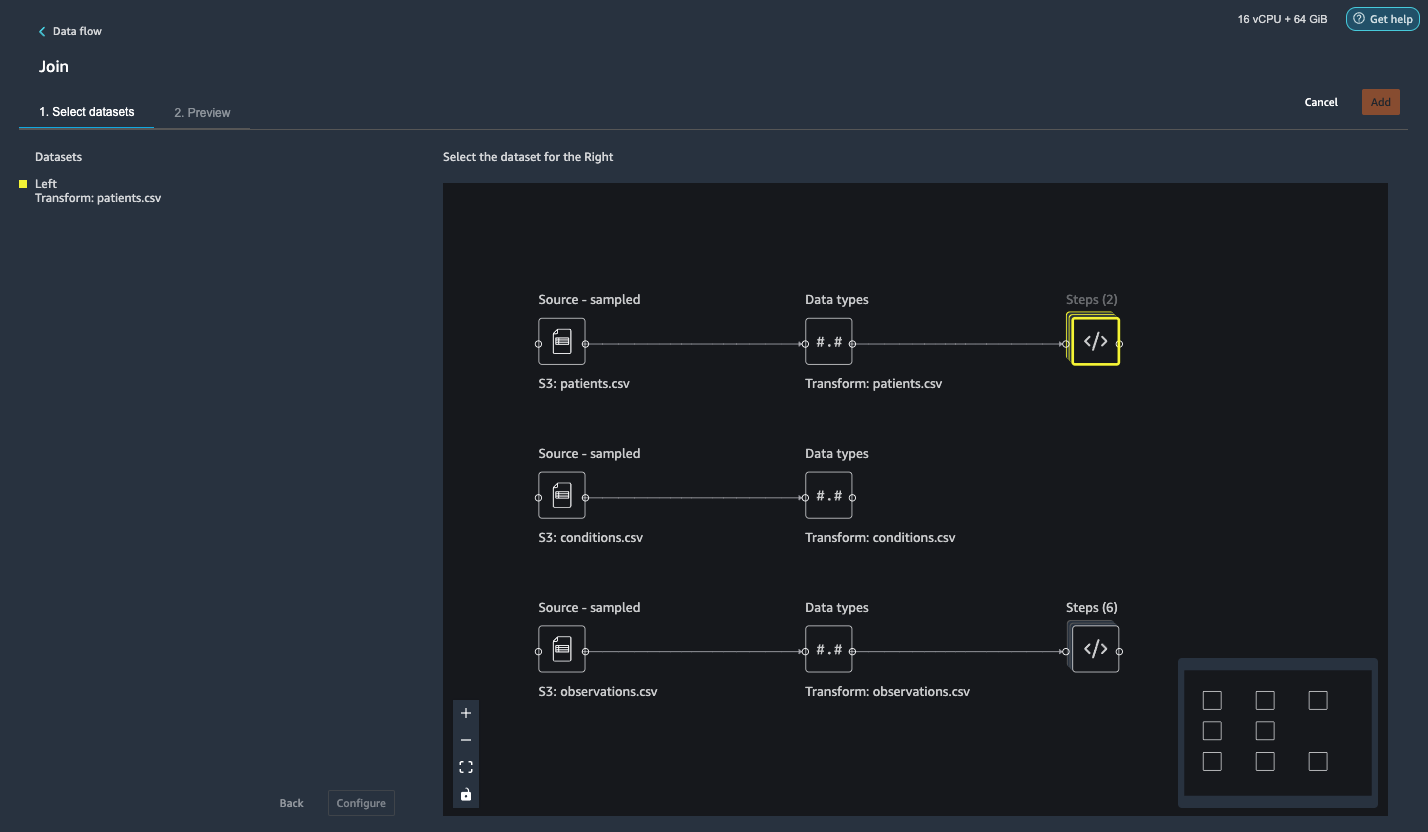

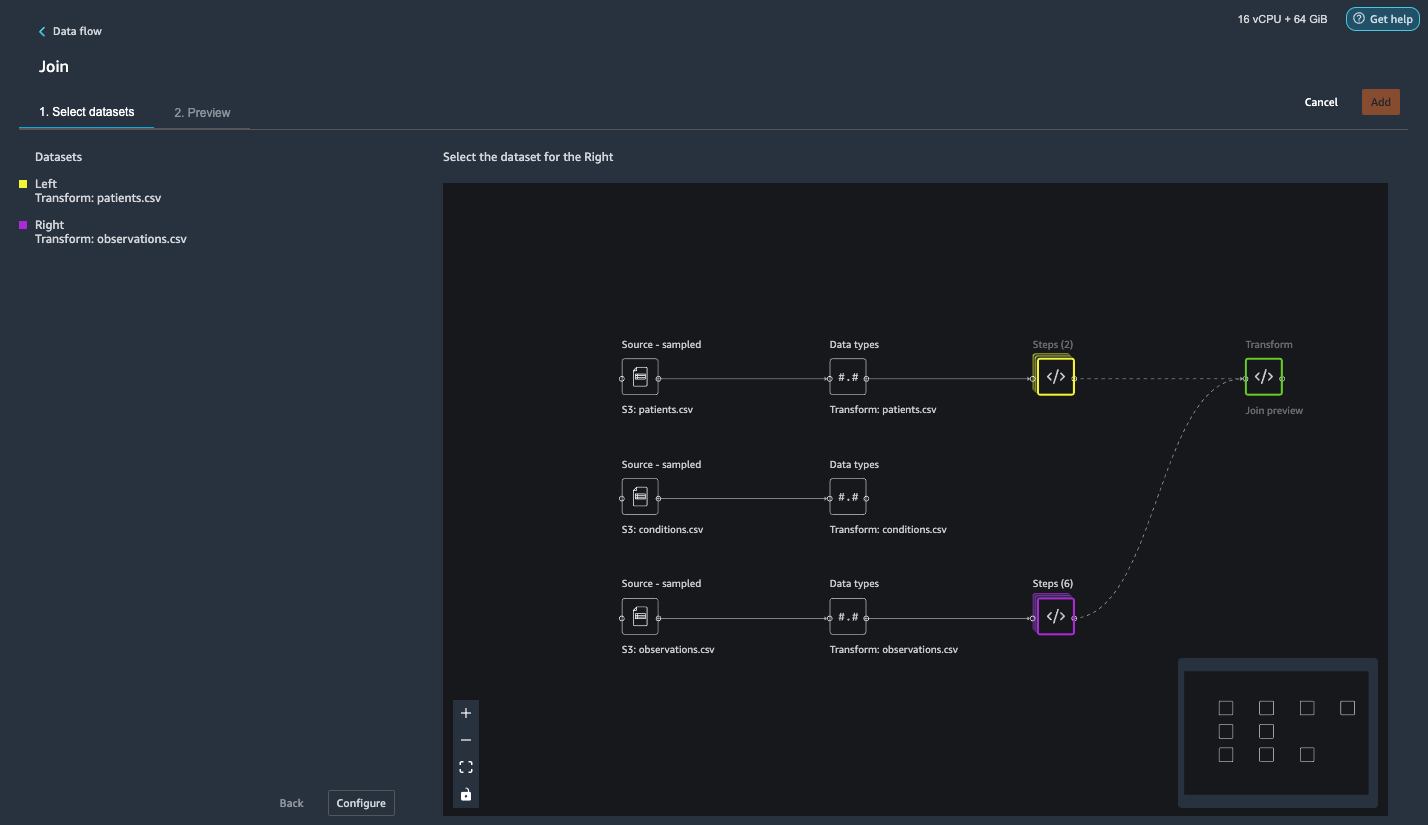

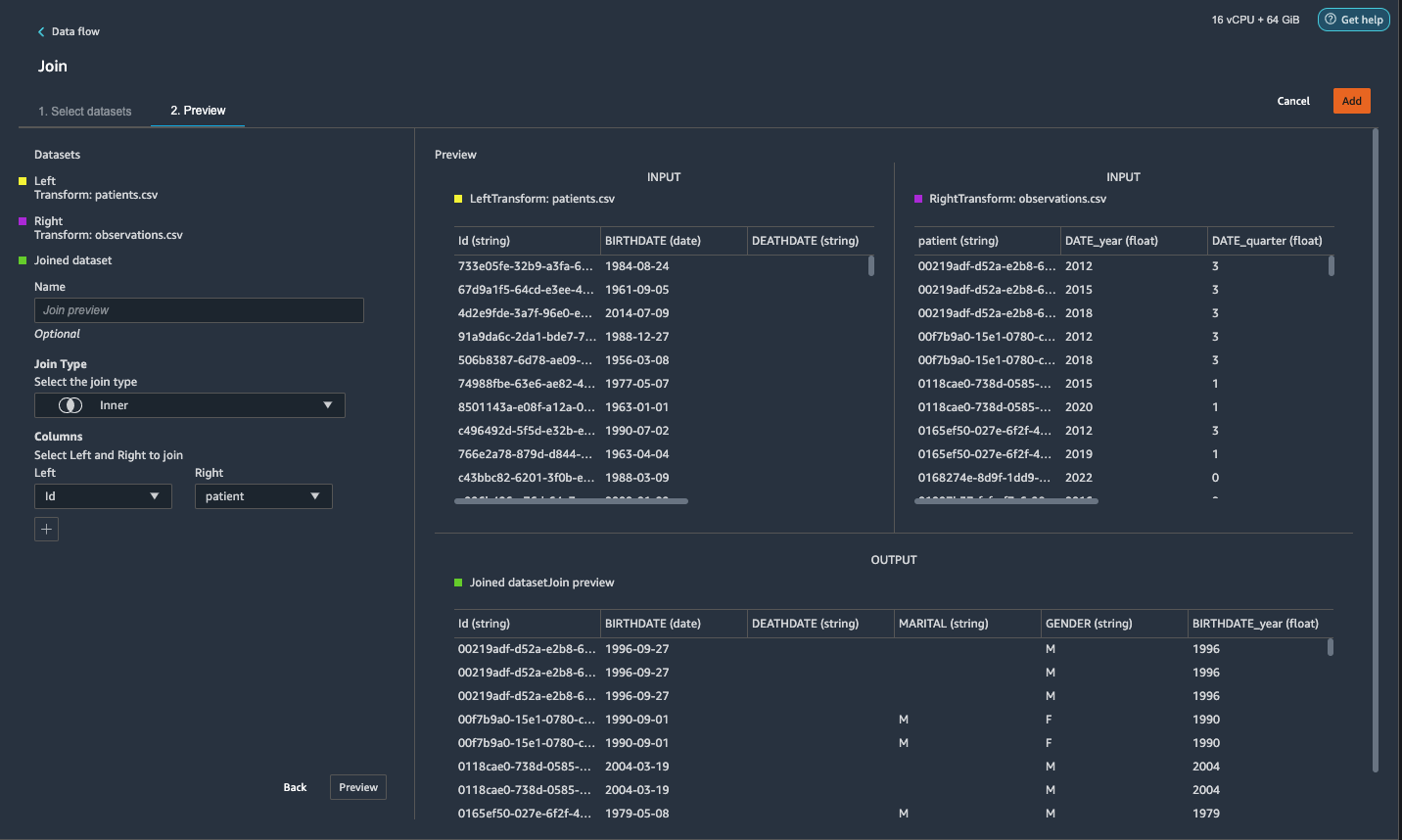

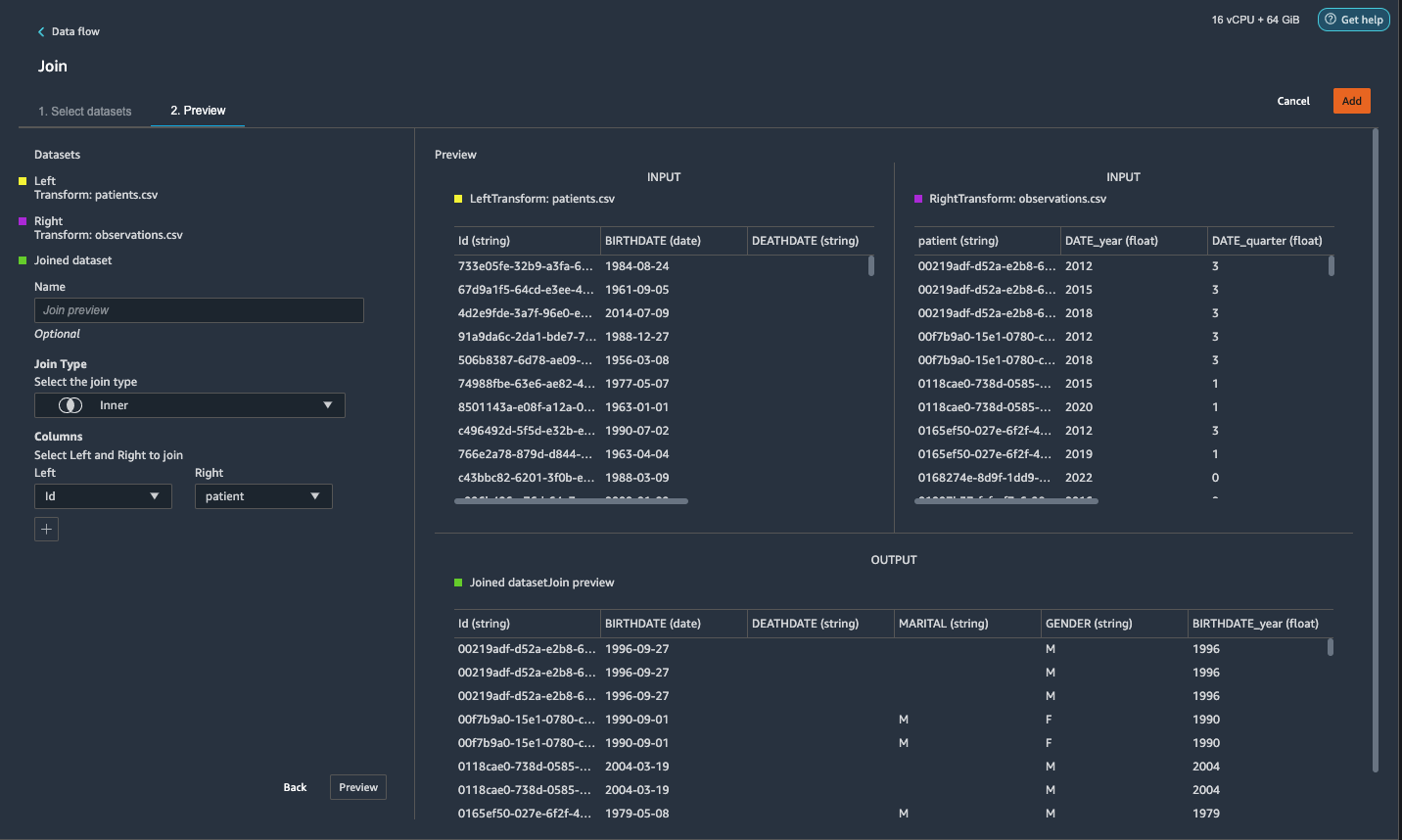

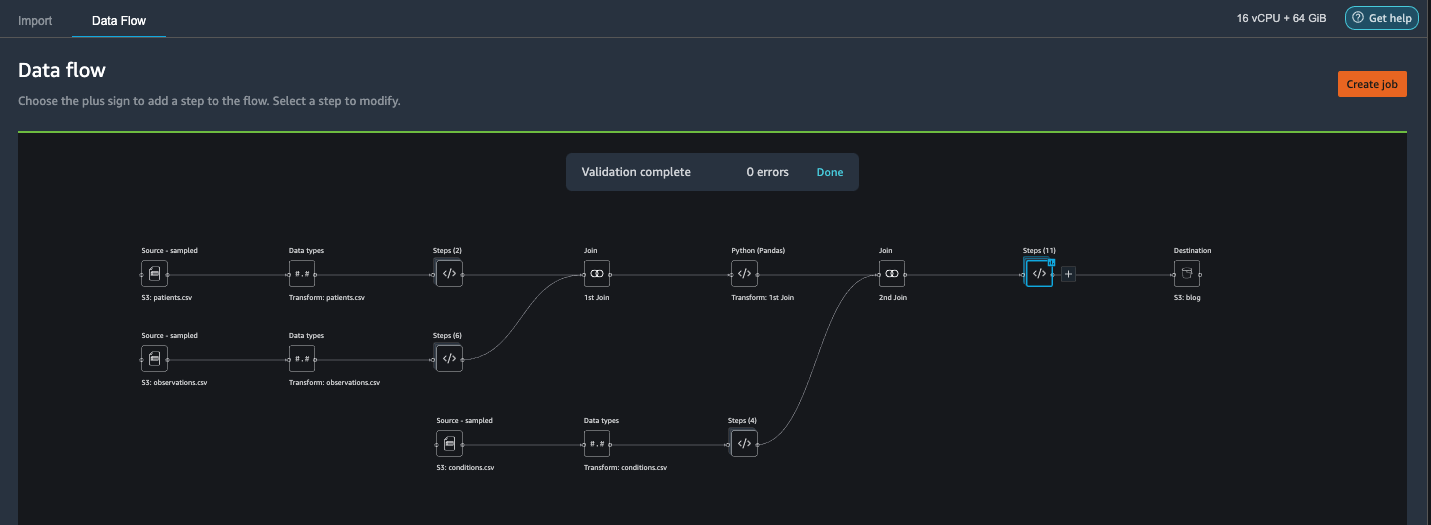

Únase apatients.csv y observaciones.csv

En este paso, mostramos cómo realizar uniones complejas en conjuntos de datos de manera fácil y efectiva sin escribir ningún código a través de la poderosa interfaz de usuario de Data Wrangler. Para obtener más información sobre los tipos de combinaciones admitidos, consulte Transformar datos.

- A la derecha de Transformar: pacientes.csv, elija el signo más junto a pasos y elige Únete.

Puede ver el archivopatients.csv transformado que aparece en Conjuntos de datos en el panel izquierdo.

- A la derecha de Transformar: observaciones.csv, Haga clic en el pasos para iniciar la operación de unión.

El archivo "observaciones.csv" transformado ahora aparece en Conjuntos de datos en el panel izquierdo.

- Elige Configurar.

- Tipo de unión, escoger Interior.

- Unidades, escoger Id.

- Derecha, escoger paciente.

- Elige Vista previa, A continuación, elija Añada.

Agregar una transformación personalizada a los conjuntos de datos unidos

En este paso, calculamos la edad del paciente en el momento de la observación. También soltamos columnas que ya no son necesarias.

- Elija el signo más junto a 1.er ingreso y elige Agregar transformación.

- Agregue una transformación personalizada en Pandas:

- Elige Vista previa, A continuación, elija Añada.

Agregar transformaciones personalizadas a conditions.csv

- Elija el signo más junto a Transformar: condiciones.csv y elige Agregar transformación.

- Agregue una transformación personalizada en Pandas:

Nota: Como demostramos anteriormente, puede soltar columnas usando código personalizado o usando las transformaciones integradas proporcionadas por Data Wrangler. Las transformaciones personalizadas dentro de Data Wrangler brindan la flexibilidad de traer su propia lógica de transformación en forma de fragmentos de código en los marcos compatibles. Estos fragmentos se pueden buscar y aplicar más tarde si es necesario.

Los códigos de la transformación anterior son códigos SNOMED-CT que corresponden a las siguientes condiciones. los heart failure or chronic congestive heart failure condición se convierte en la etiqueta. Usamos las condiciones restantes como características para predecir la insuficiencia cardíaca. También soltamos algunas columnas que ya no son necesarias.

- A continuación, agreguemos una transformación personalizada en PySpark:

Realizamos una combinación externa izquierda para mantener todas las entradas en el marco de datos de insuficiencia cardíaca. Una nueva columna

has_xxxse calcula para cada afección que no sea insuficiencia cardíaca en función de la fecha de inicio de la afección. Solo nos interesan las condiciones médicas que se registraron antes de la insuficiencia cardíaca y las usamos como características para predecir la insuficiencia cardíaca. - Agregar un incorporado Administrar columnas transform para eliminar las columnas redundantes que ya no son necesarias:

hypertensiondiabetescoronarysmokeatrial

- Extraer

YearyQuarterdel desplegableheartfailurecolumna.

Esto coincide con la granularidad que usamos anteriormente en la transformación delobservationsconjunto de datos - Deberíamos tener un total de 6 pasos para conditions.csv.

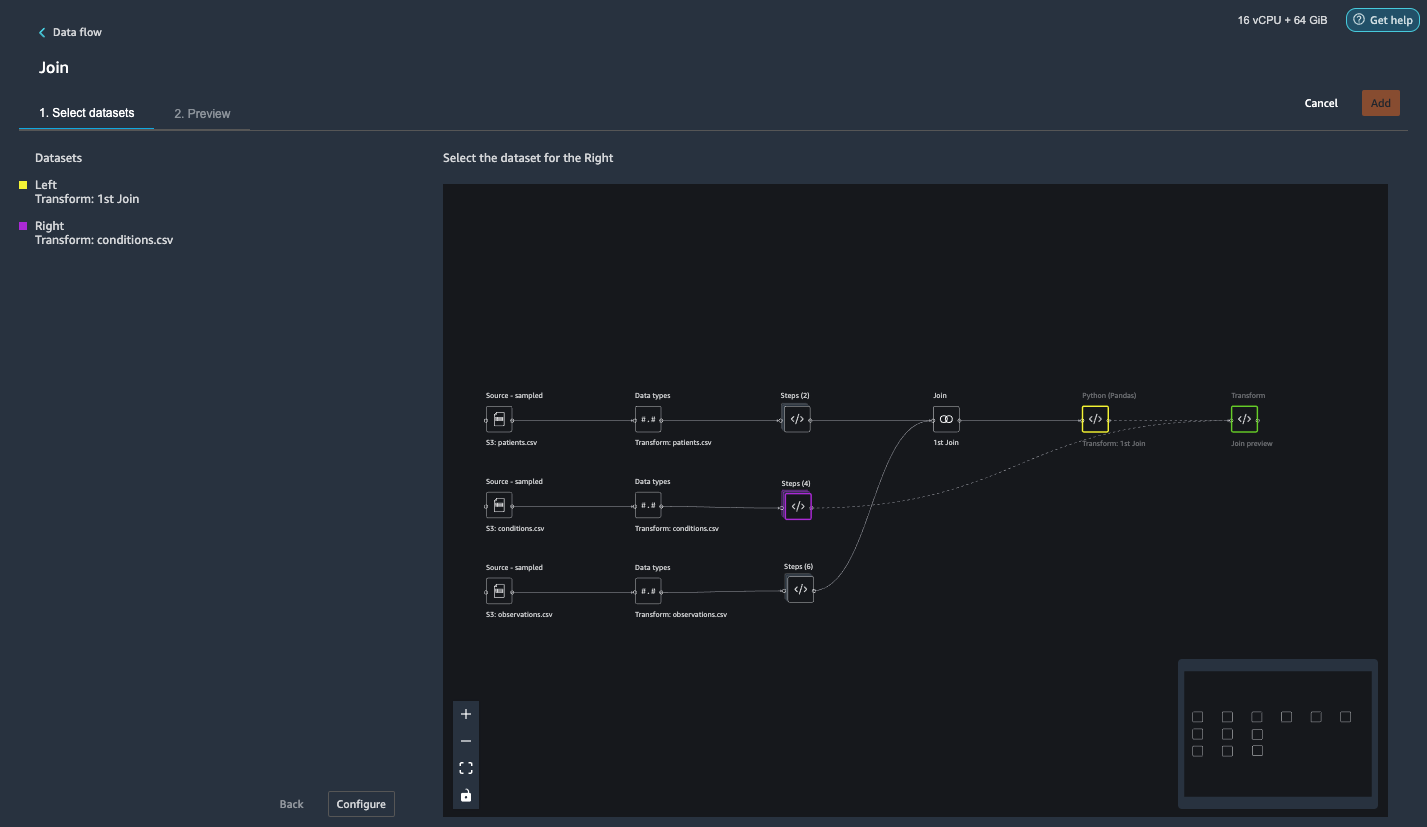

Unir condiciones.csv al conjunto de datos unido

Ahora realizamos una nueva unión para unir el conjunto de datos de condiciones al unido patients y observations conjunto de datos

- Elige Transformar: 1.er ingreso.

- Elija el signo más y elija Únete.

- Elige pasos al lado de Transformar: condiciones.csv.

- Elige Configurar.

- Tipo de unión, escoger Exterior izquierdo.

- Unidades, escoger Id.

- Derecha, escoger paciente.

- Elige Vista previa, A continuación, elija Añada.

Agregar transformaciones a los conjuntos de datos unidos

Ahora que tenemos los tres conjuntos de datos unidos, apliquemos algunas transformaciones adicionales.

- Agregue la siguiente transformación personalizada en PySpark para que

has_heartfailurese convierte en nuestra columna de etiqueta: - Agregue la siguiente transformación personalizada en PySpark:

- Suelte las columnas redundantes que ya no son necesarias:

IdDATE_yearDATE_quarterpatientheartfailureheartfailure_yearheartfailure_quarter

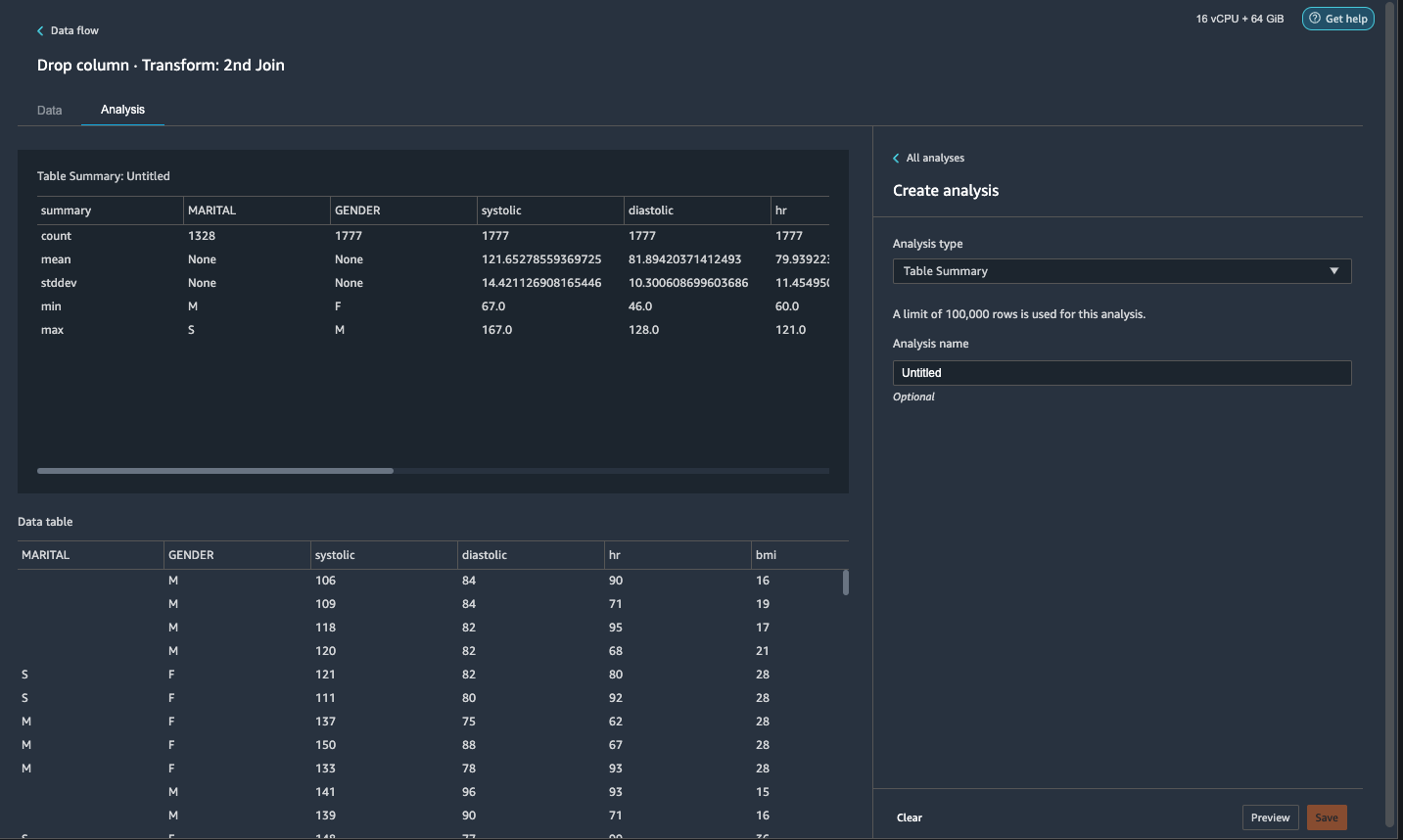

- En ECONOMÉTRICOS pestaña, para Tipo de análisisescoger Resumen de la tabla.

Una exploración rápida a través del resumen muestra que elMARITALla columna tiene datos faltantes.

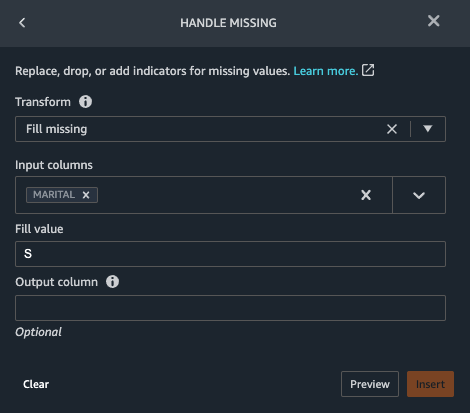

- Elija el Datos pestaña y agregue un paso.

- Elige Falta el mango.

- Transformar, escoger Relleno faltante.

- Columnas de entrada, escoger MARITAL.

- Valor de relleno, introduzca

S.

Nuestra estrategia aquí es asumir que el paciente es soltero si el estado civil tiene valor perdido. Puedes tener una estrategia diferente.

- Elige Vista previa, A continuación, elija Añada.

- Rellene el valor que falta como 0 para

has_hypertension,has_diabetes,has_coronary,has_smoke,has_atrial.

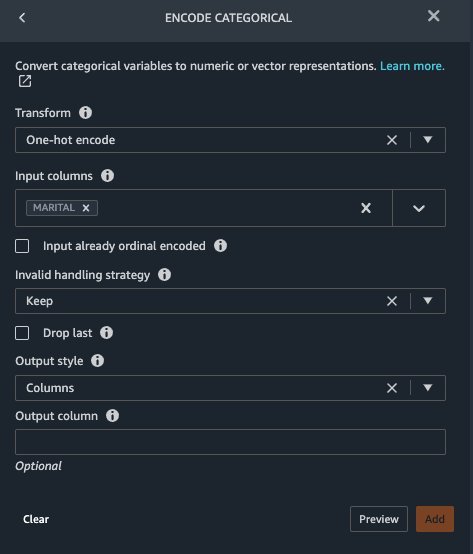

Marital y Gender son variables categóricas. Data Wrangler tiene una función integrada para codificar variables categóricas.

- Añade un paso y elige Codificar categórico.

- Transformar, escoger Codificación one-hot.

- Columnas de entrada, escoger MARITAL.

- Estilo de salida, escoger Columna.

Este estilo de salida produce valores codificados en columnas separadas.

- Elige Vista previa, A continuación, elija Añada.

- Repita estos pasos para Género columna.

La codificación one-hot divide la columna Marital en Marital_M (casado) y Marital_S (único) y divide la columna Sexo en Gender_M (hombre) y Gender_F (femenino). Porque Marital_M y Marital_S son mutuamente excluyentes (al igual que Gender_M y Gender_F), podemos eliminar una columna para evitar funciones redundantes.

- Soltar

Marital_SyGender_F.

Las funciones numéricas, como la presión arterial sistólica, la frecuencia cardíaca y la edad, tienen diferentes estándares de unidades. Para un modelo basado en regresión lineal, primero debemos normalizar estas características numéricas. De lo contrario, algunas funciones con valores absolutos más altos pueden tener una ventaja injustificada sobre otras funciones con valores absolutos más bajos y dar como resultado un rendimiento deficiente del modelo. Data Wrangler tiene el escalador min-max de transformación incorporado para normalizar los datos. Para un modelo de clasificación basado en árboles de decisión, no se requiere normalización. Nuestro estudio es un problema de clasificación por lo que no necesitamos aplicar la normalización. Las clases desequilibradas son un problema común en la clasificación. El desequilibrio ocurre cuando el conjunto de datos de entrenamiento contiene una distribución de clases severamente sesgada. Por ejemplo, cuando nuestro conjunto de datos contiene desproporcionadamente más pacientes sin insuficiencia cardíaca que pacientes con insuficiencia cardíaca, puede causar que el modelo esté sesgado hacia la predicción de ausencia de insuficiencia cardíaca y un rendimiento deficiente. Data Wrangler tiene una función integrada para abordar el problema.

- Agregue una transformación personalizada en Pandas para convertir el tipo de datos de las columnas del tipo "objeto" al tipo numérico:

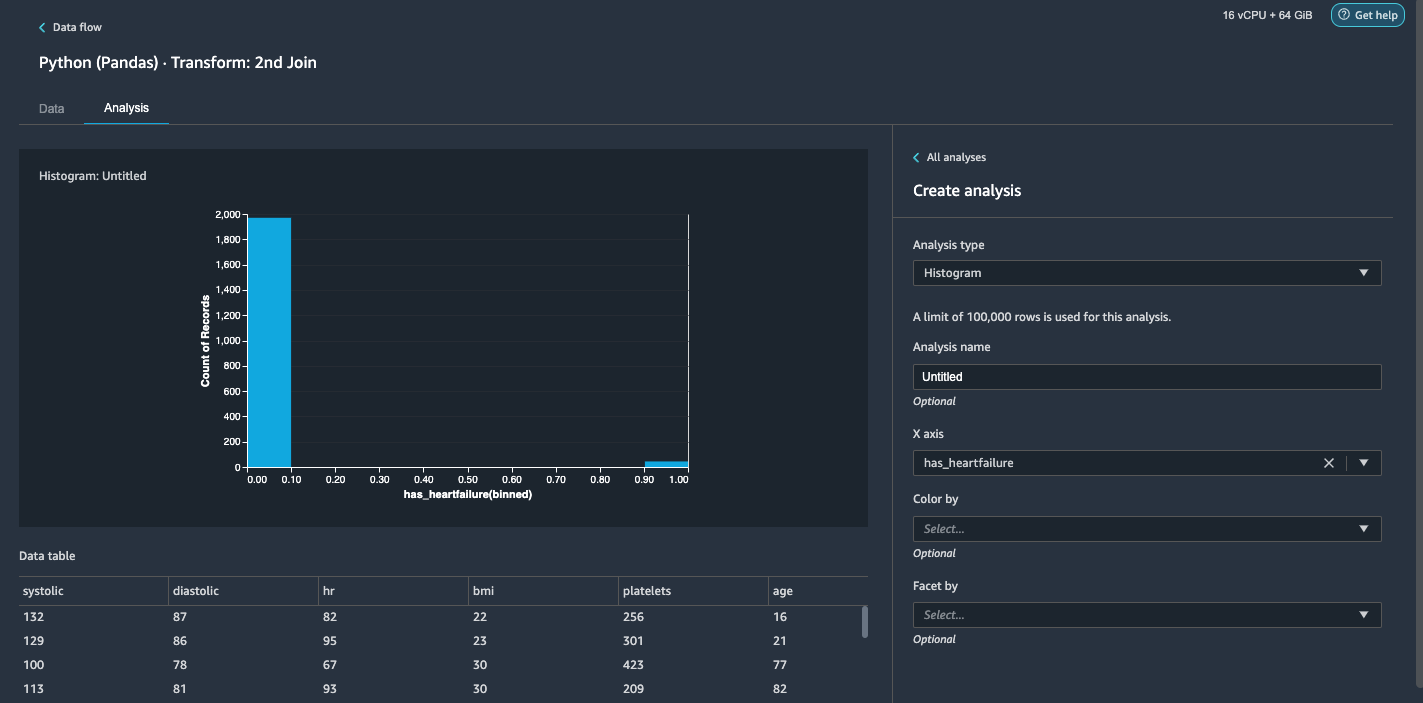

- Elija el ECONOMÉTRICOS .

- Tipo de análisisescoger Histograma.

- eje X, escoger tiene_fallo cardíaco.

- Elige Vista previa.

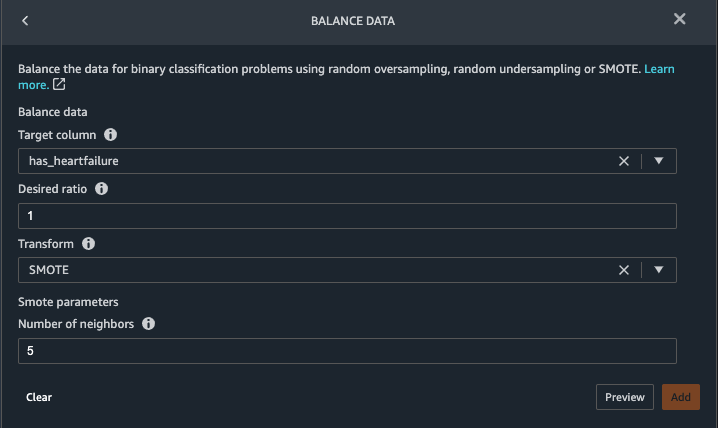

Es obvio que tenemos una clase desequilibrada (más puntos de datos etiquetados como ausencia de insuficiencia cardíaca que puntos de datos etiquetados como insuficiencia cardíaca). - Volver a la Datos lengüeta. Escoger Agregar paso y elige Saldo de datos.

- columna de destino, escoger tiene_fallo cardíaco.

- Relación deseada, introduzca

1. - Transformar, escoger HERIDO.

SMOTE significa Técnica de sobremuestreo de minorías sintéticas. Es una técnica para crear nuevas instancias minoritarias y agregarlas al conjunto de datos para alcanzar el equilibrio de clase. Para obtener información detallada, consulte SMOTE: Técnica de sobremuestreo de minorías sintéticas. - Elige Vista previa, A continuación, elija Añada.

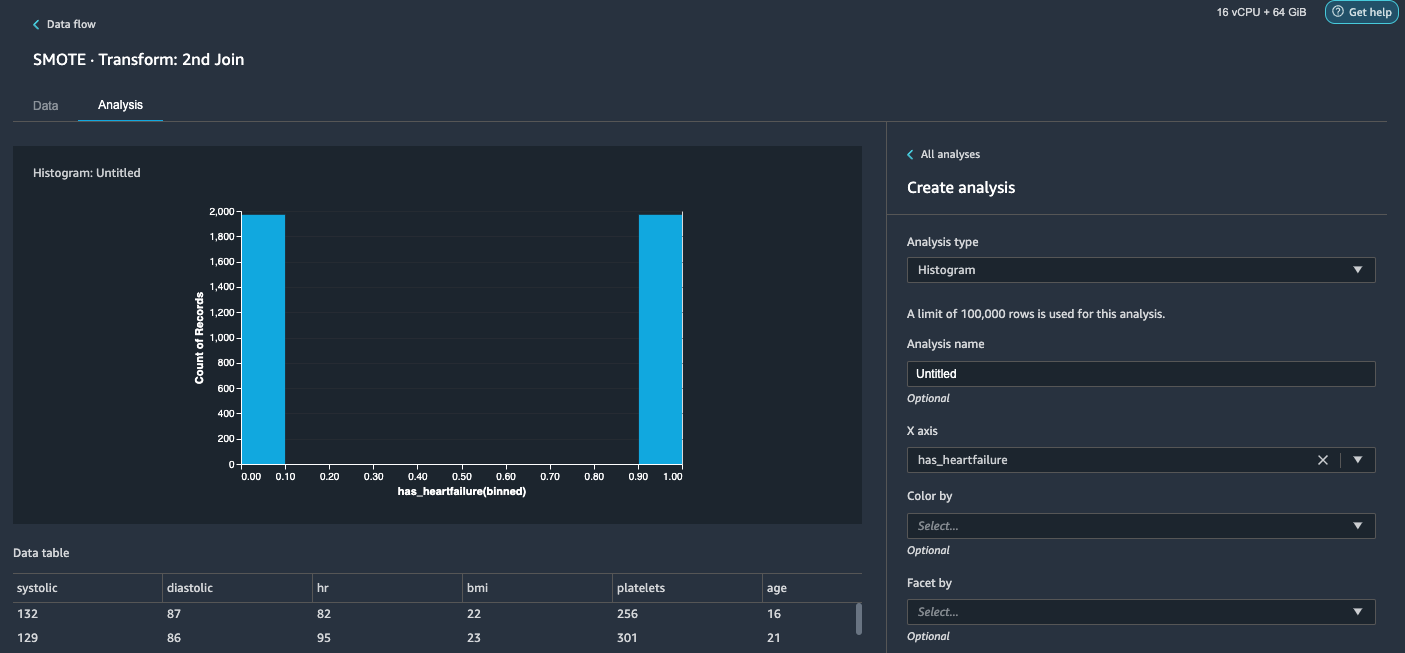

- Repita el análisis del histograma en el paso 20-23. El resultado es una clase equilibrada.

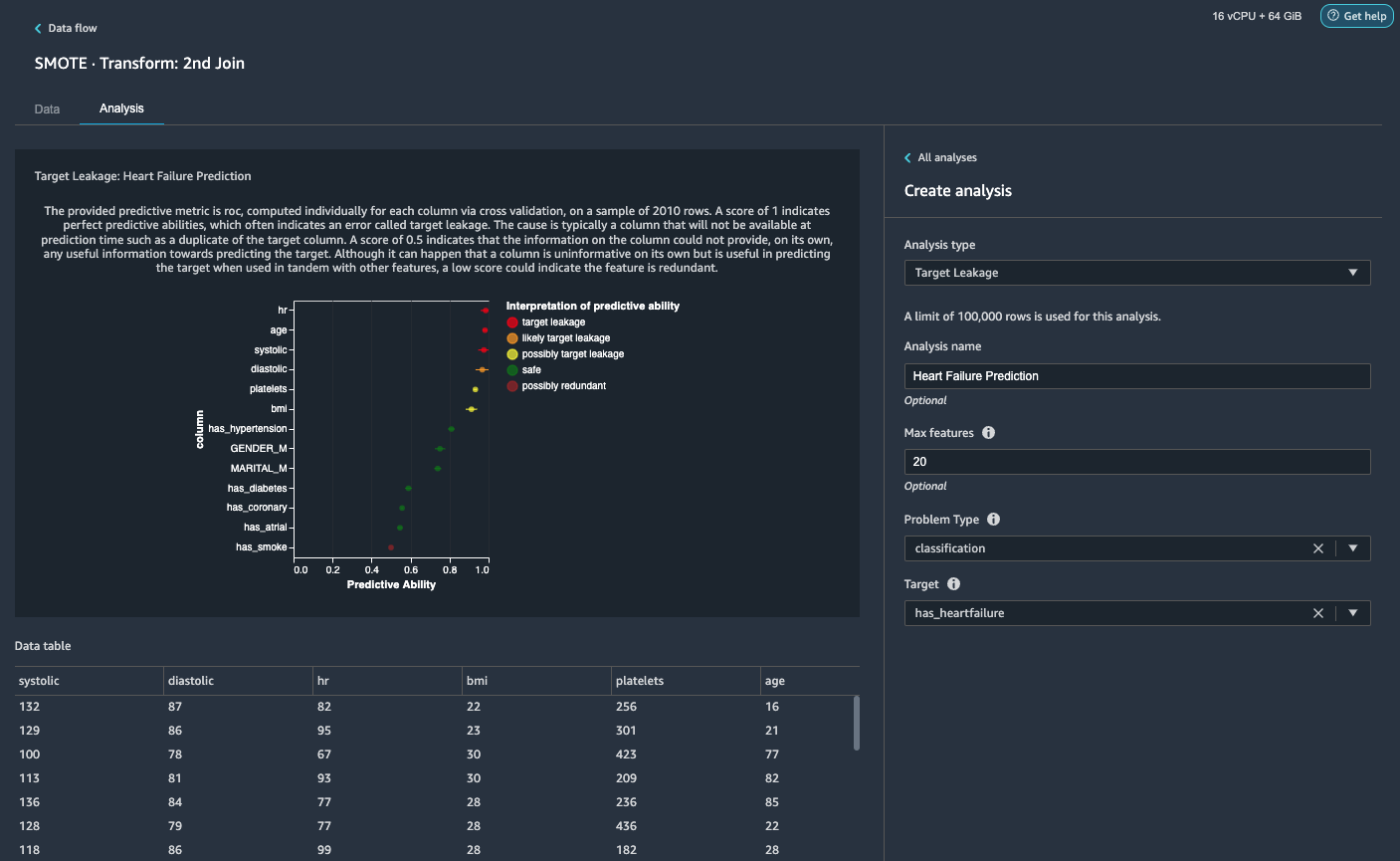

Visualice la fuga de objetivos y la correlación de características

A continuación, vamos a realizar algunos análisis visuales utilizando el rico conjunto de herramientas de Data Wrangler de tipos de análisis avanzados compatibles con ML. Primero, observamos la fuga objetivo. La fuga de destino ocurre cuando los datos en el conjunto de datos de entrenamiento están fuertemente correlacionados con la etiqueta de destino, pero no están disponibles en los datos del mundo real en el momento de la inferencia.

- En Pestaña de análisis, Para Tipo de análisisescoger Fuga objetivo.

- Tipo de problema, escoger clasificación.

- Target, escoger tiene_fallo cardíaco.

- Elige Vista previa.

Con base en el análisis,hres una fuga objetivo. Lo soltaremos en un paso posterior.ageestá marcado como una fuga objetivo. Es razonable decir que la edad de un paciente estará disponible durante el tiempo de inferencia, por lo que mantenemos la edad como una característica.Systolicydiastolictambién se marcan como posibles fugas de destino. Esperamos tener las dos medidas durante el tiempo de inferencia, por lo que las mantenemos como características. - Elige Añada para agregar el análisis.

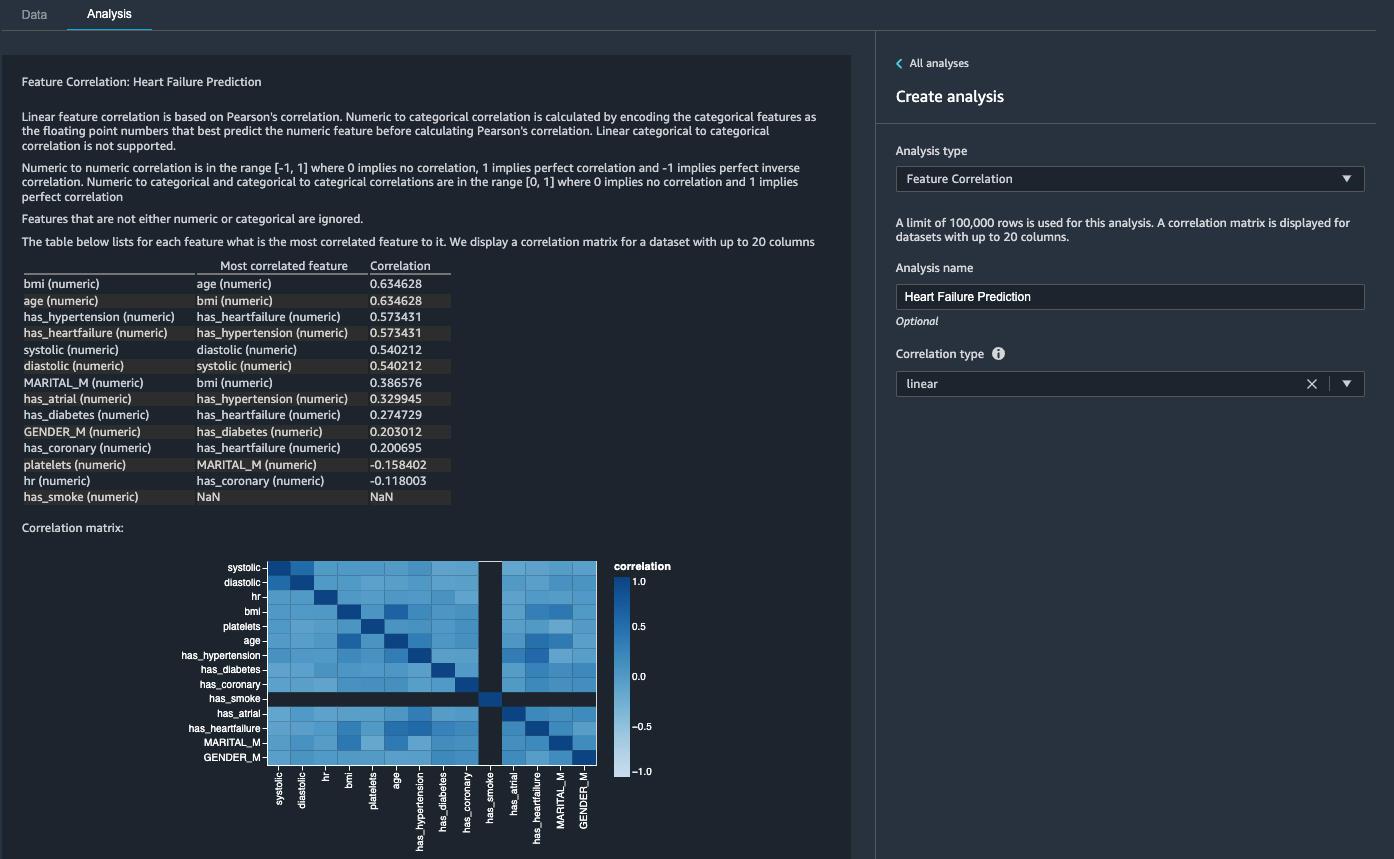

Luego, observamos la correlación de características. Queremos seleccionar características que estén correlacionadas con el objetivo pero que no estén correlacionadas entre sí.

- En Pestaña de análisis, Para Tipo de análisisescoger Correlación de características.

- Tipo de correlaciónescoger lineal.

- Elige Vista previa.

Las puntuaciones de los coeficientes indican fuertes correlaciones entre los siguientes pares:

systolicydiastolicbmiyagehas_hypertensionyhas_heartfailure(etiqueta)

Para características que están fuertemente correlacionadas, las matrices son computacionalmente difíciles de invertir, lo que puede conducir a estimaciones numéricamente inestables. Para mitigar la correlación, simplemente podemos eliminar uno del par. caemos diastolic y bmi y mantener systolic y age en un paso posterior.

Caída de las columnas de diastólica e índice de masa corporal

Agregue pasos de transformación adicionales para eliminar el hr, diastolic y bmi columnas usando la transformación incorporada.

Generar el informe de información y calidad de los datos

AWS recientemente anunció la nueva función Informe de calidad de datos y perspectivas en Data Wrangler. Este informe verifica automáticamente la calidad de los datos y detecta anomalías en sus datos. Los científicos de datos y los ingenieros de datos pueden usar esta herramienta para aplicar de manera eficiente y rápida el conocimiento del dominio para procesar conjuntos de datos para el entrenamiento del modelo ML. Este paso es opcional. Para generar este informe sobre nuestros conjuntos de datos, complete los siguientes pasos:

- En ECONOMÉTRICOS pestaña, para Tipo de análisis, escoger Informe de información y calidad de datos.

- columna de destino, escoger tiene_fallo cardíaco.

- Tipo de problema, seleccione Clasificación.

- Elige Crear.

En unos minutos, genera un informe con un resumen, imágenes y recomendaciones.

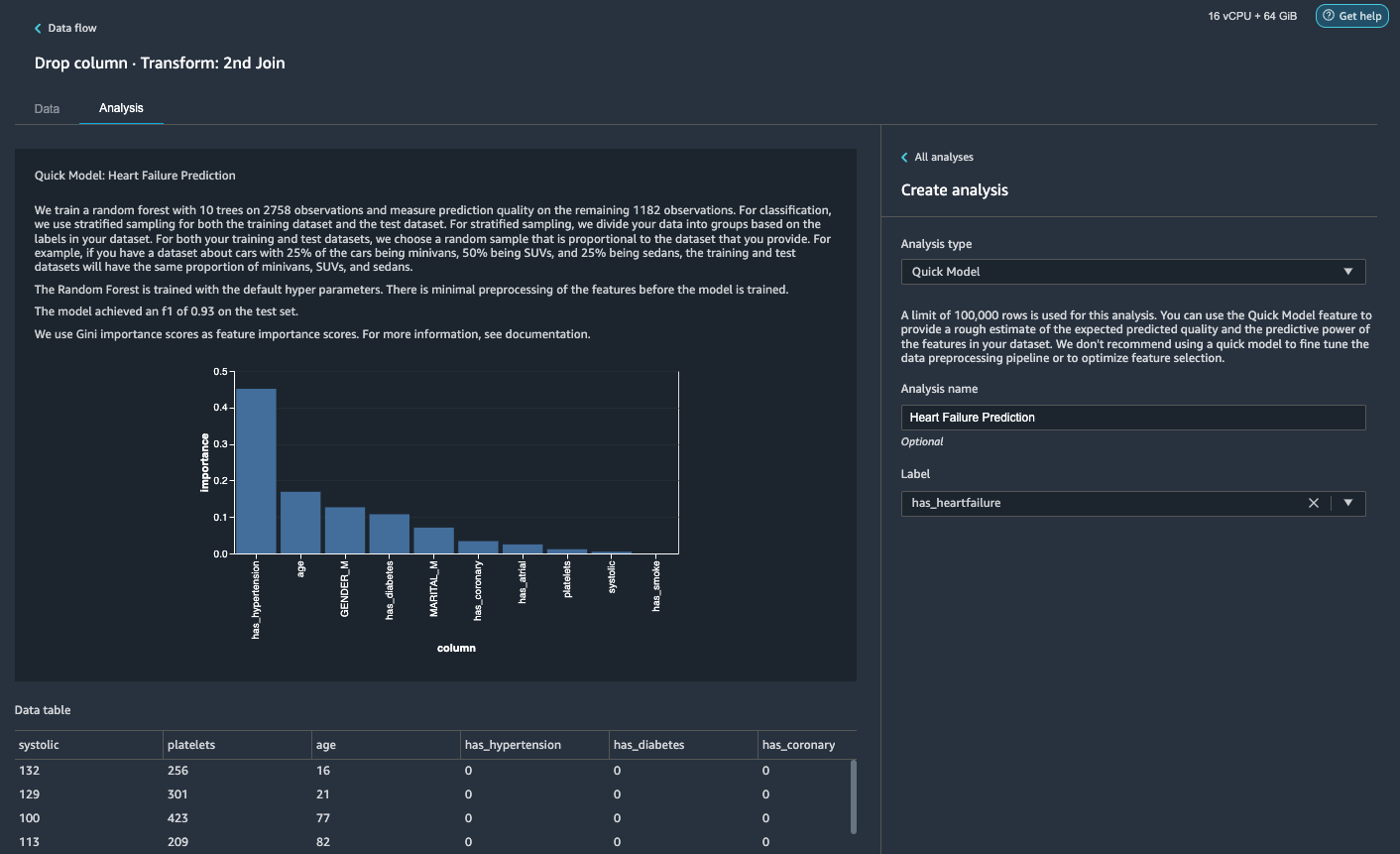

Generar un análisis de modelo rápido

Hemos completado nuestra preparación de datos, limpieza e ingeniería de características. Data Wrangler tiene una función integrada que proporciona una estimación aproximada de la calidad prevista esperada y el poder predictivo de las funciones en nuestro conjunto de datos.

- En ECONOMÉTRICOS pestaña, para Tipo de análisisescoger Modelo rápido.

- Label, escoger tiene_fallo cardíaco.

- Elige Vista previa.

Según nuestro análisis de modelo rápido, podemos ver la característica has_hypertension tiene la puntuación de importancia de característica más alta entre todas las características.

Exportar los datos y entrenar el modelo

Ahora, exportemos las características preparadas para ML transformadas a un depósito de S3 de destino y escalemos toda la canalización de ingeniería de características que hemos creado hasta ahora utilizando las muestras en todo el conjunto de datos de forma distribuida.

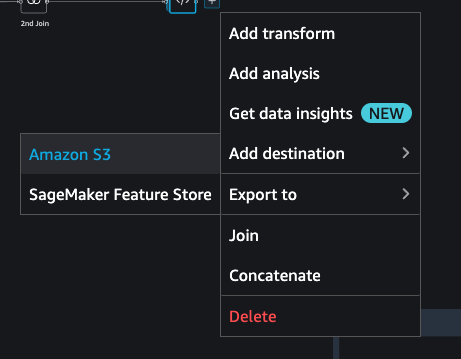

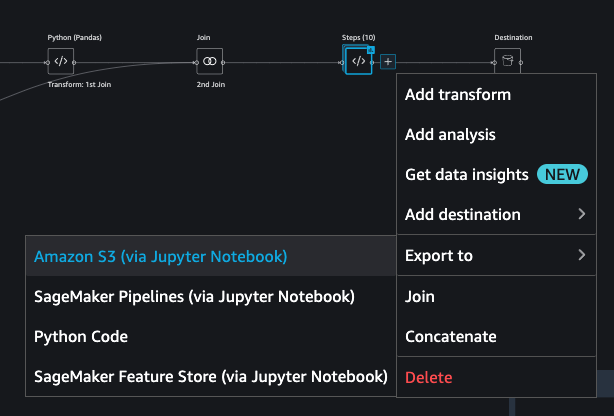

- Elija el signo más junto al último cuadro en el flujo de datos y elija Añadir destino.

- Elige Amazon S3.

- Ingrese un Nombre del conjunto de datos. For Ubicación de Amazon S3, elija un depósito de S3 y, a continuación, elija Añadir destino.

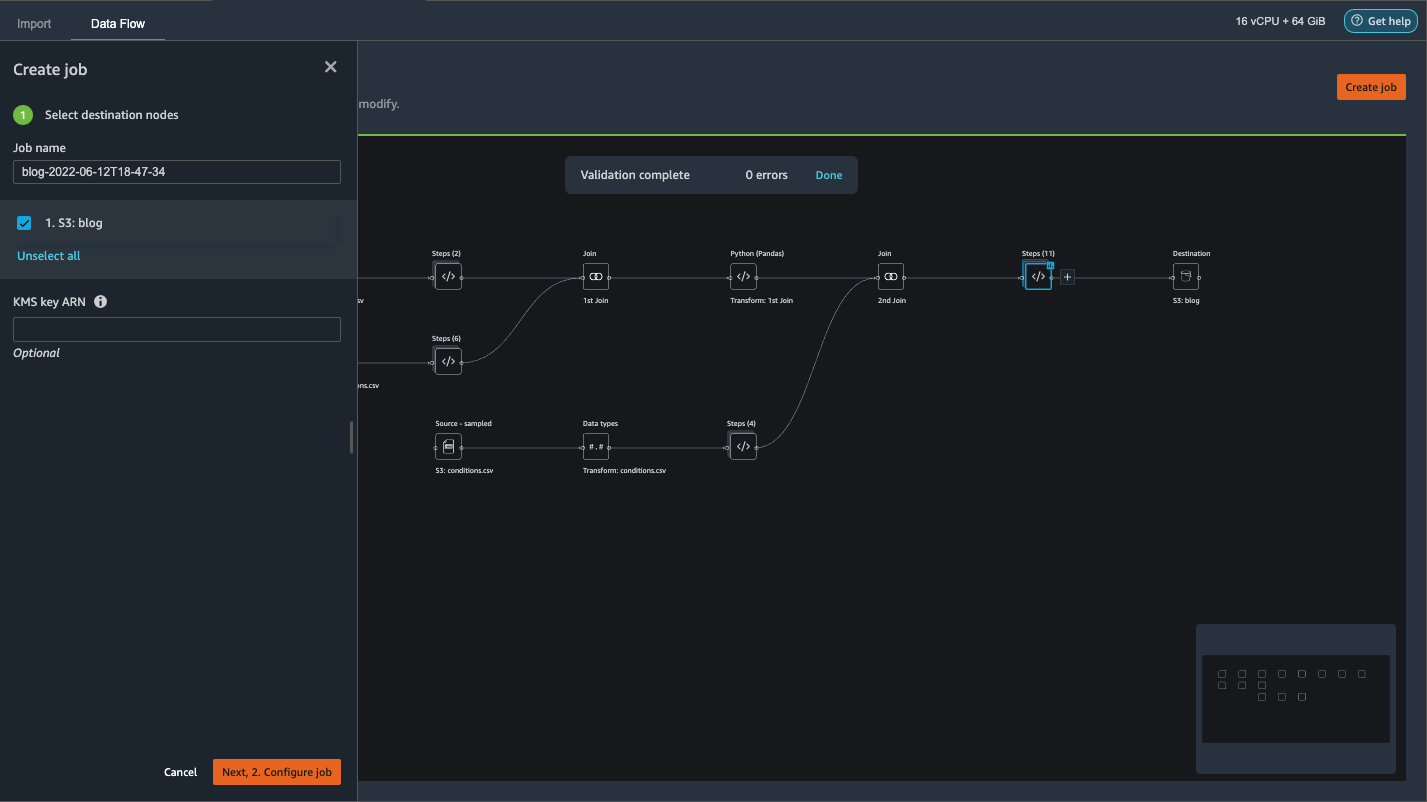

- Elige Crear trabajo para iniciar un trabajo de procesamiento de PySpark distribuido para realizar la transformación y enviar los datos al depósito S3 de destino.

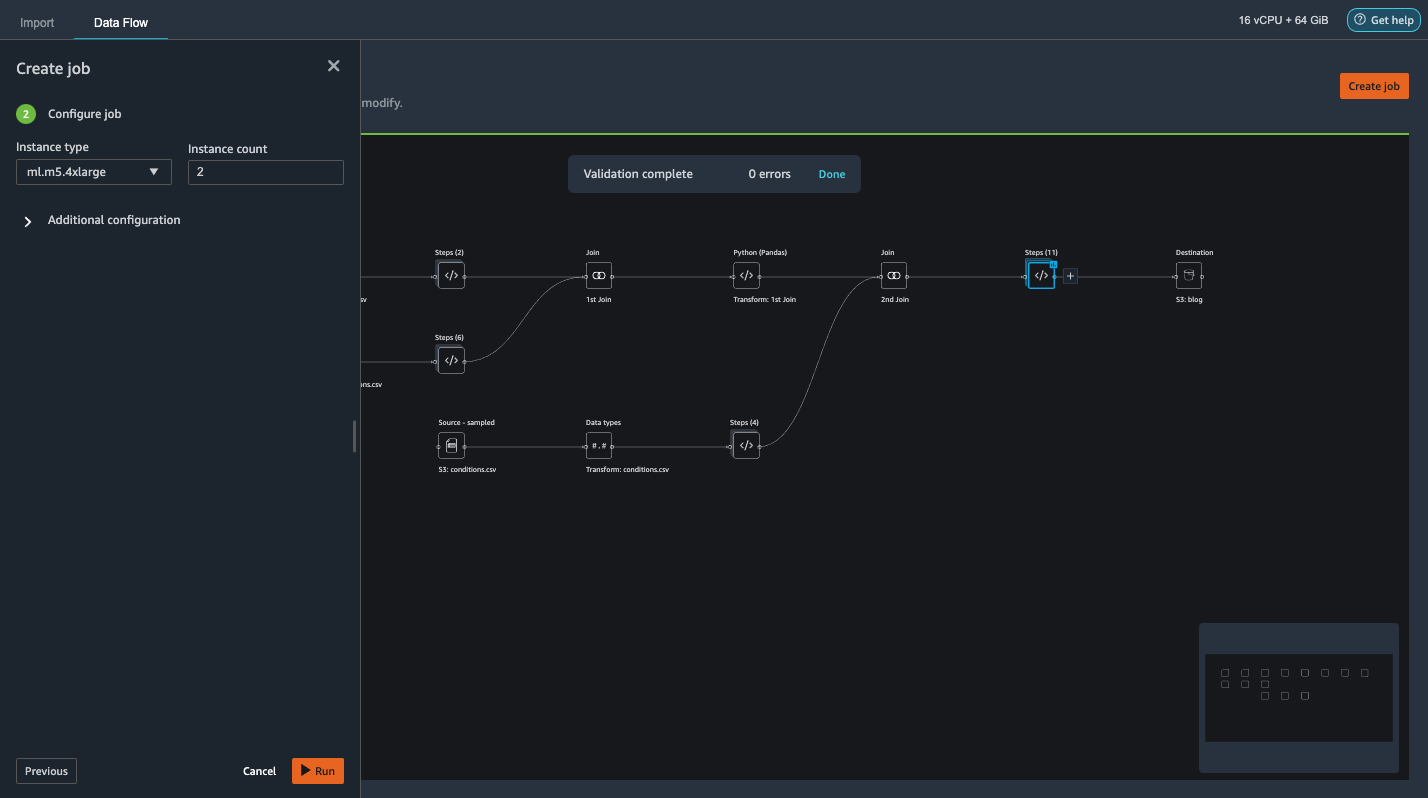

Según el tamaño de los conjuntos de datos, esta opción nos permite configurar fácilmente el clúster y escalar horizontalmente sin código. No tenemos que preocuparnos por particionar los conjuntos de datos o administrar el clúster y los componentes internos de Spark. Data Wrangler se ocupa automáticamente de todo esto. - En el panel izquierdo, elija A continuación, 2. Configurar trabajo.

- Entonces escoge Ejecutar.

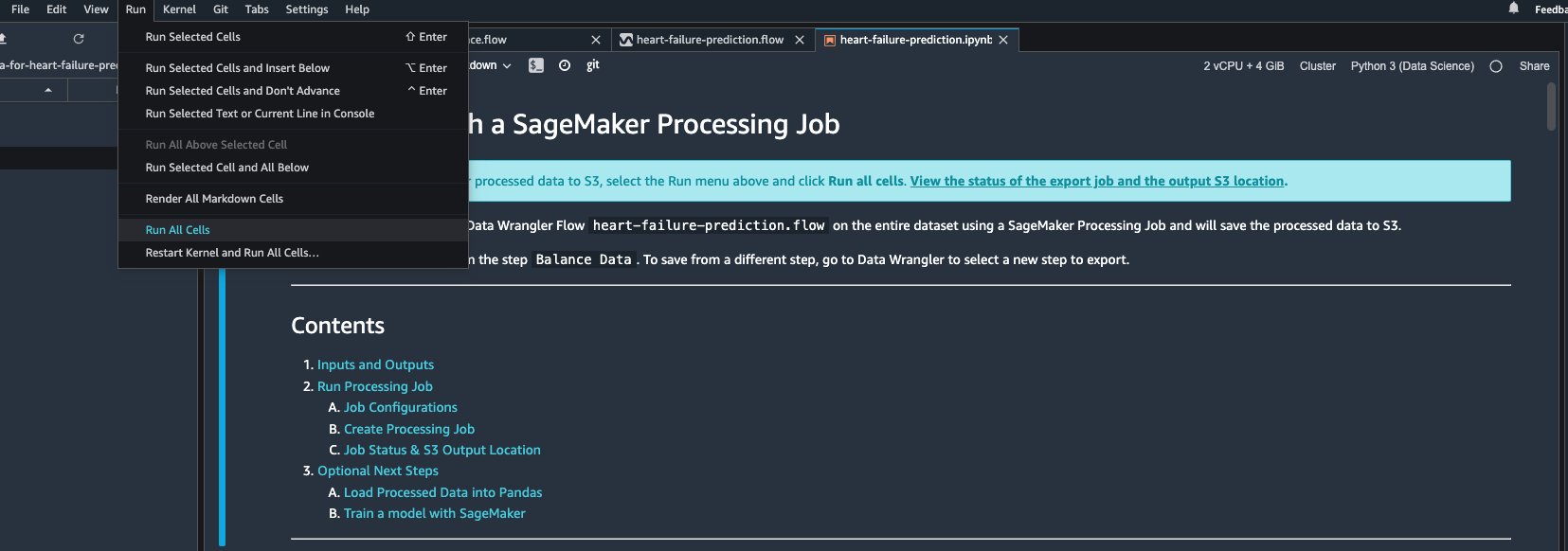

Alternativamente, también podemos exportar la salida transformada a S3 a través de un Jupyter Notebook. Con este enfoque, Data Wrangler genera automáticamente un cuaderno Jupyter con todo el código necesario para iniciar un trabajo de procesamiento para aplicar los pasos del flujo de datos (creados con una muestra) en el conjunto de datos completo más grande y usar el conjunto de datos transformado como funciones para iniciar. de un trabajo de entrenamiento más tarde. El código del cuaderno se puede ejecutar fácilmente con o sin hacer cambios. Ahora repasemos los pasos sobre cómo hacer esto a través de la interfaz de usuario de Data Wrangler.

- Elija el signo más junto al último paso en el flujo de datos y elija Exportar a.

- Elige Amazon S3 (a través de Jupyter Notebook).

- Abre automáticamente una nueva pestaña con un cuaderno Jupyter.

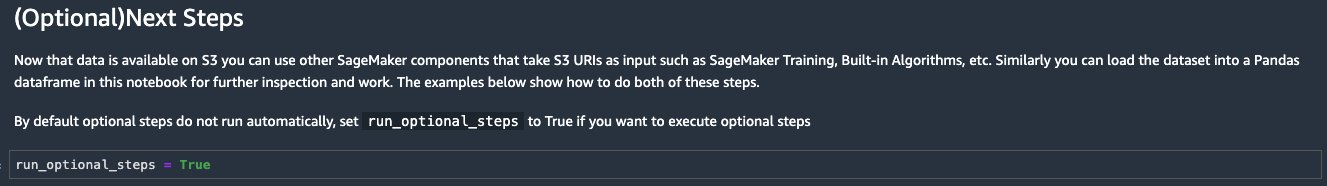

- En el cuaderno de Jupyter, localice la celda en el (Opcional) Próximos pasos sección y cambio

run_optional_stepsenFalseaTrue.

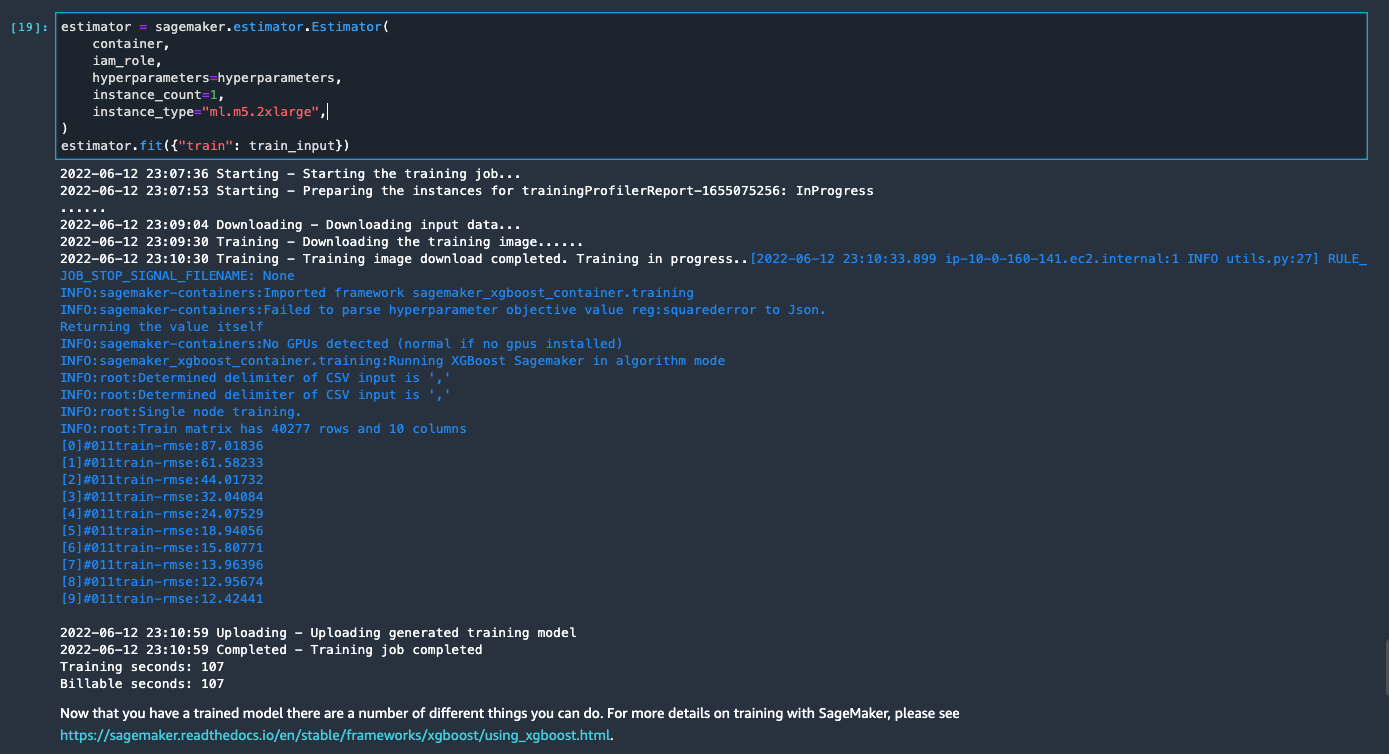

Los pasos opcionales habilitados en el cuaderno realizan lo siguiente: - Regrese a la parte superior del cuaderno y en el Ejecutar menú, seleccione Ejecutar todas las celdas.

Si usa el cuaderno generado tal como está, inicia un trabajo de procesamiento de SageMaker que escala el procesamiento en dos instancias m5.4xlarge para procesar el conjunto de datos completo en el depósito S3. Puede ajustar la cantidad de instancias y los tipos de instancias según el tamaño del conjunto de datos y el tiempo que necesita para completar el trabajo.

Espere hasta que se complete el trabajo de entrenamiento de la última celda. Genera un modelo en el depósito S3 predeterminado de SageMaker.

El modelo entrenado está listo para implementarse para la inferencia en tiempo real o la transformación por lotes. Tenga en cuenta que usamos datos sintéticos para demostrar funcionalidades en Data Wrangler y usamos datos procesados para el modelo de entrenamiento. Dado que los datos que usamos son sintéticos, el resultado de la inferencia del modelo entrenado no está destinado al diagnóstico de condiciones médicas del mundo real ni a la sustitución del juicio de los médicos.

También puede exportar directamente su conjunto de datos transformados a Amazon S3 eligiendo Exportar en la parte superior de la página de vista previa de transformación. La opción de exportación directa solo exporta la muestra transformada si se habilitó el muestreo durante la importación. Esta opción es más adecuada si se trata de conjuntos de datos más pequeños. Los datos transformados también se pueden ingerir directamente en un almacén de funciones. Para obtener más información, consulte Tienda de funciones de Amazon SageMaker. El flujo de datos también se puede exportar como una canalización de SageMaker que se puede orquestar y programar según sus requisitos. Para más información, ver Canalizaciones de Amazon SageMaker.

Conclusión

En esta publicación, mostramos cómo usar Data Wrangler para procesar datos de atención médica y realizar ingeniería de características escalables en una forma de código bajo impulsada por herramientas. Aprendimos a aplicar las transformaciones y análisis incorporados de manera adecuada donde sea necesario, combinándolos con transformaciones personalizadas para agregar aún más flexibilidad a nuestro flujo de trabajo de preparación de datos. También analizamos las diferentes opciones para escalar la receta de flujo de datos a través de trabajos de procesamiento distribuido. También aprendimos cómo los datos transformados se pueden usar fácilmente para entrenar un modelo para predecir la insuficiencia cardíaca.

Hay muchas otras características en Data Wrangler que no hemos cubierto en esta publicación. Explora lo que es posible en Prepare datos de AA con Amazon SageMaker Data Wrangler y aprenda a aprovechar Data Wrangler para su próximo proyecto de ciencia de datos o aprendizaje automático.

Acerca de los autores

Forrest sol es arquitecto sénior de soluciones en el equipo del sector público de AWS en Toronto, Canadá. Ha trabajado en las industrias de salud y finanzas durante las últimas dos décadas. Fuera del trabajo, disfruta acampar con su familia.

Forrest sol es arquitecto sénior de soluciones en el equipo del sector público de AWS en Toronto, Canadá. Ha trabajado en las industrias de salud y finanzas durante las últimas dos décadas. Fuera del trabajo, disfruta acampar con su familia.

Arunprasath Shankar es un arquitecto de soluciones especializado en inteligencia artificial y aprendizaje automático (AI / ML) en AWS, que ayuda a los clientes globales a escalar sus soluciones de inteligencia artificial de manera efectiva y eficiente en la nube. En su tiempo libre, a Arun le gusta ver películas de ciencia ficción y escuchar música clásica.

Arunprasath Shankar es un arquitecto de soluciones especializado en inteligencia artificial y aprendizaje automático (AI / ML) en AWS, que ayuda a los clientes globales a escalar sus soluciones de inteligencia artificial de manera efectiva y eficiente en la nube. En su tiempo libre, a Arun le gusta ver películas de ciencia ficción y escuchar música clásica.

- AI

- arte ai

- generador de arte ai

- robot ai

- Amazon SageMaker

- Wrangler de datos de Amazon SageMaker

- inteligencia artificial

- certificación de inteligencia artificial

- inteligencia artificial en banca

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- Aprendizaje automático de AWS

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- deep learning

- google ai

- máquina de aprendizaje

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- escala ia

- sintaxis

- zephyrnet