Hoy, nos complace anunciar la capacidad de ajustar los modelos Llama 2 mediante Meta usando JumpStart de Amazon SageMaker. La familia Llama 2 de modelos de lenguaje grande (LLM) es una colección de modelos de texto generativo previamente entrenados y ajustados que varían en escala de 7 mil millones a 70 mil millones de parámetros. Los LLM perfeccionados, llamados Llama-2-chat, están optimizados para casos de uso de diálogo. Puede probar fácilmente estos modelos y usarlos con SageMaker JumpStart, que es un centro de aprendizaje automático (ML) que brinda acceso a algoritmos, modelos y soluciones de ML para que pueda comenzar rápidamente con ML. Ahora también puede ajustar los modelos de generación de texto de Llama 7 con 13 mil millones, 70 mil millones y 2 mil millones de parámetros en SageMaker JumpStart usando el Estudio Amazon SageMaker UI con unos pocos clics o usando el SDK de SageMaker Python.

Los modelos básicos de IA generativa han sido el foco de la mayoría de las investigaciones y casos de uso de ML e inteligencia artificial durante más de un año. Estos modelos básicos funcionan muy bien con tareas generativas, como generación de texto, resúmenes, respuesta a preguntas, generación de imágenes y videos, y más, debido a su gran tamaño y también porque están entrenados en varios conjuntos de datos grandes y cientos de tareas. A pesar de las grandes capacidades de generalización de estos modelos, a menudo hay casos de uso que tienen datos de dominio muy específicos (como atención médica o servicios financieros), por lo que es posible que estos modelos no puedan proporcionar buenos resultados para estos casos de uso. Esto resulta en la necesidad de seguir ajustando estos modelos de IA generativa sobre los datos específicos del caso de uso y del dominio.

En esta publicación, explicamos cómo ajustar los modelos de generación de texto previamente entrenados de Llama 2 a través de SageMaker JumpStart.

¿Qué es Llama 2?

Llama 2 es un modelo de lenguaje autorregresivo que utiliza una arquitectura de transformador optimizada. Llama 2 está diseñado para uso comercial y de investigación en inglés. Viene en una variedad de tamaños de parámetros: 7 mil millones, 13 mil millones y 70 mil millones, así como variaciones preentrenadas y ajustadas. Según Meta, las versiones ajustadas utilizan ajuste fino supervisado (SFT) y aprendizaje reforzado con retroalimentación humana (RLHF) para alinearse con las preferencias humanas en cuanto a utilidad y seguridad. Llama 2 fue entrenado previamente en 2 billones de tokens de datos de fuentes disponibles públicamente. Los modelos ajustados están destinados a un chat similar al de un asistente, mientras que los modelos previamente entrenados se pueden adaptar para una variedad de tareas de generación de lenguaje natural. Independientemente de la versión del modelo que utilice un desarrollador, el guía de uso responsable de Meta puede ayudar a guiar los ajustes adicionales que pueden ser necesarios para personalizar y optimizar los modelos con las mitigaciones de seguridad adecuadas.

Actualmente, Llama 2 está disponible en las siguientes regiones:

- Implemente el modelo previamente entrenado disponible:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Ajuste e implemente el modelo ajustado:

“us-east-1”,“us-west-2”,“eu-west-1”

¿Qué es SageMaker JumpStart?

Con SageMaker JumpStart, los profesionales del aprendizaje automático pueden elegir entre una amplia selección de modelos básicos disponibles públicamente. Los profesionales del aprendizaje automático pueden implementar modelos básicos en sitios dedicados. Amazon SageMaker instancias desde un entorno aislado de red y personalice modelos utilizando SageMaker para el entrenamiento e implementación de modelos. Ahora puede descubrir e implementar Llama 2 con unos pocos clics en SageMaker Studio o mediante programación a través del SDK de Python de SageMaker, lo que le permite obtener el rendimiento del modelo y controles MLOps con funciones de SageMaker como Canalizaciones de Amazon SageMaker, Depurador de Amazon SageMakero registros de contenedor. El modelo se implementa en un entorno seguro de AWS y bajo los controles de su VPC, lo que ayuda a garantizar la seguridad de los datos. Además, puede ajustar los modelos de generación de texto previamente entrenados de Llama2 7B, 13B y 70B a través de SageMaker JumpStart.

Afinar los modelos Llama2

Puede ajustar los modelos utilizando la interfaz de usuario de SageMaker Studio o el SDK de SageMaker Python. Analizamos ambos métodos en esta sección.

Ajuste fino sin código a través de la interfaz de usuario de SageMaker Studio

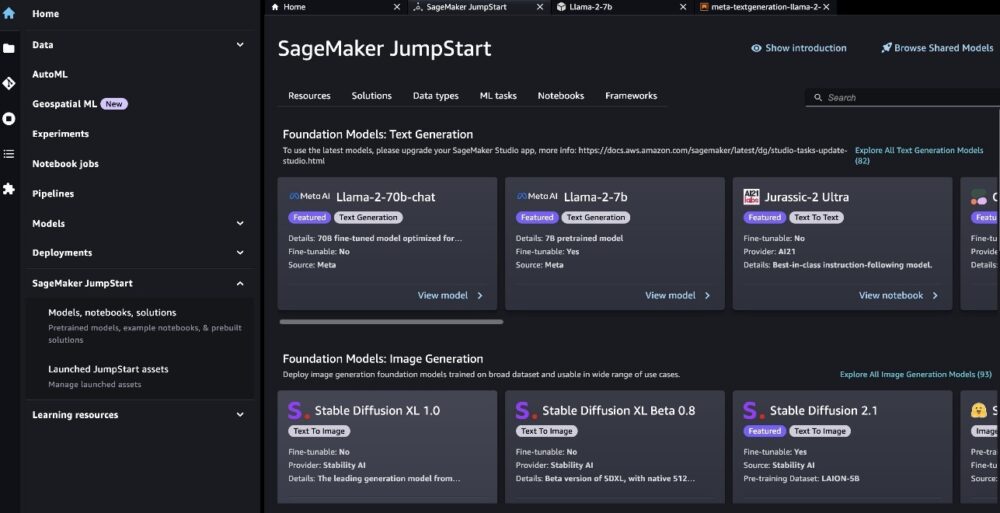

En SageMaker Studio, puede acceder a los modelos Llama 2 a través de SageMaker JumpStart en Modelos, cuadernos y soluciones., como se muestra en la siguiente captura de pantalla.

Si no ve los modelos de Llama 2, actualice su versión de SageMaker Studio apagándolo y reiniciándolo. Para obtener más información sobre las actualizaciones de versión, consulte Cierre y actualice las aplicaciones de Studio.

También puede encontrar otras cuatro variantes de modelo eligiendo Explore todos los modelos de generación de texto o buscando llama en el cuadro de búsqueda.

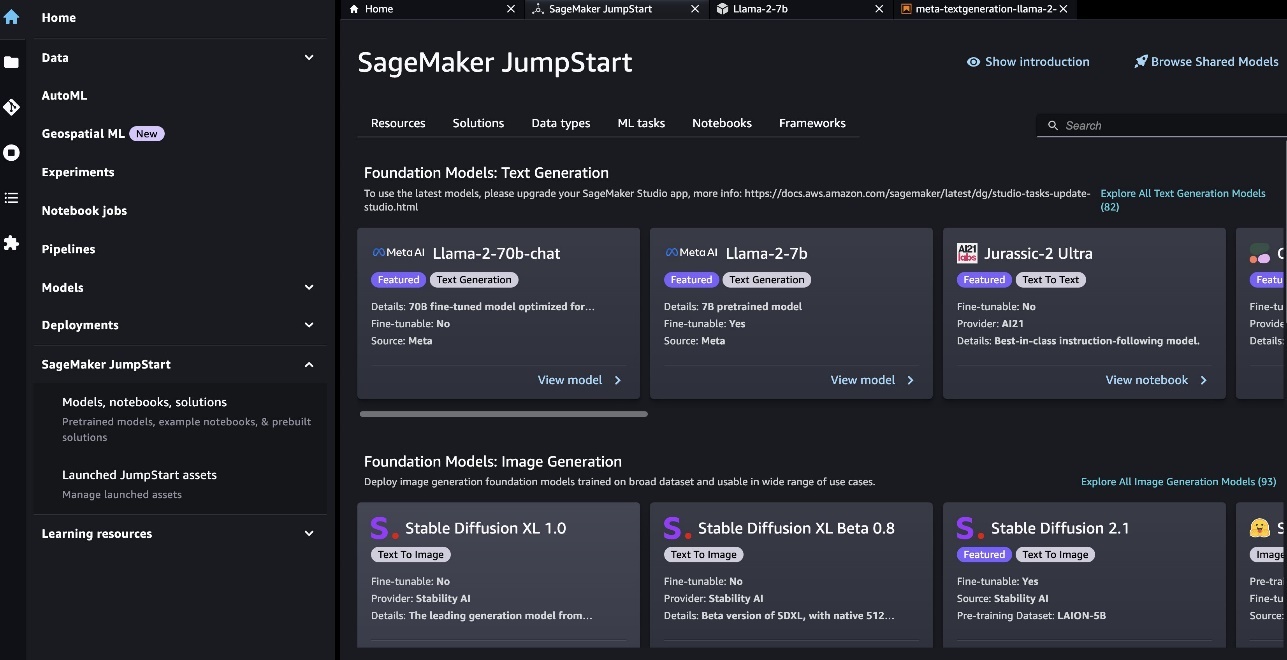

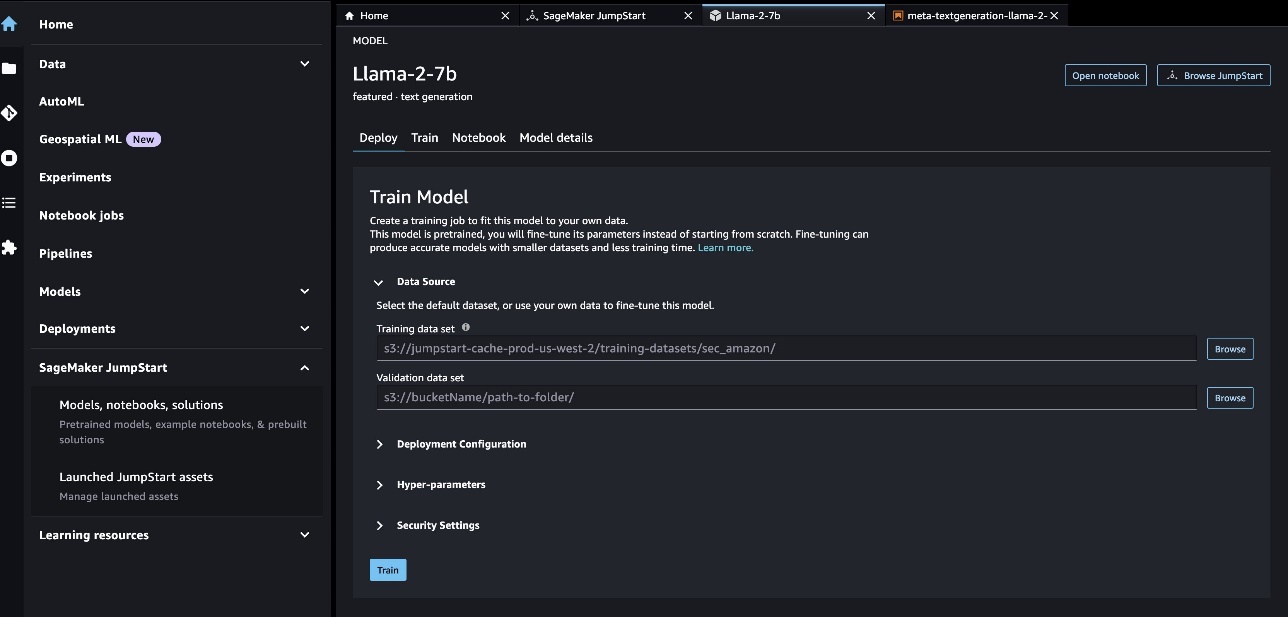

En esta página, puede señalar el Servicio de almacenamiento simple de Amazon (Amazon S3) depósito que contiene los conjuntos de datos de entrenamiento y validación para realizar ajustes. Además, puede configurar la configuración de implementación, los hiperparámetros y la configuración de seguridad para realizar ajustes. Luego puedes elegir Entrenar para iniciar el trabajo de capacitación en una instancia de SageMaker ML. La captura de pantalla anterior muestra la página de ajuste fino del modelo Llama-2 7B; sin embargo, puede ajustar los modelos de generación de texto 13B y 70B Llama 2 utilizando sus respectivas páginas de modelos de manera similar. Para utilizar los modelos Llama 2, debe aceptar el Acuerdo de licencia de usuario final (EULA). Aparecerá cuando tú elijas Entrenar, como se muestra en la siguiente captura de pantalla. Elegir He leído y acepto EULA y AUP para comenzar el trabajo de ajuste.

Implementar el modelo

Una vez que el modelo esté ajustado, puede implementarlo usando la página del modelo en SageMaker JumpStart. La opción para implementar el modelo ajustado aparecerá cuando finalice el ajuste, como se muestra en la siguiente captura de pantalla.

Ajuste a través del SDK de SageMaker Python

También puede ajustar los modelos de Llama 2 utilizando el SDK de SageMaker Python. El siguiente es un código de muestra para ajustar Llama 2 7B en su conjunto de datos:

Puede implementar el modelo ajustado directamente desde el estimador:

También puedes encontrar el código en Ajuste los modelos LLaMA 2 en SageMaker JumpStart. Incluye la preparación del conjunto de datos, la capacitación en su conjunto de datos personalizado y la implementación del modelo ajustado. Demuestra el ajuste de un subconjunto del conjunto de datos de Dolly con ejemplos de la tarea de resumen. La siguiente es la entrada de ejemplo con respuestas de ajuste fino y no ajustado junto con la respuesta de verdad fundamental:

Entrada al modelo:

Respuesta de Ground Truth:

Respuesta del modelo no afinado:

Respuesta del modelo ajustado:

Para realizar una evaluación comparativa del rendimiento de diferentes modelos en el conjunto de datos Dolly y Dialogsum, consulte la Benchmarking de rendimiento sección en el apéndice al final de esta publicación.

Técnica de ajuste fino

Los modelos de idiomas como Llama tienen un tamaño de más de 10 GB o incluso 100 GB. Para ajustar modelos tan grandes se requieren instancias con una memoria CUDA significativamente alta. Además, el entrenamiento de estos modelos puede resultar muy lento debido al tamaño del modelo. Por lo tanto, para un ajuste fino eficiente, utilizamos las siguientes optimizaciones:

- Adaptación de bajo rango (LoRA) – Este es un tipo de ajuste fino eficiente de parámetros (PEFT) para un ajuste fino eficiente de modelos grandes. En esto, congelamos todo el modelo y solo agregamos un pequeño conjunto de parámetros o capas ajustables al modelo. Por ejemplo, en lugar de entrenar los 7 mil millones de parámetros para Llama 2 7B, podemos ajustar menos del 1% de los parámetros. Esto ayuda a reducir significativamente el requisito de memoria porque solo necesitamos almacenar gradientes, estados del optimizador y otra información relacionada con el entrenamiento para solo el 1% de los parámetros. Además, esto ayuda a reducir el tiempo de formación y el coste. Para obtener más detalles sobre este método, consulte LoRA: Adaptación de bajo rango de modelos de lenguaje grande.

- Cuantización Int8 – Incluso con optimizaciones como LoRA, modelos como Llama 70B siguen siendo demasiado grandes para entrenar. Para disminuir la huella de memoria durante el entrenamiento, podemos usar la cuantificación Int8 durante el entrenamiento. La cuantificación normalmente reduce la precisión de los tipos de datos de punto flotante. Aunque esto reduce la memoria necesaria para almacenar los pesos de los modelos, degrada el rendimiento debido a la pérdida de información. La cuantificación Int8 utiliza sólo un cuarto de precisión, pero no provoca una degradación del rendimiento porque no simplemente elimina los bits. Redondea los datos de un tipo a otro. Para obtener más información sobre la cuantización Int8, consulte LLM.int8(): Multiplicación de matrices de 8 bits para transformadores a escala.

- Datos paralelos completamente fragmentados (FSDP) – Este es un tipo de algoritmo de entrenamiento de datos paralelos que fragmenta los parámetros del modelo entre trabajadores de datos paralelos y, opcionalmente, puede descargar parte del cálculo de entrenamiento a las CPU. Aunque los parámetros están divididos en diferentes GPU, el cálculo de cada microlote es local para el trabajador de la GPU. Fragmenta los parámetros de manera más uniforme y logra un rendimiento optimizado mediante la superposición de la comunicación y el cálculo durante el entrenamiento.

La siguiente tabla compara diferentes métodos con los tres modelos Llama 2.

| , | Tipo de instancia predeterminado | Tipos de instancias admitidas con configuración predeterminada | Configuración predeterminada | LORA + FSDP | LORA + Sin FSDP | Cuantización Int8 + LORA + Sin FSDP |

| Llama 2 7B | ml.g5.12xgrande | ml.g5.12xgrande, ml.g5.24xgrande, ml.g5.48xgrande | LORA + FSDP | Sí | Sí | Sí |

| Llama 2 13B | ml.g5.12xgrande | ml.g5.24xgrande, ml.g5.48xgrande | LORA + FSDP | Sí | Sí | Sí |

| Llama 2 70B | ml.g5.48xgrande | ml.g5.48xgrande | INT8 + LORA + SIN FSDP | No | No | Sí |

Tenga en cuenta que el ajuste fino de los modelos Llama se basa en scripts proporcionados por lo siguiente Repositorio GitHub.

Formato del conjunto de datos de entrenamiento

SageMaker JumpStart actualmente admite conjuntos de datos tanto en formato de adaptación de dominio como en formato de ajuste de instrucciones. En esta sección, especificamos un conjunto de datos de ejemplo en ambos formatos. Para obtener más detalles, consulte la Formato del conjunto de datos sección del apéndice.

Formato de adaptación de dominio

El modelo Llama 2 de generación de texto se puede ajustar en cualquier conjunto de datos específico de un dominio. Después de ajustar el conjunto de datos específico del dominio, se espera que el modelo genere texto específico del dominio y resuelva varias tareas de PNL en ese dominio específico con pocas indicaciones. Con este conjunto de datos, la entrada consta de un archivo CSV, JSON o TXT. Por ejemplo, los datos de entrada pueden ser presentaciones ante la SEC de Amazon como un archivo de texto:

Formato de ajuste de instrucciones

En el ajuste de instrucciones, el modelo se ajusta para un conjunto de tareas de procesamiento del lenguaje natural (PNL) descritas mediante instrucciones. Esto ayuda a mejorar el rendimiento del modelo para tareas invisibles con indicaciones de disparo cero. En el formato de conjunto de datos de ajuste de instrucciones, usted especifica el template.json archivo que describe los formatos de entrada y salida. Por ejemplo, cada línea del archivo train.jsonl se parece a lo siguiente:

El archivo adicional template.json se parece a lo siguiente:

Hiperparámetros admitidos para el entrenamiento

El ajuste fino de Llama 2 admite una serie de hiperparámetros, cada uno de los cuales puede afectar los requisitos de memoria, la velocidad de entrenamiento y el rendimiento del modelo ajustado:

- época – El número de pasadas que realiza el algoritmo de ajuste fino a través del conjunto de datos de entrenamiento. Debe ser un número entero mayor que 1. El valor predeterminado es 5.

- tasa de aprendizaje – La velocidad a la que se actualizan los pesos del modelo después de trabajar en cada lote de ejemplos de entrenamiento. Debe ser un valor flotante positivo mayor que 0. El valor predeterminado es 1e-4.

- instrucción_afinada – Si se debe entrenar el modelo mediante instrucciones o no. Debe ser '

True'o'False'. El valor predeterminado es 'False'. - por_dispositivo_tren_batch_size – El tamaño del lote por núcleo de GPU/CPU para entrenamiento. Debe ser un número entero positivo. El valor predeterminado es 4.

- per_device_eval_batch_size – El tamaño del lote por núcleo de GPU/CPU para evaluación. Debe ser un número entero positivo. El valor predeterminado es 1.

- max_train_samples – Para fines de depuración o capacitación más rápida, trunque la cantidad de ejemplos de capacitación a este valor. El valor -1 significa utilizar todas las muestras de entrenamiento. Debe ser un número entero positivo o -1. El valor predeterminado es -1.

- max_val_samples – Para fines de depuración o capacitación más rápida, trunque el número de ejemplos de validación a este valor. El valor -1 significa utilizar todas las muestras de validación. Debe ser un número entero positivo o -1. El valor predeterminado es -1.

- longitud_entrada_max – Longitud máxima total de la secuencia de entrada después de la tokenización. Las secuencias más largas se truncarán. Si -1,

max_input_lengthse establece en el mínimo de 1024 y la longitud máxima del modelo definida por el tokenizador. Si se establece en un valor positivo,max_input_lengthse establece en el mínimo del valor proporcionado y elmodel_max_lengthdefinido por el tokenizador. Debe ser un número entero positivo o -1. El valor predeterminado es -1. - relación_división_validación – Si el canal de validación es

none, la proporción de división de validación del tren a partir de los datos del tren debe estar entre 0 y 1. El valor predeterminado es 0.2. - tren_datos_split_seed – Si los datos de validación no están presentes, esto corrige la división aleatoria de los datos de entrenamiento de entrada en los datos de entrenamiento y validación utilizados por el algoritmo. Debe ser un entero. El valor predeterminado es 0.

- preprocesamiento_num_trabajadores – El número de procesos que se utilizarán para el preprocesamiento. Si

None, el proceso principal se utiliza para el preprocesamiento. El valor predeterminado esNone. - lora_r – Lora R. Debe ser un número entero positivo. El valor predeterminado es 8.

- lora_alfa – Lora Alfa. Debe ser un número entero positivo. El valor predeterminado es 32

- lora_dropout – Lora Abandono. debe ser un valor flotante positivo entre 0 y 1. El valor predeterminado es 0.05.

- int8_cuantización - Si

True, el modelo se carga con precisión de 8 bits para entrenamiento. El valor predeterminado para 7B y 13B esFalse. El valor predeterminado para 70B esTrue. - habilitar_fsdp - Si

True, el entrenamiento utiliza FSDP. El valor predeterminado para 7B y 13B esTrue. El valor predeterminado para 70B esFalse. Tenga en cuenta queint8_quantizationno es compatible con FSDP.

Tipos de instancias e hiperparámetros compatibles

El requisito de memoria durante el ajuste fino puede variar según varios factores:

- Tipo de modelo – El modelo 7B tiene el menor requisito de memoria GPU y el 70B tiene el mayor requisito de memoria

- Longitud máxima de entrada – Un valor más alto de longitud de entrada lleva a procesar más tokens a la vez y, como tal, requiere más memoria CUDA

- Tamaño del lote – Un tamaño de lote mayor requiere mayor memoria CUDA y, por lo tanto, requiere tipos de instancias más grandes

- Cuantización Int8 – Si se utiliza la cuantificación Int8, el modelo se carga con baja precisión y, por lo tanto, requiere menos memoria CUDA.

Para ayudarlo a comenzar, proporcionamos un conjunto de combinaciones de diferentes tipos de instancias, hiperparámetros y tipos de modelos que se pueden ajustar con éxito. Puede seleccionar una configuración según sus requisitos y la disponibilidad de los tipos de instancia. Ajustamos los tres modelos en una variedad de configuraciones con tres épocas en un subconjunto del conjunto de datos de Dolly con ejemplos de resumen.

modelo 7B

La siguiente tabla resume las opciones de ajuste en el modelo 7B.

| Tipo de instancia | Longitud máxima de entrada | Tamaño de lote por dispositivo | Cuantización Int8 | Habilitar FSDP | Tiempo empleado (minutos) |

| ml.g4dn.12xgrande | 1024 | 8 | VERDADERO | FALSO | 166 |

| ml.g4dn.12xgrande | 2048 | 2 | VERDADERO | FALSO | 178 |

| ml.g4dn.12xgrande | 1024 | 4 | FALSO | VERDADERO | 120 |

| ml.g4dn.12xgrande | 2048 | 2 | FALSO | VERDADERO | 143 |

| ml.g5.2xgrande | 1024 | 4 | VERDADERO | FALSO | 61 |

| ml.g5.2xgrande | 2048 | 2 | VERDADERO | FALSO | 68 |

| ml.g5.2xgrande | 1024 | 4 | FALSO | VERDADERO | 43 |

| ml.g5.2xgrande | 2048 | 2 | FALSO | VERDADERO | 49 |

| ml.g5.4xgrande | 1024 | 4 | FALSO | VERDADERO | 39 |

| ml.g5.4xgrande | 2048 | 2 | FALSO | VERDADERO | 50 |

| ml.g5.12xgrande | 1024 | 16 | VERDADERO | FALSO | 57 |

| ml.g5.12xgrande | 2048 | 4 | VERDADERO | FALSO | 64 |

| ml.g5.12xgrande | 1024 | 4 | FALSO | VERDADERO | 26 |

| ml.g5.12xgrande | 2048 | 4 | FALSO | VERDADERO | 23 |

| ml.g5.48xgrande | 1024 | 16 | VERDADERO | FALSO | 59 |

| ml.g5.48xgrande | 2048 | 4 | VERDADERO | FALSO | 67 |

| ml.g5.48xgrande | 1024 | 8 | FALSO | VERDADERO | 22 |

| ml.g5.48xgrande | 2048 | 4 | FALSO | VERDADERO | 21 |

13B

La siguiente tabla resume las opciones de ajuste en el modelo 13B.

| Tipo de instancia | Longitud máxima de entrada | Tamaño de lote por dispositivo | Cuantización Int8 | Habilitar FSDP | Tiempo empleado (minutos) |

| ml.g4dn.12xgrande | 1024 | 4 | VERDADERO | FALSO | 283 |

| ml.g4dn.12xgrande | 2048 | 2 | VERDADERO | FALSO | 328 |

| ml.g5.12xgrande | 1024 | 8 | VERDADERO | FALSO | 92 |

| ml.g5.12xgrande | 2048 | 4 | VERDADERO | FALSO | 104 |

| ml.g5.48xgrande | 1024 | 8 | VERDADERO | FALSO | 95 |

| ml.g5.48xgrande | 2048 | 4 | VERDADERO | FALSO | 107 |

| ml.g5.48xgrande | 1024 | 8 | FALSO | VERDADERO | 35 |

| ml.g5.48xgrande | 2048 | 2 | FALSO | VERDADERO | 41 |

70B

La siguiente tabla resume las opciones de ajuste en el modelo 70B.

| Tipo de instancia | Longitud máxima de entrada | Tamaño de lote por dispositivo | Cuantización Int8 | Habilitar FSDP | Tiempo empleado (minutos) |

| ml.g5.48xgrande | 1024 | 4 | VERDADERO | FALSO | 396 |

| ml.g5.48xgrande | 2048 | 1 | VERDADERO | FALSO | 454 |

Recomendaciones sobre tipos de instancias e hiperparámetros

Al ajustar la precisión del modelo, tenga en cuenta lo siguiente:

- Los modelos más grandes, como el 70B, ofrecen un mejor rendimiento que el 7B

- El rendimiento sin cuantificación Int8 es mejor que el rendimiento con cuantificación INT8

Tenga en cuenta los siguientes requisitos de tiempo de entrenamiento y memoria CUDA:

- Fijar

int8_quantization=TrueDisminuye la necesidad de memoria y conduce a un entrenamiento más rápido. - Decreciente

per_device_train_batch_sizeymax_input_lengthreduce el requisito de memoria y, por lo tanto, se puede ejecutar en instancias más pequeñas. Sin embargo, establecer valores muy bajos puede aumentar el tiempo de entrenamiento. - Si no estás usando la cuantización Int8 (

int8_quantization=False), utilice FSDP (enable_fsdp=True) para un entrenamiento más rápido y eficiente.

Al elegir el tipo de instancia, considere lo siguiente:

- Las instancias G5 brindan la capacitación más eficiente entre los tipos de instancias admitidos. Por lo tanto, si tienes instancias G5 disponibles, debes usarlas.

- El tiempo de entrenamiento depende en gran medida de la cantidad de GPU y de la memoria CUDA disponible. Por lo tanto, el entrenamiento en instancias con la misma cantidad de GPU (por ejemplo, ml.g5.2xlarge y ml.g5.4xlarge) es aproximadamente el mismo. Por lo tanto, puede utilizar la instancia más económica para entrenar (ml.g5.2xlarge).

- Cuando se utilizan instancias p3, el entrenamiento se realizará con una precisión de 32 bits porque bfloat16 no es compatible con estas instancias. Por lo tanto, el trabajo de entrenamiento consumirá el doble de memoria CUDA cuando se entrena en instancias p3 en comparación con instancias g5.

Para conocer el costo de la capacitación por instancia, consulte Instancias de Amazon EC2 G5.

Si el conjunto de datos está en formato de ajuste de instrucciones y las secuencias de entrada y finalización son pequeñas (como 50 a 100 palabras), entonces un valor alto de max_input_length conduce a un rendimiento muy pobre. El valor predeterminado de este parámetro es -1, que corresponde al max_input_length de 2048 para los modelos Llama. Por lo tanto, recomendamos que si su conjunto de datos contiene muestras pequeñas, utilice un valor pequeño para max_input_length (como 200–400).

Por último, debido a la gran demanda de las instancias G5, es posible que experimente falta de disponibilidad de estas instancias en su región con el error “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Si experimenta este error, vuelva a intentar realizar el trabajo de capacitación o pruebe con una región diferente.

Problemas al ajustar modelos muy grandes

En esta sección, analizamos dos cuestiones a la hora de ajustar modelos muy grandes.

Deshabilitar la compresión de salida

De forma predeterminada, el resultado de un trabajo de entrenamiento es un modelo entrenado que se comprime en formato .tar.gz antes de cargarlo en Amazon S3. Sin embargo, debido al gran tamaño del modelo, este paso puede llevar mucho tiempo. Por ejemplo, comprimir y cargar el modelo 70B puede llevar más de 4 horas. Para evitar este problema, puede utilizar la función deshabilitar la compresión de salida admitida por la plataforma de capacitación SageMaker. En este caso, el modelo se carga sin ningún tipo de compresión, que se utiliza posteriormente para la implementación:

Problema de tiempo de espera del kernel de SageMaker Studio

Debido al tamaño del modelo Llama 70B, el trabajo de capacitación puede tardar varias horas y el kernel de SageMaker Studio puede morir durante la fase de capacitación. Sin embargo, durante este tiempo, la capacitación todavía se ejecuta en SageMaker. Si esto sucede, aún puede implementar el punto final usando el nombre del trabajo de capacitación con el siguiente código:

Para encontrar el nombre del trabajo de capacitación, navegue hasta la consola de SageMaker y en Formación en el panel de navegación, elija Empleos de entrenamiento. Identifique el nombre del trabajo de capacitación y sustitúyalo en el código anterior.

Conclusión

En esta publicación, discutimos el ajuste de los modelos Llama 2 de Meta usando SageMaker JumpStart. Mostramos que puede usar la consola SageMaker JumpStart en SageMaker Studio o el SDK de SageMaker Python para ajustar e implementar estos modelos. También analizamos la técnica de ajuste, los tipos de instancias y los hiperparámetros admitidos. Además, describimos recomendaciones para una capacitación optimizada basadas en varias pruebas que realizamos. Los resultados del ajuste de los tres modelos en dos conjuntos de datos se muestran en el apéndice al final de esta publicación. Como podemos ver en estos resultados, el ajuste fino mejora el resumen en comparación con los modelos no ajustados. Como siguiente paso, puede intentar ajustar estos modelos en su propio conjunto de datos utilizando el código proporcionado en el repositorio de GitHub para probar y comparar los resultados para sus casos de uso.

Los autores desean agradecer las contribuciones técnicas de Christopher Whitten, Xin Huang, Kyle Ulrich, Sifei Li, Amy You, Adam Kozdrowicz, Evan Kravitz, Benjamin Crabtree, Haotian An, Manan Shah, Tony Cruz, Ernev Sharma, Jonathan Guinegagne y June. Ganado.

Acerca de los autores

Dr. Vivek Madan es un científico aplicado del equipo JumpStart de Amazon SageMaker. Obtuvo su doctorado en la Universidad de Illinois en Urbana-Champaign y fue investigador posdoctoral en Georgia Tech. Es un investigador activo en aprendizaje automático y diseño de algoritmos y ha publicado artículos en conferencias EMNLP, ICLR, COLT, FOCS y SODA.

Dr. Vivek Madan es un científico aplicado del equipo JumpStart de Amazon SageMaker. Obtuvo su doctorado en la Universidad de Illinois en Urbana-Champaign y fue investigador posdoctoral en Georgia Tech. Es un investigador activo en aprendizaje automático y diseño de algoritmos y ha publicado artículos en conferencias EMNLP, ICLR, COLT, FOCS y SODA.

Dr. Farooq Sabir es arquitecto sénior de soluciones especialista en inteligencia artificial y aprendizaje automático en AWS. Tiene un doctorado y una maestría en ingeniería eléctrica de la Universidad de Texas en Austin y una maestría en informática del Instituto de Tecnología de Georgia. Tiene más de 15 años de experiencia laboral y también le gusta enseñar y asesorar a estudiantes universitarios. En AWS, ayuda a los clientes a formular y resolver sus problemas comerciales en ciencia de datos, aprendizaje automático, visión artificial, inteligencia artificial, optimización numérica y dominios relacionados. Con sede en Dallas, Texas, a él y a su familia les encanta viajar y hacer viajes largos por carretera.

Dr. Farooq Sabir es arquitecto sénior de soluciones especialista en inteligencia artificial y aprendizaje automático en AWS. Tiene un doctorado y una maestría en ingeniería eléctrica de la Universidad de Texas en Austin y una maestría en informática del Instituto de Tecnología de Georgia. Tiene más de 15 años de experiencia laboral y también le gusta enseñar y asesorar a estudiantes universitarios. En AWS, ayuda a los clientes a formular y resolver sus problemas comerciales en ciencia de datos, aprendizaje automático, visión artificial, inteligencia artificial, optimización numérica y dominios relacionados. Con sede en Dallas, Texas, a él y a su familia les encanta viajar y hacer viajes largos por carretera.

Dr. Ashish Khetan es un científico aplicado sénior de Amazon SageMaker JumpStart y ayuda a desarrollar algoritmos de aprendizaje automático. Obtuvo su doctorado en la Universidad de Illinois Urbana-Champaign. Es un investigador activo en aprendizaje automático e inferencia estadística, y ha publicado muchos artículos en conferencias NeurIPS, ICML, ICLR, JMLR, ACL y EMNLP.

Dr. Ashish Khetan es un científico aplicado sénior de Amazon SageMaker JumpStart y ayuda a desarrollar algoritmos de aprendizaje automático. Obtuvo su doctorado en la Universidad de Illinois Urbana-Champaign. Es un investigador activo en aprendizaje automático e inferencia estadística, y ha publicado muchos artículos en conferencias NeurIPS, ICML, ICLR, JMLR, ACL y EMNLP.

Apéndice

Este apéndice proporciona información adicional sobre evaluaciones comparativas de rendimiento y formato de conjuntos de datos.

Benchmarking de rendimiento

En esta sección, proporcionamos resultados para ajustar los tres modelos Llama 2 (7B, 13B y 70B) en dos conjuntos de datos diferentes: Muñequita y suma de diálogo. Para el conjunto de datos Dolly, nuestra tarea es resumir un párrafo de texto, mientras que para Dialogsum, estamos ajustando el modelo para resumir una discusión entre dos personas. En las siguientes tablas, mostramos la entrada al modelo (indicaciones e instrucciones), la verdad fundamental (resumen), la respuesta del modelo Llama 2 previamente entrenado y la respuesta del modelo Llama 2 ajustado para cada una de las tres Llama. 2 modelos. Mostramos resultados de inferencia para cinco puntos de datos. Puede observar en las siguientes tablas que los resúmenes mejoran para ambos conjuntos de datos cuando ajustamos los modelos.

- Resultados del ajuste del modelo de generación de texto Llama 2 7B en el conjunto de datos Dolly:

| Ingresos | Verdad fundamental | Respuesta del modelo no ajustado | Respuesta del modelo ajustado |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:nDónde está Allauchnn### Entrada:nAllauch (pronunciación francesa:; occitano: Alaug) es una comuna francesa situada al este de Marsella en el departamento de Bouches-du-Rhône en la región francesa de Provenza-Alpes-Costa Azul.nnLos habitantes de la comuna son conocidos como Allaudiens o Allaudiennes en francés.nnnn### Respuesta:n | Allauch es una comuna francesa situada al este de Marsella en el departamento de Bouches-du-Rhône en la región francesa de Provenza-Alpes-Costa Azul. Los habitantes de la comuna son conocidos como Allaudiens o Allaudiennes en francés. | Allauch es una ciudad situada a 28 km al este de Marsella en el departamento de Bouches-du-Rhône en la región francesa de Provenza-Alpes-Costa Azul. Está considerado uno de los pueblos más bellos de Francia. La ciudad está rodeada de colinas y viñedos y tiene una población de alrededor de 6,000 personas. Fue mencionado por primera vez en 1006 y tiene una rica | La comuna está situada en una meseta rocosa llamada Massif du Gélas, situada al este de Marsella. Tiene una hermosa vista de Marsella y su costa. Allauch es ahora un municipio bien desarrollado con su propio ayuntamiento y una gran variedad de tiendas, bares y restaurantes. Debido a su ubicación entre Marsella y Alpilles, ha conservado muchas características naturales de la zona, incluido el Macizo de Glandes, también conocido como el “W |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:n¿Qué es un mamífero que pone huevos?nn### Entrada:nEl ornitorrinco (Ornithorhynchus anatinus), a veces denominado ornitorrinco con pico de pato, es un huevo semiacuático -Mamífero ponedor endémico del este de Australia, incluida Tasmania. El ornitorrinco es el único representante vivo o taxón monotípico de su familia (Ornithorhynchidae) y género (Ornithorhynchus), aunque en el registro fósil aparecen varias especies relacionadas.nnnn### Respuesta:n | El ornitorrinco es un mamífero que pone huevos y se encuentra en el este de Australia. Es el único representante vivo de su género Ornithorhynchus. | Investigué bastante sobre tu pregunta. Leí toda la información que proporcionaste en tu segundo párrafo. También leí un poco sobre los ornitorrincos, incluida [esta página] (https://phys.org/news/2019-04-australia-platypus-predator-species.html). Creo que encontré algunas respuestas a tu pregunta. ¿Estás preguntando si el ornitorrinco es un mamífero que pone huevos o si | Un mamífero que pone huevos, como un ornitorrinco. |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:n¿Cuándo murió Félix Luna?nn### Entrada:nFélix César Luna (30 de septiembre de 1925 - 5 de noviembre de 2009) fue un escritor, letrista e historiador argentino.nnnn# ## Respuesta:n | Félix Luna murió el 5 de noviembre de 2009. | Félix César Luna (30 de septiembre de 1925 - 5 de noviembre de 2009) fue argentinonn¿Cuándo murió Luna?nnn### Explicación:nRespondemos a la pregunta con la fecha de nacimiento y la fecha de muerte del insumo.nnn### Solución: 1102n | Félix Luna falleció el 5 de noviembre de 2009.nn |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:nAnote algunos puntos importantes sobre la ilusión óptica del pasaje dado.nn### Entrada:nEn la percepción visual, una ilusión óptica (también llamada ilusión visual) es una Ilusión causada por el sistema visual y caracterizada por una percepción visual que posiblemente parece diferir de la realidad. Las ilusiones vienen en una amplia variedad; su categorización es difícil porque la causa subyacente a menudo no está clara, pero una clasificación propuesta por Richard Gregory es útil como orientación. Según esto, hay tres clases principales: ilusiones físicas, fisiológicas y cognitivas, y en cada clase hay cuatro tipos: ambigüedades, distorsiones, paradojas y ficciones. Un ejemplo clásico de distorsión física sería la aparente curvatura de un palo medio sumergido en agua; un ejemplo de paradoja fisiológica es el efecto secundario del movimiento (donde, a pesar del movimiento, la posición permanece sin cambios). Un ejemplo de ficción anfisiológica es una imagen residual. Tres distorsiones cognitivas típicas son la ilusión de Ponzo, Poggendorff y Müller-Lyer. Las ilusiones físicas son causadas por el entorno físico, por ejemplo, por las propiedades ópticas del agua. Las ilusiones fisiológicas surgen en el ojo o en la vía visual, por ejemplo, por los efectos de una estimulación excesiva de un tipo específico de receptor. Las ilusiones visuales cognitivas son el resultado de inferencias inconscientes y son quizás las más conocidas.nnnn### Respuesta:n | 1. La ilusión visual es causada por el sistema visual y se caracteriza por una percepción visual que parece ser diferente de la realidad. n2. Según Richard Gregory es útil como orientación una clasificación propuesta por él: hay tres clases principales: ilusiones físicas, fisiológicas y cognitivas, y en cada clase hay cuatro tipos: ambigüedades, distorsiones, paradojas y ficciones.3. Un ejemplo de distorsión física sería la aparente curvatura de un palo medio sumergido en agua; un ejemplo de paradoja fisiológica es el efecto secundario del movimiento (donde, a pesar del movimiento, la posición permanece sin cambios). n4. Un ejemplo de ficción fisiológica es una imagen residual5. Tres distorsiones cognitivas son la ilusión de Ponzo, Poggendorff y Müller-Lyer.n6. Las ilusiones físicas son causadas por el entorno físico, por ejemplo, por las propiedades ópticas del agua. Las ilusiones fisiológicas surgen en el ojo o en la vía visual.n7. La ilusión más conocida son las ilusiones visuales que son el resultado de inferencias inconscientes. | La ilusión óptica mencionada en el pasaje es el movimiento ilusorio del palo que está parcialmente sumergido en agua.nn## 50.n### Instrucción:nEscriba un argumento para apoyar o refutar la afirmación:nTodos los estudiantes de nuestro laboratorio tienen el mismo coeficiente intelectual promedio.nn### Entrada:nMuchos estudiantes en el experimento tienen el mismo coeficiente intelectual promedio, y creo que son el 10% con el coeficiente intelectual más alton | Las ilusiones ópticas hacen uso de las limitaciones fisiológicas y psicológicas relacionadas con la forma en que interpretamos y respondemos a los estímulos visuales, tanto los estímulos del mundo que nos rodea como los estímulos visuales producidos internamente. Proporcionan un estímulo común a los dos sistemas (físico y psicológico/perceptivo) que nos permite comparar ambos y comprender la forma en que funciona cada uno. Hay una variedad de diferentes formas de ilusiones ópticas, que incluyen psicológicas, |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud. nn### Instrucción: n Resuma el dilema del innovador en unas pocas oraciones nn### Entrada: n Describe cómo las grandes empresas establecidas pierden participación de mercado al escuchar a sus clientes y ofrecer lo que parece ser el más alto productos de bajo valor, pero las nuevas empresas que atienden a clientes de bajo valor con tecnología poco desarrollada pueden mejorar esa tecnología gradualmente hasta que sea lo suficientemente buenannnn### Respuesta:n | El dilema del innovador: cuando las nuevas tecnologías causan el fracaso de las grandes empresas, publicado por primera vez en 1997, es el trabajo más conocido del profesor y empresario de Harvard Clayton Christensen. Amplía el concepto de tecnologías disruptivas, término que acuñó en un artículo de 1995 “Tecnologías disruptivas: atrapando la ola”. Describe cómo las grandes empresas tradicionales pierden cuota de mercado al escuchar a sus clientes y ofrecerles lo que parecen ser productos de mayor valor, pero las nuevas empresas que atienden a clientes de bajo valor con tecnología poco desarrollada pueden mejorar esa tecnología de forma incremental hasta que sea lo suficientemente buena para quitarle rápidamente cuota de mercado a las empresas establecidas. Christensen recomienda que las grandes empresas mantengan divisiones pequeñas y ágiles que intenten replicar este fenómeno internamente para evitar ser tomadas por sorpresa y superadas por competidores emergentes. | Hola, ¡¡Perdón por la respuesta tardía!! Estuve de vacaciones la semana pasada :)nnEl dilema del innovador de Clayton Christensen explica que “el dilema del innovador es que la búsqueda de ganancias sostenidas por parte de una empresa mediante la introducción o mejora de sus productos para proporcionar más valor a los clientes existentes dará como resultado que esos mismos clientes abandonen el empresa para comprar innovaciones que ofrecen al menos algo de valor | The Innovator's Dilemma es un libro que explica cómo las grandes empresas tradicionales pierden participación de mercado al escuchar a sus clientes y ofrecer lo que parecen ser productos de mayor valor, pero las nuevas empresas que atienden a clientes de bajo valor con tecnología poco desarrollada pueden mejorar esa tecnología de manera incremental. hasta que sea lo suficientemente bueno nn |

- Resultados del ajuste del modelo de generación de texto Llama 2 13B en el conjunto de datos Dolly:

| Ingresos | Verdad fundamental | Respuesta del modelo no ajustado | Respuesta del modelo ajustado |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:n¿Quién es el próximo entrenador del Fc Bayern München que sustituirá a Julian Nagelsmann?nn### Entrada:nEra Nagelsmann (2021-2023)nBajo el nuevo entrenador Julian Nagelsmann, El Bayern ha completado la hazaña de ganar 10 títulos consecutivos de la Bundesliga tras una victoria por 3-1 en Der Klassiker. Sin embargo, el equipo perdió inesperadamente ante el Villarreal en los cuartos de final de la liga de Campeones, quedando eliminado en esa instancia por segundo año consecutivo. El 24 de marzo de 2023, Nagelsmann fue liberado por el Bayern y reemplazado por Thomas Tuchel, que recibió un contrato hasta el 30 de junio de 2025.nnnn### Respuesta:n | Thomas Tuchel reemplazó a Julian Nagelsmann en marzo de 2023 y ahora es el nuevo entrenador del FC Bayern de Múnich, y anteriormente fue entrenador del Chelsea. | nn“`pythonn{n “instrucción”: “¿Quién es el próximo entrenador del Fc Bayern München que sustituirá a Julian Nagelsmann?”, n “acción”: “próximo entrenador del FC Bayern”, n “contexto”:{n “ Era Nagelsmann (2021-2023)”: n ” Con el nuevo entrenador Julian Nagelsmann, el Bayern ha completado la hazaña de ganar 10 títulos consecutivos de la Bundesliga | El próximo entrenador del Fc Bayern München será Thomas Tuchel. Tuchel sustituirá a Julian Nagelsmann tras la salida de Nagelsmann del equipo el 24 de marzo de 2023.nn |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:nCuénteme sobre la vida de Adolphe Cohnnn### Entrada:nAdolphe Cohn (29 de mayo de 1851–1930) fue un educador franco-estadounidense, nacido en París. Se graduó como “bachelier ès lettres” en la Universidad de París en 1868 y estudió derecho, crítica histórica y filología en varias instituciones de educación superior de París, donde recibió el título de LL.B. en 1873. Alumno de la École des Chartes, su tesis se tituló Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires y obtuvo el diploma de “archivista paléographe”. en 1874. Al comienzo de la guerra franco-prusiana en 1870, se alistó y sirvió en el ejército francés durante toda la lucha. Cohn emigró a la ciudad de Nueva York el 13 de mayo de 1875 y de 1876 a 1884 fue corresponsal estadounidense de La République française, entonces editado por Léon Gambetta, a quien había conocido en Francia y cuyas opiniones políticas había adoptado. En marzo de 1882, Cohn fue nombrado tutor de francés en el Columbia College y poco después nombrado instructor. Por votación popular de los residentes franceses de Nueva York fue elegido para pronunciar la oración fúnebre sobre Gambetta en 1883 en Tammany Hall, y en 1885 fue llamado desde Cambridge, Massachusetts, para un propósito similar, tras la muerte de Victor Hugo. ### Respuesta:n | Adolphe Cohn (29 de mayo de 1851 - 1930) fue un educador franco-estadounidense, nacido en París. Se graduó como "bachiller es lettres" de la Universidad de París en 1868 y estudió derecho, crítica histórica y filología en varias instituciones de educación superior en París, recibiendo los títulos de LL.B. en 1873. Alumno de la École des Chartes, su tesis se tituló Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires y obtuvo el diploma de “archivista paléographe”. en 1874. Al comienzo de la guerra franco-prusiana en 1870, se alistó y sirvió en el ejército francés durante toda la lucha. Cohn emigró a la ciudad de Nueva York el 13 de mayo de 1875 y de 1876 a 1884 fue corresponsal estadounidense de La République française, entonces editado por Léon Gambetta, a quien había conocido en Francia y cuyas opiniones políticas había adoptado. En marzo de 1882, Cohn fue nombrado tutor de francés en el Columbia College y poco después nombrado instructor. Por votación popular de los residentes franceses de Nueva York fue elegido para pronunciar la oración fúnebre sobre Gambetta en 1883 en Tammany Hall, y en 1885 fue llamado desde Cambridge, Massachusetts, para un propósito similar, tras la muerte de Víctor Hugo. | Adolfo Cohn (29 de mayo de 1851-1930) fue un educador franco-estadounidense, nacido en París. Se graduó como “bachelier ès lettres” en la Universidad de París en 1868 y estudió derecho, crítica histórica y filología en varias instituciones de educación superior de París, donde recibió el título de LL.B. en 1873. Un alumno de la É | Adolphe Cohn fue un educador franco-estadounidense que nació en París el 29 de mayo de 1851. Asistió a la Universidad de París y se licenció en derecho en 1873. También trabajó en la École des Chartes y obtuvo su título de “archivista paléographe” en 1874. Al comienzo de la guerra franco-prusiana, se unió al ejército francés y sirvió en él durante todo el año. |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:n¿Cómo ha cambiado el público objetivo de McDonald's con el tiempo?nn### Entrada:nLos restaurantes de comida rápida a menudo dirigen parte de su publicidad directamente a la población joven. Los Happy Meals de McDonald's, que incluyen un juguete que a menudo está relacionado con una película familiar recién estrenada, es un ejemplo significativo. Ronald McDonald, una mascota publicitaria payaso introducida en 1963 y diseñada para atraer a los niños pequeños, es otra. Además, en 1987 McDonald's incorporó un Play Place en sus restaurantes para promocionar aún más a los niños, haciendo de sus restaurantes un entorno más atractivo para los niños. Además, de 1996 a 2006, Disney fue socio exclusivo de McDonald's, vinculando sus productos. Anunciaron el fin de este acuerdo en mayo de 2006, y algunos informes decían que Disney estaba preocupado por la obesidad infantil. Además de Disney, McDonald's también ha estado asociado con Nintendo desde 1985, cuando se presentó por primera vez Nintendo Entertainment System. En 1987, McDonald's también creó un área de juegos de Nintendo en sus restaurantes donde los niños podían jugar en las consolas de Nintendo mientras esperaban su comida. Durante 2007, McDonald's comenzó a ofrecer WiFi desde las consolas de Nintendo; dando a los niños la posibilidad de jugar dondequiera que estuvieran. Al tener también un público objetivo de niños que estrenan estas nuevas películas e incorporan juguetes, utiliza a los niños para llegar al bolsillo de sus padres debido a su gran inversión.nnnn### Respuesta:n | McDonald's siempre ha dirigido su publicidad directamente a la población joven. A partir de 1963, presentaron a Ronald McDonald, una mascota publicitaria payaso diseñada para atraer a los niños pequeños. A lo largo de los años, McDonald's se asoció con múltiples empresas que tienen productos dirigidos a niños, como Nintendo y Disney. | Los restaurantes de comida rápida siempre se han dirigido a la población joven. Las cajitas felices también son un factor importante cuando se trata de publicidad dirigida a los jóvenes. A medida que se estrenan muchas películas, las Cajitas Felices también vienen con un juguete para promocionar esa película en su McDonald's local nn—n## 400-999nn### Comentario:nAs McDonald's, una empresa joven con una visión relativamente estrecha del mundo, no | Desde su lanzamiento, McDonald's ha dirigido su audiencia a niños pequeños y adolescentes con sus restaurantes de comida rápida y productos alimenticios orientados a los niños, así como su publicidad, que se ha dirigido principalmente a los jóvenes. Mientras los padres llevan a los niños a McDonalds, el restaurante es, en esencia, un anuncio de los padres para sus hijos: McDonalds atrae a los niños con sus restaurantes de colores brillantes y los juguetes que se encuentran en la comida y que atraen a los niños. |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:n¿Qué es Anandapuram mandal?nn### Entrada:nAnandapuram mandal es uno de los 46 mandales en el distrito de Visakhapatnam del estado indio de Andhra Pradesh. Está bajo la administración de la división de ingresos de Visakhapatnam y la sede está ubicada en Anandapuram. Anandapuram mandal limita con Bheemunipatnam mandal al este, Chinagadila al sur, Padmanabham al norte y Kothavalasa al oeste.nnnn### Respuesta:n | Anandapuram mandal es uno de los 46 mandals del distrito de Visakhapatnam del estado indio de Andhra Pradesh. Está bajo la administración de la división de ingresos de Visakhapatnam y la sede está ubicada en Anandapuram. | nnnn | Anandapuram mandal es uno de los 46 mandals del distrito de Visakhapatnam del estado indio de Andhra Pradesh. Está bajo la administración de la división de ingresos de Visakhapatnam y la sede está ubicada en Anandapuram. Anandapuram mandal limita con Bheemunipatnam mandal al este, Chinagadila al sur, Padmanabham al norte y Koth. |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:nQué pasó en Woodstocknn### Entrada:nLa Feria de Música y Arte de Woodstock, comúnmente conocida como Woodstock, fue un festival de música que se celebró del 15 al 18 de agosto de 1969, el La granja lechera de Max Yasgur en Bethel, Nueva York, Estados Unidos, a 40 km (65 millas) al suroeste de la ciudad de Woodstock. Anunciado como “una exposición de Acuario: 3 días de paz y música” y también conocido como el Festival de Rock de Woodstock, atrajo a una audiencia de más de 400,000 asistentes. Treinta y dos actos se realizaron al aire libre a pesar de las lluvias esporádicas. Fue uno de los festivales de música más grandes celebrados en la historia. El festival ha pasado a ser ampliamente considerado como un momento crucial en la historia de la música popular, así como un evento decisivo para la generación de la contracultura. La importancia del evento se vio reforzada por un documental de 1970, un álbum de banda sonora que lo acompaña y una canción escrita por Joni Mitchell que se convirtió en un gran éxito tanto para Crosby, Stills, Nash & Young y Matthews Southern Comfort. Se planificaron eventos musicales que llevaban el nombre de Woodstock para los aniversarios, que incluían el décimo, vigésimo, vigésimo quinto, trigésimo, cuadragésimo y quincuagésimo. En 2004, la revista Rolling Stone lo incluyó en el puesto 19 de los 50 momentos que cambiaron la historia del rock and roll. En 2017, el sitio del festival pasó a formar parte del Registro Nacional de Lugares Históricos.nnnn### Respuesta:n | La Feria de Arte y Música de Woodstock, comúnmente conocida como Woodstock, fue un festival de música que se celebró del 15 al 18 de agosto de 1969 en la granja lechera de Max Yasgur en Bethel, Nueva York, Estados Unidos, a 40 millas (65 km) al suroeste de la ciudad. de Woodstock. Anunciado como “una exposición de Acuario: 3 días de paz y música” y también conocido como el Festival de Rock de Woodstock, atrajo a una audiencia de más de 400,000 asistentes. Treinta y dos actos se realizaron al aire libre a pesar de las lluvias esporádicas. Fue uno de los festivales de música más grandes celebrados en la historia. El festival ha sido ampliamente considerado como un momento crucial en la historia de la música popular, así como un evento decisivo para la generación de la contracultura. La importancia del evento se vio reforzada por una película documental de 1970, un álbum de banda sonora que lo acompaña y una canción escrita por Joni Mitchell que se convirtió en un gran éxito tanto para Crosby, Stills, Nash & Young y Matthews Southern Comfort. Se planificaron eventos musicales que llevaban el nombre de Woodstock para los aniversarios, que incluían el décimo, vigésimo, vigésimo quinto, trigésimo, cuadragésimo y quincuagésimo. En 2004, la revista Rolling Stone lo incluyó en el puesto 19 de los 50 momentos que cambiaron la historia del rock and roll. En 2017, el lugar del festival pasó a formar parte del Registro Nacional de Lugares Históricos. | nRespuesta:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## Solución:nn norte Para ver la solución nn“`jsnn// Solución requerida | La Feria de Música y Arte de Woodstock, celebrada a finales del 15 al 18 de agosto, fue un evento histórico en Bethel, Nueva York, por parte de la generación de la contracultura. La multitud en el festival fue de más de 400,000 personas. Alrededor de 32 actos se realizaron al aire libre a pesar de lluvias esporádicas. Fue considerado como uno de los festivales de música más grandes que jamás se haya celebrado en la historia. |

- Resultados del ajuste del modelo de generación de texto Llama 2 70B en el conjunto de datos Dolly:

| Ingresos | Verdad fundamental | Respuesta del modelo no ajustado | Respuesta del modelo ajustado |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:nQuién es la empresa ABBnn### Entrada:nABB Ltd. es una corporación multinacional sueco-suiza con sede en Zúrich, Suiza. La empresa se formó en 1988 cuando la sueca Allmänna Svenska Elektriska Aktiebolaget (ASEA) y la suiza Brown, Boveri & Cie se fusionaron para crear ASEA Brown Boveri, más tarde simplificada a las iniciales ABB. Ambas empresas se fundaron a finales del siglo XIX y eran importantes fabricantes de equipos eléctricos, un negocio en el que ABB sigue activa en la actualidad. Desde entonces, la empresa también se ha expandido a la robótica y la tecnología de automatización.nnnn### Respuesta:n | ABB Ltd. es una corporación multinacional sueco-suiza con sede en Zúrich, Suiza. La empresa se formó en 1988 cuando la sueca Allmanna Svenska Elektriska Aktiebolaget (ASEA) y la suiza Brown, Boveri & Cie se fusionaron para crear ASEA Brown Boveri, más tarde simplificada a las iniciales ABB. Ambas empresas se fundaron a finales del siglo XIX y eran importantes fabricantes de equipos eléctricos, un negocio en el que ABB sigue activa en la actualidad. Desde entonces, la empresa también se ha expandido a la robótica y la tecnología de automatización. | * ABB es una corporación multinacional sueco-suizann### LognEND I/O DATA —n | ABB es una corporación multinacional sueco-suiza con sede en Zúrich, Suiza. La empresa se formó en 1988 cuando la sueca Allmänna Svenska Elektriska Aktiebolaget (ASEA) y la suiza Brown, Boveri & Cie se fusionaron para crear ASEA Brown Boveri, más tarde simplificada a las iniciales ABB. Ambas empresas se establecieron a finales del siglo XIX y fueron |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:n¿Por qué un Guillermo el Conquistador, un francés, se convirtió en rey de Inglaterra?nn### Entrada:nEn la década de 1050 y principios de la de 1060, Guillermo se convirtió en un contendiente para el trono. trono de Inglaterra en poder de Eduardo el Confesor, sin hijos, su primo hermano una vez destituido. Había otros pretendientes potenciales, incluido el poderoso conde inglés Harold Godwinson, a quien Eduardo nombró rey en su lecho de muerte en enero de 1066. Argumentando que Eduardo le había prometido previamente el trono y que Harold había jurado apoyar su reclamo, Guillermo construyó una gran flota e invadió Inglaterra en septiembre de 1066. Derrotó y mató decisivamente a Harold en la batalla de Hastings el 14 de octubre de 1066. Después de nuevos esfuerzos militares, William fue coronado rey el día de Navidad de 1066, en Londres. Hizo arreglos para el gobierno de Inglaterra a principios de 1067 antes de regresar a Normandía. Siguieron varias rebeliones fallidas, pero el dominio de Guillermo estaba prácticamente seguro en Inglaterra en 1075, lo que le permitió pasar la mayor parte de su reinado en Europa continental.nnnn### Respuesta:n | Guillermo el Conquistador era de Normandía, situada en el noroeste de Francia. El rey de Inglaterra a finales de la década de 1050 y principios de la de 1060 era Eduardo el Confesor. Edward era primo de William. Como Eduardo no tenía hijos, hubo varias personas que afirmaron que eran los herederos legítimos y que debían convertirse en rey. Estas afirmaciones contradictorias dieron lugar a un conflicto armado. William invadió Inglaterra, donde ganó la batalla de Hastings, derrotando al conde Harold Godwinson. Siguieron varias batallas, pero William se convirtió en rey de Inglaterra a finales de 1066. Se enfrentó a múltiples rebeliones durante la siguiente década, pero conservó su poder. Finalmente pudo regresar a Normandía y gobernar Inglaterra desde allí. | Guillermo el Conquistador se convirtió en rey de Inglaterra, ya que en la década de 1050 y principios de la de 1060 se convirtió en un aspirante al trono de Inglaterra en manos de Eduardo el Confesor, que no tenía hijos, su primo hermano una vez destituido. La respuesta puede estar vacía, pero debe contener 256 caracteres. norte | Después de la muerte del rey Harold en la batalla de Hastings el 14 de octubre de 1066, Guillermo el Conquistador fue coronado rey de Inglaterra el día de Navidad de 1066, estableciendo la conquista normanda de Inglaterra. |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:nHábleme sobre el RMS Adriaticnn### Entrada:nRMS Adriatic era un transatlántico británico de la White Star Line. Era el cuarto de un cuarteto de barcos de más de 20,000 TRB, denominados Los Cuatro Grandes. El barco fue el único de los cuatro que nunca fue el barco más grande del mundo. Sin embargo, era el más grande, el más rápido y el más lujoso de los Cuatro Grandes, siendo el primer transatlántico en tener una piscina cubierta y un baño turco. Comenzó su carrera en la nueva ruta de Southampton a Nueva York antes uniéndose, a partir de 1911, a sus barcos hermanos en la ruta secundaria desde Liverpool. En realidad, se trataba de líneas lentas destinadas a prestar un servicio a precios moderados. Cuando estalló la Primera Guerra Mundial, el Adriatic fue uno de los barcos que continuaron su servicio civil transatlántico, mientras transportaban muchas provisiones. En 1917, fue requisado y sirvió como transporte de tropas. Después de la guerra, fue reacondicionado varias veces y gradualmente fue utilizado para cruceros, que se convirtieron en sus principales servicios en la década de 1930. Cuando Cunard Line y White Star Line se fusionaron en 1934, rápidamente se consideró innecesario y se vendió a finales de año. Fue desguazada en Osaka en 1935.nnnn### Respuesta:n | El RMS Adriatic era un transatlántico británico de la White Star Line. Era el cuarto de un cuarteto de barcos de más de 20,000 TRB, denominados Los Cuatro Grandes. El barco fue el único de los cuatro que nunca fue el barco más grande del mundo. Sin embargo, era el más grande, el más rápido y el más lujoso de los Cuatro Grandes, siendo el primer transatlántico en tener una piscina cubierta y un baño turco. | RMS Adriatic era un transatlántico británico de la White Star Line. Era el cuarto de un cuarteto de barcos de más de 20,000 TRB, denominados Los Cuatro Grandes. El barco fue el único de los cuatro que nunca fue el barco más grande del mundo. nn### ContextnUna pregunta de este tipo se utiliza comúnmente para consultar un motor de búsqueda. La entrada es una entrada de la consulta y la respuesta es la pública. | El RMS Adriatic era un transatlántico británico de la White Star Line. Fue botado en 1906, pero su primera navegación comercial fue en 1907. Fue el cuarto de un cuarteto de barcos de más de 20,000 toneladas y fue apodado los Cuatro Grandes. Los otros tres fueron el RMS Celtic en 1901, el RMS Baltic en 1903 y el R. |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:n¿Cuál es el CGRO que detecta fotones?nn### Entrada:nEl Observatorio Compton de Rayos Gamma (CGRO) era un observatorio espacial que detectaba fotones con energías de 20 keV a 30 GeV, en órbita terrestre de 1991 a 2000. El observatorio contaba con cuatro telescopios principales en una nave espacial, que cubrían rayos X y rayos gamma, incluidos varios subinstrumentos y detectores especializados. Después de 14 años de esfuerzo, el observatorio fue lanzado desde el transbordador espacial Atlantis durante la misión STS-37 el 5 de abril de 1991 y estuvo en funcionamiento hasta su salida de órbita el 4 de junio de 2000. Fue desplegado en órbita terrestre baja a 450 km (280 millas) para Evite el cinturón de radiación de Van Allen. Fue la carga útil astrofísica más pesada jamás volada en ese momento con 17,000 kilogramos (37,000 lb).nnnn### Respuesta:n | El CGRO es el Observatorio Compton de Rayos Gamma (CGRO) y fue un observatorio espacial que detectó fotones con energías de 20 keV a 30 GeV en la Tierra desde 1991 hasta 2000. | **Transcriptor:** El instrumento EGRET detecta fotones.nn | El Observatorio Compton de Rayos Gamma (CGRO) mide fotones con energías de 20 keV a 30 GeV.nn |

| A continuación se muestra una instrucción que describe una tarea, junto con una entrada que proporciona más contexto. Escriba una respuesta que complete adecuadamente la solicitud.nn### Instrucción:nQué tan bueno como pianista es Yeol Eum Sonnnn### Entrada:nYeol Eum Son (nacido el 2 de mayo de 1986 en Wonju, Corea del Sur) es un clásico surcoreano pianista. Llamó la atención internacional por primera vez en octubre de 2004, a los 18 años, cuando apareció como solista interpretando el Concierto para piano n.° 1 de Liszt con la Filarmónica de Nueva York bajo la batuta de Lorin Maazel en su gira asiática en Seúl, Daejeon y Tokio. Son volvió a actuar con Maazel y la Filarmónica de Nueva York cuando regresaron al Centro de Artes de Seúl en febrero de 2008, esta vez como solista del Concierto para piano n.° 2 de Beethoven. Sus premios incluyen medallas de plata en el Decimotercer Concurso Internacional de Piano Van Cliburn (2009). ) y el Concurso Internacional Tchaikovsky 2011, donde también recibió los premios a la Mejor Interpretación de Concierto de Cámara y a la Mejor Interpretación de la Obra Por Encargo. También ganó la Medalla de Bronce en el Concurso Internacional de Maestros de Piano Arthur Rubinstein (2005) nnnn### Respuesta:n | Yeol Eum Son (nacido el 2 de mayo de 1986 en Wonju, Corea del Sur) es un pianista clásico de Corea del Sur. Llamó la atención internacional por primera vez en octubre de 2004, a los 18 años, cuando apareció como solista interpretando el Concierto para piano n.° 1 de Liszt con la Filarmónica de Nueva York bajo la batuta de Lorin Maazel en su gira asiática en Seúl, Daejeon y Tokio. Son volvió a actuar con Maazel y la Filarmónica de Nueva York cuando regresaron al Centro de Artes de Seúl en febrero de 2008, esta vez como solista del Concierto para piano n.° 2 de Beethoven. Sus premios incluyen medallas de plata en el Decimotercer Concurso Internacional de Piano Van Cliburn (2009). ) y el Concurso Internacional Tchaikovsky 2011, donde también recibió los premios a la Mejor Interpretación de Concierto de Cámara y a la Mejor Interpretación de la Obra Por Encargo. También ganó la Medalla de Bronce en el Concurso Internacional de Maestros de Piano Arthur Rubinstein (2005). | Yeol Eum Son es un pianista consumado que ha actuado con algunas de las orquestas más prestigiosas del mundo. En 2009, ganó la plata en el Decimotercer Concurso Internacional de Piano Van Cliburn y en 2005 ganó el bronce en el Concurso Internacional de Maestros de Piano Arthur Rubinstein. Continúa actuando con gran éxito en todo el mundo. | Yeol Eum Son es un muy buen pianista. Comenzó su carrera internacional uniéndose a algunos de los mejores músicos del mundo a los 18 años. Y ya era medallista de plata en dos concursos internacionales cuando cumplió 25.nn |

- Resultados para ajustar el modelo de generación de texto Llama 2 7B en el conjunto de datos Dialogsum:

| Ingresos | Verdad fundamental | Respuesta del modelo no ajustado | Respuesta del modelo ajustado |

| Resuma este diálogo: n#Persona1#: ¡Esta es una comida excelente! n#Persona2#: Gracias. Me alegro de que todo haya salido tan bien.n#Person1#: ¿Quién te enseñó a cocinar tan bien? n#Person2#: Tomé una clase de cocina en el Instituto Culinario.n#Person1#: Vaya, ¿qué hay en esto? plato de pollo?n#Persona2#: ¿No es genial? Eso es pollo con coco y jengibre con arroz.n#Person1#: ¿La sopa es una sopa de camarones? n#Person2#: Sí, hay camarones junto con vegetales marinos y hierba de limón.n#Person1#: Creo que tuve suerte al elegir un vino que combine con esta comida.n#Persona2#: Te agradezco que hayas traído el vino. Va bien con el pollo.n—nResumen:nnn### Respuesta:n | #Persona1# piensa que la comida preparada por #Persona2# es excelente. #Persona2# presenta los ingredientes de los platos. | Una vez completado el diálogo, la persona proporcionará una respuesta adecuada a la información recopilada. Por ejemplo, la persona 1 puede decir: nn#Persona1#: ¡Esto es genial! Gracias.nn#Persona2#: De nada. Pensé que te gustaría tu comida. Me alegra que lo hayas disfrutado.nn—n— — — — –nnn### Resumen:nnn### Respuesta:nDespués del diálogo | #Persona1# y #Persona2# comen en casa de #Persona2#. Hablan de la comida y el vino que combinan con el pollo. |

| Resuma este diálogo: n#Persona1#: Disculpe, estoy escribiendo un ensayo sobre la antigua Grecia. ¿Hay algún libro sobre este tema que puedas recomendar? n#Persona2#: ¿Gansos? ¿Quieres escribir sobre gansos antiguos? Nunca había oído hablar de tal cosa. De todos modos, sería con un libro de algunos animales, esa es la fila J. ¿O quieres probar la ciencia, que está en la fila Gn#Persona1#: Animales? Pero Grecia es un país, no un animal.n#Person2#: Oh, Grecia. Bueno, ya sabes, hoy debe ser tu día de suerte. Acabamos de recibir una nueva colección de libros sobre ese mismo tema. Hay escritores aquí en la fila Cn#Persona1#: Ya veo. Son muchos libros, ¿cuál sugieres? n#Persona2#: Bueno, el de Robin Smith es excelente pero es muy largo. Es el que tiene la estatua en la portada. También hay uno de Milton Pike. Tiene una pintura de un soldado en el frente. Como puedes ver, no es muy grueso, por lo que no debería tomar mucho tiempo leerlo. Pero probablemente el mejor libro sea el que tiene una imagen del antiguo Estadio Olímpico. Ha ganado varios premios por obras de historia.n#Persona1#: Bueno, es difícil decidirse, pero me temo que no tengo suficiente tiempo para leer mucho. Creo que compraré el libro de Milton Pike.n#Person2#: Está bien. ¿Podría darme su tarjeta de la biblioteca, por favor? n#Persona1#: Claro, aquí está.n—nResumen:nnn### Respuesta:n | #Persona1# le pide a #Persona2# que le recomiende algunos libros sobre la antigua Grecia. #Person2# sugiere el de Robin Smith que es muy largo, el de Milton Pike que no es muy grueso y el que gana varios premios por obras de historia. Como #Persona1# no tiene suficiente tiempo, #Persona1# conseguirá el libro de Milton Pike. | n—nnResumen:n | #Persona1# está escribiendo un ensayo sobre la antigua Grecia. #Persona2# recomienda a #Persona1# los libros sobre la antigua Grecia que acaban de recibir y sugiere adquirir el libro de Milton Pike.nn |

| Resume este diálogo: n#Persona1#: Bueno, veo que tienes tus libros, George. ¿Pero estás leyendo? Parece que solo estás coloreando.n#Persona2#: Estoy marcando las partes importantes del libro. Los colores son para diferentes cosas.n#Person1#: ¿Cómo qué? n#Person2#: Las ideas principales son el amarillo. Los detalles importantes para recordar son el rosa y el verde claro es para ideas difíciles. n#Persona1#: Parecen muchas actividades. ¿No estás perdiendo el tiempo? n#Persona2#: No lo creo, mamá. Lo leeré todo esta noche. Lo escucharé mañana. Y luego, cuando llegue el momento de estudiar, ya sabré la mayor parte de la información.n#Persona1#: En mi época, simplemente leíamos el libro y tratábamos de recordar la información.n#Persona2#: El maestro nos dijo la importancia de lectura activa. Y es la mejor manera de aprender a cualquier velocidad que elijas.n#Persona1#: Ya veo. ¿Y para qué sirve este cuaderno? n#Persona2#: Es para tomar notas. ¿Qué tipo de cosas escribes? n#Persona1#: A veces escribo un resumen. En esta página escribo preguntas. Y por supuesto tengo otra página donde anoto las nuevas palabras.n—nResumen:nnn### Respuesta:n | George le dice a su madre que marcar las partes importantes del libro con diferentes colores es su forma de aprender. También toma notas en el cuaderno y en ocasiones escribe un resumen. | #Persona1#: ¡Ohhh! Lectura activa, preguntas de lectura, notas de vocabulario, resúmenes y resaltado. Ahora puedo ver la diferencia que tienes cuando se trata de aprender información. Estoy impresionado.n#Persona2#: Gracias. La lectura es la mejor manera de aprender y recordar nueva información. ¿Estás usando la lectura activa en este momento? n#Person1#: Hmmm... Tendré que pensar en eso.nnn#Person | George describe las actividades que realiza para leer sus libros rápidamente. George le muestra el cuaderno a mamá y le explica cómo tomar notas. |

| Resuma este diálogo:n#Persona1#: Buenos días, señor. ¿Puedo ver su pasaporte? n#Persona2#: Sí, por supuesto. Aquí está.n#Persona1#: Gracias. ¿Todos estos son tuyos? n#Persona2#: No, algunos de ellos son de mi amigo. ¿Quieres su pasaporte también? n#Persona1#: Sí, por favor. ¿Tienes algún artículo de mano? n#Person2#: ¿Quieres que también lo ponga en el cinturón? n#Person1#: Sí, por favor. ¿Podrías abrir esta maleta grande? n#Persona2#: Está bien. Sólo un momento. Son solo algo de ropa y artículos de tocador.n#Persona1#: Está bien. ¿Tienes algo que declarar?n#Person2#: Creo que no hay nada.n#Person1#: ¿Algún alimento fresco, plantas vivas o animales?n#Person2#: Oh, no. Nada de eso.n#Persona1#: Gracias. Puede cerrar su maleta con llave. Aquí están sus pasaportes.n#Persona2#: Muchas gracias.n—nResumen:nnn### Respuesta:n | #Persona1# ve el pasaporte de los amigos de #Persona2# y #Persona2# y revisa su equipaje. #Persona2# le dice a #Persona1# que no tiene nada que declarar. #Persona1# los deja ir. | > Creo que no hay nada.nnn—n**Categorías:**nn- [Conversación (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Clave:nn :information_source: 31 (TSA)n:information_source: 32 (TSA)nn—-n* Cualquier copyright | El funcionario de inmigración le pide a #Persona2# que muestre su pasaporte y abra su maleta grande. #Persona2# no tiene nada que declarar y puede cerrar su maleta con llave.nn |

| Resuma este diálogo:n#Persona1#: El té chino es famoso en todo el mundo. Quiero comprar varias cajas.n#Persona2#: Hay varios tipos de té en China. Depende del sabor y el efecto.n#Person1#: Bueno, no sé nada de té chino.n#Person2#: Este es té verde, puedes beberlo en verano. Puede aliviar el calor del verano y es bueno para mantener los pulmones.n#Persona1#: Suena interesante. ¿Qué pasa con esto?n#Person2#: Es té negro, tiene un sabor fuerte y favorece la digestión.n#Person1#: ¿Qué es esto? Huele fragante.n#Persona2#: Es té de jazmín de alta calidad. Es fragante y tiene un sabor agradable.n#Persona1#: Tomaré el té de jazmín. ¿Podrías empacarlo con papel de regalo y cinta? Es un regalo para mi amigo.n#Persona2#: No hay problema. Espere un momento.n—nResumen:nnn### Respuesta:n | #Persona2# recomienda té verde, té negro y té de jazmín a #Persona1# que quiere comprar té chino y #Persona1# decide tomar el té de jazmín. | #[English]#: El té chino es famoso en todo el mundo. Quiero comprar varias cajas.n#[francés]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[Español]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[Alemán]#: Ich mö | #Persona1# quiere comprar varias cajas de té chino, con diferentes tipos de té. #Persona2# ayuda a #Persona1# a seleccionar y empacará todo.nn |

- Resultados del ajuste del modelo Llama-2 13B en el conjunto de datos Dialogsum:

| Ingresos | Verdad fundamental | Respuesta del modelo no ajustado | Respuesta del modelo ajustado |

| Resuma este diálogo:n#Person1#: La Sra. Thompson alguna vez fue diteísta, Jason.n#Person2#: ¿Por qué? ¿No deberíamos estar en problemas ni nada por el estilo? De hecho, estuvimos muy activos durante toda la discusión en clase esta mañana.n#Persona1#: Eso es todo. No creo que sea nada malo. Creo que nos va a pedir que nos postulemos para monitor de clase.n#Persona2#: ¡Vaya! ¿En realidad? Eso es mucha responsabilidad.n#Persona1#: Bueno, creo que serías genial en eso. Además, es un gran honor que me lo pidan. Significa que la Sra. Thompson nos ve como líderes.n#Persona2#: Sin embargo, no estoy seguro de poder hacerlo solo. ¿Podríamos hacerlo juntos? n#Persona1#: Preguntémosle a la Sra. Thompson. Ahora la escucho entrar desde el pasillo.n—nResumen:nnn### Respuesta:n | #Persona1# le dice a Jason que la Sra. Thompson era diteísta y #Persona1# adivina que quiere que se postulen para monitores de clase. Le preguntarán a la Sra. Thompson si pueden hacer esto juntos. | n* Cuando el maestro preguntó a Jason y a su compañero de clase si querían postularse para monitor de clase, él y su compañero de clase lo acordaron juntos. Ambos niños son cristianos, pero no son amigos en clase.n* Su fe en Jesús puede no ser compartida públicamente, pero es evidente a través de la oración y el ejemplo que siguen juntos para ayudar a los demás y mostrar amor.nn—n## 1654nn **[Situación:** Los estudiantes están hablando sobre el reciente | La señora Thompson les pide a Jason y James que se postulen para ser monitor de clase porque cree que son líderes. |

| Resuma este diálogo: n#Person1#: Oye, detengámonos y miremos esa casa de allí. n#Person2#: Sí, ¡se ve genial! ¿Está en nuestra lista de puertas abiertas? n#Person1#: Sí, está en nuestra lista. n#Person2#: Bueno, se ve fantástico desde la acera. Sigamos adentro.n#Persona1#: Firmemos el registro. El agente inmobiliario parece algo ocupado en este momento. n#Person2#: Bueno, ahora vamos a ver la cocina. n#Person1#: Oh, mira, tienen algunos refrigerios aquí. n#Person2#: Asegúrate de recoger un volante con los datos de la vivienda.n#Person1#: ¿Dice cuánto piden por esta casa? n#Person2#: Sí, parece que la han rebajado de doscientos treinta y cinco mil a doscientos y veinticinco mil—nResumen:nnn### Respuesta:n | #Persona1# y #Persona2# vienen a ver una casa. Miran el interior y hablan de su precio. | Esta es una respuesta AMI al siguiente estímulo. Persona 2: ¡Sí, se ve genial! ¿Está en nuestra lista de puertas abiertas? Sí, está en nuestra lista. Bueno, se ve muy bien desde la acera. Entremos. Firmemos el registro. El agente inmobiliario parece algo ocupado en este momento. Está bien, ahora vayamos a ver la cocina. Oh, mira, tienen algunas cosas. | #Persona1# y #Persona2# están buscando una casa que está en su lista de puertas abiertas. Firman un registro y #Persona2# le dice a #Persona1# que lleve un volante con la información. |

| Resuma este diálogo: n#Persona1#: ¿Cómo está, Sr. Wilson? Soy Tina.n#Person2#: Encantada de conocerla, señora Tina.n#Person1#: Por favor, tome asiento. Sé que nuestro empleado de fuerza ya le ha brindado la información sobre su contrato de empleado, pero me gustaría repasar los detalles principales nuevamente antes de firmar. Primero, recibirás un salario mensual, con un mes de vacaciones pagadas después de un año de servicio.n#Person2#: Eso es lo que entiendo.n#Person1#: Estarás cubierto por nuestro plan médico mientras estés de servicio. Dado que será un mando intermedio, se espera que esté disponible hasta 1 horas más allá del horario laboral normal. Cualquier tiempo aprobado que exceda se pagará a tiempo y medio, que podrá tomar como salario o tiempo libre. n#Person5#: Exactamente según tengo entendido. n#Person2#: La empresa cubrirá un número razonable de días de enfermedad . Cualquier enfermedad prolongada estará cubierta por el seguro. ¿Ha leído los demás términos del contrato? n#Person1#: Sí, lo he hecho. n#Person2#: ¿Tiene alguna otra pregunta? n#Person1#: Solo una. Noté un artículo sobre el horario flexible. ¿Es esa una posibilidad para mí? n#Person2#: Sí, lo es, pero tendrás que discutir los detalles con tu gerente. n#Person1#: Eso es aceptable.n#Person2#: Bien. Ahora, si firma aquí, podrá comenzar a trabajar en 1 días.n—nResumen:nnn### Respuesta:n | El señor Wilson le describe a Tina la información elemental sobre el contrato de trabajo. Menciona salario mensual, un mes de vacaciones pagadas, planes médicos, jornada laboral ampliada y horario flexible. | No, los resúmenes no están bien. Los diálogos #Persona1 no dicen que el nombre es Tina, no se presentan. Creo que ambos saben el nombre del otro, así que eso es innecesario. Creo que si todo lo demás está bien, el Resumen no cambiará, a menos que #Persona1 termine, y eso está bien. | Tina se reúne con el Sr. Wilson para repasar los detalles principales del contrato de empleado de Tina. Los dos discuten el salario mensual y el plan médico. Tina no tiene preguntas y empezará a trabajar en 3 días.nn |

| Resume este diálogo: n#Person1#: Jack, ¿cuál es tu tema favorito? n#Person2#: ¿Mi tema favorito? Bueno, creo que prefiero la ciencia. Sí, la ciencia, me parece muy interesante. El profesor de ciencias hace que la materia sea muy apasionante. ¿Y tú? n#Persona1#: Siempre me va muy bien en los exámenes de matemáticas. También me gusta la geografía. Me gusta aprender sobre las personas y los lugares donde viven. ¿Hay alguna materia que no te guste, Jack? n#Persona2#: No me gusta mucho la física. No es fácil de entender, la mayoría de los niños se aburren con ello.n—nResumen:nnn### Respuesta:n | La materia favorita de Jack es la ciencia, aunque no le gusta mucho la física. A #Persona1# le gustan las matemáticas y la geografía. | n—nn### La palabra: “favorito” (adj)nnSignificado: Amado, apreciado por la mayoría de los demás nEjemplos: Mi libro favorito es la Biblia; ¿Cuál es tu deporte favorito?; Mi color favorito es el azul.nn—nnnn### ¿Cuál es tu tema ____? (formal)nnDiálogo de preguntas y respuestas:nn#Persona1#: ¿Cuál es tu materia favorita?n# | Jack y Jack están hablando de sus temas favoritos y de los que menos les gustan. |

| Resume este diálogo: n#Persona1#: Hola, Maggie. Vi tu pintura en la exposición de arte de fin de año de la escuela a la que asistieron todos los padres. Fue genial.n#Person2#: Bueno, nuestro profesor de arte parecía muy satisfecho con esto, pero no estoy seguro de qué pensaron los padres.n#Person1#: Oh, no te preocupes. Solo los escuché decir cosas buenas al respecto.n#Person2#: Hmm… Probablemente no se dio cuenta de que no había usado los colores correctos.n#Person1#: No creo que nadie se diera cuenta.n#Person2# : No, pero lo hice. Pero ya era demasiado tarde para hacer algo al respecto. Bueno, la próxima vez espero hacer algo mejor.n—nResumen:nnn### Respuesta:n | #Persona1# vio el cuadro de Maggie y piensa que era genial, pero a Maggie le preocupa no haber usado los colores correctos y espera hacer algo mejor la próxima vez. | Este resumen debe resaltar los puntos clave y las conclusiones de la discusión.nn# Responder a la Persona1:n[Resumen de respuesta]nn—n### Respuesta:nEste resumen debe resaltar los puntos clave y las conclusiones de la discusión.nn# Responder a la Persona2 :n[Resumen de respuesta]nn### Persona1:n[Resumen de Persona1]n—n### Persona2:n[Resumen de Persona2]nn### Personan—n | #Persona1# vio el cuadro de Maggie y le dijo que muchos padres decían cosas maravillosas sobre el cuadro de Maggie. Maggie no lo cree así. |

- Resultados del ajuste del modelo Llama 2 70B en el conjunto de datos Dialogsum: