Whisper es un modelo de reconocimiento automático de voz (ASR) que se ha entrenado utilizando 680,000 horas de datos supervisados de la web, que abarcan una variedad de idiomas y tareas. Una de sus limitaciones es el bajo rendimiento en idiomas de bajos recursos, como el idioma marathi y los idiomas dravídicos, que se puede remediar con ajustes. Sin embargo, ajustar un modelo de Whisper se ha convertido en un desafío considerable, tanto en términos de recursos computacionales como de requisitos de almacenamiento. De cinco a diez ejecuciones de ajuste completo para los modelos Whisper requieren aproximadamente 100 horas de GPU A100 (40 GB SXM4) (varía según los tamaños y parámetros del modelo), y cada punto de control ajustado requiere alrededor de 7 GB de espacio de almacenamiento. Esta combinación de altas demandas computacionales y de almacenamiento puede plantear obstáculos importantes, especialmente en entornos con recursos limitados, lo que a menudo hace que sea excepcionalmente difícil lograr resultados significativos.

Adaptación de bajo rango, también conocida como lora, adopta un enfoque único para el ajuste del modelo. Mantiene los pesos del modelo previamente entrenado en un estado estático e introduce matrices de descomposición de rangos entrenables en cada capa de la estructura del Transformador. Este método puede disminuir 10,000 veces la cantidad de parámetros entrenables necesarios para tareas posteriores y reducir el requisito de memoria de la GPU 3 veces. En términos de calidad del modelo, se ha demostrado que LoRA iguala o incluso supera el rendimiento de los métodos de ajuste fino tradicionales, a pesar de operar con menos parámetros entrenables (consulte los resultados del estudio original). papel LoRA). También ofrece el beneficio de un mayor rendimiento de la capacitación. A diferencia del adaptador métodos, LoRA no introduce latencia adicional durante la inferencia, manteniendo así la eficiencia del modelo durante la fase de implementación. El ajuste fino de Whisper utilizando LoRA ha mostrado resultados prometedores. Tomemos como ejemplo Whisper-Large-v2: ejecutar 3 épocas con un conjunto de datos de voz común de 12 horas en una GPU de 8 GB de memoria tarda entre 6 y 8 horas, que es 5 veces más rápido que el ajuste completo con un rendimiento comparable.

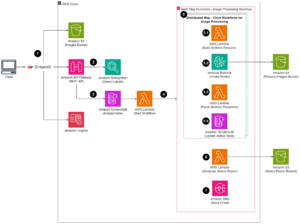

Amazon SageMaker es una plataforma ideal para implementar el ajuste LoRA de Whisper. Amazon SageMaker le permite crear, entrenar e implementar modelos de aprendizaje automático para cualquier caso de uso con infraestructura, herramientas y flujos de trabajo totalmente administrados. Los beneficios adicionales de la capacitación de modelos pueden incluir menores costos de capacitación con Managed Spot Training, bibliotecas de capacitación distribuidas para dividir modelos y conjuntos de datos de capacitación en instancias de GPU de AWS, y más, . Los modelos entrenados de SageMaker se pueden implementar fácilmente para realizar inferencias directamente en SageMaker. En esta publicación, presentamos una guía paso a paso para implementar el ajuste fino de LoRA en SageMaker. El código fuente asociado con esta implementación se puede encontrar en GitHub.

Prepare el conjunto de datos para realizar ajustes

Usamos el idioma marathi, de bajos recursos, para la tarea de ajuste. Utilizando el Conjuntos de datos de caras abrazadas biblioteca, puede descargar y dividir el conjunto de datos de Common Voice en conjuntos de datos de entrenamiento y prueba. Vea el siguiente código:

El modelo de reconocimiento de voz Whisper requiere que las entradas de audio sean Archivos WAV enteros con signo de 16 bits mono de 16 kHz. Debido a que el conjunto de datos de Common Voice tiene una frecuencia de muestreo de 48K, primero deberá reducir la resolución de los archivos de audio. Luego, debe aplicar el extractor de funciones de Whisper al audio para extraer las funciones del espectrograma log-mel y aplicar el tokenizador de Whisper a las funciones enmarcadas para convertir cada oración de la transcripción en una identificación simbólica. Vea el siguiente código:

Después de haber procesado todas las muestras de entrenamiento, cargue los datos procesados en Amazon S3, de modo que cuando utilice los datos de entrenamiento procesados en la etapa de ajuste fino, pueda usar Archivo rápido para montar el archivo S3 directamente en lugar de copiarlo al disco local:

Entrenar a la modelo

Para la demostración, utilizamos Whisper-large-v2 como modelo previamente entrenado (whisper v3 ya está disponible), que se puede importar a través de la biblioteca de transformadores Hugging Face. Puedes usar Cuantificación de 8 bit para mejorar aún más la eficiencia de la formación. La cuantificación de 8 bits ofrece optimización de la memoria redondeando desde punto flotante a enteros de 8 bits. Es una técnica de compresión de modelos comúnmente utilizada para ahorrar memoria reducida sin sacrificar demasiado la precisión durante la inferencia.

Para cargar el modelo previamente entrenado en formato cuantificado de 8 bits, simplemente agregamos el argumento load_in_8bit=True al crear una instancia del modelo, como se muestra en el siguiente código. Esto cargará los pesos del modelo cuantificados a 8 bits, lo que reducirá la huella de memoria.

Usamos la implementación LoRA de Hugging Face's peft paquete. Hay cuatro pasos para ajustar un modelo usando LoRA:

- Cree una instancia de un modelo base (como hicimos en el último paso).

- Crear una configuración (

LoraConfig) donde se definen los parámetros específicos de LoRA. - Envuelva el modelo base con

get_peft_model()para conseguir un entrenablePeftModel. - Entrena al

PeftModelcomo modelo base.

Ver el siguiente código:

Para ejecutar un Entrenamiento de SageMaker trabajo, traemos nuestro propio contenedor Docker. Puede descargar la imagen de Docker desde GitHub, donde ffmpeg4 y git-lfs se empaquetan junto con otros requisitos de Python. Para obtener más información sobre cómo adaptar su propio contenedor Docker para que funcione con SageMaker, consulte Adaptando tu propio contenedor de entrenamiento. Luego puede utilizar Hugging Face Estimator y comenzar un trabajo de capacitación en SageMaker:

La implementación de LoRA nos permitió ejecutar la gran tarea de ajuste fino de Whisper en una sola instancia de GPU (por ejemplo, ml.g5.2xlarge). En comparación, la gran tarea de ajuste completo de Whisper requiere múltiples GPU (por ejemplo, ml.p4d.24xlarge) y un tiempo de entrenamiento mucho más largo. Más específicamente, nuestro experimento demostró que la tarea de ajuste completo requiere 24 veces más horas de GPU en comparación con el enfoque LoRA.

Evaluar el rendimiento del modelo

Para evaluar el rendimiento del modelo Whisper ajustado, calculamos la tasa de error de palabras (WER) en un conjunto de pruebas retenido. WER mide la diferencia entre la transcripción predicha y la transcripción real. Un WER más bajo indica un mejor rendimiento. Puede ejecutar el siguiente script en el modelo previamente entrenado y el modelo ajustado y comparar su diferencia de WER:

Conclusión

En esta publicación, demostramos cómo ajustar Whisper, un modelo de reconocimiento de voz de última generación. En particular, utilizamos PEFT LoRA de Hugging Face y habilitamos la cuantificación de 8 bits para un entrenamiento eficiente. También demostramos cómo ejecutar el trabajo de capacitación en SageMaker.

Aunque este es un primer paso importante, hay varias maneras de aprovechar este trabajo para mejorar aún más el modelo de susurro. En el futuro, considere utilizar la capacitación distribuida de SageMaker para escalar la capacitación en un conjunto de datos mucho más grande. Esto permitirá que el modelo se entrene con datos más variados y completos, mejorando la precisión. También puede optimizar la latencia al servir el modelo Whisper para permitir el reconocimiento de voz en tiempo real. Además, podría ampliar el trabajo para manejar transcripciones de audio más largas, lo que requiere cambios en la arquitectura del modelo y los esquemas de capacitación.

Aceptación

Los autores extienden su agradecimiento a Paras Mehra, John Sol y Evandro Franco por sus valiosos comentarios y revisión de la publicación.

Acerca de los autores

junio shi es arquitecto senior de soluciones en Amazon Web Services (AWS). Sus áreas de enfoque actuales son la infraestructura y las aplicaciones de AI/ML. Tiene más de una década de experiencia en la industria FinTech como ingeniero de software.

junio shi es arquitecto senior de soluciones en Amazon Web Services (AWS). Sus áreas de enfoque actuales son la infraestructura y las aplicaciones de AI/ML. Tiene más de una década de experiencia en la industria FinTech como ingeniero de software.

El Dr. Changsha Ma es especialista en IA/ML en AWS. Es tecnóloga con un doctorado en Ciencias de la Computación, una maestría en Psicología de la Educación y años de experiencia en ciencia de datos y consultoría independiente en AI/ML. Le apasiona investigar enfoques metodológicos para la inteligencia humana y de máquinas. Fuera del trabajo, le encanta hacer senderismo, cocinar, cazar y pasar tiempo con amigos y familiares.

El Dr. Changsha Ma es especialista en IA/ML en AWS. Es tecnóloga con un doctorado en Ciencias de la Computación, una maestría en Psicología de la Educación y años de experiencia en ciencia de datos y consultoría independiente en AI/ML. Le apasiona investigar enfoques metodológicos para la inteligencia humana y de máquinas. Fuera del trabajo, le encanta hacer senderismo, cocinar, cazar y pasar tiempo con amigos y familiares.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/fine-tune-whisper-models-on-amazon-sagemaker-with-lora/

- :posee

- :es

- :dónde

- 000

- 1

- 10

- 100

- 13

- 15%

- 17

- 24

- 25

- 26%

- 40

- 7

- 8

- 97

- a

- Nuestra Empresa

- la exactitud

- Lograr

- a través de

- adaptar

- adaptaciónes

- add

- Adicionales

- Adicionalmente

- en contra

- AI / ML

- Todos

- permitir

- también

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Servicios Web de Amazon (AWS)

- amp

- an

- y

- cualquier

- aplicaciones

- Aplicá

- enfoque

- enfoques

- aproximadamente

- arquitectura

- somos

- áreas

- argumento

- Formación

- AS

- asociado

- At

- audio

- Autorzy

- auto

- Automático

- Hoy Disponibles

- AWS

- bases

- basado

- BE

- porque

- a las que has recomendado

- esto

- es el beneficio

- beneficios

- mejores

- entre

- ambas

- llevar

- build

- by

- calcular

- PUEDEN

- case

- Reto

- Cambios

- código

- combinación

- Algunos

- comúnmente

- comparable

- comparar

- en comparación con

- comparación

- exhaustivo

- computational

- Calcular

- computadora

- Ciencias de la Computación

- Configuración

- Considerar

- considerable

- consultoría

- Envase

- convertir

- proceso de copiar

- Precio

- podría

- Current

- datos

- Preparación de datos

- Ciencia de los datos

- conjuntos de datos

- década

- disminuir

- se define

- Grado

- de los

- demandas

- demostrado

- desplegar

- desplegado

- despliegue

- A pesar de las

- HIZO

- un cambio

- difícil

- directamente

- distribuidos

- entrenamiento distribuido

- Docker

- No

- descargar

- durante

- cada una

- pasan fácilmente

- Educación

- eficiencia

- eficiente

- habilitar

- facilita

- permite

- que abarca

- ingeniero

- ambientes

- época

- error

- especialmente

- evaluar

- Incluso

- ejemplo

- exceden

- excepcionalmente

- Expandir

- experience

- experimento

- ampliar

- extraerlos

- Cara

- familias

- más rápida

- Feature

- Caracteristicas

- realimentación

- menos

- Archive

- archivos

- Fintech

- Nombre

- Digital XNUMXk

- flotante

- Focus

- siguiendo

- Comida

- Footprint

- formato

- adelante

- encontrado

- Digital XNUMXk

- amigos

- Desde

- ser completados

- completamente

- función

- promover

- obtener

- va

- GPU

- GPU

- gratitud

- Polo a Tierra

- guía

- encargarse de

- Tienen

- he

- Alta

- su

- HORAS

- Cómo

- Como Hacer

- Sin embargo

- HTML

- HTTPS

- humana

- Inteligencia humana

- Caza

- Obstáculos

- ID

- ideal

- ids

- imagen

- implementar

- implementación

- importar

- importante

- mejorar

- la mejora de

- in

- incluir

- aumentado

- independientes

- Indica

- energético

- EN LA MINA

- Las opciones de entrada

- entradas

- perspicaz

- ejemplo

- Intelligence

- dentro

- introducir

- Presenta

- IT

- SUS

- Trabajos

- Juan

- jpg

- conocido

- Label

- Etiquetas

- idioma

- Idiomas

- large

- mayores

- Apellidos

- Estado latente

- .

- APRENDE:

- aprendizaje

- bibliotecas

- Biblioteca

- limitaciones

- Limitada

- carga

- local

- por más tiempo

- ama

- inferior

- máquina

- máquina de aprendizaje

- Mantener los

- mantiene

- Realizar

- gestionado

- mapa

- Máster

- Match

- significativo

- medidas

- Salud Cerebral

- Método

- métodos

- métrico

- ML

- modelo

- modelos

- más,

- MONTE

- mr

- mucho más

- múltiples

- necesita

- ¿ Necesita ayuda

- Ninguna

- ahora

- número

- Nvidia

- of

- Ofertas

- a menudo

- on

- ONE

- funcionamiento

- optimización

- Optimización

- Opciones

- or

- reconocida por

- Otro

- "nuestr

- afuera

- Más de

- EL DESARROLLADOR

- paquete

- empaquetado

- parámetros

- particular

- apasionado

- (PDF)

- actuación

- fase

- Doctor en Filosofía

- plataforma

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- punto

- plantear

- Publicación

- Precisión

- previsto

- preparación

- presente

- Procesado

- prometedor

- Psicología

- Python

- calidad

- distancia

- clasificar

- Rate

- en tiempo real

- reconocimiento

- reducir

- Reducción

- la reducción de

- remitir

- requisito

- Requisitos

- requiere

- Recursos

- Resultados

- volvemos

- una estrategia SEO para aparecer en las búsquedas de Google.

- redondeo

- Ejecutar

- corre

- s

- sacrificando

- sabio

- Ahorros

- Escala

- esquemas

- Ciencia:

- guión

- ver

- mayor

- sentencia

- Servicios

- servicio

- set

- Varios

- ella

- mostrado

- firmado

- importante

- simplemente

- soltero

- tamaños

- So

- Software

- Ingeniero de Software

- SOL

- Soluciones

- Fuente

- código fuente

- Espacio

- especialista

- específicamente

- habla

- Reconocimiento de voz

- Gastos

- dividido

- Spot

- Etapa

- comienzo

- Estado

- el estado de la técnica

- estático

- paso

- pasos

- STORAGE

- estructura

- tal

- ¡Prepárate!

- toma

- Target

- Tarea

- tareas

- la técnica

- tecnólogo

- diez

- términos

- test

- Pruebas

- texto

- que

- esa

- La

- La Fuente

- su

- luego

- Ahí.

- de este modo

- así

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- rendimiento

- equipo

- veces

- a

- juntos

- ficha

- demasiado

- antorcha

- tradicional

- Entrenar

- entrenado

- Formación

- Expediente académico

- transformador

- transformers

- verdad

- único

- diferente a

- us

- utilizan el

- caso de uso

- usado

- usando

- variado

- Voz

- formas

- we

- web

- servicios web

- cuando

- que

- Susurro

- seguirá

- sin

- Palabra

- Actividades:

- flujos de trabajo

- años

- Usted

- tú

- zephyrnet