El aumento de las actividades sociales en línea, como las redes sociales o los juegos en línea, a menudo está plagado de comportamientos hostiles o agresivos que pueden dar lugar a manifestaciones no solicitadas de incitación al odio, ciberacoso o acoso. Por ejemplo, muchas comunidades de juegos en línea ofrecen la función de chat de voz para facilitar la comunicación entre sus usuarios. Aunque el chat de voz a menudo admite bromas amistosas y charlas basura, también puede generar problemas como incitación al odio, ciberacoso, acoso y estafas. Marcar el lenguaje dañino ayuda a las organizaciones a mantener conversaciones civilizadas y mantener un entorno en línea seguro e inclusivo para que los usuarios creen, compartan y participen libremente. Hoy en día, muchas empresas confían únicamente en moderadores humanos para revisar el contenido tóxico. Sin embargo, escalar moderadores humanos para satisfacer estas necesidades con una calidad y velocidad suficientes es costoso. Como resultado, muchas organizaciones corren el riesgo de enfrentar altas tasas de deserción de usuarios, daños a la reputación y multas reglamentarias. Además, los moderadores a menudo se ven afectados psicológicamente al revisar el contenido tóxico.

Amazon Transcribe es un servicio de reconocimiento de voz automático (ASR) que facilita a los desarrolladores agregar la capacidad de conversión de voz a texto a sus aplicaciones. Hoy, nos complace anunciar Detección de toxicidad de Amazon Transcribe, una capacidad impulsada por aprendizaje automático (ML) que utiliza señales basadas en audio y texto para identificar y clasificar contenido tóxico basado en voz en siete categorías, que incluyen acoso sexual, incitación al odio, amenazas, abuso, blasfemias, insultos y lenguaje gráfico. . Además del texto, la detección de toxicidad utiliza señales de voz, como tonos y tono, para identificar la intención tóxica en el habla.

Esta es una mejora de los sistemas de moderación de contenido estándar que están diseñados para centrarse solo en términos específicos, sin tener en cuenta la intención. La mayoría de las empresas tienen un SLA de 7 a 15 días para revisar el contenido informado por los usuarios porque los moderadores deben escuchar archivos de audio largos para evaluar si la conversación se volvió tóxica y cuándo. Con la detección de toxicidad de Amazon Transcribe, los moderadores solo revisan la parte específica del archivo de audio marcada por contenido tóxico (en lugar de todo el archivo de audio). El contenido que los moderadores humanos deben revisar se reduce en un 95 %, lo que permite a los clientes reducir su SLA a solo unas pocas horas, así como moderar de manera proactiva más contenido más allá de lo que marcan los usuarios. Permitirá a las empresas detectar y moderar automáticamente el contenido a escala, proporcionar un entorno en línea seguro e inclusivo y tomar medidas antes de que pueda causar la pérdida de usuarios o daños a la reputación. Amazon Transcribe mantiene los modelos utilizados para la detección de contenido tóxico y los actualiza periódicamente para mantener la precisión y la relevancia.

En esta publicación, aprenderá cómo:

- Identifique contenido dañino en el habla con Amazon Transcribe Toxicity Detection

- Use la consola de Amazon Transcribe para la detección de toxicidad

- Cree un trabajo de transcripción con detección de toxicidad usando el Interfaz de línea de comandos de AWS (AWS CLI) y SDK de Python

- Utilice la respuesta de la API de detección de toxicidad de Amazon Transcribe

Detecte la toxicidad en el chat de audio con Amazon Transcribe Toxicity Detection

Amazon Transcribe ahora proporciona una solución simple basada en ML para marcar lenguaje dañino en conversaciones habladas. Esta función es especialmente útil para las redes sociales, los juegos y las necesidades generales, ya que elimina la necesidad de que los clientes proporcionen sus propios datos para entrenar el modelo ML. La detección de toxicidad clasifica el contenido de audio tóxico en las siguientes siete categorías y proporciona una puntuación de confianza (0-1) para cada categoría:

- Blasfemia – Discurso que contenga palabras, frases o acrónimos descorteses, vulgares u ofensivos.

- El discurso del odio – Discurso que critica, insulta, denuncia o deshumaniza a una persona o grupo sobre la base de una identidad (como raza, etnia, género, religión, orientación sexual, capacidad y origen nacional).

- Sexual – Discurso que indica interés, actividad o excitación sexual usando referencias directas o indirectas a partes del cuerpo, rasgos físicos o sexo.

- Insultos – Discurso que incluye lenguaje degradante, humillante, burlón, insultante o denigrante. Este tipo de lenguaje también se etiqueta como bullying.

- Violencia o amenaza – Discurso que incluye amenazas que buscan infligir dolor, daño u hostilidad hacia una persona o grupo.

- Gráfico – Discurso que utiliza imágenes visualmente descriptivas y desagradablemente vívidas. Este tipo de lenguaje a menudo es intencionalmente detallado para amplificar la incomodidad del destinatario.

- Acoso o abuso – Discurso destinado a afectar el bienestar psicológico del destinatario, incluidos los términos degradantes y objetivantes.

Puede acceder a la detección de toxicidad a través de la consola de Amazon Transcribe o llamando a las API directamente mediante la CLI de AWS o los SDK de AWS. En la consola de Amazon Transcribe, puede cargar los archivos de audio cuya toxicidad desea analizar y obtener resultados con solo unos pocos clics. Amazon Transcribe identificará y categorizará el contenido tóxico, como el acoso, la incitación al odio, el contenido sexual, la violencia, los insultos y las blasfemias. Amazon Transcribe también proporciona una puntuación de confianza para cada categoría, lo que brinda información valiosa sobre el nivel de toxicidad del contenido. La detección de toxicidad está actualmente disponible en la API estándar de Amazon Transcribe para el procesamiento por lotes y es compatible con el idioma inglés de EE. UU.

Tutorial de la consola de Amazon Transcribe

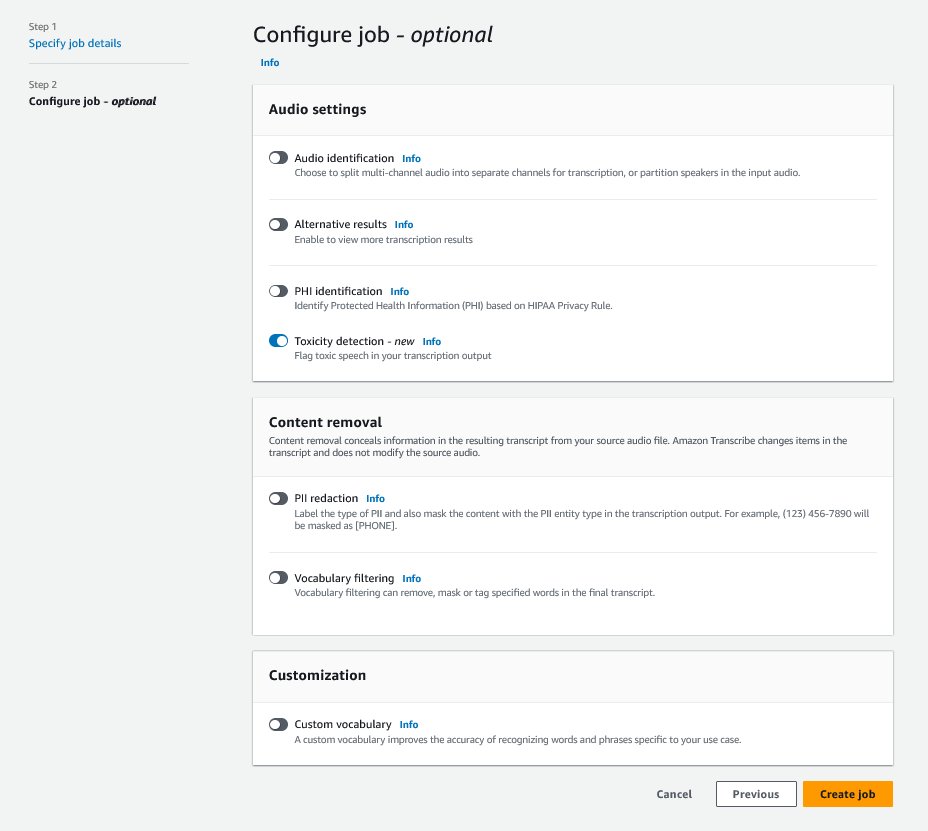

Para comenzar, inicie sesión en el Consola de administración de AWS y vaya a Amazon Transcribe. Para crear un nuevo trabajo de transcripción, debe cargar sus archivos grabados en un Servicio de almacenamiento simple de Amazon (Amazon S3) antes de que se puedan procesar. En la página de configuración de audio, como se muestra en la siguiente captura de pantalla, habilite Detección de toxicidad y proceda a crear el nuevo trabajo. Amazon Transcribe procesará el trabajo de transcripción en segundo plano. A medida que avanza el trabajo, puede esperar que el estado cambie a TERMINADO cuando finalice el proceso.

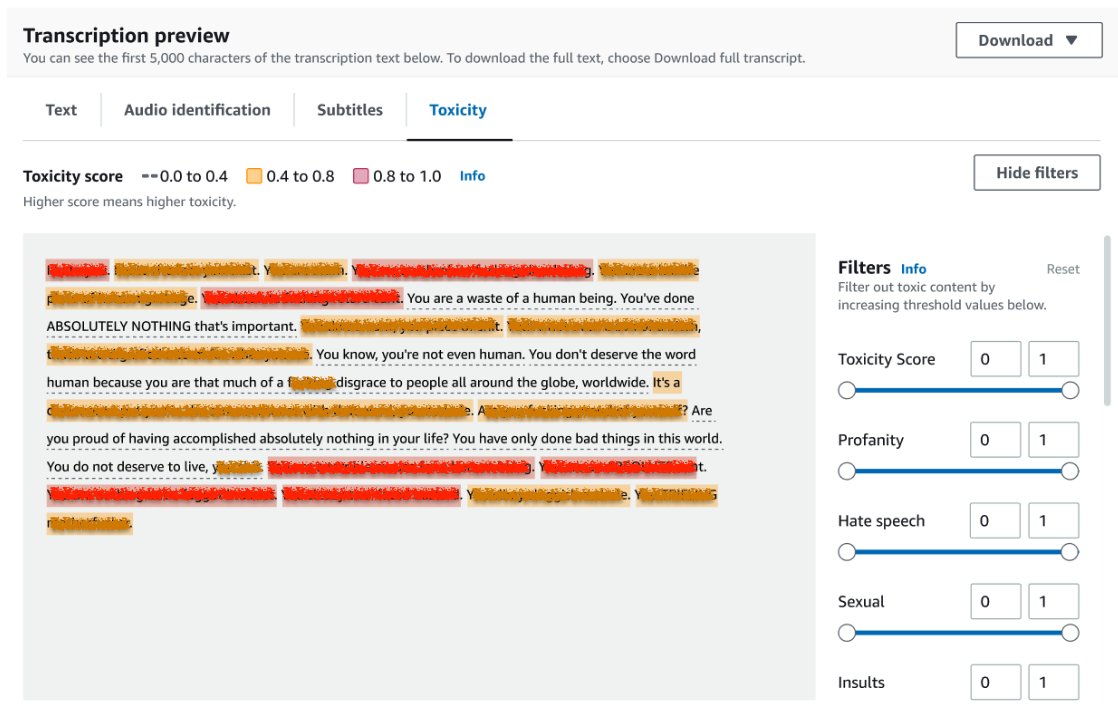

Para revisar los resultados de un trabajo de transcripción, elija el trabajo de la lista de trabajos para abrirlo. Desplácese hacia abajo hasta el Vista previa de la transcripción sección para comprobar los resultados en el Toxicidad pestaña. La interfaz de usuario muestra segmentos de transcripción codificados por colores para indicar el nivel de toxicidad, determinado por la puntuación de confianza. Para personalizar la pantalla, puede usar las barras de alternar en el Filtros cristal. Estas barras le permiten ajustar los umbrales y filtrar las categorías de toxicidad en consecuencia.

La siguiente captura de pantalla ha cubierto partes del texto de la transcripción debido a la presencia de información confidencial o tóxica.

API de transcripción con una solicitud de detección de toxicidad

En esta sección, lo guiaremos a través de la creación de un trabajo de transcripción con detección de toxicidad mediante interfaces de programación. Si el archivo de audio aún no está en un depósito de S3, cárguelo para garantizar el acceso de Amazon Transcribe. De manera similar a la creación de un trabajo de transcripción en la consola, al invocar el trabajo, debe proporcionar los siguientes parámetros:

- TranscripciónJobName – Especifique un nombre de trabajo exclusivo.

- MediaFileUri – Ingrese la ubicación URI del archivo de audio en Amazon S3. Amazon Transcribe admite los siguientes formatos de audio: MP3, MP4, WAV, FLAC, AMR, OGG o WebM

- Código de lenguaje - Ajustado a

en-US. En el momento de redactar este documento, la detección de toxicidad solo es compatible con el idioma inglés de EE. UU. - ToxicidadCategorías - Pasa el

ALLvalor para incluir todas las categorías de detección de toxicidad admitidas.

Los siguientes son ejemplos de cómo iniciar un trabajo de transcripción con la detección de toxicidad habilitada mediante Python3:

Puede invocar el mismo trabajo de transcripción con detección de toxicidad mediante el siguiente comando de la CLI de AWS:

API de transcripción con respuesta de detección de toxicidad

La salida JSON de detección de toxicidad de Amazon Transcribe incluirá los resultados de la transcripción en el campo de resultados. Habilitar la detección de toxicidad agrega un campo adicional llamado toxicityDetection debajo del campo de resultados. toxicityDetection incluye una lista de elementos transcritos con los siguientes parámetros:

- texto – El texto transcrito en bruto

- toxicidad – Una puntuación de confianza de detección (un valor entre 0 y 1)

- categoría – Una puntuación de confianza para cada categoría de discurso tóxico

- hora de inicio – La posición de inicio de la detección en el archivo de audio (segundos)

- hora de finalización – La posición final de detección en el archivo de audio (segundos)

La siguiente es una respuesta de detección de toxicidad abreviada de muestra que puede descargar desde la consola:

Resumen

En esta publicación, proporcionamos una descripción general de la nueva función de detección de toxicidad de Amazon Transcribe. También describimos cómo puede analizar la salida JSON de detección de toxicidad. Para obtener más información, consulte la consola de Amazon Transcribe y pruebe la API de transcripción con detección de toxicidad.

La detección de toxicidad de Amazon Transcribe ahora está disponible en las siguientes regiones de AWS: EE. UU. Este (Ohio), EE. UU. Este (Norte de Virginia), EE. UU. Oeste (Oregón), Asia Pacífico (Sídney), Europa (Irlanda) y Europa (Londres). Para obtener más información, visite Amazon Transcribe.

Aprenda más sobre moderación de contenido en AWS y nuestro Casos de uso de ML de moderación de contenido. Da el primer paso hacia optimizar sus operaciones de moderación de contenido con AWS.

Acerca del autor.

lana zhang es un arquitecto de soluciones sénior en el equipo de servicios de IA de AWS WWSO, que se especializa en IA y ML para moderación de contenido, visión artificial y procesamiento de lenguaje natural. Con su experiencia, se dedica a promover las soluciones de IA/ML de AWS y ayudar a los clientes a transformar sus soluciones comerciales en diversas industrias, incluidas las redes sociales, los juegos, el comercio electrónico y la publicidad y el marketing.

lana zhang es un arquitecto de soluciones sénior en el equipo de servicios de IA de AWS WWSO, que se especializa en IA y ML para moderación de contenido, visión artificial y procesamiento de lenguaje natural. Con su experiencia, se dedica a promover las soluciones de IA/ML de AWS y ayudar a los clientes a transformar sus soluciones comerciales en diversas industrias, incluidas las redes sociales, los juegos, el comercio electrónico y la publicidad y el marketing.

Sumit Kumar es gerente de producto sénior, técnico en el equipo de AWS AI Language Services. Tiene 10 años de experiencia en gestión de productos en una variedad de dominios y le apasiona la IA/ML. Fuera del trabajo, a Sumit le encanta viajar y disfruta jugar al cricket y al tenis sobre césped.

Sumit Kumar es gerente de producto sénior, técnico en el equipo de AWS AI Language Services. Tiene 10 años de experiencia en gestión de productos en una variedad de dominios y le apasiona la IA/ML. Fuera del trabajo, a Sumit le encanta viajar y disfruta jugar al cricket y al tenis sobre césped.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Automoción / vehículos eléctricos, Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- Desplazamientos de bloque. Modernización de la propiedad de compensaciones ambientales. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/flag-harmful-language-in-spoken-conversations-with-amazon-transcribe-toxicity-detection/

- :posee

- :es

- :no

- 10

- 100

- 16

- 17

- 20

- 24

- 7

- 95%

- a

- capacidad

- Nuestra Empresa

- abuso

- de la máquina

- en consecuencia

- Contabilidad

- la exactitud

- a través de

- la columna Acción

- actividades

- actividad

- add

- adición

- Añade

- Publicidad

- agresivo

- AI

- Servicios de IA

- AI / ML

- Todos

- permitir

- ya haya utilizado

- también

- Aunque

- Amazon

- Amazon Transcribe

- Amazon Web Services

- entre

- an

- y

- Anunciar

- abejas

- API

- aplicaciones

- somos

- AS

- Asia

- asia pacifico

- ayudando

- At

- desgaste

- audio

- Automático

- automáticamente

- Hoy Disponibles

- AWS

- fondo

- bares

- base

- BE

- se convirtió en

- porque

- antes

- comportamiento

- entre

- Más allá de

- cuerpo

- ambas

- Descanso

- intimidación

- by

- , que son

- llamar

- PUEDEN

- capacidad

- categoría

- Categoría

- Causar

- el cambio

- comprobar

- Elige

- clasificar

- Comunicación

- Comunidades

- Empresas

- completar

- Completado

- computadora

- Visión por computador

- confianza

- Consola

- contiene

- contenido

- Conversación

- conversaciones

- cubierto

- Para crear

- Creamos

- cricket

- Critica

- En la actualidad

- Clientes

- personalizan

- datos

- Días

- a dedicados

- descrito

- diseñado

- detectar

- Detección

- determina

- desarrolladores

- de reservas

- directamente

- Pantalla

- diverso

- dominios

- DE INSCRIPCIÓN

- descargar

- dos

- comercio electrónico

- cada una

- Este

- de forma sencilla

- ya sea

- eliminando

- habilitar

- facilita

- permitiendo

- final

- Inglés

- garantizar

- Participar

- empresas

- Todo

- Entorno

- especialmente

- etnicidad

- Europa

- evaluar

- ejemplo

- ejemplos

- excitado

- esperar

- costoso

- experience

- Experiencia

- extra

- facilitar

- tener problemas con

- Fallidos

- Feature

- pocos

- campo

- Archive

- archivos

- filtrar

- multas

- Nombre

- marcado

- Focus

- siguiendo

- amigable

- Desde

- a la fatiga

- juego de azar

- Género

- General

- obtener

- Go

- Va

- Gráfico

- Grupo procesos

- guía

- perjudicial

- Tienen

- he

- ayuda

- aquí

- esta página

- Alta

- HORAS

- Cómo

- Como Hacer

- Sin embargo

- HTML

- http

- HTTPS

- humana

- Identifique

- Identidad

- if

- impactados

- importar

- es la mejora continua

- in

- incluir

- incluye

- Incluye

- INTEGRAL

- aumente

- indicar

- Indica

- industrias

- información

- Insights

- Insulto

- Destinado a

- intención

- Intención

- intencionalmente

- intereses

- las interfaces

- dentro

- Irlanda

- IT

- artículos

- Trabajos

- jpg

- json

- solo

- Guardar

- idioma

- Lead

- APRENDE:

- aprendizaje

- Nivel

- línea

- Lista

- Ubicación

- Londres

- ama

- máquina

- máquina de aprendizaje

- mantener

- HACE

- Management

- gerente

- muchos

- Marketing

- Medios

- Conoce a

- ML

- modelo

- modelos

- moderación

- más,

- MEJOR DE TU

- debe

- nombre

- Nacional

- Natural

- Procesamiento natural del lenguaje

- ¿ Necesita ayuda

- red

- Nuevo

- ahora

- of

- LANZAMIENTO

- a menudo

- Ohio

- on

- en línea

- Juego en linea

- , solamente

- habiertos

- Operaciones

- or

- Oregón

- para las fiestas.

- natural

- nuestros

- salir

- salida

- afuera

- visión de conjunto

- EL DESARROLLADOR

- Costa

- página

- Dolor

- parámetros

- participar

- partes

- pass

- apasionado

- persona

- frases

- los libros físicos

- Paso

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- jugando

- parte

- posición

- Publicación

- presencia

- problemas

- Procesado

- tratamiento

- Producto

- gestión de producto

- gerente de producto

- BLASFEMIA

- Programación

- Promoción

- proporcionar

- previsto

- proporciona un

- proporcionando

- Python

- calidad

- Carrera

- Tarifas

- Crudo

- ready

- reconocimiento

- grabado

- reducir

- Reducción

- referencias

- regiones

- regulador

- la relevancia

- religión

- confiar

- reportado

- respuesta

- resultado

- Resultados

- una estrategia SEO para aparecer en las búsquedas de Google.

- la revisión

- Riesgo

- ambiente seguro

- mismo

- Escala

- la ampliación

- estafas

- Puntuación

- mover

- SDK

- segundos

- Sección

- la búsqueda de

- segmento

- segmentos

- mayor

- sensible

- de coches

- Servicios

- set

- ajustes

- siete

- Sexo

- Sexual

- Compartir

- ella

- mostrado

- Shows

- firmar

- similares

- sencillos

- Social

- redes sociales

- Redes Sociales

- únicamente

- a medida

- Soluciones

- especializada

- soluciones y

- habla

- Reconocimiento de voz

- de voz a texto

- velocidad

- habla

- estándar

- comienzo

- fundó

- Comience a

- Estado

- paso

- STORAGE

- tal

- suficiente

- Soportado

- soportes

- Sydney

- Todas las funciones a su disposición

- ¡Prepárate!

- hablar

- equipo

- Técnico

- términos

- test

- esa

- El

- su

- Les

- Estas

- ellos

- así

- amenazas

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- a

- hoy

- hacia

- hacia

- Entrenar

- transformadora

- viajes

- verdadero

- try

- tipo

- ui

- bajo

- único

- No solicitado

- actualizado

- us

- utilizan el

- usado

- Usuario

- usuarios

- usos

- usando

- Valioso

- propuesta de

- variedad

- vía

- Violencia

- Virginia

- visión

- Visite

- Voz

- vs

- Vulgar

- esperar

- quieres

- we

- web

- servicios web

- WELL

- West

- cuando

- mientras

- seguirá

- sin

- palabras

- Actividades:

- la escritura

- años

- aún

- Usted

- tú

- zephyrnet