Esta es una publicación invitada en coautoría con Nafi Ahmet Turgut, Hasan Burak Yel y Damla Şentürk de Getir.

Establecido en 2015, traído se ha posicionado como pionero en el ámbito de la entrega ultrarrápida de comestibles. Esta innovadora empresa de tecnología ha revolucionado el segmento de entrega de última milla con su atractiva oferta de "comestibles en minutos". Con presencia en Turquía, el Reino Unido, los Países Bajos, Alemania y los Estados Unidos, Getir se ha convertido en una fuerza multinacional a tener en cuenta. Hoy en día, la marca Getir representa un conglomerado diversificado que abarca nueve verticales diferentes, todas trabajando sinérgicamente bajo un paraguas singular.

En esta publicación, explicamos cómo creamos un canal de predicción de categorías de productos de un extremo a otro para ayudar a los equipos comerciales mediante el uso Amazon SageMaker y Lote de AWS, reduciendo la duración del entrenamiento del modelo en un 90%.

Comprender nuestra variedad de productos existente de manera detallada es un desafío crucial que nosotros, junto con muchas empresas, enfrentamos en el mercado competitivo y de ritmo rápido de hoy. Una solución eficaz a este problema es la predicción de categorías de productos. Un modelo que genera un árbol de categorías completo permite a nuestros equipos comerciales comparar nuestra cartera de productos existente con la de nuestros competidores, ofreciendo una ventaja estratégica. Por lo tanto, nuestro desafío central es la creación e implementación de un modelo preciso de predicción de categorías de productos.

Aprovechamos las poderosas herramientas proporcionadas por AWS para enfrentar este desafío y navegar de manera efectiva en el complejo campo del aprendizaje automático (ML) y el análisis predictivo. Nuestros esfuerzos llevaron a la creación exitosa de un canal de predicción de categorías de productos de extremo a extremo, que combina las fortalezas de SageMaker y AWS Batch.

Esta capacidad de análisis predictivo, en particular el pronóstico preciso de categorías de productos, ha demostrado ser invaluable. Proporcionó a nuestros equipos información crítica basada en datos que optimizó la gestión de inventario, mejoró las interacciones con los clientes y fortaleció nuestra presencia en el mercado.

La metodología que explicamos en esta publicación abarca desde la fase inicial de recopilación del conjunto de características hasta la implementación final del proceso de predicción. Un aspecto importante de nuestra estrategia ha sido el uso de SageMaker y AWS Batch para perfeccionar modelos BERT previamente entrenados para siete idiomas diferentes. Además, nuestra perfecta integración con el servicio de almacenamiento de objetos de AWS Servicio de almacenamiento simple de Amazon (Amazon S3) ha sido clave para almacenar y acceder de manera eficiente a estos modelos refinados.

SageMaker es un servicio de aprendizaje automático totalmente administrado. Con SageMaker, los científicos y desarrolladores de datos pueden crear y entrenar modelos de aprendizaje automático de forma rápida y sin esfuerzo, y luego implementarlos directamente en un entorno alojado listo para producción.

Como servicio totalmente administrado, AWS Batch lo ayuda a ejecutar cargas de trabajo informáticas por lotes de cualquier escala. AWS Batch aprovisiona automáticamente recursos informáticos y optimiza la distribución de la carga de trabajo en función de la cantidad y escala de las cargas de trabajo. Con AWS Batch, no es necesario instalar ni administrar software informático por lotes, por lo que puede centrar su tiempo en analizar resultados y resolver problemas. Usamos trabajos de GPU que nos ayudan a ejecutar trabajos que usan las GPU de una instancia.

Resumen de la solución

Cinco personas del equipo de ciencia de datos y del equipo de infraestructura de Getir trabajaron juntas en este proyecto. El proyecto se completó en un mes y se puso en producción después de una semana de pruebas.

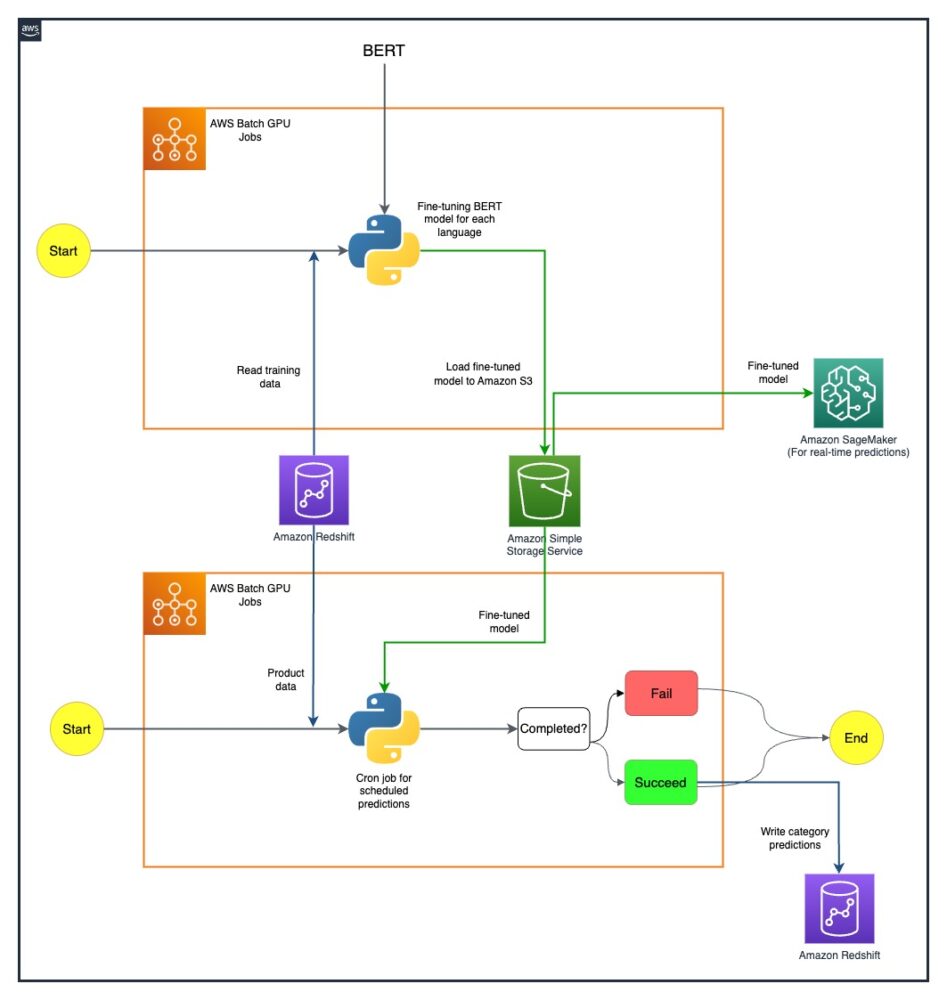

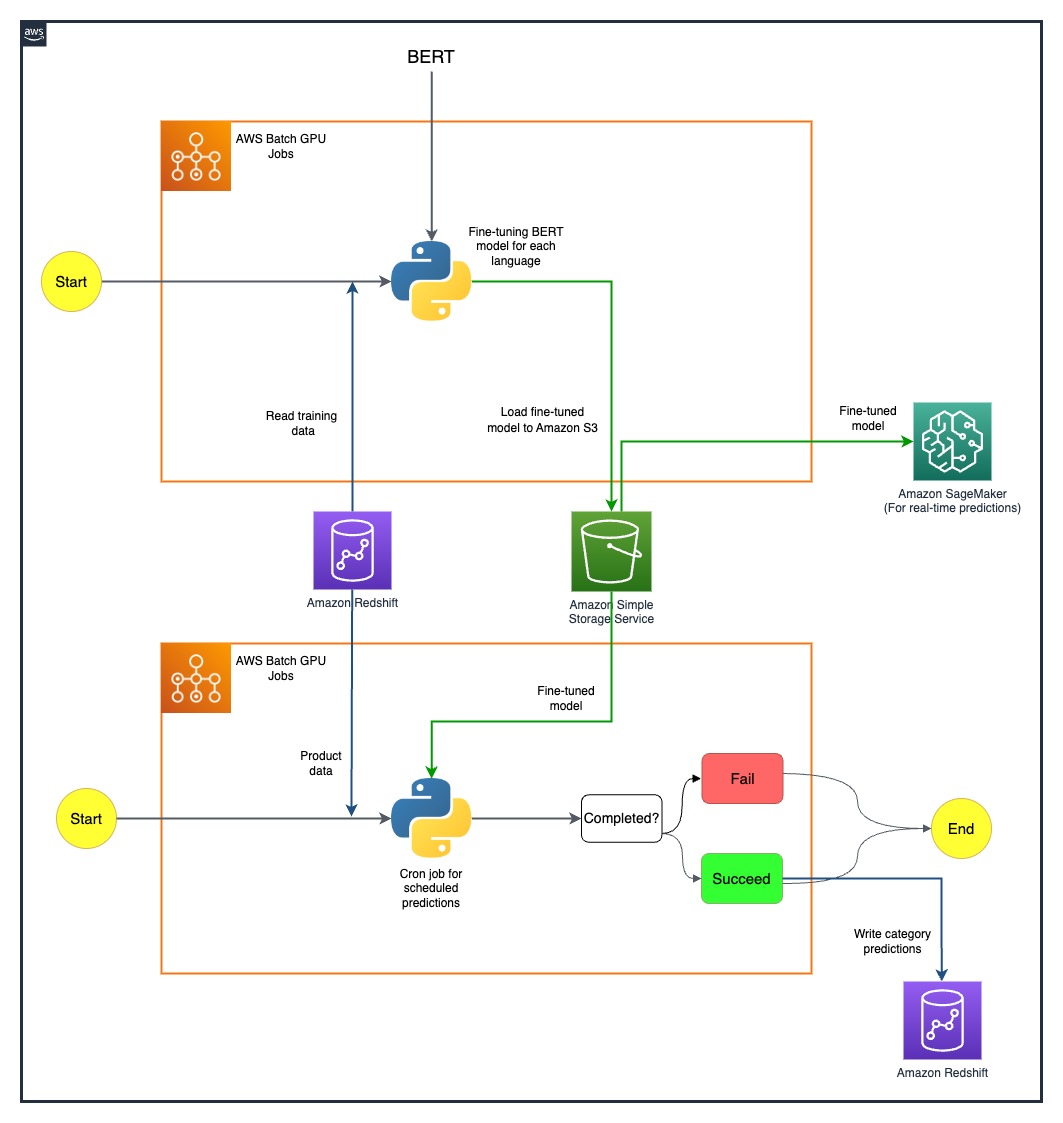

El siguiente diagrama muestra la arquitectura de la solución.

El modelo en proceso se ejecuta por separado para cada país. La arquitectura incluye dos trabajos cron de GPU de AWS Batch para cada país, que se ejecutan en horarios definidos.

Superamos algunos desafíos mediante la implementación estratégica de recursos de GPU de SageMaker y AWS Batch. El proceso utilizado para abordar cada dificultad se detalla en las siguientes secciones.

Ajuste de modelos BERT multilingües con trabajos de GPU de AWS Batch

Buscábamos una solución que admitiera varios idiomas para nuestra diversa base de usuarios. Los modelos BERT fueron una elección obvia debido a su capacidad establecida para manejar tareas complejas de lenguaje natural de manera efectiva. Para adaptar estos modelos a nuestras necesidades, aprovechamos el poder de AWS mediante el uso de trabajos de instancia de GPU de un solo nodo. Esto nos permitió ajustar los modelos BERT previamente entrenados para cada uno de los siete idiomas para los que necesitábamos soporte. A través de este método, aseguramos una alta precisión en la predicción de categorías de productos, superando cualquier posible barrera del idioma.

Almacenamiento de modelos eficiente con Amazon S3

Nuestro siguiente paso fue abordar el almacenamiento y la gestión de modelos. Para ello, seleccionamos Amazon S3, conocido por su escalabilidad y seguridad. Almacenar nuestros modelos BERT ajustados en Amazon S3 nos permitió brindar acceso fácil a diferentes equipos dentro de nuestra organización, lo que agilizó significativamente nuestro proceso de implementación. Este fue un aspecto crucial para lograr agilidad en nuestras operaciones y una integración perfecta de nuestros esfuerzos de ML.

Crear un canal de predicción de un extremo a otro

Se necesitaba un proceso eficiente para aprovechar al máximo nuestros modelos previamente entrenados. Primero implementamos estos modelos en SageMaker, una acción que permitía predicciones en tiempo real con baja latencia, mejorando así nuestra experiencia de usuario. Para predicciones por lotes a mayor escala, que eran igualmente vitales para nuestras operaciones, utilizamos trabajos de GPU por lotes de AWS. Esto aseguró el uso óptimo de nuestros recursos, proporcionándonos un equilibrio perfecto entre rendimiento y eficiencia.

Explorando posibilidades futuras con SageMaker MME

A medida que continuamos evolucionando y buscando eficiencias en nuestro proceso de aprendizaje automático, una vía que estamos interesados en explorar es el uso de puntos finales multimodelo (MME) de SageMaker para implementar nuestros modelos optimizados. Con MME, podemos potencialmente optimizar la implementación de varios modelos optimizados, garantizando una gestión eficiente de los modelos y al mismo tiempo beneficiándonos de las capacidades nativas de SageMaker, como variantes de sombra, escalado automático y Reloj en la nube de Amazon integración. Esta exploración se alinea con nuestra búsqueda continua de mejorar nuestras capacidades de análisis predictivo y brindar experiencias superiores a nuestros clientes.

Conclusión

Nuestra exitosa integración de SageMaker y AWS Batch no solo ha abordado nuestros desafíos específicos sino que también ha aumentado significativamente nuestra eficiencia operativa. Mediante la implementación de un sofisticado proceso de predicción de categorías de productos, podemos dotar a nuestros equipos comerciales de conocimientos basados en datos, facilitando así una toma de decisiones más eficaz.

Nuestros resultados dicen mucho sobre la efectividad de nuestro enfoque. Hemos logrado una precisión de predicción del 80 % en los cuatro niveles de granularidad de categorías, lo que juega un papel importante en la configuración de la variedad de productos para cada país al que servimos. Este nivel de precisión extiende nuestro alcance más allá de las barreras del idioma y garantiza que atendemos a nuestra diversa base de usuarios con la máxima precisión.

Además, al utilizar estratégicamente trabajos programados de GPU de AWS Batch, hemos podido reducir la duración del entrenamiento de nuestro modelo en un 90 %. Esta eficiencia ha simplificado aún más nuestros procesos y ha reforzado nuestra agilidad operativa. El almacenamiento eficiente de modelos mediante Amazon S3 ha desempeñado un papel fundamental en este logro, equilibrando las predicciones en tiempo real y por lotes.

Para obtener más información sobre cómo comenzar a crear sus propios canales de aprendizaje automático con SageMaker, consulte Recursos de Amazon SageMaker. AWS Batch es una excelente opción si busca una solución escalable y de bajo costo para ejecutar trabajos por lotes con una sobrecarga operativa baja. Para empezar, consulte Introducción a AWS Batch.

Acerca de los autores

Nafi Ahmet Turgut Terminó su maestría en Ingeniería Eléctrica y Electrónica y trabajó como científico investigador graduado. Su objetivo era crear algoritmos de aprendizaje automático para simular anomalías de la red nerviosa. Se unió a Getir en 2019 y actualmente trabaja como Gerente Senior de Análisis y Ciencia de Datos. Su equipo es responsable de diseñar, implementar y mantener algoritmos de aprendizaje automático de un extremo a otro y soluciones basadas en datos para Getir.

Nafi Ahmet Turgut Terminó su maestría en Ingeniería Eléctrica y Electrónica y trabajó como científico investigador graduado. Su objetivo era crear algoritmos de aprendizaje automático para simular anomalías de la red nerviosa. Se unió a Getir en 2019 y actualmente trabaja como Gerente Senior de Análisis y Ciencia de Datos. Su equipo es responsable de diseñar, implementar y mantener algoritmos de aprendizaje automático de un extremo a otro y soluciones basadas en datos para Getir.

Hasan Burak Yel Recibió su licenciatura en Ingeniería Eléctrica y Electrónica en la Universidad de Boğaziçi. Trabajó en Turkcell, centrándose principalmente en la previsión de series temporales, visualización de datos y automatización de redes. Se unió a Getir en 2021 y actualmente trabaja como gerente de análisis y ciencia de datos con responsabilidad en los dominios de búsqueda, recomendación y crecimiento.

Hasan Burak Yel Recibió su licenciatura en Ingeniería Eléctrica y Electrónica en la Universidad de Boğaziçi. Trabajó en Turkcell, centrándose principalmente en la previsión de series temporales, visualización de datos y automatización de redes. Se unió a Getir en 2021 y actualmente trabaja como gerente de análisis y ciencia de datos con responsabilidad en los dominios de búsqueda, recomendación y crecimiento.

Damla Şentürk Recibió su licenciatura en Ingeniería Informática en la Universidad de Galatasaray. Continúa su maestría en Ingeniería Informática en la Universidad de Boğaziçi. Se unió a Getir en 2022 y ha estado trabajando como científica de datos. Ha trabajado en proyectos comerciales, de cadena de suministro y relacionados con el descubrimiento.

Damla Şentürk Recibió su licenciatura en Ingeniería Informática en la Universidad de Galatasaray. Continúa su maestría en Ingeniería Informática en la Universidad de Boğaziçi. Se unió a Getir en 2022 y ha estado trabajando como científica de datos. Ha trabajado en proyectos comerciales, de cadena de suministro y relacionados con el descubrimiento.

Esra Kayabali es arquitecto senior de soluciones en AWS, especializado en el dominio de análisis, incluido el almacenamiento de datos, lagos de datos, análisis de big data, transmisión de datos por lotes y en tiempo real e integración de datos. Tiene 12 años de experiencia en arquitectura y desarrollo de software. Le apasiona aprender y enseñar tecnologías en la nube.

Esra Kayabali es arquitecto senior de soluciones en AWS, especializado en el dominio de análisis, incluido el almacenamiento de datos, lagos de datos, análisis de big data, transmisión de datos por lotes y en tiempo real e integración de datos. Tiene 12 años de experiencia en arquitectura y desarrollo de software. Le apasiona aprender y enseñar tecnologías en la nube.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/how-getir-reduced-model-training-durations-by-90-with-amazon-sagemaker-and-aws-batch/

- :posee

- :es

- :no

- 100

- 12

- 2015

- 2019

- 2021

- 2022

- 7

- a

- capacidad

- Poder

- Nuestra Empresa

- de la máquina

- el acceso

- la exactitud

- preciso

- alcanzado

- logro

- el logro de

- a través de

- la columna Acción

- Adicionalmente

- dirección

- dirigido

- Ventaja

- Después

- en contra

- algoritmos

- Alinea

- Todos

- permitido

- permite

- a lo largo de

- también

- Amazon

- Amazon SageMaker

- Amazon Web Services

- an

- Analytics

- el análisis de

- y

- e infraestructura

- anomalías

- cualquier

- arquitectura

- somos

- AS

- aspecto

- surtido

- At

- auto

- automáticamente

- Automatización

- Avenida

- AWS

- Balance

- equilibrio

- las barreras

- bases

- basado

- BE

- a las que has recomendado

- esto

- beneficiando

- MEJOR

- Más allá de

- Big

- Big Data

- impulsado

- ambas

- marca

- build

- Construir la

- construido

- negocios

- pero

- by

- PUEDEN

- capacidades

- capacidad

- en mayúscula

- categoría

- Categoría

- abastecer

- central

- cadena

- Reto

- retos

- manera?

- Soluciones

- combina

- completo

- compañía

- irresistible

- competitivos

- competidores

- Completado

- integraciones

- exhaustivo

- Calcular

- computadora

- Ingeniería Informática

- informática

- conglomerado

- continue

- continúa

- continuo

- país

- creación

- crítico

- crucial

- En la actualidad

- cliente

- Clientes

- datos

- Data Analytics

- Ciencia de los datos

- científico de datos

- Visualización de datos

- basada en datos

- Toma de Decisiones

- se define

- Grado

- entrega

- desplegar

- desplegado

- Desplegando

- despliegue

- diseño

- detallado

- desarrolladores

- Desarrollo

- una experiencia diferente

- Dificultad

- directamente

- diverso

- diversificado

- dominio

- dominios

- dos

- duración

- cada una

- de forma sencilla

- Eficaz

- de manera eficaz

- eficacia

- eficiencias

- eficiencia

- eficiente

- eficiente.

- sin esfuerzo

- esfuerzos

- Electrónica

- empoderar a

- facilita

- que abarca

- de extremo a extremo

- Ingeniería

- mejorado

- mejorar

- asegurado

- asegura

- asegurando que

- Entorno

- igualmente

- se establece

- evoluciona

- excelente,

- existente

- experience

- Experiencias

- Explicar

- exploración

- explorar

- Se extiende

- Cara

- facilitando

- de ritmo rápido

- Feature

- campo

- final

- Nombre

- Focus

- centrado

- siguiendo

- FORCE

- Pronóstico

- Digital XNUMXk

- Desde

- completamente

- promover

- futuras

- reunión

- genera

- Alemania

- obtener

- GPU

- GPU

- graduados

- Crecimiento

- Invitad@s

- Guest Post

- encargarse de

- Tienen

- he

- ayuda

- ayuda

- aquí

- Alta

- su

- organizado

- Cómo

- Como Hacer

- HTML

- http

- HTTPS

- if

- implementación

- implementación

- importante

- aspecto importante

- in

- incluye

- Incluye

- información

- EN LA MINA

- inicial

- originales

- Insights

- instalar

- ejemplo

- integración

- interacciones

- dentro

- inestimable

- inventario

- La gestión del inventario

- IT

- SUS

- sí mismo

- Empleo

- se unió a

- jpg

- Keen

- Clave

- conocido

- lagos

- idioma

- Idiomas

- Estado latente

- aprendizaje

- LED

- Nivel

- como

- mirando

- Baja

- de bajo costo

- máquina

- máquina de aprendizaje

- principalmente

- Mantener los

- para lograr

- gestionan

- gestionado

- Management

- gerente

- manera

- muchos

- Mercado

- Máster

- Método

- Metodología

- Min

- ML

- modelo

- modelos

- Mes

- más,

- multinacional

- múltiples

- nativo

- Natural

- Navegar

- ¿ Necesita ayuda

- Países Bajos

- del sistema,

- Next

- nueve

- no

- objeto

- obvio

- of

- que ofrece

- on

- ONE

- , solamente

- operativos.

- Operaciones

- óptimo

- optimizado

- Optimiza

- Optión

- or

- solicite

- organización

- "nuestr

- superación

- EL DESARROLLADOR

- particularmente

- apasionado

- Personas

- perfecto

- actuación

- fase

- industrial

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- jugado

- juega

- portafolio

- posicionado

- POSIBILIDADES

- Publicación

- posible

- la posibilidad

- industria

- poderoso

- Precisión

- predecir

- predicción

- Predicciones

- Análisis Predictivo

- presencia

- Problema

- problemas

- en costes

- Producto

- Producción

- proyecto

- proyecta

- probado

- proporcionar

- previsto

- proporcionando

- búsqueda

- la cantidad

- con rapidez

- rangos

- en comunicarse

- en tiempo real

- datos en tiempo real

- recibido

- Recomendación

- reducir

- Reducción

- la reducción de

- FILTRO

- refinado

- representa

- Requisitos

- la investigación

- Recursos

- responsabilidad

- responsable

- Resultados

- revolucionado

- Función

- Ejecutar

- correr

- sabio

- Escalabilidad

- escalable

- Escala

- la ampliación

- programada

- Ciencia:

- Científico

- los científicos

- sin costura

- Buscar

- (secciones)

- EN LINEA

- ver

- EL EQUIPO

- segmento

- seleccionado

- mayor

- Serie

- ayudar

- de coches

- Servicios

- set

- siete

- Shadow

- la formación

- ella

- Shows

- significativamente

- sencillos

- singular

- So

- Software

- Desarrollo de software ad-hoc

- a medida

- Soluciones

- Resolver

- algo

- sofisticado

- buscado

- De una Charla a tu equipo

- especializado

- soluciones y

- fundó

- Zonas

- paso

- STORAGE

- almacenamiento

- Estratégico

- Estratégicamente

- Estrategia

- en streaming

- aerodinamizar

- racionalizado

- racionalización

- fortalecido

- fortalezas

- exitosos

- superior

- suministro

- cadena de suministro

- SOPORTE

- entrada

- Sastre

- tareas

- Educación

- equipo

- equipos

- tecnología

- Empresa de tecnología

- Tecnologías

- Pruebas

- esa

- La

- Países Bajos

- el Reino Unido

- su

- Les

- luego

- de este modo

- por lo tanto

- Estas

- así

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- Series de tiempo

- a

- hoy

- de hoy

- juntos

- pionero

- Entrenar

- Formación

- árbol

- Turquía

- dos

- Uk

- paraguas

- bajo

- United

- Estados Unidos

- universidad

- us

- utilizan el

- usado

- Usuario

- experiencia como usuario

- usando

- utilizado

- mayor

- diversos

- verticales

- visualización

- vital

- volúmenes

- fue

- we

- web

- servicios web

- semana

- tuvieron

- que

- mientras

- dentro de

- trabajado

- trabajando

- funciona

- años

- Usted

- tú

- zephyrnet