En un mundo cada vez más centrado en los datos, las empresas deben centrarse en recopilar información física valiosa y generar la información que necesitan pero que no pueden capturar fácilmente. El acceso a los datos, la regulación y el cumplimiento son una fuente creciente de fricción para la innovación en análisis e inteligencia artificial (IA).

Para sectores altamente regulados como Servicios Financieros, Salud, Ciencias de la Vida, Automotriz, Robótica y Manufactura, el problema es aún mayor. Provoca barreras para el diseño del sistema, el intercambio de datos (interno y externo), la monetización, el análisis y el aprendizaje automático (ML).

Los datos sintéticos son una herramienta que aborda muchos desafíos relacionados con los datos, en particular la IA y los problemas de análisis, como la protección de la privacidad, el cumplimiento normativo, la accesibilidad, la escasez de datos y el sesgo. Esto también incluye el intercambio de datos y el tiempo de obtención de datos (y, por lo tanto, el tiempo de comercialización).

Los datos sintéticos se generan algorítmicamente. Refleja las propiedades estadísticas y los patrones de los datos de origen. Pero lo más importante es que no contiene puntos de datos confidenciales, privados o personales.

Usted hace preguntas a los datos sintéticos y obtiene las mismas respuestas que obtendría de los datos reales.

En nuestros post anterior, demostramos cómo usar redes antagónicas como Generative Adversarial Networks (GANS) para generar conjuntos de datos tabulares para mejorar la capacitación del modelo de fraude crediticio.

Para que las partes interesadas del negocio adopten datos sintéticos para sus proyectos de ML y análisis, es imperativo no solo asegurarse de que los datos sintéticos generados se ajusten al propósito y las aplicaciones posteriores esperadas, sino también que puedan medir y demostrar la calidad de los datos generados.

Con el aumento de las obligaciones legales y éticas en la preservación de la privacidad, una de las fortalezas de los datos sintéticos es la capacidad de eliminar información sensible y original durante su síntesis. Por lo tanto, además de la calidad, necesitamos métricas para evaluar el riesgo de fugas de información privada, si las hay, y evaluar que el proceso de generación no esté “memorizando” o copiando ninguno de los datos originales.

Para lograr todo esto, podemos mapear la calidad de los datos sintéticos en dimensiones, lo que ayuda a los usuarios, las partes interesadas y a nosotros a comprender mejor los datos generados.

Las tres dimensiones de la evaluación de la calidad de los datos sintéticos

Los datos sintéticos generados se miden con respecto a tres dimensiones clave:

- Fidelidad

- Utilidad

- Privacidad

Estas son algunas de las preguntas sobre los datos sintéticos generados que deberían ser respondidas por un informe de calidad de datos sintéticos:

- ¿Qué tan similares son estos datos sintéticos en comparación con el conjunto de entrenamiento original?

- ¿Qué utilidad tienen estos datos sintéticos para nuestras aplicaciones posteriores?

- ¿Se ha filtrado alguna información de los datos de entrenamiento originales a los datos sintéticos?

- ¿Nuestro modelo ha sintetizado inadvertidamente algún dato que se considere confidencial en el mundo real (de otros conjuntos de datos que no se utilizan para entrenar el modelo)?

Las métricas que traducen cada una de estas dimensiones para los usuarios finales son algo flexibles. Después de todo, los datos que se generarán pueden variar en términos de distribuciones, tamaño y comportamientos. También deben ser fáciles de comprender e interpretar.

En última instancia, las métricas deben estar completamente basadas en datos y no requerir ningún conocimiento previo o información específica del dominio. Sin embargo, si el usuario desea aplicar reglas y restricciones específicas aplicables a un dominio comercial específico, debe poder definirlas durante el proceso de síntesis para asegurarse de que se cumpla la fidelidad específica del dominio.

Analizamos cada una de estas métricas con más detalle en las siguientes secciones.

Métricas para entender la fidelidad

En cualquier proyecto de ciencia de datos, debemos comprender si una población de muestra determinada es relevante para el problema que estamos resolviendo. Del mismo modo, para el proceso de evaluación de la relevancia de los datos sintéticos generados, debemos evaluarlos en términos de fidelidad en comparación con el original.

Las representaciones visuales de estas métricas las hacen más fáciles de comprender. Podríamos ilustrar si se respetó la cardinalidad y la razón de categorías, se mantuvieron las correlaciones entre las distintas variables, etc.

Visualizar los datos no solo ayuda a evaluar la calidad de los datos sintéticos, sino que también encaja como uno de los pasos iniciales en el ciclo de vida de la ciencia de datos para una mejor comprensión de los datos.

Profundicemos en algunas métricas de fidelidad con más detalle.

Comparaciones estadísticas exploratorias

Dentro de las comparaciones estadísticas exploratorias, las características de los conjuntos de datos originales y sintéticos se exploran utilizando medidas estadísticas clave, como la media, la mediana, la desviación estándar, valores distintos, valores faltantes, mínimos, máximos, rangos de cuartiles para características continuas y el número de registros por categoría, valores faltantes por categoría y caracteres más frecuentes para atributos categóricos.

Esta comparación debe realizarse entre el conjunto de datos reservado original y los datos sintéticos. Esta evaluación revelaría si los conjuntos de datos comparados son estadísticamente similares. Si no lo son, sabremos qué características y medidas son diferentes. Debe considerar volver a entrenar y regenerar los datos sintéticos con diferentes parámetros si se observa una diferencia significativa.

Esta prueba actúa como una evaluación inicial para asegurarse de que los datos sintéticos tengan una fidelidad razonable con el conjunto de datos original y, por lo tanto, puedan someterse a pruebas más rigurosas.

Puntuación de similitud de histograma

La puntuación de similitud del histograma mide las distribuciones marginales de cada característica de los conjuntos de datos sintéticos y originales.

La puntuación de similitud está limitada entre cero y uno, con una puntuación de uno que indica que las distribuciones de datos sintéticos se superponen perfectamente a las distribuciones de los datos originales.

Una puntuación cercana a uno daría a los usuarios la confianza de que el conjunto de datos reservado y el conjunto de datos sintético son estadísticamente similares.

Puntaje de información mutua

La puntuación de información mutua mide la dependencia mutua de dos características, numéricas o categóricas, indicando cuánta información se puede obtener de una característica al observar otra.

La información mutua puede medir las relaciones no lineales, proporcionando una comprensión más completa de la calidad de los datos sintéticos, ya que nos permite comprender el alcance de la preservación de las relaciones de la variable.

Una puntuación de uno indica que la dependencia mutua entre características se ha capturado perfectamente en los datos sintéticos.

Puntuación de correlación

La puntuación de correlación mide qué tan bien se han capturado las correlaciones en el conjunto de datos original en los datos sintéticos.

Las correlaciones entre dos o más columnas son extremadamente importantes para las aplicaciones de ML, que ayudan a descubrir las relaciones entre las características y la variable de destino y ayudan a crear un modelo bien entrenado.

La puntuación de la correlación está limitada entre cero y uno, con una puntuación de uno que indica que las correlaciones han coincidido perfectamente.

A diferencia de los datos tabulares estructurados, que comúnmente encontramos en los problemas de datos, algunos tipos de datos estructurados tienen un comportamiento particular donde las observaciones pasadas tienen la probabilidad de influir en la siguiente observación. Estos se conocen como series de tiempo o datos secuenciales; por ejemplo, un conjunto de datos con mediciones horarias de la temperatura ambiente.

Este comportamiento significa que existe un requisito para definir ciertas métricas que pueden medir específicamente la calidad de estos conjuntos de datos de series temporales.

Puntuación de autocorrelación y autocorrelación parcial

Aunque similar a la correlación, la autocorrelación muestra la relación de una serie de tiempo en su valor actual en relación con sus valores anteriores. La eliminación de los efectos de los retrasos de tiempo anteriores produce una autocorrelación parcial. Por lo tanto, la puntuación de autocorrelación mide qué tan bien los datos sintéticos han capturado las autocorrelaciones significativas, o correlaciones parciales, del conjunto de datos original.

Métricas para entender la utilidad

Ahora es posible que nos hayamos dado cuenta estadísticamente de que los datos sintéticos son similares al conjunto de datos original. Además, también debemos evaluar qué tan bien se desempeña el conjunto de datos sintetizados en problemas comunes de ciencia de datos cuando se entrena en varios algoritmos de ML.

Usando lo siguiente utilidad métricas, nuestro objetivo es generar confianza de que realmente podemos lograr el rendimiento en las aplicaciones posteriores con respecto al rendimiento de los datos originales.

Puntuación de predicción

La medición del rendimiento de los datos sintéticos en comparación con los datos reales originales se puede realizar a través de modelos ML. La puntuación del modelo descendente captura la calidad de los datos sintéticos al comparar el rendimiento de los modelos de ML entrenados en los conjuntos de datos sintéticos y originales y validados en los datos de prueba retenidos del conjunto de datos original. Esto proporciona una Puntuación real de la prueba sintética del tren (TSTR) y Entrenar Prueba Real Real (TRTR) puntuación respectivamente.

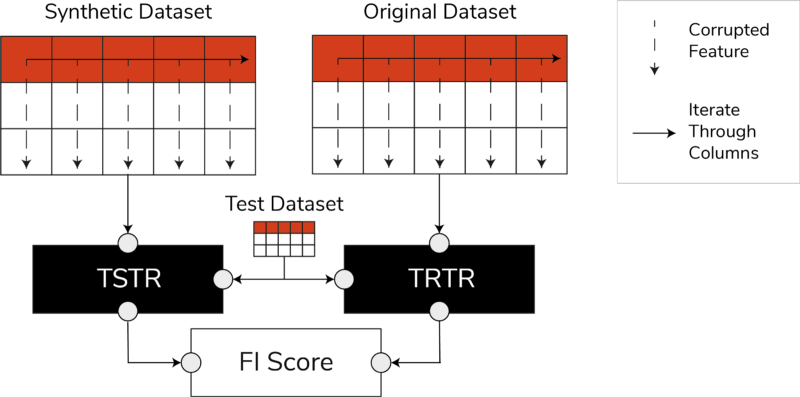

Puntuaciones TSTR, TRTR y la puntuación de importancia de la función (Imagen del autor)

La puntuación incorpora una amplia gama de los algoritmos de ML más confiables para tareas de regresión o clasificación. El uso de varios clasificadores y regresores garantiza que la puntuación sea más generalizable en la mayoría de los algoritmos, de modo que los datos sintéticos puedan considerarse útiles en el futuro.

Al final, si el puntaje TSTR y el puntaje TRTR son comparables, esto indica que los datos sintéticos tienen la calidad para usarse para entrenar modelos ML efectivos para aplicaciones del mundo real.

Puntuación de importancia de la característica

Altamente relacionado con el puntaje de predicción, el puntaje de importancia de la característica (FI) lo amplía al agregar interpretabilidad a los puntajes TSTR y TRTR.

La puntuación F1 compara los cambios y la estabilidad del orden de importancia de la función obtenidos con la puntuación de predicción. Se considera que un conjunto sintético de datos es de gran utilidad si produce el mismo orden de importancia de características que los datos reales originales.

puntuación Q

Para asegurarnos de que un modelo entrenado con nuestros datos recién generados producirá las mismas respuestas a las mismas preguntas que un modelo entrenado con los datos originales, usamos el Qscore. Esto mide el rendimiento descendente de los datos sintéticos mediante la ejecución de muchas consultas aleatorias basadas en agregaciones en los conjuntos de datos sintéticos y originales (y reservados).

La idea aquí es que ambas consultas deberían arrojar resultados similares.

Un QScore alto garantiza que las aplicaciones posteriores que utilizan operaciones de consulta y agregación puedan proporcionar un valor casi igual al del conjunto de datos original.

Métricas para entender la privacidad

Con política de privacidad regulaciones ya vigentes, es una obligación ética y un requisito legal asegurarse de que la información confidencial esté protegida.

Antes de que estos datos sintéticos puedan compartirse libremente y usarse para aplicaciones posteriores, debemos considerar las métricas de privacidad que pueden ayudar a las partes interesadas a comprender dónde se encuentran los datos sintéticos generados en comparación con los datos originales en términos del alcance de la información filtrada. Además, debemos tomar decisiones críticas con respecto a cómo se pueden compartir y utilizar los datos sintéticos.

Puntuación de coincidencia exacta

Una evaluación directa e intuitiva de la privacidad es buscar copias de los datos reales entre los registros sintéticos. La puntuación de coincidencia exacta cuenta el número de registros reales que se pueden encontrar entre el conjunto sintético.

La puntuación debe ser cero, lo que indica que no hay información real tal como está en los datos sintéticos. Esta métrica actúa como un mecanismo de detección antes de evaluar otras métricas de privacidad.

Puntaje de privacidad de los vecinos

Además, la puntuación de privacidad de los vecinos mide la proporción de registros sintéticos que pueden ser demasiado parecidos a los reales. Esto significa que, aunque no son copias directas, son puntos potenciales de fuga de privacidad y una fuente de información útil para ataques de inferencia.

La puntuación se calcula realizando una búsqueda de vecinos más cercanos de alta dimensión en los datos sintéticos superpuestos con los datos originales.

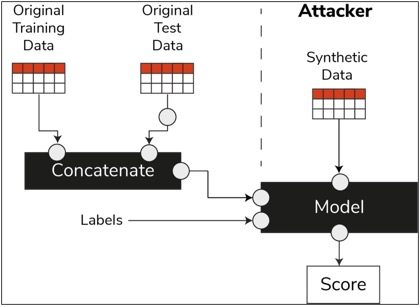

Puntuación de inferencia de membresía

En el ciclo de vida de la ciencia de datos, una vez que se entrena un modelo, ya no necesita acceder a las muestras de entrenamiento y puede hacer predicciones sobre datos no vistos. De manera similar, en nuestro caso, una vez que se entrena el modelo del sintetizador, se pueden generar muestras de datos sintéticos sin necesidad de los datos originales.

A través de un tipo de ataque llamado “ataque de inferencia de membresía”, los atacantes pueden intentar revelar los datos que se usaron para crear los datos sintéticos, sin tener acceso a los datos originales. Esto resulta en un compromiso de la privacidad.

La puntuación de inferencia de membresía mide la probabilidad de que un ataque de inferencia de membresía tenga éxito.

Una puntuación baja sugiere la viabilidad de la inferencia de que un registro en particular era miembro del conjunto de datos de entrenamiento que condujo a la creación de los datos sintéticos. En otras palabras, los ataques pueden inferir detalles de un registro individual, comprometiendo así la privacidad.

Una puntuación de inferencia de pertenencia alta indica que es poco probable que un atacante determine si un registro en particular formaba parte del conjunto de datos original utilizado para crear los datos sintéticos. Esto también significa que la información de ninguna persona se vio comprometida a través de los datos sintéticos.

El concepto de retención

Una práctica recomendada importante que debemos seguir es asegurarnos de que los datos sintéticos sean lo suficientemente generales y no se ajusten demasiado a los datos originales en los que se entrenaron. En el flujo típico de ciencia de datos, mientras construimos modelos ML como un clasificador de bosque aleatorio, reservamos datos de prueba, entrenamos los modelos usando los datos de entrenamiento y evaluamos las métricas en datos de prueba no vistos.

De manera similar, para los datos sintéticos, reservamos una muestra de los datos originales, generalmente denominados conjunto de datos reservados o datos de prueba ocultos ocultos, y evaluamos los datos sintéticos generados contra el conjunto de datos reservados.

Se espera que el conjunto de datos reservados sea una representación de los datos originales, pero no se vio cuando se generaron los datos sintéticos. Por lo tanto, es vital tener puntajes similares para todas las métricas al comparar el original con los conjuntos de datos retenidos y sintéticos.

Cuando se obtienen puntajes similares, podemos establecer que los puntos de datos sintéticos no son el resultado de la memorización de los puntos de datos originales, conservando la misma fidelidad y utilidad.

Reflexiones finales

El mundo está empezando a comprender la importancia estratégica de los datos sintéticos. Como científicos de datos y generadores de datos, es nuestro deber generar confianza en los datos sintéticos que generamos y asegurarnos de que tengan un propósito.

Los datos sintéticos se están convirtiendo en un elemento imprescindible en el conjunto de herramientas de desarrollo de la ciencia de datos. MIT Technology Review ha señaló datos sintéticos como una de las tecnologías innovadoras de 2022. No podemos imaginarnos construir modelos de IA de excelente valor sin datos sintéticos, afirma Gartner.

Según la McKinsey, los datos sintéticos minimizan los costos y las barreras que de otro modo tendría al desarrollar algoritmos u obtener acceso a los datos.

La generación de datos sintéticos se trata de conocer las aplicaciones posteriores y comprender las compensaciones entre las diferentes dimensiones para la calidad de los datos sintéticos.

Resumen

Como usuario de los datos sintéticos, es fundamental definir el contexto del caso de uso para el que se utilizará cada muestra de datos sintéticos en el futuro. Al igual que con los datos reales, la calidad de los datos sintéticos depende del caso de uso previsto, así como de los parámetros elegidos para la síntesis.

Por ejemplo, mantener valores atípicos en los datos sintéticos como en los datos originales es útil para un caso de uso de detección de fraude. Sin embargo, no es útil en un caso de uso de atención médica con problemas de privacidad, ya que los valores atípicos generalmente podrían ser una fuga de información.

Además, existe una compensación entre fidelidad, utilidad y privacidad. Los datos no se pueden optimizar para los tres simultáneamente. Estas métricas permiten a las partes interesadas priorizar lo que es esencial para cada caso de uso y gestionar las expectativas de los datos sintéticos generados.

En última instancia, cuando vemos los valores de cada métrica y cuando cumplen con las expectativas, las partes interesadas pueden confiar en las soluciones que crean utilizando los datos sintéticos.

Los casos de uso de datos sintéticos estructurados cubren una amplia gama de aplicaciones, desde datos de prueba para el desarrollo de software hasta la creación de brazos de control sintéticos en ensayos clínicos.

Comuníquese para explorar estas oportunidades o cree una PoC para demostrar el valor.

faris haddad es el líder de datos e información en el equipo de actividades estratégicas de AABG. Ayuda a las empresas a convertirse con éxito en datos.

faris haddad es el líder de datos e información en el equipo de actividades estratégicas de AABG. Ayuda a las empresas a convertirse con éxito en datos.

- Avanzado (300)

- AI

- arte ai

- generador de arte ai

- robot ai

- Aprendizaje automático de Amazon

- inteligencia artificial

- certificación de inteligencia artificial

- inteligencia artificial en banca

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- Aprendizaje automático de AWS

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- deep learning

- google ai

- máquina de aprendizaje

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- escala ia

- sintaxis

- Procedimientos técnicos

- zephyrnet