Hemos capacitado y estamos abriendo una red neuronal llamada Whisper que se acerca a la robustez y precisión del nivel humano en el reconocimiento del habla en inglés.

Ver código

Ver modelo de tarjeta

Ejemplos de susurros:

Whisper es un sistema de reconocimiento automático de voz (ASR) entrenado en 680,000 horas de datos supervisados multilingües y multitarea recopilados de la web. Mostramos que el uso de un conjunto de datos tan grande y diverso conduce a una mayor solidez a los acentos, el ruido de fondo y el lenguaje técnico. Además, permite la transcripción en varios idiomas, así como la traducción de esos idiomas al inglés. Somos modelos de código abierto y código de inferencia que sirven como base para crear aplicaciones útiles y para futuras investigaciones sobre procesamiento de voz sólido.

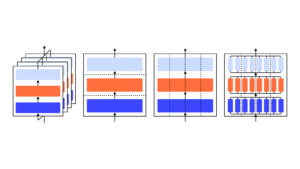

La arquitectura Whisper es un enfoque simple de extremo a extremo, implementado como un transformador codificador-decodificador. El audio de entrada se divide en fragmentos de 30 segundos, se convierte en un espectrograma log-Mel y luego se pasa a un codificador. Se entrena un decodificador para predecir el subtítulo de texto correspondiente, entremezclado con tokens especiales que dirigen al modelo único para realizar tareas como identificación de idioma, marcas de tiempo a nivel de frase, transcripción de voz multilingüe y traducción de voz al inglés.

Otros enfoques existentes utilizan con frecuencia conjuntos de datos de entrenamiento de audio y texto más pequeños y más estrechamente emparejados., o use un preentrenamiento de audio amplio pero no supervisado. Debido a que Whisper se entrenó en un conjunto de datos grande y diverso y no se ajustó a ninguno específico, no supera a los modelos que se especializan en el rendimiento de LibriSpeech, un famoso punto de referencia competitivo en el reconocimiento de voz. Sin embargo, cuando medimos el rendimiento de disparo cero de Whisper en muchos conjuntos de datos diversos, encontramos que es mucho más sólido y comete un 50 % menos de errores que esos modelos.

Alrededor de un tercio del conjunto de datos de audio de Whisper no está en inglés, y alternativamente se le asigna la tarea de transcribir en el idioma original o traducir al inglés. Encontramos que este enfoque es particularmente efectivo para aprender la traducción de voz a texto y supera al SOTA supervisado en CoVoST2 para la traducción al inglés de tiro cero.

Esperamos que la alta precisión y la facilidad de uso de Whisper permitan a los desarrolladores agregar interfaces de voz a un conjunto mucho más amplio de aplicaciones. Revisar la , tarjeta modeloy código para conocer más detalles y probar Whisper.

- AI

- arte ai

- generador de arte ai

- robot ai

- inteligencia artificial

- certificación de inteligencia artificial

- inteligencia artificial en banca

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- deep learning

- google ai

- máquina de aprendizaje

- OpenAI

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- la investigación

- escala ia

- sintaxis

- zephyrnet