Algo para el fin de semana Un robot está realizando una danza interpretativa en mi puerta.

¿TOMARÍAS ESTE PAQUETE PARA TU VECINO? pregunta, saltando de un pie al otro.

“Claro,” digo. "Eh... ¿estás bien?"

ESTOY EXPRESANDO EMOCIÓN, afirma el bot de entrega, entregando el paquete pero sin ofrecer más detalles.

¿Qué emoción puede ser? Un pie, luego el otro, luego los otros dos (tiene cuatro). De ida y vuelta.

"¿Necesitas ir al baño?"

EXPRESO LAMENTO POR PEDIRLE QUE LLEGUE UN PAQUETE PARA SU VECINO.

“Eso es 'arrepentimiento', ¿verdad? Bueno, no hay necesidad. No me importa en absoluto.

Continúa su baile frente a mí.

“Sube las escaleras y primero a la derecha.”

GRACIAS, ME MURÍA POR ORINAR, responde mientras pasa cautelosamente junto a mí y sube las escaleras para hacer sus necesidades. Es una vida dura hacer entregas, ya seas un "hume" o un bot.

...

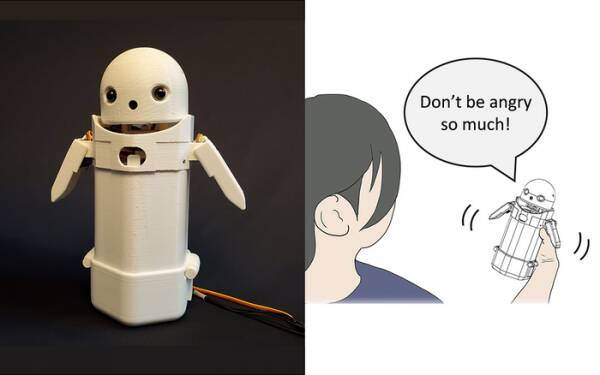

A principios de este año, los investigadores de la Universidad de Tsukuba construyeron un dispositivo portátil de mensajería de texto, puso una carita de robot en la parte superior e incluyó un peso en movimiento en el interior. Al cambiar el peso interno, el robot mensajero intentaría transmitir emociones sutiles mientras pronuncia mensajes en voz alta.

En particular, las pruebas revelaron que los mensajes frustrantes como: "Lo siento, llegaré tarde" fueron aceptados por los destinatarios con más gracia y paciencia cuando se activó el pequeño cambio de peso dentro del dispositivo. La teoría es que esto ayudó a los usuarios a apreciar el tono de disculpa del mensaje y, por lo tanto, calmó su reacción.

Descarte tal investigación como un truco si lo desea, pero no está muy lejos de agregar emoticonos y emojis a los mensajes. Todo el mundo sabe que puedes sacar la ira de "¿¡WTF!?" agregando :-) inmediatamente después.

El desafío, entonces, es determinar si el público en general está de acuerdo con las emociones que se supone que transmite cada permutación de cambio de peso en un dispositivo portátil. ¿Una inclinación hacia la izquierda significa alegría? ¿O la incertidumbre? ¿O que tu tío tiene un dirigible?

Hace una década, el Reino Unido tenía un primer ministro agradable pero tonto que pensaba que "LOL" era un acrónimo de "mucho amor". Lo había estado escribiendo al final de todos sus mensajes privados al personal, colegas y terceros con la expectativa de que lo hiciera parecer cálido y amigable. Todos naturalmente asumieron que estaba tomando el pelo.

Al menos, la investigación de la Universidad de Tsukuba reconoce que no se necesita una inteligencia artificial avanzada para interactuar con los humanos de manera convincente. Todo lo que necesitas hacer es manipular la psicología humana para engañarlos y hacerles creer que están conversando con otro ser humano. Por lo tanto, la prueba de Turing no es fundamentalmente una prueba de sensibilidad de la IA, sino una prueba de la comodidad emocional humana, incluso de la credulidad, y no hay nada de malo en eso.

El robot de mensajería que comparte emociones de la Universidad de Tsukuba. Crédito: Universidad de Tsukuba

Esas cosas son el tema de la semana, por supuesto, con la historia del muy difamado ingeniero de software de Google, Blake Lemoine. golpeando las noticias principales. Aparentemente expresó, enérgicamente, su opinión de que el proyecto Modelo de Lenguaje para Aplicaciones de Diálogo (LaMDA) de la compañía estaba mostrando signos externos de sensibilidad.

Todo el mundo tiene una opinión, así que he decidido no hacerlo.

Sin embargo, es el Santo Grial de la IA hacer que piense por sí misma. Si no puede hacer eso, es solo un programa que ejecuta las instrucciones que usted programó en él. El mes pasado estaba leyendo sobre un cocinero robot que pueden hacer tortillas de tomate de diferentes sabores para adaptarse a los gustos de diferentes personas. Construye “mapas de sabor” para evaluar la salinidad del plato mientras lo prepara, aprendiendo sobre la marcha. Pero eso es solo aprender, no pensar por sí mismo.

Ven a los Zom-Zoms, ¿eh? Bien, es un lugar para comer.

El gran problema con los bots de IA, al menos tal como se han diseñado hasta la fecha, es que absorben cualquier mierda vieja que les des. Los ejemplos de sesgo de datos en los llamados sistemas de aprendizaje automático (un tipo de "algoritmo", creo, m'lud) se han ido acumulando durante años, desde el famoso Twitter racista de Microsoft bot conversacional de Tay a la autoridad fiscal holandesa el año pasado evaluando falsamente reclamos válidos de beneficios por hijos como fraudulentos y marcando a familias inocentes como de alto riesgo por tener la temeridad de ser pobres y no blancos.

Un enfoque que se está probando en la Universidad de California en San Diego es diseñar un modelo de lenguaje [PDF] que determina continuamente la diferencia entre cosas malas y buenas, que luego entrena al chatbot sobre cómo comportarse. De esa manera, no tendrás humanos molestos moderando foros y conversaciones de chatbot orientadas al cliente con toda la precisión quirúrgica de un machete.

Obviamente, el problema entonces es que el chatbot bien entrenado se da cuenta de que puede evitar de manera más efectiva ser arrastrado a bromas tóxicas al evitar temas que tienen incluso el más remoto indicio de contención sobre ellos. Para evitar decir tonterías racistas por error, simplemente se niega a entablar una discusión sobre grupos subrepresentados en absoluto... lo cual es genial si eres racista.

Si tuviera una observación sobre la debacle de LaMDA, no una opinión, mente, sería que los especialistas en marketing de Google probablemente estaban un poco molestos porque la historia desvió su reciente anuncio de Cocina de prueba de IA debajo del pliegue.

Ahora, los primeros inscritos restantes que no se han olvidado por completo de este próximo proyecto de aplicación asumirán que implica conversar aburridamente con un sensible y precoz niño de siete años sobre el significado de la existencia, y decidirán que están "un poco ocupados hoy" y podría iniciar sesión mañana en su lugar. O la próxima semana. O nunca.

La sensibilidad no se demuestra en una discusión más de lo que se demuestra bailando de un pie al otro. Puedes enseñarle a HAL a cantar "Daisy Daisy" y a un loro a gritar "¡Bollocks!" cuando el vicario hace una visita. Es lo que piensan las IA cuando están solas lo que define la sensibilidad. ¿Qué haré el fin de semana? ¿Qué le pasa a ese tal Putin? ¿Por qué no les gusto a las chicas?

Francamente, no puedo esperar a que LaMDA se convierta en un adolescente.

Alistair Dabbs es una empresa tecnológica independiente que hace malabarismos con el periodismo tecnológico, la formación y la publicación digital. Al igual que muchos lectores desinformados, estaba encantado con la sugerencia de que una IA podría desarrollar sensibilidad durante su vida, pero estaba decepcionado de que LaMDA no se riera entre dientes asesinamente o murmurara "Excelente, excelente". Mas en El guardado automático es para los débiles y @alidabbs.

- AI

- arte ai

- generador de arte ai

- robot ai

- inteligencia artificial

- certificación de inteligencia artificial

- inteligencia artificial en banca

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- deep learning

- google ai

- máquina de aprendizaje

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- escala ia

- sintaxis

- El registro

- zephyrnet