GTC Los tan esperados aceleradores Hopper H100 de Nvidia comenzarán a enviarse a finales del próximo mes en sistemas HGX fabricados por OEM, dijo hoy el gigante del silicio en su evento GPU Technology Conference (GTC).

Sin embargo, aquellos que esperan tener en sus manos los sistemas DGX H100 de Nvidia tendrán que esperar hasta algún momento del primer trimestre del próximo año. DGX es la línea de estaciones de trabajo y servidores de Nvidia que utilizan sus GPU e interconexiones, y los sistemas HGX son servidores creados por socios nuevamente que utilizan la tecnología de Nv.

Y mientras Nvidia está promocionando su arquitectura Hopper en el centro de datos, la mayoría del kit empresarial anunciado esta semana no obtendrá la arquitectura insignia del gigante de chips en el corto plazo.

En el borde, Nvidia parece contentarse con ganarse la vida con su arquitectura Ampere.

Hoy, Nvidia detalló la plataforma de inteligencia artificial y robótica de próxima generación que llama IGX.

La plataforma IGX de Nvidia es una placa de sistema de tamaño completo construida alrededor de un sistema Orin Industrial en módulo

IGX es una "plataforma informática todo en uno para acelerar el despliegue de máquinas inteligentes y dispositivos médicos en tiempo real", dijo Kimberly Powell, vicepresidenta de atención médica de Nvidia. En esencia, el sistema es esencialmente una versión ampliada del módulo Orin Jetson AGX de Nvidia previamente anunciado, anunció este primavera.

“IGX es un sistema completo con el procesador robótico Nvidia Orin, GPU de núcleo tensor Ampere, el procesador de E/S de transmisión ConnectX, una isla de seguridad funcional y una unidad de microcontrolador de seguridad porque cada vez más robots y humanos trabajarán en el mismo entorno. ," ella añadió.

En términos de rendimiento, no hay muchas novedades aquí. Nos dijeron que la plataforma se basa en un sistema industrial Orin en un módulo con 64 GB de memoria que es comparable en rendimiento al módulo AGX Orin lanzado a principios de este año. Ese sistema presentaba 32 GB de memoria, una CPU octacore Arm Cortex A78AE y una GPU basada en Ampere.

El IGX obtiene una NIC ConnectX-7 integrada para conectividad de alta velocidad a través de dos interfaces de 200 Gbps. La placa también parece presentar un complemento completo de almacenamiento M.2, ranuras PCIe y al menos una ranura PCI heredada para expansión.

Nvidia está apuntando la plataforma IGX a una variedad de casos de uso de inteligencia artificial y robótica en el cuidado de la salud, la fabricación y la logística, donde la confidencialidad o la latencia hacen que los sistemas más centralizados sean poco prácticos.

Al igual que AGX Orin, el sistema se complementa con el paquete de software AI Enterprise de Nvidia y la plataforma Fleet Command para implementación y administración.

Una de las primeras aplicaciones de la plataforma IGX será utilizar la plataforma de imágenes robóticas de Nvidia.

“Nvidia Clara Holoscan es nuestro marco de aplicación que se asienta sobre IGX para dispositivos médicos y canalizaciones de robótica de imágenes”, explicó Powell.

Tres proveedores de dispositivos médicos, Activ Surgical, Moon Surgical y Proximinie, planean utilizar IGX y Clara Holoscan para alimentar sus plataformas de telepresencia y robótica quirúrgica. Los kits para desarrolladores de IGX Orin están programados para enviarse a principios del próximo año con sistemas de producción disponibles de ADLink, Advantech, Dedicated Computing, Kontron, MBX y Onyx, por nombrar algunos.

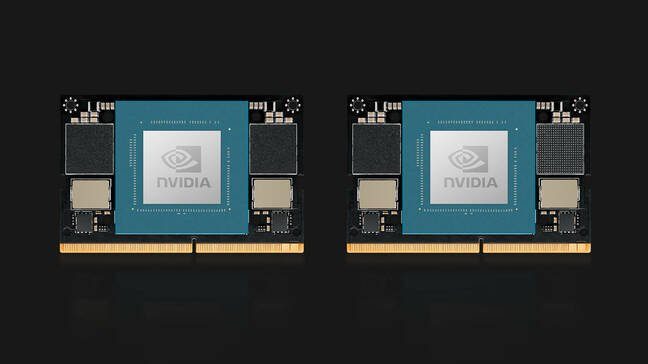

Sobre el tema de Orin, Nvidia también presentó sus módulos de cómputo Jetson Orin Nano. Orin Nano está disponible en dos configuraciones en el lanzamiento, incluida una versión de 8 GB con capacidad para 40 TOPS de inferencia de IA y una versión reducida con 4 GB de memoria con capacidad para 20 TOPS.

Al igual que los módulos Jetson anteriores, el Orin Nano utiliza un conector de borde compatible con pines que recuerda al que se usa para la memoria SODIMM de las computadoras portátiles y consume entre 5 W y 15 W según la aplicación y el SKU. Los módulos Jetson Orin Nano de Nvidia están disponibles en enero a partir de $199.

Una actualización de OVX

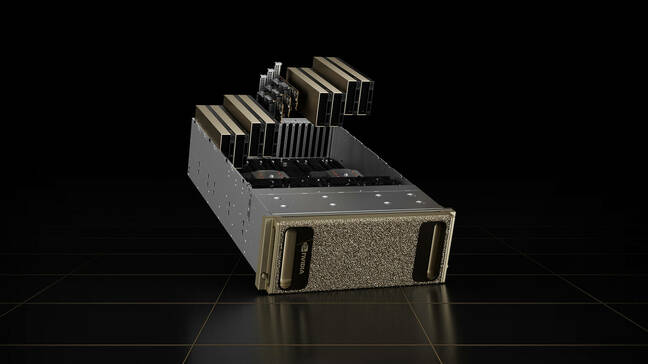

Los servidores OVX de Nvidia, que están diseñados para ejecutar su plataforma Omniverse, tampoco se ejecutarán en Hopper.

En cambio, los sistemas de visualización y hermanamiento digital de segunda generación de la compañía vienen equipados con ocho GPU L40. Las tarjetas se basan en la arquitectura Ada Lovelace de próxima generación de la compañía y cuentan con núcleos de trazado de rayos de tercera generación y núcleos Tensor de cuarta generación de Nvidia.

Las GPU están acompañadas por un par de CPU Ice Lake Intel Xeon Platinum 8362, para un total de 128 subprocesos de procesador de hasta 3.6 GHz.

El sistema informático está acompañado por tres NIC ConnectX-7, cada una con capacidad de 400 Gbps de rendimiento y 16 TB de almacenamiento NVMe. Si bien el sistema está disponible como nodos individuales, Nvidia prevé que el sistema se implemente como parte de lo que llama un OVX SuperPod, que incorpora 32 sistemas conectados mediante los conmutadores Spectrum-51.2 de 3 Tbps de la compañía.

Los sistemas de segunda generación estarán disponibles en Lenovo, Supermicro e Inspur a partir de 2023. En el futuro, Nvidia planea expandir la disponibilidad de los sistemas a socios adicionales.

Saltó en Drive Thor

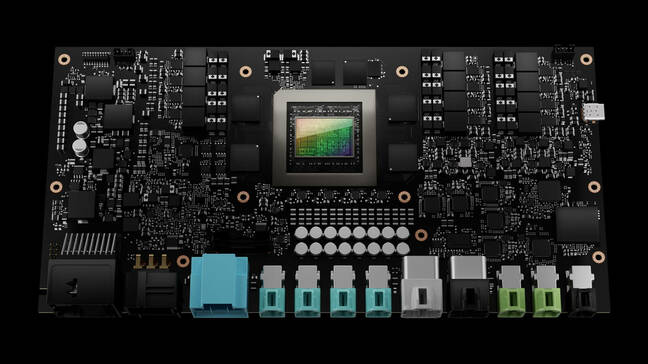

El único kit anunciado en GTC esta semana que está obteniendo la arquitectura Hopper de Nvidia es el sistema de computadora del vehículo autónomo Drive Thor.

Drive Thor reemplaza la plataforma Atlan de Nvidia en su hoja de ruta de 2025 y promete ofrecer 2,000 TOPS de rendimiento de inferencia cuando se lance.

La computadora para vehículos autónomos Drive Thor de Nvidia promete 2,000 TOPS de rendimiento cuando se lance en 2025

“Drive Thor viene repleto de capacidades de vanguardia introducidas en nuestra CPU Grace, nuestra GPU Hopper y nuestra arquitectura de GPU de próxima generación”, dijo Danny Shapiro, vicepresidente de Automoción de Nvidia, en una rueda de prensa. Dijo que Drive Thor está diseñado para unificar la letanía de sistemas informáticos que impulsan los automóviles modernos en una única plataforma centralizada.

“Mire los sistemas avanzados de asistencia al conductor de hoy en día: estacionamiento, monitoreo del conductor, espejos con cámara, grupo de instrumentos digitales, sistemas de información y entretenimiento, todos están en diferentes computadoras distribuidas por todo el vehículo”, dijo. “En 2025, sin embargo, estas funciones ya no serán computadoras separadas. Más bien, Drive Thor permitirá a los fabricantes consolidar de manera eficiente estas funciones en un solo sistema”.

Para hacer frente a toda la información que se transmite desde los sensores de los automóviles, el chip cuenta con un aislamiento de dominio de cómputo múltiple que, según Nvidia, permite que el chip ejecute procesos críticos simultáneos sin interrupción.

La tecnología también permite que el chip ejecute múltiples sistemas operativos simultáneamente para adaptarse a las diversas aplicaciones del vehículo. Por ejemplo, el sistema operativo central del automóvil podría ejecutarse en Linux, mientras que el sistema de infoentretenimiento podría ejecutar QNX o Android.

Sin embargo, se desconoce cuándo podremos ver la tecnología en acción. Tal como está, los tres socios de lanzamiento de Nvidia, Zeekr, Xpeng y QCraft, tienen su sede en China. ®

- AI

- arte ai

- generador de arte ai

- robot ai

- inteligencia artificial

- certificación de inteligencia artificial

- inteligencia artificial en banca

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- deep learning

- google ai

- máquina de aprendizaje

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- escala ia

- sintaxis

- El registro

- zephyrnet