Introducción

En el aprendizaje automático, la compensación sesgo-varianza es un concepto fundamental que afecta el rendimiento de cualquier modelo predictivo. Se refiere al delicado equilibrio entre el error de sesgo y el error de varianza de un modelo, ya que es imposible minimizar ambos simultáneamente. Lograr el equilibrio correcto es crucial para lograr un rendimiento óptimo del modelo.

En este breve artículo, definiremos el sesgo y la varianza, explicaremos cómo afectan un modelo de aprendizaje automático y brindaremos algunos consejos prácticos sobre cómo manejarlos en la práctica.

Comprender el sesgo y la varianza

Antes de profundizar en la relación entre el sesgo y la varianza, definamos qué representan estos términos en el aprendizaje automático.

El error de sesgo se refiere a la diferencia entre la predicción de un modelo y los valores correctos que intenta predecir (verdad fundamental). En otras palabras, el sesgo es el error que comete un modelo debido a sus suposiciones incorrectas sobre la distribución de datos subyacente. Los modelos de alto sesgo a menudo son demasiado simplistas y no logran capturar la complejidad de los datos, lo que lleva a un ajuste insuficiente.

El error de varianza, por otro lado, se refiere a la sensibilidad del modelo a las pequeñas fluctuaciones en los datos de entrenamiento. Los modelos de alta varianza son demasiado complejos y tienden a ajustarse al ruido de los datos, en lugar del patrón subyacente, lo que lleva a un sobreajuste. Esto da como resultado un rendimiento deficiente en datos nuevos e invisibles.

Un alto sesgo puede conducir a un ajuste insuficiente, donde el modelo es demasiado simple para capturar la complejidad de los datos. Hace fuertes suposiciones sobre los datos y no logra capturar la verdadera relación entre las variables de entrada y salida. Por otro lado, una varianza alta puede conducir a un ajuste excesivo, donde el modelo es demasiado complejo y aprende el ruido de los datos en lugar de la relación subyacente entre las variables de entrada y salida. Por lo tanto, los modelos sobreajustados tienden a ajustarse demasiado a los datos de entrenamiento y no se generalizarán bien a los nuevos datos, mientras que los modelos con ajuste insuficiente ni siquiera pueden ajustar los datos de entrenamiento con precisión.

Como se mencionó anteriormente, el sesgo y la varianza están relacionados, y un buen modelo equilibra el error de sesgo y el error de varianza. La compensación sesgo-varianza es el proceso de encontrar el equilibrio óptimo entre estas dos fuentes de error. Es probable que un modelo con un sesgo bajo y una varianza baja funcione bien tanto en el entrenamiento como en los datos nuevos, minimizando el error total.

La compensación de sesgo-varianza

Lograr un equilibrio entre la complejidad del modelo y su capacidad para generalizar a datos desconocidos es el núcleo de la compensación entre sesgo y varianza. En general, un modelo más complejo tendrá un sesgo más bajo pero una varianza más alta, mientras que un modelo más simple tendrá un sesgo más alto pero una varianza más baja.

Dado que es imposible minimizar simultáneamente el sesgo y la varianza, encontrar el equilibrio óptimo entre ellos es crucial para construir un modelo sólido de aprendizaje automático. Por ejemplo, a medida que aumentamos la complejidad de un modelo, también aumentamos la varianza. Esto se debe a que es más probable que un modelo más complejo se ajuste al ruido en los datos de entrenamiento, lo que conducirá a un sobreajuste.

Por otro lado, si mantenemos el modelo demasiado simple, aumentaremos el sesgo. Esto se debe a que un modelo más simple no podrá capturar las relaciones subyacentes en los datos, lo que conducirá a un ajuste insuficiente.

El objetivo es entrenar un modelo que sea lo suficientemente complejo para capturar las relaciones subyacentes en los datos de entrenamiento, pero no tan complejo como para que se ajuste al ruido de los datos de entrenamiento.

Compensación de sesgo-varianza en la práctica

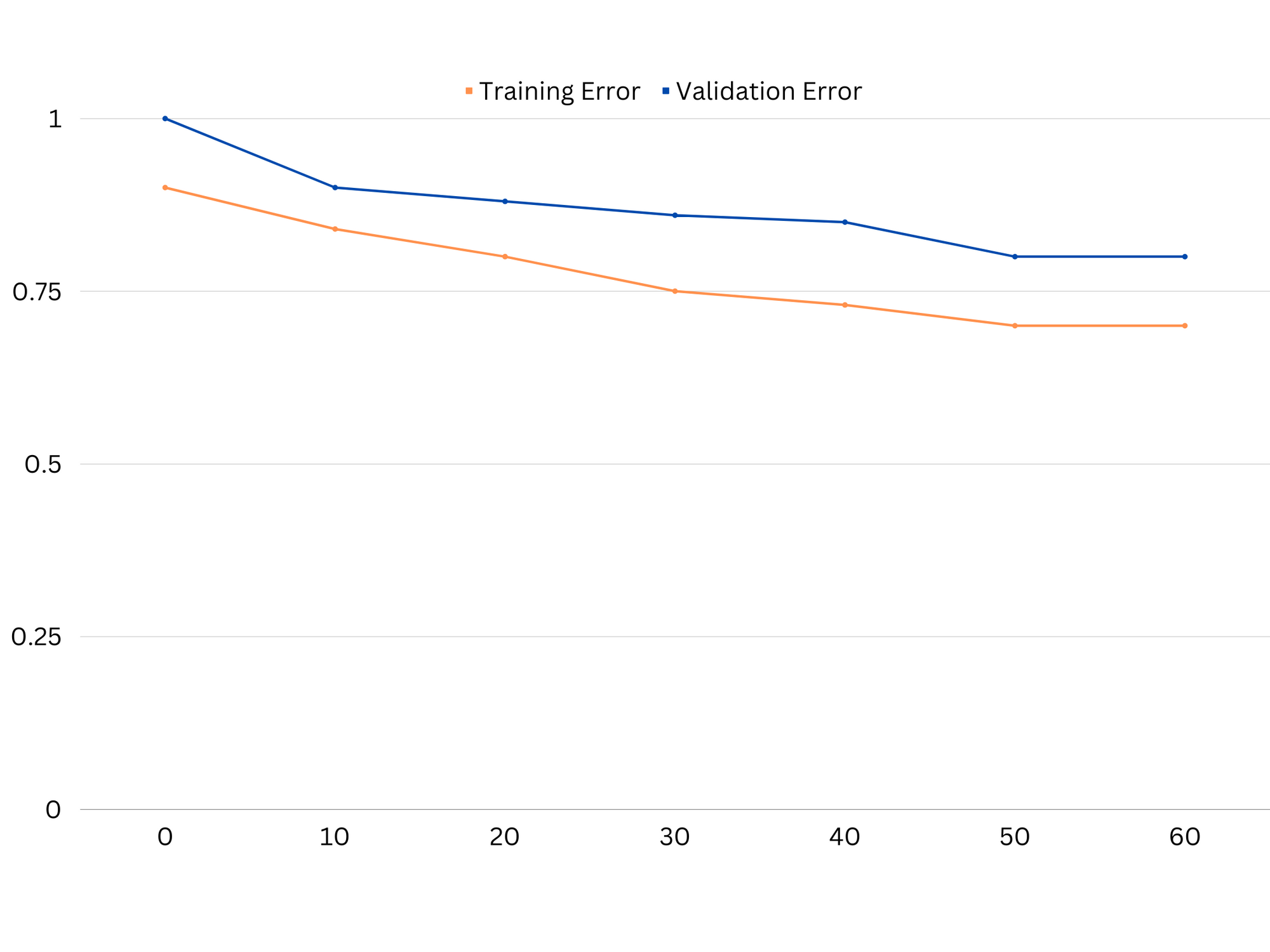

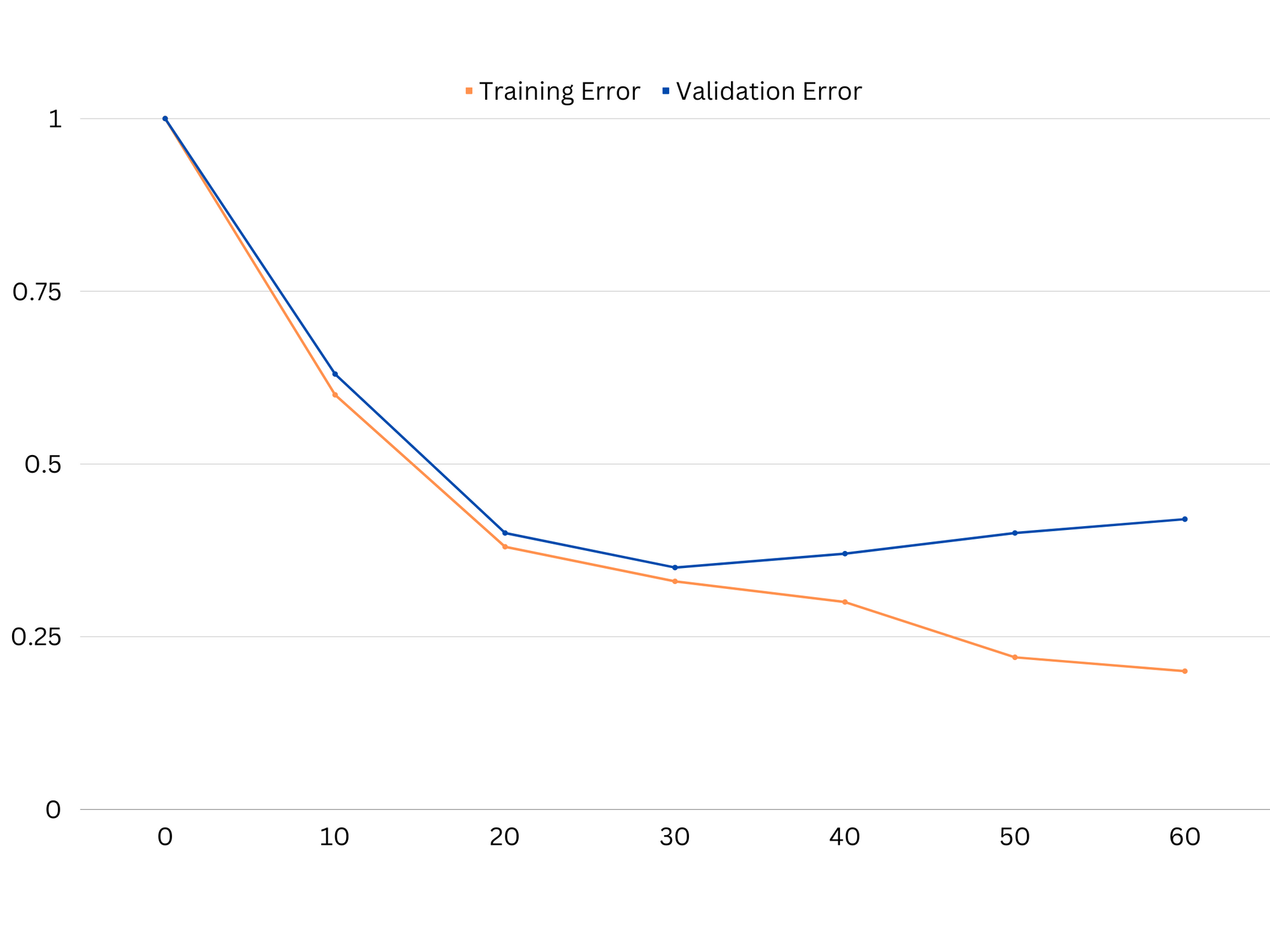

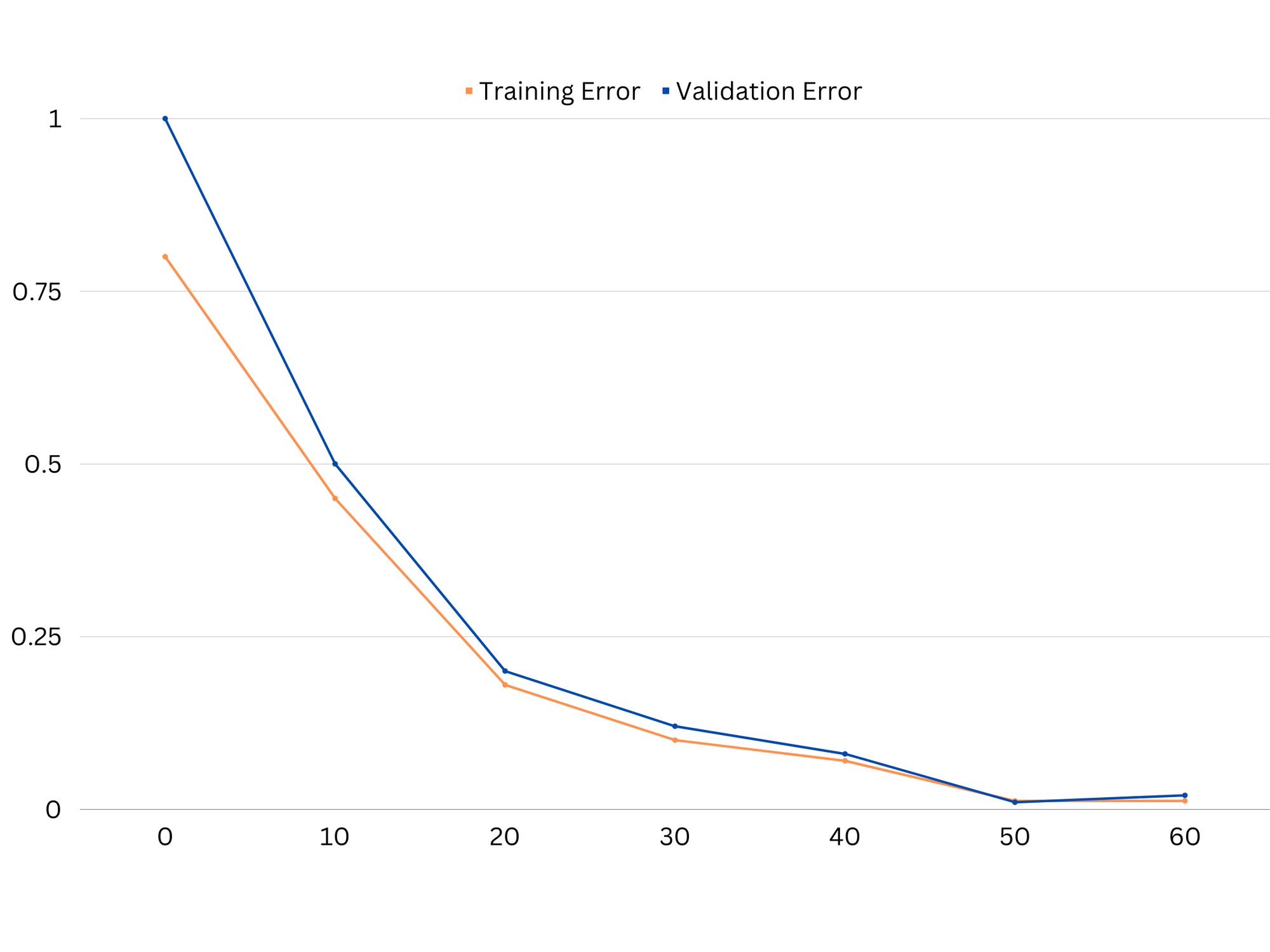

Para diagnosticar el rendimiento del modelo, normalmente calculamos y comparamos los errores de tren y validación. Una herramienta útil para visualizar esto es un gráfico de las curvas de aprendizaje, que muestra el rendimiento del modelo tanto en el tren como en los datos de validación a lo largo del proceso de entrenamiento. Al examinar estas curvas, podemos determinar si un modelo se ajusta en exceso (varianza alta), se ajusta mal (sesgo alto) o se ajusta bien (equilibrio óptimo entre sesgo y varianza).

Ejemplo de curvas de aprendizaje de un modelo de underfitting. Tanto el error de tren como el error de validación son altos.

En la práctica, el bajo rendimiento de los datos de entrenamiento y validación sugiere que el modelo es demasiado simple, lo que lleva a un ajuste insuficiente. Por otro lado, si el modelo funciona muy bien con los datos de entrenamiento pero mal con los datos de prueba, es probable que la complejidad del modelo sea demasiado alta, lo que resultará en un sobreajuste. Para abordar el ajuste insuficiente, podemos intentar aumentar la complejidad del modelo agregando más funciones, cambiando el algoritmo de aprendizaje o eligiendo diferentes hiperparámetros. En el caso de sobreajuste, deberíamos considerar regularizar el modelo o usar técnicas como la validación cruzada para mejorar sus capacidades de generalización.

Ejemplo de curvas de aprendizaje de un modelo de sobreajuste. El error de tren disminuye mientras que el error de validación comienza a aumentar. El modelo no puede generalizar.

La regularización es una técnica que se puede utilizar para reducir el error de varianza en los modelos de aprendizaje automático, lo que ayuda a abordar el equilibrio entre sesgo y varianza. Hay varias técnicas de regularización diferentes, cada una con sus propias ventajas y desventajas. Algunas técnicas de regularización populares incluyen la regresión de cresta, la regresión de lazo y la regularización de red elástica. Todas estas técnicas ayudan a evitar el sobreajuste al agregar un término de penalización a la función objetivo del modelo, lo que desalienta los valores extremos de los parámetros y fomenta modelos más simples.

Regresión de cresta, también conocido como regularización L2, agrega un término de penalización proporcional al cuadrado de los parámetros del modelo. Esta técnica tiende a dar como resultado modelos con valores de parámetros más pequeños, lo que puede conducir a una varianza reducida y una mejor generalización. Sin embargo, no realiza la selección de funciones, por lo que todas las funciones permanecen en el modelo.

Consulte nuestra guía práctica y práctica para aprender Git, con las mejores prácticas, los estándares aceptados por la industria y la hoja de trucos incluida. Deja de buscar en Google los comandos de Git y, de hecho, aprenden ella!

regresión de lazo, o regularización L1, agrega un término de penalización proporcional al valor absoluto de los parámetros del modelo. Esta técnica puede conducir a modelos con valores de parámetros escasos, realizando de manera efectiva la selección de características al establecer algunos parámetros en cero. Esto puede resultar en modelos más simples que son más fáciles de interpretar.

Regularización de red elástica es una combinación de regularización L1 y L2, lo que permite un equilibrio entre la regresión de cresta y lazo. Al controlar la relación entre los dos términos de penalización, la red elástica puede lograr los beneficios de ambas técnicas, como una mejor generalización y selección de características.

Ejemplo de curvas de aprendizaje de modelo de buen ajuste.

Conclusiones

La compensación de sesgo-varianza es un concepto crucial en el aprendizaje automático que determina la efectividad y la bondad de un modelo. Si bien un sesgo alto conduce a un ajuste insuficiente y una variación alta conduce a un ajuste excesivo, es necesario encontrar el equilibrio óptimo entre los dos para construir modelos sólidos que generalicen bien los datos nuevos.

Con la ayuda de las curvas de aprendizaje, es posible identificar problemas de sobreajuste o desajuste, y ajustando la complejidad del modelo o implementando técnicas de regularización, es posible mejorar el rendimiento de los datos de entrenamiento y validación, así como de los datos de prueba.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoAiStream. Inteligencia de datos Web3. Conocimiento amplificado. Accede Aquí.

- Acuñando el futuro con Adryenn Ashley. Accede Aquí.

- Compra y Vende Acciones en Empresas PRE-IPO con PREIPO®. Accede Aquí.

- Fuente: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :es

- :no

- :dónde

- 1

- 12

- 20

- 8

- a

- capacidad

- Poder

- Nuestra Empresa

- Absoluto

- precisamente

- Lograr

- el logro de

- la adición de

- dirección

- Añade

- ventajas

- consejos

- afectar

- afectando

- algoritmo

- Todos

- Permitir

- también

- an

- y

- cualquier

- somos

- artículo

- AS

- Balance

- saldos

- BE

- porque

- beneficios

- entre

- parcialidad

- frontera

- ambas

- Construir la

- pero

- by

- calcular

- PUEDEN

- capacidades

- capturar

- case

- cambio

- la elección de

- de cerca

- combinación

- comparar

- integraciones

- complejidad

- concepto

- Considerar

- CONTROL

- Core

- correcta

- crucial

- datos

- acuerdo

- disminuye

- Determinar

- determina

- un cambio

- una experiencia diferente

- sí

- dos

- cada una

- Más temprano

- más fácil

- de manera eficaz

- eficacia

- anima

- suficientes

- error

- Errores

- Incluso

- Examinar

- ejemplo

- Explicar

- extremo

- fallando

- falla

- Feature

- Caracteristicas

- la búsqueda de

- cómodo

- adecuado

- fluctuaciones del mercado.

- Focus

- función

- fundamental

- General

- Git

- objetivo

- candidato

- Polo a Tierra

- guía

- mano

- emprendedor

- Tienen

- ayuda

- ayudando

- Alta

- más alto

- flotar

- Cómo

- Como Hacer

- Sin embargo

- HTTPS

- Identifique

- if

- implementación

- imposible

- mejorar

- mejorado

- in

- En otra

- incluir

- incluido

- aumente

- creciente

- Las opciones de entrada

- dentro

- Introducción

- IT

- SUS

- Guardar

- conocido

- L1

- l2

- Lead

- líder

- Prospectos

- aprendizaje

- dejar

- LG

- como

- que otros

- ll

- Baja

- inferior

- máquina

- máquina de aprendizaje

- HACE

- mencionado

- minimizando

- modelo

- modelos

- más,

- necesario

- red

- Nuevo

- ruido

- número

- objetivo

- of

- a menudo

- on

- óptimo

- or

- Otro

- nuestros

- salir

- salida

- EL DESARROLLADOR

- parámetro

- parámetros

- Patrón de Costura

- Realizar

- actuación

- realizar

- realiza

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- pobre

- Popular

- posible

- Metodología

- predecir

- predicción

- evitar

- problemas

- proporcionar

- más bien

- proporción

- reducir

- Reducción

- se refiere

- relacionado

- relación

- Relaciones

- permanecer

- representar

- resultado

- resultante

- Resultados

- Derecho

- Anillos

- robusto

- s

- selección

- Sensibilidad

- pólipo

- Shadow

- hoja

- En Corto

- tienes

- sencillos

- simultáneamente

- chica

- menores

- So

- algo

- Fuentes

- cuadrado

- Abuso de pila

- estándares de salud

- Detener

- fuerte

- tal

- Sugiere

- técnicas

- término

- términos

- test

- que

- esa

- La

- su

- Les

- Ahí.

- Estas

- ellos

- así

- a lo largo de

- a

- demasiado

- del IRS

- Total

- Entrenar

- Formación

- transición

- verdadero

- verdad

- try

- dos

- típicamente

- incapaz

- subyacente

- desconocido

- usado

- usando

- validación

- propuesta de

- Valores

- muy

- we

- WELL

- ¿

- sean

- que

- mientras

- seguirá

- palabras

- zephyrnet

- cero