Sí... Estoy hablando de las aplicaciones de IA: nuestra miríada de aplicaciones de IA y las próximas que susurran a los humanos sobre qué hacer... cómo hacerlo... pero no sobre los susurradores que interactúan con los chatbots de IA.

Según la IDC Según nuestras predicciones, el mercado global de IA podría alcanzar más de $ 500 mil millones para 2024, un aumento de más del 50 % desde 2021. Esto indica que pasamos de los experimentos comerciales a aceptar que es una parte integral de la estrategia empresarial para todos los tamaños. Es una herramienta necesaria para convertir los datos en conocimientos para generar acciones basadas en mejores decisiones. Nadie debate los beneficios de la IA para disminuir el riesgo comercial y amplificar el ROI con la innovación. Pero, como siempre, hay un... PERO... la IA imparcial es más fácil decirlo que hacerlo.

Críticos para el negocio, estos modelos de IA deben operar de manera confiable con visibilidad y responsabilidad. De lo contrario, el fracaso, en este caso, tiene consecuencias nefastas que impactan el flujo de caja de cualquier empresa e incluso pueden resultar en asuntos legales. La única forma de evitar esto es la automatización y la transparencia para responder a una pregunta "¿Puede probar que esta aplicación/carga de trabajo de IA está construida éticamente?". Aka... ¿cómo se gobierna? ¿Y puedes probar que está siendo gobernado continuamente?

Aquí es donde a las empresas les gusta IBM han invertido en la gobernanza de IA para orquestar el proceso general de dirección, gestión y seguimiento de las actividades de IA de la organización. El trabajo principal es garantizar que todas las unidades comerciales se mantengan proactivas e infundir el marco de gobierno en las iniciativas para fortalecer la capacidad de cumplir con los principios y las normas éticas. Especialmente, las industrias reguladas como la banca y los servicios financieros están legalmente obligadas a proporcionar evidencia para satisfacer a los reguladores.

La influencia de la IA está creciendo exponencialmente en el sector de los servicios financieros debido a la tremenda presión de la transformación digital. Como se dijo, es más fácil decirlo que hacerlo porque:

1. Operar con confianza las aplicaciones de IA:

En algunos casos, los modelos se construyen sin claridad y catalogación; no hace falta decir que el monitoreo se escapa en medio de todo para rastrear el ciclo de vida de extremo a extremo. Mientras los bancos luchan con las aplicaciones heredadas, la automatización de los procesos para crear transparencia y explicabilidad se volvió más difícil y, a su vez, una caja negra. Nadie sabe por qué/cómo se tomaron las decisiones. Las nuevas aplicaciones enredadas con aplicaciones heredadas nunca ven la luz del día, aunque se asocia con un gran retorno de la inversión debido a la calidad y los riesgos no percibidos.

Eso nos lleva a nuestro segundo punto: gestionar el riesgo de reputación.

2. Gestionar el riesgo reputacional junto con el riesgo general

he preguntado #chatGPT y #Bardo – quién es Padma Chukka. #ChatGPT se negó a responder incluso si cambié la pregunta de varias maneras. Aún así, Bard me dio una respuesta detallada, incluido mi perfil de LinkedIn... pero los datos provienen de varios sitios donde mi perfil anterior todavía existe como parte de la biografía del orador. A partir de ese momento, todavía tengo que abrir el Bardo. Así de rápido, me apagué, también conocido como – Riesgo de reputación. Supongamos que puedo desactivar un chatbot simple cuando me doy cuenta de que los datos pueden ser inconsistentes. ¿Cómo podría no estar seguro antes de decidir comprar una aplicación infundida con IA para realizar negocios críticos? El riesgo reputacional es un factor esencial que a veces las empresas olvidan. Si cuantifica el riesgo reputacional, uno puede ver el tremendo impacto en el negocio si uno no es proactivo.

Para agregar a la complejidad, el tercero es...

3. ¿Cómo puede responder una empresa a las cambiantes regulaciones de IA?

Para evitar el riesgo de reputación, un equipo de IA exitoso y responsable debe estar al tanto de todas las regulaciones locales y globales, cayendo como un video de tic-tac con un aviso de un momento. Y el incumplimiento puede, en última instancia, costarle a una organización millones de dólares en multas relacionadas con el trabajo, como la propuesta Ley de IA de la UE. Puede ser hasta 30 millones de euros o el 6 % de los ingresos globales de la empresa: OUCH.

Bueno, no todo tiene que ser color de rosa desde el principio... siempre y cuando sepamos cómo hacer un cambio de imagen de una situación aterradora a una situación color de rosa.

Sin sorpresas... siempre se trata de personas, procesos y tecnología. Entonces, primero, cree un órgano de gobierno multifuncional para educar, dirigir y monitorear las iniciativas en función de los objetivos. Luego, compare la tecnología y los procesos de IA actuales, comprenda las brechas y luego corrija a prueba de futuro. Luego recurra a un conjunto de flujos de trabajo de gobernanza automatizados en línea con los requisitos de cumplimiento. Finalmente, configure un sistema de monitoreo para alertar a los propietarios si el umbral aceptable se está acercando. Desde el lado de la tecnología, una IA bien diseñada, bien ejecutada y bien conectada requiere varios componentes básicos. Y asegúrese de que tenga algunas o todas las capacidades:

· Integridad de datos en diversas implementaciones

· Usar herramientas existentes abiertas y flexibles que se adhieran a la gobernabilidad de la IA

· Asegúrese de ofrecer acceso de autoservicio con controles de privacidad: una forma de rastrear

· Diseñar teniendo en cuenta la automatización y el gobierno de la IA

· Puede conectarse y ser personalizable para múltiples partes interesadas a través de un flujo de trabajo personalizable

Una vez que hagamos un cambio de imagen de la aplicación de Scary a Rosy... entonces la siguiente pregunta es cómo probar...

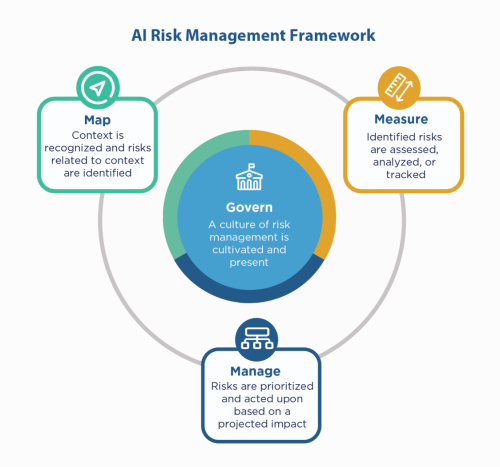

En primer lugar, recurra a los principios de IA de la empresa: construya con ellos y, sin embargo, aún necesita "demostrar" que cumple, especialmente en entornos regulados como los servicios financieros. Dado que los servicios financieros deben quejarse con NIST 800-53, podrían consultar el Marco de gestión de riesgos de IA NIST (AI RMF). NIST sugirió los controles en cuatro familias: gobernar, mapear, medir y administrar. Usar eso como un factor guía y hacer una prueba de estrés de las aplicaciones para identificar las brechas para remediar y monitorear.

IBM puede validar sus modelos antes de que los ponga en producción, y puede monitorear su imparcialidad, calidad y deriva. También puede proporcionar documentación que explique el comportamiento y las predicciones del modelo para satisfacer los requisitos de los reguladores y auditores. Estas explicaciones pueden brindar visibilidad y aliviar el dolor de la auditoría, y aumentar la transparencia y la capacidad de determinar los posibles riesgos.

¡Escucha esos susurros de IA con confianza!

#Servicios financieros #responsableai #éticoai #NISTAIRMF

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Acuñando el futuro con Adryenn Ashley. Accede Aquí.

- Fuente: https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- :es

- $ UP

- 2021

- 2024

- 7

- a

- capacidad

- Nuestra Empresa

- aceptable

- de la máquina

- seguimiento semanal

- a través de

- Actúe

- la columna Acción

- actividades

- adherirse

- AI

- Ley de IA

- Gobernanza de la IA

- aka

- Alertar

- Todos

- hacerlo

- y

- https://www.youtube.com/watch?v=xB-eutXNUMXJtA&feature=youtu.be

- applicación

- Aplicación

- aplicaciones

- aplicaciones

- somos

- en torno a

- AS

- asociado

- At

- auditoría

- los auditores

- Confirmación de Viaje

- automatizar

- Automatización

- Atrás

- Bancario

- Bancos

- basado

- BE

- porque

- antes

- "Ser"

- beneficios

- mejores

- mil millones

- Negro

- Bloques

- cuerpo

- Box

- Trae

- build

- Construir la

- construido

- comprar

- by

- PUEDEN

- capacidades

- case

- cases

- efectivo

- flujo de fondos

- cambio

- chatterbot

- Chatbots

- transparencia

- cierre

- Empresas

- compañía

- complejidad

- compliance

- obediente

- Conducir

- con confianza

- Contacto

- Consecuencias

- continuamente

- controles

- Cost

- podría

- Para crear

- crítico

- Current

- personalizable

- Cycle

- datos

- debatiendo

- Decidir

- decisiones

- disminuir

- Diseño

- detallado

- Determinar

- digital

- Transformación Digital

- terrible

- de reservas

- dirigiendo

- diverso

- documentación

- dólares

- Dejar caer

- más fácil

- educar

- de extremo a extremo

- garantizar

- Empresa

- ambientes

- especialmente

- esencial

- ético

- EU

- Euros

- Incluso

- Cada

- todo

- evidencia sólida

- existente

- existe

- explicando

- exponencialmente

- Fracaso

- justicia

- Otoño

- familias

- Finalmente

- financiero

- servicios financieros

- multas

- Finextra

- Nombre

- flexible

- de tus señales

- Marco conceptual

- Desde

- de 2021

- futuras

- Donar

- Buscar

- gobierno

- Creciendo

- Tienen

- Cómo

- Como Hacer

- HTTPS

- enorme

- Humanos

- i

- Identifique

- Impacto

- in

- Incluye

- aumente

- Indica

- industrias

- influir

- iniciativas

- Innovation

- Insights

- un elemento indispensable

- integridad

- interactuar

- será invertido

- IT

- SUS

- Trabajos

- Saber

- Legado

- Legal

- asuntos legales

- Vida

- como

- línea

- Etiqueta LinkedIn

- local

- Largo

- Mira

- hecho

- para lograr

- gestionan

- Management

- administrar

- mapa

- Mercado

- Cuestiones

- Puede..

- medir

- Conoce a

- podría

- millones

- millones

- modelo

- modelos

- momento

- Monitorear

- monitoreado

- monitoreo

- más,

- múltiples

- necesario

- ¿ Necesita ayuda

- Innecesario

- Nuevo

- Next

- nist

- ,

- of

- LANZAMIENTO

- Viejo

- on

- ONE

- habiertos

- funcionar

- organización

- de otra manera

- total

- los propietarios de

- Dolor

- parte

- Personas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- punto

- posible

- Predicciones

- presión

- primario

- principios

- política de privacidad

- Proactiva

- en costes

- Producción

- Mi Perfil

- prueba

- propuesto

- Demostrar.

- proporcionar

- poner

- calidad

- pregunta

- con rapidez

- en comunicarse

- darse cuenta de

- regulados

- industrias reguladas

- Regulación

- reglamentos

- Reguladores

- reputación

- Requisitos

- Requisitos

- requiere

- Responder

- responsable

- resultado

- ingresos

- Riesgo

- Gestión sistemática del riesgo,

- riesgos

- ROI

- Rosado

- s

- Said

- Segundo

- sector

- Autoservicio

- Servicios

- set

- tienes

- Mostrar

- lado

- sencillos

- desde

- Sitios Web

- situación

- tamaños

- So

- algo

- Spark

- Speaker

- las partes interesadas

- quedarse

- Sin embargo

- Estrategia

- FORTALECIMIENTO

- estrés

- Luchando

- exitosos

- te

- hablar

- equipo

- Tecnología

- test

- esa

- La

- Les

- Estas

- Código

- umbral

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- a

- del IRS

- seguir

- Transparencia

- tremendo

- GIRO

- Convertido

- Finalmente, a veces

- entender

- unidades que

- próximos

- us

- utilizan el

- VALIDAR

- diversos

- Video

- la visibilidad

- Camino..

- formas

- ¿

- mientras

- QUIENES

- sin

- Actividades:

- flujos de trabajo

- Usted

- tú

- zephyrnet