Muchas aplicaciones destinadas al mantenimiento de equipos industriales, el control del comercio, la gestión de flotas y la optimización de rutas se crean utilizando controladores y API Cassandra de código abierto para procesar datos a alta velocidad y baja latencia. Administrar las tablas de Cassandra usted mismo puede llevar mucho tiempo y ser costoso. Amazon Keyspaces (para Apache Cassandra) le permite configurar, proteger y escalar tablas de Cassandra en la nube de AWS sin administrar infraestructura adicional.

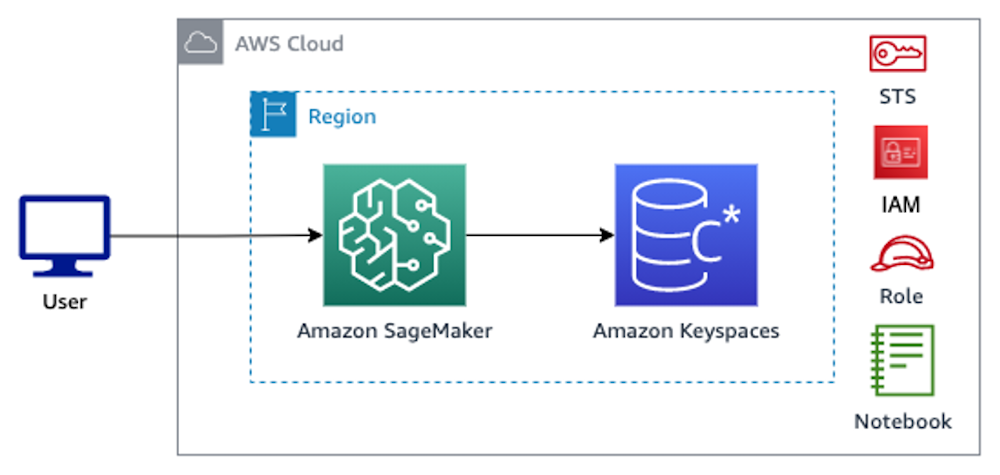

En esta publicación, lo guiaremos a través de los servicios de AWS relacionados con la capacitación de modelos de aprendizaje automático (ML) utilizando Amazon Keyspaces a un alto nivel, y brindaremos instrucciones paso a paso para incorporar datos de Amazon Keyspaces en Amazon SageMaker y entrenar un modelo que se puede usar para un caso de uso específico de segmentación de clientes.

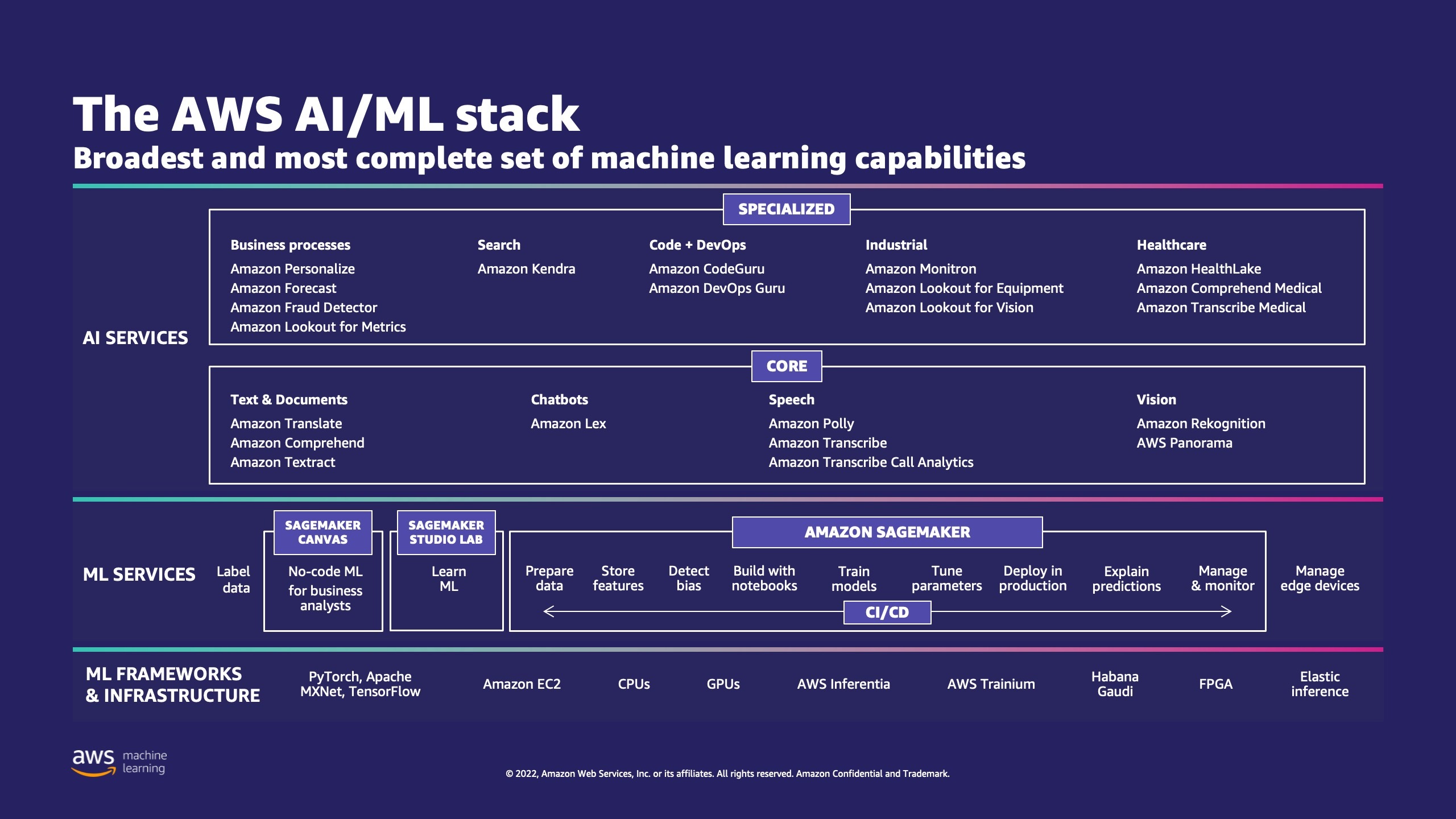

AWS tiene múltiples servicios para ayudar a las empresas a implementar procesos de ML en la nube.

AWS ML Stack tiene tres capas. En la capa intermedia se encuentra SageMaker, que brinda a los desarrolladores, científicos de datos e ingenieros de ML la capacidad de crear, entrenar e implementar modelos de ML a escala. Elimina la complejidad de cada paso del flujo de trabajo de ML para que pueda implementar más fácilmente sus casos de uso de ML. Esto incluye cualquier cosa, desde el mantenimiento predictivo hasta la visión artificial para predecir el comportamiento de los clientes. Los clientes logran una mejora de hasta 10 veces en la productividad de los científicos de datos con SageMaker.

Apache Cassandra es una opción popular para casos de uso intensivo de lectura con datos no estructurados o semiestructurados. Por ejemplo, un negocio popular de comida a domicilio estima el tiempo de entrega, y un cliente minorista podría persistir con frecuencia utilizando la información del catálogo de productos en la base de datos de Apache Cassandra. Espacios de claves de Amazon es un servicio de base de datos compatible con Apache Cassandra escalable, altamente disponible y administrado sin servidor. No necesita aprovisionar, aplicar parches o administrar servidores, y no necesita instalar, mantener ni operar software. Las tablas se pueden escalar hacia arriba y hacia abajo automáticamente, y solo paga por los recursos que usa. Amazon Keyspaces le permite ejecutar sus cargas de trabajo de Cassandra en AWS utilizando el mismo código de aplicación de Cassandra y las mismas herramientas de desarrollo que utiliza actualmente.

SageMaker ofrece un conjunto de algoritmos incorporados para ayudar a los científicos de datos y profesionales de ML a comenzar a entrenar e implementar modelos de ML rápidamente. En esta publicación, le mostraremos cómo un cliente minorista puede usar el historial de compras del cliente en la base de datos Keyspaces y dirigirse a diferentes segmentos de clientes para campañas de marketing.

K-significa es un algoritmo de aprendizaje no supervisado. Intenta encontrar agrupaciones discretas dentro de los datos, donde los miembros de un grupo son lo más similares posible entre sí y lo más diferentes posible de los miembros de otros grupos. Usted define los atributos que desea que use el algoritmo para determinar la similitud. SageMaker utiliza una versión modificada del algoritmo de agrupamiento k-means a escala web. En comparación con la versión original del algoritmo, la versión utilizada por SageMaker es más precisa. Sin embargo, al igual que el algoritmo original, se escala a conjuntos de datos masivos y ofrece mejoras en el tiempo de entrenamiento.

Resumen de la solución

Las instrucciones asumen que usaría SageMaker Studio para ejecutar el código. El código asociado ha sido compartido en GitHub de muestra de AWS. Siguiendo las instrucciones en el laboratorio, puede hacer lo siguiente:

- Instale las dependencias necesarias.

- Conéctese a Amazon Keyspaces, cree una tabla e ingiera datos de muestra.

- Cree un modelo de clasificación ML utilizando los datos en Amazon Keyspaces.

- Explore los resultados del modelo.

- Limpie los recursos recién creados.

Una vez completado, habrá integrado SageMaker con Amazon Keyspaces para entrenar modelos ML como se muestra en la siguiente imagen.

Ahora puedes seguir el instrucciones paso a paso en esta publicación para ingerir datos sin procesar almacenados en Amazon Keyspaces utilizando SageMaker y los datos así recuperados para el procesamiento de ML.

Requisitos previos

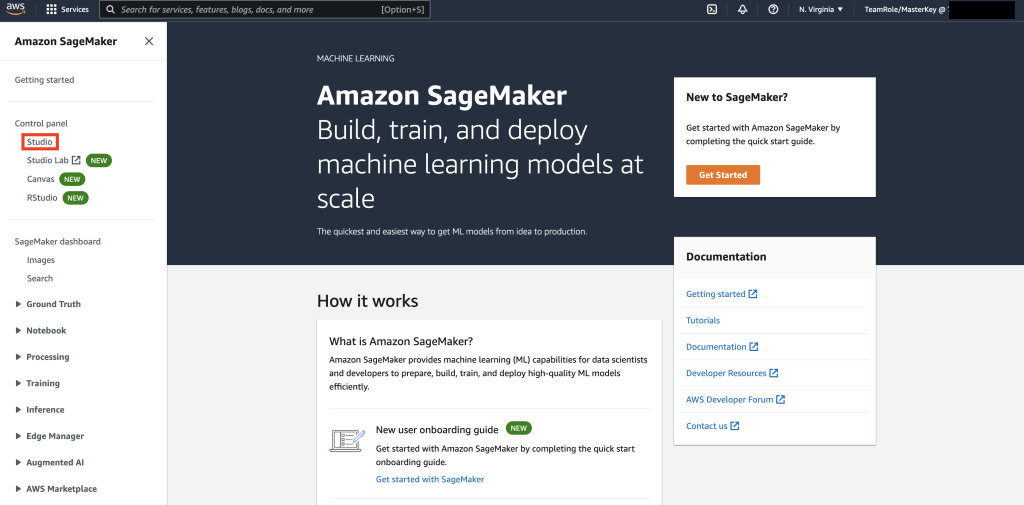

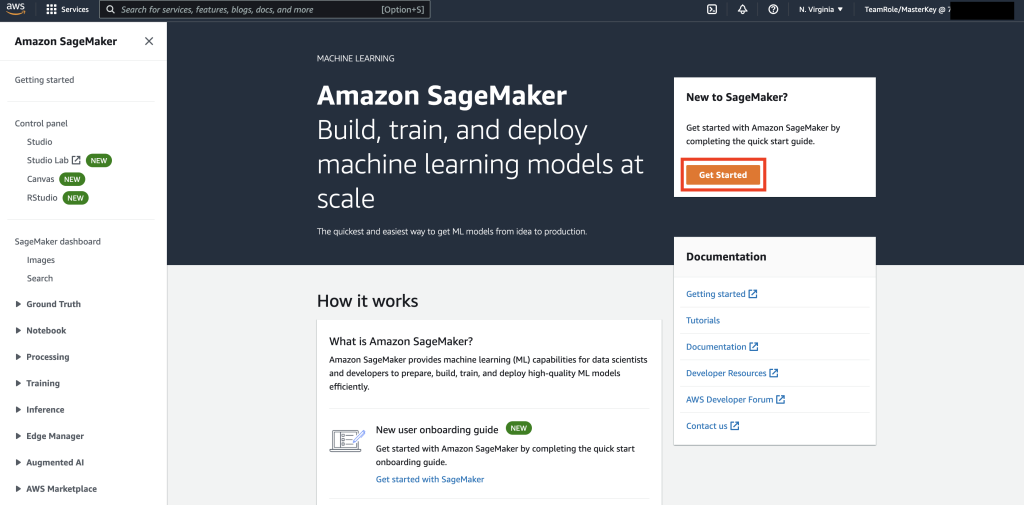

Primero, navegue a SageMaker.

A continuación, si es la primera vez que usa SageMaker, seleccione Iniciar.

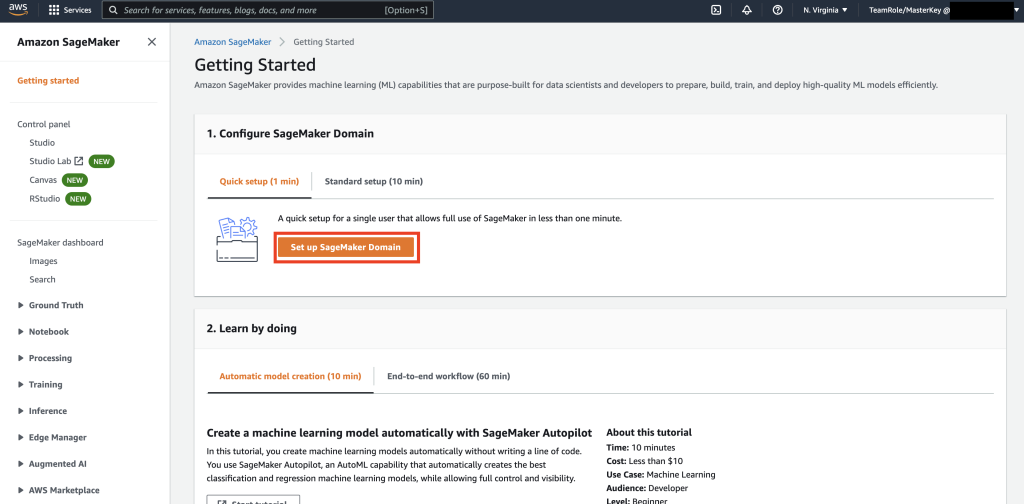

Luego, selecciona Configurar el dominio de SageMaker.

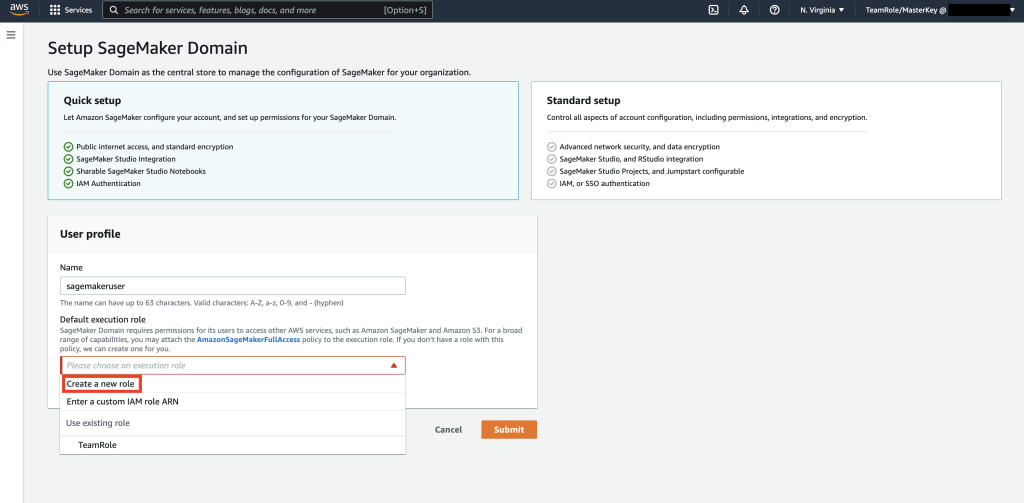

A continuación, cree un nuevo perfil de usuario con Nombre: usuario sagemakery seleccione Crear nuevo rol existentes Rol de ejecución predeterminado subsección.

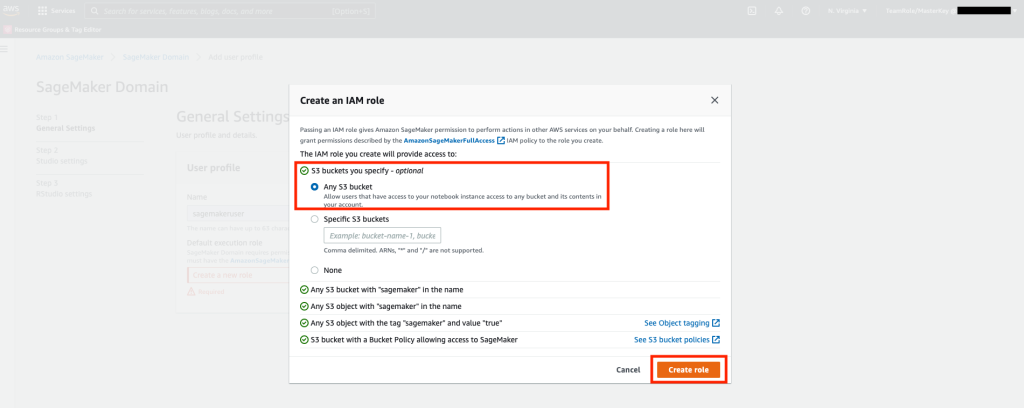

A continuación, en la pantalla que aparece, seleccione cualquier Servicio de almacenamiento simple de Amazon (Amazon S3) depósito y seleccione Crear función.

Esta función se usará en los siguientes pasos para permitir que SageMaker acceda a la tabla Keyspaces usando las credenciales temporales de la función. Esto elimina la necesidad de almacenar un nombre de usuario y una contraseña en el portátil.

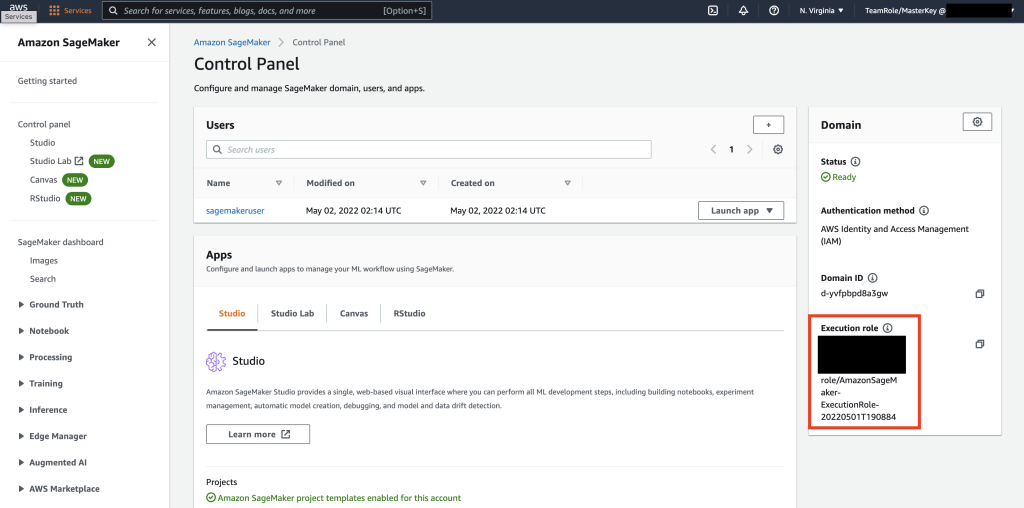

A continuación, recupere el rol asociado con el usuario sagemaker que se creó en el paso anterior desde la sección de resumen.

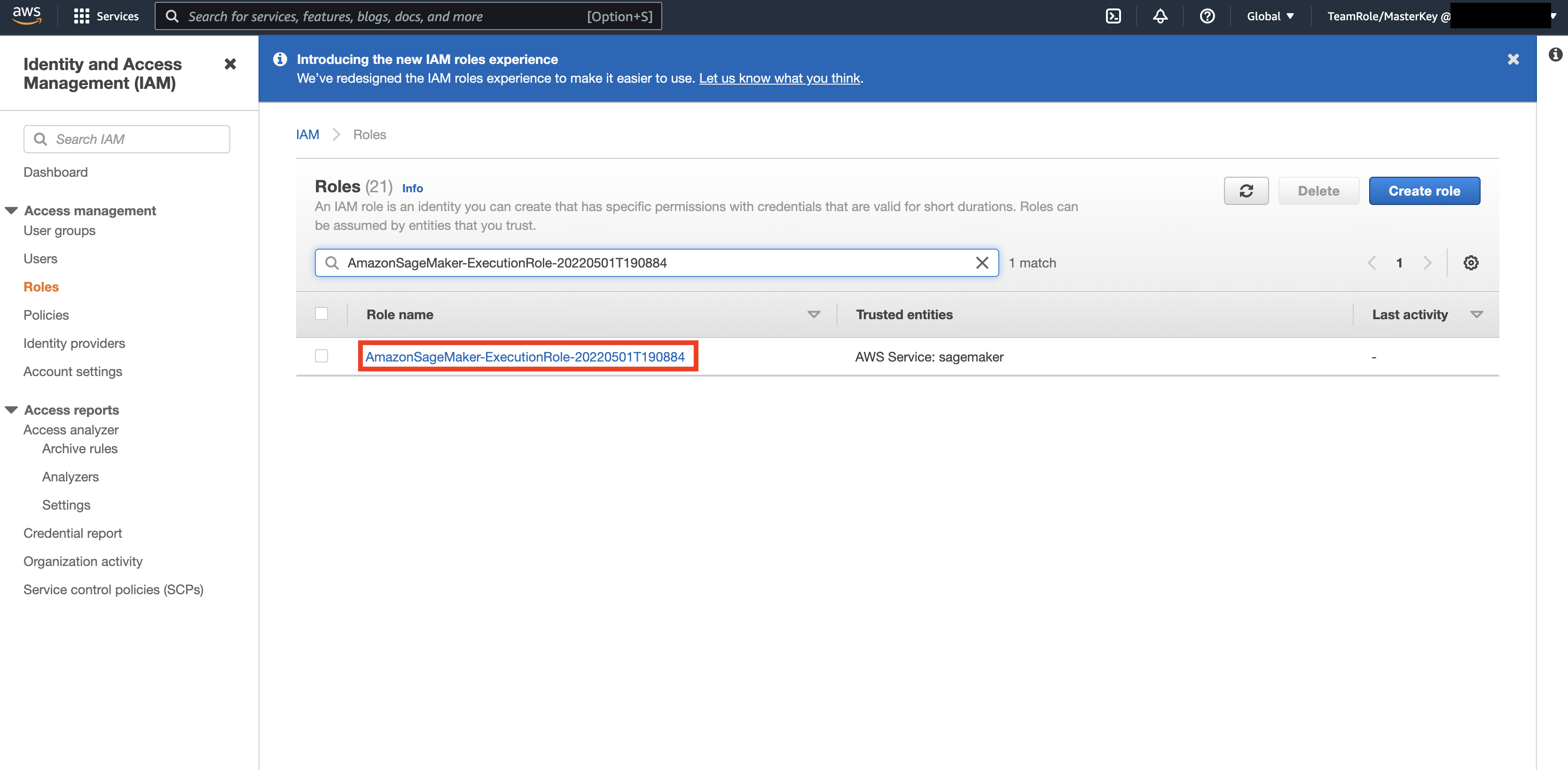

Luego, navega hasta el AWS Console y mira hacia arriba Gestión de acceso e identidad de AWS (IAM). Dentro de IAM, vaya a Roles. Dentro de Roles, busque el rol de ejecución identificado en el paso anterior.

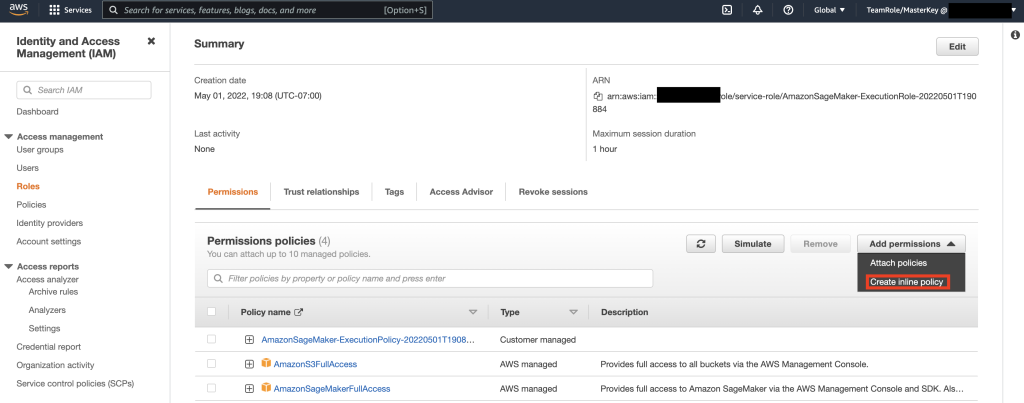

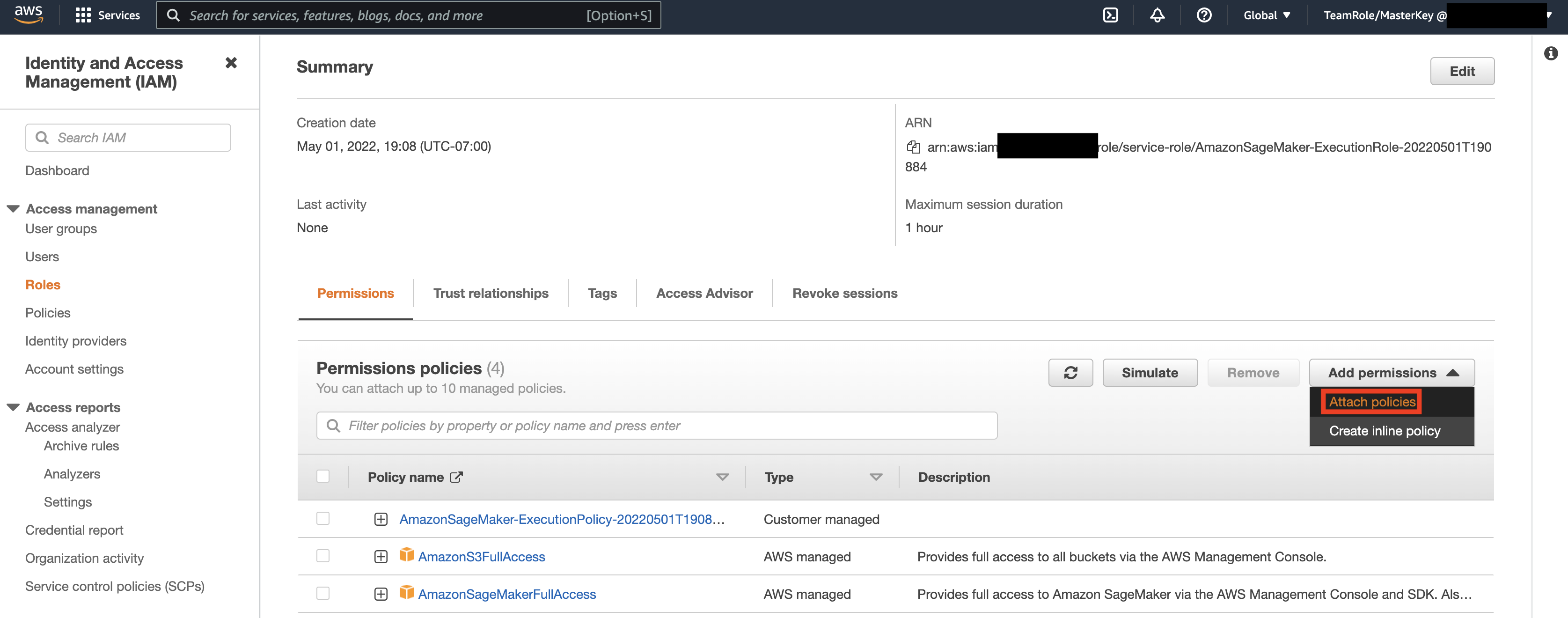

A continuación, seleccione el rol identificado en el paso anterior y seleccione Agregar permisos. En el menú desplegable que aparece, seleccione Crear política en línea. SageMaker le permite proporcionar un nivel granular de acceso que restringe las acciones que puede realizar un usuario/aplicación en función de los requisitos comerciales.

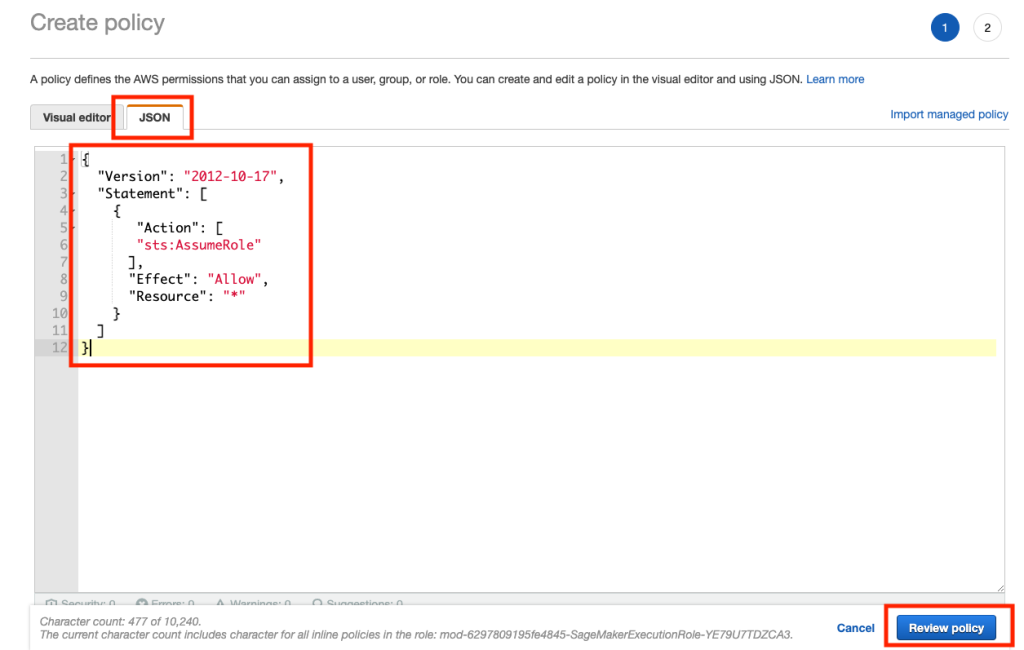

Luego, seleccione la pestaña JSON y copie la política de la sección Nota de Github página. Esta política permite que el cuaderno de SageMaker se conecte a Keyspaces y recupere datos para su posterior procesamiento.

Luego, seleccione Agregar permisos nuevamente y en el menú desplegable, y seleccione Adjuntar política.

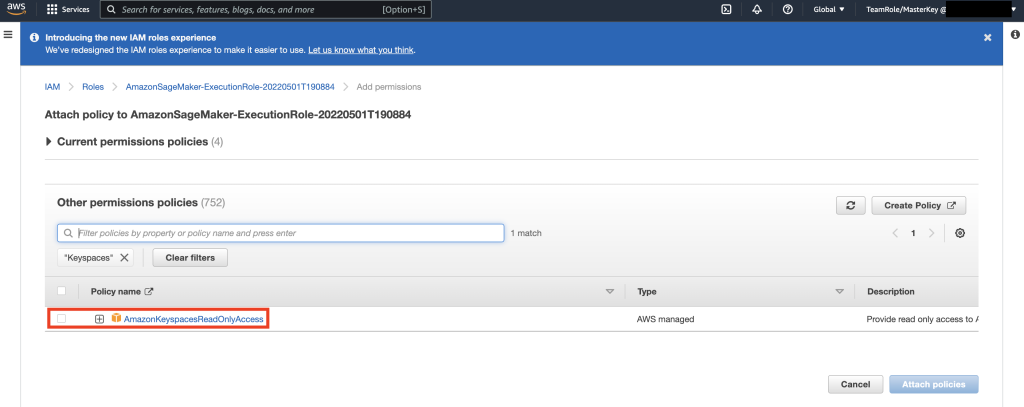

Busque la política AmazonKeyspacesFullAccess, seleccione la casilla de verificación junto al resultado coincidente y seleccione Adjuntar políticas.

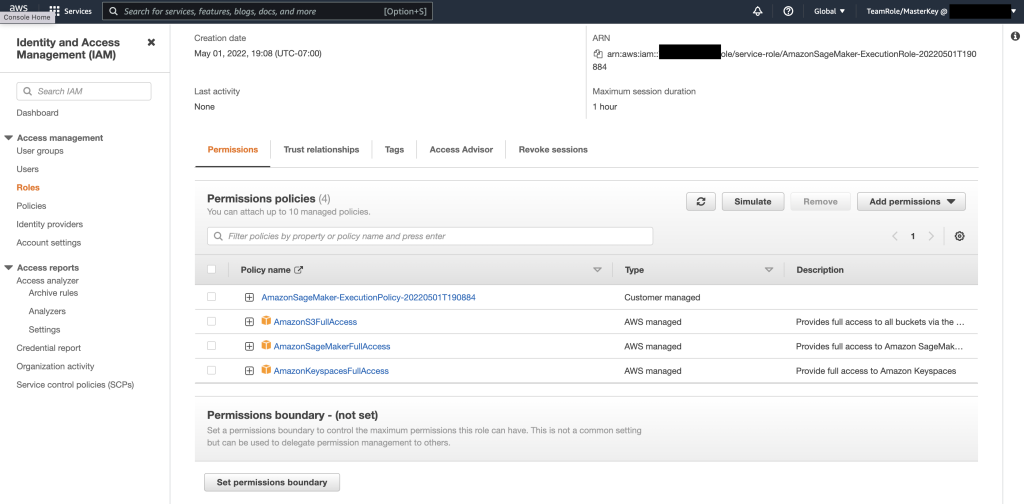

Verifique que la sección de políticas de permisos incluya AmazonS3FullAccess, AmazonSageMakerFullAccess, AmazonKeyspacesFullAccess, así como la política en línea recién agregada.

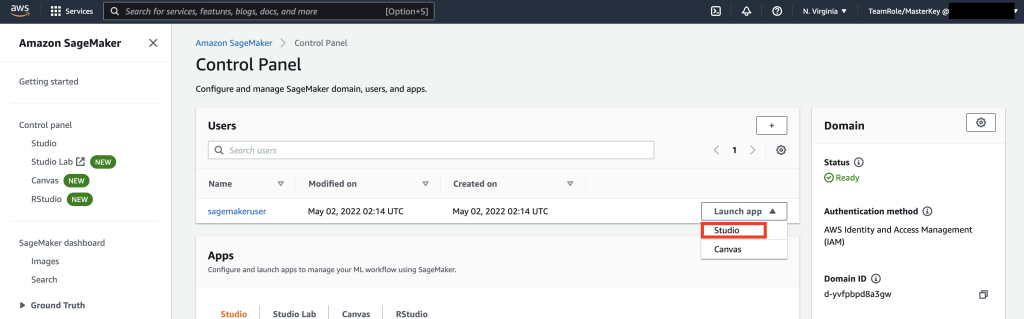

A continuación, navegue hasta SageMaker Studio mediante la consola de AWS y seleccione SageMaker Studio. Una vez allí, seleccione Iniciar aplicación y seleccione Studio.

Tutorial del cuaderno

La forma preferida de conectarse a Keyspaces desde SageMaker Notebook es mediante Proceso de la versión 4 de AWS Signature (SigV4) basado Credenciales temporales para la autenticación. En este escenario, NO necesitamos generar ni almacenar credenciales de Keyspaces y podemos usar las credenciales para autenticarnos con el complemento SigV4. Las credenciales de seguridad temporales constan de un ID de clave de acceso y una clave de acceso secreta. Sin embargo, también incluyen un token de seguridad que indica cuándo caducan las credenciales. En esta publicación, crearemos un rol de IAM y generaremos credenciales de seguridad temporales.

Primero, instalamos un controlador (cassandra-sigv4). Este controlador le permite agregar información de autenticación a sus solicitudes de API mediante el proceso de AWS Signature Version 4 (SigV4). Con el complemento, puede proporcionar a los usuarios y aplicaciones credenciales a corto plazo para acceder a Amazon Keyspaces (para Apache Cassandra) utilizando usuarios y roles de IAM. Después de esto, importará un certificado requerido junto con dependencias de paquetes adicionales. Al final, permitirá que el portátil asuma el rol de hablar con Keyspaces.

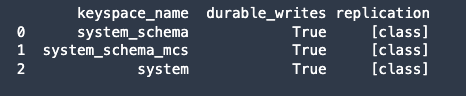

A continuación, conéctese a Amazon Keyspaces y lea los datos de los sistemas de Keyspaces en Pandas DataFrame para validar la conexión.

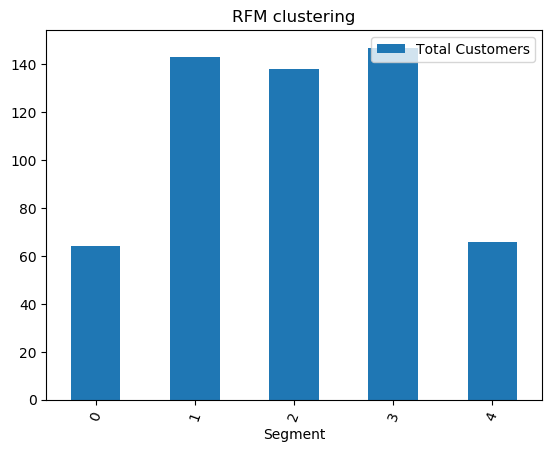

A continuación, prepare los datos para el entrenamiento en el conjunto de datos sin procesar. En el cuaderno de Python asociado con esta publicación, use un conjunto de datos minorista descargado de esta páginay procesarlo. Nuestro objetivo comercial dado el conjunto de datos es agrupar a los clientes utilizando una métrica específica llamada RFM. El modelo RFM se basa en tres factores cuantitativos:

- Actualidad: Hace cuánto tiempo un cliente ha realizado una compra.

- Frecuencia: Con qué frecuencia un cliente realiza una compra.

- Valor monetario: cuánto dinero gasta un cliente en compras.

El análisis RFM clasifica numéricamente a un cliente en cada una de estas tres categorías, generalmente en una escala de 1 a 5 (cuanto mayor sea el número, mejor será el resultado). El "mejor" cliente recibiría la máxima puntuación en todas las categorías. Usaremos la función de discretización basada en cuantiles de pandas (qcut). Ayudará a diferenciar los valores en cubos de igual tamaño según los cuantiles de muestra.

En este ejemplo, usamos CQL para leer registros de la tabla Keyspace. En algunos casos de uso de ML, es posible que deba leer los mismos datos de la misma tabla Keyspaces varias veces. En este caso, le recomendamos que guarde sus datos en un depósito de Amazon S3 para evitar incurrir en gastos adicionales. el costos leyendo de Amazon Keyspaces. Dependiendo de su escenario, también puede usar EMR de Amazon a ingerir un archivo muy grande de Amazon S3 en SageMaker.

A continuación, entrenamos un modelo de ML con el algoritmo KMeans y nos aseguramos de que se creen los clústeres. En este escenario particular, vería que los clústeres creados se imprimen, lo que muestra que los clientes en el conjunto de datos sin procesar se han agrupado en función de varios atributos en el conjunto de datos. Esta información de clúster se puede utilizar para campañas de marketing dirigidas.

(Opcional) A continuación, guardamos los segmentos de clientes identificados por el modelo ML en una tabla de Amazon Keyspaces para marketing dirigido. Un trabajo por lotes podría leer estos datos y ejecutar campañas dirigidas a clientes en segmentos específicos.

Finalmente nosotros limpiar los recursos creado durante este tutorial para evitar incurrir en cargos adicionales.

Puede llevar de unos segundos a un minuto completar la eliminación del espacio de claves y las tablas. Cuando elimina un espacio de claves, el espacio de claves y todas sus tablas se eliminan y deja de acumular cargos de ellos.

Conclusión

Esta publicación le mostró cómo ingerir datos de clientes de Amazon Keyspaces en SageMaker y entrenar un modelo de agrupación que le permitió segmentar a los clientes. Puede usar esta información para marketing dirigido, mejorando así en gran medida el KPI de su negocio. Para obtener más información sobre Amazon Keyspaces, consulte los siguientes recursos:

- Entrene modelos de aprendizaje automático utilizando Amazon Keyspaces como fuente de datos (Cuaderno de SageMaker)

- Conéctese a Amazon Keyspaces desde su escritorio usando los IDE IntelliJ, PyCharm o DataGrip

- Referencia del lenguaje CQL para Amazon Keyspaces (para Apache Cassandra)

- Cómo configurar el acceso de línea de comandos a Amazon Keyspaces (para Apache Cassandra) mediante el uso de la nueva imagen Docker del kit de herramientas para desarrolladores

- Gestión de acceso e identidad para Amazon Keyspaces (para Apache Cassandra)

- Conexión a Amazon Keyspaces desde SageMaker con credenciales específicas del servicio

- Actualidad, frecuencia, valor monetario (RFM)

- Referencia del código de Kaggle

Acerca de los autores

vadim liajovich es arquitecto sénior de soluciones en AWS en el área de la bahía de San Francisco y ayuda a los clientes a migrar a AWS. Está trabajando con organizaciones que van desde grandes empresas hasta pequeñas empresas emergentes para respaldar sus innovaciones. También ayuda a los clientes a diseñar soluciones escalables, seguras y rentables en AWS.

vadim liajovich es arquitecto sénior de soluciones en AWS en el área de la bahía de San Francisco y ayuda a los clientes a migrar a AWS. Está trabajando con organizaciones que van desde grandes empresas hasta pequeñas empresas emergentes para respaldar sus innovaciones. También ayuda a los clientes a diseñar soluciones escalables, seguras y rentables en AWS.

Parto Patel es arquitecto de soluciones en AWS en el área de la bahía de San Francisco. Parth guía a los clientes para acelerar su viaje a la nube y ayudarlos a adoptar la nube de AWS con éxito. Se enfoca en ML y modernización de aplicaciones.

Parto Patel es arquitecto de soluciones en AWS en el área de la bahía de San Francisco. Parth guía a los clientes para acelerar su viaje a la nube y ayudarlos a adoptar la nube de AWS con éxito. Se enfoca en ML y modernización de aplicaciones.

carnero pathangi es arquitecto de soluciones en AWS en el área de la bahía de San Francisco. Ha ayudado a clientes en las verticales de agricultura, seguros, banca, comercio minorista, atención de la salud y ciencias de la vida, hospitalidad y alta tecnología a administrar sus negocios con éxito en la nube de AWS. Se especializa en Bases de Datos, Analytics y ML.

carnero pathangi es arquitecto de soluciones en AWS en el área de la bahía de San Francisco. Ha ayudado a clientes en las verticales de agricultura, seguros, banca, comercio minorista, atención de la salud y ciencias de la vida, hospitalidad y alta tecnología a administrar sus negocios con éxito en la nube de AWS. Se especializa en Bases de Datos, Analytics y ML.

- Coinsmart. El mejor intercambio de Bitcoin y criptografía de Europa.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. ACCESO LIBRE.

- CriptoHawk. Radar de altcoins. Prueba gratis.

- Fuente: https://aws.amazon.com/blogs/machine-learning/train-machine-learning-models-using-amazon-keyspaces-as-a-data-source/

- '

- "

- &

- 10

- 100

- 9

- capacidad

- Nuestra Empresa

- acelerar

- de la máquina

- preciso

- Lograr

- acciones

- Adicionales

- agricultura

- adelante

- algoritmo

- Todos

- Amazon

- análisis

- Analytics

- Otra

- abejas

- API

- applicación

- Aplicación

- aplicaciones

- Reservada

- atributos

- Autenticación

- automáticamente

- Hoy Disponibles

- AWS

- Bancario

- Bay

- Blog

- frontera

- build

- negocios

- llamar al

- Campañas

- servicios sociales

- cases

- Categoría

- certificado

- cargos

- manera?

- clasificación

- Soluciones

- código

- en comparación con

- computadora

- Contacto

- conexión

- Consola

- rentable

- podría

- país

- Para crear

- creado

- Referencias

- cliente

- Clientes

- datos

- conjunto de datos

- Base de datos

- bases de datos

- entrega

- entrega

- Dependiente

- desplegar

- Desplegando

- computadora de escritorio

- Determinar

- Developer

- desarrolladores

- una experiencia diferente

- Docker

- DE INSCRIPCIÓN

- conductor

- Soltar

- durante

- pasan fácilmente

- certificados

- empresas

- equipo

- estima

- ejemplo

- ejecución

- factores importantes

- Nombre

- primer vez

- FLOTA

- se centra

- seguir

- siguiendo

- Comida

- Francisco

- función

- promover

- en general

- generar

- conseguir

- GitHub

- muy

- Grupo procesos

- Grupo

- Guías

- Salud

- Atención médica

- ayuda

- ayudando

- Alta

- más alto

- altamente

- historia

- Cómo

- Como Hacer

- Sin embargo

- HTTPS

- Identidad

- imagen

- implementar

- es la mejora continua

- la mejora de

- incluir

- incluye

- índice

- industrial

- información

- EN LA MINA

- innovaciones

- instalar

- aseguradora

- COMPLETAMENTE

- IT

- Trabajos

- Clave

- el lab

- idioma

- large

- lanzamiento

- .

- APRENDE:

- aprendizaje

- Nivel

- Ciencias de la vida

- Etiqueta LinkedIn

- Mira

- leal

- máquina

- máquina de aprendizaje

- hecho

- mantener

- HACE

- gestionan

- gestionado

- Management

- administrar

- Marketing

- masivo

- pareo

- Miembros

- ML

- modelo

- modelos

- Monetario

- dinero

- monitoreo

- más,

- MEJOR DE TU

- múltiples

- necesario

- cuaderno

- número

- funcionar

- optimización

- para las fiestas.

- Otro

- paquete

- particular

- Contraseña

- Patch

- Pagar

- (PDF)

- plugin

- políticas

- política

- Popular

- posible

- posible

- predecir

- Preparar

- anterior

- precio

- primario

- en costes

- tratamiento

- Producto

- productividad

- Mi Perfil

- prometedor

- proporcionar

- proporciona un

- comprar

- compras

- XNUMX% automáticos

- con rapidez

- que van

- Crudo

- Reading

- recepción

- recientemente

- recomiendan

- archivos

- solicitudes

- Requisitos

- Requisitos

- Recursos

- Resultados

- el comercio minorista

- una estrategia SEO para aparecer en las búsquedas de Google.

- Riesgo

- Función

- Ruta

- Ejecutar

- San

- San Francisco

- SC

- escalable

- Escala

- CIENCIAS

- los científicos

- Pantalla

- Buscar

- segundos

- seguro

- EN LINEA

- token de seguridad

- segmento

- segmentación

- segmentos

- Sin servidor

- de coches

- Servicios

- set

- compartido

- a corto plazo

- mostrado

- similares

- sencillos

- sueño

- chica

- So

- Software

- sólido

- Soluciones

- algo

- se especializa

- montón

- fundó

- Startups

- STORAGE

- tienda

- estudio

- Con éxito

- SOPORTE

- te

- Todas las funciones a su disposición

- escuchar

- Target

- afectados

- temporal

- El

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- veces

- hoy

- juntos

- ficha

- caja de herramientas

- parte superior

- comercio

- Formación

- utilizan el

- casos de uso

- usuarios

- propuesta de

- diversos

- versión

- verticales

- visión

- ¿

- dentro de

- sin

- trabajando

- se

- tú