Vicepresidente de IBM Quantum Jay Gambetta habla con Philip Ball sobre los muchos avances cuánticos de la compañía en los últimos 20 años, así como sobre su hoja de ruta de cinco años recientemente anunciada hacia la "ventaja cuántica"

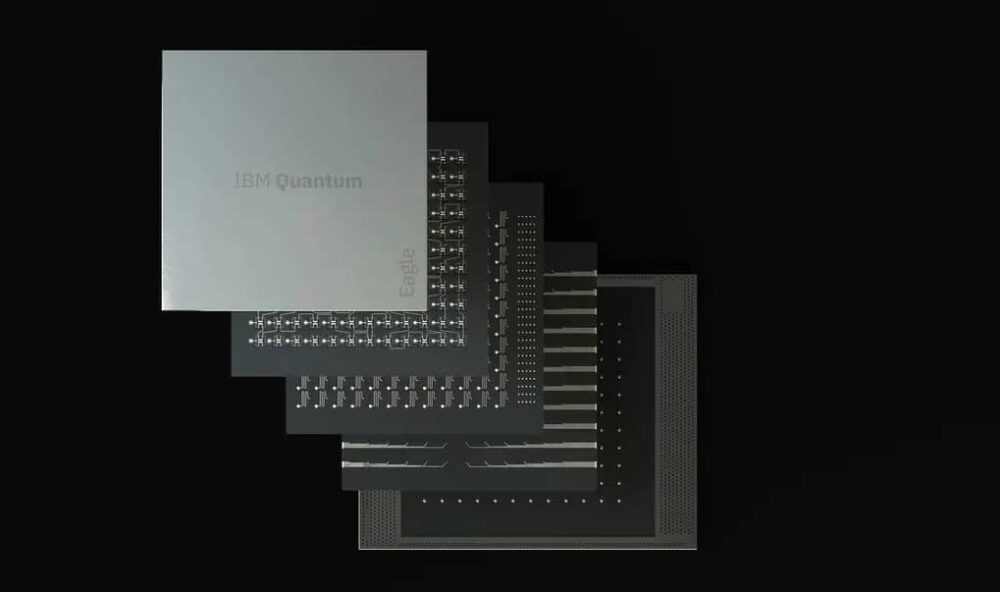

Las empresas y los laboratorios de investigación de todo el mundo están trabajando para sacar sus tecnologías cuánticas nacientes del laboratorio y llevarlas al mundo real, y el gigante tecnológico estadounidense IBM es un jugador clave. En mayo de este año, IBM Quantum presentó su última hoja de ruta para el futuro de la computación cuántica en la próxima década, y la empresa ha establecido algunos objetivos ambiciosos. Habiendo anunciado su Procesador Eagle con 127 bits cuánticos (qubits) el año pasado, la empresa es ahora desarrollando el procesador Osprey de 433 qubits para un debut a finales de este año, seguido en 2023 por el Cóndor de 1121 qubits.

Pero más allá de eso, dice la compañía, el juego cambiará para ensamblar dichos procesadores en circuitos modulares, en los que los chips se conectan entre sí a través de interconexiones clásicas o cuánticas más dispersas. Ese esfuerzo culminará en lo que denominan su dispositivo Kookaburra de 4158 qubits en 2025. Más allá de esa fecha, IBM pronostica modular procesadores con 100,000 o más qubits, capaces de computar sin los errores que actualmente hacen que la computación cuántica sea una cuestión de encontrar soluciones para el ruido de los qubits. Con este enfoque, el equipo de computación cuántica de la compañía confía en que puede lograr una "ventaja cuántica" general, en la que las computadoras cuánticas superen consistentemente a las computadoras clásicas y realicen cálculos complejos más allá de los medios de los dispositivos clásicos.

Mientras estaba en Londres de camino a la 28th Conferencia Solvay en Bruselas, que abordó la información cuántica, Mundo de la física atrapado con el físico Jay Gambetta, vicepresidente de IBM Quantum. Habiendo encabezado gran parte de los avances de la compañía durante las últimas dos décadas, Gambetta explicó cómo se pueden alcanzar estos objetivos y qué implicarán para el futuro de la computación cuántica.

¿Cuál es el estado actual del arte en IBM Quantum? ¿Cuáles son algunos de los parámetros clave en los que se está enfocando?

La hoja de ruta de IBM se trata de escalar, no solo la cantidad de qubits, sino también su velocidad, calidad y arquitectura de circuitos. Ahora tenemos tiempos de coherencia [la duración durante la cual los qubits se mantienen coherentes y capaces de realizar un cálculo cuántico] de 300 microsegundos en el procesador Eagle [en comparación con aproximadamente 1 μs en 2010], y la próxima generación de dispositivos alcanzará los 300 milisegundos. Y nuestros qubits [hechos de metales superconductores] ahora tienen casi un 99.9 % de fidelidad [incurren solo en un error cada 1000 operaciones, una tasa de error de 10-3]. Creo que el 99.99% no sería imposible para fines del próximo año.

La última prueba de fuego para la madurez de las computadoras cuánticas es si el tiempo de ejecución cuántico puede ser competitivo con el tiempo de ejecución clásico.

Pero hacer las cosas de manera inteligente se volverá más importante que simplemente impulsar las métricas sin procesar. La arquitectura del procesador es cada vez más importante. No creo que superemos los 1000 qubits por chip [como en el Condor], así que ahora estamos analizando la modularidad. De esta forma, podremos llegar a procesadores de 10,000 qubits a finales de esta década. Vamos a utilizar tanto la comunicación clásica (para controlar la electrónica) entre chips como los canales cuánticos que crean cierto enredo (para realizar cálculos). Estos canales entre chips van a ser lentos, quizás 100 veces más lentos que los propios circuitos. Y será difícil superar la fidelidad de los canales por encima del 95 %.

Para la informática de alto rendimiento, lo que realmente importa es minimizar el tiempo de ejecución, es decir, minimizar el tiempo que lleva generar una solución para un problema de interés. La última prueba de fuego para la madurez de las computadoras cuánticas es si el tiempo de ejecución cuántico puede ser competitivo con el tiempo de ejecución clásico. Hemos comenzado a demostrar teóricamente que si tiene un circuito grande que desea ejecutar y lo divide en circuitos más pequeños, entonces cada vez que hace un corte, puede pensar que incurre en un costo clásico, lo que aumenta el tiempo de ejecución. exponencialmente Entonces, el objetivo es mantener ese aumento exponencial lo más cerca posible de 1.

Para un circuito dado, el tiempo de ejecución depende exponencialmente de un parámetro que llamamos γ̄ elevado al poder nd, Donde n es el número de qubits y d es la profundidad [una medida del camino más largo entre la entrada y la salida del circuito, o equivalentemente el número de pasos de tiempo necesarios para que el circuito funcione]. Entonces, si podemos obtener b γ̄ lo más cerca posible de 1, llegamos a un punto en el que existe una ventaja cuántica real: no hay crecimiento exponencial en el tiempo de ejecución. Podemos reducir γ̄ a través de mejoras en la coherencia y la fidelidad de la puerta [tasa de error intrínseco]. Con el tiempo, llegaremos a un punto de inflexión en el que, incluso con la sobrecarga exponencial de la mitigación de errores, podremos obtener beneficios del tiempo de ejecución en comparación con las computadoras clásicas. Si puede reducir γ̄ a 1.001, el tiempo de ejecución es más rápido que si tuviera que simular esos circuitos de forma clásica. Estoy seguro de que podemos hacer esto: con mejoras en la fidelidad de la puerta y la supresión de la diafonía entre qubits, ya hemos medido un γ̄ de 1.008 en el chip Falcon r10 [27-qubit].

¿Cómo puede realizar esas mejoras para la mitigación de errores?

Para mejorar la fidelidad, hemos tomado un enfoque llamado cancelación de error probabilístico [arXiv:2201.09866]. La idea es que me envíes cargas de trabajo y yo te enviaré resultados procesados con estimaciones sin ruido de las mismas. Dices que quiero que administres este circuito; Caracterizo todo el ruido que tengo en mi sistema, realizo muchas ejecuciones y luego proceso todos esos resultados juntos para brindarle una estimación sin ruido de la salida del circuito. De esta manera, estamos comenzando a mostrar que es probable que haya un continuo desde donde estamos hoy con la supresión y mitigación de errores hasta la corrección total de errores.

Entonces, ¿puede llegar allí sin construir qubits lógicos que corrijan completamente los errores?

¿Qué es realmente un qubit lógico? ¿Qué quiere decir realmente la gente con eso? Lo que realmente importa es: ¿puedes ejecutar circuitos lógicos y cómo los ejecutas de manera que el tiempo de ejecución sea siempre más rápido? En lugar de pensar en construir qubits lógicos, estamos pensando en cómo ejecutamos los circuitos y brindamos a los usuarios estimaciones de la respuesta, y luego la cuantificamos por el tiempo de ejecución.

Cuando realiza la corrección de errores normal, corrige lo que pensó que habría sido la respuesta hasta ese momento. Actualizar un marco de referencia. Pero lograremos la corrección de errores a través de la mitigación de errores. Con γ̄ igual a 1, efectivamente tendré corrección de errores, porque no hay gastos generales para mejorar las estimaciones tanto como desee.

De esta manera, efectivamente tendremos qubits lógicos, pero se insertarán continuamente. Así que estamos empezando a pensar en ello a un nivel superior. Nuestro punto de vista es crear, desde la perspectiva del usuario, un continuo que sea cada vez más rápido. La última prueba de fuego para la madurez de las computadoras cuánticas, entonces, es si el tiempo de ejecución cuántico puede ser competitivo con el tiempo de ejecución clásico.

Eso es muy diferente de lo que están haciendo otras empresas cuánticas, pero me sorprendería mucho si esto no se convierte en la opinión general: apuesto a que comenzará a ver personas comparando tiempos de ejecución, no tasas de corrección de errores.

Lo que estamos haciendo es solo computación en general, y le estamos dando un impulso a través de un procesador cuántico.

Si fabrica dispositivos modulares con conexiones clásicas, ¿significa eso que el futuro no es realmente cuántico versus clásico, sino cuántico? y ¿clásico?

Sí. Reunir lo clásico y lo cuántico le permitirá hacer más. Eso es lo que yo llamo excedente cuántico: hacer computación clásica de manera inteligente utilizando recursos cuánticos.

Si pudiera agitar una varita mágica, no lo llamaría computación cuántica. Volvería y diría que realmente lo que estamos haciendo es solo computación en general, y le estamos dando un impulso a través de un procesador cuántico. He estado usando el eslogan "supercomputación cuántica centrada". Realmente se trata de intensificar la computación al agregarle cuántica. Realmente creo que esta será la arquitectura.

¿Cuáles son los obstáculos técnicos? ¿Importa que estos dispositivos necesiten refrigeración criogénica, por ejemplo?

Eso no es realmente un gran problema. Un problema mayor es que si continuamos con nuestra hoja de ruta, me preocupa el precio de la electrónica y todas las cosas que la rodean. Para reducir estos costos, necesitamos desarrollar un ecosistema; y nosotros, como comunidad, todavía no estamos haciendo lo suficiente para crear ese entorno. No veo a muchas personas enfocándose solo en la electrónica, pero creo que sucederá.

¿Ya se ha hecho toda la ciencia, de modo que ahora es más una cuestión de ingeniería?

Siempre habrá ciencia que hacer, especialmente al trazar este camino desde la mitigación de errores hasta la corrección de errores. ¿Qué tipo de conectividad desea incorporar en el chip? ¿Cuáles son las conexiones? Estas son todas las ciencias fundamentales. Creo que todavía podemos llevar las tasas de error a 10-5. Personalmente, no me gusta etiquetar las cosas como "ciencia" o "tecnología"; estamos construyendo una innovación. Creo que definitivamente hay una transición para que estos dispositivos se conviertan en herramientas, y la pregunta es cómo usamos estas cosas para la ciencia, en lugar de la ciencia de crear la herramienta.

¿Te preocupa que pueda haber una burbuja cuántica?

No. Creo que la ventaja cuántica se puede dividir en dos cosas. Primero, ¿cómo se ejecutan los circuitos más rápido en hardware cuántico? Confío en que puedo hacer predicciones al respecto. Y segundo, ¿cómo usa realmente estos circuitos y los relaciona con las aplicaciones? ¿Por qué un método basado en cuántica funciona mejor que un método clásico solo? Esas son preguntas científicas muy difíciles. Y son preguntas en las que están interesados los físicos de alta energía, los científicos de materiales y los químicos cuánticos. Creo que definitivamente habrá una demanda, ya la vemos. Estamos viendo que algunas empresas comerciales también se están interesando, pero llevará un tiempo encontrar soluciones reales, en lugar de que la tecnología cuántica sea una herramienta para hacer ciencia.

Veo esto como una transición suave. Un gran área potencial de aplicación son los problemas que tienen datos con algún tipo de estructura, especialmente datos para los que es muy difícil encontrar las correlaciones clásicamente. Tanto las finanzas como la medicina enfrentan problemas como ese, y los métodos cuánticos como el aprendizaje automático cuántico son muy buenos para encontrar correlaciones. Va a ser un largo camino, pero vale la pena la inversión para que lo hagan.

¿Qué hay de mantener la computación segura contra, digamos, ataques como el algoritmo de factorización de Shor, que aprovecha los métodos cuánticos para descifrar los métodos criptográficos de clave pública actuales, basados en la factorización?

Todo el mundo quiere estar seguro contra el algoritmo de Shor; ahora se llama "seguridad cuántica". Tenemos mucha investigación fundamental sobre los algoritmos, pero cómo incorporarlos se convertirá en una pregunta importante. Estamos investigando incorporar esto en nuestros productos todo el tiempo, en lugar de como un complemento. Y debemos preguntarnos cómo nos aseguramos de tener la infraestructura clásica que sea segura para la tecnología cuántica. La forma en que se desarrolle ese futuro será muy importante en los próximos años: cómo se construye hardware cuántico seguro desde cero.

Mi definición de éxito es cuando la mayoría de los usuarios ni siquiera saben que están usando una computadora cuántica.

¿Te ha sorprendido la velocidad a la que ha llegado la computación cuántica?

Para alguien que ha estado tan involucrado como yo desde el año 2000, se ha seguido notablemente cerca del camino que se predijo. Recuerdo volver a una hoja de ruta interna de IBM de 2011 y fue bastante acertada. ¡Pensé que me estaba inventando cosas entonces! En general, siento que la gente está sobreestimando cuánto tiempo llevará. A medida que avanzamos más y más, y las personas aportan ideas de información cuántica a estos dispositivos, en los próximos años podremos ejecutar circuitos más grandes. Luego, se tratará de qué tipos de arquitectura necesita construir, qué tan grandes son los clústeres, qué tipos de canales de comunicación usa, etc. Estas preguntas serán impulsadas por el tipo de circuitos que está ejecutando: ¿cómo comenzamos a construir máquinas para ciertos tipos de circuitos? Habrá una especialización de circuitos.

¿Cómo será 2030 para la computación cuántica?

Mi definición de éxito es cuando la mayoría de los usuarios ni siquiera saben que están usando una computadora cuántica, porque está integrada en una arquitectura que funciona a la perfección con la computación clásica. La medida del éxito sería entonces que es invisible para la mayoría de las personas que lo usan, pero mejora su vida de alguna manera. Tal vez su teléfono móvil use una aplicación que haga su estimación usando una computadora cuántica. En 2030 no estaremos a ese nivel, pero creo que para entonces tendremos máquinas muy grandes y estarán mucho más allá de lo que podemos hacer clásicamente.