Amazon SageHacerr Administrador de datos es una herramienta de preparación de datos basada en la interfaz de usuario que ayuda a realizar análisis, preprocesamiento y visualización de datos con funciones para limpiar, transformar y preparar datos más rápido. Las plantillas de flujo preconstruidas de Data Wrangler ayudan a que la preparación de datos sea más rápida para los científicos de datos y los profesionales del aprendizaje automático (ML) al ayudarlo a acelerar y comprender los patrones de mejores prácticas para los flujos de datos utilizando conjuntos de datos comunes.

Puede utilizar los flujos de Data Wrangler para realizar las siguientes tareas:

- Visualización de datos - Examinar las propiedades estadísticas de cada columna del conjunto de datos, construir histogramas, estudiar valores atípicos

- Limpieza de datos - Eliminar duplicados, eliminar o completar entradas con valores faltantes, eliminar valores atípicos

- Enriquecimiento de datos e ingeniería de funciones - Procesamiento de columnas para crear características más expresivas, seleccionando un subconjunto de características para el entrenamiento.

Esta publicación lo ayudará a comprender Data Wrangler utilizando los siguientes flujos prediseñados de muestra en GitHub. El repositorio muestra la transformación de datos tabulares, las transformaciones de datos de series temporales y las transformaciones de conjuntos de datos unidos. Cada uno requiere un tipo diferente de transformaciones debido a su naturaleza básica. Los datos tabulares o transversales estándar se recopilan en un momento específico. Por el contrario, los datos de series temporales se capturan repetidamente a lo largo del tiempo, y cada punto de datos sucesivo depende de sus valores anteriores.

Veamos un ejemplo de cómo podemos usar el flujo de datos de muestra para datos tabulares.

Requisitos previos

Data Wrangler es un Amazon SageMaker característica disponible dentro Estudio Amazon SageMaker, por lo que debemos seguir el proceso de incorporación de Studio para activar el entorno y los cuadernos de Studio. Aunque puede elegir entre varios métodos de autenticación, la forma más sencilla de crear un dominio de Studio es seguir las Inicio rápido instrucciones. El inicio rápido utiliza la misma configuración predeterminada que el configuración de estudio estándar. También puede optar por incorporarse utilizando Centro de identidad de AWS IAM (sucesor de AWS Single Sign-On) para la autenticación (consulte Incorporación al dominio de Amazon SageMaker mediante el centro de identidad de IAM).

Importe el conjunto de datos y los archivos de flujo a Data Wrangler usando Studio

Los siguientes pasos describen cómo importar datos en SageMaker para que los consuma Data Wrangler:

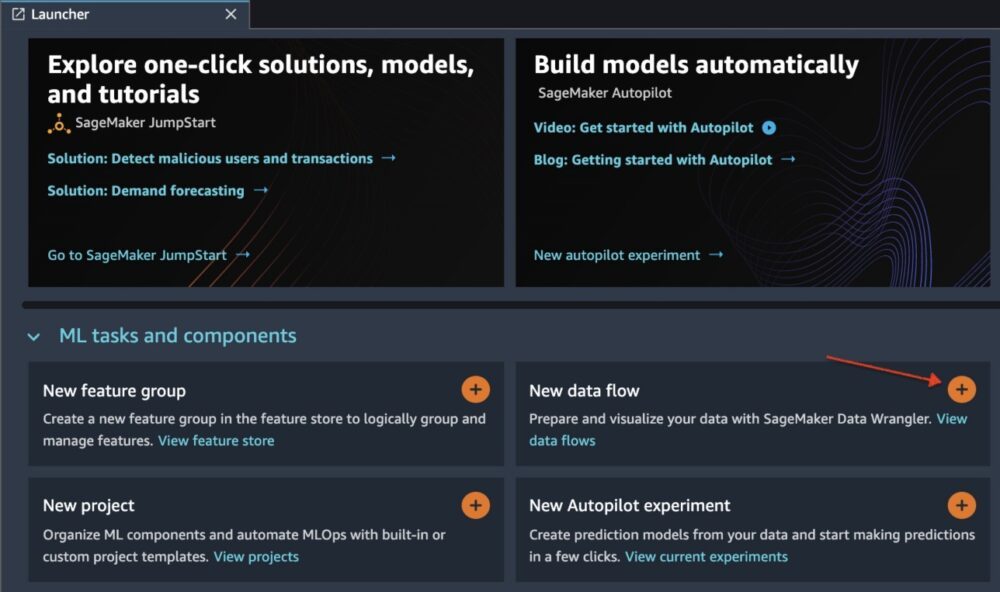

Inicialice Data Wrangler a través de la interfaz de usuario de Studio eligiendo Nuevo flujo de datos.

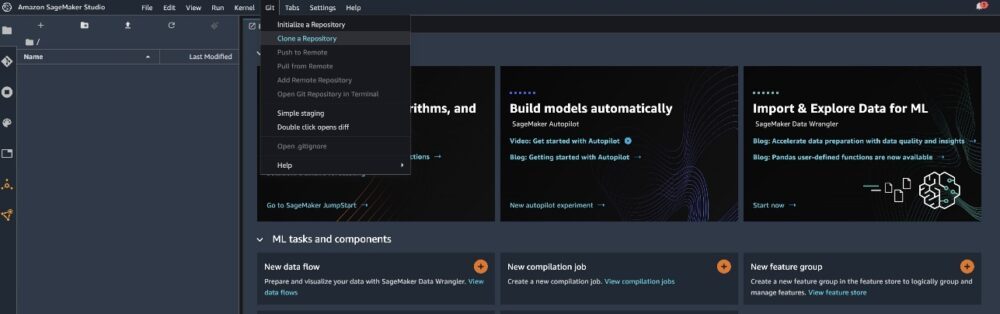

Clona el Repositorio GitHub para descargar los archivos de flujo en su entorno Studio.

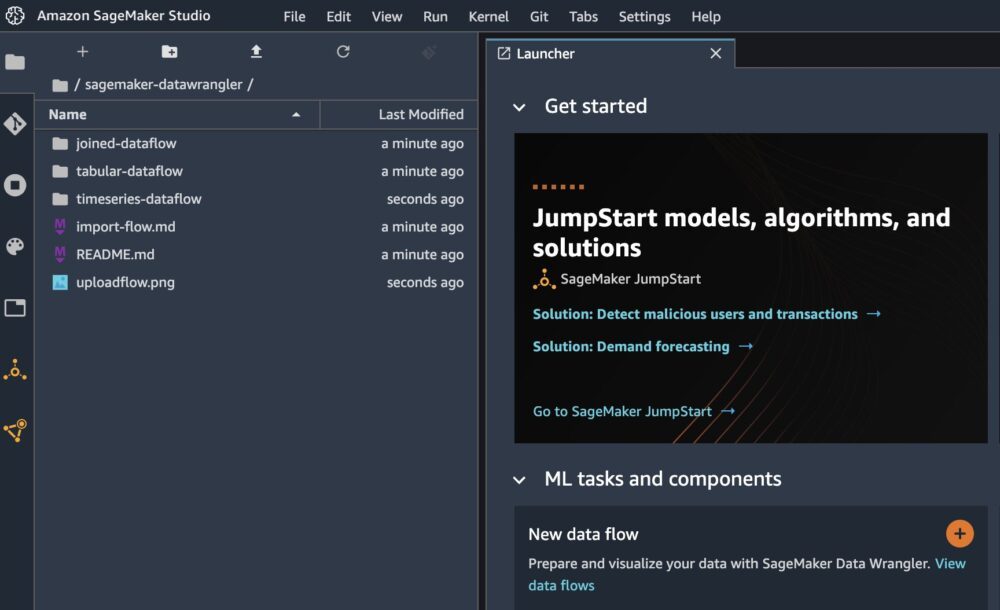

Cuando se complete la clonación, debería poder ver el contenido del repositorio en el panel izquierdo.

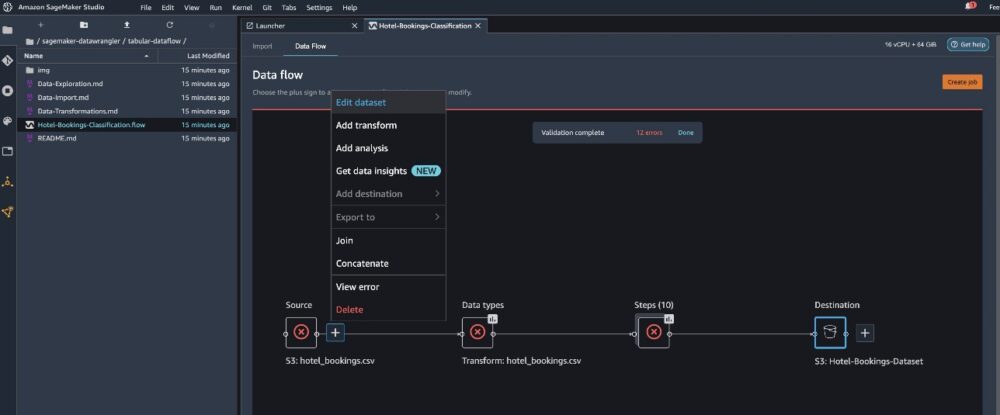

Elige el archivo Hotel-Reservas-Clasificación.flow para importar el archivo de flujo a Data Wrangler.

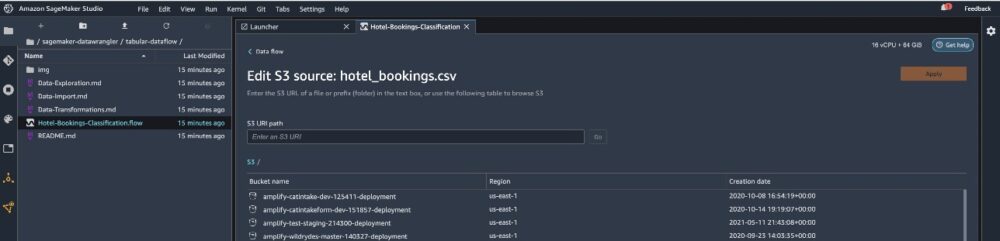

Si usa la serie temporal o el flujo de datos unidos, el flujo aparecerá con un nombre diferente. Después de importar el flujo, debería ver la siguiente captura de pantalla. Esto nos muestra errores porque necesitamos asegurarnos de que el archivo de flujo apunte a la fuente de datos correcta en Servicio de almacenamiento simple de Amazon (Amazon S3).

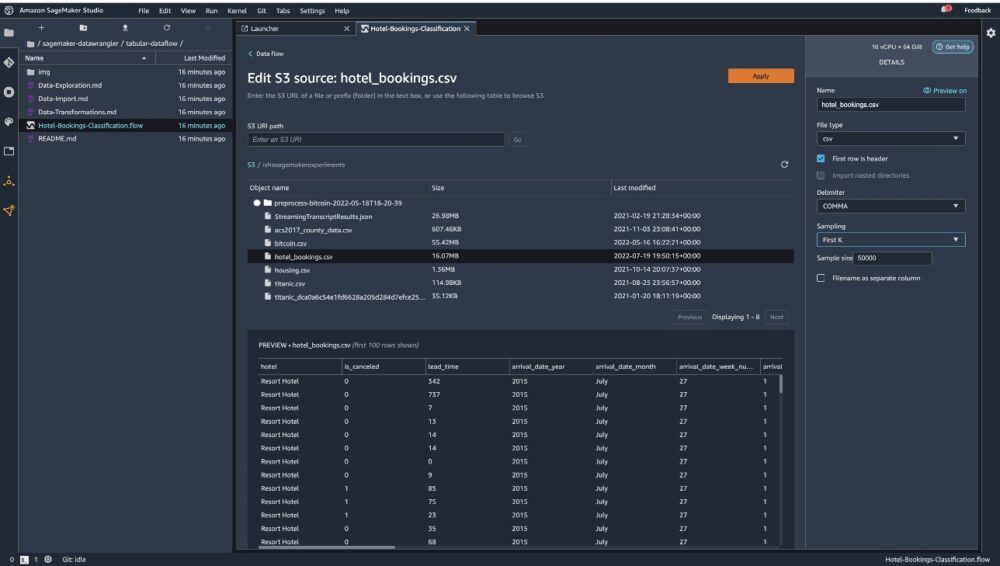

Elige Editar conjunto de datos para que aparezcan todos sus cubos S3. A continuación, elija el conjunto de datos hotel_bookings.csv de su cubo S3 para ejecutar a través de la flujo de datos tabulares.

Tenga en cuenta que si está utilizando el flujo de datos unido, es posible que deba importar varios conjuntos de datos a Data Wrangler

En el panel derecho, asegúrese de PÁRRAFO se elige como delimitador y Muestreo se establece a primera k. Nuestro conjunto de datos es lo suficientemente pequeño como para ejecutar transformaciones de Data Wrangler en el conjunto de datos completo, pero queríamos resaltar cómo puede importar el conjunto de datos. Si tiene un conjunto de datos grande, considere usar el muestreo. Elegir Importa para importar este conjunto de datos a Data Wrangler.

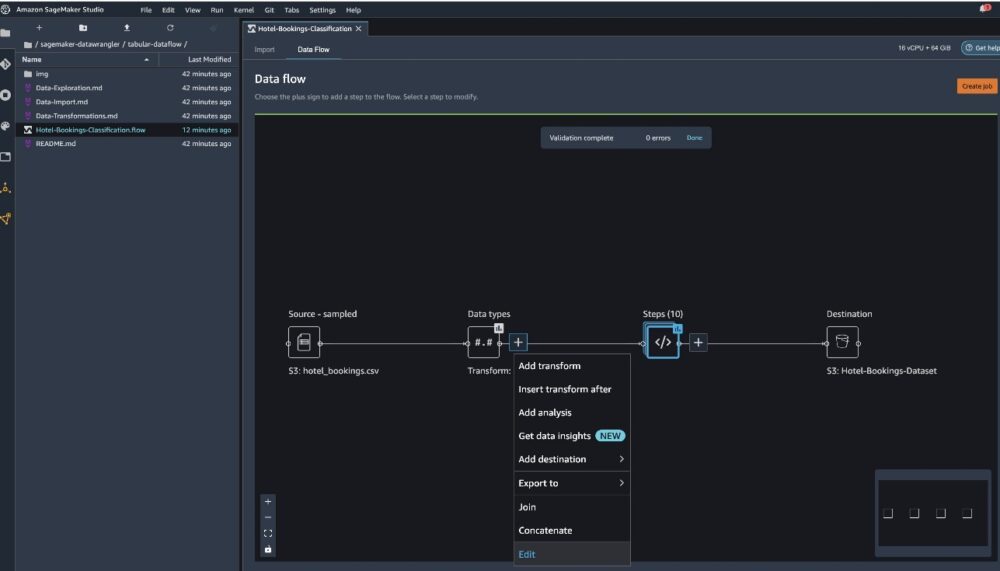

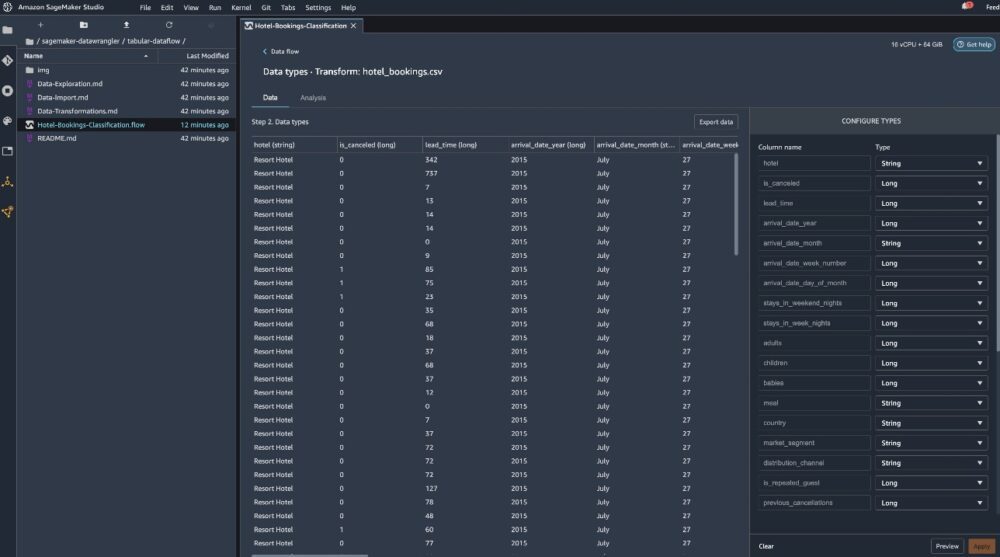

Después de importar el conjunto de datos, Data Wrangler valida automáticamente el conjunto de datos y detecta los tipos de datos. Puede ver que los errores han desaparecido porque apuntamos al conjunto de datos correcto. El editor de flujo ahora muestra dos bloques que muestran que los datos se importaron de una fuente y se reconocieron los tipos de datos. También puede editar los tipos de datos si es necesario.

La siguiente captura de pantalla muestra nuestros tipos de datos.

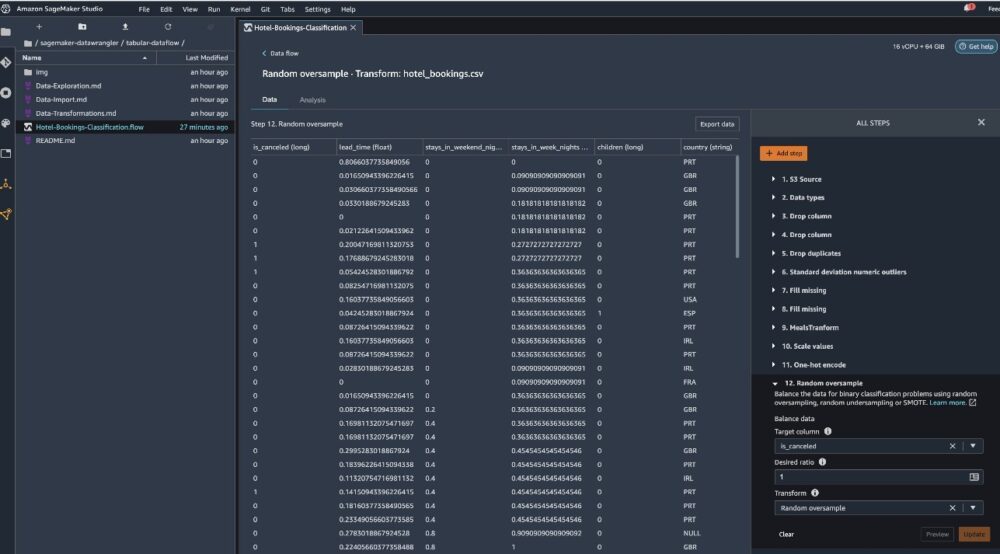

Veamos algunas de las transformaciones realizadas como parte de este flujo tabular. Si estás usando el series de tiempo or se unió a flujos de datos, consulte algunas transformaciones comunes en el Repositorio GitHub. Realizamos algunos análisis de datos exploratorios básicos utilizando informes de información de datos que estudiaron la fuga objetivo y la colinealidad de características en el conjunto de datos, análisis de resumen de tablas y capacidad de modelado rápido. Explore los pasos en el Repositorio GitHub.

Ahora soltamos columnas según las recomendaciones proporcionadas por el Informe de calidad y análisis de datos.

- Para fuga objetivo, suelte estado_reserva.

- Para columnas redundantes, suelte días_en_lista_de_espera, hotel, tipo_de_habitación_reservada, fecha_de_llegada_mes, fecha_de_estado_de_la_reserva, bebés, y fecha_de_llegada_día_del_mes.

- Basado en los resultados de la correlación lineal, descartar columnas fecha_de_llegada_número_de_la_semana y fecha_de_llegada_año porque los valores de correlación para estos pares de características (columnas) son mayores que el umbral recomendado de 0.90.

- Con base en los resultados de la correlación no lineal, suelte estado_reserva. Esta columna ya se marcó para eliminarse según el análisis de fuga objetivo.

- Procesar valores numéricos (escala min-max) para lead_time, estancias_en_noches_de_fin de semana, estancias_en_noches_de_día_de_semana, es_invitado_repetido, cancelaciones_previas, reservas_prev_no_canceladas, cambios_de_reserva, adr, total_de_solicitudes_específicas, y espacios_de_estacionamiento_de_coche_requeridos.

- One-hot codifica variables categóricas como comida, es_invitado_repetido, segmento_mercado, tipo_habitación_asignado, tipo_depósito, y tipo de cliente.

- Equilibre la variable de destino Sobremuestreo aleatorio para el desequilibrio de clase. Use la capacidad de modelado rápido para manejar valores atípicos y faltantes.

Exportar a Amazon S3

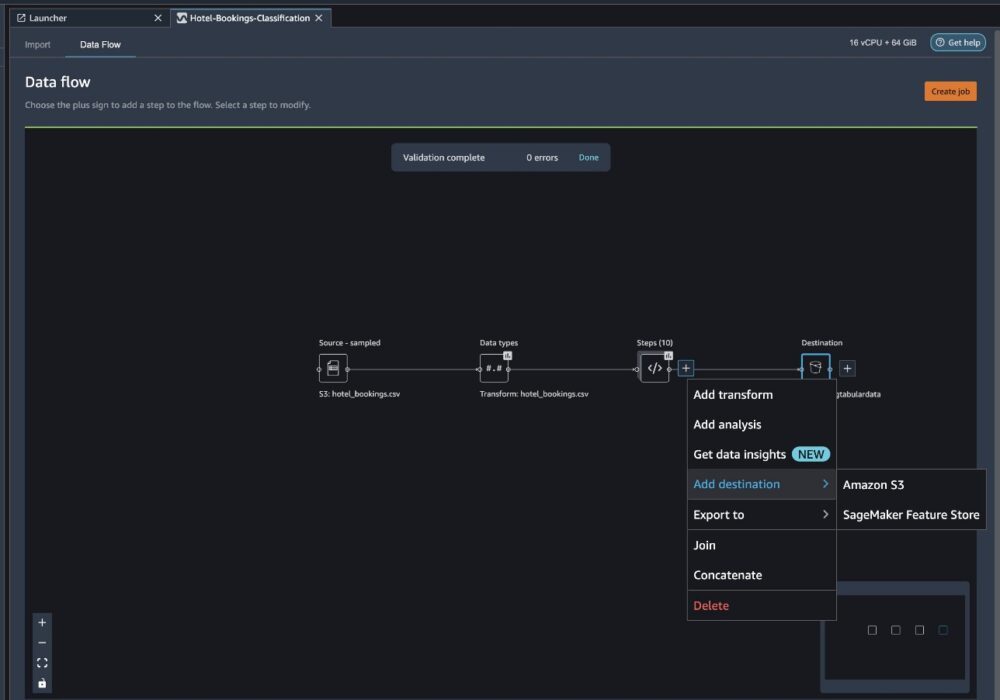

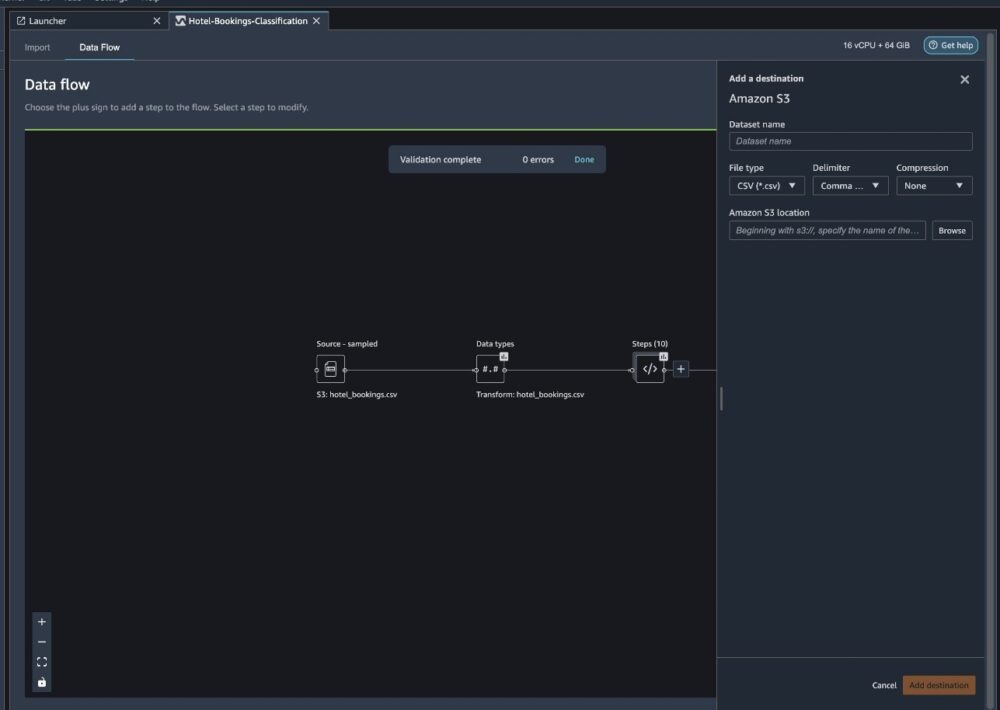

Ahora hemos pasado por las diferentes transformaciones y estamos listos para exportar los datos a Amazon S3. Esta opción crea un trabajo de procesamiento de SageMaker, que ejecuta el flujo de procesamiento de Data Wrangler y guarda el conjunto de datos resultante en un depósito de S3 específico. Siga los siguientes pasos para configurar la exportación a Amazon S3:

Elija el signo más junto a una colección de elementos de transformación y elija Añadir destino, entonces Amazon S3.

- Nombre del conjunto de datos, ingrese un nombre para el nuevo conjunto de datos, por ejemplo

NYC_export. - Tipo de Archivo, escoger CSV.

- Delimitador, escoger Coma.

- Compresión, escoger Ninguna.

- Ubicación de Amazon S3, use el mismo nombre de depósito que creamos anteriormente.

- Elige Añadir destino.

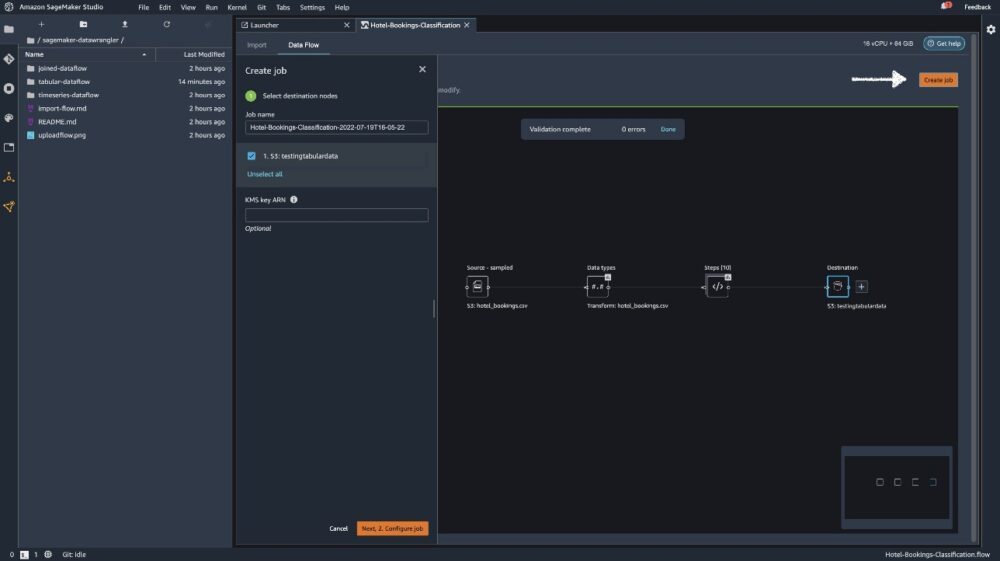

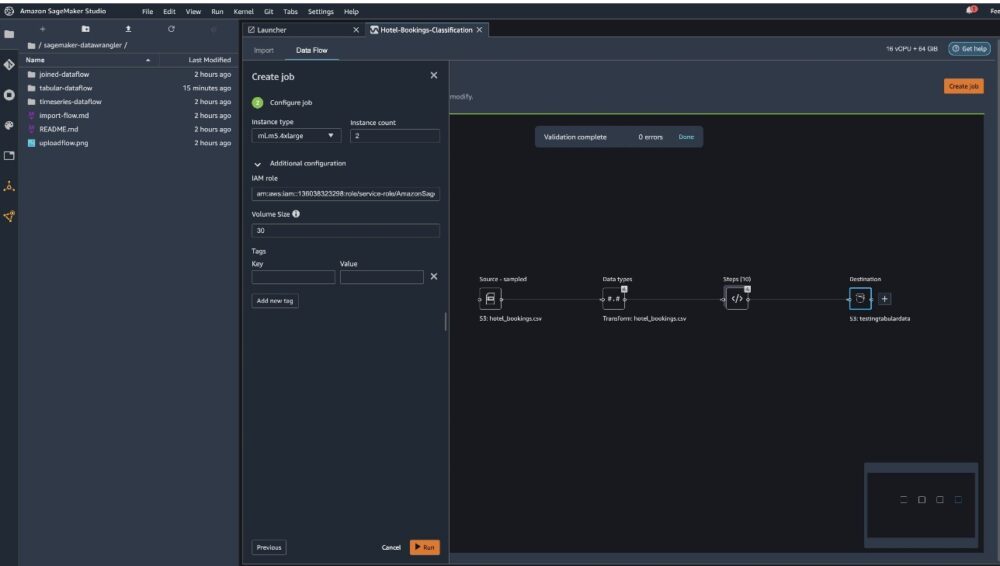

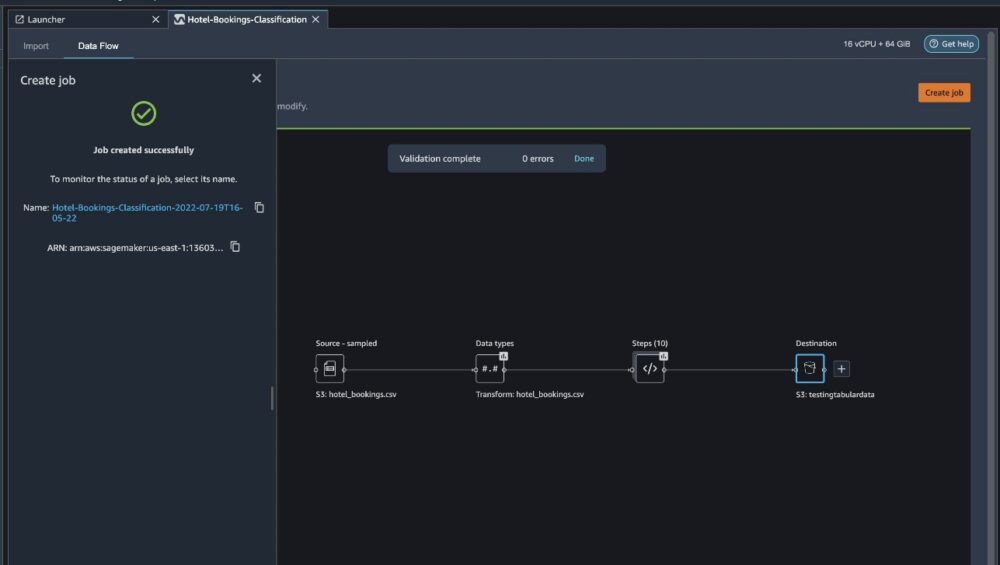

Elige Crear trabajo.

Nombre del trabajo, ingrese un nombre o mantenga la opción generada automáticamente y elija destino. Tenemos un solo destino, S3:testingtabulardata, pero es posible que tenga varios destinos de diferentes pasos en su flujo de trabajo. Deja el ARN de la clave de KMS campo vacío y elija Siguiente.

Ahora debe configurar la capacidad de cómputo para un trabajo. Puede mantener todos los valores predeterminados para este ejemplo.

- Tipo de instancia, utilice ml.m5.4xlarge.

- Recuento de instancias, usa 2.

- Puedes explorar Configuración adicional, pero mantenga la configuración predeterminada.

- Elige Ejecutar.

Ahora su trabajo ha comenzado y lleva algún tiempo procesar 6 GB de datos de acuerdo con nuestro flujo de procesamiento de Data Wrangler. El costo de este trabajo será de alrededor de $2 USD, porque ml.m5.4xlarge cuesta $0.922 USD por hora y estamos usando dos de ellos.

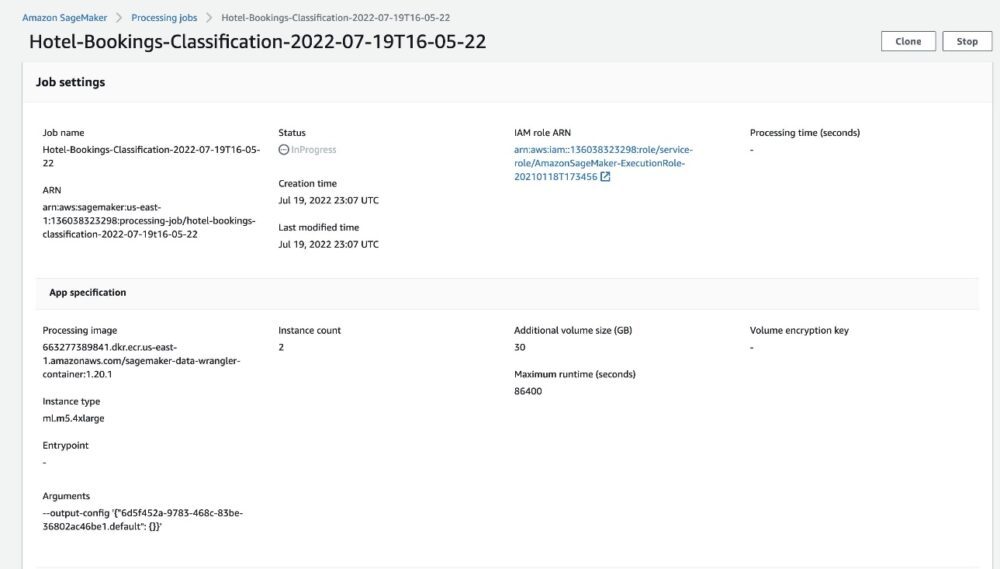

Si elige el nombre del trabajo, será redirigido a una nueva ventana con los detalles del trabajo.

En la página de detalles del trabajo, puede ver todos los parámetros de los pasos anteriores.

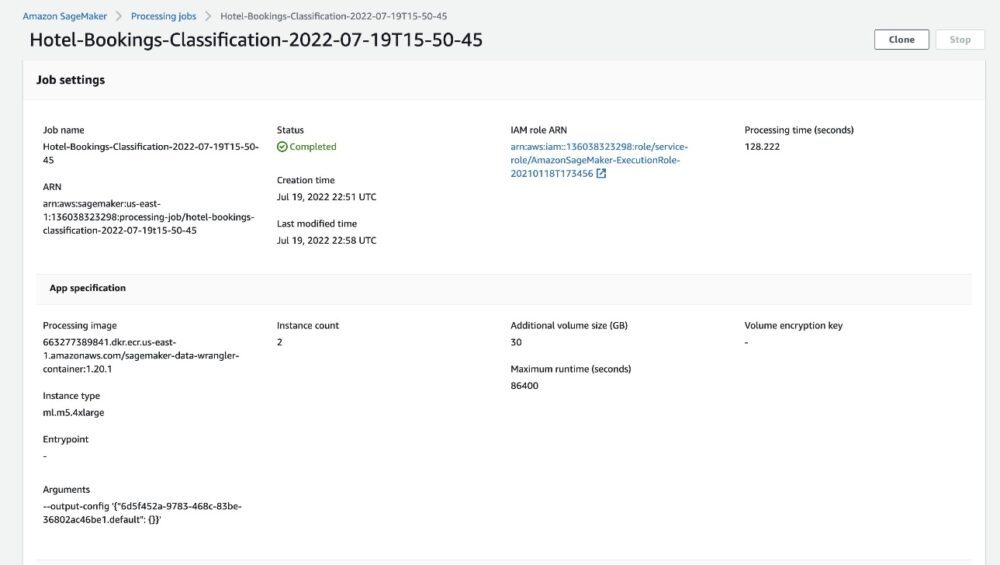

Cuando el estado del trabajo cambia a Completado, también puede verificar el Tiempo de procesamiento (segundos) valor. Este trabajo de procesamiento tarda entre 5 y 10 minutos en completarse.

Cuando se completa el trabajo, los archivos de salida de entrenamiento y prueba están disponibles en las carpetas de salida de S3 correspondientes. Puede encontrar la ubicación de salida en las configuraciones del trabajo de procesamiento.

Una vez que se completa el trabajo de procesamiento de Data Wrangler, podemos verificar los resultados guardados en nuestro depósito S3. No olvides actualizar el job_name variable con el nombre de su trabajo.

Ahora puede usar estos datos exportados para ejecutar modelos ML.

Limpiar

Elimine sus cubos S3 y su Flujo de administrador de datos para eliminar los recursos subyacentes y evitar costos no deseados después de finalizar el experimento.

Conclusión

En esta publicación, mostramos cómo puede importar el flujo de datos tabulares preconstruidos a Data Wrangler, conectarlo con nuestro conjunto de datos y exportar los resultados a Amazon S3. Si sus casos de uso requieren que manipule datos de series temporales o que se una a varios conjuntos de datos, puede revisar los otros flujos de muestra prediseñados en el Repositorio GitHub.

Una vez que haya importado un flujo de trabajo de preparación de datos preconstruido, puede integrarlo con Amazon SageMaker Processing, Canalizaciones de Amazon SageMakery Tienda de funciones de Amazon SageMaker para simplificar la tarea de procesar, compartir y almacenar datos de entrenamiento de ML. También puede exportar este flujo de datos de muestra a una secuencia de comandos de Python y crear una canalización de preparación de datos de ML personalizada, acelerando así su velocidad de lanzamiento.

Le recomendamos que consulte nuestra Repositorio GitHub para obtener práctica y encontrar nuevas formas de mejorar la precisión del modelo. Para obtener más información sobre SageMaker, visite el Guía para desarrolladores de Amazon SageMaker.

Acerca de los autores

Isha Dua es un Arquitecto de Soluciones Sénior con sede en el Área de la Bahía de San Francisco. Ella ayuda a los clientes empresariales de AWS a crecer mediante la comprensión de sus objetivos y desafíos, y los guía sobre cómo pueden diseñar sus aplicaciones de manera nativa en la nube mientras se asegura de que sean resistentes y escalables. Le apasionan las tecnologías de aprendizaje automático y la sostenibilidad ambiental.

Isha Dua es un Arquitecto de Soluciones Sénior con sede en el Área de la Bahía de San Francisco. Ella ayuda a los clientes empresariales de AWS a crecer mediante la comprensión de sus objetivos y desafíos, y los guía sobre cómo pueden diseñar sus aplicaciones de manera nativa en la nube mientras se asegura de que sean resistentes y escalables. Le apasionan las tecnologías de aprendizaje automático y la sostenibilidad ambiental.

- AI

- arte ai

- generador de arte ai

- robot ai

- Amazon SageMaker

- Wrangler de datos de Amazon SageMaker

- inteligencia artificial

- certificación de inteligencia artificial

- inteligencia artificial en banca

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- Aprendizaje automático de AWS

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- deep learning

- google ai

- máquina de aprendizaje

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- escala ia

- sintaxis

- zephyrnet