Las empresas farmacéuticas que buscan la aprobación de agencias reguladoras como la Administración de Drogas y Alimentos de los EE. UU. (FDA) o la Agencia Japonesa de Productos Farmacéuticos y Dispositivos Médicos (PMDA) para vender sus medicamentos en el mercado deben presentar evidencia para demostrar que su medicamento es seguro y efectivo para el propósito previsto. usar. Un equipo de médicos, estadísticos, químicos, farmacólogos y otros científicos clínicos revisan los datos de envío del ensayo clínico y el etiquetado propuesto. Si la revisión establece que existe evidencia estadística suficiente para demostrar que los beneficios para la salud del medicamento superan los riesgos, se aprueba la venta del medicamento.

El paquete de envío de ensayos clínicos consta de datos tabulados, datos de análisis, metadatos de ensayos e informes estadísticos que consisten en tablas estadísticas, listados y figuras. En el caso de la FDA de EE. UU., el documento técnico común electrónico (eCTD) es el formato estándar para enviar solicitudes, enmiendas, suplementos e informes al Centro de Evaluación e Investigación Biológica (CBER) y al Centro de Evaluación e Investigación de Medicamentos de la FDA ( CDER). Para la FDA y el PMDA japonés, es un requisito normativo enviar datos tabulados en CDISC Standard Data Tabulation Model (SDTM), datos de análisis en CDISC Analysis Dataset Model (ADaM) y metadatos de prueba en CDISC Define-XML (basado en Operational Data Model (ODM)).

En esta publicación, demostramos cómo podemos usar RStudio en Amazon SageMaker para crear dichos entregables de presentación regulatoria. Esta publicación describe el proceso de envío de ensayos clínicos, cómo podemos ingerir datos de investigación de ensayos clínicos, tabular y analizar los datos, y luego crear informes estadísticos: tablas de resumen, listas de datos y figuras (TLF). Este método puede permitir a los clientes farmacéuticos conectarse sin problemas a los datos clínicos almacenados en su entorno de AWS, procesarlos con R y ayudar a acelerar el proceso de investigación de ensayos clínicos.

Proceso de desarrollo de fármacos

El proceso de desarrollo de fármacos se puede dividir en términos generales en cinco pasos principales, como se ilustra en la siguiente figura.

Toma un promedio de 10 a 15 años y aproximadamente USD $ 1 a 3 mil millones para que un medicamento reciba una aprobación exitosa de alrededor de 10,000 moléculas potenciales. Durante las primeras fases de la investigación (la fase de descubrimiento de fármacos), se identifican candidatos a fármacos prometedores, que avanzan hacia la investigación preclínica. Durante la fase preclínica, los investigadores intentan averiguar la toxicidad del fármaco realizando in vitro experimentos en el laboratorio y in vivo experimentos con animales. Después de las pruebas preclínicas, los medicamentos pasan a la fase de investigación de ensayos clínicos, donde deben probarse en humanos para determinar su seguridad y eficacia. Los investigadores diseñan ensayos clínicos y detallan el plan de estudio en el protocolo del ensayo clínico. Definen las diferentes fases de investigación clínica, desde pequeños estudios de fase 1 para determinar la seguridad y la dosis del fármaco, hasta ensayos de fase 2 más grandes para determinar la eficacia y los efectos secundarios del fármaco, hasta ensayos de fase 3 y 4 aún más grandes para determinar la eficacia, la seguridad y la eficacia del fármaco. seguimiento de reacciones adversas. Después de ensayos clínicos exitosos en humanos, el patrocinador del fármaco presenta una Solicitud de nuevo fármaco (NDA) para comercializar el fármaco. Las agencias reguladoras revisan todos los datos, trabajan con el patrocinador en la información del etiquetado de recetas y aprueban el medicamento. Después de la aprobación del fármaco, las agencias reguladoras revisan los informes de seguridad posteriores a la comercialización para garantizar la seguridad del producto completo.

En 1997, el Consorcio de Estándares de Intercambio de Datos Clínicos (CDISC), una organización global sin fines de lucro compuesta por compañías farmacéuticas, CRO, biotecnología, instituciones académicas, proveedores de atención médica y agencias gubernamentales, se inició como un grupo de voluntarios. CDISC ha publicado estándares de datos para agilizar el flujo de datos desde la recopilación hasta los envíos, y facilitó el intercambio de datos entre socios y proveedores. CDISC ha publicado los siguientes estándares:

- CDASH (Armonización de Estándares de Adquisición de Datos Clínicos) – Estándares para los datos recopilados

- SDTM (Modelo de tabulación de datos del estudio) – Normas para la presentación de datos tabulados

- ADaM (modelo de datos de análisis) – Estándares para el análisis de datos

- SEND (Estándar para el intercambio de datos no clínicos) – Estándares para datos no clínicos

- PRM (modelo de representación de protocolo) – Estándares para el protocolo

Estos estándares pueden ayudar a los revisores capacitados a analizar los datos de manera más efectiva y rápida utilizando herramientas estándar, lo que reduce los tiempos de aprobación de medicamentos. Es un requisito reglamentario de la FDA de EE. UU. y la PMDA japonesa enviar todos los datos tabulados utilizando el formato SDTM.

R para presentaciones de investigación de ensayos clínicos

SAS y R son dos de los software de análisis estadístico más utilizados en la industria farmacéutica. Cuando CDISC inició el desarrollo de los estándares SDTM, SAS era de uso casi universal en la industria farmacéutica y en la FDA. Sin embargo, R está ganando una gran popularidad hoy en día porque es de código abierto y se agregan continuamente nuevos paquetes y bibliotecas. Los estudiantes usan R principalmente durante sus estudios e investigaciones, y llevan esta familiaridad con R a sus trabajos. R también ofrece soporte para tecnologías emergentes, como integraciones avanzadas de aprendizaje profundo.

Los proveedores de la nube como AWS ahora se han convertido en la plataforma elegida por los clientes farmacéuticos para alojar su infraestructura. AWS también proporciona servicios administrados como SageMaker, que facilita la creación, el entrenamiento y la implementación de modelos de aprendizaje automático (ML) en la nube. SageMaker también permite el acceso al IDE de RStudio desde cualquier lugar a través de un navegador web. Esta publicación detalla cómo los programadores estadísticos y bioestadísticos pueden ingerir sus datos clínicos en el entorno R, cómo se puede ejecutar el código R y cómo se almacenan los resultados. Proporcionamos fragmentos de código que permiten a los científicos de datos de ensayos clínicos ingerir archivos XPT en el entorno R, crear marcos de datos R para SDTM y ADaM y, finalmente, crear TLF que se pueden almacenar en un Servicio de almacenamiento simple de Amazon (Amazon S3) cubeta de almacenamiento de objetos.

RStudio en SageMaker

El 2 de noviembre de 2021, AWS en colaboración con RStudio PBC anunció la disponibilidad general de RStudio en SageMaker, el primer IDE RStudio Workbench completamente administrado de la industria en la nube. Ahora puede traer su licencia actual de RStudio para migrar fácilmente sus entornos de RStudio autoadministrados a SageMaker en solo unos pocos pasos. Para obtener más información sobre esta emocionante colaboración, consulte Anuncio de RStudio en Amazon SageMaker.

Junto con RStudio Workbench, la suite RStudio para desarrolladores de R también ofrece RStudio Connect y RStudio Package Manager. RStudio Connect está diseñado para permitir que los científicos de datos publiquen información, paneles y aplicaciones web. Facilita el intercambio de conocimientos de ciencia de datos y ML del trabajo complicado de los científicos de datos y lo pone en manos de los responsables de la toma de decisiones. RStudio Connect también hace que el alojamiento y la gestión de contenido sean sencillos y escalables para un amplio consumo.

Resumen de la solución

En las siguientes secciones, analizamos cómo podemos importar datos sin procesar desde un repositorio remoto o un depósito S3 en RStudio en SageMaker. También es posible conectarse directamente a Servicio de base de datos relacional de Amazon (Amazon RDS) y almacenes de datos como Desplazamiento al rojo de Amazon (consulta: Conexión de R con Amazon Redshift) directamente desde RStudio; sin embargo, esto está fuera del alcance de esta publicación. Una vez que se han ingerido los datos de un par de fuentes diferentes, los procesamos y creamos marcos de datos R para una tabla. Luego, convertimos el marco de datos de la tabla en un archivo RTF y almacenamos los resultados en un depósito S3. Estos resultados se pueden usar potencialmente para fines de envío regulatorio, siempre que los paquetes R utilizados en la publicación hayan sido validados para su uso para envíos regulatorios por parte del cliente.

Configurar RStudio en SageMaker

Para obtener instrucciones sobre cómo configurar RStudio en SageMaker en su entorno, consulte Comience con RStudio en SageMaker. Asegúrese de que la función de ejecución de RStudio en SageMaker tenga acceso para descargar y cargar datos en el depósito de S3 en el que se almacenan los datos. Para obtener más información sobre cómo administrar paquetes R y publicar su análisis mediante RStudio en SageMaker, consulte Anuncio de RStudio completamente administrado en SageMaker para científicos de datos.

Ingerir datos en RStudio

En este paso, ingerimos datos de varias fuentes para que estén disponibles para nuestra sesión de R. Importamos datos en formato SAS XPT; sin embargo, el proceso es similar si desea ingerir datos en otros formatos. Una de las ventajas de usar RStudio en SageMaker es que si los datos de origen se almacenan en sus cuentas de AWS, SageMaker puede acceder de forma nativa a los datos usando Gestión de identidades y accesos de AWS (IAM) funciones.

Acceda a los datos almacenados en un repositorio remoto

En este paso, importamos datos ADaM desde el Repositorio GitHub de la FDA. Creamos un directorio local llamado data en el entorno RStudio para almacenar los datos y descargar datos demográficos (dm.xpt) del repositorio remoto. En este contexto, el directorio local hace referencia a un directorio creado en su almacenamiento privado de Amazon EFS que se adjunta de forma predeterminada a su entorno de sesión de R. Ver el siguiente código:

Cuando se completa este paso, puede ver dm.xpt siendo descargado navegando a archivos, datos, dm.xpt.

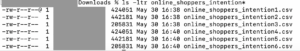

Acceda a los datos almacenados en Amazon S3

En este paso, descargamos datos almacenados en un depósito S3 en nuestra cuenta. Hemos copiado el contenido del repositorio GitHub de la FDA al depósito S3 llamado aws-sagemaker-rstudio para este ejemplo. Ver el siguiente código:

Cuando se completa el paso, puede ver pp.xpt siendo descargado navegando a archivos, datos, pp.xpt.

Procesar datos XPT

Ahora que tenemos archivos SAS XPT disponibles en el entorno R, debemos convertirlos en marcos de datos R y procesarlos. usamos el haven biblioteca para leer archivos XPT. Fusionamos conjuntos de datos CDISC SDTM dm y pp para crear un conjunto de datos ADPP. Luego, creamos una tabla estadística de resumen utilizando el marco de datos ADPP. A continuación, la tabla de resumen se exporta en formato RTF.

Primero, los archivos XPT se leen usando el read_xpt función de la biblioteca refugio. Luego se crea un conjunto de datos de análisis utilizando el sqldf función de la sqldf biblioteca. Ver el siguiente código:

Luego, se crea un marco de datos de salida usando funciones del Tplyr y dplyr bibliotecas:

El marco de datos de salida luego se almacena como un archivo RTF en la carpeta de salida en el entorno de RStudio:

Subir salidas a Amazon S3

Una vez que se ha generado la salida, volvemos a colocar los datos en un depósito S3. Podemos lograr esto creando una sesión de SageMaker nuevamente, si una sesión aún no está activa, y cargando el contenido de la carpeta de salida a un depósito S3 usando el session$upload_data función:

Con estos pasos, ingerimos datos, los procesamos y cargamos los resultados para que estén disponibles para su envío a las autoridades reguladoras.

Limpiar

Para evitar incurrir en costos no deseados, debe salir de su sesión actual. En la esquina superior derecha de la página, elija el ícono de encendido. Esto detendrá automáticamente la instancia subyacente y, por lo tanto, dejará de incurrir en costos informáticos no deseados.

Desafios

La publicación ha descrito los pasos para ingerir datos sin procesar almacenados en un depósito S3 o desde un repositorio remoto. Sin embargo, hay muchas otras fuentes de datos sin procesar para un ensayo clínico, principalmente datos eCRF (formularios electrónicos de informes de casos) almacenados en sistemas EDC (captura electrónica de datos) como Oracle Clinical, Medidata Rave, OpenClinica o Snowflake; datos de laboratorio; datos de eCOA (evaluación de resultados clínicos) y ePRO (resultados electrónicos informados por el paciente); datos del mundo real de aplicaciones y dispositivos médicos; y registros electrónicos de salud (HCE) en los hospitales. Se requiere un preprocesamiento significativo antes de que estos datos puedan utilizarse para presentaciones regulatorias. Construir conectores a varias fuentes de datos y recopilarlos en un repositorio de datos centralizado (CDR) o un lago de datos clínicos, mientras se mantienen controles de acceso adecuados, plantea desafíos importantes.

Otro desafío clave a superar es el del cumplimiento normativo. El sistema informático utilizado para crear los resultados de las presentaciones reglamentarias debe cumplir con las reglamentaciones correspondientes, como 21 CFR Parte 11, HIPAA, RGPD o cualquier otro requisito de GxP o las pautas de ICH. Esto se traduce en trabajar en un entorno validado y calificado con controles de acceso, seguridad, respaldo y auditabilidad implementados. Esto también significa que cualquier paquete de R que se utilice para crear resultados de presentación regulatoria debe validarse antes de su uso.

Conclusión

En esta publicación, vimos que algunos de los entregables clave para una presentación de eCTD fueron CDISC SDTM, conjuntos de datos ADaM y TLF. Esta publicación describió los pasos necesarios para crear estos entregables de presentación reglamentaria al ingerir primero datos de un par de fuentes en RStudio en SageMaker. Luego vimos cómo podemos procesar los datos ingeridos en formato XPT; convertirlo en marcos de datos R para crear SDTM, ADaM y TLF; y finalmente cargue los resultados en un depósito S3.

Esperamos que con las ideas generales expuestas en la publicación, los programadores estadísticos y bioestadísticos puedan visualizar fácilmente el proceso integral de carga, procesamiento y análisis de datos de investigación de ensayos clínicos en RStudio en SageMaker y utilizar los aprendizajes para definir un personalizado. flujo de trabajo adecuado para sus presentaciones reglamentarias.

¿Puede pensar en otras aplicaciones de RStudio para ayudar a los investigadores, estadísticos y programadores de R a hacer sus vidas más fáciles? ¡Nos encantaría escuchar tus ideas! Y si tienes alguna pregunta, por favor compártela en la sección de comentarios.

Recursos

Para obtener más información, visite los siguientes enlaces:

Sobre los autores

Rohit Banga es un especialista en la industria de desarrollo clínico global con sede en Londres, Reino Unido. Es bioestadístico de formación y ayuda a los clientes de Healthcare y LifeScience a implementar soluciones innovadoras de desarrollo clínico en AWS. Le apasiona cómo la ciencia de datos, la IA/ML y las tecnologías emergentes pueden usarse para resolver problemas comerciales reales dentro de la industria de la salud y las ciencias de la vida. En su tiempo libre, a Rohit le gusta esquiar, hacer barbacoas y pasar tiempo con familiares y amigos.

Rohit Banga es un especialista en la industria de desarrollo clínico global con sede en Londres, Reino Unido. Es bioestadístico de formación y ayuda a los clientes de Healthcare y LifeScience a implementar soluciones innovadoras de desarrollo clínico en AWS. Le apasiona cómo la ciencia de datos, la IA/ML y las tecnologías emergentes pueden usarse para resolver problemas comerciales reales dentro de la industria de la salud y las ciencias de la vida. En su tiempo libre, a Rohit le gusta esquiar, hacer barbacoas y pasar tiempo con familiares y amigos.

Georgios Schinas es Arquitecto de Soluciones Especializado en IA/ML en la región EMEA. Tiene su sede en Londres y trabaja en estrecha colaboración con clientes en el Reino Unido e Irlanda. Georgios ayuda a los clientes a diseñar e implementar aplicaciones de aprendizaje automático en producción en AWS con un interés particular en las prácticas de MLOps y permite a los clientes realizar aprendizaje automático a escala. En su tiempo libre, le gusta viajar, cocinar y pasar tiempo con amigos y familiares.

Georgios Schinas es Arquitecto de Soluciones Especializado en IA/ML en la región EMEA. Tiene su sede en Londres y trabaja en estrecha colaboración con clientes en el Reino Unido e Irlanda. Georgios ayuda a los clientes a diseñar e implementar aplicaciones de aprendizaje automático en producción en AWS con un interés particular en las prácticas de MLOps y permite a los clientes realizar aprendizaje automático a escala. En su tiempo libre, le gusta viajar, cocinar y pasar tiempo con amigos y familiares.

- AI

- arte ai

- generador de arte ai

- robot ai

- Amazon SageMaker

- Servicio de almacenamiento simple de Amazon (S3)

- inteligencia artificial

- certificación de inteligencia artificial

- inteligencia artificial en banca

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- Aprendizaje automático de AWS

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- deep learning

- google ai

- Intermedio (200)

- Ciencias de la vida

- máquina de aprendizaje

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- escala ia

- sintaxis

- zephyrnet