"Selle asemel, et keskenduda koodile, peaksid ettevõtted keskenduma süstemaatiliste tehniliste tavade väljatöötamisele andmete täiustamiseks viisil, mis on usaldusväärne, tõhus ja süstemaatiline. Teisisõnu peavad ettevõtted liikuma mudelikeskselt lähenemiselt andmekesksele lähenemisele. – Andrew Ng

Andmekeskne tehisintellekti lähenemisviis hõlmab kvaliteetsete andmetega tehisintellektisüsteemide ehitamist, mis hõlmab andmete ettevalmistamist ja funktsioonide kavandamist. See võib olla tüütu ülesanne, mis hõlmab andmete kogumist, avastamist, profiilide koostamist, puhastamist, struktureerimist, teisendamist, rikastamist, valideerimist ja andmete turvalist salvestamist.

Amazon SageMaker Data Wrangler on teenus Amazon SageMaker Studio mis pakub täielikku lahendust andmete importimiseks, ettevalmistamiseks, teisendamiseks, esitlemiseks ja analüüsimiseks, kasutades vähest või üldse mitte kodeerimist. Saate integreerida Data Wrangleri andmete ettevalmistamise voo oma masinõppe (ML) töövoogudesse, et lihtsustada andmete eeltöötlust ja funktsioonide inseneritööd, viies andmete ettevalmistamise kiiremini tootmisse, ilma et peaksite PySparki koodi autoreerima, Apache Sparki installima või klastreid looma.

Stsenaariumide puhul, kus peate andmete teisendamiseks lisama oma kohandatud skripte, saate kirjutada oma teisendusloogika Pandas, PySparkis või PySpark SQL-is. Data Wrangler toetab nüüd NLTK ja SciPy teeke kohandatud teisenduste loomiseks, et valmistada ette tekstiandmeid ML-i jaoks ja teostada piirangute optimeerimist.

Võite kokku puutuda stsenaariumidega, kus peate andmete teisendamiseks lisama oma kohandatud skriptid. Data Wrangleri kohandatud teisendusvõimalusega saate kirjutada oma teisendusloogika Pandas, PySparkis, PySpark SQL-is.

Selles postituses arutame, kuidas saate kirjutada oma kohandatud teisenduse NLTK-s, et valmistada ette tekstiandmed ML-i jaoks. Jagame ka mõnda kohandatud koodi teisenduse näidet, kasutades muid levinud raamistikke, nagu NLTK, NumPy, SciPy ja scikit-learn ning AWS AI teenused. Selle harjutuse jaoks kasutame Titanicu andmestik, populaarne andmestik ML-i kogukonnas, mis on nüüd lisatud kui a näidisandmekogum Data Wrangleris.

Lahenduse ülevaade

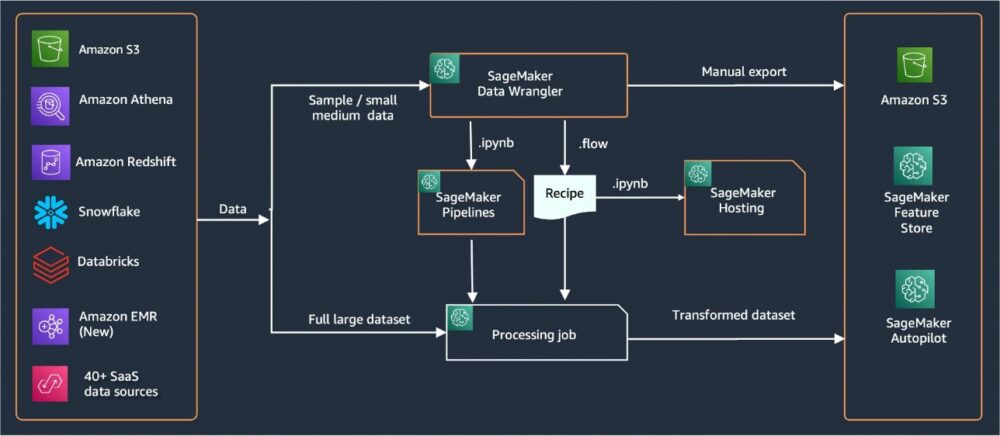

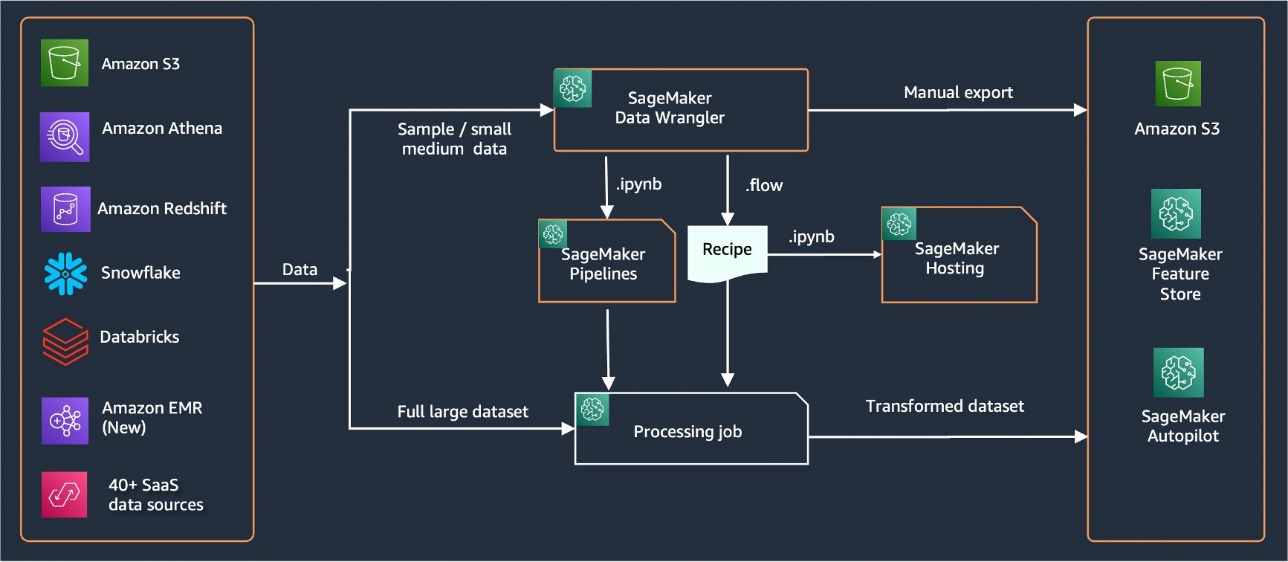

Data Wrangler pakub andmete importimiseks üle 40 sisseehitatud pistiku. Pärast andmete importimist saate luua oma andmete analüüsi ja teisendusi enam kui 300 sisseehitatud teisenduse abil. Seejärel saate funktsioonide kasutamiseks luua tööstuslikud torujuhtmed Amazoni lihtne salvestusteenus (Amazon S3) või Amazon SageMakeri funktsioonipood. Järgmine diagramm näitab täielikku kõrgtaseme arhitektuuri.

Eeldused

Data Wrangler on SageMakeri funktsioon, mis on saadaval Amazon SageMaker Studio. Saate jälgida Stuudio liitumisprotsess Studio keskkonna ja märkmikute keerutamiseks. Kuigi saate valida mõne autentimismeetodi vahel, on kõige lihtsam viis Studio domeeni loomiseks järgida Kiirjuhised. Kiirkäivitus kasutab samu vaikesätteid, mis Studio standardseadistus. Saate valida ka pardal oleva kasutamise AWS IAM identiteedikeskus (AWS Single Sign-On järglane) autentimiseks (vt Sisseehitatud Amazon SageMakeri domeeniga, kasutades IAM-i identiteedikeskust).

Importige Titanicu andmestik

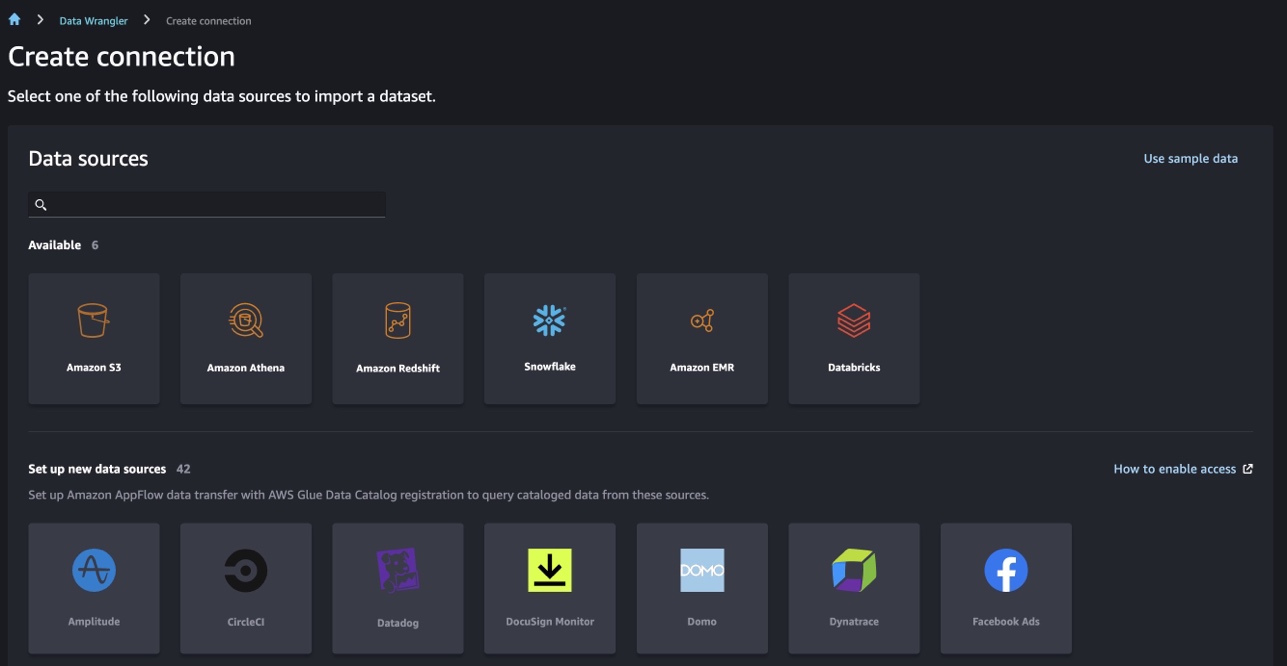

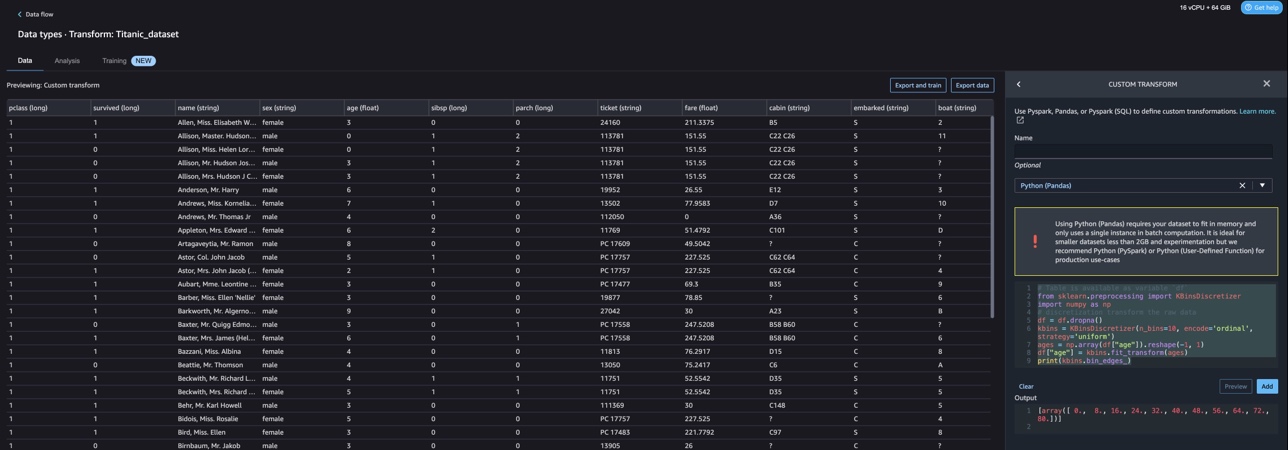

Käivitage oma Studio keskkond ja looge uus Data Wrangleri voog. Saate importida oma andmestiku või kasutada näidisandmestikku (Titanic), nagu on näidatud järgmisel ekraanipildil. Data Wrangler võimaldab importida andmekogumeid erinevatest andmeallikatest. Meie kasutusjuhtumi jaoks impordime näidisandmestiku S3 ämbrist.

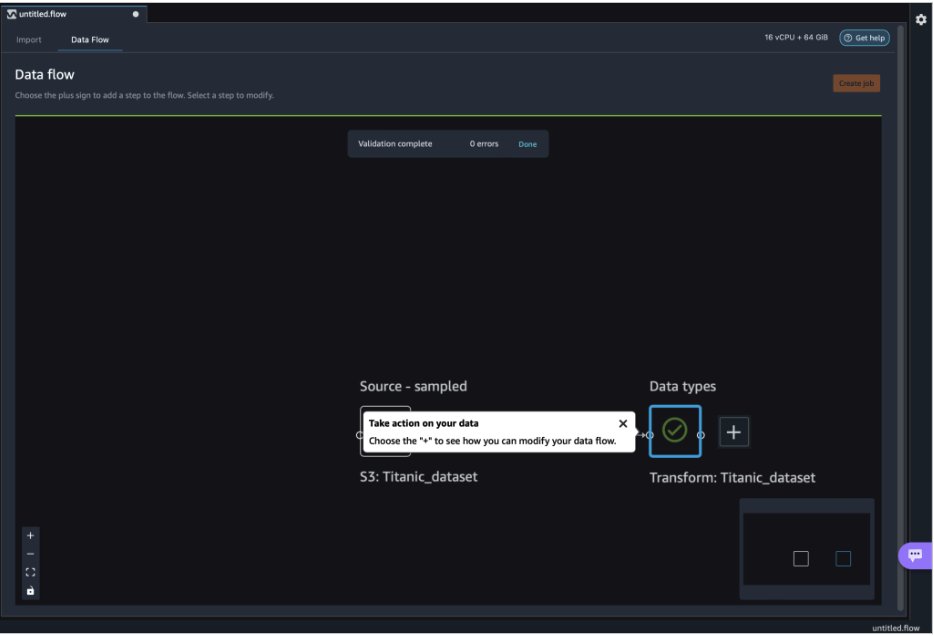

Pärast importimist näete andmevoos kahte sõlme (allikasõlm ja andmetüübi sõlm). Data Wrangler tuvastab andmestiku kõigi veergude andmetüübi automaatselt.

Kohandatud teisendused NLTK-ga

Andmete ettevalmistamiseks ja funktsioonide projekteerimiseks Data Wrangleriga saate kasutada üle 300 sisseehitatud teisenduse või luua oma kohandatud teisendusi. Kohandatud teisendused saab kirjutada eraldi sammudena Data Wrangleris. Need muutuvad Data Wrangleri .flow-faili osaks. Kohandatud teisendusfunktsioon toetab Pythoni, PySparki ja SQL-i koodilõikude erinevate etappidena. Pärast märkmikufailide (.ipynb) genereerimist .flow-failist või .flow-faili kasutamist retseptidena jäävad kohandatud teisenduskoodilõigud muudatusi tegemata. See Data Wrangleri disain võimaldab kohandatud teisendustest saada osa SageMakeri töötlemistööst, et töödelda kohandatud teisendustega suuri andmekogumeid.

Titanicu andmekogumil on paar funktsiooni (nimi ja home.dest), mis sisaldavad tekstiteavet. Me kasutame NLTK nime veeru poolitamiseks ja perekonnanime eraldamiseks ning perekonnanimede sageduse printimiseks. NLTK on juhtiv platvorm Pythoni programmide loomiseks inimkeele andmetega töötamiseks. See pakub hõlpsasti kasutatavaid liideseid üle 50 korpuse ja leksikaalse ressursi nagu WordNet koos tekstitöötlusteekide komplektiga klassifitseerimiseks, märgistamiseks, tüve moodustamiseks, märgistamiseks, sõelumiseks ja semantilisteks arutlusteks ning ümbristeks tööstusliku tugevusega loomuliku keele töötlemise (NLP) teekide jaoks.

Uue teisenduse lisamiseks toimige järgmiselt.

- Valige plussmärk ja valige Lisage teisendus.

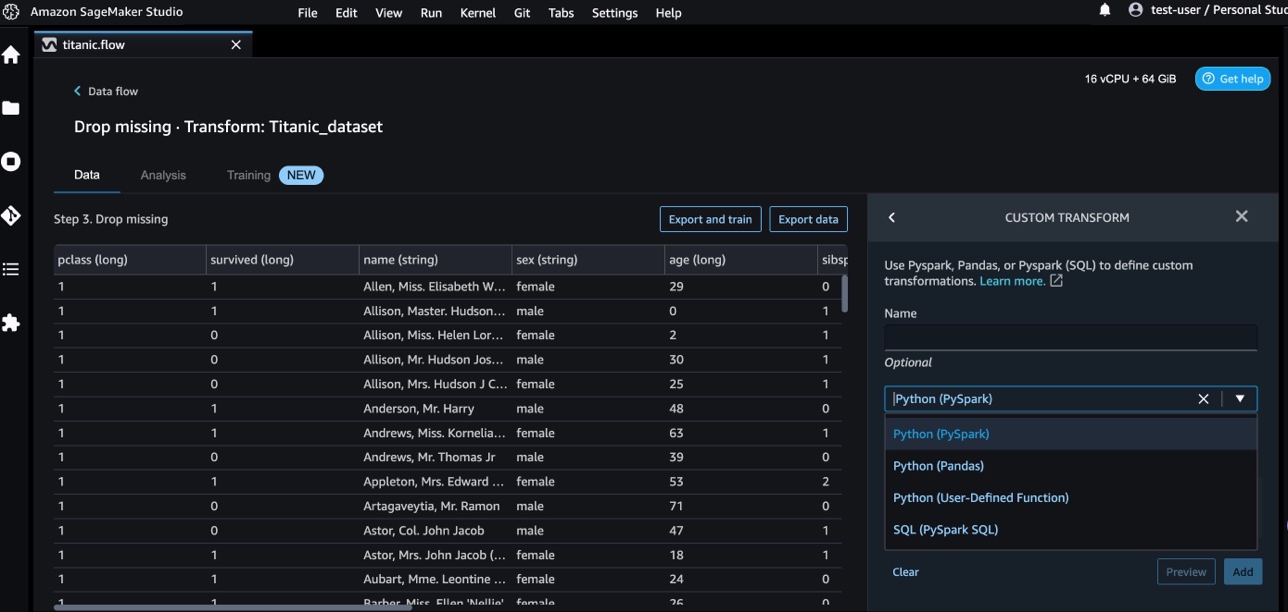

- Vali Lisa samm Ja vali Kohandatud teisendus.

Saate luua kohandatud teisenduse, kasutades Pandasi, PySparki, Pythoni kasutaja määratud funktsioone ja SQL PySparki.

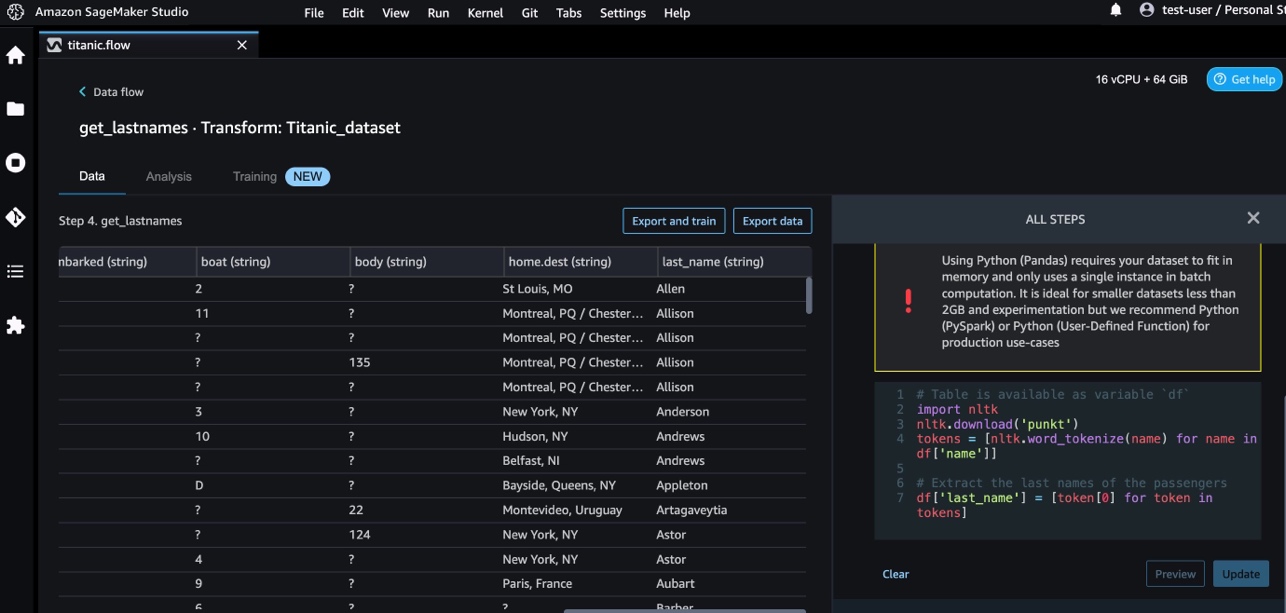

- Vali Python (Pandad) ja lisage perekonnanime veerust eraldamiseks järgmine kood:

- Vali Eelvaade tulemuste ülevaatamiseks.

Järgmine ekraanipilt näitab last_name veerg ekstraheeritud.

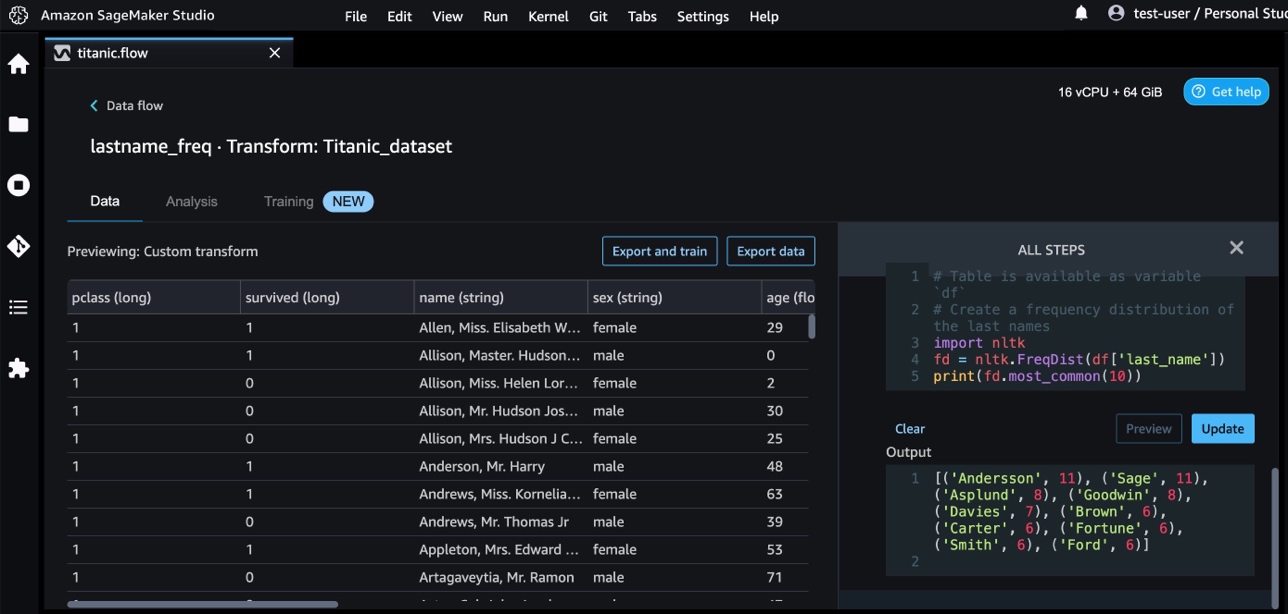

- Lisage perekonnanimede sagedusjaotuse tuvastamiseks veel üks kohandatud teisendusetapp, kasutades järgmist koodi:

- Vali Eelvaade sageduse tulemuste ülevaatamiseks.

Kohandatud teisendused AWS AI teenustega

AWS-i eelkoolitatud AI-teenused pakuvad teie rakenduste ja töövoogude jaoks valmis intelligentsust. AWS AI teenused on hõlpsasti integreeritavad teie rakendustega, et lahendada paljusid levinud kasutusjuhtumeid. Nüüd saate kasutada AWS AI teenuste võimalusi Data Wrangleri kohandatud teisendusetapina.

Amazoni mõistmine kasutab NLP-d dokumentide sisu kohta ülevaate saamiseks. See arendab teadmisi, tuvastades dokumendi olemid, võtmefraasid, keele, tunded ja muud levinud elemendid.

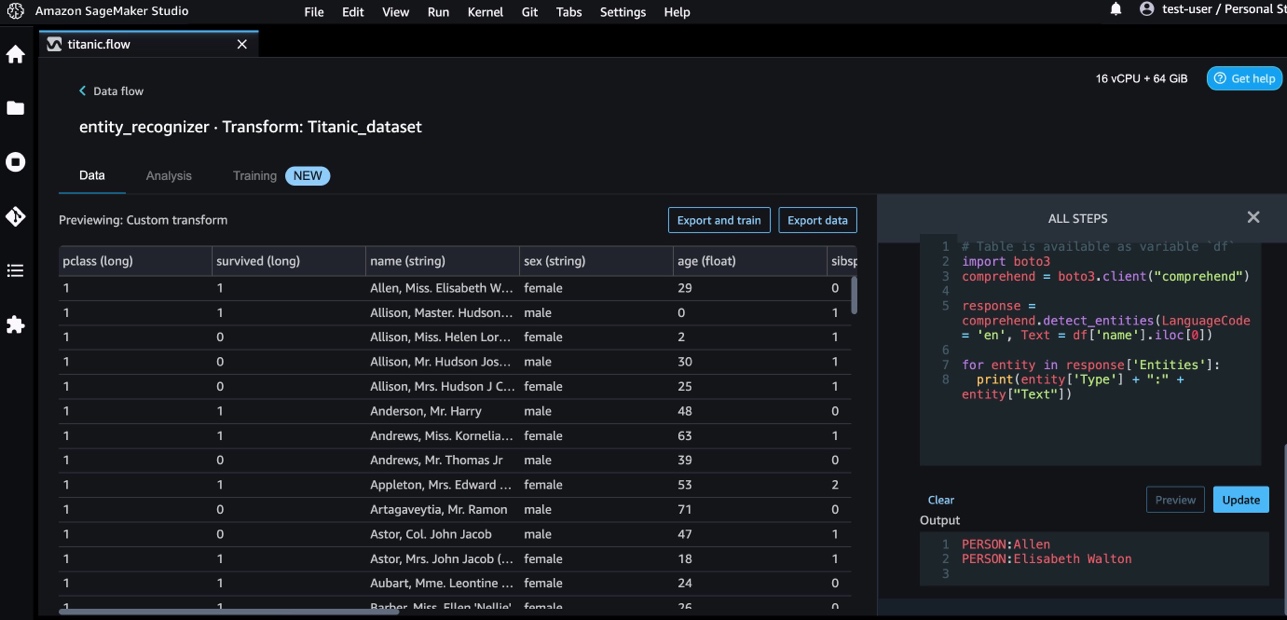

Üksuste nimeveerust eraldamiseks kasutame Amazon Comprehendi. Tehke järgmised sammud.

- Lisage kohandatud teisendusetapp.

- Vali Python (Pandad).

- Olemite eraldamiseks sisestage järgmine kood:

- Vali Eelvaade ja visualiseerida tulemusi.

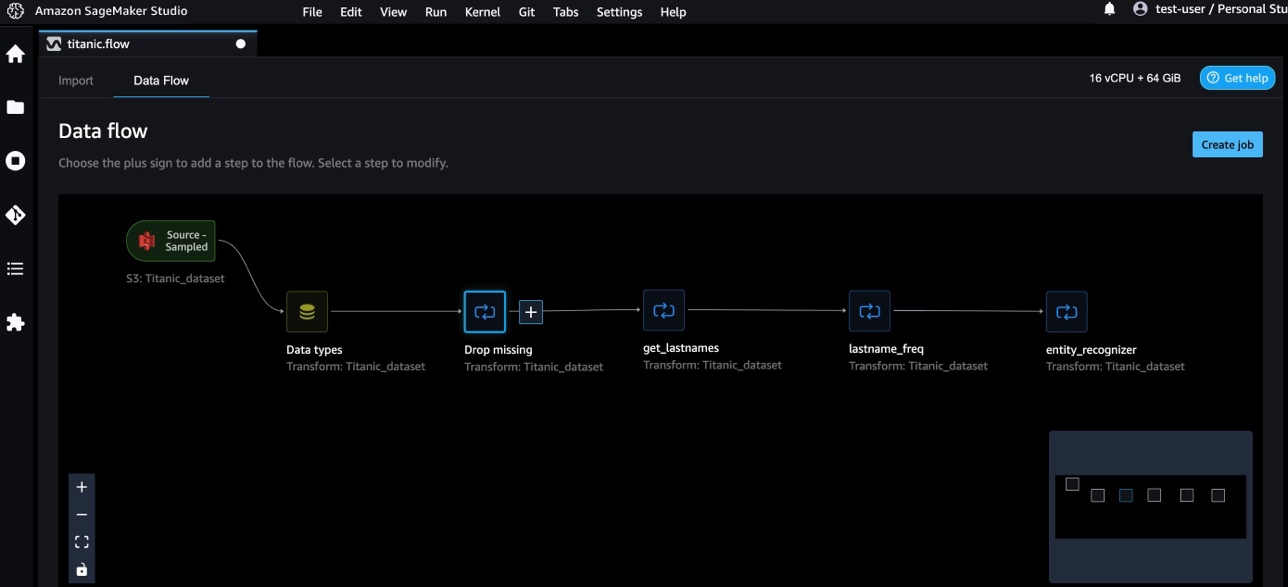

Oleme nüüd Data Wranglerisse lisanud kolm kohandatud teisendust.

- Vali Andmevoog otspunktidevahelise andmevoo visualiseerimiseks.

Kohandatud teisendused NumPy ja SciPy abil

tuim on Pythoni avatud lähtekoodiga teek, mis pakub põhjalikke matemaatilisi funktsioone, juhuslike arvude generaatoreid, lineaaralgebra rutiine, Fourier' teisendusi ja palju muud. SciPy on avatud lähtekoodiga Pythoni teek, mida kasutatakse teaduslikuks andmetöötluseks ja tehniliseks andmetöötluseks ning mis sisaldab optimeerimismooduleid, lineaaralgebrat, integreerimist, interpoleerimist, erifunktsioone, kiiret Fourier' teisendust (FFT), signaali- ja pilditöötlust, lahendajaid ja palju muud.

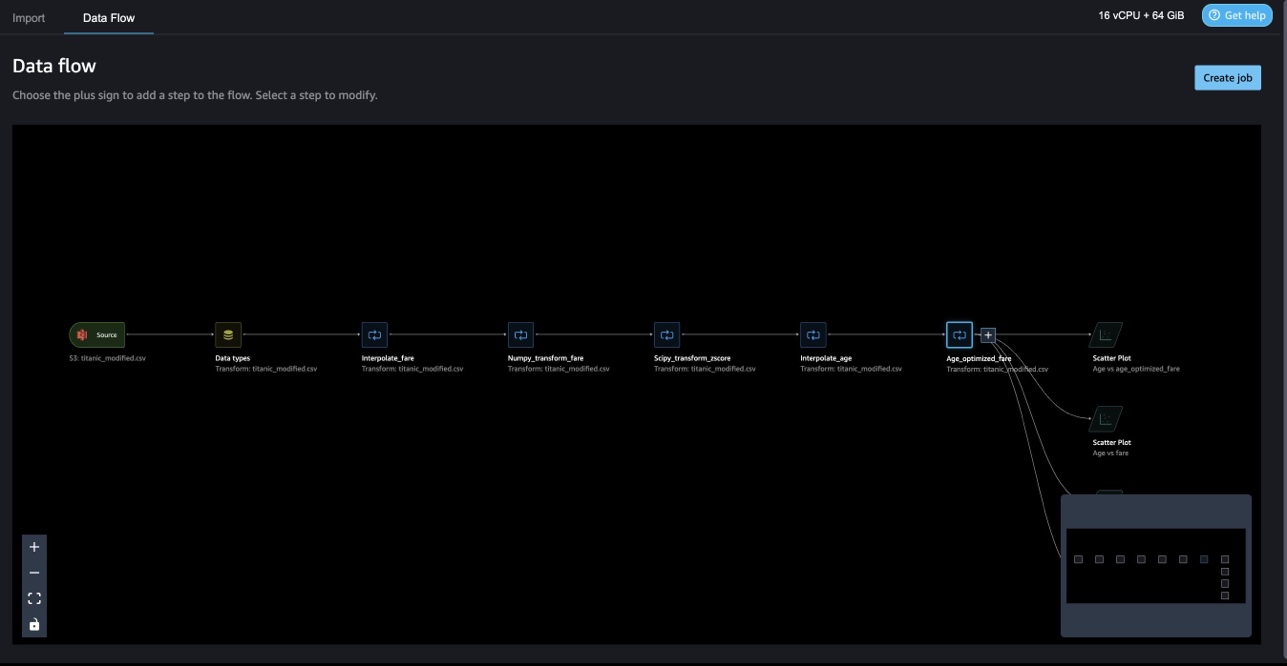

Data Wrangleri kohandatud teisendused võimaldavad kombineerida Pythoni, PySparki ja SQL-i erinevate sammudena. Järgmises Data Wrangleri voos rakendatakse Pythoni pakettide, NumPy ja SciPy erinevaid funktsioone Titanicu andmestikus mitme sammuna.

NumPy teisendused

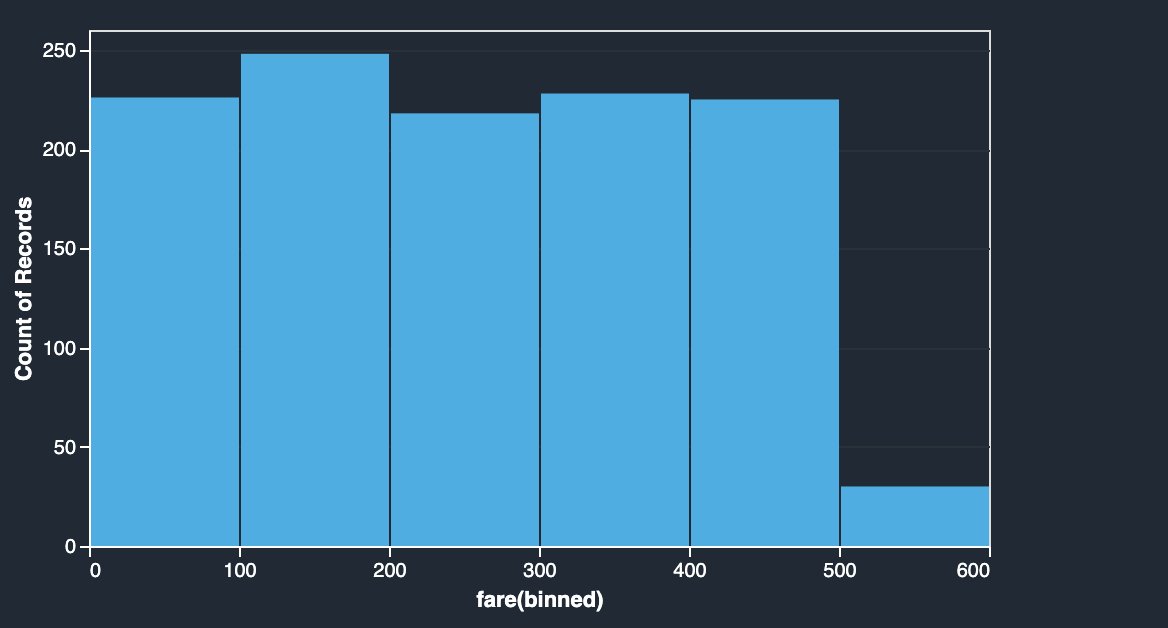

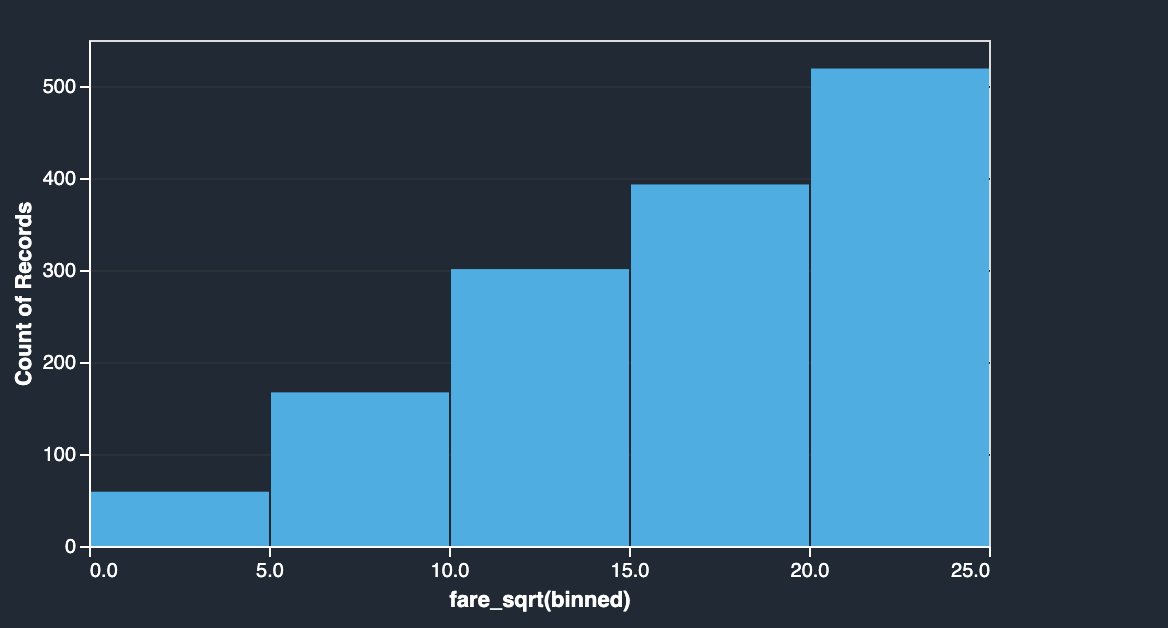

Titanicu andmestiku piletihinna veerus on erinevate reisijate pardahinnad. Piletihinna veeru histogramm näitab ühtlast jaotust, välja arvatud viimane prügikast. Rakendades NumPy teisendusi, nagu log või ruutjuur, saame jaotust muuta (nagu näitab ruutjuurteisendus).

|

|

Vaadake järgmist koodi:

SciPy teisendused

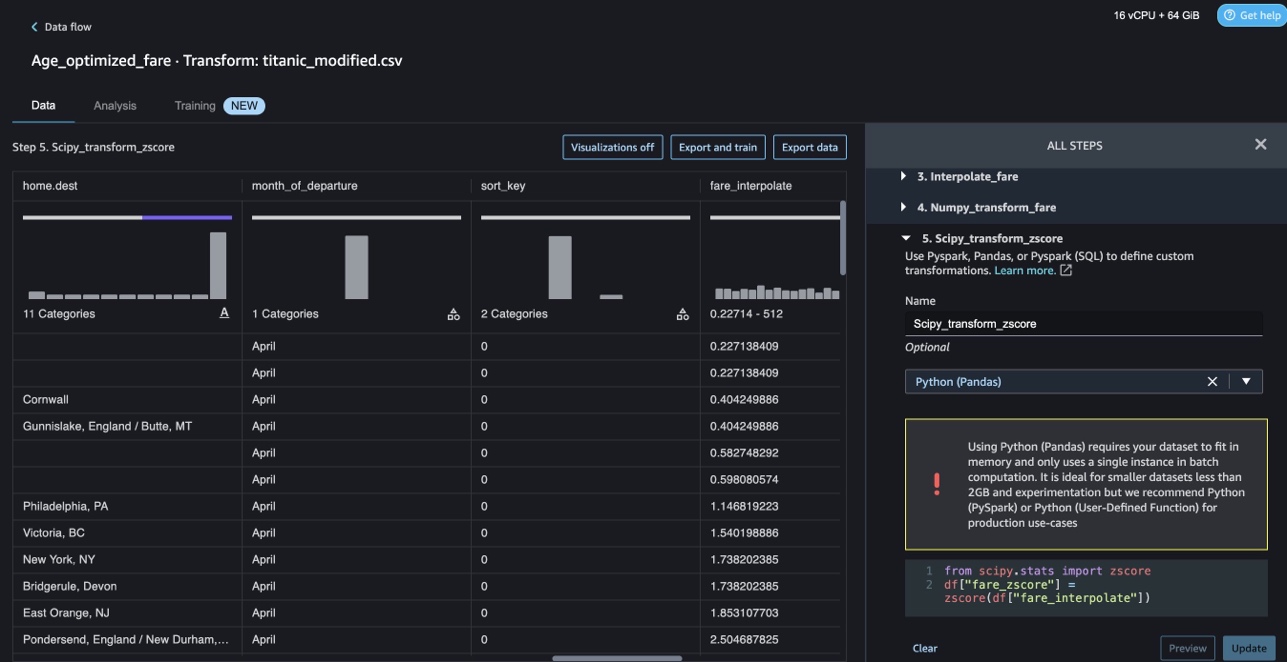

SciPy funktsioone, nagu z-skoor, rakendatakse kohandatud teisenduse osana, et standardida piletite jaotus keskmise ja standardhälbega.

Vaadake järgmist koodi:

Piirangute optimeerimine NumPy ja SciPy abil

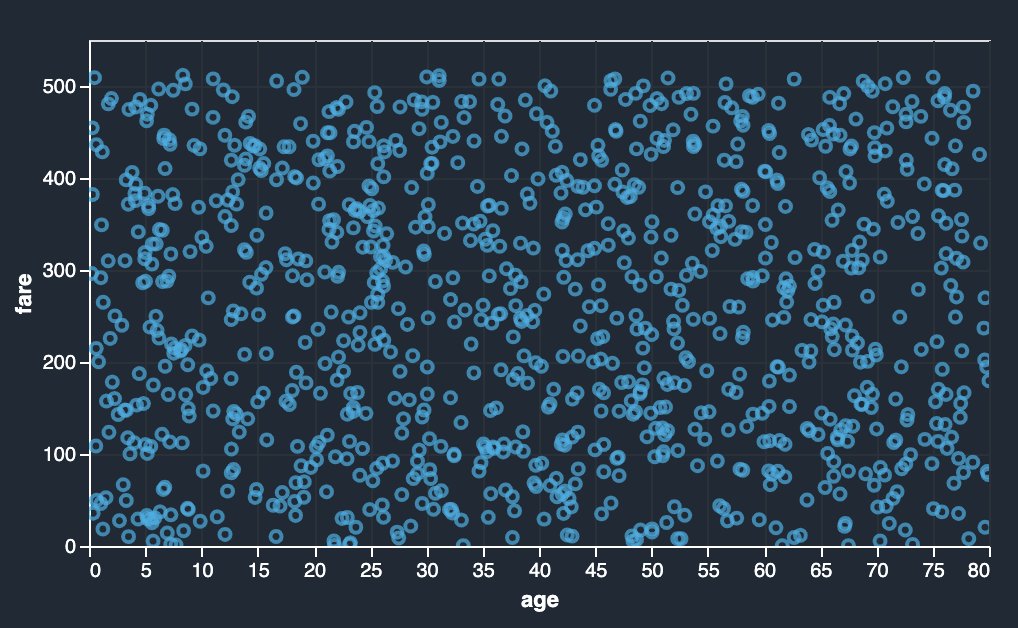

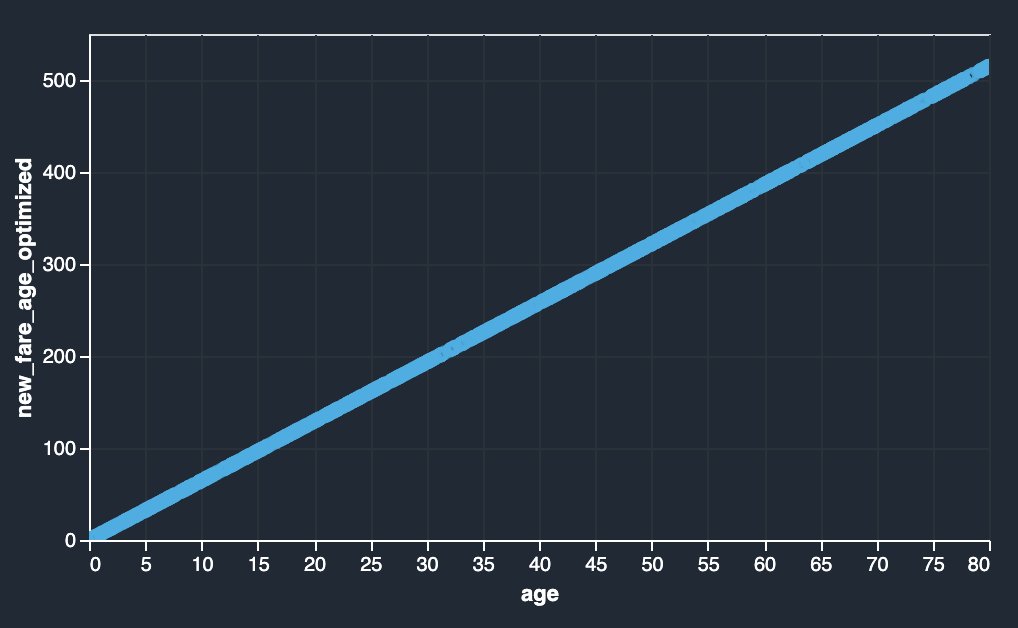

Data Wrangleri kohandatud teisendused saavad hakkama täiustatud teisendustega, nagu piirangute optimeerimine, rakendades SciPy optimeerimisfunktsioone ja kombineerides SciPy ja NumPy. Järgmises näites ei näita piletihind vanuse funktsioonina jälgitavat trendi. Piirangute optimeerimine võib aga muuta piletihinda vanuse funktsiooniks. Piiranguks on antud juhul see, et uus piletihind jääb samaks kui vana koguhind. Data Wrangleri kohandatud teisendused võimaldavad teil käivitada SciPy optimeerimisfunktsiooni, et määrata optimaalne koefitsient, mis võib piirangutingimuste korral muuta piletihinda vanuse funktsiooniks.

|

|

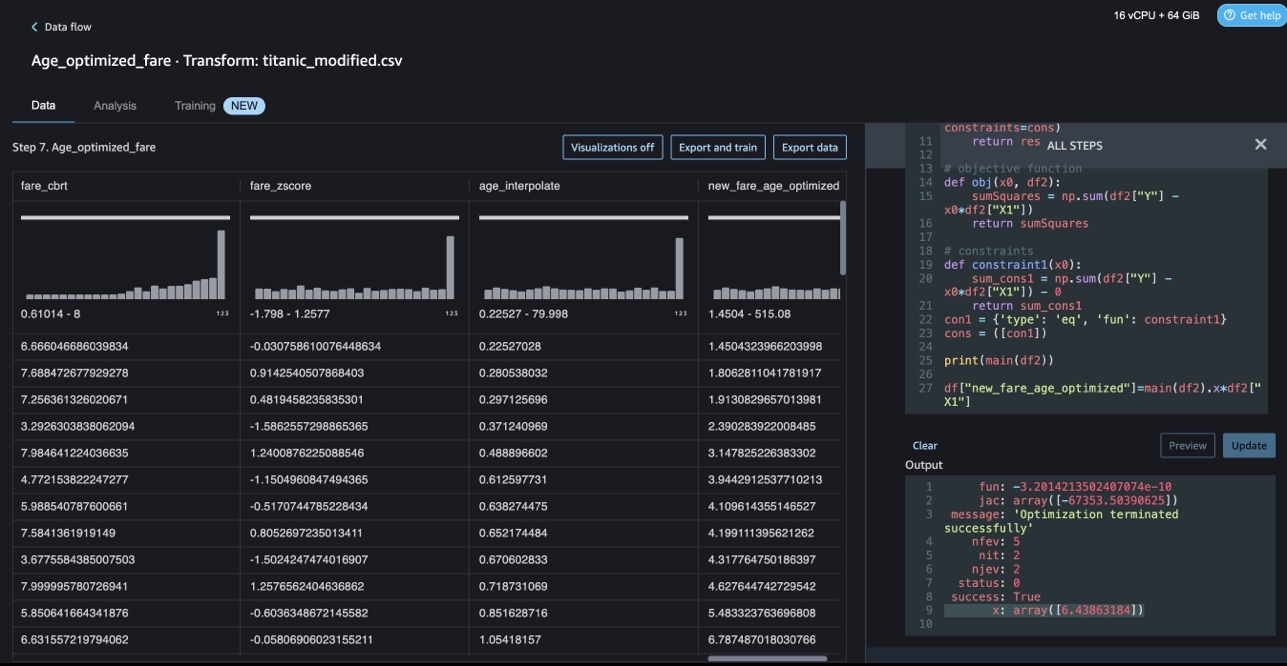

Optimeerimise määratlust, eesmärgi määratlust ja mitut piirangut võib mainida erinevate funktsioonidena, formuleerides piirangute optimeerimist Data Wrangleri kohandatud teisenduses, kasutades SciPy ja NumPy. Kohandatud teisendused võivad tuua ka erinevaid lahendamismeetodeid, mis on saadaval SciPy optimeerimispaketi osana. Uue teisendatud muutuja saab genereerida, korrutades optimaalse koefitsiendi algse veeruga ja lisades selle Data Wrangleri olemasolevatele veergudele. Vaadake järgmist koodi:

Data Wrangleri kohandatud teisendusfunktsioonil on kasutajaliidese võime kuvada SciPy optimeerimisfunktsioonide tulemusi, näiteks optimaalse koefitsiendi väärtust (või mitut koefitsienti).

Kohandatud teisendused scikit-learniga

skikit õppima on Pythoni moodul masinõppeks, mis on ehitatud SciPy peale. See on avatud lähtekoodiga ML-teek, mis toetab juhendatud ja järelevalveta õppimist. Samuti pakub see erinevaid tööriistu mudelite sobitamiseks, andmete eeltöötluseks, mudelite valimiseks, mudeli hindamiseks ja paljudeks muudeks utiliitideks.

Diskretiseerimine

Diskretiseerimine (muidu tuntud kui kvantimine or binning) annab võimaluse pidevate funktsioonide jaotamiseks diskreetseteks väärtusteks. Teatud pidevate funktsioonidega andmekogumid võivad kasu saada diskretiseerimisest, kuna diskreteerimine võib muuta pidevate atribuutide andmekogumi selliseks, millel on ainult nominaalsed atribuudid. Ühekordselt kodeeritud diskreetsed funktsioonid võivad muuta mudeli väljendusrikkamaks, säilitades samal ajal tõlgendatavuse. Näiteks eeltöötlemine diskretiseerijaga võib lisada lineaarsetele mudelitele mittelineaarsuse.

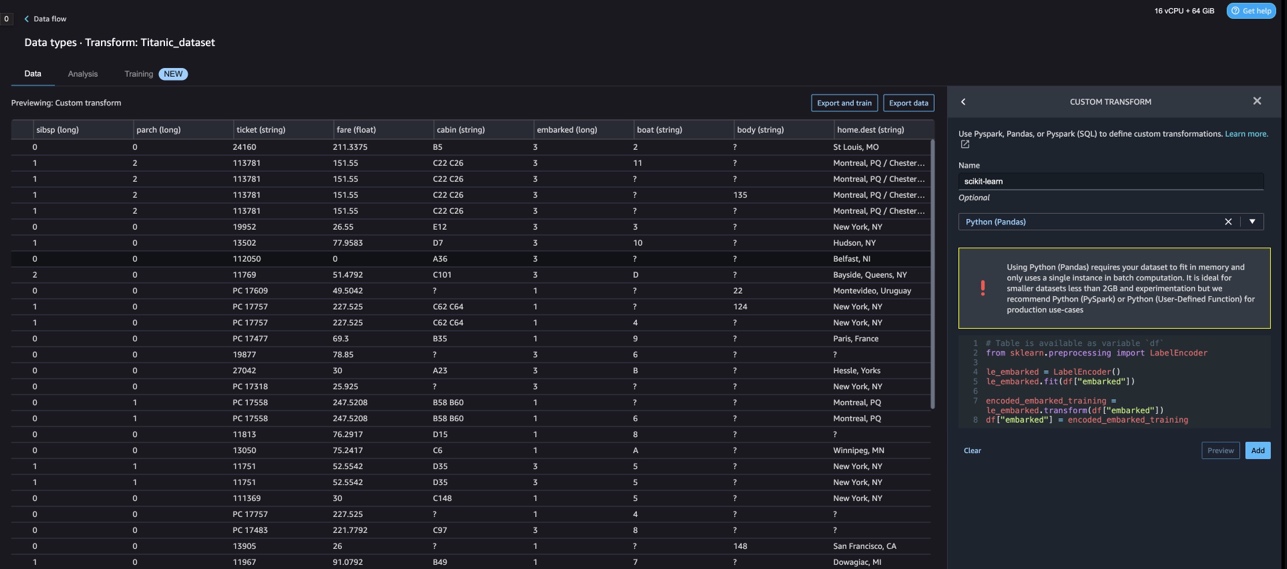

Järgmises koodis kasutame KBinsDiscretizer vanuse veeru diskreteerimiseks 10 prügikasti:

Järgmisel ekraanipildil on prinditud prügikasti servad.

Üks kuum kodeering

Väärtused veergudes Embarked on kategoorilised väärtused. Seetõttu peame oma mudeliga klassifitseerimiseks esitama need stringid arvväärtustena. Saaksime seda teha ka ühe kuuma kodeeringu teisenduse abil.

Embarkedil on kolm väärtust: S, C ja Q. Esitame need numbritega. Vaadake järgmist koodi:

Koristage

Kui te Data Wranglerit ei kasuta, on lisatasude vältimiseks oluline sulgeda eksemplar, millel see töötab.

Data Wrangler salvestab teie andmevoo automaatselt iga 60 sekundi järel. Töö kaotamise vältimiseks salvestage andmevoog enne Data Wrangleri väljalülitamist.

- Andmevoo salvestamiseks Studios valige fail, siis vali Salvesta andmete Wrangler Flow.

- Data Wrangleri eksemplari sulgemiseks Studios valige Eksemplaride ja tuumade käitamine.

- alla RAKENDUSTE TÖÖTAMINE, valige rakenduse sagemaker-data-wrangler-1.0 kõrval seiskamise ikoon.

- Vali Pange kõik kinni kinnitada.

Data Wrangler töötab ml.m5.4xsuurel eksemplaril. See juhtum kaob JOOKSUJUHTUMID kui sulgete rakenduse Data Wrangler.

Pärast Data Wrangleri rakenduse sulgemist peab see järgmisel korral Data Wrangleri voofaili avamisel taaskäivitama. Selleks võib kuluda mõni minut.

Järeldus

Selles postituses näitasime, kuidas saate Data Wrangleris kohandatud teisendusi kasutada. Sisseehitatud andmete teisendamise võimaluste laiendamiseks kasutasime Data Wrangleri konteineris olevaid teeke ja raamistikku. Selle postituse näited esindavad kasutatud raamistike alamhulka. Data Wrangleri voo teisendusi saab nüüd skaleerida DataOpsi konveieriks.

Lisateavet andmevoogude kasutamise kohta koos Data Wrangleriga leiate artiklist Looge ja kasutage Data Wrangleri voogu ja Amazon SageMakeri hinnakujundus. Data Wrangleriga alustamiseks vaadake Valmistage ette ML-andmed rakendusega Amazon SageMaker Data Wrangler. Autopiloodi ja AutoML-i kohta SageMakeris lisateabe saamiseks külastage Automatiseerige mudeliarendus Amazon SageMaker Autopilotiga.

Autoritest

Meenakshisundaram Thandavarayan on AWS-iga AI/ML vanemspetsialist. Ta aitab kõrgtehnoloogilisi strateegilisi kontosid nende AI ja ML teekonnal. Ta on väga kirglik andmepõhise AI vastu.

Meenakshisundaram Thandavarayan on AWS-iga AI/ML vanemspetsialist. Ta aitab kõrgtehnoloogilisi strateegilisi kontosid nende AI ja ML teekonnal. Ta on väga kirglik andmepõhise AI vastu.

Sovik Kumar Nath on AWS-iga AI/ML-lahenduste arhitekt. Tal on laialdased kogemused masinõppe terviklike disainide ja lahenduste alal; Ärianalüütika finants-, tegevus- ja turundusanalüütika raames; tervishoid; tarneahel; ja IoT. Tööväliselt naudib Sovik reisimist ja filmide vaatamist.

Sovik Kumar Nath on AWS-iga AI/ML-lahenduste arhitekt. Tal on laialdased kogemused masinõppe terviklike disainide ja lahenduste alal; Ärianalüütika finants-, tegevus- ja turundusanalüütika raames; tervishoid; tarneahel; ja IoT. Tööväliselt naudib Sovik reisimist ja filmide vaatamist.

Abigail on Amazon SageMakeri tarkvaraarenduse insener. Ta soovib kirglikult aidata klientidel DataWrangleris andmeid ette valmistada ja hajutatud masinõppesüsteeme luua. Vabal ajal naudib Abigail reisimist, matkamist, suusatamist ja küpsetamist.

Abigail on Amazon SageMakeri tarkvaraarenduse insener. Ta soovib kirglikult aidata klientidel DataWrangleris andmeid ette valmistada ja hajutatud masinõppesüsteeme luua. Vabal ajal naudib Abigail reisimist, matkamist, suusatamist ja küpsetamist.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- Platoblockchain. Web3 metaversiooni intelligentsus. Täiustatud teadmised. Juurdepääs siia.

- Tuleviku rahapaja Adryenn Ashley. Juurdepääs siia.

- Allikas: https://aws.amazon.com/blogs/machine-learning/authoring-custom-transformations-in-amazon-sagemaker-data-wrangler-using-nltk-and-scipy/

- :on

- :on

- $ UP

- 1

- 10

- 100

- 7

- 8

- 9

- a

- MEIST

- Kontod

- lisatud

- Täiendavad lisad

- aadress

- edasijõudnud

- pärast

- Ages

- AI

- AI teenused

- AI / ML

- Materjal: BPA ja flataatide vaba plastik

- võimaldab

- mööda

- Kuigi

- Amazon

- Amazoni mõistmine

- Amazon SageMaker

- Amazon SageMaker Data Wrangler

- analüüs

- analytics

- analüüsima

- ja

- Andrew

- Teine

- mistahes

- Apache

- app

- rakendused

- rakendatud

- Rakendades

- lähenemine

- arhitektuur

- OLEME

- AS

- At

- atribuudid

- Autentimine

- autor

- autor

- automaatselt

- AutoML

- saadaval

- AWS

- BE

- sest

- muutuma

- olnud

- enne

- kasu

- BIN

- pardale minek

- tooma

- ehitama

- Ehitus

- ehitatud

- sisseehitatud

- äri

- by

- CAN

- võimeid

- juhul

- juhtudel

- kindel

- kett

- muutma

- Vaidluste lahendamine

- Vali

- klassifikatsioon

- kood

- Kodeerimine

- kogumine

- Veerg

- Veerud

- ühendama

- kombineerimine

- ühine

- kogukond

- Ettevõtted

- täitma

- mõista

- terviklik

- arvutustehnika

- seisund

- Tingimused

- Kinnitama

- Miinused

- piiranguid

- sisaldama

- Konteiner

- sisu

- pidev

- võiks

- Paar

- looma

- tava

- Kliendid

- andmed

- andmete analüüs

- Andmete ettevalmistamine

- andmepõhistele

- andmekogumid

- vaikimisi

- Näidatud

- Disain

- disainilahendused

- Määrama

- arenev

- & Tarkvaraarendus

- arendab

- kõrvalekalle

- erinev

- avastus

- arutama

- jagatud

- jaotus

- dokument

- dokumendid

- Ei tee

- domeen

- alla

- kergesti

- lihtne-to-use

- tõhus

- kumbki

- elemendid

- Lõpuks-lõpuni

- insener

- Inseneriteadus

- rikastav

- üksuste

- üksus

- keskkond

- hindamine

- Iga

- näide

- näited

- Välja arvatud

- Teostama

- olemasolevate

- kogemus

- väljendusrikas

- laiendama

- ulatuslik

- Laialdased kogemused

- väljavõte

- KIIRE

- kiiremini

- tunnusjoon

- FUNKTSIOONID

- Tasud

- vähe

- fail

- Faile

- finants-

- paigaldamine

- voog

- Voolud

- Keskenduma

- keskendumine

- järgima

- Järel

- eest

- sõnastama

- Raamistik

- raamistikud

- tasuta

- Sagedus

- Alates

- lõbu

- funktsioon

- funktsioonid

- tekitama

- loodud

- generaatorid

- saama

- käepide

- Olema

- he

- tervishoid

- aidates

- aitab

- hi-tech

- kõrgetasemeline

- Avaleht

- Kuidas

- aga

- HTML

- http

- HTTPS

- inim-

- ICON

- identifitseerib

- identifitseerima

- Identity

- pilt

- import

- oluline

- importivate

- Paranemist

- in

- Teistes

- info

- teadmisi

- paigaldama

- Näiteks

- integreerima

- integratsioon

- Intelligentsus

- liidesed

- kehtestama

- asjade Interneti

- IT

- töö

- teekond

- jpg

- Võti

- teatud

- keel

- viimane

- juhtivate

- Õppida

- õppimine

- raamatukogud

- Raamatukogu

- nagu

- vähe

- kaotamine

- masin

- masinõpe

- säilitamine

- tegema

- palju

- Turundus

- suur

- matemaatiline

- mai..

- mainitud

- meetodid

- võib

- protokoll

- ML

- mudel

- mudelid

- moodulid

- Moodulid

- rohkem

- liikuma

- Filmid

- mitmekordne

- korrutades

- nimi

- nimed

- Natural

- Natural Language Processing

- Vajadus

- Uus

- järgmine

- nlp

- sõlme

- sõlmed

- märkmik

- number

- numbrid

- tuim

- eesmärk

- of

- pakkumine

- Vana

- on

- Pardal

- Pardal

- ONE

- avatud

- avatud lähtekoodiga

- töökorras

- optimaalselt

- optimeerimine

- optimeerima

- et

- originaal

- Muu

- muidu

- meie

- väljaspool

- üle

- enda

- pakend

- pakette

- pandas

- osa

- kirglik

- täitma

- fraasid

- torujuhe

- inimesele

- Platon

- Platoni andmete intelligentsus

- PlatoData

- pluss

- populaarne

- post

- tavad

- Valmistama

- trükk

- töötlemine

- Produktsioon

- profiilide

- Programmid

- anda

- annab

- eesmärk

- Lükkama

- Python

- kvaliteet

- Kiire

- juhuslik

- Töötlemata

- usaldusväärne

- jäänused

- esindama

- vastus

- Tulemused

- tagasipöördumine

- läbi

- juur

- jooks

- s

- salveitegija

- sama

- Näidisandmekogum

- Säästa

- stsenaariumid

- teaduslik

- skikit õppima

- skripte

- sekundit

- kindlalt

- valik

- vanem

- eri

- teenus

- Teenused

- seaded

- seade

- Jaga

- peaks

- näitama

- näidatud

- Näitused

- sulgema

- seiskamine

- kirjutama

- Signaali

- lihtne

- lihtsustama

- ühekordne

- tarkvara

- tarkvaraarenduse

- lahendus

- Lahendused

- mõned

- allikas

- Allikad

- Säde

- eriline

- spetsialist

- Spin

- jagada

- ruut

- standard

- algus

- alustatud

- stats

- Samm

- Sammud

- ladustamine

- ladustamine

- Strateegiline

- struktureerimine

- stuudio

- selline

- komplekt

- varustama

- tarneahelas

- Toetab

- süsteemid

- tabel

- Võtma

- võtmine

- Ülesanne

- Tehniline

- et

- .

- Allikas

- oma

- seetõttu

- Need

- kolm

- aeg

- et

- sümboolne

- Tokeniseerimine

- märgid

- töövahendid

- ülemine

- Summa

- Muutma

- Transformation

- muundumised

- ümber

- transformeerivate

- Reisimine

- Trend

- ui

- all

- kasutama

- kasutage juhtumit

- Kasutatud

- kommunaalteenused

- väärtus

- Väärtused

- eri

- visiit

- vaadates

- Tee..

- kuidas

- Hästi

- mis

- kuigi

- will

- koos

- jooksul

- ilma

- sõnad

- Töö

- Töövoogud

- kirjutama

- kirjalik

- sa

- Sinu

- sephyrnet