Täna on meil hea meel teatada, et Meta abil on võimalik Code Llama mudeleid peenhäälestada Amazon SageMaker JumpStart. Code Llama suurte keelemudelite (LLM) perekond on eelkoolitatud ja peenhäälestatud koodi genereerimise mudelite kogum, mille skaala ulatub 7 miljardist 70 miljardi parameetrini. Peenhäälestatud Code Llama mudelid pakuvad paremat täpsust ja seletatavust võrreldes Code Llama põhimudelitega, nagu ilmneb selle testimisel. HumanEval ja MBPP andmekogumid. Code Llama mudeleid saate SageMaker JumpStarti abil peenhäälestada ja juurutada Amazon SageMaker Studio Kasutajaliides mõne klõpsuga või SageMaker Python SDK abil. Llama mudelite peenhäälestus põhineb dokumendis esitatud skriptidel laama-retseptid GitHubi repo Metast, kasutades PyTorch FSDP, PEFT/LoRA ja Int8 kvantimistehnikaid.

Selles postituses käsitleme Code Llama eelkoolitatud mudelite viimistlemist SageMaker JumpStarti kaudu ühe klõpsuga kasutajaliidese ja SDK kogemuse kaudu, mis on saadaval järgmistes kohtades. GitHubi hoidla.

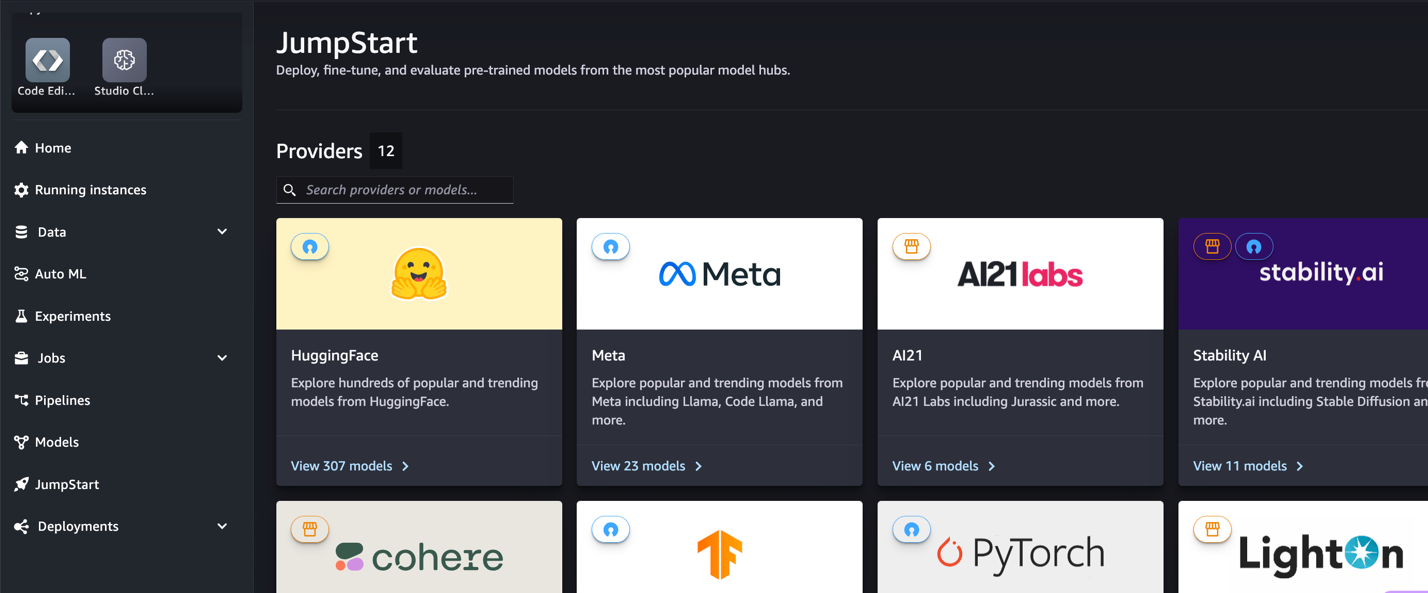

Mis on SageMaker JumpStart

SageMaker JumpStarti abil saavad masinõppe (ML) praktikud valida laia valiku avalikult saadaolevate alusmudelite hulgast. ML-praktikud saavad sihtotstarbeliselt kasutusele võtta sihtasutuse mudelid Amazon SageMaker eksemplare võrgust eraldatud keskkonnast ja kohandage mudeleid SageMakeri abil mudeli koolituseks ja juurutamiseks.

Mis on Code Lama

Code Llama on koodile spetsialiseerunud versioon Laama 2 mis loodi Llama 2 koodispetsiifiliste andmekogumite edasiõppimisel ja samast andmekogumist pikema aja jooksul rohkemate andmete valimisega. Code Llamal on täiustatud kodeerimisvõimalused. See võib genereerida koodi ja loomuliku keele koodi kohta nii koodi kui ka loomuliku keele viipadest (näiteks "Kirjutage mulle funktsioon, mis väljastab Fibonacci jada"). Saate seda kasutada ka koodi lõpetamiseks ja silumiseks. See toetab paljusid tänapäeval kasutatavaid populaarsemaid programmeerimiskeeli, sealhulgas Python, C++, Java, PHP, Typescript (JavaScript), C#, Bash ja palju muud.

Miks Code Llama mudeleid peenhäälestada

Meta avaldas Code Llama jõudlusnäitajad HumanEval ja MBPP levinud kodeerimiskeelte jaoks, nagu Python, Java ja JavaScript. Code Llama Pythoni mudelite jõudlus HumanEvalis näitas erinevat jõudlust erinevates kodeerimiskeeltes ja -ülesannetes vahemikus 38% Pythoni 7B mudelil kuni 57% 70B Pythoni mudelitel. Lisaks on SQL-i programmeerimiskeele peenhäälestatud Code Llama mudelid näidanud paremaid tulemusi, nagu ilmneb SQL-i hindamise võrdlusalustest. Need avaldatud võrdlusnäitajad toovad esile Code Llama mudelite peenhäälestuse võimalikud eelised, mis võimaldavad paremat jõudlust, kohandamist ja kohandamist konkreetsete kodeerimisvaldkondade ja ülesannetega.

Koodivaba peenhäälestus SageMaker Studio kasutajaliidese kaudu

Llama mudelite peenhäälestamise alustamiseks SageMaker Studio abil toimige järgmiselt.

- Valige SageMaker Studio konsoolil KiirStart navigeerimispaanil.

Leiate enam kui 350 mudeli loendid, alates avatud lähtekoodiga mudelitest kuni patenteeritud mudeliteni.

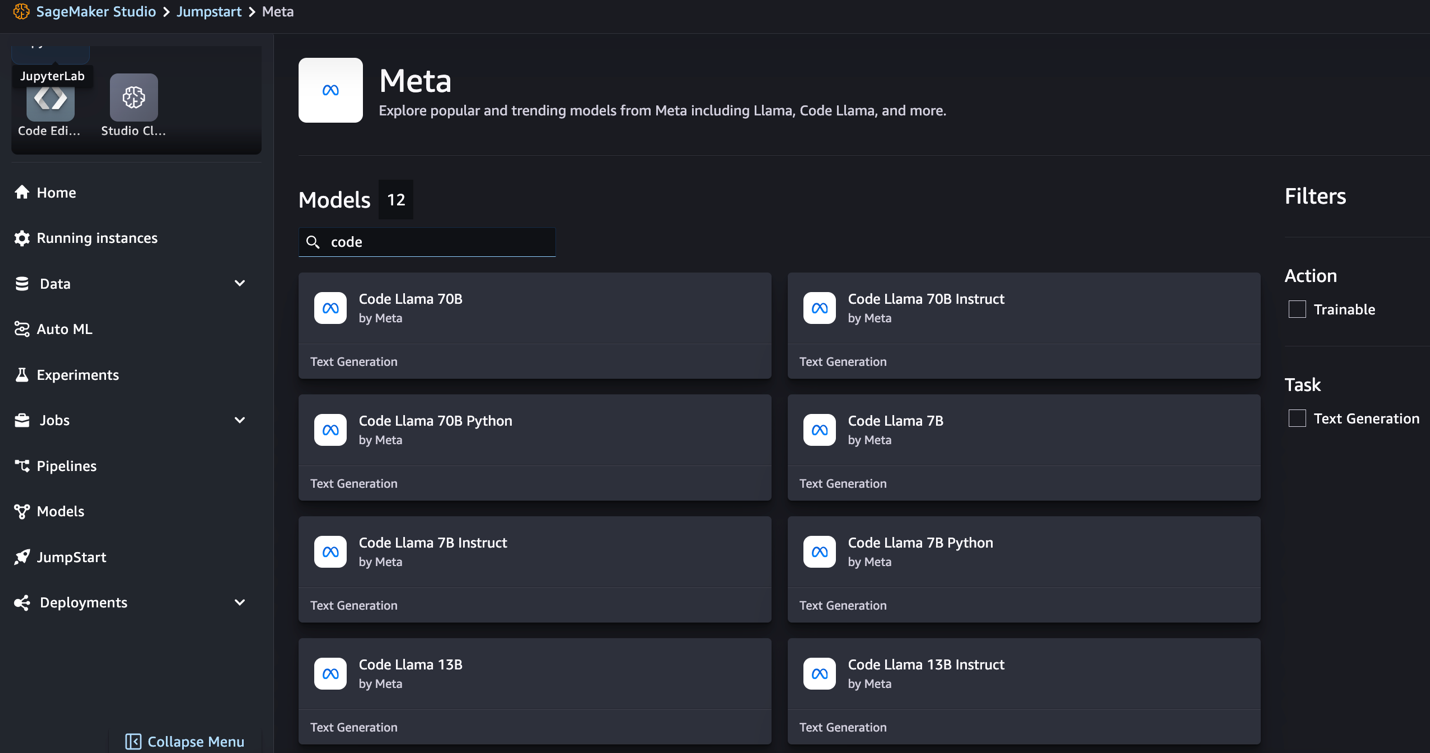

- Otsi Code Llama mudeleid.

Kui te Code Llama mudeleid ei näe, saate oma SageMaker Studio versiooni värskendada, sulgedes ja taaskäivitades. Versioonivärskenduste kohta lisateabe saamiseks vaadake Lülitage Studio rakendused välja ja värskendage neid. Valides leiate ka teisi mudelivariante Tutvuge kõigi koodi genereerimise mudelitega või otsides otsingukastist Code Lama.

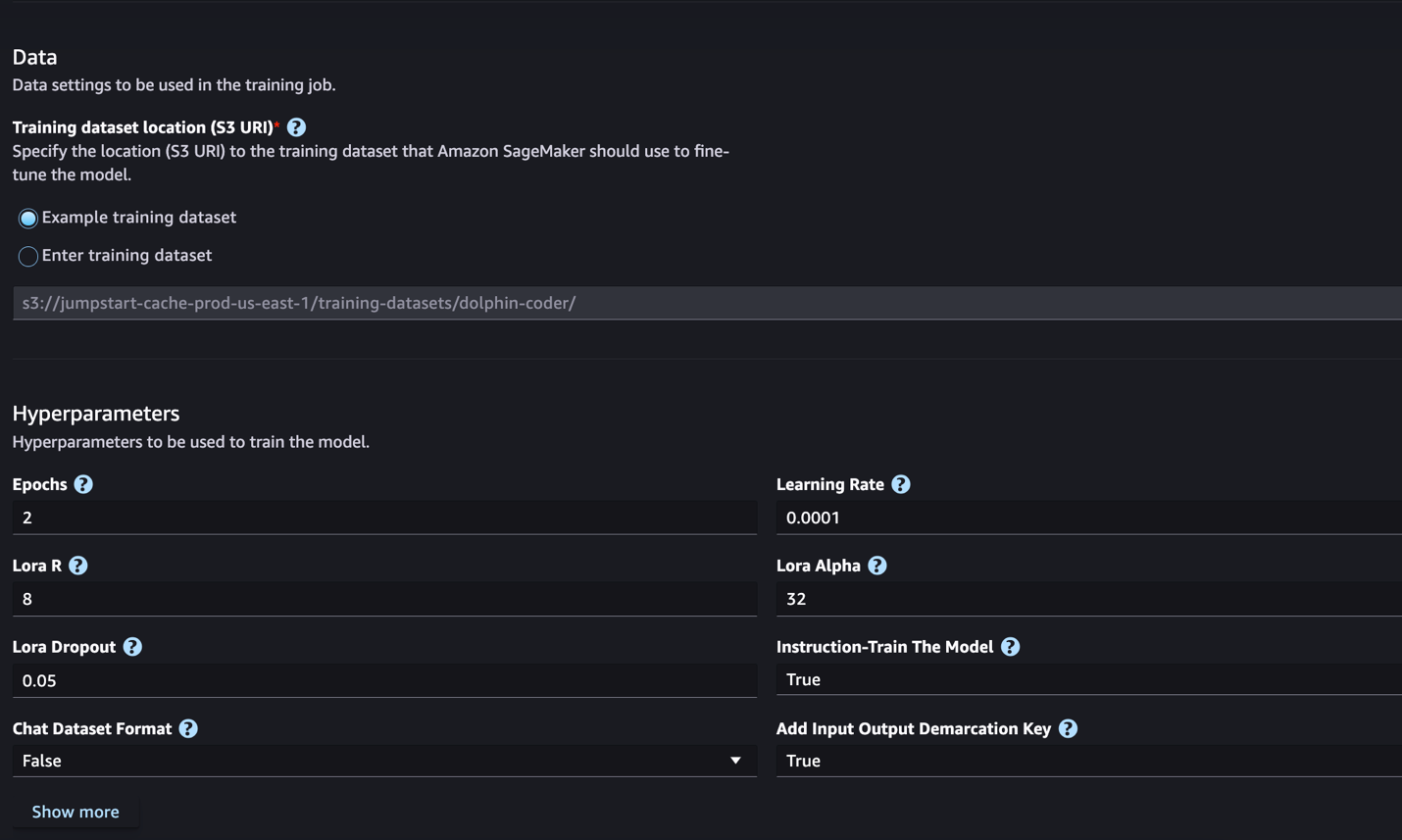

SageMaker JumpStart toetab praegu Code Llama mudelite juhiste peenhäälestamist. Järgmine ekraanipilt näitab Code Llama 2 70B mudeli peenhäälestuslehte.

- eest Koolituse andmestiku asukoht, võite osutada Amazoni lihtne salvestusteenus (Amazon S3) kopp, mis sisaldab peenhäälestamiseks mõeldud koolitus- ja valideerimisandmekogumeid.

- Määrake peenhäälestamiseks juurutamise konfiguratsioon, hüperparameetrid ja turbesätted.

- Vali Rong et alustada SageMaker ML eksemplari peenhäälestustööd.

Järgmises jaotises käsitleme andmekogumi vormingut, mida vajate juhiste peenhäälestamiseks.

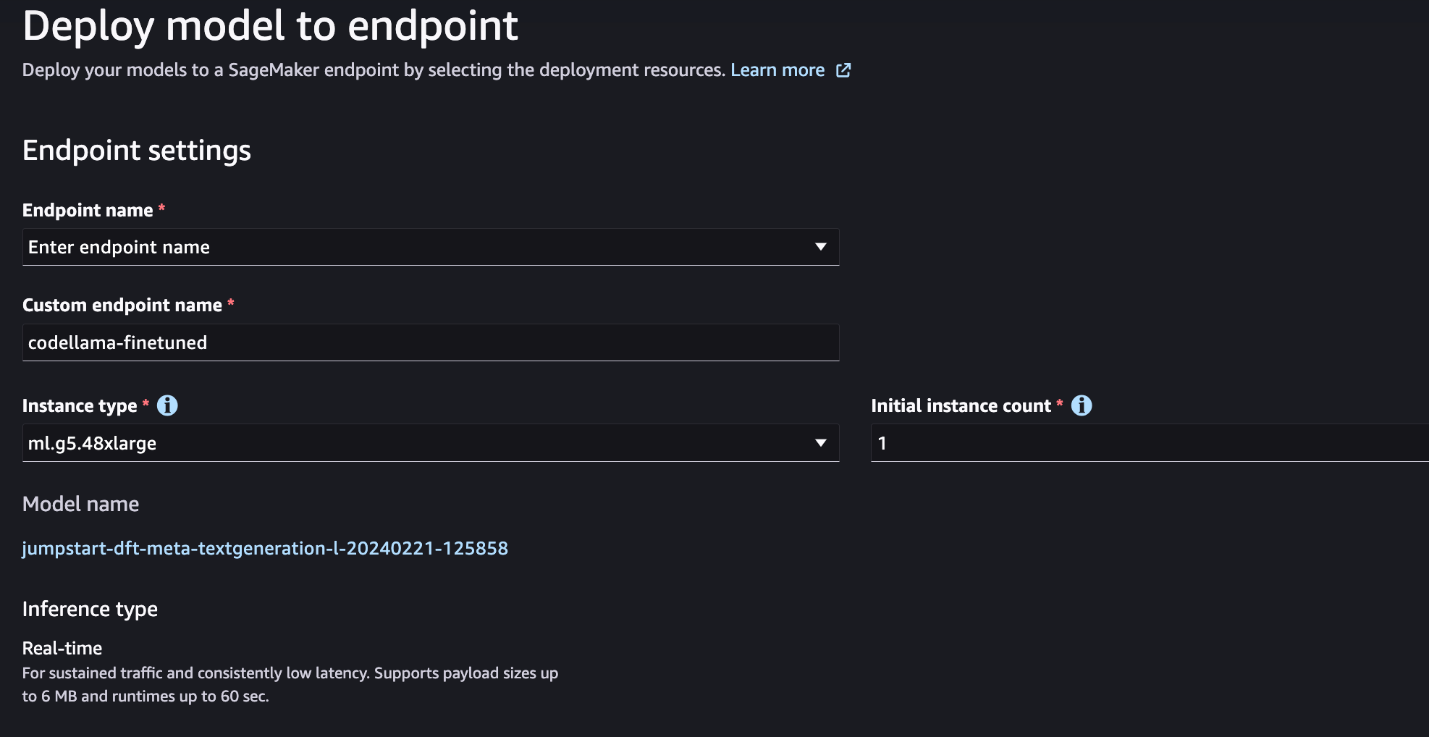

- Pärast mudeli peenhäälestamist saate selle juurutada, kasutades SageMakeri JumpStarti mudelilehte.

Peenhäälestatud mudeli juurutamise valik kuvatakse, kui peenhäälestus on lõppenud, nagu on näidatud järgmisel ekraanipildil.

Täpsustage SageMaker Python SDK kaudu

Selles jaotises näitame, kuidas viimistleda Code LIama mudeleid, kasutades SageMaker Python SDK-d käsuvormingus andmestikul. Täpsemalt, mudel on peenhäälestatud loomuliku keele töötlemise (NLP) ülesannete komplekti jaoks, mida kirjeldatakse juhiste abil. See aitab nullkaadri viipade abil parandada mudeli jõudlust nähtamatute ülesannete puhul.

Täppishäälestustöö lõpuleviimiseks täitke järgmised sammud. Kogu peenhäälestuskoodi saate aadressilt GitHubi hoidla.

Kõigepealt vaatame käsu peenhäälestamiseks vajalikku andmestiku vormingut. Treeningandmed tuleks vormindada JSON-ridade (.jsonl) vormingusse, kus iga rida on andmenäidist esindav sõnastik. Kõik treeninguandmed peavad olema ühes kaustas. Selle saab aga salvestada mitmesse jsonl-faili. Järgmine on JSON-ridade vormingu näidis:

Koolitusmapp võib sisaldada a template.json fail, mis kirjeldab sisend- ja väljundvorminguid. Järgmine on näidismall:

Malliga sobitamiseks peab iga JSON-ridade faili näidis sisaldama system_prompt, questionja response väljad. Selles esitluses kasutame Dolphin Coderi andmestik alates Hugging Face.

Pärast andmestiku ettevalmistamist ja selle S3 ämbrisse laadimist saate alustada peenhäälestamist järgmise koodi abil.

Täppishäälestatud mudeli saate juurutada otse hindajast, nagu on näidatud järgmises koodis. Üksikasjalikumat teavet leiate sülearvutist GitHubi hoidla.

Peenhäälestustehnikad

Keelemudelid, nagu Llama, on suuremad kui 10 GB või isegi 100 GB. Selliste suurte mudelite peenhäälestamiseks on vaja märkimisväärselt suure CUDA-mäluga eksemplare. Lisaks võib nende mudelite treenimine mudeli suuruse tõttu olla väga aeglane. Seetõttu kasutame tõhusaks peenhäälestamiseks järgmisi optimeerimisi:

- Madala asetusega kohandamine (LoRA) – See on teatud tüüpi parameetrite tõhus peenhäälestus (PEFT) suurte mudelite tõhusaks peenhäälestamiseks. Selle meetodi abil külmutate kogu mudeli ja lisate mudelisse vaid väikese komplekti reguleeritavaid parameetreid või kihte. Näiteks selle asemel, et treenida kõiki 7 miljardit parameetrit Llama 2 7B jaoks, saate peenhäälestada vähem kui 1% parameetritest. See aitab oluliselt vähendada mäluvajadust, kuna peate salvestama ainult 1% parameetrite gradiente, optimeerija olekuid ja muud treeninguga seotud teavet. Lisaks aitab see vähendada koolituse aega ja kulusid. Selle meetodi kohta lisateabe saamiseks vaadake LoRA: suurte keelemudelite madalatasemeline kohandamine.

- Int8 kvantimine – Isegi selliste optimeeringutega nagu LoRA on mudelid nagu Llama 70B ikka veel treenimiseks liiga suured. Treeningu ajal mälujalajälje vähendamiseks saate treeningu ajal kasutada Int8 kvantiseerimist. Kvantimine vähendab tavaliselt ujukoma andmetüüpide täpsust. Kuigi see vähendab mudeli kaalude salvestamiseks vajalikku mälu, halvendab see teabe kadumise tõttu jõudlust. Int8 kvantimine kasutab ainult veerandi täpsust, kuid ei põhjusta jõudluse halvenemist, kuna see ei kaota lihtsalt bitte. See ümardab andmed ühelt tüübilt teisele. Int8 kvantimise kohta lisateabe saamiseks vaadake LLM.int8(): 8-bitine maatrikskorrutis mastaabis transformerite jaoks.

- Täielikult jagatud andmete paralleelne (FSDP) – See on teatud tüüpi andmeparalleelne treeningalgoritm, mis killustab mudeli parameetrid andmetega paralleelsete töötajate vahel ja võib valikuliselt osa treeninguarvutustest protsessoritele maha laadida. Kuigi parameetrid on jagatud erinevate GPU-de vahel, on iga mikropartii arvutamine GPU töötaja jaoks kohalik. See killustab parameetreid ühtlasemalt ja saavutab optimeeritud jõudluse suhtluse ja arvutuste kattumise kaudu treeningu ajal.

Järgmine tabel võtab kokku iga mudeli üksikasjad erinevate seadistustega.

| MUDEL | Vaikeseade | LORA + FSDP | LORA + FSDP puudub | Int8 kvantimine + LORA + FSDP puudub |

| Kood Laama 2 7B | LORA + FSDP | Jah | Jah | Jah |

| Kood Laama 2 13B | LORA + FSDP | Jah | Jah | Jah |

| Kood Laama 2 34B | INT8 + LORA + NO FSDP | Ei | Ei | Jah |

| Kood Laama 2 70B | INT8 + LORA + NO FSDP | Ei | Ei | Jah |

Llama mudelite peenhäälestus põhineb alljärgnevatel skriptidel GitHub repo.

Toetatud hüperparameetrid treenimiseks

Code Llama 2 peenhäälestus toetab mitmeid hüperparameetreid, millest igaüks võib mõjutada peenhäälestatud mudeli mälunõuet, treeningkiirust ja jõudlust:

- epohh – Läbimiste arv, mille peenhäälestusalgoritm läbib treeningu andmestiku. Peab olema täisarv, mis on suurem kui 1. Vaikimisi on 5.

- õppimise_määr – Mudeli kaalude värskendamise kiirus pärast iga treeningnäidete partii läbitöötamist. Peab olema positiivne ujuk, mis on suurem kui 0. Vaikimisi on 1e-4.

- instruction_tuned – Kas modelli juhendada-koolitada või mitte. Peab olema

TrueorFalse. Vaikimisi onFalse. - per_device_train_batch_size – Partii suurus GPU tuuma/protsessori kohta koolituse jaoks. Peab olema positiivne täisarv. Vaikimisi on 4.

- per_device_eval_batch_size – Hindamiseks mõeldud partii suurus GPU tuuma/protsessori kohta. Peab olema positiivne täisarv. Vaikimisi on 1.

- max_train_samples – Silumiseks või kiiremaks treenimiseks kärpige treeningnäidete arv selle väärtuseni. Väärtus -1 tähendab kõigi treeningnäidiste kasutamist. Peab olema positiivne täisarv või -1. Vaikimisi on -1.

- max_val_samples – Silumiseks või kiiremaks väljaõppeks kärpige valideerimisnäidete arv selle väärtuseni. Väärtus -1 tähendab kõigi valideerimisnäidiste kasutamist. Peab olema positiivne täisarv või -1. Vaikimisi on -1.

- max_sisendi_pikkus – Sisendjada maksimaalne kogupikkus pärast märgistamist. Sellest pikemad jadad kärbitakse. Kui -1,

max_input_lengthon seatud minimaalseks 1024 ja maksimaalseks mudeli pikkuseks, mille määrab tokenisaator. Kui see on seatud positiivsele väärtusele,max_input_lengthon seatud antud väärtuse miinimumile jamodel_max_lengthmääratletud tokenisaatori poolt. Peab olema positiivne täisarv või -1. Vaikimisi on -1. - validation_split_ratio – Kui valideerimiskanal on

none, peab rongi andmetest eraldatud rongi valideerimise suhe olema vahemikus 0–1. Vaikimisi on 0.2. - train_data_split_seed – Kui valideerimisandmed puuduvad, fikseerib see sisendtreeningu andmete juhusliku jagamise algoritmi kasutatavateks treening- ja valideerimisandmeteks. Peab olema täisarv. Vaikimisi on 0.

- eeltöötlus_töötajate_arv – eeltöötluseks kasutatavate protsesside arv. Kui

None, põhiprotsessi kasutatakse eeltöötluseks. Vaikimisi onNone. - lora_r – Lora R. Peab olema positiivne täisarv. Vaikimisi on 8.

- lora_alpha - Lora Alfa. Peab olema positiivne täisarv. Vaikimisi on 32

- lora_dropout – Lora Dropout. peab olema positiivne ujuk vahemikus 0 kuni 1. Vaikimisi on 0.05.

- int8_kvantimine - Kui

True, mudel on treenimiseks laaditud 8-bitise täpsusega. Vaikimisi 7B ja 13B jaoks onFalse. Vaikimisi on 70BTrue. - enable_fsdp – Kui see on tõsi, kasutab koolitus FSDP-d. 7B ja 13B vaikeväärtus on Tõene. 70B vaikeväärtus on False. Pange tähele, et

int8_quantizationFSDP ei toeta.

Hüperparameetrite valimisel võtke arvesse järgmist:

- Kehtestamine

int8_quantization=Truevähendab mäluvajadust ja viib kiirema treeninguni. - Vähenemine

per_device_train_batch_sizejamax_input_lengthvähendab mälunõuet ja seetõttu saab seda kasutada väiksematel eksemplaridel. Väga madalate väärtuste seadmine võib aga treeninguaega pikendada. - Kui te ei kasuta Int8 kvantiseerimist (

int8_quantization=False), kasutage FSDP-d (enable_fsdp=True) kiiremaks ja tõhusamaks treenimiseks.

Koolituse toetatud eksemplaritüübid

Järgmine tabel võtab kokku erinevate mudelite koolitamiseks toetatud eksemplaritüübid.

| MUDEL | Vaikimisi eksemplari tüüp | Toetatud eksemplaritüübid |

| Kood Laama 2 7B | ml.g5.12xsuur |

ml.g5.12xlarge, ml.g5.24xlarge, ml.g5.48xlarge, ml.p3dn.24xlarge, ml.g4dn.12xsuur |

| Kood Laama 2 13B | ml.g5.12xsuur |

ml.g5.24xlarge, ml.g5.48xlarge, ml.p3dn.24xlarge, ml.g4dn.12xsuur |

| Kood Laama 2 70B | ml.g5.48xsuur |

ml.g5.48xsuur ml.p4d.24xlarge |

Eksemplari tüübi valimisel võtke arvesse järgmist.

- G5 eksemplarid pakuvad toetatud eksemplaritüüpide seas kõige tõhusamat koolitust. Seega, kui teil on saadaval G5 eksemplare, peaksite neid kasutama.

- Treeningu aeg sõltub suuresti GPU-de arvust ja saadaolevast CUDA mälust. Seetõttu on sama arvu GPU-dega eksemplaride (nt ml.g5.2xlarge ja ml.g5.4xlarge) koolitus ligikaudu sama. Seetõttu saate treenimiseks kasutada odavamat eksemplari (ml.g5.2xlarge).

- P3 eksemplaride kasutamisel toimub koolitus 32-bitise täpsusega, kuna bfloat16 nendel juhtudel ei toetata. Seetõttu kulutab treeningtöö p3 eksemplaridel treenides võrreldes g5 eksemplaridega kaks korda rohkem CUDA mälu.

Koolituse maksumuse kohta eksemplari kohta lisateabe saamiseks vaadake Amazon EC2 G5 eksemplarid.

Hindamine

Hindamine on oluline samm peenhäälestatud mudelite toimivuse hindamisel. Esitame nii kvalitatiivseid kui ka kvantitatiivseid hinnanguid, et näidata peenhäälestatud mudelite paranemist võrreldes mitte-peenhäälestatud mudelitega. Kvalitatiivses hindamises näitame nii peenhäälestatud kui ka peenhäälestamata mudelite vastust. Kvantitatiivsel hindamisel kasutame HumanEval, OpenAI välja töötatud testikomplekt Pythoni koodi genereerimiseks, et testida õigete ja täpsete tulemuste andmise võimet. HumanEvali hoidla on MIT-i litsentsi all. Täpsustasime kõigi Code LIama mudelite Pythoni variante eri suurustes (kood LIama Python 7B, 13B, 34B ja 70B seadmel Dolphin Coderi andmestik) ja esitage hindamistulemused järgmistes osades.

Kvalitatiivne hindamine

Kui teie peenhäälestatud mudel on juurutatud, saate hakata koodi genereerimiseks kasutama lõpp-punkti. Järgmises näites esitame vastused nii põhi- kui ka peenhäälestatud Code LIama 34B Pythoni variantidest testnäidises Dolphin Coderi andmestik:

Täppishäälestatud Code Llama mudel genereerib lisaks eelneva päringu koodi andmisele lähenemise üksikasjaliku selgituse ja pseudokoodi.

Code Llama 34b Pythoni peenhäälestuseta vastus:

Code Llama 34B Pythoni peenhäälestatud vastus

Põhjendatud tõde

Huvitaval kombel pakub meie Code Llama 34B Pythoni peenhäälestatud versioon dünaamilise programmeerimisel põhinevat lahendust pikima palindroomse alamstringi jaoks, mis erineb valitud testnäite põhitões pakutavast lahendusest. Meie peenhäälestatud mudel põhjendab ja selgitab üksikasjalikult dünaamilist programmeerimispõhist lahendust. Teisest küljest hallutsineerib peenhäälestuseta mudel potentsiaalseid väljundeid kohe pärast print avaldus (näidatud vasakpoolses lahtris), kuna väljund axyzzyx ei ole antud stringi pikim palindroom. Ajalise keerukuse poolest on dünaamiline programmeerimislahendus üldiselt parem kui esialgne lähenemine. Dünaamilise programmeerimislahenduse ajaline keerukus on O(n^2), kus n on sisendstringi pikkus. See on tõhusam kui peenhäälestuseta mudeli esialgne lahendus, millel oli ka ruutajaline keerukus O (n ^ 2), kuid vähem optimeeritud lähenemisviisiga.

See tundub paljulubav! Pidage meeles, et koodi LIama Pythoni varianti peenhäälestasime ainult 10% -ga Dolphin Coderi andmestik. Uurida on veel palju!

Vaatamata põhjalikele juhistele vastuses, peame siiski uurima lahenduses esitatud Pythoni koodi õigsust. Järgmisena kasutame hindamisraamistikku nimega Inimene Eval käivitada Code LIama loodud vastuse integratsioonitestid, et süstemaatiliselt kontrollida selle kvaliteeti.

Kvantitatiivne hindamine HumanEvaliga

HumanEval on hindamisriist LLM-i probleemide lahendamise võimete hindamiseks Pythoni-põhiste kodeerimisprobleemide puhul, nagu on kirjeldatud artiklis Koodi järgi koolitatud suurte keelemudelite hindamine. Täpsemalt koosneb see 164 algsest Pythoni-põhisest programmeerimisprobleemist, mis hindavad keelemudeli võimet genereerida koodi esitatud teabe, näiteks funktsiooni allkirja, dokumendistringi, keha- ja ühikutestide põhjal.

Iga Pythoni-põhise programmeerimisküsimuse jaoks saadame selle Code LIama mudelile, mis on juurutatud SageMakeri lõpp-punktis, et saada k vastust. Järgmisena käivitame HumanEvali hoidlas integratsioonitestides kõik k vastusest. Kui mõni vastus k vastusest läbib integratsioonitestid, loeme, et testjuhtum õnnestus; muidu ebaõnnestus. Seejärel kordame protsessi, et arvutada edukate juhtumite suhe lõpliku hindamisskoorina pass@k. Tavapraktikat järgides määrasime oma hindamisel k väärtuseks 1, et genereerida ainult üks vastus küsimuse kohta ja testida, kas see läbib integratsioonitesti.

Järgmine on HumanEvali hoidla kasutamise näidiskood. Saate juurdepääsu andmestikule ja luua ühe vastuse, kasutades SageMakeri lõpp-punkti. Üksikasjalikumat teavet leiate sülearvutist GitHubi hoidla.

Järgmises tabelis on näidatud peenhäälestatud Code LIama Pythoni mudelite täiustused võrreldes peenhäälestamata mudelitega erinevates mudelisuurustes. Korrektsuse tagamiseks juurutame SageMakeri lõpp-punktides ka viimistlemata Code LIama mudelid ja läbime Human Evali hinnangud. The pass@1 numbrid (järgmise tabeli esimene rida) vastavad esitatud numbritele Code Lama uurimistöö. Järeldusparameetrid on järjepidevalt seatud kui "parameters": {"max_new_tokens": 384, "temperature": 0.2}.

Nagu tulemustest näeme, näitavad kõik peenhäälestatud Code LIama Pythoni variandid märkimisväärselt paranemist võrreldes peenhäälestamata mudelitega. Eelkõige ületab Code LIama Python 70B peenhäälestamata mudelit ligikaudu 12%.

| . | 7B Python | 13B Python | 34B | 34B Python | 70B Python |

| Eelkoolitatud mudeli jõudlus (pass@1) | 38.4 | 43.3 | 48.8 | 53.7 | 57.3 |

| Peenhäälestatud mudeli jõudlus (pass@1) | 45.12 | 45.12 | 59.1 | 61.5 | 69.5 |

Nüüd saate proovida Code LIama mudeleid oma andmekogumis peenhäälestada.

Koristage

Kui otsustate, et te ei soovi enam SageMakeri lõpp-punkti töös hoida, saate selle kustutada AWS SDK Pythoni jaoks (Boto3), AWS-i käsurea liides (AWS CLI) või SageMakeri konsool. Lisateabe saamiseks vt Kustutage lõpp-punktid ja ressursid. Lisaks saate sulgege SageMaker Studio ressursid mida enam ei nõuta.

Järeldus

Selles postituses arutasime Meta Code Llama 2 mudelite peenhäälestamist, kasutades SageMaker JumpStart. Näitasime, et saate nende mudelite viimistlemiseks ja juurutamiseks kasutada SageMakeri JumpStart-konsooli SageMaker Studios või SageMaker Python SDK-d. Arutasime ka peenhäälestustehnikat, eksemplaritüüpe ja toetatud hüperparameetreid. Lisaks andsime välja soovitused optimeeritud koolituseks, mis põhinevad erinevatel meie poolt läbi viidud testidel. Nagu näeme nendest kolme mudeli kahe andmekogumi peenhäälestuse tulemustest, parandab peenhäälestus kokkuvõtet võrreldes peenhäälestamata mudelitega. Järgmise sammuna võite proovida neid mudeleid oma andmekogus peenhäälestada, kasutades GitHubi hoidlas oleva koodi, et testida ja võrrelda tulemusi oma kasutusjuhtumite jaoks.

Autoritest

Dr Xin Huang on Amazon SageMaker JumpStart ja Amazon SageMaker sisseehitatud algoritmide vanemrakendusteadlane. Ta keskendub skaleeritavate masinõppe algoritmide arendamisele. Tema uurimishuvid on seotud loomuliku keele töötlemise, tabeliandmete seletatava süvaõppe ja mitteparameetrilise aegruumi klastrite tugeva analüüsiga. Ta on avaldanud palju artikleid ACL-is, ICDM-is, KDD konverentsidel ja Kuninglikus Statistikaühingus: A-seeria.

Dr Xin Huang on Amazon SageMaker JumpStart ja Amazon SageMaker sisseehitatud algoritmide vanemrakendusteadlane. Ta keskendub skaleeritavate masinõppe algoritmide arendamisele. Tema uurimishuvid on seotud loomuliku keele töötlemise, tabeliandmete seletatava süvaõppe ja mitteparameetrilise aegruumi klastrite tugeva analüüsiga. Ta on avaldanud palju artikleid ACL-is, ICDM-is, KDD konverentsidel ja Kuninglikus Statistikaühingus: A-seeria.

Vishaal Yalamanchali on Startup Solutions Architect, kes töötab varajases staadiumis generatiivse AI, robootika ja autonoomsete sõidukite ettevõtetega. Vishaal töötab koos oma klientidega tipptasemel ML-lahenduste pakkumisel ning on isiklikult huvitatud arendusõppest, LLM-i hindamisest ja koodide genereerimisest. Enne AWS-i oli Vishaal UCI bakalaureuseõppes, keskendudes bioinformaatikale ja intelligentsetele süsteemidele.

Vishaal Yalamanchali on Startup Solutions Architect, kes töötab varajases staadiumis generatiivse AI, robootika ja autonoomsete sõidukite ettevõtetega. Vishaal töötab koos oma klientidega tipptasemel ML-lahenduste pakkumisel ning on isiklikult huvitatud arendusõppest, LLM-i hindamisest ja koodide genereerimisest. Enne AWS-i oli Vishaal UCI bakalaureuseõppes, keskendudes bioinformaatikale ja intelligentsetele süsteemidele.

Meenakshisundaram Thandavarayan töötab AWS-is AI/ML spetsialistina. Tal on kirg kujundada, luua ja edendada inimkeskseid andme- ja analüüsikogemusi. Meena keskendub jätkusuutlike süsteemide arendamisele, mis pakuvad AWS-i strateegilistele klientidele mõõdetavaid konkurentsieeliseid. Meena on ühendaja ja disainimõtleja ning püüab innovatsiooni, inkubatsiooni ja demokratiseerimise kaudu juhtida ettevõtteid uutele tööviisidele.

Meenakshisundaram Thandavarayan töötab AWS-is AI/ML spetsialistina. Tal on kirg kujundada, luua ja edendada inimkeskseid andme- ja analüüsikogemusi. Meena keskendub jätkusuutlike süsteemide arendamisele, mis pakuvad AWS-i strateegilistele klientidele mõõdetavaid konkurentsieeliseid. Meena on ühendaja ja disainimõtleja ning püüab innovatsiooni, inkubatsiooni ja demokratiseerimise kaudu juhtida ettevõtteid uutele tööviisidele.

Dr Ashish Khetan on vanemrakendusteadlane, kellel on Amazon SageMaker sisseehitatud algoritmid ja aitab välja töötada masinõppe algoritme. Ta sai doktorikraadi Illinoisi Urbana-Champaigni ülikoolist. Ta on aktiivne masinõppe ja statistiliste järelduste uurija ning avaldanud palju artikleid NeurIPS, ICML, ICLR, JMLR, ACL ja EMNLP konverentsidel.

Dr Ashish Khetan on vanemrakendusteadlane, kellel on Amazon SageMaker sisseehitatud algoritmid ja aitab välja töötada masinõppe algoritme. Ta sai doktorikraadi Illinoisi Urbana-Champaigni ülikoolist. Ta on aktiivne masinõppe ja statistiliste järelduste uurija ning avaldanud palju artikleid NeurIPS, ICML, ICLR, JMLR, ACL ja EMNLP konverentsidel.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- PlatoTervis. Biotehnoloogia ja kliiniliste uuringute luureandmed. Juurdepääs siia.

- Allikas: https://aws.amazon.com/blogs/machine-learning/fine-tune-code-llama-on-amazon-sagemaker-jumpstart/

- :on

- :on

- :mitte

- : kus

- 1

- 10

- 100

- 12

- 13

- 14

- 16

- 20

- 27

- 2D

- 350

- 7

- 70

- 8

- a

- võimeid

- võime

- MEIST

- aktsepteerima

- juurdepääs

- täpsus

- täpne

- Saavutab

- üle

- aktiivne

- kohandamine

- lisama

- lisamine

- Lisaks

- reguleeritav

- eelised

- pärast

- vastu

- AI

- algoritm

- algoritme

- Materjal: BPA ja flataatide vaba plastik

- Alfa

- juba

- Ka

- Kuigi

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- vahel

- summa

- an

- analüüs

- analytics

- ja

- Teatama

- Teine

- vastus

- mistahes

- ilmuma

- rakendatud

- lähenemine

- umbes

- OLEME

- PIIRKOND

- AS

- hinnata

- At

- autonoomne

- saadaval

- AWS

- B.A.B.

- baas

- põhineb

- sisse lööma

- BE

- sest

- muutub

- taga

- võrrelda

- kriteeriumid

- Kasu

- Parem

- vahel

- Suur

- Miljard

- bits

- keha

- mõlemad

- Mõlemad pooled

- Kast

- Murdma

- lai

- sisseehitatud

- ettevõtted

- kuid

- by

- C + +

- arvutama

- kutsutud

- CAN

- Saab

- võimeid

- võime

- kaasas

- juhul

- juhtudel

- rakk

- muutma

- muutuv

- Kanal

- iseloom

- märki

- vestlus

- odavam

- kontrollima

- kontroll

- Kontroll

- Vali

- valimine

- cli

- Klastrite loomine

- coaching

- kood

- kooder

- Kodeerimine

- kogumine

- ühine

- KOMMUNIKATSIOON

- Ettevõtted

- võrreldes

- konkurentsivõimeline

- täitma

- lõpetamist

- keerukus

- arvutamine

- konverentsid

- konfiguratsioon

- järjestikune

- Arvestama

- järjepidevalt

- Koosneb

- koosneb

- konsool

- tarbima

- sisaldama

- parandada

- Maksma

- loe

- looma

- loodud

- Praegune

- Praegu

- Kliendid

- kohandamine

- kohandada

- viimase peal

- andmed

- andmekogumid

- otsustama

- vähenema

- väheneb

- pühendunud

- sügav

- sügav õpe

- vaikimisi

- määratletud

- tarnima

- demokratiseerimine

- näitama

- Näidatud

- demonstratsioon

- sõltub

- juurutada

- lähetatud

- kasutuselevõtu

- Tuletatud

- kirjeldatud

- Kirjeldades

- Disain

- detail

- üksikasjalik

- detailid

- arendama

- arenenud

- arenev

- erinev

- numbrit

- mõõdud

- otse

- arutama

- arutatud

- Ei tee

- Domeenid

- tehtud

- Ära

- kahekordistada

- alla

- ajam

- Drop

- kaks

- ajal

- dünaamiline

- iga

- varajases staadiumis

- efektiivsus

- tõhus

- kumbki

- võimaldades

- lõpp

- lõpetamine

- Lõpp-punkt

- Inglise

- tõhustatud

- tagama

- Kogu

- keskkond

- võrdne

- hindamine

- hindamine

- hindamised

- Isegi

- ilmne

- uurima

- näide

- näited

- erutatud

- Laiendama

- kogemus

- Kogemused

- Selgitama

- Selgitab

- selgitus

- nägu

- Ebaõnnestunud

- vale

- pere

- kiiremini

- FB

- FUNKTSIOONID

- vähe

- Fibonacci

- Valdkonnad

- fail

- Faile

- täitma

- lõplik

- Lõpuks

- leidma

- esimene

- parandused

- Float

- ujuv

- Keskenduma

- keskendunud

- keskendub

- Järel

- Jalajälg

- eest

- formaat

- Sihtasutus

- Raamistik

- Külmutama

- Alates

- funktsioon

- edasi

- Pealegi

- üldiselt

- tekitama

- loodud

- genereerib

- põlvkond

- generatiivne

- Generatiivne AI

- saama

- GitHub

- antud

- annab

- sain

- GPU

- GPU

- kalded

- suurem

- Maa

- olnud

- käsi

- rakmed

- Olema

- he

- aitab

- Suur

- Esile tõstma

- tema

- Kuidas

- Kuidas

- aga

- HTML

- http

- HTTPS

- inim-

- i

- identiques

- if

- Illinois

- mõju

- import

- oluline

- parandama

- paranemine

- parandusi

- parandab

- in

- sisaldama

- Kaasa arvatud

- Suurendama

- juurdekasv

- INKUBATSIOONI

- indeks

- Indeksid

- info

- esialgne

- Innovatsioon

- sisend

- paigaldama

- Näiteks

- selle asemel

- juhised

- integratsioon

- Intelligentne

- huvitatud

- el

- sisse

- isoleeritud

- IT

- korduv

- iteratsioon

- ITS

- Java

- JavaScript

- töö

- jpeg

- jpg

- Json

- hoidma

- hoiab

- keel

- Keeled

- suur

- suurelt jaolt

- viimane

- kihid

- Leads

- Õppida

- õppimine

- lahkus

- Pikkus

- vähem

- litsents

- nagu

- joon

- liinid

- Näita

- Laama

- LLM

- kohalik

- enam

- Vaata

- otsin

- välimus

- kaotus

- Partii

- Madal

- masin

- masinõpe

- põhiline

- jääb

- tegema

- palju

- Vastama

- sobitatud

- tikud

- maatriks

- maksimaalne

- mai..

- me

- vahendid

- Mälu

- Meta

- meetod

- miinimum

- MIT

- ML

- mudel

- mudelid

- rohkem

- tõhusam

- kõige

- Populaarseim

- mitmekordne

- peab

- Nimega

- Natural

- Natural Language Processing

- NAVIGATSIOON

- Vajadus

- võrk

- mitte kunagi

- Uus

- järgmine

- nlp

- ei

- meeles

- märkmik

- number

- numbrid

- of

- on

- ONE

- ones

- ainult

- avatud

- avatud lähtekoodiga

- OpenAI

- optimeerimine

- optimeeritud

- valik

- or

- et

- originaal

- Muu

- muidu

- meie

- välja

- välja toodud

- Ületab tulemusi

- väljund

- väljundid

- üle

- enda

- lehekülg

- pane

- Paber

- dokumendid

- Parallel

- parameeter

- parameetrid

- osa

- eriline

- möödub

- kirg

- kohta

- jõudlus

- Isiklikult

- phd

- PHP

- Platon

- Platoni andmete intelligentsus

- PlatoData

- palun

- Punkt

- populaarne

- positiivne

- post

- potentsiaal

- tava

- eelnev

- Täpsus

- Valmistama

- esitada

- Eelnev

- Probleem

- probleemi lahendamine

- probleeme

- protsess

- Protsessid

- töötlemine

- tootmine

- Programming

- programmeerimiskeeled

- edendama

- küsib

- varaline

- anda

- tingimusel

- annab

- pakkudes

- avalikult

- avaldatud

- eesmärkidel

- Python

- pütorch

- kvadraatiline

- kvalitatiivne

- kvaliteet

- kvantitatiivne

- Kvartal

- päringu

- küsimus

- kiiremini

- R

- juhuslik

- alates

- määr

- suhe

- jõudis

- Jõuab

- põhjustel

- soovitused

- vähendab

- vähendamine

- viitama

- ülejäänud

- meeles pidama

- kordama

- Teatatud

- Hoidla

- esindavad

- nõutav

- nõue

- Vajab

- teadustöö

- uurija

- vastus

- vastuste

- kaasa

- Tulemused

- tagasipöördumine

- Tulu

- õige

- robootika

- jõuline

- ligikaudu

- voorud

- ROW

- kuninglik

- jooks

- jooksmine

- s

- salveitegija

- sama

- proov

- salvestatud

- skaalautuvia

- Skaala

- teadlane

- skoor

- skripte

- SDK

- Otsing

- otsimine

- Osa

- lõigud

- turvalisus

- vaata

- väljavalitud

- valik

- saatma

- vanem

- Jada

- Seeria

- Seeria A

- Teenused

- komplekt

- Komplektid

- kehtestamine

- seaded

- kildudeks

- peaks

- näitama

- näitas

- näidatud

- Näitused

- seiskamist

- Küljed

- allkiri

- märkimisväärne

- märgatavalt

- lihtne

- lihtsalt

- ühekordne

- SUURUS

- suurused

- aeglane

- väike

- väiksem

- So

- Ühiskond

- lahendus

- Lahendused

- mõned

- allikas

- spetsialist

- konkreetse

- eriti

- kiirus

- jagada

- standard

- algus

- Käivitus

- käivitamisel

- väljavõte

- Ühendriigid

- statistiline

- Samm

- Sammud

- Veel

- Peatab

- ladustamine

- salvestada

- Strateegiline

- nöör

- püüab

- stuudio

- edukas

- edukas

- selline

- komplekt

- Toetatud

- Toetab

- jätkusuutlik

- süsteemid

- tabel

- võtab

- ülesanded

- tehnika

- tehnikat

- šabloon

- tingimused

- test

- Testimine

- testid

- kui

- et

- .

- Piirkond

- Neile

- SIIS

- Seal.

- seetõttu

- Need

- mõtleja

- see

- põhjalik

- kolm

- Läbi

- aeg

- et

- täna

- Tokeniseerimine

- liiga

- Summa

- jälgida

- Rong

- koolitatud

- koolitus

- trafod

- tõsi

- Tõde

- püüdma

- kaks

- tüüp

- liigid

- Masinakiri

- tüüpiliselt

- ui

- all

- üksus

- Ülikool

- kuni

- Värskendused

- ajakohastatud

- Uudised

- us

- kasutama

- Kasutatud

- kasutusalad

- kasutamine

- kehtiv

- kinnitamine

- väärtus

- Väärtused

- variant

- eri

- varieeruv

- sõiduk

- versioon

- väga

- kaudu

- kõndima

- tahan

- oli

- kuidas

- we

- web

- veebiteenused

- Hästi

- millal

- kas

- mis

- kuigi

- kogu

- will

- koos

- ilma

- töötaja

- töötajate

- töö

- töötab

- sa

- Sinu

- sephyrnet