Amazon SageMaker on täielikult hallatav teenus, mis annab igale arendajale ja andmeteadlasele võimaluse kiiresti luua, koolitada ja mastaabis masinõppe (ML) mudeleid juurutada. ML realiseerub järeldades. SageMaker pakub nelja järeldusvõimalust:

Need neli valikut võib laias laastus liigitada võrgu- ja partii järelduste valikuteks. Online Inference'is eeldatakse, et päringuid töödeldakse kohe, kui need saabuvad, ja tarbiv rakendus ootab vastust pärast iga päringu töötlemist. See võib toimuda sünkroonselt (reaalajas järeldus, serverita) või asünkroonselt (asünkroonne järeldus). Sünkroonse mustri korral on tarbiv rakendus blokeeritud ja ei saa jätkata enne, kui see saab vastuse. Need töökoormused on tavaliselt reaalajas rakendused, näiteks krediitkaardipettuste tuvastamine Internetis, kus vastuseid oodatakse millisekunditest kuni sekunditeni ja taotluste koormus on väike (paar MB). Asünkroonse mustri korral ei blokeerita rakenduskogemust (näiteks kindlustusnõude esitamine mobiilirakenduse kaudu) ja tavaliselt on vaja suuremat koormust ja/või pikemat töötlemisaega. Võrguühenduseta järelduses töödeldakse järeldustaotluste koondamist (partii) koos ja vastused esitatakse alles pärast kogu partii töötlemist. Tavaliselt ei ole need töökoormused latentsustundlikud, hõlmavad suuri andmemahtusid (mitu GB) ja on ajastatud korrapärase kadentsiga (näiteks käivitage päeva lõpus turvakaamera salvestusel objektide tuvastamine või töödelge palgaarvestuse andmeid kuu lõpus).

Paljaste luude juures, SageMakeri reaalajas järeldus koosneb mudeli(te)st, raamistikust/konteinerist, millega töötate, ja infrastruktuurist/eksemplaridest, mis toetavad teie juurutatud lõpp-punkti. Selles postituses uurime, kuidas saate luua ja käivitada ühe mudeli lõpp-punkti.

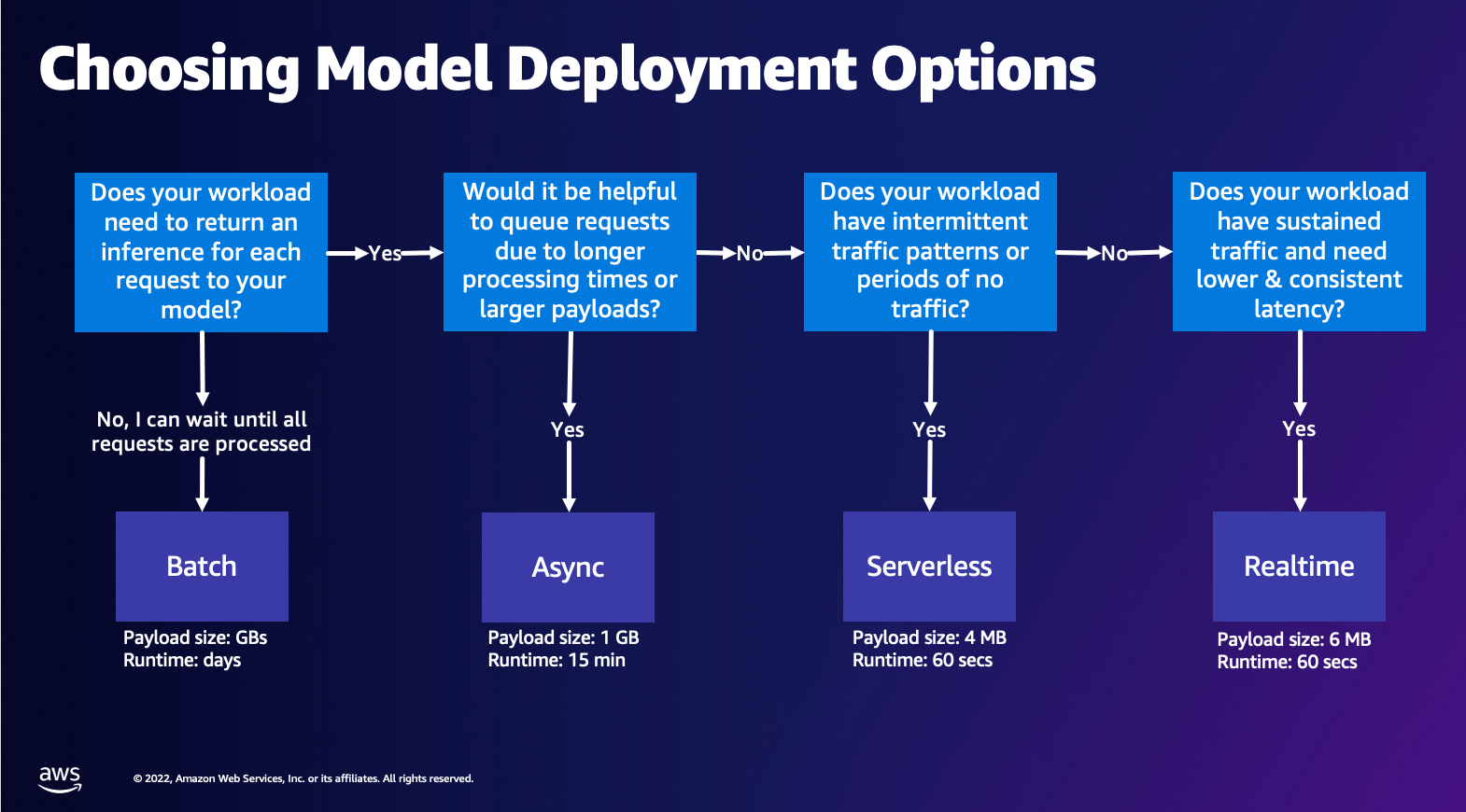

Mudeli juurutamise valiku valimine

Õige järeldustüübi valimine võib olla keeruline ja järgmine lihtne juhend võib teid aidata. See ei ole range vooskeem, nii et kui leiate, et mõni muu valik sobib teile paremini, kasutage seda julgelt. Eelkõige on Real-Time Inference suurepärane võimalus mudelite majutamiseks, kui teil on madal ja ühtlane latentsusaeg (millisekundite või sekundite suurusjärgus) ja läbilaskevõimega tundlik töökoormus. Saate juhtida eksemplari tüüpi ja lugeda lõpp-punkti taga, samal ajal konfigureerides Automaatne skaleerimine liikluse korraldamise poliitika. On veel kaks SageMaker Inference valikut, mida saate kasutada ka lõpp-punkti loomiseks. Asünkroonne järeldus on siis, kui teil on suur kasulik koormus ja peaaegu reaalajas latentsusriba laius. See on hea valik, eriti NLP ja Computer Vision mudelite puhul, millel on pikem eeltöötlusaeg. Serverita järeldus on suurepärane võimalus, kui teil on katkendlik liiklus ja te ei soovi infrastruktuuri skaleerimist hallata. Lõpp-punkti loomise retsept jääb samaks, olenemata teie valitud järeldustüübist. Selles postituses keskendume reaalajas eksemplaripõhise lõpp-punkti loomisele, kuid saate seda hõlpsasti kohandada mõne muu järeldussuvandiga, mis põhineb teie kasutusjuhtumil. Lõpuks toimub pakettjäreldamine võrguühenduseta, nii et saate esitada andmete kogumi, millest soovite järeldusi teha, ja me käivitame selle. See on samamoodi eksemplaripõhine, nii et saate valida oma töökoormuse jaoks optimaalse eksemplari. Kuna ükski lõpp-punkt ei tööta, maksate ainult töö kestuse eest. See on hea gigabaitide andmete töötlemiseks ja töö kestus võib olla päevi. Struktureeritud andmetega töötamise hõlbustamiseks on sisseehitatud funktsioonid ja optimeerimised struktureeritud andmete automaatseks levitamiseks. Mõned näited kasutusjuhtudest on kalduvuse modelleerimine, ennustav hooldus ja vähenemise prognoosimine. Kõik need võivad toimuda võrguühenduseta hulgi, kuna see ei pea reageerima konkreetsele sündmusele.

Mudeli hostimine SageMakeri lõpp-punktides

Põhimõtteliselt koosnevad SageMakeri reaalajas lõpp-punktid mudelist ja infrastruktuurist, millega otsustate lõpp-punkti toetada. SageMaker kasutab mudelite hostimiseks konteinereid, mis tähendab, et teil on vaja konteinerit, mis seadistab iga pakutava mudeli jaoks kasutatava raamistiku keskkonna õigesti. Näiteks kui töötate Sklearni mudeliga, peate oma mudeli skriptid/andmed sisestama konteinerisse, mis Sklearni õigesti seadistab. Õnneks pakub SageMaker hallatavad pildid populaarsete raamistike jaoks, nagu TensorFlow, PyTorch, Sklearn ja HuggingFace. Saate neid pilte laadida ja kasutada kõrgtasemel SageMaker Python SDK ja sisestage oma mudeli skriptid ja andmed nendesse konteineritesse. Kui SageMakeril pole toetatud konteinerit, saate seda ka teha Ehitage oma konteiner ja suruge oma kohandatud pilt, installides teie mudeli jaoks vajalikud sõltuvused.

SageMaker toetab nii koolitatud kui ka eelkoolitatud mudeleid. Eelmises lõigus, kui räägime mudeliskriptidest/andmetest, viitame sellele küsimusele. Saate oma konteinerile paigaldada skripti või kui teil on eelkoolitatud mudeliartefakt (nt `mudel.joblib` SKLearni jaoks), siis saate selle koos oma pildiga SageMakerile esitada. SageMakeri järelduse mõistmiseks on kolm peamist olemit, mille loote lõpp-punkti loomise protsessis:

- SageMakeri mudeliüksus – siin saate edastada oma koolitatud mudeliandmed/mudeli skripti ja pildi, millega töötate, olenemata sellest, kas see kuulub AWS-ile või on teie loodud.

- Lõpp-punkti konfiguratsiooni loomine – siin saate määratleda oma infrastruktuuri, mis tähendab, et valite eksemplari tüübi, loenduse jne.

- Lõpp-punkti loomine – see on REST-i lõpp-punkt, mis majutab teie mudelit, mida vastuse saamiseks kutsute. Vaatame, kuidas saate lõpp-punkti juurutamiseks kasutada hallatud SageMakeri pilti ja oma kohandatud pilti.

Reaalajas lõpp-punkti nõuded

- Enne lõpp-punkti loomist peate mõistma, millist tüüpi mudelit soovite hostida. Kui see on raamistiku mudel, näiteks TensorFlow, PyTorch või MXNet, saate kasutada üht eelehitatud raamistiku kujutised.

Kui see on kohandatud mudel või soovite täielikku paindlikkust konteineri loomisel, mida SageMaker järelduste tegemiseks kasutab, saate luua oma konteineri.

SageMakeri lõpp-punktid koosnevad a SageMakeri mudel ja Lõpp-punkti konfiguratsioon.

Kui kasutate Boto3, loote mõlemad objektid. Vastasel juhul, kui kasutate SageMaker Pythoni SDK-d, luuakse lõpp-punkti konfiguratsioon teie nimel, kui kasutate .deploy(..) funktsiooni.

SageMakeri olemid:

- SageMakeri mudel:

- Sisaldab järelduskujutise üksikasju, mudeli artefaktide asukohta Amazon Simple Storage Service (Amazon S3), võrgu konfiguratsioon ja AWS-i identiteedi ja juurdepääsu haldus (IAM) roll, mida lõpp-punkt kasutab.

- SageMaker nõuab teie mudeli artefaktide tihendamist a

.tar.gzfaili. SageMaker ekstraktib selle automaatselt.tar.gzfaili sisse/opt/ml/model/kataloogi teie konteineris. Kui kasutate ühte raamistiku konteineritest, nagu TensorFlow, PyTorch või MXNet, eeldab konteiner, et teie TAR-i struktuur on järgmine:- TensorFlow

- PyTorch

- MX Net

- Sklearn

- TensorFlow

- Frameworki kujutise kasutamisel saame pakkuda kohandatud sisenemispunkti skripti, kus saame rakendada oma eel- ja järeltöötlust. Meie puhul on järeldusskript pakitud kataloogi model.tar.gz /code kataloogi.

- SageMaker nõuab teie mudeli artefaktide tihendamist a

- Sisaldab järelduskujutise üksikasju, mudeli artefaktide asukohta Amazon Simple Storage Service (Amazon S3), võrgu konfiguratsioon ja AWS-i identiteedi ja juurdepääsu haldus (IAM) roll, mida lõpp-punkt kasutab.

-

- Lõpp-punkti konfiguratsioon

- Sisaldab infrastruktuuri teavet, mis on vajalik SageMakeri mudeli juurutamiseks lõpp-punktis.

- Näiteks on siin määratletud meie loodud SageMakeri mudel, samuti eksemplari tüüp ja esialgse eksemplari arv.

Frameworks ja BYOC

-

- SageMakeri piltide toomine

- See osa pole alati vajalik ja SageMaker Python SDK võtab selle hinnangute abil välja. Kui soovite aga hankida SageMakeri hallatud pilti, et seda laiendada, saate SDK kaudu saadaolevad pildid hankida. Järgmine on näide TF 2.2 kujutise leidmisest järelduste tegemiseks.

- raamistikud

- Kui soovite juurutada raammudelit, nagu TensorFlow, PyTorch või MXNet, on teil vaja ainult mudeli artefakte.

- Vaadake dokumentatsiooni mudelite juurutamise kohta otse mudeli artefaktidest TensorFlow, PyTorchvõi MX Net.

- SageMakeri piltide toomine

-

- 1P ja BYOC vahel valimine

- SageMaker SDK teeb ka pildi haldamise abstraktse, nagu nägite eelmises raamistiku jaotises. Sellel on Sklearni, TensorFlow ja PyTorchi jaoks valmis hinnangud, mis valivad teie jaoks pildi automaatselt teie valitud versiooni põhjal. Seejärel saate läbida koolituse/järeldusskripti Skriptirežiim nendesse hinnangutesse.

- SageMaker ei toeta kõiki pakette ja pilte ning sel juhul peate seda tegema võtke kaasa oma konteiner (BYOC). See tähendab Dockeri faili loomist, mis loob teie mudeli teenindamiseks sobiva keskkonna. Selle näiteks on moodul Spacy NLP ja selle raamistiku jaoks pole hallatud SageMakeri konteinereid. Seetõttu peate esitama Dockeri faili, mis installib Spacey. Konteinerisse ühendate ka oma mudeli järeldusskriptid. Arutame kiiresti komponentide üle, mida pakute vormingus Bring Your Own Container, kuna need on enamiku näidete puhul järjepidevad.

- "nginx.conf" on nginxi esiosa konfiguratsioonifail. Te ei pea seda faili redigeerima, välja arvatud juhul, kui soovite neid osi häälestada.

- "predictor.py" on programm, mis tegelikult rakendab teie rakenduse jaoks Flask veebiserveri ja mudelikoodi. Teie konteineris võib olla muid Pythoni faile või funktsioone, mida saate selles failis kutsuda.

- "teenida" on programm, mis käivitatakse konteineri hostimiseks käivitamisel. See lihtsalt käivitab gunicorn-serveri, mis käitab mitut failisprecedor.py määratletud rakenduse Flask eksemplari. Nagu nginx.conf, ei pea te seda faili redigeerima, välja arvatud juhul, kui soovite teha täiendavaid häälestusi.

- "rong" on programm, mis käivitatakse konteineri treenimiseks käivitamisel. Saate seda programmi oma treeningalgoritmi rakendamiseks muuta. Kui võtate kaasa eelkoolitatud mudeli või raamistiku, näiteks Spacey, pole teil seda faili vaja.

- "wsgi.py" on väike ümbris, mida kasutatakse Flask rakenduse käivitamiseks. Peaksite saama seda faili kasutada nii, nagu see on, välja arvatud juhul, kui olete oma failiprediktor.py nime muutnud. Sel juhul veenduge, et kaardid oleksid siin õigesti tehtud.

- 1P ja BYOC vahel valimine

-

- Kohandatud järeldusskript

- SageMaker Frameworki konteinerid annavad teile paindlikkuse hallata päringu eel- ja järeltöötlust ning mudeli laadimist, kasutades kohandatud sisestuspunkti skripti/inference.py.

- Vaadake dokumentatsiooni kohandatud skripti inference.py loomiseks TensorFlow, PyTorch ja MX Net.

- Kohandatud konteiner

- Kohandatud järeldusskript

Erinevad viisid, kuidas saate SageMakeri lõpp-punktidega suhelda

SageMakeri programmiliseks kasutamiseks on palju võimalusi, nii et saate järelduste tegemiseks helistada juurutatud mudelitele. The AWS-i käsurealiides (AWS CLI), REST API-d, AWS CloudFormation, AWS-i pilvearenduskomplekt (AWS CDK) ja AWS SDK-d on tavalised tööriistad, mida pakub AWS ja mida laialdaselt toetavad ka teised AWS-i teenused. SageMakeri jaoks on meil ka SageMaker Python SDK. Nüüd võrdleme SageMakeri lõpp-punktide loomise, kutsumise ja haldamise erinevaid võimalusi.

Lisaks SageMaker CLI, saate programmiliselt SDK-de kaudu SageMakeri lõpp-punktidega suhelda kahel viisil. Vaatame mõningaid erinevusi SageMaker Python SDK ja Boto3 Python SDK:

- Kõrgetasemeline SageMaker "Python" SDK – see SDK on avatud lähtekoodiga teek, mis pakub kõrgema taseme abstraktsiooni, mis on spetsiaalselt ette nähtud SageMakeri API-de programmiliseks kutsumiseks Pythoni abil. Selle SDK hea osa on see, et sagemakeri API-sid on väga lihtne kutsuda, juba tehakse palju raskeid töid, nagu API-de kutsumine sünkroonselt/asünkroonrežiimis (aitab vältida küsitlemist), lihtsam päringu/vastuse skeem, palju vähem koodi ja palju muud. lihtsam kood. SageMaker Python SDK pakub mitmeid kõrgetasemelisi abstraktsioone SageMakeriga töötamiseks. Pakett on mõeldud erinevate ML-i protsesside lihtsustamiseks SageMakeris.

- Madala taseme AWS SDK (Boto3 SDK) – see SDK töötab madalamal tasemel, võimaldades kasutajal valida toetatud programmeerimiskeelte hulgast ja kutsuda programmiliselt kõiki AWS-teenuseid. See pole ainult SageMakeri spetsiifiline, vaid seda saab kasutada üldiselt kõigi AWS-teenuste jaoks. Madala taseme AWS-i SDK-d on saadaval erinevates programmeerimiskeeltes, nagu .NET, Python, Java, Node.js jne. Üks populaarsemaid SDK-sid on boto3 python SDK, mis on ML-i andmeteadlaste kogukonnas populaarne. Selle SDK hea osa on see, et see on väga kerge ja vaikimisi saadaval AWS Lambda Kestus. Lisaks saate seda SDK-d kasutada mis tahes AWS-teenusega väljaspool SageMakeri suhtlemiseks.

Mõlemaid SDK-sid saab kasutada samade ülesannete jaoks, kuid mõnel juhul on intuitiivsem kasutada ühte rohkem kui teist. Testimise hõlbustamiseks on soovitatav kasutada SageMaker Python SDK-d, samas kui AWS SDK/Boto3 on soovitatav kasutada tootmisjuhtudel, et jõudlust paremini kontrollida. Näiteks pakub SageMaker teenusena eelehitatud ja hooldatud pilte populaarsete raamistike jaoks, nagu Sklearn, PyTorch ja TensorFlow. Eriti kasulik võib olla SageMaker SDK kasutamine süvaõppepiltide hankimiseks ja mudelite koolitamiseks Hindajad, ja juurutage mudel lihtsa API-kõne abil. Selle tegevuse tutvustamiseks leiate näite siin.

Teisest küljest on teil mõnikord eelkoolitatud mudeleid või erinevaid raamistikke, mida võite kasutada. See nõuab suuremat kohandamist ja SageMaker SDK ei paku seda alati. Meil on kolm olulist sammu ja vastavad boto3 API kutsed, mida peame lõpp-punkti juurutamiseks täitma: Mudeli loomine, Lõpp-punkti konfiguratsiooni loomineja Lõpp-punkti loomine. Esimesed kaks olemit eraldati meie toetatud raamistikega SageMaker SDK-ga, kuid me näeme neid üksikasju Boto3 SDK-ga. Leiate ulatusliku näite Boto3 SDK kasutamise etappide tutvustamiseks lõpp-punkti loomiseks ja haldamiseks. siin.

SageMakeri hostimise kaalutlused

SageMaker Real-Time Inference sisaldab kahte peamist optimeerimist, mida võite kaaluda: 1/ toimivuse optimeerimine ja 2/ kulude optimeerimine. Vaatame kõigepealt jõudluse optimeerimine, nagu ka siis, kui tegemist on latentsustundliku töökoormusega, on iga millisekund ülioluline. Latentsusaja ja läbilaskevõime optimeerimiseks saate häälestada erinevaid nuppe. Eksemplari tasemel saate kasutada Järelduste soovitaja, meie sisseehitatud koormuse testimise tööriist, mis aitab teil valida õige eksemplari tüübi ja arvestada oma töökoormusega. Arvutamise õige kombinatsiooni kasutamine aitab teil nii jõudlust kui ka kulusid suurendada. Saate häälestada ka konteineri ja raamistiku tasemel.

Küsimused, mida endalt küsida, hõlmavad järgmist:

- Millist raamistikku te kasutate?

- Kas on keskkonnamuutujaid, mida saate oma konteineris häälestada?

Selle näiteks on maksimeerimine TensorFlow jõudlus SageMakeri konteineritega. Teine konteineritaseme optimeerimise näide on kasutades gRPC-d mitte PUHASTA oma lõpp-punkti taga. Lõpuks saate optimeerida ka skripti tasemel. Kas teie järelduskood võtab teatud plokkide puhul lisaaega? Skripti iga rea ajastus aitab teil tabada kõik koodi kitsaskohad.

Vaatamiseks on kolm võimalust kasutamise parandamine teie reaalajas lõpp-punktist:

- Mitme mudeli lõpp-punktid (MME)

- Saate ühe lõpp-punkti taga majutada tuhandeid mudeleid. See sobib suurepäraselt kasutamiseks, kus te ei vaja iga mudeli jaoks spetsiaalset lõpp-punkti. MME töötab kõige paremini, kui mudelid on sarnase suuruse ja latentsusega ning kuuluvad samasse ML-raamistikku. Neid saab tavaliselt kasutada siis, kui te ei pea alati helistama samale mudelile. Saate vastava mudeli dünaamiliselt laadida SageMakeri lõpp-punkti, et teie päring toimiks. Leiate näite, mis tutvustab MME-d tegevuses siin. Kui soovite rohkem teada saada MME-s mudelite hostimise erinevate hoiatuste ja parimate tavade kohta, vaadake postitust siin.

- Mitme konteineri lõpp-punktid (MCE)

- Selle asemel, et kasutada mitme konteineri hostimiseks mitut lõpp-punkti, võite vaadata kuni 15 konteineri hostimist ühes lõpp-punktis. Igaüks neist konteineritest saab otse välja kutsuda. Seetõttu saate vaadata erinevate raamistike erinevate mudelite hostimist ühes lõpp-punktis. See valik on parim, kui konteinerite kasutus- ja jõudlusnäitajad on sarnased. MCE-d tutvustava näite leiate siin. Kui soovite lisateavet MCE-s mudelite hostimise erinevate hoiatuste ja parimate tavade kohta, vaadake postitust siin.

- Serial Inference Pipeline (SIP)

- Kui teie järeldusloogikas on toimingute konveier, võite kasutada SIP-i (Serial Inference Pipeline). SIP võimaldab teil aheldada 2–15 konteinerit ühe lõpp-punkti taha. SIP töötab hästi, kui teil on eel- ja järeltöötlusetapid. Kui soovite rohkem teada saada järjestikuste järelduste torujuhtmete kujundusmustrite kohta, vaadake postitust siin.

Teine peamine optimeerimine, mida meeles pidada, on hind. Reaalajas järeldus on üks kolmest valikust SageMakeri lõpp-punktide loomisel. SageMakeri lõpp-punktid töötavad kogu aeg, kui neid pole kustutatud. Seetõttu peate otsima lõpp-punkti kasutamise parandamist, mis omakorda annab kulude kasu.

SageMaker pakub ka Säästuplaanid. Säästuplaanid võivad teie kulusid vähendada kuni 64%. See on 1- või 3-aastane kohustus järjepidevalt kasutada ($/tund). Vaata seda link rohkem informatsiooni. Ja vaata seda link Amazon SageMakeri Inference kulude parimaks optimeerimiseks.

Järeldus

Selles postituses näitasime teile mõningaid parimaid tavasid, kuidas valida SageMakeri erinevate mudelite hostimisvõimaluste vahel. Arutasime SageMakeri lõpp-punkti nõudeid ning vastandasime ka Frameworki ja BYOCi nõudeid ja funktsioone. Lisaks rääkisime erinevatest viisidest, kuidas saate reaalajas lõpp-punkte oma ML-mudelite majutamiseks tootmises kasutada. kulutõhusal viisil ja suure jõudlusega.

Vaata vastavat GitHubi hoidla ja proovige näiteid.

Autoritest

Raghu Ramesha on Amazon SageMaker Service meeskonnaga ML Solutionsi arhitekt. Ta keskendub sellele, et aidata klientidel luua, juurutada ja ML-i tootmise töökoormust SageMakerile ulatuslikult üle viia. Ta on spetsialiseerunud masinõppele, tehisintellektile ja arvutinägemisvaldkondadele ning tal on magistrikraadi arvutiteaduses TÜ Dallases. Vabal ajal meeldib talle reisida ja pildistada.

Raghu Ramesha on Amazon SageMaker Service meeskonnaga ML Solutionsi arhitekt. Ta keskendub sellele, et aidata klientidel luua, juurutada ja ML-i tootmise töökoormust SageMakerile ulatuslikult üle viia. Ta on spetsialiseerunud masinõppele, tehisintellektile ja arvutinägemisvaldkondadele ning tal on magistrikraadi arvutiteaduses TÜ Dallases. Vabal ajal meeldib talle reisida ja pildistada.

Ram Vegiraju on SageMaker Service meeskonnaga ML arhitekt. Ta keskendub sellele, et aidata klientidel luua ja optimeerida oma AI/ML-lahendusi Amazon SageMakeris. Vabal ajal armastab ta reisimist ja kirjutamist.

Ram Vegiraju on SageMaker Service meeskonnaga ML arhitekt. Ta keskendub sellele, et aidata klientidel luua ja optimeerida oma AI/ML-lahendusi Amazon SageMakeris. Vabal ajal armastab ta reisimist ja kirjutamist.

Marc Karp on SageMaker Service meeskonnaga ML arhitekt. Ta keskendub klientide abistamisele ML-töökoormuste ulatuslikul kavandamisel, juurutamisel ja haldamisel. Vabal ajal meeldib talle reisida ja avastada uusi kohti.

Marc Karp on SageMaker Service meeskonnaga ML arhitekt. Ta keskendub klientide abistamisele ML-töökoormuste ulatuslikul kavandamisel, juurutamisel ja haldamisel. Vabal ajal meeldib talle reisida ja avastada uusi kohti.

Dhawal Patel on AWS-i peamine masinõppe arhitekt. Ta on hajutatud andmetöötluse ja tehisintellektiga seotud probleemide lahendamisel töötanud organisatsioonidega alates suurettevõtetest kuni keskmise suurusega idufirmadeni. Ta keskendub sügavale õppimisele, sealhulgas NLP ja arvutinägemise valdkondadele. Ta aitab klientidel teha Amazon SageMakeris suure jõudlusega mudeli järeldusi.

Dhawal Patel on AWS-i peamine masinõppe arhitekt. Ta on hajutatud andmetöötluse ja tehisintellektiga seotud probleemide lahendamisel töötanud organisatsioonidega alates suurettevõtetest kuni keskmise suurusega idufirmadeni. Ta keskendub sügavale õppimisele, sealhulgas NLP ja arvutinägemise valdkondadele. Ta aitab klientidel teha Amazon SageMakeris suure jõudlusega mudeli järeldusi.

Saurabh Trikande on Amazon SageMaker Inference'i vanemtootejuht. Ta on kirglik töö klientidega ja teda motiveerib eesmärk demokratiseerida masinõpe. Ta keskendub põhiprobleemidele, mis on seotud keeruliste ML-rakenduste, mitme rentniku ML-mudelite, kulude optimeerimise ja süvaõppemudelite juurutamise kättesaadavamaks muutmisega. Vabal ajal naudib Saurabh matkamist, uuenduslike tehnoloogiate õppimist, TechCrunchi jälgimist ja perega aega veetmist.

Saurabh Trikande on Amazon SageMaker Inference'i vanemtootejuht. Ta on kirglik töö klientidega ja teda motiveerib eesmärk demokratiseerida masinõpe. Ta keskendub põhiprobleemidele, mis on seotud keeruliste ML-rakenduste, mitme rentniku ML-mudelite, kulude optimeerimise ja süvaõppemudelite juurutamise kättesaadavamaks muutmisega. Vabal ajal naudib Saurabh matkamist, uuenduslike tehnoloogiate õppimist, TechCrunchi jälgimist ja perega aega veetmist.

- Täpsem (300)

- AI

- ai kunst

- ai kunsti generaator

- on robot

- Amazon SageMaker

- tehisintellekti

- tehisintellekti sertifikaat

- tehisintellekt panganduses

- tehisintellekti robot

- tehisintellekti robotid

- tehisintellekti tarkvara

- AWS-i masinõpe

- blockchain

- plokiahela konverents ai

- coingenius

- vestluslik tehisintellekt

- krüptokonverents ai

- dall's

- sügav õpe

- google ai

- masinõpe

- Platon

- plato ai

- Platoni andmete intelligentsus

- Platoni mäng

- PlatoData

- platogaming

- skaala ai

- süntaks

- sephyrnet