Sissejuhatus

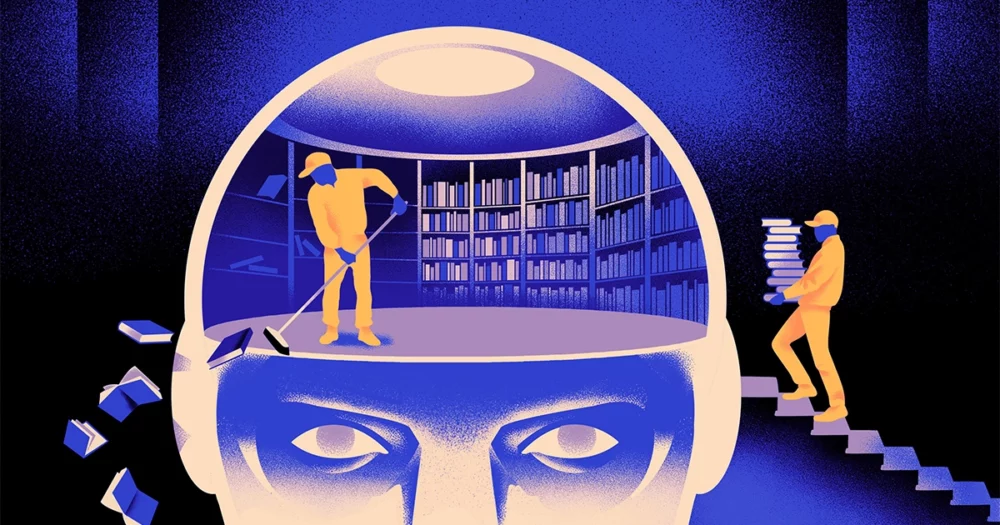

Arvutiteadlaste meeskond on loonud a krapsakam, paindlikum tüüp masinõppe mudelist. Trikk: see peab aeg-ajalt unustama, mida ta teab. Ja kuigi see uus lähenemisviis ei tõrju välja suuri mudeleid, mis suurimate rakenduste all on, võib see paljastada rohkem selle kohta, kuidas need programmid keelest aru saavad.

Uus uurimus tähistab "märkimisväärset edu selles valdkonnas", ütles Jea Kwon, AI insener Lõuna-Korea alusteaduste instituudis.

Tänapäeval kasutatavad tehisintellekti keelemootorid on enamasti toidetud kunstlikud närvivõrgud. Iga võrgus olev neuron on matemaatiline funktsioon, mis võtab vastu signaale teistelt sellistelt neuronitelt, teeb mõningaid arvutusi ja saadab signaale läbi mitme neuronikihi. Esialgu on info liikumine enam-vähem juhuslik, kuid koolituse kaudu paraneb infovoog neuronite vahel, kuna võrk kohandub treeningandmetega. Kui tehisintellekti teadlane soovib luua näiteks kakskeelset mudelit, treeniks ta mudelit suure hunniku tekstiga mõlemast keelest, mis reguleeriks neuronite vahelisi ühendusi nii, et ühes keeles oleks tekst samaväärsete tekstidega seotud. sõnad teises.

Kuid see koolitusprotsess võtab palju arvutusvõimsust. Kui mudel väga hästi ei tööta või kui kasutaja vajadused hiljem muutuvad, on seda raske kohandada. "Ütleme, et teil on mudel, millel on 100 keelt, kuid kujutage ette, et üks teie soovitud keel pole hõlmatud," ütles ta. Mikel Artetxe, uue uurimistöö kaasautor ja tehisintellekti startup Reka asutaja. "Võite alustada nullist, kuid see pole ideaalne."

Artetxe ja tema kolleegid on püüdnud neist piirangutest mööda hiilida. Paar aastat tagasi, Artetxe ja teised treenisid närvivõrku ühes keeles, seejärel kustutasid selle, mida ta teadis sõnade ehitusplokkidest, mida nimetatakse märgideks. Need on salvestatud närvivõrgu esimesse kihti, mida nimetatakse manustamiskihiks. Nad jätsid kõik teised mudeli kihid rahule. Pärast esimese keele märkide kustutamist õpetasid nad mudelit ümber teisele keelele, mis täitis manustamiskihi selle keele uute märkidega.

Kuigi mudel sisaldas mittevastavat teavet, töötas ümberõpe: mudel võis uut keelt õppida ja töödelda. Teadlased oletasid, et kui manustamiskiht talletas keeles kasutatavatele sõnadele spetsiifilist teavet, siis võrgu sügavamad tasemed salvestasid inimkeelte taga olevate mõistete kohta abstraktsemat teavet, mis aitas mudelil õppida teist keelt.

"Me elame samas maailmas. Mõistame samu asju erinevate sõnadega” erinevates keeltes, ütles Yihong Chen, hiljutise artikli juhtiv autor. "Seetõttu on teil mudelis sama kõrgetasemeline arutluskäik. Õun on sõna asemel midagi magusat ja mahlast.

Sissejuhatus

Kuigi see unustamisviis oli tõhus viis juba koolitatud mudelile uue keele lisamiseks, oli ümberõpe siiski nõudlik – see nõudis palju keelelisi andmeid ja töötlemisvõimsust. Chen soovitas näpunäidet: selle asemel, et treenida, kustutada manustamiskiht ja seejärel uuesti koolitada, peaksid nad algse treeningu ajal manustuskihi perioodiliselt lähtestama. "Seda tehes harjub kogu mudel lähtestama, " ütles Artetxe. "See tähendab, et kui soovite mudelit mõnele muule keelele laiendada, on see lihtsam, sest just seda olete teinud."

Teadlased võtsid kasutusele tavaliselt kasutatava keelemudeli nimega Roberta, treenisid seda oma perioodilise unustamise tehnikaga ja võrdlesid seda sama mudeli jõudlusega, kui seda treeniti standardse, unustamatu lähenemisviisiga. Unustamise mudelil läks pisut halvemini kui tavapärasel, saades ühe keele täpsuse üldnäitaja hindeks 85.1 võrreldes 86.1-ga. Seejärel õpetasid nad mudeleid ümber teistes keeltes, kasutades palju väiksemaid andmekogumeid, mis koosnesid vaid 5 miljonist märgist, mitte 70 miljardit, mida nad esimesel koolitusel kasutasid. Tavamudeli täpsus langes keskmiselt 53.3-ni, unustamismudel aga vaid 62.7-ni.

Unustamise mudelil läks ka palju paremini, kui meeskond kehtestas ümberõppe ajal arvutuslikud piirangud. Kui teadlased vähendasid treeningu pikkust 125,000 5,000 sammult kõigest 57.8-ni, vähenes unustamismudeli täpsus keskmiselt 37.2-ni, samas kui standardmudel langes XNUMX-ni, mis pole parem kui juhuslikud oletused.

Sissejuhatus

Töörühm jõudis järeldusele, et perioodiline unustamine näib muutvat mudeli üldiselt keelte õppimisel paremaks. "Kuna [nad] unustavad ja õpivad koolituse ajal uuesti, muutub võrgustikule hiljem millegi uue õpetamine lihtsamaks," ütles Jevgeni Nikishin, teadur Milas, Quebecis asuvas süvaõppe uurimiskeskuses. See viitab sellele, et kui keelemudelid mõistavad keelt, teevad nad seda sügavamal tasandil kui ainult üksikute sõnade tähendused.

Lähenemisviis on sarnane meie enda aju tööle. "Inimese mälu üldiselt ei ole väga hea suure hulga üksikasjaliku teabe täpseks salvestamiseks. Selle asemel kipuvad inimesed meeles pidama meie kogemuste põhiolemust, abstraktselt ja ekstrapoleerides, ”ütles Benjamin Levy, San Francisco ülikooli neuroteadlane. AI lubamine inimlikumate protsessidega, nagu adaptiivne unustamine, on üks viis paindlikuma jõudluse saavutamiseks.

Lisaks sellele, mida see võib öelda mõistmise toimimise kohta, loodab Artetxe, et paindlikumad unustamiskeelemudelid võivad aidata tuua uusimad AI läbimurded rohkematesse keeltesse. Ehkki tehisintellekti mudelid oskavad hästi hakkama saada hispaania ja inglise keelega, mis on kaks keelt koos rohkete õppematerjalidega, ei sobi mudelid tema emakeelega baski keelega, mis on kohalik Kirde-Hispaaniale omane keel. "Enamik suurte tehnoloogiaettevõtete mudeleid ei tee seda hästi," ütles ta. "Olemasolevate mudelite kohandamine baski keelega on õige tee."

Chen ootab ka maailma, kus õitseb rohkem AI lilli. «Ma mõtlen olukorrale, kus maailm ei vaja üht suurt keelemudelit. Meil on nii palju, ”ütles ta. "Kui tehas valmistab keelemudeleid, on teil vaja sellist tehnoloogiat. Sellel on üks baasmudel, mis suudab kiiresti uute domeenidega kohaneda.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- PlatoTervis. Biotehnoloogia ja kliiniliste uuringute luureandmed. Juurdepääs siia.

- Allikas: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :on

- :on

- :mitte

- : kus

- ][lk

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- MEIST

- ABSTRACT

- täpsus

- täpselt

- kohandama

- adaptiivne

- kohaneb

- lisama

- lisamine

- edendama

- pärast

- AI

- AI mudelid

- Materjal: BPA ja flataatide vaba plastik

- üksi

- juba

- Ka

- summad

- an

- ja

- Teine

- õun

- lähenemine

- apps

- OLEME

- AS

- At

- autor

- keskmine

- baas

- põhiline

- sest

- muutub

- olnud

- taga

- Parem

- vahel

- Suur

- suur tehnika

- suurim

- Miljard

- Plokid

- Õitsema

- mõlemad

- läbimurdeid

- tooma

- Ehitus

- kuid

- by

- arvutused

- kutsutud

- CAN

- keskus

- muutma

- Chen

- mööda hiilida

- Kaasautor

- kolleegidega

- ühine

- tavaliselt

- Ettevõtted

- võrreldes

- arvutuslik

- arvuti

- arvutustehnika

- arvutusvõimsus

- mõisted

- sõlmitud

- Side

- sisaldub

- tavaline

- võiks

- kaetud

- looma

- loodud

- lõigatud

- andmed

- andmekogumid

- vähenenud

- sügav

- sügav õpe

- sügavam

- nõudlik

- üksikasjalik

- DID

- erinev

- do

- Ei tee

- teeme

- Domeenid

- Ära

- langes

- ajal

- iga

- lihtsam

- Tõhus

- kinnistamine

- insener

- Mootorid

- Inglise

- Kogu

- Samaväärne

- näide

- olemasolevate

- Kogemused

- laiendama

- tehas

- vähe

- väli

- täidetud

- esimene

- paindlik

- voog

- eest

- edasi

- Asutaja

- Francisco

- Alates

- funktsioon

- Üldine

- üldiselt

- saama

- GitHub

- Go

- hea

- Käsitsemine

- Raske

- Olema

- he

- aitama

- aitas

- kõrgetasemeline

- tema

- loodab

- Kuidas

- HTTPS

- tohutu

- inim-

- inimlik

- Inimestel

- ideaalne

- if

- kujutage ette

- kehtestatud

- parandab

- in

- eraldi

- info

- esialgne

- esialgu

- selle asemel

- Instituut

- IT

- lihtsalt

- hoidma

- Laps

- teab

- Korea

- keel

- Keeled

- suur

- pärast

- hiljemalt

- kiht

- kihid

- viima

- Õppida

- õppimine

- lahkus

- Pikkus

- vähem

- Tase

- taset

- nagu

- piirangud

- piirid

- elama

- kohalik

- välimus

- Partii

- masin

- masinõpe

- ajakiri

- tegema

- Tegemine

- palju

- materjalid

- matemaatiline

- tähendused

- vahendid

- mõõtma

- Mälu

- võib

- miljon

- mudel

- mudelid

- rohkem

- enamasti

- palju

- mitmekordne

- peab

- emakeelena

- Vajadus

- vajadustele

- võrk

- närvi-

- Närvivõrgus

- Neuronid

- Uus

- ei

- of

- on

- ONE

- ainult

- or

- Muu

- teised

- meie

- üle

- enda

- Paber

- jõudlus

- perioodiline

- Platon

- Platoni andmete intelligentsus

- PlatoData

- sukeldus

- võim

- sisse

- protsess

- Protsessid

- töötlemine

- Töötlemise võimsus

- Programmid

- Kvantamagazin

- Quebec

- kiiresti

- juhuslik

- pigem

- saab

- vastuvõtmine

- hiljuti

- meeles pidama

- nõutav

- teadustöö

- uurija

- Teadlased

- avalduma

- ümber

- jookseb

- Ütlesin

- sama

- San

- San Francisco

- ütlema

- teadus

- teadlased

- skoor

- kriimustada

- Teine

- tundub

- selektiivne

- saadab

- Komplektid

- ta

- peaks

- signaale

- märkimisväärne

- sarnane

- olukord

- väiksem

- So

- mõned

- midagi

- Lõuna

- Lõuna-Korea

- Hispaania

- hispaania

- konkreetse

- standard

- algus

- käivitamisel

- Sammud

- Veel

- ladustatud

- ladustamine

- selline

- Soovitab

- magus

- võtab

- õpetamine

- meeskond

- tech

- tech ettevõtted

- tehnika

- Tehnoloogia

- kipuvad

- tekst

- kui

- et

- .

- teave

- maailm

- oma

- Neile

- SIIS

- Need

- nad

- asjad

- Mõtlemine

- see

- kuigi?

- Läbi

- et

- täna

- märgid

- võttis

- Rong

- koolitatud

- koolitus

- trikk

- proovitud

- näpistama

- kaks

- mõistma

- mõistmine

- Ülikool

- kasutama

- Kasutatud

- kasutamine

- väga

- tahan

- tahab

- oli

- Tee..

- we

- webp

- Hästi

- M

- millal

- mis

- kuigi

- miks

- koos

- sõna

- sõnad

- Töö

- töötas

- töötab

- maailm

- halvem

- oleks

- aastat

- sa

- sephyrnet