Amazon SageMaker muudab masinõppe (ML) mudelite juurutamise reaalajas järelduste tegemiseks lihtsaks ja pakub laia valikut ML-i eksemplare, mis hõlmavad protsessoreid ja kiirendeid, nagu AWS Inferentia. Täielikult hallatava teenusena saate oma mudeli juurutusi skaleerida, minimeerida järelduskulusid ja hallata oma mudeleid tootmises tõhusamalt, vähendades töökoormust. SageMakeri reaalajas järelduse lõpp-punkt koosneb HTTP-i lõpp-punktist ja ML-eksemplaridest, mis on kõrge kättesaadavuse tagamiseks juurutatud mitmes saadavuse tsoonis. SageMaker rakenduse automaatne skaleerimine saab dünaamiliselt kohandada mudeli jaoks ette nähtud ML-eksemplaride arvu vastuseks töökoormuse muutustele. Lõpp-punkt jaotab sissetulevad päringud ühtlaselt ML-i eksemplaridele, kasutades ring-robin algoritmi.

Kui eksemplaridel juurutatud ML-mudelid saavad API-kõnesid suurelt arvult klientidelt, võib päringute juhuslik jaotus toimida väga hästi, kui teie päringud ja vastused ei ole palju varieeruvad. Kuid generatiivse tehisintellektiga töökoormusega süsteemides võivad päringud ja vastused olla väga erinevad. Sellistel juhtudel on sageli soovitav koormuse tasakaal võtta arvesse eksemplari võimsust ja kasutust, mitte juhuslikku koormuse tasakaalustamist.

Selles postituses käsitleme SageMakeri vähimate taotluste (LOR) marsruutimise strateegiat ja seda, kuidas see saab minimeerida teatud tüüpi reaalajas järelduste töökoormuse latentsust, võttes arvesse ML-juhtumite mahtu ja kasutamist. Räägime selle eelistest võrreldes vaikemarsruutimismehhanismiga ja kuidas saate lubada LOR-i oma mudeli juurutamiseks. Lõpuks esitame võrdleva analüüsi latentsusaja paranemise kohta LOR-iga võrreldes juhusliku marsruutimise vaikemarsruutimisstrateegiaga.

SageMaker LOR strateegia

Vaikimisi on SageMakeri lõpp-punktidel juhuslik marsruutimisstrateegia. SageMaker toetab nüüd LOR-strateegiat, mis võimaldab SageMakeril optimaalselt suunata päringud eksemplarile, mis sobib selle päringu teenindamiseks kõige paremini. SageMaker teeb selle võimalikuks, jälgides teie lõpp-punkti taga olevate eksemplaride koormust ja igal eksemplaril juurutatud mudeleid või järelduskomponente.

Järgmine interaktiivne diagramm näitab vaikemarsruutimispoliitikat, kus mudeli lõpp-punktidesse saabuvad päringud edastatakse juhuslikul viisil ML-eksemplaridele.

Järgmine interaktiivne diagramm näitab marsruutimisstrateegiat, kus SageMaker suunab päringu eksemplarile, millel on kõige vähem rahuldamata taotlusi.

Üldiselt töötab LOR-marsruutimine hästi põhimudelite või generatiivsete AI-mudelite puhul, kui teie mudel reageerib sadade millisekundite kuni minutitega. Kui teie mudeli vastuse latentsus on väiksem (kuni sadu millisekundeid), võite juhuslikust marsruutimisest rohkem kasu saada. Sellest hoolimata soovitame teil testida ja leida oma töökoormuse jaoks parim marsruutimisalgoritm.

Kuidas määrata SageMakeri marsruutimisstrateegiaid

SageMaker võimaldab nüüd määrata RoutingStrategy parameetri loomise ajal EndpointConfiguration lõpp-punktide jaoks. Erinevad RoutingStrategy SageMakeri toetatud väärtused on järgmised:

LEAST_OUTSTANDING_REQUESTSRANDOM

Järgmine on mudeli juurutamise näide järelduse lõpp-punktis, millel on lubatud LOR:

- Loo lõpp-punkti konfiguratsioon sätte abil

RoutingStrategyasLEAST_OUTSTANDING_REQUESTS: - Looge lõpp-punkt, kasutades lõpp-punkti konfiguratsiooni (muutusteta):

Tulemuslikkuse tulemused

Viisime läbi jõudluse võrdlusuuringu, et mõõta lõpp-otsa järelduste latentsust ja läbilaskevõimet codegen2-7B mudel, mis on hostitud ml.g5.24xl eksemplaridel vaikemarsruutimise ja nutika marsruutimise lõpp-punktidega. CodeGen2 mudel kuulub autoregressiivsete keelemudelite perekonda ja genereerib käivitatava koodi ingliskeelsete viipade korral.

Analüüsis suurendasime iga katsekäigu jaoks iga lõpp-punkti taga olevate ml.g5.24xl eksemplaride arvu, kuna samaaegsete kasutajate arv suurenes, nagu on näidatud järgmises tabelis.

| test | Samaaegsete kasutajate arv | Juhtumite arv |

| 1 | 4 | 1 |

| 2 | 20 | 5 |

| 3 | 40 | 10 |

| 4 | 60 | 15 |

| 5 | 80 | 20 |

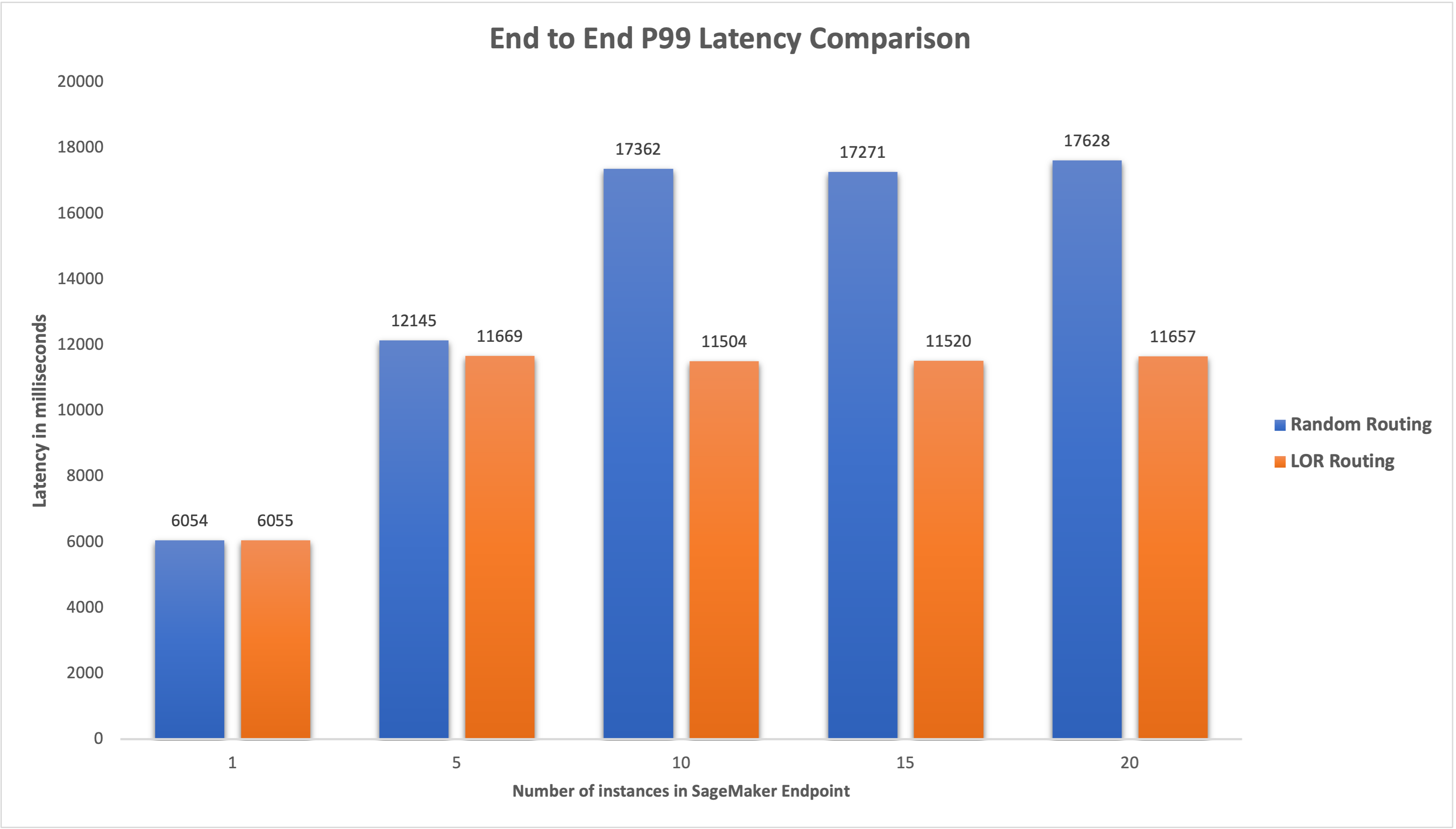

Mõõtsime mõlema lõpp-punkti P99 latentsust ja täheldasime latentsusaja paranemist 4–33%, kui juhtude arvu suurendati 5-lt 20-le, nagu on näidatud järgmisel graafikul.

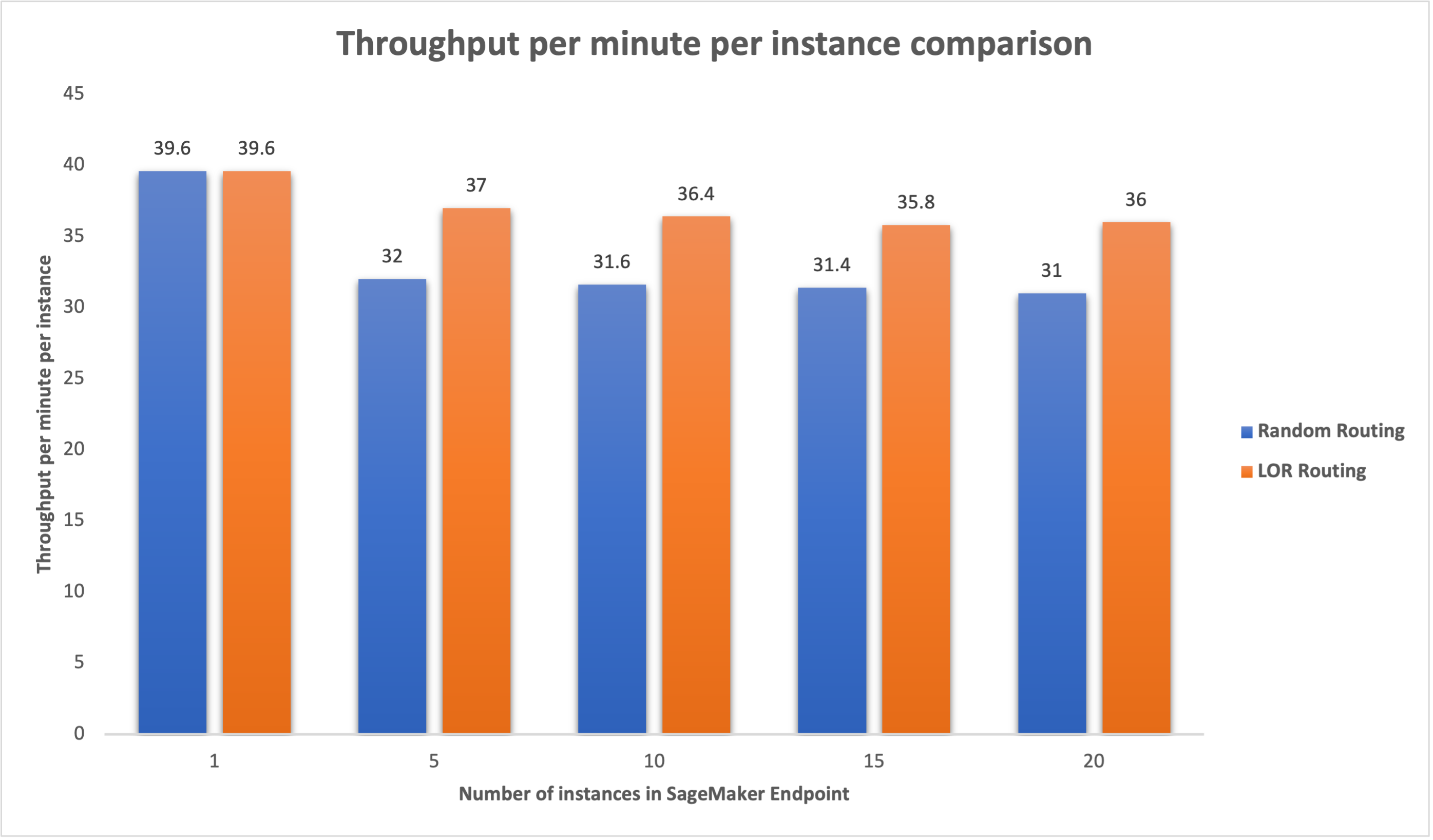

Samamoodi täheldasime läbilaskevõime 15–16% paranemist eksemplari kohta, kui eksemplaride arvu suurendati 5-lt 20-le.

See näitab, et nutikas marsruutimine on võimeline parandama liikluse jaotust lõpp-punktide vahel, mis toob kaasa otspunktide latentsuse ja üldise läbilaskevõime paranemise.

Järeldus

Selles postituses selgitasime SageMakeri marsruutimisstrateegiaid ja uut võimalust LOR-marsruutimise lubamiseks. Selgitasime, kuidas LOR-i lubada ja kuidas see teie mudeli juurutamisel kasuks saab. Meie jõudlustestid näitasid reaalajas järelduste tegemisel latentsusaja ja läbilaskevõime paranemist. SageMakeri marsruutimise funktsioonide kohta lisateabe saamiseks vaadake dokumentatsioon. Soovitame teil hinnata oma järelduste töökoormust ja teha kindlaks, kas olete marsruutimisstrateegiaga optimaalselt konfigureeritud.

Autoritest

Jamesi park on Amazon Web Servicesi lahenduste arhitekt. Ta teeb koostööd Amazon.com-iga, et kavandada, ehitada ja juurutada AWS-is tehnoloogilised lahendused ning ta on eriti huvitatud AI-st ja masinõppest. Vabal ajal meeldib talle otsida uusi kultuure, uusi kogemusi ja olla kursis uusimate tehnoloogiatrendidega. Leiad ta siit LinkedIn.

Jamesi park on Amazon Web Servicesi lahenduste arhitekt. Ta teeb koostööd Amazon.com-iga, et kavandada, ehitada ja juurutada AWS-is tehnoloogilised lahendused ning ta on eriti huvitatud AI-st ja masinõppest. Vabal ajal meeldib talle otsida uusi kultuure, uusi kogemusi ja olla kursis uusimate tehnoloogiatrendidega. Leiad ta siit LinkedIn.

Venugopal pai on AWS-i lahenduste arhitekt. Ta elab Indias Bengalurus ja aitab digitaalse päritoluga klientidel oma rakendusi AWS-is skaleerida ja optimeerida.

Venugopal pai on AWS-i lahenduste arhitekt. Ta elab Indias Bengalurus ja aitab digitaalse päritoluga klientidel oma rakendusi AWS-is skaleerida ja optimeerida.

David Nigenda on Amazon SageMakeri meeskonna tarkvaraarenduse vaneminsener, kes töötab praegu tootmismasinõppe töövoogude täiustamise ja uute järeldusfunktsioonide käivitamise kallal. Vabal ajal püüab ta oma lastega sammu pidada.

David Nigenda on Amazon SageMakeri meeskonna tarkvaraarenduse vaneminsener, kes töötab praegu tootmismasinõppe töövoogude täiustamise ja uute järeldusfunktsioonide käivitamise kallal. Vabal ajal püüab ta oma lastega sammu pidada.

Sügav Ragha on Amazon SageMakeri meeskonna tarkvaraarenduse insener. Tema praegune töö keskendub masinõppemudelite tõhusaks hostimiseks funktsioonide loomisele. Vabal ajal naudib ta reisimist, matkamist ja taimede kasvatamist.

Sügav Ragha on Amazon SageMakeri meeskonna tarkvaraarenduse insener. Tema praegune töö keskendub masinõppemudelite tõhusaks hostimiseks funktsioonide loomisele. Vabal ajal naudib ta reisimist, matkamist ja taimede kasvatamist.

Alan Tan on SageMakeri vanem tootejuht, kes juhib jõupingutusi suurte mudelite järelduste tegemisel. Ta on kirglik masinõppe rakendamisest analüütika valdkonnas. Väljaspool tööd naudib ta õues olemist.

Alan Tan on SageMakeri vanem tootejuht, kes juhib jõupingutusi suurte mudelite järelduste tegemisel. Ta on kirglik masinõppe rakendamisest analüütika valdkonnas. Väljaspool tööd naudib ta õues olemist.

Dhawal Patel on AWS-i peamine masinõppearhitekt. Ta on töötanud hajutatud andmetöötluse ja tehisintellektiga seotud probleemide lahendamisel organisatsioonidega alates suurettevõtetest kuni keskmise suurusega idufirmadeni. Ta keskendub süvaõppele, sealhulgas NLP ja Computer Vision domeenidele. Ta aitab klientidel teha SageMakeris suure jõudlusega mudeli järeldusi.

Dhawal Patel on AWS-i peamine masinõppearhitekt. Ta on töötanud hajutatud andmetöötluse ja tehisintellektiga seotud probleemide lahendamisel organisatsioonidega alates suurettevõtetest kuni keskmise suurusega idufirmadeni. Ta keskendub süvaõppele, sealhulgas NLP ja Computer Vision domeenidele. Ta aitab klientidel teha SageMakeris suure jõudlusega mudeli järeldusi.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- PlatoTervis. Biotehnoloogia ja kliiniliste uuringute luureandmed. Juurdepääs siia.

- Allikas: https://aws.amazon.com/blogs/machine-learning/minimize-real-time-inference-latency-by-using-amazon-sagemaker-routing-strategies/

- :on

- :on

- :mitte

- : kus

- $ UP

- 1

- 100

- 125

- 150

- 17

- 1870

- 20

- 7

- 9

- a

- Võimalik

- MEIST

- kiirendid

- Saavutada

- üle

- AI

- AI mudelid

- Alan

- algoritm

- võimaldab

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- vahel

- an

- analüüs

- analytics

- ja

- API

- rakendused

- Rakendades

- OLEME

- PIIRKOND

- kunstlik

- tehisintellekti

- AS

- At

- auto

- kättesaadavus

- AWS

- Saldo

- tasakaalustamine

- BE

- taga

- kuulub

- võrdlusuuringud

- kasu

- Kasu

- BEST

- mõlemad

- lai

- ehitama

- Ehitus

- koormus

- kuid

- by

- Kutsub

- CAN

- Võimsus

- juhtudel

- kindel

- muutma

- Vaidluste lahendamine

- kliendid

- kood

- COM

- tulevad

- komponendid

- arvuti

- Arvuti visioon

- arvutustehnika

- konkurent

- konfiguratsioon

- konfigureeritud

- tasu

- arvestades

- koosneb

- kulud

- loomine

- Praegune

- Praegu

- Kliendid

- kuupäev

- sügav

- sügav õpe

- vaikimisi

- juurutada

- lähetatud

- kasutuselevõtu

- kasutuselevõtt

- Disain

- Määrama

- & Tarkvaraarendus

- erinev

- arutama

- jagatud

- hajutatud arvutus

- jaotus

- Domeenid

- ajal

- dünaamiliselt

- iga

- tõhusalt

- tõhusalt

- jõupingutusi

- võimaldama

- lubatud

- julgustama

- Lõpuks-lõpuni

- Lõpp-punkt

- insener

- Inglise

- ettevõtete

- hindama

- näide

- Kogemused

- selgitas

- äärmiselt

- pere

- FUNKTSIOONID

- Lõpuks

- leidma

- keskendub

- Järel

- eest

- alus

- Alates

- täielikult

- Üldine

- genereerib

- generatiivne

- Generatiivne AI

- gif

- antud

- graafik

- Kasvavad

- Olema

- he

- aitab

- siin

- Suur

- teda

- tema

- võõrustaja

- võõrustas

- Kuidas

- Kuidas

- HTML

- HTTPS

- sajad

- identifitseerima

- if

- illustreerib

- parandama

- paranemine

- parandusi

- Paranemist

- in

- Kaasa arvatud

- Sissetulev

- kasvanud

- India

- Näiteks

- Intelligentsus

- interaktiivne

- huvi

- sisse

- IT

- ITS

- jpg

- hoidma

- lapsed

- keel

- suur

- Suured ettevõtted

- Hilinemine

- hiljemalt

- käivitamine

- juhtivate

- Õppida

- õppimine

- kõige vähem

- Elab

- koormus

- Partii

- vähendada

- masin

- masinõpe

- TEEB

- juhtima

- juhitud

- juht

- viis

- mai..

- mõõtma

- mehhanism

- millisekundit

- minut

- protokoll

- ML

- mudel

- mudelid

- järelevalve

- rohkem

- mitmekordne

- Uus

- nlp

- ei

- nüüd

- number

- of

- Pakkumised

- sageli

- on

- töökorras

- optimeerima

- valik

- or

- organisatsioonid

- meie

- välja

- väljas

- väljaspool

- tasumata

- üle

- üldine

- parameeter

- eriline

- kirglik

- kohta

- jõudlus

- Taimed

- Platon

- Platoni andmete intelligentsus

- PlatoData

- poliitika

- võimalik

- post

- esitada

- Peamine

- probleeme

- Toode

- tootejuht

- Produktsioon

- küsib

- juhuslik

- alates

- pigem

- reaalajas

- saama

- soovitama

- Lühendatud

- viitama

- Sõltumata sellest

- seotud

- taotleda

- Taotlusi

- vastus

- vastuste

- Marsruut

- Marsruutimine

- jooks

- salveitegija

- Skaala

- otsib

- valik

- vanem

- teenima

- teenus

- Teenused

- komplekt

- kehtestamine

- ta

- näitas

- näidatud

- Näitused

- nutikas

- tarkvara

- tarkvaraarenduse

- Lahendused

- Pinge

- Alustavatel

- viibides

- lihtne

- strateegiad

- Strateegia

- selline

- Toetatud

- Toetab

- süsteemid

- tabel

- võtmine

- rääkima

- meeskond

- Tehnoloogia

- test

- testid

- kui

- et

- .

- Piirkond

- oma

- Seal.

- Need

- see

- läbilaskevõime

- aeg

- et

- liiklus

- Reisimine

- Trends

- liigid

- Kasutajad

- kasutamine

- Väärtused

- muutuja

- väga

- nägemus

- we

- web

- veebiteenused

- Hästi

- olid

- millal

- mis

- kuigi

- will

- koos

- Töö

- töötas

- Töövoogud

- töö

- töötab

- sa

- Sinu

- sephyrnet

- tsoonid