Andmeteaduse ja andmetehnika meeskonnad veedavad olulise osa oma ajast masinõppe (ML) elutsükli andmete ettevalmistamise etapis, tehes andmete valimise, puhastamise ja teisendamise etappe. See on iga ML-i töövoo vajalik ja oluline samm, et luua sisukaid teadmisi ja ennustusi, sest halvad või madala kvaliteediga andmed vähendavad oluliselt saadud arusaamade asjakohasust.

Andmetehnoloogia meeskonnad vastutavad traditsiooniliselt töötlemata andmete sissevõtmise, konsolideerimise ja teisendamise eest järgnevaks tarbimiseks. Andmeteadlased peavad sageli tegema täiendavat andmete töötlemist domeenispetsiifiliste ML kasutusjuhtude jaoks, nagu loomulik keel ja aegread. Näiteks võivad teatud ML-algoritmid olla tundlikud puuduvate väärtuste, väheste funktsioonide või kõrvalekallete suhtes ning nõuda erilist tähelepanu. Isegi juhtudel, kui andmestik on heas korras, võivad andmeteadlased soovida funktsioonide jaotusi muuta või uusi funktsioone luua, et mudelitest saadavat teavet maksimaalselt kasutada. Nende eesmärkide saavutamiseks peavad andmeteadlased toetuma andmetöötlusmeeskondadele, et kohandada nõutud muudatusi, mille tulemuseks on sõltuvus ja viivitus mudeli arendusprotsessis. Teise võimalusena võivad andmeteaduse meeskonnad teha andmete ettevalmistamise ja funktsioonide projekteerimise sisemiselt, kasutades erinevaid programmeerimisparadigmasid. See nõuab aga aja ja jõupingutusi teekide ja raamistike installimiseks ja konfigureerimiseks, mis pole ideaalne, kuna seda aega saab paremini kulutada mudeli jõudluse optimeerimiseks.

Amazon SageMaker Data Wrangler lihtsustab andmete ettevalmistamise ja funktsioonide kavandamise protsessi, vähendades ML jaoks andmete koondamiseks ja ettevalmistamiseks kuluvat aega nädalatest minutiteni, pakkudes andmeteadlastele ühtset visuaalset liidest, et valida, puhastada ja uurida oma andmekogumeid. Data Wrangler pakub üle 300 sisseehitatud andmete teisenduse, mis aitavad normaliseerida, teisendada ja kombineerida funktsioone ilma koodi kirjutamata. Saate importida andmeid mitmest andmeallikast, nt Amazon Simple Storage Service (Amazon S3), Amazonase Athena, Amazoni punane niheja Lumehelves. Nüüd saate ka kasutada Andmebaasid Data Wrangleri andmeallikana andmete hõlpsaks ettevalmistamiseks ML-i jaoks.

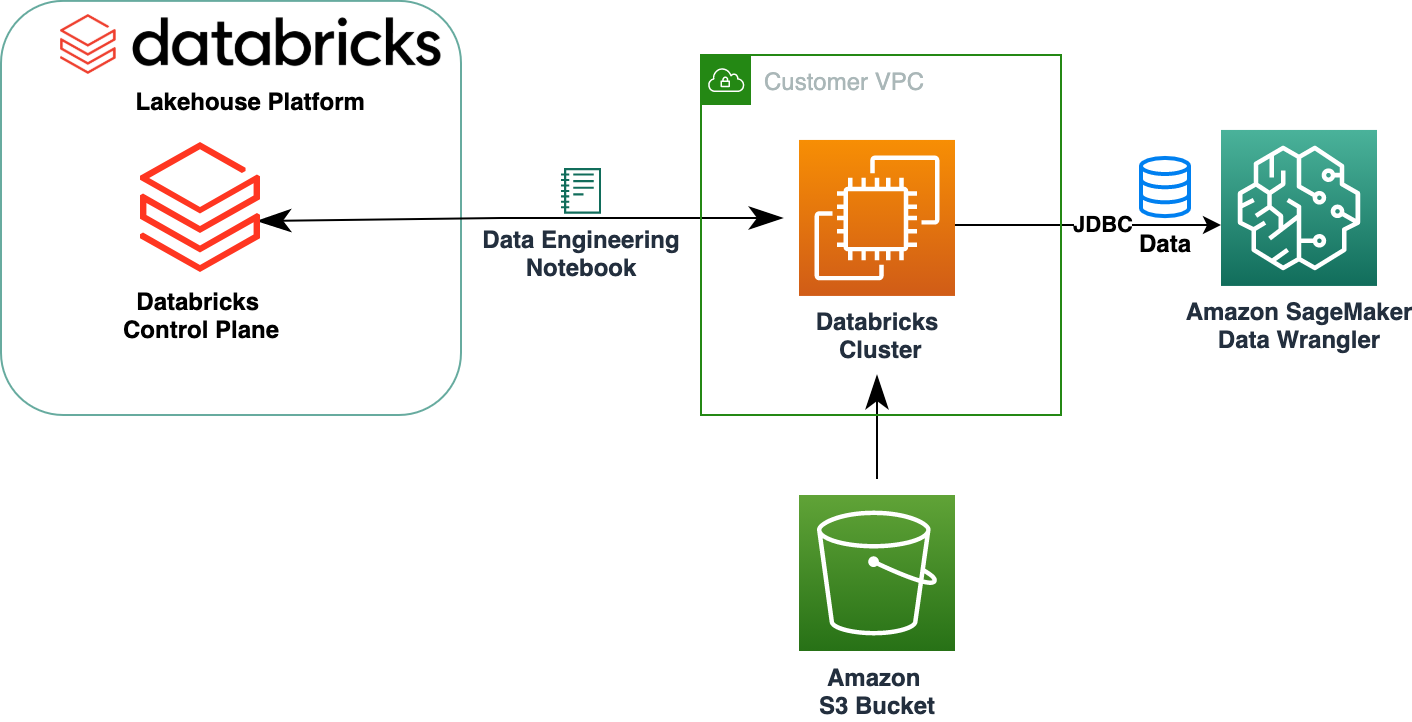

Databricks Lakehouse Platform ühendab andmejärvede ja andmeladude parimad elemendid, et pakkuda andmeladude usaldusväärsust, tugevat juhtimist ja jõudlust koos andmejärvede avatuse, paindlikkuse ja masinõppe toega. Kui Databricks on Data Wrangleri andmeallikas, saate nüüd kiiresti ja hõlpsalt ühenduda Databricksiga, interaktiivselt teha päringuid Databricksis salvestatud andmetest SQL-i abil ja vaadata andmeid enne importimist. Lisaks saate ühendada oma andmed Databricksis Amazon S3-sse salvestatud andmete ja Amazon Athena, Amazon Redshifti ja Snowflake'i kaudu päritavate andmetega, et luua oma ML-i kasutusjuhtumi jaoks õige andmestik.

Selles postituses muudame laenuklubi laenuandmestiku, kasutades Amazon SageMaker Data Wranglerit, et kasutada seda ML-mudeli koolituses.

Lahenduse ülevaade

Järgmine diagramm illustreerib meie lahenduse arhitektuuri.

Laenuklubi laenuandmekogum sisaldab täielikke laenuandmeid kõigi aastatel 2007–2011 välja antud laenude kohta, sealhulgas laenu hetkeseisu ja viimast makseteavet. Sellel on 39,717 22 rida, 3 funktsioonide veergu ja XNUMX sihtmärgist.

Andmete Data Wrangleri abil teisendamiseks teeme järgmised kõrgetasemelised sammud.

- Laadige alla ja jagage andmestik.

- Looge Data Wrangleri voog.

- Importige andmed Databricksist Data Wranglerisse.

- Importige andmed Amazon S3-st Data Wranglerisse.

- Ühendage andmed.

- Rakenda teisendusi.

- Eksportige andmestik.

Eeldused

Postitus eeldab, et teil on töötav Databricksi klaster. Kui teie klaster töötab AWS-is, kontrollige, kas teil on konfigureeritud järgmine.

Andmeplokkide seadistamine

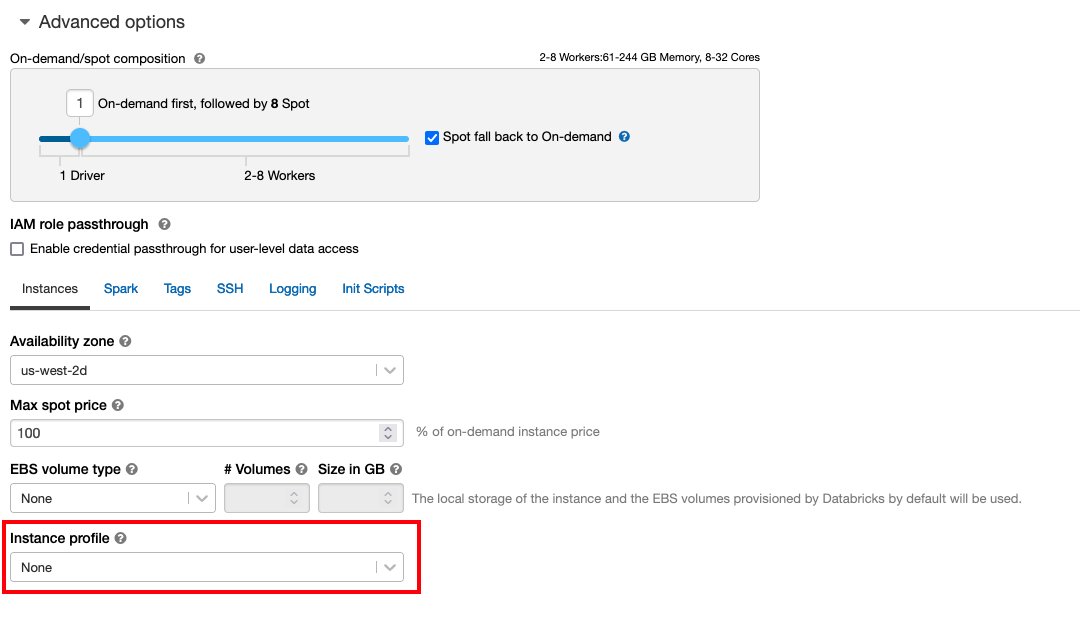

- An eksemplari profiil nõutavate õigustega, et pääseda juurde S3 ämbrile

- A ämbripoliitika nõutavate õigustega siht-S3 ämbri jaoks

järgima Turvaline juurdepääs S3 ämbritele eksemplariprofiilide abil nõutava jaoks AWS-i identiteedi- ja juurdepääsuhaldus (IAM) rollid, S3 ämbripoliitika ja Databricksi klastri konfiguratsioon. Veenduge, et Databricksi klaster on konfigureeritud õigega Instance Profile, mis on valitud täpsemate valikute alt, et pääseda juurde soovitud S3 ämbrile.

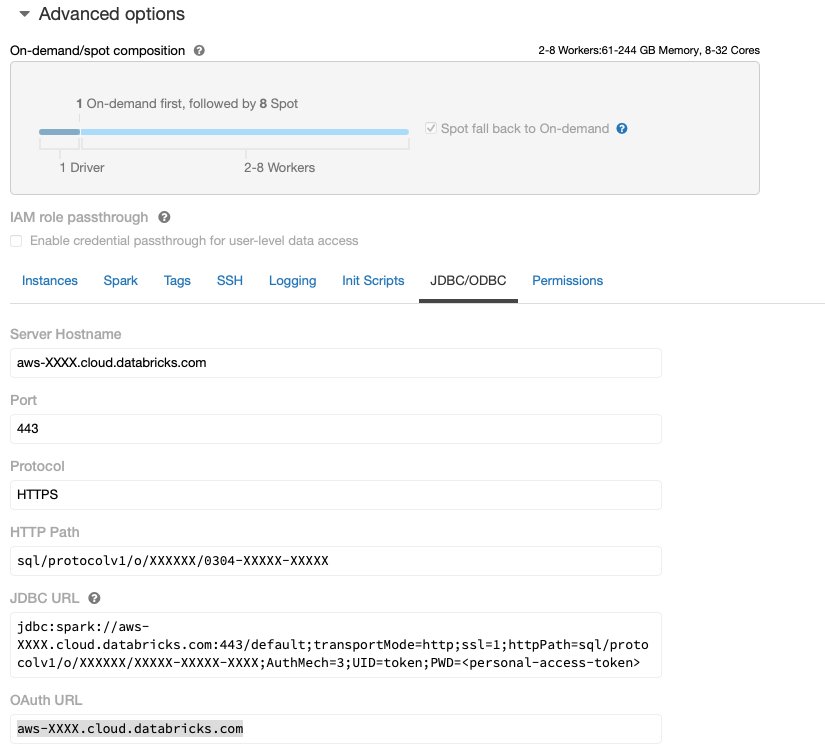

Pärast seda, kui Databricksi klaster on käivitatud ja töötab vajaliku juurdepääsuga Amazon S3-le, saate hankida JDBC URL teie Databricksi klastrist, et seda saaks Data Wrangler sellega ühenduse loomiseks kasutada.

Hankige JDBC URL

JDBC URL-i toomiseks toimige järgmiselt.

- Navigeerige Databricksis klastrite kasutajaliidese juurde.

- Valige oma klaster.

- Kohta konfiguratsioon valige vahekaart Lisavalikud.

- alla Lisavalikud, Vali JDBC/ODBC Tab.

- Kopeerige JDBC URL.

Asendage kindlasti oma isiklik juurdepääs sümboolne URL-is.

Data Wrangleri seadistamine

See samm eeldab, et teil on juurdepääs Amazon SageMakeri eksemplarile Amazon SageMaker Studioja Studio kasutaja.

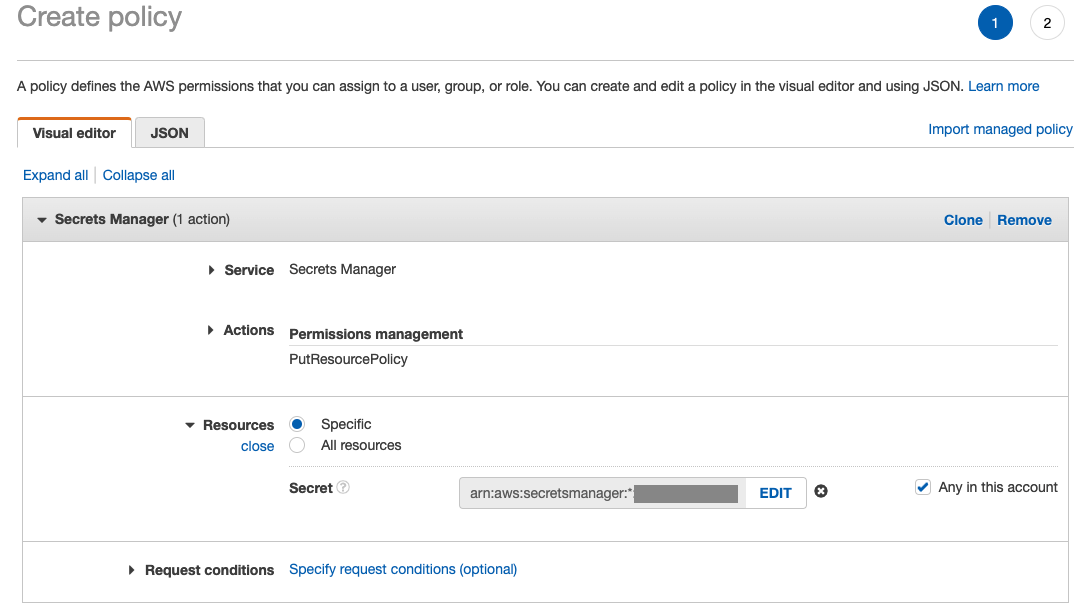

Data Wranglerilt Databricksi JDBC ühendusele juurdepääsu võimaldamiseks vajab Studio kasutaja järgmist luba:

secretsmanager:PutResourcePolicy

Ülaltoodud loaga Studio kasutajale IAM-i administraatorikasutajana määratud IAM-i täitmisrolli värskendamiseks järgige allolevaid samme.

- Valige IAM-konsoolil rollid navigeerimispaanil.

- Valige oma Studio kasutajale määratud roll.

- Vali Lisa õigused.

- Vali Loo tekstisisene poliitika.

- Teeninduse jaoks valige Saladuste haldur.

- On Meetmete, vali Juurdepääsutase.

- Vali Lubade haldamine.

- Vali PutResourcePolicy.

- eest Vahendid, vali Konkreetne ja valige Kõik sellel kontol.

Laadige alla ja jagage andmestik

Võite alustada andmestiku allalaadimine. Demonstreerimise eesmärgil jagasime andmestiku osadeks, kopeerides funktsioonide veerud id, emp_title, emp_length, home_ownerja annual_inc sekundi loomiseks laenud_2.csv faili. Eemaldame algsest laenufailist eelnimetatud veerud, välja arvatud id veerus ja nimetage algfail ümber laenud_1.csv. Laadige üles laenud_1.csv toimikule Andmebaasid tabeli loomiseks loans_1 ja laenud_2.csv S3 ämbris.

Looge Data Wrangleri voog

Teavet Data Wrangleri eeltingimuste kohta vt Alustage Data Wrangleriga.

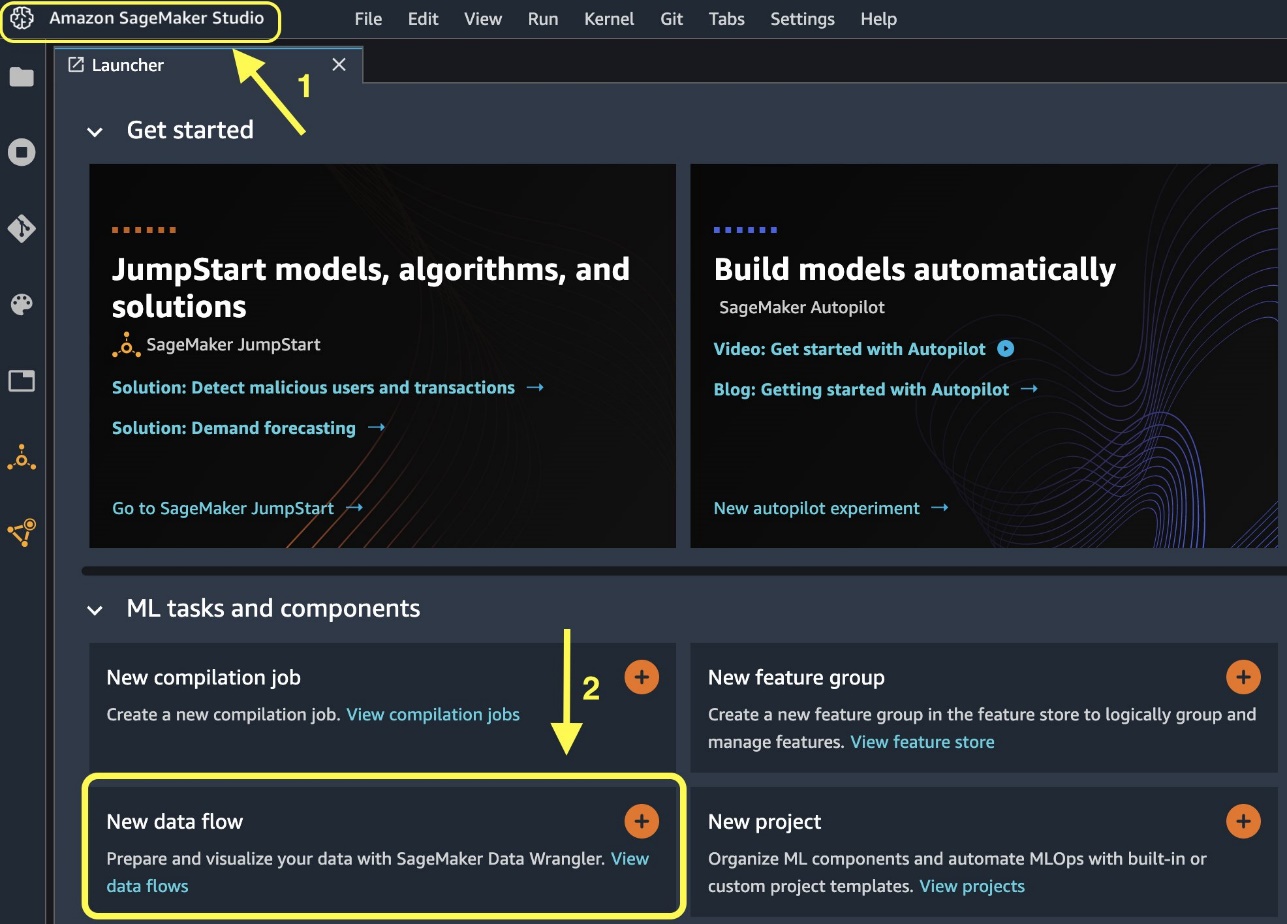

Alustame uue andmevoo loomisega.

- Studio konsoolil fail menüüst valige Uus.

- Vali Data Wrangleri voog.

- Nimetage voog vastavalt soovile ümber.

Teise võimalusena saate käivitajast luua uue andmevoo.

Uue voo loomine võib võtta mõne minuti. Pärast voo loomist näete Andmete importimine lehel.

Importige andmed Databricksist Data Wranglerisse

Järgmisena seadistasime Data Wrangleri andmeallikana Databricksi (JDBC). Databricksist andmete importimiseks peame esmalt lisama Databricksi andmeallikana.

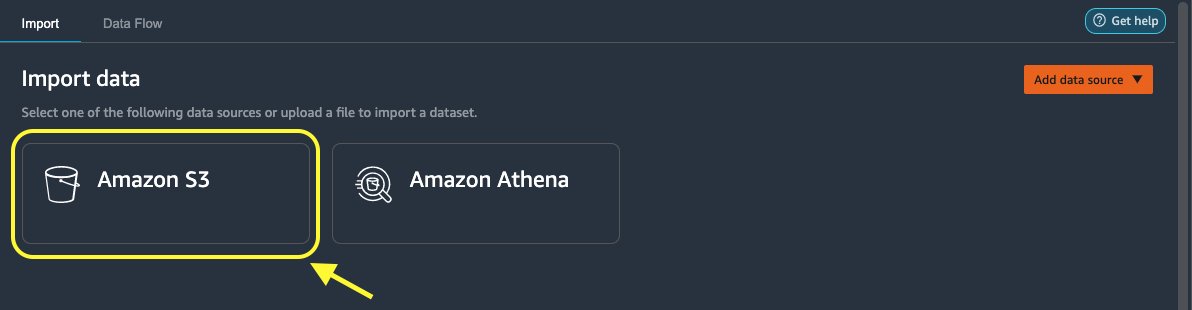

- Kohta Andmete importimine valige oma Data Wrangleri voo vahekaart Andmeallika lisamine.

- Valige rippmenüüst Databricks (JDBC).

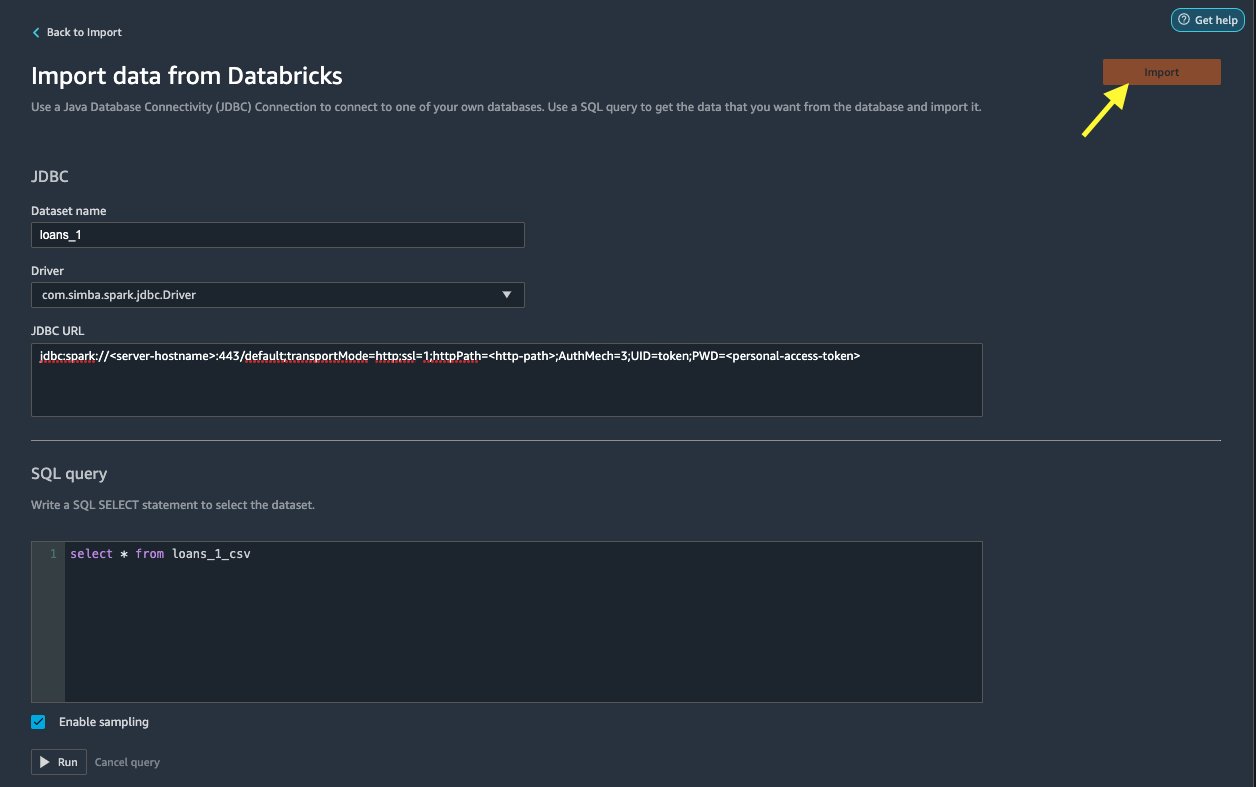

Kohta Andmete importimine Databricksist lehele, sisestate oma klastri üksikasjad.

- eest Andmestiku nimi, sisestage nimi, mida soovite voofailis kasutada.

- eest juht, valige draiver

com.simba.spark.jdbc.Driver. - eest JDBC URL, sisestage varem saadud Databricksi klastri URL.

URL peaks sarnanema järgmise vorminguga jdbc:spark://<serve- hostname>:443/default;transportMode=http;ssl=1;httpPath=<http- path>;AuthMech=3;UID=token;PWD=<personal-access-token>.

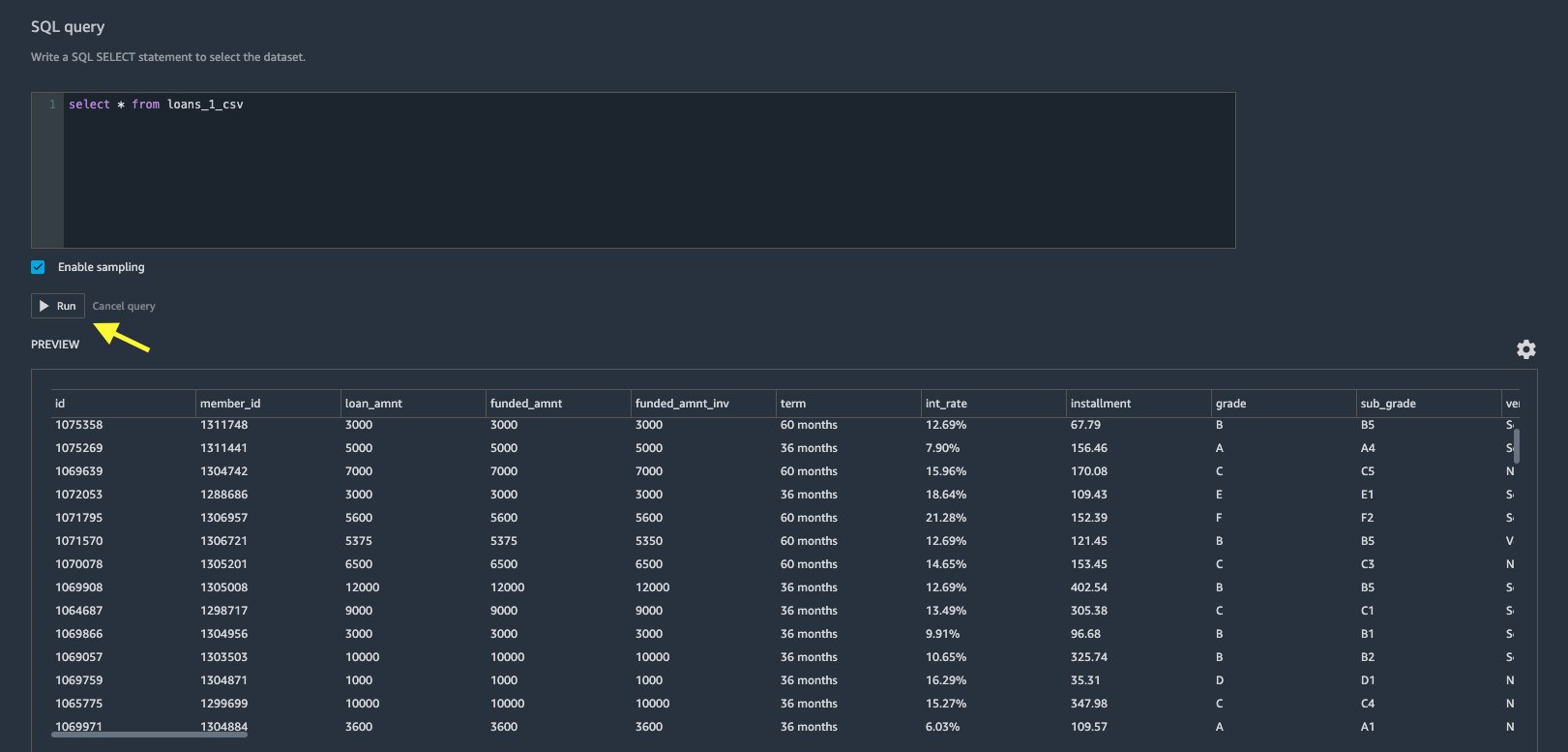

- Määrake SQL päringuredaktoris järgmine SQL SELECT-lause:

Kui valisite andmete Databricksi üleslaadimisel teise tabeli nime, asendage ülaltoodud SQL-päringus laenud_1 vastavalt.

aasta SQL päring Data Wrangleri jaotises saate teha päringuid mis tahes JDBC Databricksi andmebaasiga ühendatud tabelis. Eelvalitud Luba proovivõtt seade hangib vaikimisi teie andmestiku esimesed 50,000 XNUMX rida. Sõltuvalt andmestiku suurusest tühistatakse valik Luba proovivõtt võib importida pikemat aega.

- Vali jooks.

Päringu käitamine annab teie Databricksi andmestiku eelvaate otse rakenduses Data Wrangler.

Data Wrangler pakub paindlikkust mitme samaaegse ühenduse seadistamiseks ühe Databricksi klastri või vajaduse korral mitme klastriga, võimaldades kombineeritud andmekogumite analüüsi ja ettevalmistamist.

Importige andmed Amazon S3-st Data Wranglerisse

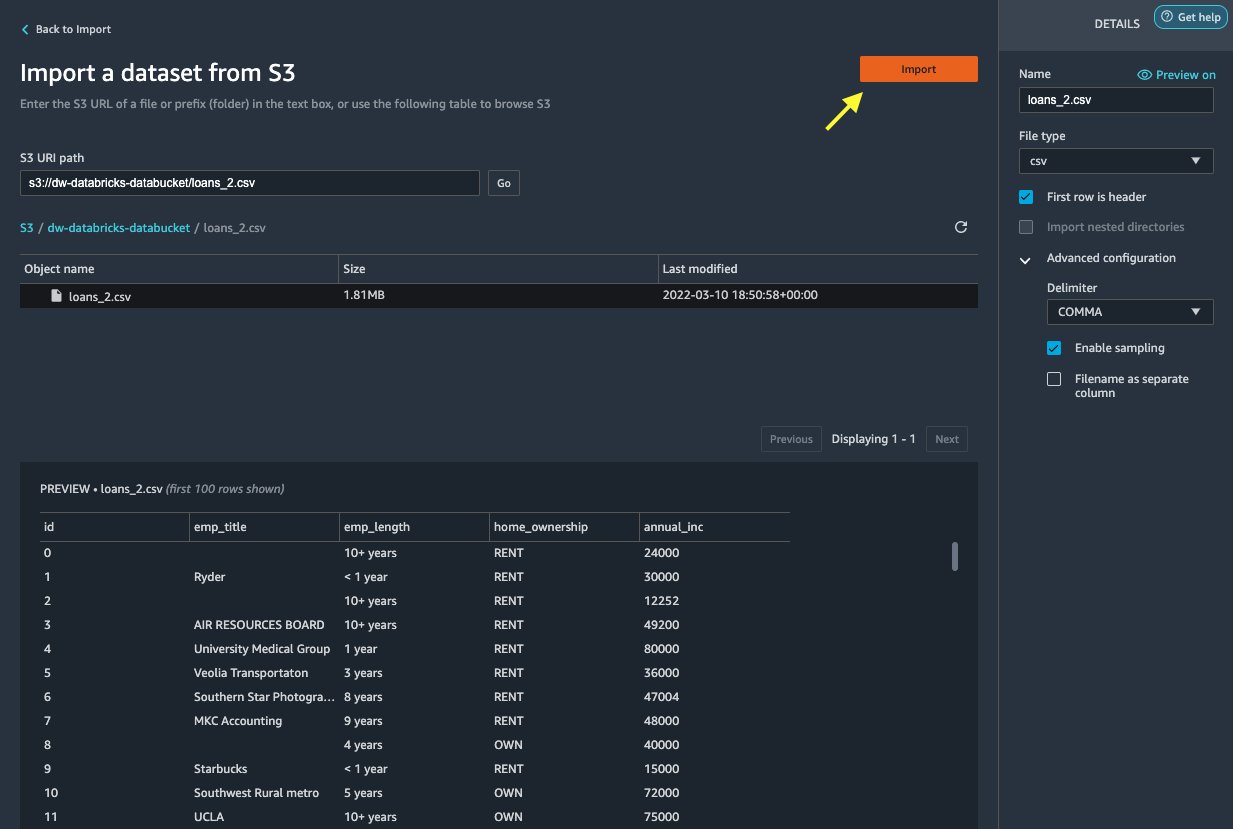

Järgmiseks impordime loan_2.csv fail Amazon S3-st.

Kui valite CSV-faili, saate andmete eelvaateid vaadata.

- aasta Detailid paneel, valige Täpsem konfiguratsioon veenduda Luba proovivõtt on valitud ja LÕIGE jaoks on valitud Eraldaja.

- Vali Import.

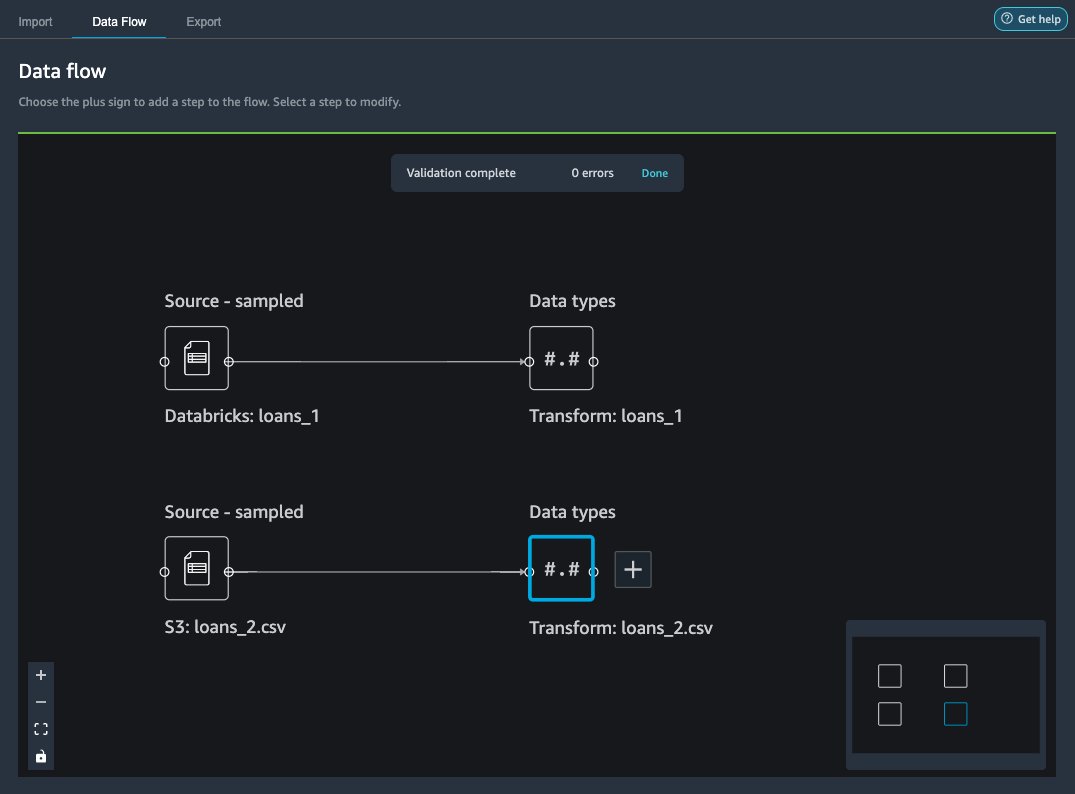

Pärast loans_2.csv andmekogum on edukalt imporditud, kuvab andmevoo liides nii Databricks JDBC kui ka Amazon S3 andmeallikad.

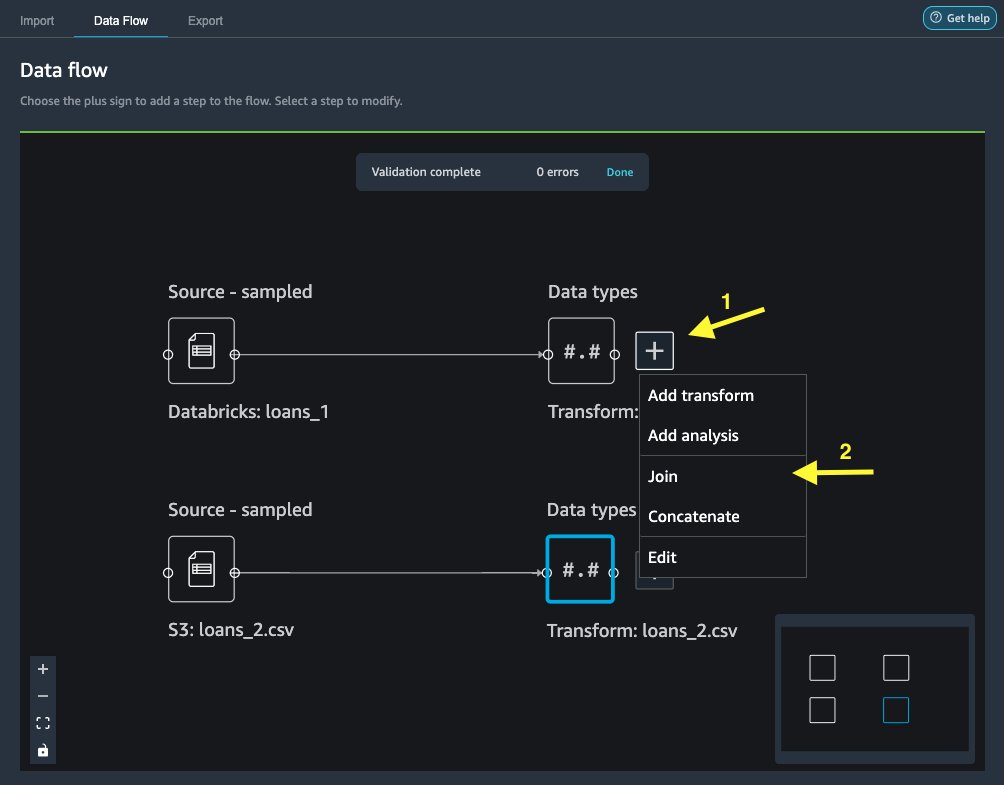

Ühendage andmed

Nüüd, kui oleme Databricksist ja Amazon S3-st andmed importinud, ühendame andmekogumid ühise kordumatu identifikaatori veeru abil.

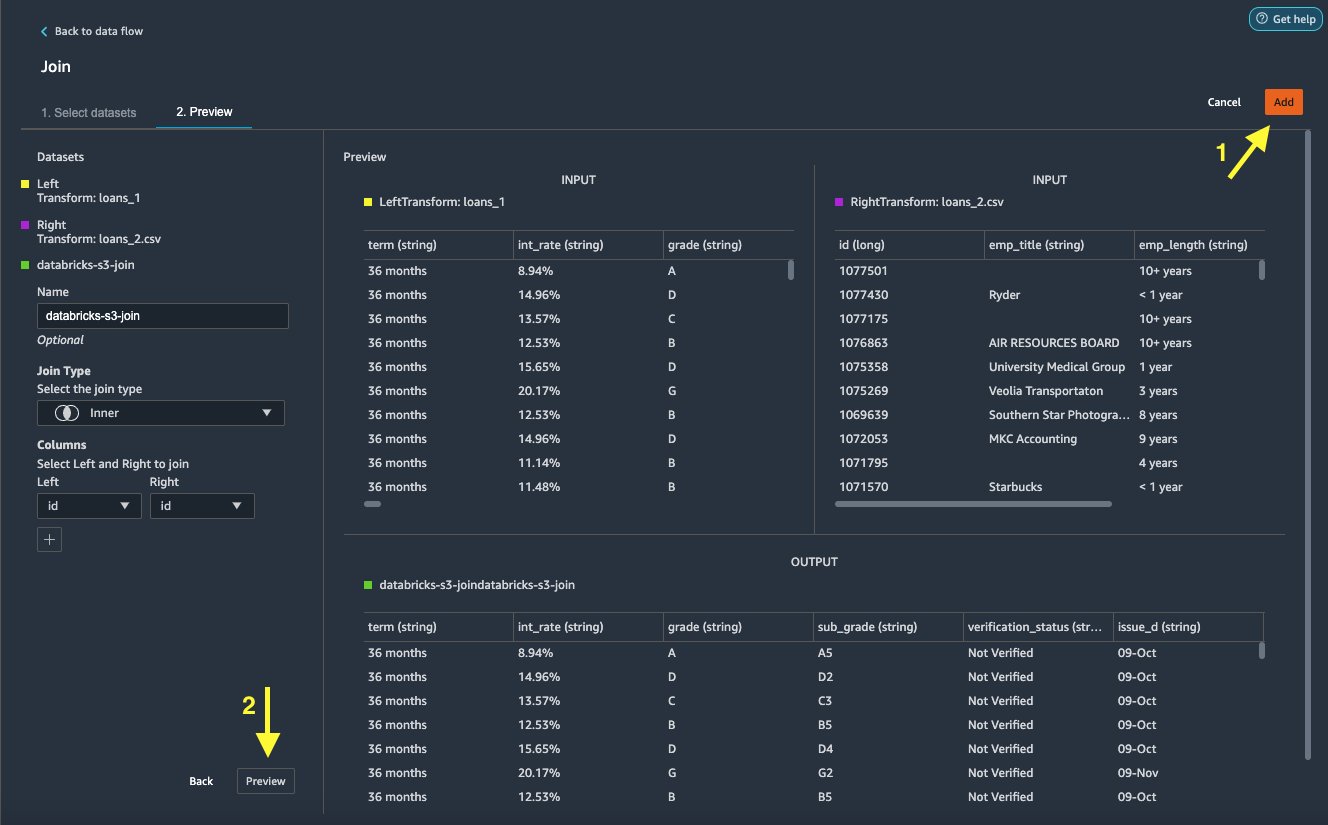

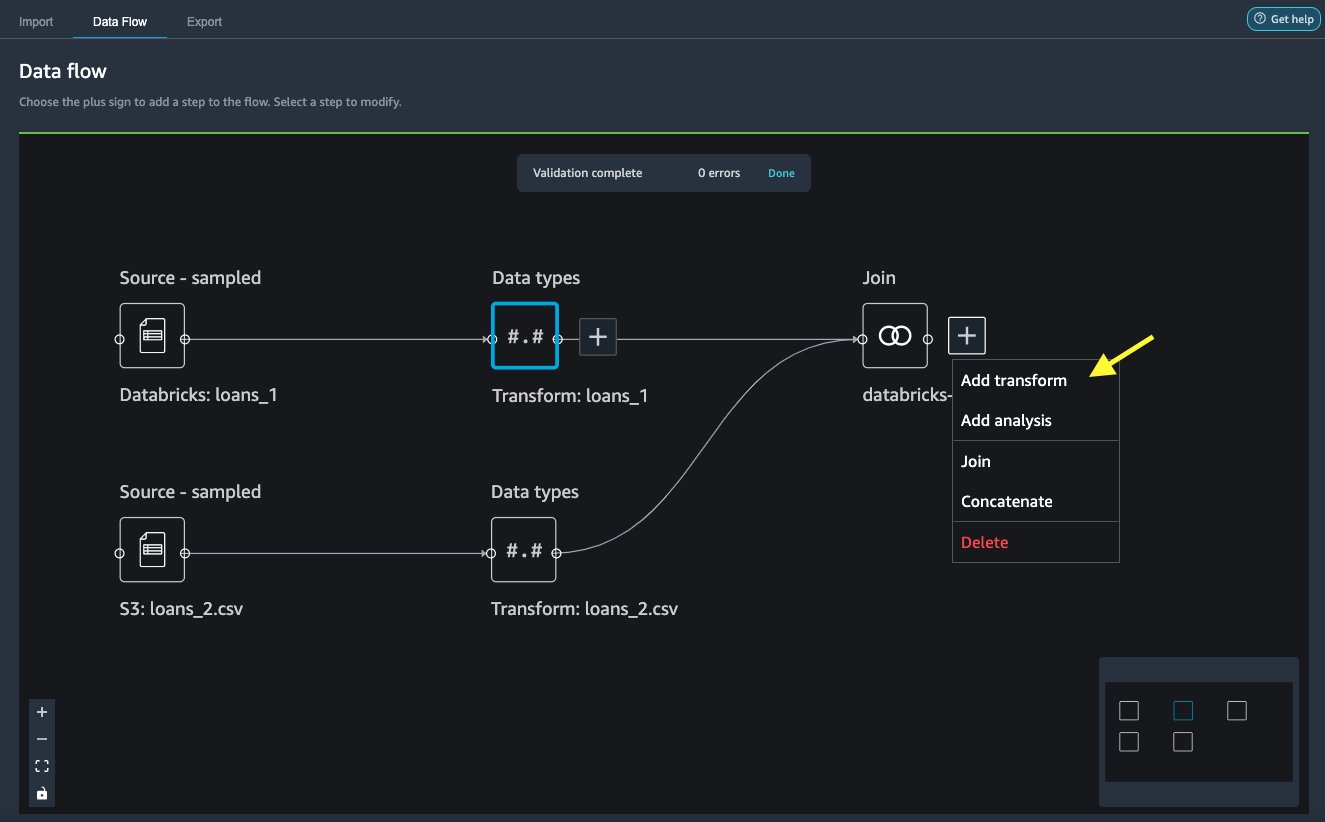

- Kohta Andmevoog vahekaart, jaoks Andmetüübid, valige plussmärk

loans_1. - Vali Liitu.

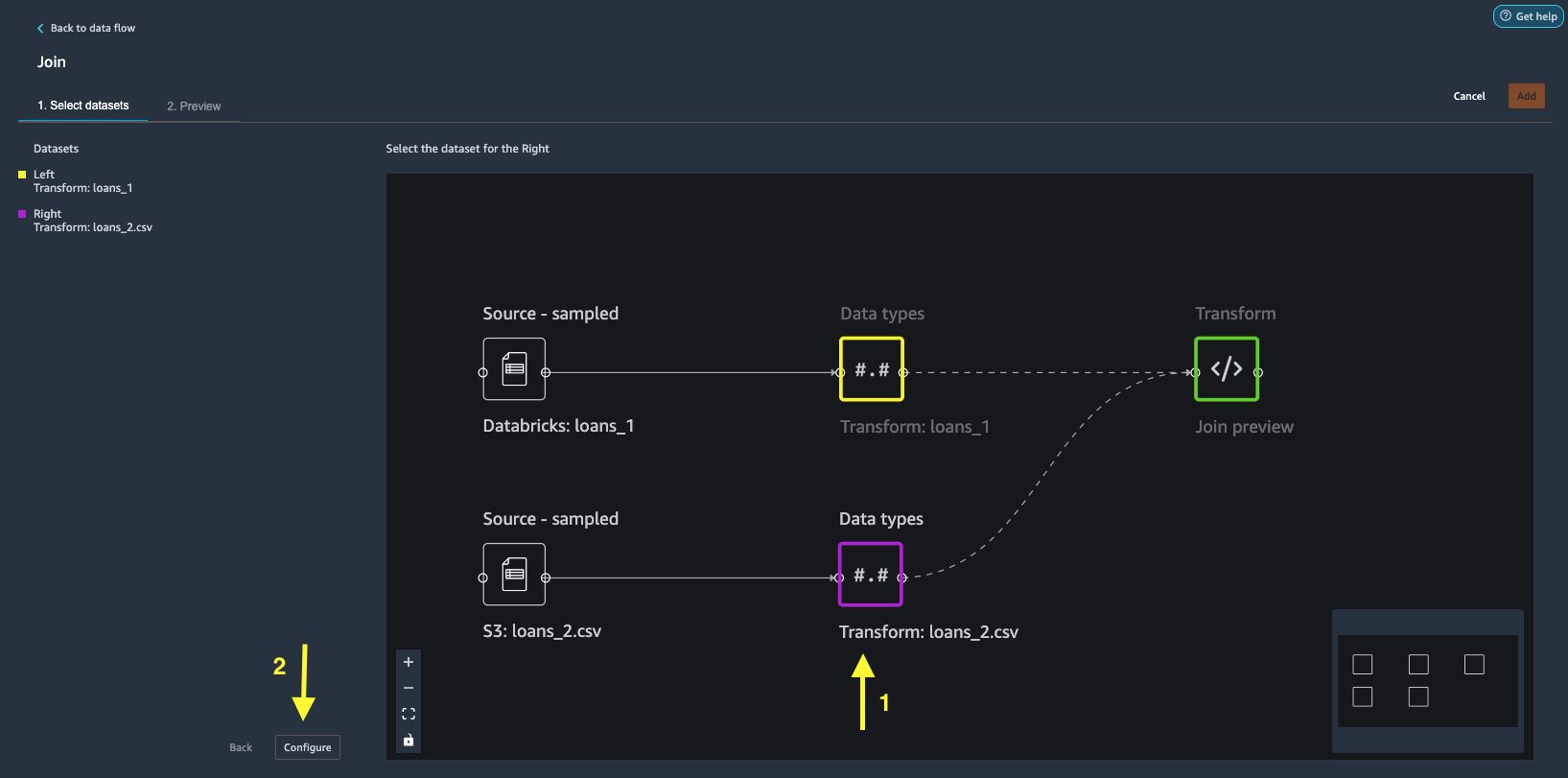

- Vali

loans_2.csvfail kui Õigus andmestik. - Vali Seadistamine liitumiskriteeriumide seadistamiseks.

- eest Nimi, sisestage liitumise nimi.

- eest Liitumise tüüp, vali Sisemine selle postituse jaoks.

- Vali

idveerus, millega liituda. - Vali kehtima ühendatud andmestiku eelvaate kuvamiseks.

- Vali lisama et see andmevoogu lisada.

Rakenda teisendusi

Data Wrangler sisaldab üle 300 sisseehitatud teisenduse, mis ei vaja kodeerimist. Kasutame andmestiku ettevalmistamiseks sisseehitatud teisendusi.

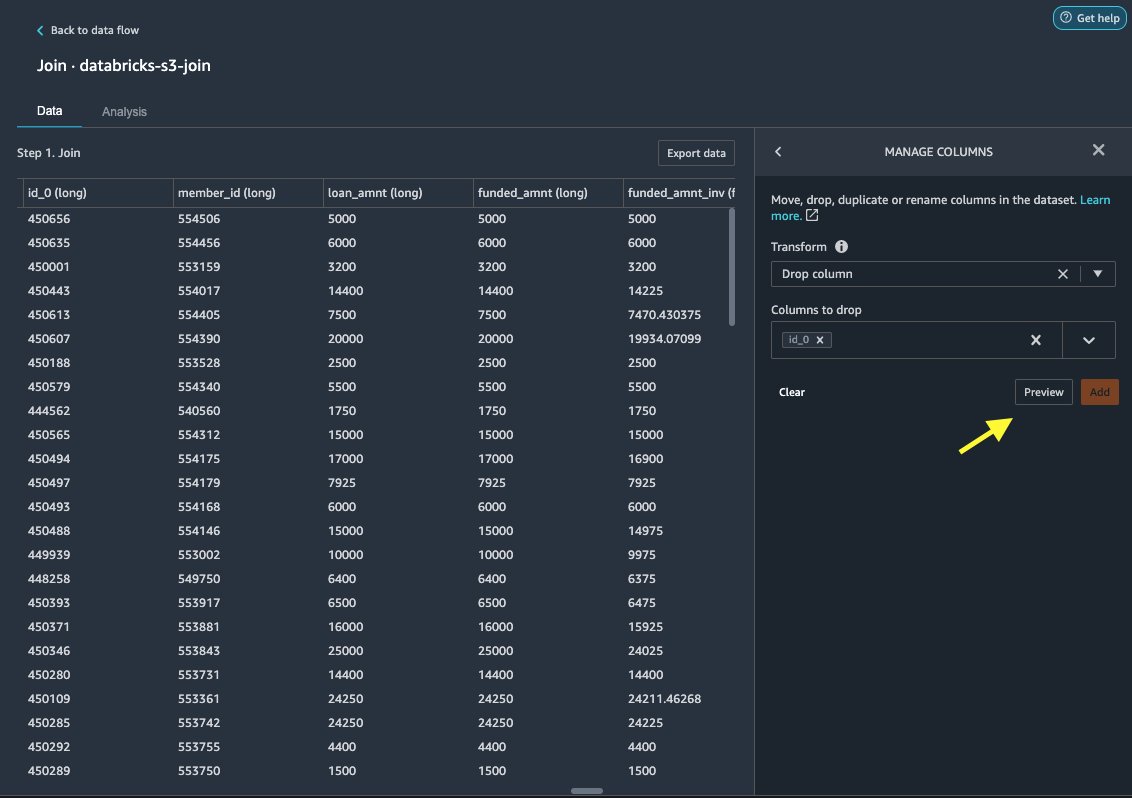

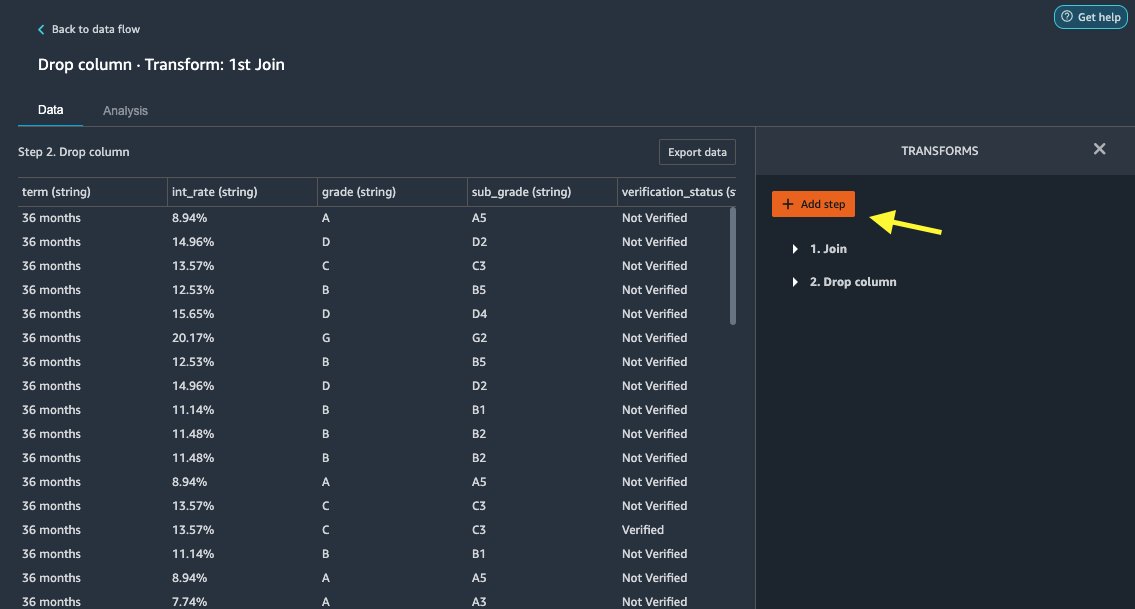

Langetage veerg

Esmalt loobume üleliigse ID veerust.

- Valige ühendatud sõlmel plussmärk.

- Vali Lisa teisendus.

- alla Muudab, valima + Lisa samm.

- Vali Veergude haldamine.

- eest Muutma, vali Langetage veerg.

- eest Veerud kukutamiseks, valige veerg

id_0. - Vali Eelvaade.

- Vali lisama.

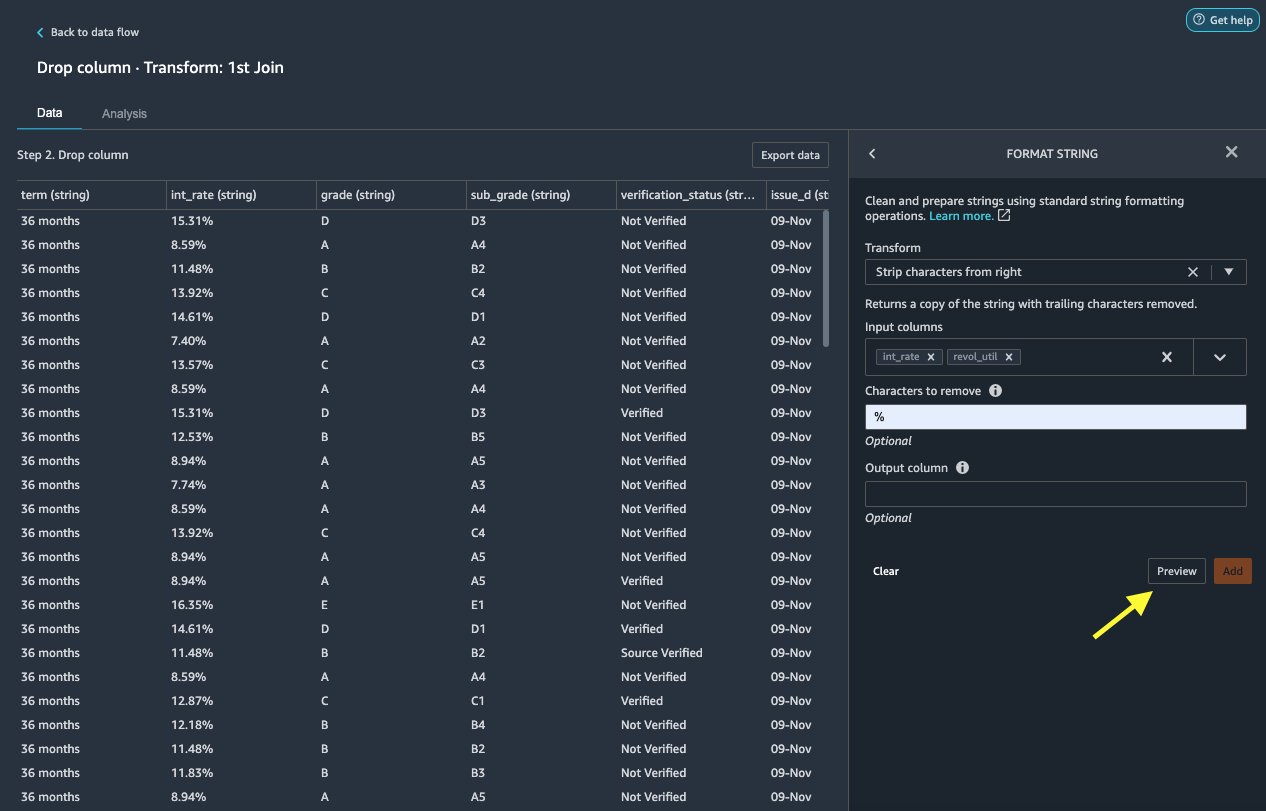

Vorminda string

Rakendame stringi vormingut, et eemaldada protsendisümbol int_rate ja revol_util veerud.

- Kohta kuupäev sakk, all Transformeerub, vali + Lisa samm.

- Vali Vorminda string.

- eest Muutma, vali Eemaldage tähemärgid paremalt.

Data Wrangler võimaldab teil rakendada valitud teisendust mitmele veerule korraga.

- eest Sisestusveerud, vali

int_ratejarevol_util. - eest Eemaldatavad märgid, sisenema

%. - Vali Eelvaade.

- Vali lisama.

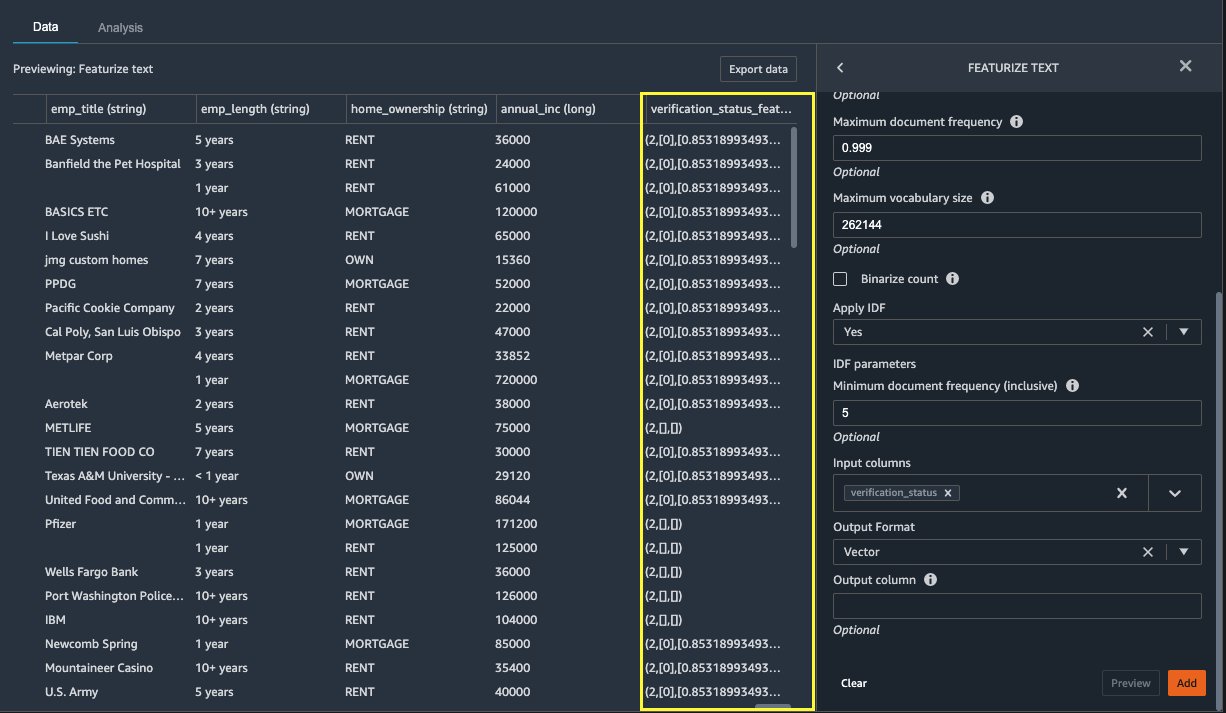

Teksti esiletõstmine

Nüüd vektoriseerime verification_status, tekstifunktsiooni veerg. Teisendame tekstiveeru terminisageduse ja dokumendi pöördsageduse (TF-IDF) vektoriteks, rakendades allpool kirjeldatud loendusvektorit ja standardset tokenisaatorit. Data Wrangler pakub soovi korral ka võimalust kaasa võtta oma tokeniseerija.

- alla Transformers, vali + Lisa samm.

- Vali Teksti esiletõstmine.

- eest Muutma, vali Vektoriseerida.

- eest Sisestusveerud, vali

verification_status. - Vali Eelvaade.

- Vali lisama.

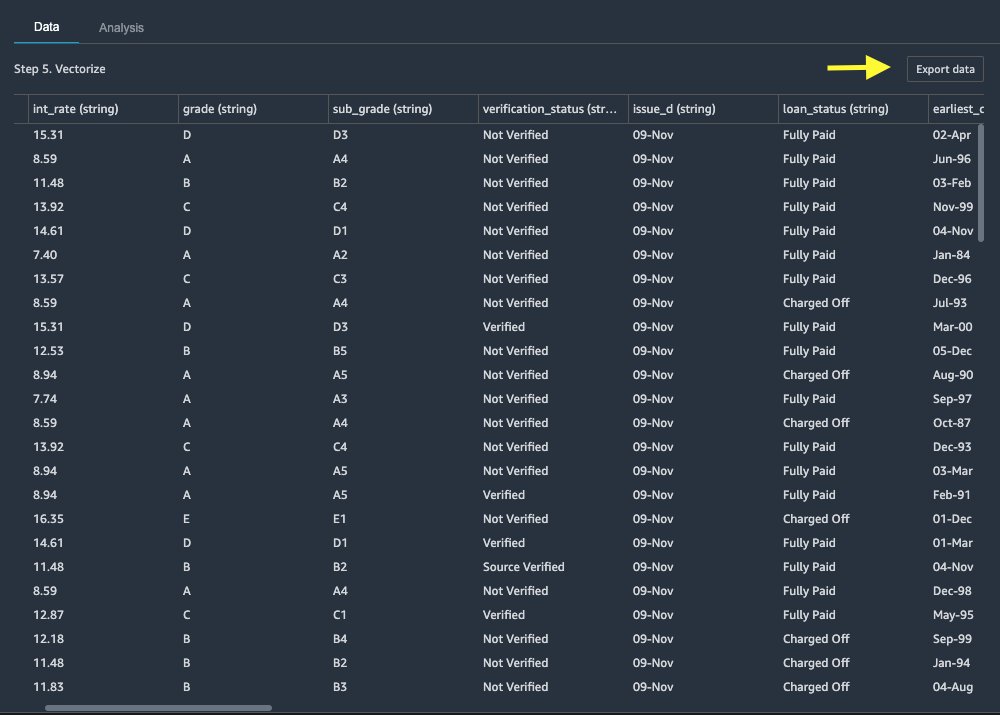

Eksportige andmestik

Pärast mitmete teisenduste rakendamist eri tüüpi veergudele, sealhulgas teksti-, kategoorilistele ja numbrilistele veergudele, oleme valmis kasutama teisendatud andmestikku ML-mudeli koolituseks. Viimane samm on teisendatud andmestiku eksportimine Amazon S3-sse. Data Wrangleris on teil teisenduste järgnevaks tarbimiseks valida mitme valiku vahel.

- Vali Ekspordi samm et automaatselt genereerida töötlemiseks SageMakeri töötlemiskoodiga Jupyteri sülearvuti ja eksportida teisendatud andmestik S3 ämbrisse. Lisateabe saamiseks vaadake Käivitage töötlemistööd mõne klõpsuga, kasutades Amazon SageMaker Data Wrangleri.

- Eksportige Studio märkmik, mis loob a SageMakeri torujuhe teie andmevooga või märkmikuga, mis loob Amazon SageMakeri funktsioonipood funktsioonide rühma ja lisab funktsioone võrguühenduseta või veebipõhisesse funktsioonipoodi.

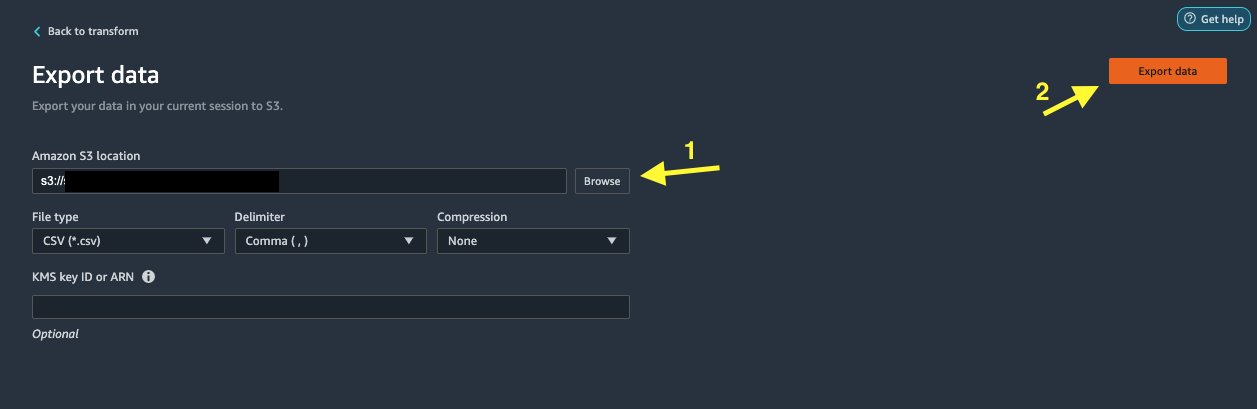

- Vali Andmete eksportimine eksportida otse Amazon S3-sse.

Selles postituses kasutame ära Andmete eksportimine valik Muutma vaade teisendatud andmestiku eksportimiseks otse Amazon S3-sse.

- Vali Andmete eksportimine.

- eest S3 asukoht, vali Sirvi ja valige oma S3 ämber.

- Vali Andmete eksportimine.

Koristage

Kui teie töö Data Wrangleriga on lõpetatud, sulgege oma Data Wrangleri eksemplar et vältida lisatasusid.

Järeldus

Selles postituses käsitlesime seda, kuidas saate Data Wrangleris Databricksi kiiresti ja lihtsalt andmeallikana seadistada ja ühendada, SQL-i abil interaktiivselt Databricksi salvestatud andmete päringuid teha ja enne importimist andmeid eelvaadata. Lisaks uurisime, kuidas saate oma andmed Databricksis ühendada Amazon S3 salvestatud andmetega. Seejärel rakendasime kombineeritud andmekogumis andmete teisendusi, et luua andmete ettevalmistamise konveier. Lisateavet Data Wrangleri analüüsivõimaluste, sealhulgas sihtlekke ja nihkearuande genereerimise kohta leiate järgmisest ajaveebi postitusest Kiirendage andmete ettevalmistamist, kasutades diabeedihaigete tagasivõtmise ennustamiseks rakendust Amazon SageMaker Data Wrangler.

Data Wrangleriga alustamiseks vaadake Valmistage ette ML-andmed rakendusega Amazon SageMaker Data Wranglerja vaadake uusimat teavet Data Wrangleri kohta Toote leht.

Autoritest

Roop Bains on AWS-i lahenduste arhitekt, kes keskendub AI/ML-ile. Ta on kirglik aidata klientidel tehisintellekti ja masinõppe abil uuendusi teha ja oma ärieesmärke saavutada. Vabal ajal meeldib Roopile lugeda ja matkata.

Roop Bains on AWS-i lahenduste arhitekt, kes keskendub AI/ML-ile. Ta on kirglik aidata klientidel tehisintellekti ja masinõppe abil uuendusi teha ja oma ärieesmärke saavutada. Vabal ajal meeldib Roopile lugeda ja matkata.

Igor Alekseev on AWS-i andmete ja analüüsi partnerlahenduste arhitekt. Igor teeb koostööd strateegiliste partneritega, aidates neil ehitada keerulisi AWS-i jaoks optimeeritud arhitektuure. Enne AWS-iga liitumist rakendas ta andmete/lahenduste arhitektina paljusid suurandmete projekte, sealhulgas mitut Hadoopi ökosüsteemi andmejärve. Andmeinsenerina oli ta seotud AI/ML rakendamisega pettuste tuvastamisel ja kontori automatiseerimisel. Igori projektid olid seotud erinevates tööstusharudes, sealhulgas side, rahandus, avalik turvalisus, tootmine ja tervishoid. Varem töötas Igor täisinsenerina/tehnilise juhina.

Igor Alekseev on AWS-i andmete ja analüüsi partnerlahenduste arhitekt. Igor teeb koostööd strateegiliste partneritega, aidates neil ehitada keerulisi AWS-i jaoks optimeeritud arhitektuure. Enne AWS-iga liitumist rakendas ta andmete/lahenduste arhitektina paljusid suurandmete projekte, sealhulgas mitut Hadoopi ökosüsteemi andmejärve. Andmeinsenerina oli ta seotud AI/ML rakendamisega pettuste tuvastamisel ja kontori automatiseerimisel. Igori projektid olid seotud erinevates tööstusharudes, sealhulgas side, rahandus, avalik turvalisus, tootmine ja tervishoid. Varem töötas Igor täisinsenerina/tehnilise juhina.

Huong Nguyen on AWS-i vanem tootejuht. Ta juhib SageMaker Studio kasutajakogemust. Tal on 13-aastane kogemus klientidega seotud ja andmepõhiste toodete loomisel nii ettevõtetele kui ka tarbijatele. Vabal ajal meeldib talle lugeda, looduses viibida ja perega aega veeta.

Huong Nguyen on AWS-i vanem tootejuht. Ta juhib SageMaker Studio kasutajakogemust. Tal on 13-aastane kogemus klientidega seotud ja andmepõhiste toodete loomisel nii ettevõtetele kui ka tarbijatele. Vabal ajal meeldib talle lugeda, looduses viibida ja perega aega veeta.

Henry Wang on AWS-i tarkvaraarenduse insener. Ta liitus hiljuti Data Wrangleri meeskonnaga pärast UC Davise lõpetamist. Ta tunneb huvi andmeteaduse ja masinõppe vastu ning tegeleb hobi korras 3D-printimisega.

Henry Wang on AWS-i tarkvaraarenduse insener. Ta liitus hiljuti Data Wrangleri meeskonnaga pärast UC Davise lõpetamist. Ta tunneb huvi andmeteaduse ja masinõppe vastu ning tegeleb hobi korras 3D-printimisega.

- Münditark. Euroopa parim Bitcoini ja krüptobörs.

- Platoblockchain. Web3 metaversiooni intelligentsus. Täiustatud teadmised. TASUTA PÄÄS.

- CryptoHawk. Altcoini radar. Tasuta prooviversioon.

- Allikas: https://aws.amazon.com/blogs/machine-learning/prepare-data-from-databricks-for-machine-learning-using-amazon-sagemaker-data-wrangler/

- "

- 000

- 100

- 39

- 3d

- MEIST

- juurdepääs

- majutada

- Täiendavad lisad

- edasijõudnud

- ADEelis

- algoritme

- Materjal: BPA ja flataatide vaba plastik

- Amazon

- analüüs

- analytics

- Rakendades

- arhitektuur

- kunstlik

- tehisintellekti

- Tehisintellekt ja masinõpe

- määratud

- Automaatika

- AWS

- on

- BEST

- Big andmed

- Blogi

- piir

- ehitama

- sisseehitatud

- äri

- võimeid

- juhtudel

- Vali

- puhastamine

- klubi

- kood

- Kodeerimine

- Veerg

- kombineeritud

- ühine

- Side

- keeruline

- konfiguratsioon

- seotud

- ühendus

- Side

- tasu

- konsool

- konsolideerimine

- tarbija

- tarbimine

- sisaldab

- loodud

- loob

- loomine

- Praegune

- Kliendid

- andmed

- andmeteadus

- andmebaas

- viivitus

- Olenevalt

- Detection

- & Tarkvaraarendus

- erinev

- otse

- Näidikute

- alla

- juht

- Drop

- kergesti

- ökosüsteemi

- toimetaja

- võimaldama

- võimaldades

- insener

- Inseneriteadus

- sisene

- ettevõte

- näide

- Välja arvatud

- täitmine

- kogemus

- uurima

- pere

- tunnusjoon

- FUNKTSIOONID

- Tasud

- rahastama

- esimene

- Paindlikkus

- voog

- Järel

- formaat

- pettus

- täis

- tekitama

- põlvkond

- hea

- valitsemistava

- Grupp

- tervishoid

- aitama

- Kuidas

- HTTPS

- Identity

- rakendatud

- oluline

- importivate

- Kaasa arvatud

- tööstusharudes

- info

- teadmisi

- Intelligentsus

- huvi

- Interface

- investeering

- seotud

- IT

- Tööturg

- liituma

- liitunud

- Labels

- keel

- hiljemalt

- viima

- juhtivate

- õppimine

- laenud

- Laenud

- Vaatasin

- masin

- masinõpe

- juht

- tootmine

- ML

- mudel

- mudelid

- rohkem

- mitmekordne

- Natural

- loodus

- NAVIGATSIOON

- Uued funktsioonid

- märkmik

- Pakkumised

- offline

- Internetis

- valik

- Valikud

- et

- enda

- partner

- partnerid

- kirglik

- makse

- protsent

- jõudlus

- isiklik

- faas

- inimesele

- poliitika

- Ennustused

- Eelvaade

- protsess

- Toode

- Toodet

- Programming

- projektid

- annab

- pakkudes

- avalik

- eesmärkidel

- kiiresti

- Töötlemata

- Lugemine

- vähendamine

- aru

- nõudma

- nõutav

- vastutav

- jooksmine

- ohutus

- teadus

- teadlased

- väljavalitud

- Seeria

- teenus

- komplekt

- kehtestamine

- märkimisväärne

- lihtne

- SUURUS

- tarkvara

- tarkvaraarenduse

- lahendus

- Lahendused

- tühikud

- kulutama

- Kulutused

- jagada

- Kestab

- standard

- algus

- alustatud

- väljavõte

- olek

- ladustamine

- salvestada

- Strateegiline

- tugev

- stuudio

- Edukalt

- toetama

- sihtmärk

- meeskond

- Läbi

- aeg

- koolitus

- Muutma

- Transformation

- ui

- ainulaadne

- Värskendused

- kasutama

- sort

- eri

- kuigi

- ilma

- Töö

- töötas

- töötab

- kirjutamine