Sissejuhatus

Masinõppes on eelarvamuse ja dispersiooni kompromiss põhikontseptsioon, mis mõjutab mis tahes ennustava mudeli toimivust. See viitab õrnale tasakaalule mudeli kallutatuse ja dispersioonivea vahel, kuna mõlemat on võimatu samaaegselt minimeerida. Õige tasakaalu leidmine on mudeli optimaalse jõudluse saavutamiseks ülioluline.

Selles lühikeses artiklis määratleme kallutatuse ja dispersiooni, selgitame, kuidas need masinõppe mudelit mõjutavad, ja anname praktilisi nõuandeid, kuidas nendega praktikas toime tulla.

Eelarvamuste ja dispersiooni mõistmine

Enne eelarvamuste ja dispersiooni vaheliste seoste käsitlemist määratleme, mida need terminid masinõppes esindavad.

Nihkeviga viitab erinevusele mudeli ennustuse ja õigete väärtuste vahel, mida see ennustada üritab (põhitõde). Teisisõnu, kallutatus on viga, mille mudel teeb selle aluseks olevate andmete jaotuse kohta tehtud valede eelduste tõttu. Kõrge kallutatusega mudelid on sageli liiga lihtsustatud, ei suuda tabada andmete keerukust, mis põhjustab alasobivust.

Dispersiooniviga seevastu viitab mudeli tundlikkusele treeningandmete väikeste kõikumiste suhtes. Suure dispersiooniga mudelid on liiga keerulised ja kalduvad sobima andmete müraga, mitte aluseks oleva mustriga, mis põhjustab ülepaigutamist. Selle tulemuseks on halb jõudlus uute, nähtamatute andmete puhul.

Suur kallutatus võib viia alasobitamiseni, kus mudel on andmete keerukuse jäädvustamiseks liiga lihtne. See teeb andmete kohta tugevaid eeldusi ega suuda tabada sisend- ja väljundmuutujate vahelist tõelist seost. Teisest küljest võib suur dispersioon põhjustada ülepaigutamist, kus mudel on liiga keeruline ja õpib pigem andmete müra kui sisend- ja väljundmuutujate vahelise seose. Seega kipuvad ülepaigutavad mudelid treeningandmeid liiga tihedalt sobitama ja ei üldista hästi uuteks andmeteks, samas kui alasobivad mudelid ei suuda isegi treeningandmeid täpselt sobitada.

Nagu varem mainitud, on kallutatus ja dispersioon omavahel seotud ning hea mudel tasakaalustab nihkevea ja dispersioonivea vahel. Eelarvamuse ja dispersiooni kompromiss on nende kahe veaallika vahelise optimaalse tasakaalu leidmise protsess. Madala kalde ja väikese dispersiooniga mudel toimib tõenäoliselt hästi nii koolituse kui ka uute andmete puhul, minimeerides koguvea.

Kallutatuse ja variatsiooni kompromiss

Tasakaalu saavutamine mudeli keerukuse ja selle võime vahel üldistada tundmatutele andmetele on eelarvamuse ja dispersiooni kompromissi tuum. Üldiselt on keerulisemal mudelil väiksem nihe, kuid suurem dispersioon, samas kui lihtsamal mudelil on suurem nihe, kuid väiksem dispersioon.

Kuna eelarvamusi ja dispersioone on võimatu samaaegselt minimeerida, on nende vahel optimaalse tasakaalu leidmine tugeva masinõppemudeli koostamisel ülioluline. Näiteks suurendades mudeli keerukust, suurendame ka dispersiooni. Selle põhjuseks on asjaolu, et keerulisem mudel mahutab tõenäolisemalt treeningandmete müra, mis toob kaasa ülepaigutamise.

Teisest küljest, kui jätame mudeli liiga lihtsaks, suurendame kallutatust. Selle põhjuseks on asjaolu, et lihtsam mudel ei suuda jäädvustada andmete aluseks olevaid seoseid, mis toob kaasa alasobivuse.

Eesmärk on treenida mudel, mis on piisavalt keeruline, et tabada treeningandmete aluseks olevaid seoseid, kuid mitte nii keeruline, et see sobiks treeningandmete müraga.

Kallutatuse-variatsiooni kompromiss praktikas

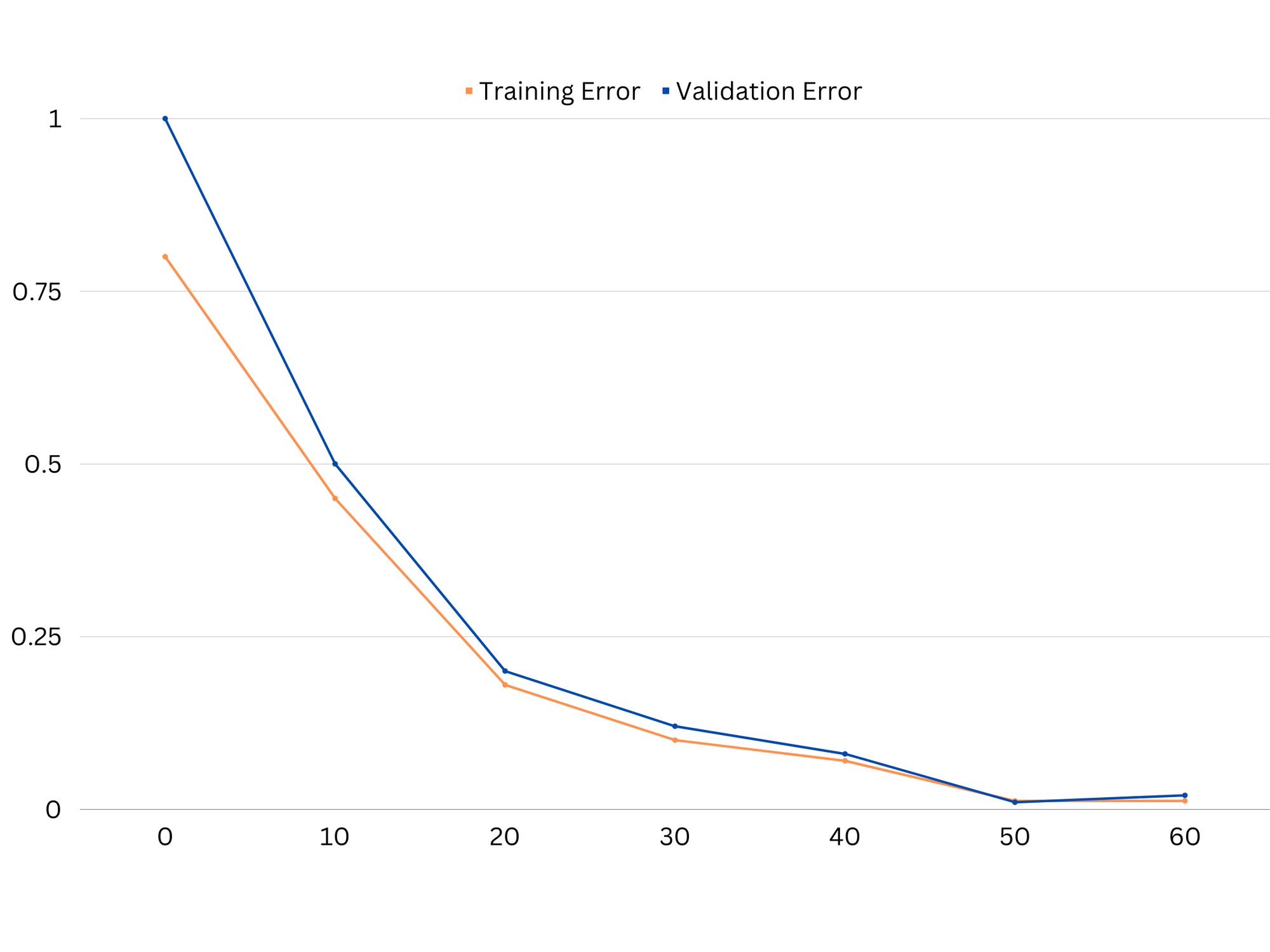

Mudeli toimivuse diagnoosimiseks arvutame ja võrdleme tavaliselt rongi- ja valideerimisvigu. Kasulik tööriist selle visualiseerimiseks on õppimiskõverate graafik, mis kuvab mudeli toimivust nii rongi kui ka valideerimisandmetel kogu koolitusprotsessi vältel. Neid kõveraid uurides saame kindlaks teha, kas mudel on ülesobiv (suur dispersioon), alasobiv (suur kallutatus) või hästisobiv (optimaalne tasakaal kõrvalekalde ja dispersiooni vahel).

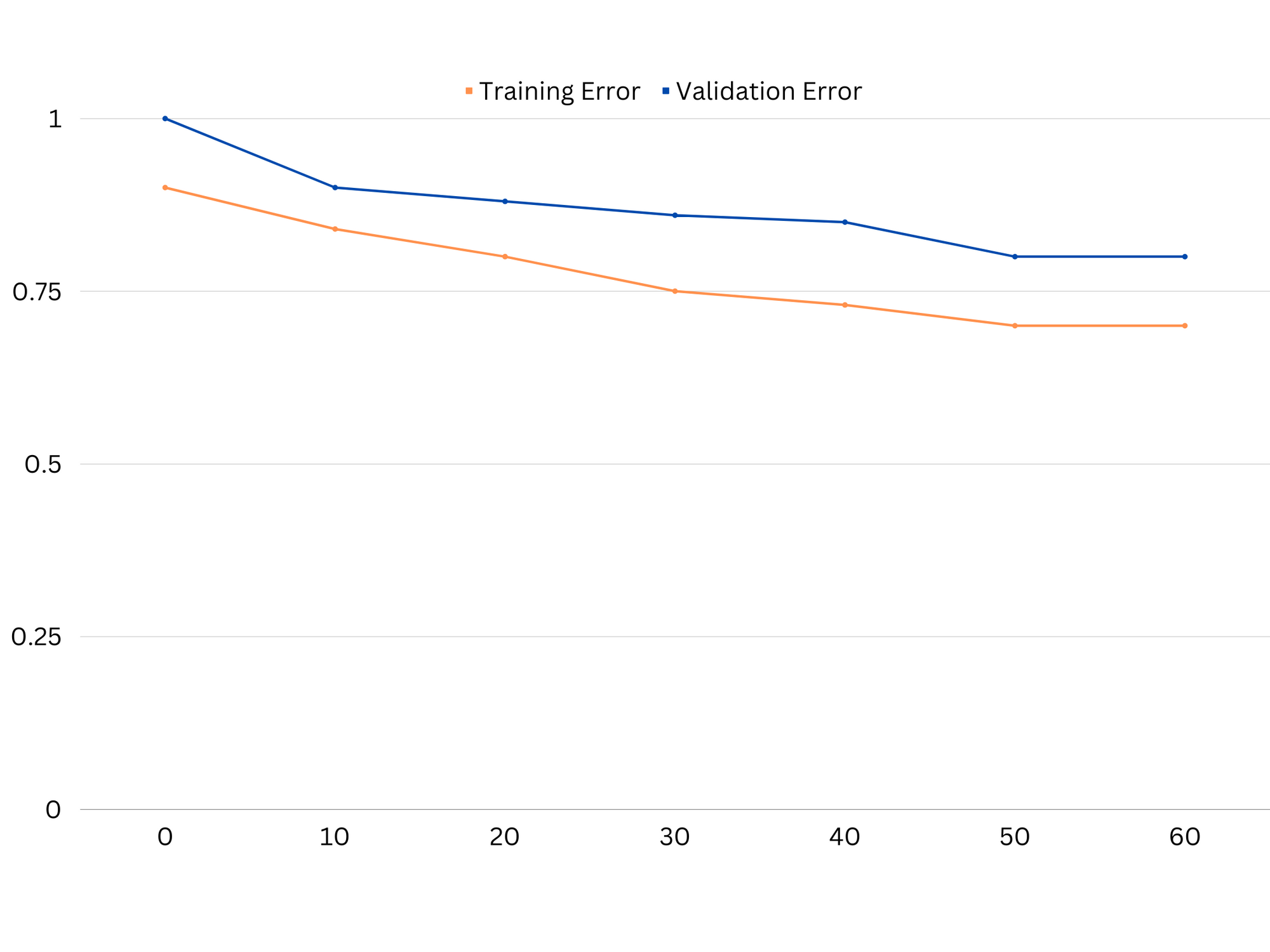

Näide alasobiva mudeli õppimiskõveratest. Nii rongi viga kui ka valideerimisviga on suured.

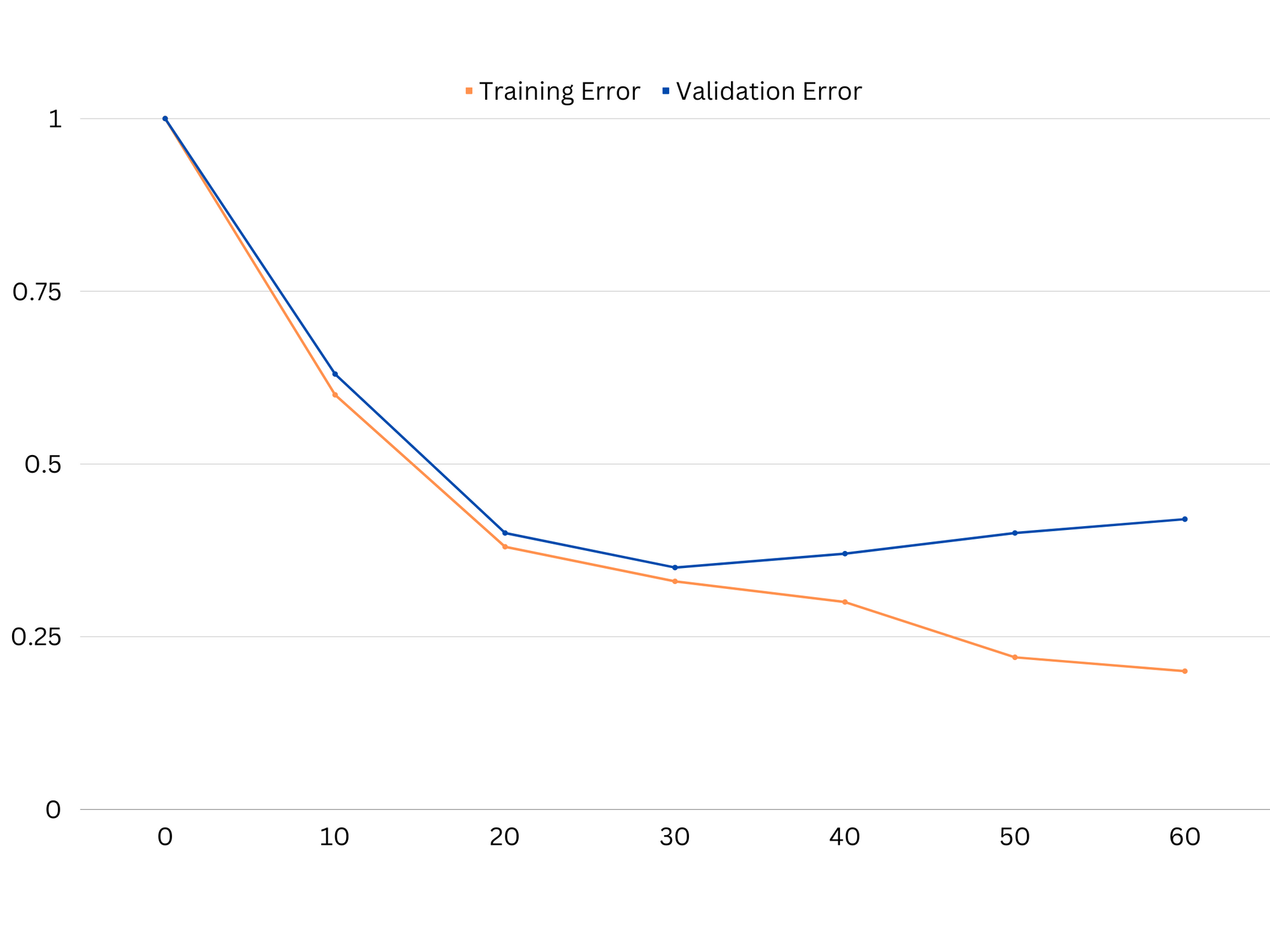

Praktikas viitab nii koolitus- kui ka valideerimisandmete madal jõudlus sellele, et mudel on liiga lihtne, mis põhjustab alasobivust. Teisest küljest, kui mudel toimib treeningandmetega väga hästi, kuid katseandmetega halvasti, on mudeli keerukus tõenäoliselt liiga kõrge, mille tulemuseks on ülepaigutamine. Alasobivuse kõrvaldamiseks võime proovida mudeli keerukust suurendada, lisades rohkem funktsioone, muutes õppealgoritmi või valides erinevaid hüperparameetreid. Ülesobitamise korral peaksime kaaluma mudeli reguleerimist või selliste tehnikate kasutamist nagu ristvalideerimine, et parandada selle üldistusvõimet.

Ülesobiva mudeli õppimiskõverate näide. Rongi viga väheneb, samas kui valideerimisviga hakkab suurenema. Mudel ei suuda üldistada.

Regulariseerimine on tehnika, mida saab kasutada masinõppemudelite dispersioonivigade vähendamiseks, aidates lahendada nihke ja dispersiooni kompromissi. On mitmeid erinevaid seadustamistehnikaid, millest igaühel on oma eelised ja puudused. Mõned populaarsed reguleerimismeetodid hõlmavad harja regressiooni, lasso regressiooni ja elastset netoreguleerimist. Kõik need tehnikad aitavad vältida ülepaigutamist, lisades mudeli sihtfunktsioonile karistustermini, mis heidutab äärmuslikke parameetriväärtusi ja soodustab lihtsamate mudelite kasutamist.

Ridge regressioon, tuntud ka kui L2 regulaarsus, lisab trahviliikme, mis on võrdeline mudeli parameetrite ruuduga. Selle tehnika tulemuseks on tavaliselt väiksemate parameetriväärtustega mudelid, mis võib viia dispersiooni vähenemiseni ja parema üldistamiseni. Kuid see ei teosta funktsioonide valikut, seega jäävad kõik funktsioonid mudelisse.

Tutvuge meie praktilise ja praktilise Giti õppimise juhendiga, mis sisaldab parimaid tavasid, tööstusharus aktsepteeritud standardeid ja kaasas olevat petulehte. Lõpetage Giti käskude guugeldamine ja tegelikult õppima seda!

Lasso regressioon, ehk L1 regulaarsus, lisab trahviliikme, mis on võrdeline mudeli parameetrite absoluutväärtusega. See meetod võib viia hõredate parameetriväärtustega mudeliteni, mis teostavad funktsioonide valimise tõhusalt, seades mõned parameetrid nulli. Selle tulemuseks võivad olla lihtsamad mudelid, mida on lihtsam tõlgendada.

Elastne võrguregulatsioon on kombinatsioon nii L1 kui ka L2 regulaarsusest, mis võimaldab saavutada tasakaalu harja ja lasso regressiooni vahel. Kahe karistustermini suhet reguleerides võib elastne võrk saavutada mõlema tehnika eelised, nagu parem üldistus ja funktsioonide valik.

Hea sobivuse mudeli õppimiskõverate näide.

Järeldused

Kallutatuse ja dispersiooni kompromiss on masinõppes ülioluline kontseptsioon, mis määrab mudeli tõhususe ja headuse. Kui suur kallutatus põhjustab alasobitamist ja suur dispersioon ülesobivuseni, on nende kahe vahel optimaalse tasakaalu leidmine vajalik tugevate mudelite loomiseks, mis üldistavad hästi uusi andmeid.

Õppimiskõverate abil on võimalik tuvastada üle- või alasobitusprobleeme ning mudeli keerukust häälestades või seadustamistehnikaid juurutades on võimalik parandada jõudlust nii treening- ja valideerimisandmetel kui ka testiandmetel.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoAiStream. Web3 andmete luure. Täiustatud teadmised. Juurdepääs siia.

- Tuleviku rahapaja Adryenn Ashley. Juurdepääs siia.

- Ostke ja müüge IPO-eelsete ettevõtete aktsiaid koos PREIPO®-ga. Juurdepääs siia.

- Allikas: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :on

- :mitte

- : kus

- 1

- 12

- 20

- 8

- a

- võime

- Võimalik

- MEIST

- absoluutne

- täpselt

- Saavutada

- saavutamisel

- tegelikult

- lisades

- aadress

- Lisab

- eelised

- nõuanne

- mõjutada

- mõjutades

- algoritm

- Materjal: BPA ja flataatide vaba plastik

- Lubades

- Ka

- an

- ja

- mistahes

- OLEME

- artikkel

- AS

- Saldo

- saldod

- BE

- sest

- Kasu

- vahel

- erapoolikus

- piir

- mõlemad

- Ehitus

- kuid

- by

- arvutama

- CAN

- võimeid

- lüüa

- juhul

- muutuv

- valimine

- lähedalt

- kombinatsioon

- võrdlema

- keeruline

- keerukus

- mõiste

- Arvestama

- kontroll

- tuum

- parandada

- otsustav

- andmed

- tegelema

- väheneb

- Määrama

- määrab

- erinevus

- erinev

- Näidikute

- jaotus

- ei

- kaks

- iga

- Ajalugu

- lihtsam

- tõhusalt

- tõhusus

- julgustab

- piisavalt

- viga

- vead

- Isegi

- Uurimine

- näide

- Selgitama

- äärmuslik

- vastasel

- ei

- tunnusjoon

- FUNKTSIOONID

- leidmine

- sobima

- paigaldamine

- kõikumisi

- Keskenduma

- eest

- funktsioon

- põhiline

- Üldine

- Git

- eesmärk

- hea

- Maa

- suunata

- käsi

- käed-

- Olema

- aitama

- aidates

- Suur

- rohkem

- hõljuma

- Kuidas

- Kuidas

- aga

- HTTPS

- identifitseerima

- if

- rakendamisel

- võimatu

- parandama

- paranenud

- in

- Teistes

- sisaldama

- lisatud

- Suurendama

- kasvav

- sisend

- sisse

- Sissejuhatus

- IT

- ITS

- hoidma

- teatud

- L1

- l2

- viima

- juhtivate

- Leads

- õppimine

- laskma

- LG

- nagu

- Tõenäoliselt

- ll

- Madal

- vähendada

- masin

- masinõpe

- TEEB

- mainitud

- minimeerimine

- mudel

- mudelid

- rohkem

- vajalik

- neto

- Uus

- müra

- number

- eesmärk

- of

- sageli

- on

- optimaalselt

- or

- Muu

- meie

- välja

- väljund

- enda

- parameeter

- parameetrid

- Muster

- täitma

- jõudlus

- esitades

- täidab

- Platon

- Platoni andmete intelligentsus

- PlatoData

- vaene

- populaarne

- võimalik

- Praktiline

- tava

- ennustada

- ennustus

- vältida

- probleeme

- protsess

- anda

- pigem

- suhe

- vähendama

- Lühendatud

- viitab

- seotud

- suhe

- Suhted

- jääma

- esindama

- kaasa

- tulemuseks

- Tulemused

- õige

- ring

- jõuline

- s

- valik

- Tundlikkus

- kehtestamine

- vari

- leht

- Lühike

- peaks

- lihtne

- üheaegselt

- väike

- väiksem

- So

- mõned

- Allikad

- ruut

- Stackabus

- standardite

- Peatus

- tugev

- selline

- Soovitab

- tehnikat

- termin

- tingimused

- test

- kui

- et

- .

- oma

- Neile

- Seal.

- Need

- nad

- see

- läbi kogu

- et

- liiga

- tööriist

- Summa

- Rong

- koolitus

- üleminek

- tõsi

- Tõde

- püüdma

- kaks

- tüüpiliselt

- ei suuda

- aluseks

- tundmatu

- Kasutatud

- kasutamine

- kinnitamine

- väärtus

- Väärtused

- väga

- we

- Hästi

- M

- kas

- mis

- kuigi

- will

- koos

- sõnad

- sephyrnet

- null