Kuna masinõppe (ML) mudelid on paranenud, on andmeteadlased, ML-insenerid ja teadlased pööranud rohkem tähelepanu andmete kvaliteedi määratlemisele ja parandamisele. See on kaasa toonud andmekeskse lähenemise ML-ile ja erinevatele tehnikatele mudeli jõudluse parandamiseks, keskendudes andmenõuetele. Nende tehnikate rakendamine võimaldab ML-i praktikutel vähendada ML-mudeli koolitamiseks vajalike andmete hulka.

Selle lähenemisviisi osana on kasutusele võetud täiustatud andmete alamhulga valimise tehnikad, mis kiirendavad koolitust, vähendades sisendandmete hulka. See protsess põhineb antud arvu punktide automaatsel valimisel, mis on ligikaudne suurema andmekogumi jaotusele, ja selle kasutamisel koolituseks. Seda tüüpi tehnika rakendamine vähendab ML-mudeli treenimiseks kuluvat aega.

Selles postituses kirjeldame andmekesksete AI põhimõtete rakendamist Amazon SageMaker Ground Truth, kuidas rakendada andmete alamhulga valiku tehnikaid kasutades Nöörid hoidla sisse lülitatud Amazon SageMaker et vähendada esialgse mudeli väljaõpetamiseks vajalike andmete hulka ja kuidas seda lähenemisviisi kasutades katseid läbi viia Amazon SageMakeri katsed.

Andmekeskne lähenemine masinõppele

Enne täpsematesse andmekesksetesse tehnikatesse (nt andme alamhulga valimisse) sukeldumist saate oma andmekogumeid mitmel viisil täiustada, rakendades andmesildistamise protsessis aluspõhimõtteid. Selleks toetab Ground Truth erinevaid mehhanisme, et parandada märgistuse järjepidevust ja andmete kvaliteeti.

Märgistuse järjepidevus on mudeli jõudluse parandamiseks oluline. Ilma selleta ei saa mudelid luua otsustuspiiri, mis eraldaks kõik erinevatesse klassidesse kuuluvad punktid. Üks viis järjepidevuse tagamiseks on kasutamine annotatsiooni konsolideerimine Ground Truthis, mis võimaldab esitada antud näidet mitmele märgistajale ja kasutada selle näite puhul põhitõena esitatud koondatud silti. Erinevusi märgistuses mõõdetakse Ground Truthi loodud usaldusskooriga. Kui märgistuses esineb lahknevusi, peaksite kontrollima, kas märgistajatele antavates märgistamisjuhistes on ebaselgust, mida saab eemaldada. See lähenemisviis leevendab üksikute märgistajate eelarvamuste mõju, mis on märgiste järjepidevamaks muutmisel keskse tähtsusega.

Teine võimalus mudeli jõudluse parandamiseks andmetele keskendudes hõlmab meetodite väljatöötamist etikettide vigade analüüsimiseks, kui need tuvastavad kõige olulisema andmete alamhulga, mida parandada. saate seda teha oma treeningandmete kogumi jaoks käsitsi tehtavate pingutuste kombinatsiooniga, mis hõlmab märgistatud näidetesse sukeldumist ja Amazon CloudWatch Ground Truthi märgistustööde loodud logid ja mõõdikud. Samuti on oluline vaadata vigu, mida mudel teeb järelduste tegemise ajal, et juhtida meie andmestiku järgmise märgistamise iteratsiooni. Lisaks nendele mehhanismidele Amazon SageMaker Clarify võimaldab andmeteadlastel ja ML-inseneridel käitada selliseid algoritme nagu KernelSHAP võimaldada neil tõlgendada oma mudeli tehtud ennustusi. Nagu mainitud, võib mudeli ennustuste sügavamat selgitust seostada esialgse märgistamisprotsessiga, et seda parandada.

Lõpuks võite kaaluda lärmakate või liiga üleliigsete näidete väljaviskamist. See võimaldab teil vähendada treeninguaega, eemaldades näited, mis ei aita kaasa mudeli jõudluse parandamisele. Antud andmekogumi kasuliku alamhulga käsitsi tuvastamine on aga keeruline ja aeganõudev. Selles postituses kirjeldatud andmete alamhulga valiku tehnikate rakendamine võimaldab teil seda protsessi automatiseerida vastavalt kehtestatud raamistikele.

Kasutusjuhtum

Nagu mainitud, keskendub andmekeskne AI mudeli sisendi parandamisele, mitte mudeli enda arhitektuurile. Kui olete need põhimõtted andmesildistamise või funktsioonide kavandamise ajal rakendanud, saate jätkata mudeli sisestamisele keskendumist, rakendades koolituse ajal andmete alamhulga valikut.

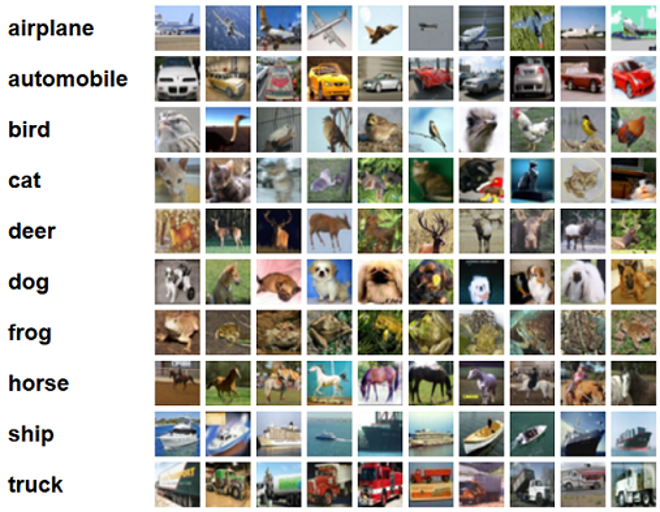

Selle postituse jaoks rakendame üldistuspõhist andmehulga valikut tõhusaks ja tugevaks õppimiseks (GLISTER), mis on üks paljudest CORDS-i hoidlas rakendatud andmete alamhulga valimise tehnikatest ResNet-18 mudel, et minimeerida aega, mis kulub mudeli koolitamiseks klassifitseerimiseks CIFAR-10 pilte. Järgnevalt on mõned näidispildid koos vastavate siltidega, mis on võetud CIFAR-10 andmekogumist.

ResNet-18 kasutatakse sageli klassifitseerimisülesannete jaoks. See on 18-kihiline sügav konvolutsiooniline närvivõrk. CIFAR-10 andmekogumit kasutatakse sageli erinevate tehnikate ja lähenemisviiside kehtivuse hindamiseks ML-is. See koosneb 60,000 32 32 × 10 värvilisest pildist, mis on märgistatud XNUMX klassis.

Järgmistes osades näitame, kuidas GLISTER aitab teil teatud määral vastata järgmisele küsimusele:

Mitu protsenti antud andmekogumist saame kasutada ja siiski saavutada mudeli head jõudlust koolituse ajal?

GLISTERi rakendamine treeningalgoritmile lisab teie treeningalgoritmis hüperparameetrina murdosa. See tähistab antud andmestiku protsenti, mida soovite kasutada. Nagu iga hüperparameetri puhul, nõuab teie mudeli ja andmete jaoks parima tulemuse andva väärtuse leidmine häälestamist. Me ei lähe selles postituses hüperparameetrite häälestamisesse süvitsi. Lisateabe saamiseks vaadake Optimeerige hüperparameetreid Amazon SageMakeri automaatse mudeli häälestamisega.

Käitame mitmeid katseid, kasutades SageMaker Experiments, et mõõta lähenemisviisi mõju. Tulemused varieeruvad olenevalt esialgsest andmekogumist, seega on oluline katsetada lähenemist meie andmetele erinevate alamhulkade suuruste puhul.

Kuigi me arutame GLISTERi kasutamist piltidel, saate seda rakendada ka struktureeritud või tabeliandmetega töötavatele treeningalgoritmidele.

Andmete alamhulga valik

Andmete alamhulga valiku eesmärk on kiirendada koolitusprotsessi, minimeerides samal ajal mõju täpsusele ja suurendades mudeli töökindlust. Täpsemalt valib GLISTER-ONLINE alamhulga, kui mudel õpib, püüdes maksimeerida selle treeningandmete alamhulga logimise tõenäosust teie määratud valideerimiskomplektis. Andmete alamhulga valiku sellisel viisil optimeerimine leevendab müra ja klasside tasakaalustamatust, mida sageli esineb reaalmaailma andmekogumites, ning võimaldab alamhulga valikustrateegial kohaneda, kui mudel õpib.

Algne GLISTER paber kirjeldab kiiruse/täpsuse kompromissi erinevate andmete alamhulga suuruste puhul, nagu järgitakse kasutades a LeNet mudel:

| Alamhulga suurus | speedup | Täpsus |

| 10% | 6x | -3% |

| 30% | 2.5x | -1.20% |

| 50% | 1.5x | -0.20% |

Modelli koolitamiseks käivitame a SageMakeri koolitustöö kasutades kohandatud treeningskripti. Samuti oleme oma pildiandmestiku juba üles laadinud Amazoni lihtne salvestusteenus (Amazon S3). Nagu iga SageMakeri koolitustöö puhul, peame määratlema Estimator objektiks. PyTorchi hindaja alates sagemaker.pytorch pakett võimaldab meil käitada oma treeningskripti hallatud PyTorchi konteineris. The inputs muutuja edastati hindajale .fit funktsioon sisaldab koolituse ja valideerimise andmestiku S3 asukoha sõnastikku.

. train.py skript käivitatakse koolitustöö käivitamisel. Selles skriptis impordime ResNet-18 mudeli CORDSi teegist ja edastame sellele meie andmestiku klasside arvu järgmiselt:

Seejärel kasutame gen_dataset funktsiooni CORDS-ist, et luua koolitus-, valideerimis- ja testiandmekogumeid:

Igast andmekogumist loome samaväärse PyTorchi andmelaadija:

Lõpuks kasutame neid andmelaadijaid, et luua a GLISTERDataLoader CORDSi raamatukogust. See kasutab GLISTER-ONLINE valikustrateegia rakendamist, mis rakendab alamhulga valikut, kui värskendame mudelit koolituse ajal, nagu selles postituses varem käsitletud.

Objekti loomiseks edastame valikustrateegia spetsiifilised argumendid kui a DotMap objekt koos train_loader, validation_loaderja logger:

. GLISTERDataLoader saab nüüd rakendada treeningtsüklile tavalise andmelaadijana. See valib andmete alamhulgad järgmiseks koolituspartiiks, kui mudel selle mudeli kadumise põhjal õpib. Nagu on näidatud eelmises tabelis, võimaldab andmete alamhulga valimise strateegia lisamine meil märkimisväärselt lühendada treeninguaega isegi täiendava andme alamhulga valimise etapiga, kuid täpsuses on vähe kompromisse.

Andmeteadlased ja ML-insenerid peavad sageli hindama lähenemisviisi kehtivust, võrreldes seda mõne lähtetasemega. Näitame, kuidas seda teha järgmises jaotises.

Katse jälgimine

Saate kasutada SageMakeri katseid, et mõõta andmete alamhulga valiku lähenemisviisi kehtivust. Lisateabe saamiseks vt Järgmise põlvkonna Amazon SageMaker Experiments – korraldage, jälgige ja võrrelge oma masinõppe koolitusi ulatuslikult.

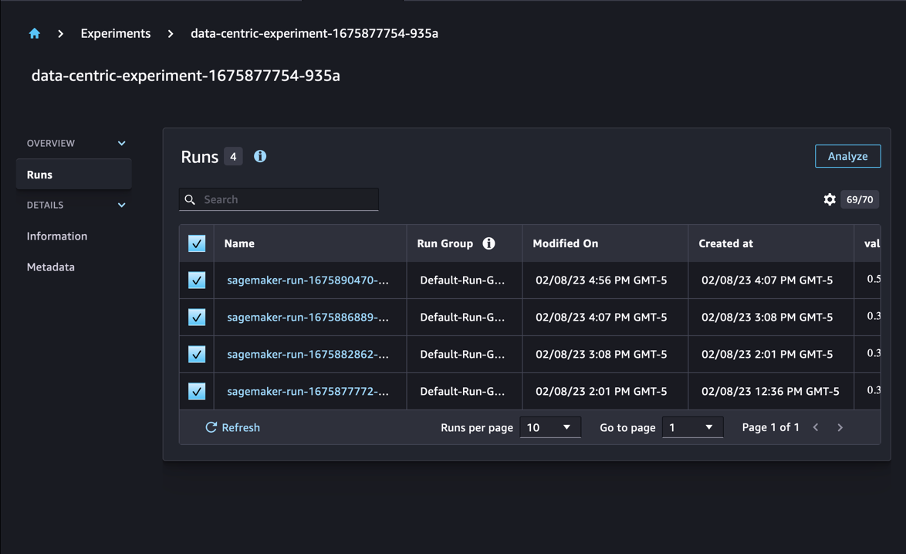

Meie puhul teeme neli katset: lähtejoon ilma andmete alamhulga valikut rakendamata ja kolm teist erinevat katset fraction parameetrid, mis tähistavad alamhulga suurust üldise andmestiku suhtes. Loomulikult kasutades väiksemat fraction parameeter peaks vähendama treeninguaega, kuid vähendama ka mudeli täpsust.

Selle postituse puhul on iga treeningjooks kujutatud a Run SageMakeri katsetes. Kõik meie katsega seotud jooksud on rühmitatud ühe alla Experiment objektiks. Jooksud saab lisada ühise katse loomisel Estimator koos SDK-ga. Vaadake järgmist koodi:

Kohandatud treeningskripti osana saate koguda jooksumõõdikuid kasutades load_run:

Seejärel saate eelmise toimingu poolt tagastatud käitamisobjekti kasutades koguda andmepunkte epohhi kohta helistades run.log_metric(name, value, step) ja esitades meetrika nime, väärtuse ja praeguse epohhi numbri.

Meie lähenemisviisi paikapidavuse mõõtmiseks kogume mõõdikuid, mis vastavad treeningu kadudele, treeningu täpsusele, valideerimise kadudele, valideerimise täpsusele ja ajastu läbimise ajale. Siis pärast koolitustööde läbiviimist saame vaadake üle meie katse tulemused in Amazon SageMaker Studio või SageMaker Experiments SDK kaudu.

Valideerimistäpsuse vaatamiseks Studios valige Analüüsima eksperimendi kohta Jookseb lehel.

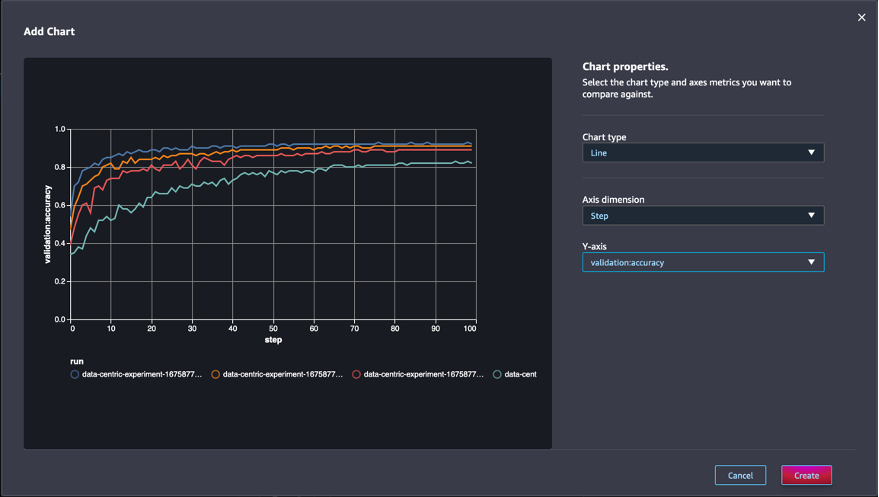

Lisage diagramm, määrake diagrammi atribuudid ja valige Looma. Nagu on näidatud järgmisel ekraanipildil, näete valideerimistäpsuste graafikut igal ajajärgul kõigi käitamiste kohta.

SDK võimaldab teil hankida ka katsega seotud teavet Panda andmeraamina.

Soovi korral saab koolitustöid sorteerida. Näiteks võiksime lisada "metrics.validation:accuracy.max" väärtusena sort_by parameeter edastati ExperimentAnalytics valideerimistäpsuse järgi järjestatud tulemuse tagastamiseks.

Nagu oodatud, näitavad meie katsed, et GLISTERi ja andmete alamhulga valiku rakendamine treeningalgoritmile vähendab treeninguaega. Meie algtaseme treeningalgoritmi käitamisel hõljub ühe epohhi läbimiseks kuluv keskmine aeg umbes 27 sekundit. Seevastu GLISTERi rakendamine alamhulga valimiseks, mis vastab 50%, 30% ja 10% üldisest andmestikust, annab ml.p13xsuurtel eksemplaridel aega vastavalt umbes 8.5, 2.75 ja 3.2 sekundile. .

Samuti täheldame suhteliselt minimaalset mõju valideerimise täpsusele, eriti 50% andmete alamhulkade kasutamisel. Pärast 100 epohhi treenimist annab baasjoon valideerimise täpsuseks 92.72%. Seevastu GLISTERi rakendamine alamhulga valimiseks, mis vastab 50%, 30% ja 10% üldisest andmekogumist, annab valideerimise täpsuseks vastavalt 91.42%, 89.76% ja 82.82%.

Järeldus

SageMaker Ground Truth ja SageMaker Experiments võimaldavad andmekeskset lähenemist masinõppele, võimaldades andmeteadlastel ja ML-i inseneridel luua ühtsemaid andmekogumiid ja jälgida täiustatud tehnikate mõju nende rakendamisel mudeli loomise etapis. Andmekeskse lähenemise rakendamine ML-is võimaldab teil vähendada mudeli jaoks nõutavate andmete hulka ja parandada selle töökindlust.

Proovige järele ja andke meile kommentaarides teada, mida arvate.

Autoritest

Nicolas Bernier on lahenduste arhitekt, osa AWS-i Kanada avaliku sektori meeskonnast. Praegu õpib ta magistrikraadi süvaõppe uurimisvaldkonnas ja tal on viis AWS-i sertifikaati, sealhulgas ML-i erialasertifikaat. Nicolas soovib kirglikult aidata klientidel oma teadmisi AWS-ist süvendada, tehes nendega koostööd, et muuta nende äriprobleemid tehnilisteks lahendusteks.

Nicolas Bernier on lahenduste arhitekt, osa AWS-i Kanada avaliku sektori meeskonnast. Praegu õpib ta magistrikraadi süvaõppe uurimisvaldkonnas ja tal on viis AWS-i sertifikaati, sealhulgas ML-i erialasertifikaat. Nicolas soovib kirglikult aidata klientidel oma teadmisi AWS-ist süvendada, tehes nendega koostööd, et muuta nende äriprobleemid tehnilisteks lahendusteks.

Givanildo Alves on prototüüpimise arhitekt koos Amazon Web Servicesi prototüüpide ja pilvetehnoloogia meeskonnaga, aidates klientidel uuendusi teha ja kiirendada, näidates AWS-is võimalikku kunsti, olles juba rakendanud mitmeid tehisintellekti prototüüpe. Tal on pikk karjäär tarkvaratehnika alal ja ta on varem töötanud tarkvaraarenduse insenerina aadressil Amazon.com.br.

Givanildo Alves on prototüüpimise arhitekt koos Amazon Web Servicesi prototüüpide ja pilvetehnoloogia meeskonnaga, aidates klientidel uuendusi teha ja kiirendada, näidates AWS-is võimalikku kunsti, olles juba rakendanud mitmeid tehisintellekti prototüüpe. Tal on pikk karjäär tarkvaratehnika alal ja ta on varem töötanud tarkvaraarenduse insenerina aadressil Amazon.com.br.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- Platoblockchain. Web3 metaversiooni intelligentsus. Täiustatud teadmised. Juurdepääs siia.

- Allikas: https://aws.amazon.com/blogs/machine-learning/use-a-data-centric-approach-to-minimize-the-amount-of-data-required-to-train-amazon-sagemaker-models/

- :on

- $ UP

- 000

- 1

- 10

- 100

- 7

- 8

- a

- MEIST

- kiirendama

- täpsus

- Saavutada

- üle

- kohandama

- lisamine

- Täiendavad lisad

- edasijõudnud

- pärast

- vastu

- AI

- algoritm

- algoritme

- Materjal: BPA ja flataatide vaba plastik

- Lubades

- võimaldab

- juba

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- Mitmetähenduslikkus

- summa

- analytics

- analüüsima

- ja

- vastus

- rakendatud

- kehtima

- Rakendades

- lähenemine

- lähenemisviisid

- arhitektuur

- OLEME

- PIIRKOND

- argumendid

- ümber

- kunst

- kunstlik

- tehisintellekti

- AS

- At

- üritab

- tähelepanu

- automatiseerima

- Automaatne

- automaatselt

- AWS

- tagasi

- põhineb

- Baseline

- BE

- BEST

- erapoolikus

- Ehitus

- äri

- by

- kutsudes

- CAN

- Kanada

- Karjäär

- juhul

- kesk-

- sertifikaat

- sertifikaadid

- väljakutseid

- Joonis

- Vali

- klass

- klassid

- klassifikatsioon

- Klassifitseerige

- kliendid

- Cloud

- kood

- koguma

- värv

- COM

- kombinatsioon

- Tulema

- kommentaarid

- ühine

- suhteliselt

- võrdlema

- võrrelda

- täitma

- koostatud

- Juhtimine

- usaldus

- Arvestama

- järjepidev

- konsolideerimine

- Konteiner

- sisaldab

- jätkama

- kontrast

- aitama kaasa

- Vastav

- võiks

- looma

- loomine

- Praegune

- Praegu

- tava

- Kliendid

- andmed

- andmepunktid

- andmekogumid

- otsus

- sügav

- sügav õpe

- Süvene

- sügavam

- määratlemisel

- Kraad

- näitama

- Näidatud

- Olenevalt

- sügavus

- kirjeldama

- kirjeldatud

- arenev

- & Tarkvaraarendus

- erinev

- erinevad

- raske

- arutama

- arutatud

- jaotus

- Lahknemine

- teeme

- Ära

- ajam

- ajal

- iga

- Ajalugu

- mõju

- tõhus

- jõupingutusi

- tekkimine

- võimaldama

- insener

- Inseneriteadus

- Inseneride

- tagama

- epohh

- ajajärgud

- Samaväärne

- vead

- eriti

- asutatud

- hindama

- Isegi

- Iga

- näide

- näited

- oodatav

- eksperiment

- selgitus

- tunnusjoon

- leidmine

- Keskenduma

- keskendub

- keskendumine

- Järgneb

- Järel

- järgneb

- eest

- avastatud

- murdosa

- raamistikud

- Alates

- funktsioon

- loodud

- põlvkond

- antud

- Go

- hea

- Maa

- Olema

- võttes

- aitama

- aidates

- omab

- Kuidas

- Kuidas

- aga

- HTML

- http

- HTTPS

- Hüperparameetrite häälestamine

- identifitseerima

- identifitseerimiseks

- pilt

- pildid

- tasakaalutus

- mõju

- rakendada

- täitmine

- rakendatud

- rakendamisel

- import

- oluline

- parandama

- paranenud

- Paranemist

- in

- Kaasa arvatud

- kasvav

- eraldi

- info

- esialgne

- uuendama

- sisend

- Näiteks

- juhised

- Intelligentsus

- kehtestama

- IT

- iteratsioon

- ITS

- ise

- töö

- Tööturg

- Teadma

- teadmised

- silt

- märgistamine

- Labels

- suurem

- käivitatud

- õppimine

- Led

- Raamatukogu

- nagu

- nimekiri

- vähe

- liising

- Pikk

- Vaata

- kaotus

- masin

- masinõpe

- tehtud

- TEEB

- Tegemine

- juhitud

- käsiraamat

- käsitsi

- palju

- meistrid

- max

- Maksimeerima

- mõõtma

- mainitud

- meetodid

- meetriline

- Meetrika

- minimaalne

- minimeerimine

- ML

- mudel

- mudelid

- rohkem

- kõige

- mitmekordne

- nimi

- Vajadus

- võrk

- Närvivõrgus

- järgmine

- Nicolas

- müra

- number

- objekt

- jälgima

- of

- on

- ONE

- töö

- optimeerimine

- teised

- üldine

- enda

- pakend

- lehekülg

- pandas

- parameeter

- parameetrid

- osa

- Vastu võetud

- kirglik

- protsent

- täitma

- jõudlus

- faas

- Platon

- Platoni andmete intelligentsus

- PlatoData

- Punkt

- võrra

- võimalik

- post

- Ennustused

- eelmine

- varem

- põhimõtted

- protsess

- tootma

- omadused

- prototüüpide

- prototüüpimine

- tingimusel

- avalik

- eesmärk

- pütorch

- kvaliteet

- kogus

- küsimus

- pigem

- päris maailm

- vähendama

- Lühendatud

- vähendab

- vähendamine

- piirkond

- regulaarne

- seotud

- Eemaldatud

- eemaldades

- Hoidla

- esindatud

- esindab

- nõutav

- Nõuded

- Vajab

- teadustöö

- Teadlased

- need

- kaasa

- Tulemused

- tagasipöördumine

- jõuline

- tugevus

- jooks

- jooksmine

- salveitegija

- teadlased

- SDK

- sekundit

- Osa

- lõigud

- sektor

- valides

- valik

- teenima

- teenused

- istung

- komplekt

- mitu

- peaks

- näitama

- näidatud

- märgatavalt

- lihtne

- ühekordne

- SUURUS

- suurused

- väiksem

- So

- tarkvara

- tarkvaraarenduse

- tarkvaraarendus

- Lahendused

- mõned

- allikas

- Eriala

- konkreetse

- eriti

- kiirus

- Samm

- Veel

- ladustamine

- Strateegia

- struktureeritud

- stuudio

- varustamise

- Toetab

- tabel

- võtab

- ülesanded

- meeskond

- Tehniline

- tehnikat

- test

- testid

- et

- .

- oma

- Neile

- Need

- kolm

- Läbi

- aeg

- korda

- et

- tõrvik

- Toronto

- jälgida

- Rong

- koolitus

- koolitused

- tõlkima

- all

- aluseks

- Värskendused

- laetud

- us

- kasutama

- kinnitamine

- väärtus

- eri

- vaade

- Tee..

- kuidas

- web

- veebiteenused

- Hästi

- M

- mis

- kuigi

- will

- koos

- jooksul

- ilma

- töötas

- töö

- sa

- Sinu

- sephyrnet