سازمانها در سراسر جهان در حال رقابت برای استفاده از فناوریهای هوش مصنوعی در برنامهها و ابزارهای امنیت سایبری خود هستند. آ اکثریت (65٪) از توسعه دهندگان استفاده کنید یا برنامه ریزی کنید استفاده از هوش مصنوعی در تلاشهای آزمایشی در سه سال آینده برنامه های امنیتی بسیاری وجود دارند که از هوش مصنوعی مولد بهره مند خواهند شد، اما آیا رفع کد یکی از آنهاست؟

برای بسیاری از تیمهای DevSecOps، هوش مصنوعی مولد نشان دهنده جام مقدس برای پاک کردن انحرافات آسیبپذیری فزاینده آنها است. بیش از نیمی (66%) سازمانها میگویند که بک لاگهای آنها از بیش از 100,000 آسیبپذیری تشکیل شده است و بیش از دو سوم یافتههای گزارش شده از تست امنیت برنامههای استاتیک (SAST) سه ماه پس از شناسایی باز میمانند. 50% پس از 363 روز باز می ماند. رویا این است که یک توسعهدهنده میتواند به سادگی از ChatGPT بخواهد که این آسیبپذیری را برطرف کند، و ساعتها و روزهایی که قبلاً صرف رفع آسیبپذیریها میشد، متعلق به گذشته خواهد بود.

از نظر تئوری، این یک ایده کاملا دیوانه کننده نیست. از این گذشته، یادگیری ماشینی سال ها به طور موثر در ابزارهای امنیت سایبری برای خودکارسازی فرآیندها و صرفه جویی در زمان استفاده شده است – هوش مصنوعی زمانی که برای کارهای ساده و تکراری به کار می رود بسیار سودمند است. اما استفاده از هوش مصنوعی مولد در برنامههای کد پیچیده، در عمل دارای اشکالاتی است. بدون نظارت انسانی و دستور اکسپرس، تیمهای DevSecOps میتوانند بیشتر از آنچه که حل کنند، مشکلاتی ایجاد کنند.

مزایا و محدودیتهای هوش مصنوعی مرتبط با کد رفع اشکال

ابزارهای هوش مصنوعی می توانند ابزارهای فوق العاده قدرتمندی برای تجزیه و تحلیل امنیت سایبری ساده و کم خطر، نظارت یا حتی نیازهای اصلاحی باشند. نگرانی زمانی به وجود می آید که ریسک ها نتیجه ای می گیرند. این در نهایت یک مسئله اعتماد است.

محققان و توسعه دهندگان هنوز در حال تعیین قابلیت های فناوری جدید هوش مصنوعی مولد هستند ایجاد اصلاحات کد پیچیده. هوش مصنوعی مولد برای تصمیم گیری به اطلاعات موجود و موجود متکی است. این می تواند برای مواردی مانند ترجمه کد از یک زبان به زبان دیگر یا رفع نقص های شناخته شده مفید باشد. برای مثال، اگر از ChatGPT بخواهید «این کد جاوا اسکریپت را در پایتون بنویسد»، احتمالاً نتیجه خوبی خواهید گرفت. استفاده از آن برای تعمیر پیکربندی امنیت ابری مفید خواهد بود زیرا اسناد مربوطه برای انجام این کار در دسترس عموم است و به راحتی یافت می شود و هوش مصنوعی می تواند دستورالعمل های ساده را دنبال کند.

با این حال، رفع بیشتر آسیبپذیریهای کد مستلزم اقدام بر روی مجموعهای از شرایط و جزئیات منحصربهفرد است و سناریوی پیچیدهتری برای حرکت هوش مصنوعی ارائه میکند. هوش مصنوعی ممکن است یک "اصلاح" ارائه دهد، اما بدون تأیید، نباید به آن اعتماد کرد. هوش مصنوعی مولد، طبق تعریف، نمیتواند چیزی را ایجاد کند که قبلاً شناخته شده نیست، و میتواند توهماتی را تجربه کند که منجر به خروجیهای جعلی میشود.

در یک مثال اخیر، یک وکیل پس از استفاده از ChatGPT برای کمک به نوشتن پرونده های دادگاهی که شش مورد غیرموجود را که ابزار هوش مصنوعی ابداع کرده است، ذکر کرده است، با عواقب جدی مواجه شده است. اگر هوش مصنوعی روشهایی را که وجود ندارند توهم میکند و سپس آن روشها را برای نوشتن کد به کار میبرد، منجر به اتلاف زمان برای یک «رفع» میشود که قابل کامپایل نیست. علاوه بر این، با توجه به OpenAI کاغذ سفید GPT-4اکسپلویت های جدید، جیلبریک ها و رفتارهای نوظهور به مرور زمان کشف خواهند شد و جلوگیری از آن دشوار خواهد بود. بنابراین برای اطمینان از اینکه ابزارهای امنیتی هوش مصنوعی و راه حل های شخص ثالث بررسی شده و مرتباً به روز می شوند، بررسی دقیق لازم است تا اطمینان حاصل شود که به درهای پشتی ناخواسته در سیستم تبدیل نمی شوند.

اعتماد کنیم یا اعتماد نکنیم؟

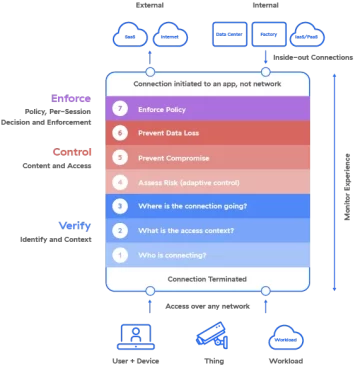

مشاهده پذیرش سریع هوش مصنوعی مولد در اوج جنبش اعتماد صفر، پویایی جالبی است. اکثر ابزارهای امنیت سایبری بر اساس این ایده ساخته شدهاند که سازمانها هرگز نباید اعتماد کنند و همیشه آن را تأیید کنند. هوش مصنوعی مولد بر اساس اصل اعتماد ذاتی به اطلاعاتی که توسط منابع شناخته شده و ناشناخته در دسترس آن قرار می گیرد، ساخته شده است. به نظر میرسد این تضاد در اصول، استعارهای مناسب برای سازمانهای مبارزاتی است که در یافتن تعادل مناسب بین امنیت و بهرهوری، که در این لحظه تشدید میشود، روبرو هستند.

در حالی که ممکن است هوش مصنوعی مولد هنوز آن جام مقدسی نباشد که تیمهای DevSecOps به آن امیدوار بودند، به پیشرفت تدریجی در کاهش آسیبپذیریهای عقب مانده کمک میکند. در حال حاضر، می توان از آن برای ایجاد اصلاحات ساده استفاده کرد. برای رفعهای پیچیدهتر، آنها باید یک روش تأیید به اعتماد را اتخاذ کنند که از قدرت هوش مصنوعی با هدایت دانش توسعهدهندگانی که کد را نوشته و مالک آن هستند، استفاده کند.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. خودرو / خودروهای الکتریکی، کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- BlockOffsets. نوسازی مالکیت افست زیست محیطی. دسترسی به اینجا.

- منبع: https://www.darkreading.com/application-security/can-generative-ai-be-trusted-to-fix-your-code-

- : دارد

- :است

- :نه

- $UP

- 000

- 100

- 7

- a

- مطابق

- بازیگری

- علاوه بر این

- اتخاذ

- اتخاذ

- مزایای

- پس از

- AI

- معرفی

- قبلا

- همیشه

- an

- تحلیل

- و

- دیگر

- کاربرد

- امنیت نرم افزار

- برنامه های کاربردی

- اعمال می شود

- درخواست

- با استفاده از

- هستند

- At

- خودکار بودن

- در دسترس

- پشتيباني

- برج میزان

- BE

- زیرا

- شدن

- بوده

- مفید

- سود

- میان

- ساخته

- اما

- by

- CAN

- قابلیت های

- دقیق

- موارد

- GPT چت

- موقعیت

- اشاره

- برخورد

- نقل و انتقال بانکی

- ابر

- امنیت ابر

- رمز

- پیچیده

- شامل

- نگرانی

- پیکر بندی

- عواقب

- دارای اهمیت

- توجه

- میتوانست

- دادگاه

- پرونده های دادگاه

- دیوانه

- ایجاد

- ایجاد

- امنیت سایبری

- روز

- تصمیم گیری

- تعریف

- جزئیات

- کشف

- تعیین

- توسعه دهنده

- توسعه دهندگان

- مشکل

- کشف

- do

- مستندات

- رویا

- پویا

- به آسانی

- به طور موثر

- پایان

- اطمینان حاصل شود

- به طور کامل

- حتی

- مثال

- وجود داشته باشد

- موجود

- تجربه

- سوء استفاده

- صریح

- چهره

- نما

- جعلی

- ادویه جات

- پیدا کردن

- یافته ها

- مناسب

- رفع

- معایب

- به دنبال

- برای

- یافت

- از جانب

- مولد

- هوش مصنوعی مولد

- دریافت کنید

- خوب

- نیم

- ارتفاع

- کمک

- مفید

- امید

- ساعت ها

- HTML

- HTTPS

- به شدت

- انسان

- اندیشه

- if

- in

- افزایش

- بطور باور نکردنی

- اطلاعات

- ذاتی

- دستورالعمل

- جالب

- به

- معرفی

- اختراع

- موضوع

- IT

- جاوا اسکریپت

- JPG

- دانش

- شناخته شده

- زبان

- وکیل

- یادگیری

- پسندیدن

- احتمالا

- محدودیت

- ll

- ریسک کم

- دستگاه

- فراگیری ماشین

- ساخته

- اکثریت

- ساخت

- بسیاری

- روش شناسی

- روش

- قدرت

- لحظه

- نظارت بر

- ماه

- بیش

- اکثر

- جنبش

- هدایت

- نیاز

- نیازهای

- هرگز

- جدید

- بعد

- وجود ندارد

- اکنون

- of

- on

- ONE

- باز کن

- OpenAI

- or

- سفارش

- سازمان های

- خارج

- روی

- نظارت

- خود

- ویژه

- گذشته

- برنامه

- افلاطون

- هوش داده افلاطون

- PlatoData

- بازی

- قدرت

- قوی

- تمرین

- جلوگیری از

- قبلا

- اصل

- از اصول

- مشکلات

- فرآیندهای

- بهره وری

- برنامه ها

- پیشرفت

- ارائه

- عمومی

- پــایتــون

- نژاد

- سریع

- اخیر

- کاهش

- به طور منظم

- مربوط

- مربوط

- ماندن

- باقی مانده

- تکراری

- گزارش

- نشان دهنده

- ضروری

- نیاز

- نتیجه

- راست

- s

- ذخیره

- گفتن

- سناریو

- تیم امنیت لاتاری

- دیدن

- به نظر می رسد

- جدی

- تنظیم

- باید

- ساده

- به سادگی

- شش

- So

- مزایا

- حل

- برخی از

- چیزی

- منابع

- صرف

- هنوز

- مبارزه

- سیستم

- وظایف

- تیم ها

- فن آوری

- پیشرفته

- تست

- نسبت به

- که

- La

- اطلاعات

- شان

- آنها

- سپس

- نظریه

- آنجا.

- آنها

- چیز

- اشیاء

- شخص ثالث

- این

- کسانی که

- سه

- زمان

- به

- ابزار

- ابزار

- اعتماد

- مورد اعتماد

- دو سوم

- در نهایت

- منحصر به فرد

- ناشناخته

- به روز شده

- استفاده کنید

- استفاده

- با استفاده از

- تایید

- بررسی

- بررسی شده

- آسیب پذیری ها

- آسیب پذیری

- معروف

- بود

- چه زمانی

- که

- WHO

- اراده

- با

- بدون

- در سرتاسر جهان

- خواهد بود

- نوشتن

- نوشته

- سال

- هنوز

- شما

- شما

- زفیرنت