امروز، ما مشتاقیم اعلام کنیم که مدلهای بنیاد Code Llama که توسط متا توسعه یافته است، از طریق Amazon SageMaker JumpStart برای استقرار با یک کلیک برای اجرای استنتاج. Code Llama یک مدل زبان بزرگ پیشرفته (LLM) است که قادر به تولید کد و زبان طبیعی در مورد کد از هر دو درخواست کد و زبان طبیعی است. میتوانید این مدل را با SageMaker JumpStart امتحان کنید، یک مرکز یادگیری ماشین (ML) که دسترسی به الگوریتمها، مدلها و راهحلهای ML را فراهم میکند تا بتوانید به سرعت با ML شروع کنید. در این پست، نحوه کشف و استقرار مدل Code Llama از طریق SageMaker JumpStart را بررسی می کنیم.

کد لاما

Code Llama مدلی است که توسط متا که بر روی Llama 2 ساخته شده است. این مدل پیشرفته برای بهبود بهره وری برای وظایف برنامه نویسی برای توسعه دهندگان با کمک به آنها در ایجاد کد با کیفیت بالا و مستند طراحی شده است. این مدل ها در Python، C++، Java، PHP، C#، TypeScript و Bash برتری دارند و این پتانسیل را دارند که در زمان توسعه دهندگان صرفه جویی کنند و گردش کار نرم افزار را کارآمدتر کنند.

این در سه نوع ارائه می شود که برای پوشش طیف گسترده ای از کاربردها مهندسی شده است: مدل پایه (Code Llama)، یک مدل تخصصی پایتون (Code Llama Python)، و یک مدل مطابق دستورالعمل برای درک دستورالعمل های زبان طبیعی (Code Llama Instruct). همه انواع Code Llama در چهار اندازه ارائه می شوند: پارامترهای 7B، 13B، 34B و 70B. انواع پایه و دستورالعمل 7B و 13B از پر کردن بر اساس محتوای اطراف پشتیبانی می کنند و آنها را برای برنامه های دستیار کد ایده آل می کند. این مدلها با استفاده از Llama 2 به عنوان پایه طراحی شدند و سپس بر روی 500 میلیارد توکن دادههای کد آموزش دیدند، با نسخه تخصصی پایتون که با افزایش 100 میلیارد توکن آموزش داده شد. مدلهای Code Llama نسلهای پایداری را با حداکثر 100,000 توکن زمینه ارائه میکنند. همه مدلها بر روی دنبالههای 16,000 توکن آموزش داده شدهاند و بهبودهایی را در ورودیها با حداکثر 100,000 توکن نشان میدهند.

مدل تحت همین موجود در دسترس است مجوز انجمن به عنوان Llama 2.

مدل های پایه در SageMaker

SageMaker JumpStart دسترسی به طیف وسیعی از مدلها از هابهای مدل محبوب، از جمله Hugging Face، PyTorch Hub، و TensorFlow Hub را فراهم میکند، که میتوانید در گردش کار توسعه ML خود در SageMaker استفاده کنید. پیشرفتهای اخیر در ML منجر به پیدایش دسته جدیدی از مدلها شده است که به آنها میگویند مدل های پایه، که معمولاً بر روی میلیاردها پارامتر آموزش داده می شوند و با دسته بندی گسترده ای از موارد استفاده مانند خلاصه سازی متن، تولید هنر دیجیتال و ترجمه زبان سازگار هستند. از آنجایی که آموزش این مدلها گران است، مشتریان میخواهند به جای آموزش این مدلها، از مدلهای پایه از پیش آموزشدیده موجود استفاده کنند و در صورت نیاز آنها را تنظیم کنند. SageMaker لیستی از مدلهایی را ارائه میکند که میتوانید از میان آنها در کنسول SageMaker انتخاب کنید.

میتوانید مدلهای پایه را از ارائهدهندگان مدلهای مختلف در SageMaker JumpStart بیابید، که به شما امکان میدهد به سرعت با مدلهای پایه شروع کنید. می توانید مدل های پایه را بر اساس وظایف مختلف یا ارائه دهندگان مدل پیدا کنید و به راحتی ویژگی های مدل و شرایط استفاده را بررسی کنید. همچنین می توانید این مدل ها را با استفاده از ویجت UI آزمایشی امتحان کنید. هنگامی که می خواهید از یک مدل پایه در مقیاس استفاده کنید، می توانید این کار را بدون ترک SageMaker با استفاده از نوت بوک های از پیش ساخته شده از ارائه دهندگان مدل انجام دهید. از آنجایی که مدلها بر روی AWS میزبانی و مستقر میشوند، میتوانید مطمئن باشید که دادههای شما، چه برای ارزیابی یا استفاده از مدل در مقیاس استفاده شود، هرگز با اشخاص ثالث به اشتراک گذاشته نمیشود.

مدل Code Llama را در SageMaker JumpStart کشف کنید

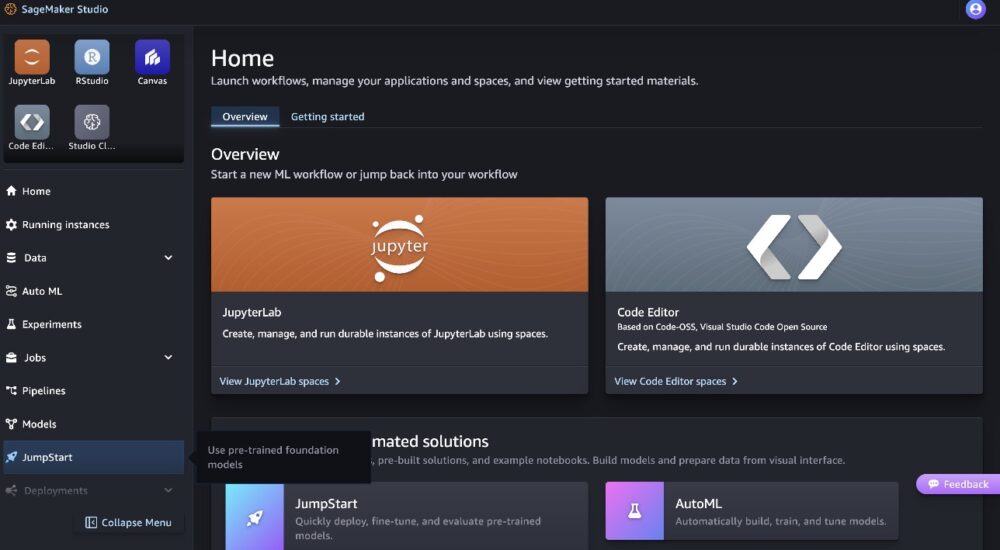

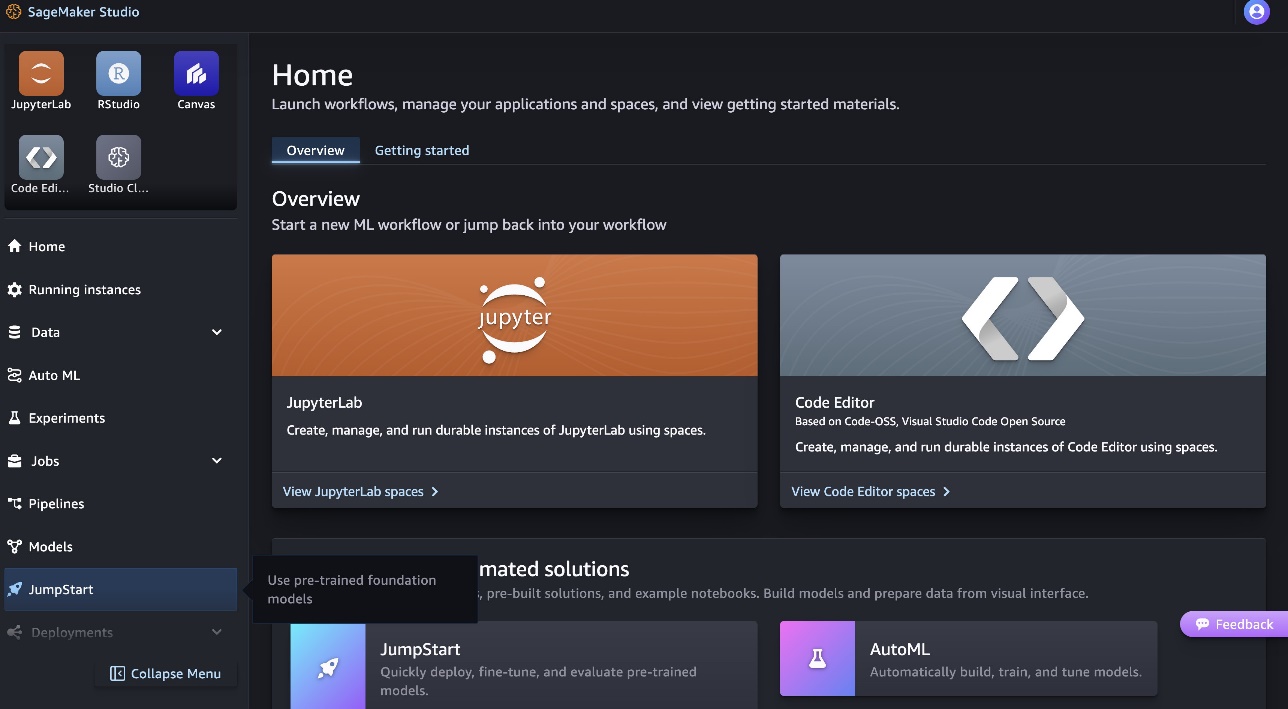

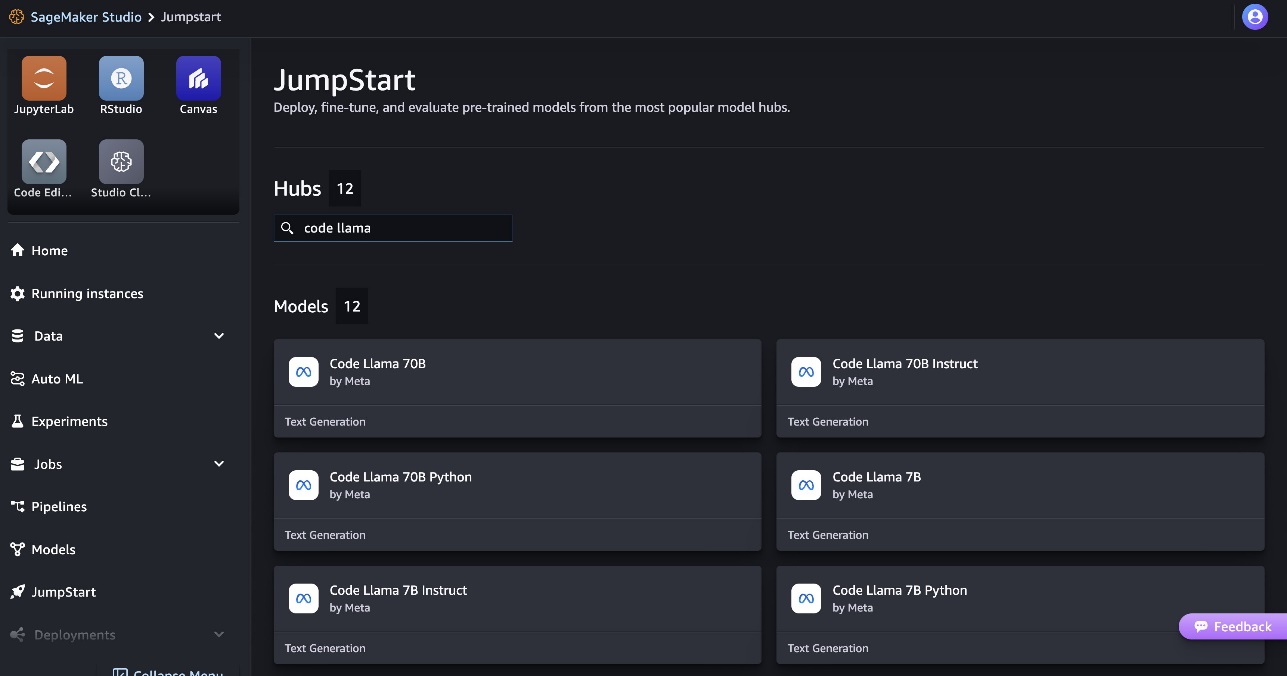

برای استقرار مدل Code Llama 70B، مراحل زیر را انجام دهید Amazon SageMaker Studio:

- در صفحه اصلی SageMaker Studio، را انتخاب کنید شروع به کار در صفحه ناوبری

- مدل های Code Llama را جستجو کنید و مدل Code Llama 70B را از لیست مدل های نشان داده شده انتخاب کنید.

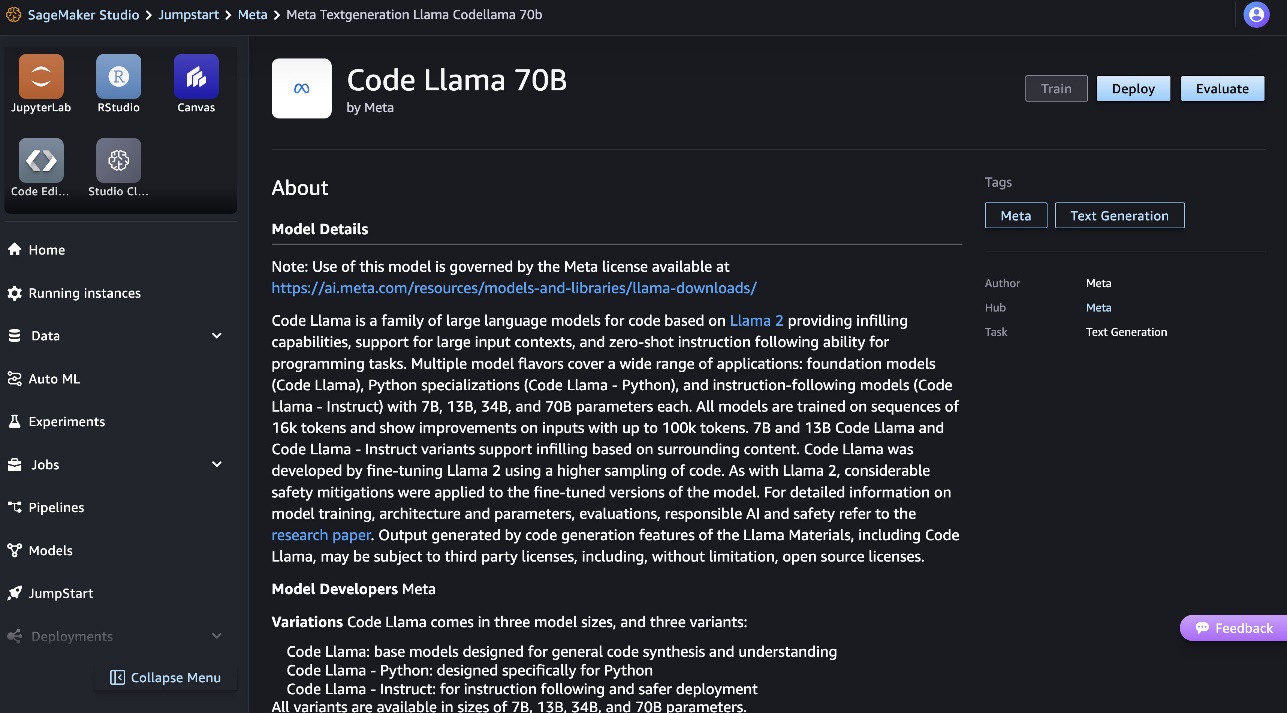

اطلاعات بیشتر در مورد مدل را می توانید در کارت مدل Code Llama 70B بیابید.

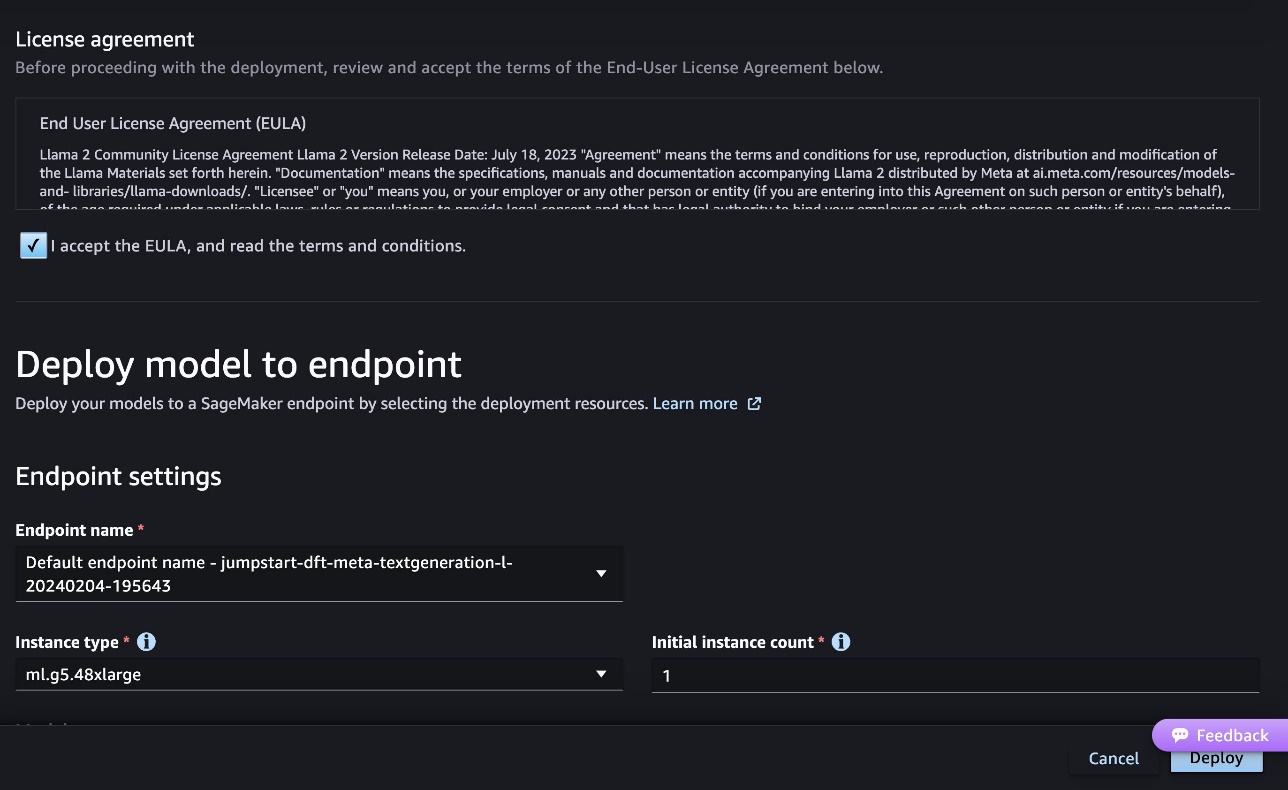

تصویر زیر تنظیمات نقطه پایانی را نشان می دهد. می توانید گزینه ها را تغییر دهید یا از گزینه های پیش فرض استفاده کنید.

- موافقتنامه مجوز کاربر نهایی (EULA) را بپذیرید و انتخاب کنید گسترش.

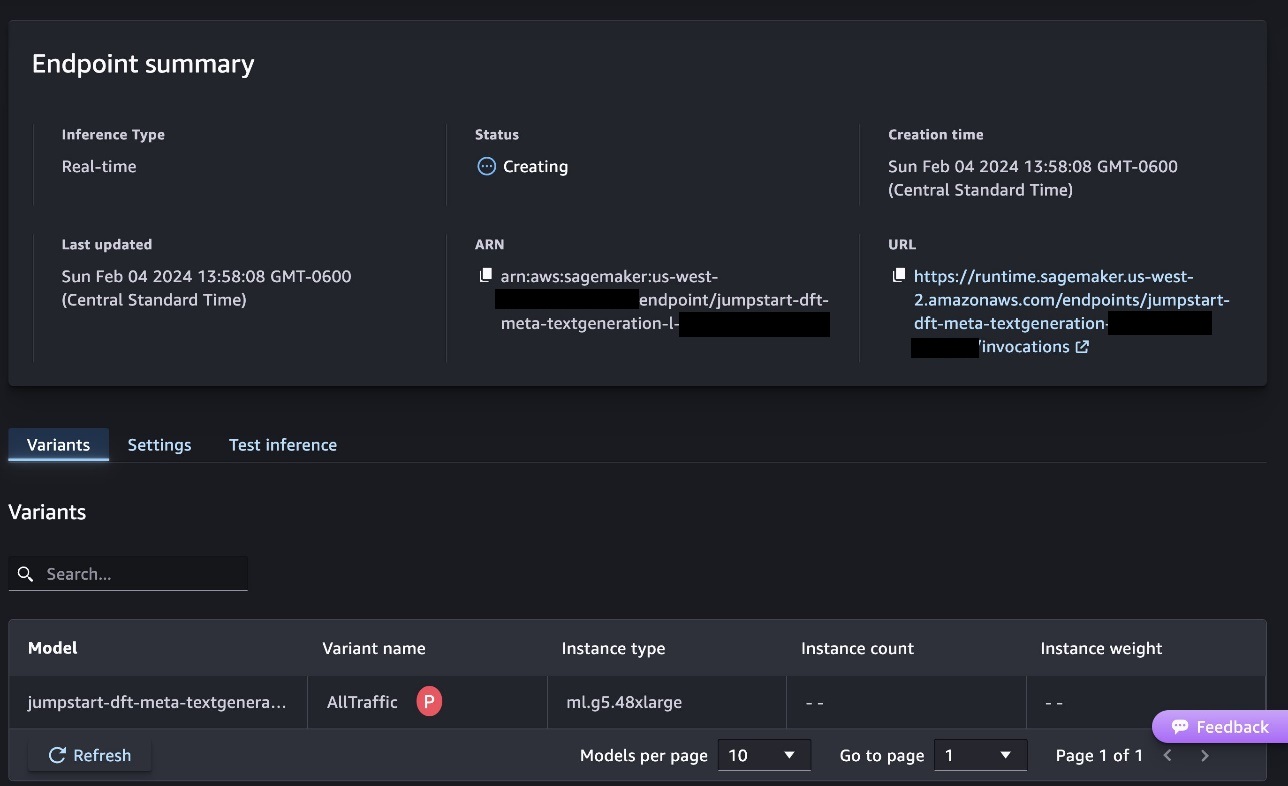

همانطور که در تصویر زیر نشان داده شده است، فرآیند استقرار نقطه پایانی آغاز می شود.

مدل را با SageMaker Python SDK اجرا کنید

از طرف دیگر، می توانید با انتخاب از طریق دفترچه یادداشت نمونه مستقر شوید نوت بوک را باز کنید در صفحه جزئیات مدل کلاسیک استودیو. دفترچه یادداشت نمونه راهنمایی سرتاسری در مورد نحوه استقرار مدل برای استنتاج و پاکسازی منابع ارائه می دهد.

برای استقرار با استفاده از نوت بوک، با انتخاب یک مدل مناسب شروع می کنیم، مشخص شده توسط model_id. می توانید هر یک از مدل های انتخاب شده را با کد زیر در SageMaker مستقر کنید:

این مدل را در SageMaker با تنظیمات پیشفرض، از جمله نوع نمونه پیشفرض و تنظیمات پیشفرض VPC، مستقر میکند. شما می توانید این تنظیمات را با تعیین مقادیر غیر پیش فرض در آن تغییر دهید JumpStartModel. توجه داشته باشید که به طور پیش فرض، accept_eula تنظیم شده است False. باید تنظیم کنید accept_eula=True برای استقرار نقطه پایانی با موفقیت با انجام این کار، موافقت نامه مجوز کاربر و خط مشی استفاده قابل قبول را همانطور که قبلا ذکر شد می پذیرید. شما همچنین می توانید دانلود قرارداد مجوز

یک نقطه پایانی SageMaker را فراخوانی کنید

پس از استقرار نقطه پایانی، می توانید با استفاده از Boto3 یا SageMaker Python SDK استنتاج انجام دهید. در کد زیر از SageMaker Python SDK برای فراخوانی مدل برای استنتاج و چاپ پاسخ استفاده میکنیم:

تابع print_response محموله ای متشکل از محموله و پاسخ مدل را می گیرد و خروجی را چاپ می کند. Code Llama هنگام انجام استنتاج از پارامترهای زیادی پشتیبانی می کند:

- بیشترین طول – مدل تا زمانی که طول خروجی (که شامل طول متن ورودی است) برسد، متن تولید می کند

max_length. اگر مشخص شود، باید یک عدد صحیح مثبت باشد. - max_new_tokens – مدل تا زمانی که طول خروجی (به استثنای طول زمینه ورودی) به آن برسد، متن تولید می کند

max_new_tokens. اگر مشخص شود، باید یک عدد صحیح مثبت باشد. - num_beams – این تعداد پرتوهای مورد استفاده در جستجوی حریصانه را مشخص می کند. اگر مشخص شود، باید یک عدد صحیح بزرگتر یا مساوی باشد

num_return_sequences. - no_repeat_ngram_size - مدل تضمین می کند که دنباله ای از کلمات

no_repeat_ngram_sizeدر توالی خروجی تکرار نمی شود. اگر مشخص شده باشد، باید یک عدد صحیح مثبت بزرگتر از 1 باشد. - درجه حرارت - این امر تصادفی بودن خروجی را کنترل می کند. بالاتر

temperatureمنجر به یک دنباله خروجی با کلمات کم احتمال و کمتر می شودtemperatureمنجر به یک دنباله خروجی با کلمات با احتمال بالا می شود. اگرtemperature0 است، منجر به رمزگشایی حریصانه می شود. اگر مشخص شود، باید شناور مثبت باشد. - زود_توقف - اگر

True، تولید متن زمانی به پایان می رسد که همه فرضیه های پرتو به پایان نشانه جمله برسند. اگر مشخص شده باشد، باید Boolean باشد. - do_sample - اگر

True، مدل کلمه بعدی را بر اساس احتمال نمونه برداری می کند. اگر مشخص شده باشد، باید Boolean باشد. - top_k – در هر مرحله از تولید متن، مدل فقط از متن نمونه برداری می کند

top_kبه احتمال زیاد کلمات اگر مشخص شود، باید یک عدد صحیح مثبت باشد. - top_p - در هر مرحله از تولید متن، مدل از کوچکترین مجموعه ممکن کلمات با احتمال تجمعی نمونه برداری می کند.

top_p. اگر مشخص شده باشد، باید شناور بین 0 و 1 باشد. - بازگشت_متن_کامل - اگر

True، متن ورودی بخشی از متن تولید شده خروجی خواهد بود. اگر مشخص شده باشد، باید Boolean باشد. مقدار پیش فرض برای آن استFalse. - متوقف کردن – اگر مشخص شده باشد، باید فهرستی از رشته ها باشد. اگر هر یک از رشته های مشخص شده تولید شود، تولید متن متوقف می شود.

شما می توانید هر زیر مجموعه ای از این پارامترها را هنگام فراخوانی یک نقطه پایانی مشخص کنید. در مرحله بعد، نمونه ای از نحوه فراخوانی یک نقطه پایانی با این آرگومان ها را نشان می دهیم.

تکمیل کد

مثالهای زیر نحوه تکمیل کد را نشان میدهند که در آن پاسخ نقطه پایانی مورد انتظار ادامه طبیعی دستور است.

ابتدا کد زیر را اجرا می کنیم:

خروجی زیر را دریافت می کنیم:

برای مثال بعدی ما کد زیر را اجرا می کنیم:

خروجی زیر را دریافت می کنیم:

تولید کد

مثالهای زیر تولید کد پایتون را با استفاده از Code Llama نشان میدهند.

ابتدا کد زیر را اجرا می کنیم:

خروجی زیر را دریافت می کنیم:

برای مثال بعدی ما کد زیر را اجرا می کنیم:

خروجی زیر را دریافت می کنیم:

اینها نمونه هایی از کارهای مرتبط با کد با استفاده از Code Llama 70B هستند. می توانید از مدل برای تولید کدهای پیچیده تر استفاده کنید. ما شما را تشویق می کنیم که آن را با استفاده از موارد و نمونه های استفاده مرتبط با کد خود امتحان کنید!

پاک کردن

پس از اینکه نقاط پایانی را آزمایش کردید، مطمئن شوید که نقاط پایانی استنتاج SageMaker و مدل را حذف کرده اید تا از تحمیل هزینه جلوگیری کنید. از کد زیر استفاده کنید:

نتیجه

در این پست Code Llama 70B را در SageMaker JumpStart معرفی کردیم. Code Llama 70B یک مدل پیشرفته برای تولید کد از دستورات زبان طبیعی و همچنین کد است. میتوانید مدل را با چند مرحله ساده در SageMaker JumpStart اجرا کنید و سپس از آن برای انجام کارهای مرتبط با کد مانند تولید کد و تکمیل کد استفاده کنید. به عنوان گام بعدی، سعی کنید از مدل با موارد استفاده و داده های مربوط به کد خود استفاده کنید.

درباره نویسندگان

دکتر کایل اولریش یک دانشمند کاربردی با تیم آمازون SageMaker JumpStart است. علایق تحقیقاتی او شامل الگوریتم های یادگیری ماشین مقیاس پذیر، بینایی کامپیوتر، سری های زمانی، ناپارامتریک های بیزی و فرآیندهای گاوسی است. دکترای او از دانشگاه دوک است و مقالاتی در NeurIPS، Cell و Neuron منتشر کرده است.

دکتر کایل اولریش یک دانشمند کاربردی با تیم آمازون SageMaker JumpStart است. علایق تحقیقاتی او شامل الگوریتم های یادگیری ماشین مقیاس پذیر، بینایی کامپیوتر، سری های زمانی، ناپارامتریک های بیزی و فرآیندهای گاوسی است. دکترای او از دانشگاه دوک است و مقالاتی در NeurIPS، Cell و Neuron منتشر کرده است.

دکتر فاروق صابر یک معمار ارشد راه حل های متخصص هوش مصنوعی و یادگیری ماشین در AWS است. او دارای مدرک دکتری و کارشناسی ارشد در مهندسی برق از دانشگاه تگزاس در آستین و کارشناسی ارشد در علوم کامپیوتر از موسسه فناوری جورجیا است. او بیش از 15 سال سابقه کار دارد و همچنین دوست دارد به دانشجویان کالج تدریس و راهنمایی کند. او در AWS به مشتریان کمک می کند تا مشکلات تجاری خود را در زمینه علم داده، یادگیری ماشین، بینایی کامپیوتر، هوش مصنوعی، بهینه سازی عددی و حوزه های مرتبط فرموله و حل کنند. او و خانواده اش که در دالاس، تگزاس مستقر هستند، عاشق سفر و رفتن به سفرهای جاده ای طولانی هستند.

دکتر فاروق صابر یک معمار ارشد راه حل های متخصص هوش مصنوعی و یادگیری ماشین در AWS است. او دارای مدرک دکتری و کارشناسی ارشد در مهندسی برق از دانشگاه تگزاس در آستین و کارشناسی ارشد در علوم کامپیوتر از موسسه فناوری جورجیا است. او بیش از 15 سال سابقه کار دارد و همچنین دوست دارد به دانشجویان کالج تدریس و راهنمایی کند. او در AWS به مشتریان کمک می کند تا مشکلات تجاری خود را در زمینه علم داده، یادگیری ماشین، بینایی کامپیوتر، هوش مصنوعی، بهینه سازی عددی و حوزه های مرتبط فرموله و حل کنند. او و خانواده اش که در دالاس، تگزاس مستقر هستند، عاشق سفر و رفتن به سفرهای جاده ای طولانی هستند.

ژوئن برد یک مدیر محصول با SageMaker JumpStart است. او بر روی ساخت مدل های پایه به راحتی قابل کشف و استفاده برای کمک به مشتریان در ساخت برنامه های کاربردی هوش مصنوعی تمرکز دارد. تجربه او در آمازون همچنین شامل اپلیکیشن خرید موبایلی و تحویل آخرین مایل است.

ژوئن برد یک مدیر محصول با SageMaker JumpStart است. او بر روی ساخت مدل های پایه به راحتی قابل کشف و استفاده برای کمک به مشتریان در ساخت برنامه های کاربردی هوش مصنوعی تمرکز دارد. تجربه او در آمازون همچنین شامل اپلیکیشن خرید موبایلی و تحویل آخرین مایل است.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/code-llama-70b-is-now-available-in-amazon-sagemaker-jumpstart/

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 000

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- سال 15

- ٪۱۰۰

- 16

- 22

- 25

- 500

- 7

- 80

- 9

- a

- درباره ما

- پذیرفتن

- قابل قبول

- پذیرش

- دسترسی

- پیشرفت

- توافق

- AI

- الگوریتم

- معرفی

- همچنین

- آمازون

- آمازون SageMaker

- Amazon SageMaker JumpStart

- آمازون خدمات وب

- an

- و

- اعلام

- هر

- کاربرد

- برنامه های کاربردی

- اعمال می شود

- مناسب

- هستند

- استدلال

- هنر

- مصنوعی

- هوش مصنوعی

- هوش مصنوعی و یادگیری ماشین

- AS

- دستیار

- مطمئن

- At

- آستین

- در دسترس

- اجتناب از

- AWS

- پایه

- مستقر

- بر هم زدن

- بیزی

- BE

- پرتو

- زیرا

- میان

- بیلیون

- میلیارد توکن

- میلیاردها

- هر دو

- حباب

- ساختن

- ساخته

- کسب و کار

- by

- ++C

- صدا

- CAN

- توانا

- کارت

- حمل

- موارد

- دسته بندی

- سلول

- تغییر دادن

- مشخصات

- بار

- را انتخاب کنید

- انتخاب

- کلاس

- کلاسیک

- تمیز

- کلیک

- رمز

- کالج

- بیا

- می آید

- کامل

- اتمام

- بغرنج

- کامپیوتر

- علم کامپیوتر

- چشم انداز کامپیوتر

- شامل

- کنسول

- محتوا

- زمینه

- ادامه

- گروه شاهد

- پوشش

- ایجاد

- سرپرستی

- مشتریان

- دالاس

- داده ها

- علم اطلاعات

- رمز گشایی

- به طور پیش فرض

- تحویل

- نشان دادن

- گسترش

- مستقر

- گسترش

- مستقر می کند

- طراحی

- جزئیات

- توسعه

- توسعه دهندگان

- پروژه

- مختلف

- دیجیتال

- هنر دیجیتال

- كشف كردن

- do

- عمل

- حوزه

- دوک

- دانشگاه دوک

- هر

- پیش از آن

- به آسانی

- موثر

- را قادر می سازد

- تشویق

- پایان

- پشت سر هم

- نقطه پایانی

- مهندسی

- مهندسی

- تضمین می کند

- برابر

- خطا

- ارزیابی

- حتی

- مثال

- مثال ها

- اکسل

- جز

- برانگیخته

- به استثنای

- موجود

- انتظار می رود

- گران

- تجربه

- نمایی

- چهره

- خانواده

- کمی از

- پیدا کردن

- نام خانوادگی

- شناور

- تمرکز

- پیروی

- برای

- پایه

- بنیادین

- چهار

- از جانب

- تابع

- تولید می کنند

- تولید

- تولید می کند

- مولد

- نسل

- نسل ها

- مولد

- هوش مصنوعی مولد

- گرجستان

- دریافت کنید

- داده

- Go

- بیشتر

- حریص

- راهنمایی

- آیا

- he

- کمک

- کمک

- کمک می کند

- با کیفیت بالا

- بالاتر

- خود را

- دارای

- صفحه اصلی

- میزبان

- میزبانی

- چگونه

- چگونه

- HTTPS

- قطب

- هاب

- i

- دلخواه

- if

- واردات

- بهبود

- ارتقاء

- in

- شامل

- شامل

- از جمله

- افزایشی

- اطلاعات

- ورودی

- ورودی

- نمونه

- موسسه

- دستورالعمل

- اطلاعات

- منافع

- معرفی

- IT

- جاوه

- JPG

- شناخته شده

- کایل

- زبان

- بزرگ

- نام

- یادگیری

- ترک

- طول

- مجوز

- احتمال

- احتمالا

- دوست دارد

- فهرست

- پشم لاما

- LLM

- طولانی

- عشق

- کاهش

- دستگاه

- فراگیری ماشین

- ساخته

- ساخت

- ساخت

- مدیر

- بسیاری

- ذکر شده

- مربی

- متا

- مایل

- ML

- موبایل

- مدل

- مدل

- بیش

- کارآمدتر

- اکثر

- MS

- باید

- طبیعی

- جهت یابی

- نیاز

- ضروری

- هرگز

- جدید

- بعد

- توجه داشته باشید

- دفتر یادداشت

- اکنون

- عدد

- of

- on

- ONE

- آنهایی که

- فقط

- بهینه سازی

- گزینه

- or

- ما

- خارج

- تولید

- روی

- خود

- با ما

- قطعه

- اوراق

- پارامترهای

- بخش

- احزاب

- برای

- انجام

- انجام

- دکترا

- پی اچ پی

- افلاطون

- هوش داده افلاطون

- PlatoData

- سیاست

- محبوب

- مثبت

- ممکن

- پست

- پتانسیل

- پیشگو

- چاپ

- چاپ

- مشکلات

- روند

- فرآیندهای

- محصول

- مدیر تولید

- بهره وری

- برنامه نويسي

- پرسیدن

- ارائه

- ارائه دهندگان

- فراهم می کند

- منتشر شده

- پــایتــون

- مارماهی

- به سرعت

- تصادفی بودن

- محدوده

- نسبتا

- رسیدن به

- می رسد

- اخیر

- مربوط

- منتشر شد

- مکرر

- تحقیق

- منابع

- پاسخ

- REST

- نتایج

- برگشت

- معکوس

- این فایل نقد می نویسید:

- طلوع

- جاده

- دویدن

- در حال اجرا

- حکیم ساز

- استنباط SageMaker

- همان

- ذخیره

- مقیاس پذیر

- مقیاس

- علم

- دانشمند

- sdk

- جستجو

- انتخاب شد

- انتخاب

- ارشد

- جمله

- دنباله

- سلسله

- خدمات

- تنظیم

- تنظیمات

- به اشتراک گذاشته شده

- خريد كردن

- نشان

- نشان داده شده

- نشان می دهد

- ساده

- اندازه

- So

- نرم افزار

- مزایا

- حل

- برخی از

- متخصص

- تخصصی

- مشخص شده

- مشخص کردن

- پایدار

- شروع

- آغاز شده

- وضعیت هنر

- گام

- مراحل

- توقف

- رشته

- دانشجویان

- استودیو

- موفقیت

- چنین

- پشتیبانی

- پشتیبانی از

- مطمئن

- اطراف

- طول می کشد

- وظایف

- تیم

- پیشرفته

- جریان تنسور

- قوانین و مقررات

- آزمون

- آزمایش

- وابسته به تکزاس

- متن

- نسبت به

- که

- La

- شان

- آنها

- خودشان

- سپس

- اینها

- سوم

- اشخاص ثالث

- این

- سه

- از طریق

- زمان

- سری زمانی

- به

- رمز

- نشانه

- بالا

- قطار

- آموزش دیده

- ترجمه

- سفر

- گذشتن از

- درست

- امتحان

- نوع

- حروفچینی

- به طور معمول

- ui

- زیر

- درک

- دانشگاه

- تا

- قابل استفاده

- استفاده

- استفاده کنید

- استفاده

- کاربر

- با استفاده از

- ارزش

- ارزشها

- تنوع

- نسخه

- از طريق

- دید

- راه رفتن

- می خواهم

- we

- وب

- خدمات وب

- خوب

- بود

- چه زمانی

- چه

- که

- در حین

- وسیع

- ویدجت

- اراده

- با

- در داخل

- بدون

- کلمه

- کلمات

- مهاجرت کاری

- گردش کار

- گردش کار

- نوشتن

- سال

- شما

- شما

- زفیرنت