لبه اصطلاحی است که به مکانی، دور از ابر یا یک مرکز داده بزرگ، که در آن یک دستگاه کامپیوتری (دستگاه لبه) قادر به اجرای برنامههای کاربردی (لبه) دارید، اشاره دارد. محاسبات لبه عمل اجرای بارهای کاری در این دستگاه های لبه است. یادگیری ماشینی در لبه (ML@Edge) مفهومی است که قابلیت اجرای مدلهای ML را به صورت محلی به دستگاههای لبه میآورد. سپس این مدل های ML می توانند توسط برنامه edge فراخوانی شوند. ML@Edge برای بسیاری از سناریوهایی که دادههای خام از منابع دور از ابر جمعآوری میشوند، مهم است. این سناریوها همچنین ممکن است الزامات یا محدودیت های خاصی داشته باشند:

- پیش بینی های با تاخیر کم و در زمان واقعی

- اتصال ضعیف یا عدم وجود اتصال به ابر

- محدودیت های قانونی که اجازه ارسال داده به سرویس های خارجی را نمی دهد

- مجموعه دادههای بزرگی که باید قبل از ارسال پاسخها به ابر، به صورت محلی پردازش شوند

موارد زیر برخی از موارد استفاده بسیاری هستند که میتوانند از مدلهای ML که نزدیک به تجهیزاتی که دادههای مورد استفاده برای پیشبینیها را تولید میکنند، بهرهمند شوند:

- امنیت و ایمنی - یک منطقه محدود که در آن ماشین های سنگین در یک پورت خودکار کار می کنند توسط یک دوربین نظارت می شود. اگر فردی به اشتباه وارد این منطقه شود، مکانیزم ایمنی برای متوقف کردن ماشین ها و محافظت از انسان فعال می شود.

- تعمیرات قابل پیش بینی - سنسورهای لرزش و صدا داده ها را از جعبه دنده یک توربین بادی جمع آوری می کنند. یک مدل تشخیص ناهنجاری دادههای حسگر را پردازش میکند و در صورت وجود ناهنجاری در تجهیزات شناسایی میکند. اگر یک ناهنجاری تشخیص داده شود، دستگاه لبه میتواند برای جلوگیری از آسیب رساندن به تجهیزات، اندازهگیری احتمالی را در زمان واقعی شروع کند، مانند درگیر کردن خرابیها یا جدا کردن ژنراتور از شبکه.

- تشخیص عیب در خطوط تولید - یک دوربین تصاویری از محصولات را روی یک تسمه نقاله می گیرد و فریم ها را با یک مدل طبقه بندی تصویر پردازش می کند. در صورت تشخیص نقص، محصول را می توان به طور خودکار و بدون دخالت دست دور انداخت.

اگرچه ML@Edge میتواند موارد استفاده زیادی را برطرف کند، اما چالشهای معماری پیچیدهای وجود دارد که برای داشتن طراحی ایمن، قوی و قابل اعتماد باید حل شوند. در این پست، جزئیاتی در مورد ML@Edge، موضوعات مرتبط، و نحوه استفاده از خدمات AWS برای غلبه بر این چالشها و پیادهسازی یک راهحل کامل برای ML خود در بار کاری لبه، یاد میگیرید.

نمای کلی ML@Edge

در مورد ML@Edge و اینترنت اشیا (IoT) یک سردرگمی رایج وجود دارد، بنابراین مهم است که مشخص شود ML@Edge چه تفاوتی با IoT دارد و چگونه هر دو میتوانند برای ارائه یک راهحل قدرتمند در موارد خاص گرد هم آیند.

راه حل لبه ای که از ML@Edge استفاده می کند دارای دو جزء اصلی است: یک برنامه لبه و یک مدل ML (که توسط برنامه فراخوانی می شود) که روی دستگاه لبه اجرا می شود. ML@Edge در مورد کنترل چرخه عمر یک یا چند مدل ML است که در ناوگانی از دستگاه های لبه استفاده می شود. چرخه عمر مدل ML می تواند از سمت ابر شروع شود (روشن آمازون SageMakerبه عنوان مثال) اما معمولاً با استقرار مستقل مدل در دستگاه لبه خاتمه می یابد. هر سناریو نیازمند چرخههای عمر مدل ML متفاوتی است که میتواند توسط مراحل متعددی مانند جمعآوری دادهها تشکیل شود. آماده سازی داده ها؛ ساخت مدل، کامپایل و استقرار در دستگاه لبه. بارگذاری و اجرای مدل؛ و تکرار چرخه زندگی

مکانیزم ML@Edge مسئول چرخه عمر برنامه نیست. برای این منظور باید رویکرد متفاوتی اتخاذ شود. جدا کردن چرخه عمر مدل ML و چرخه عمر برنامه به شما آزادی و انعطاف پذیری می دهد تا آنها را با سرعت های مختلف تکامل دهید. یک برنامه تلفن همراه را تصور کنید که یک مدل ML را به عنوان منبعی مانند تصویر یا فایل XML تعبیه کرده است. در این حالت، هر بار که یک مدل جدید را آموزش میدهید و میخواهید آن را در تلفنهای همراه مستقر کنید، باید کل برنامه را مجدداً نصب کنید. این کار باعث صرف زمان و هزینه می شود و می تواند باگ هایی را در برنامه شما ایجاد کند. با جدا کردن چرخه عمر مدل ML، برنامه تلفن همراه را یک بار منتشر می کنید و هر تعداد نسخه از مدل ML را که نیاز دارید به کار می برید.

اما اینترنت اشیا چگونه با ML@Edge ارتباط دارد؟ اینترنت اشیا به اشیاء فیزیکی تعبیه شده با فناوری هایی مانند حسگرها، توانایی پردازش و نرم افزار مربوط می شود. این اشیاء به منظور تبادل داده ها از طریق اینترنت یا سایر شبکه های ارتباطی به دستگاه ها و سیستم های دیگر متصل می شوند. شکل زیر این معماری را نشان می دهد. این مفهوم در ابتدا زمانی ایجاد شد که به دستگاههای سادهای فکر میکردیم که فقط دادهها را از لبه جمعآوری میکنند، پردازش محلی ساده را انجام میدهند و نتیجه را به یک واحد محاسباتی قدرتمندتر ارسال میکنند که فرآیندهای تحلیلی را اجرا میکند که به افراد و شرکتها در تصمیمگیری کمک میکند. راه حل IoT مسئول کنترل چرخه عمر برنامه لبه است. برای اطلاعات بیشتر در مورد اینترنت اشیا به ادامه مطلب مراجعه کنید اینترنت چیزها.

اگر قبلاً یک برنامه IoT دارید، میتوانید مانند شکل زیر، قابلیتهای ML@Edge را برای کارآمدتر کردن محصول اضافه کنید. به خاطر داشته باشید که ML@Edge به اینترنت اشیا وابسته نیست، اما میتوانید آنها را برای ایجاد راهحل قدرتمندتر ترکیب کنید. وقتی این کار را انجام میدهید، پتانسیل دستگاه ساده خود را برای ایجاد بینش در زمان واقعی برای کسبوکارتان سریعتر از ارسال دادهها به ابر برای پردازش بعدی بهبود میبخشید.

اگر از ابتدا یک راه حل لبه جدید با قابلیت های ML@Edge ایجاد می کنید، طراحی یک معماری انعطاف پذیر که از چرخه عمر برنامه و مدل ML پشتیبانی می کند بسیار مهم است. چند معماری مرجع برای برنامههای لبه با ML@Edge در این پست ارائه میکنیم. اما ابتدا، بیایید عمیقتر به محاسبات لبه بپردازیم و بیاموزیم که چگونه بر اساس محدودیتهای محیط، دستگاه لبه مناسب را برای راهحل خود انتخاب کنیم.

محاسبات لبه

بسته به اینکه دستگاه تا چه اندازه از ابر یا یک مرکز داده بزرگ (پایه) فاصله دارد، سه ویژگی اصلی دستگاه های لبه برای به حداکثر رساندن عملکرد و طول عمر سیستم باید در نظر گرفته شود: ظرفیت محاسباتی و ذخیره سازی، اتصال و مصرف انرژی. نمودار زیر سه گروه از دستگاه های لبه را نشان می دهد که بسته به فاصله آنها از پایه، مشخصات متفاوتی از این ویژگی ها را با هم ترکیب می کنند.

گروه ها به شرح زیر است:

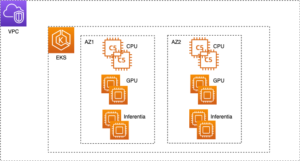

- MEC (محاسبات لبه با دسترسی چندگانه) – MEC ها یا مراکز داده کوچک که با تأخیر کم یا بسیار کم و پهنای باند بالا مشخص می شوند، محیط های رایجی هستند که ML@Edge می تواند بدون محدودیت های بزرگ در مقایسه با حجم کاری ابری، مزایایی را به همراه داشته باشد. آنتنها و سرورهای 5G در کارخانهها، انبارها، آزمایشگاهها و غیره با حداقل محدودیت انرژی و با اتصال به اینترنت خوب، راههای مختلفی را برای اجرای مدلهای ML بر روی GPU و CPU، ماشینهای مجازی، کانتینرها و سرورهای فلزی خالی ارائه میدهند.

- نزدیک لبه – این زمانی است که تحرک یا تجمیع دادهها الزامی است و دستگاهها محدودیتهایی در رابطه با مصرف انرژی و قدرت پردازش دارند، اما همچنان دارای اتصال قابل اعتماد هستند، اگرچه با تأخیر بالاتر، با توان عملیاتی محدود و گرانتر از «نزدیک به لبه». برنامه های موبایل، بردهای خاص برای شتاب دادن به مدل های ML یا دستگاه های ساده با ظرفیت اجرای مدل های ML که تحت پوشش شبکه های بی سیم قرار دارند، در این گروه قرار می گیرند.

- لبه دور - در این سناریوی شدید، دستگاه های لبه دارای محدودیت های مصرف انرژی یا اتصال شدید هستند. در نتیجه، قدرت پردازش نیز در بسیاری از سناریوهای لبه دور محدود است. کشاورزی، معدن، نظارت و امنیت، و حمل و نقل دریایی برخی از مناطقی هستند که دستگاه های لبه دور نقش مهمی را ایفا می کنند. بردهای ساده، معمولاً بدون پردازنده گرافیکی یا سایر شتاب دهنده های هوش مصنوعی، رایج هستند. آنها برای بارگذاری و اجرای مدل های ساده ML، ذخیره پیش بینی ها در یک پایگاه داده محلی و خواب تا چرخه پیش بینی بعدی طراحی شده اند. دستگاههایی که نیاز به پردازش دادههای بلادرنگ دارند، میتوانند ذخیرهسازی محلی بزرگی برای جلوگیری از از دست دادن دادهها داشته باشند.

چالش ها

معمولاً سناریوهای ML@Edge وجود دارد که در آن صدها یا هزاران (شاید میلیونها) دستگاه دارید که از مدلها و برنامههای کاربردی لبه مشابهی استفاده میکنند. هنگامی که سیستم خود را مقیاس بندی می کنید، داشتن یک راه حل قوی که می تواند تعداد دستگاه هایی را که باید پشتیبانی کنید مدیریت کند، مهم است. این یک کار پیچیده است و برای این سناریوها، شما باید سوالات زیادی بپرسید:

- چگونه می توانم مدل های ML را در ناوگانی از دستگاه های لبه کار کنم؟

- چگونه می توانم مدل های ML را در چندین دستگاه لبه بسازم، بهینه سازی کنم و مستقر کنم؟

- چگونه می توانم مدل خود را در حین استقرار و اجرای آن در لبه ایمن کنم؟

- چگونه می توانم عملکرد مدل خود را کنترل کنم و در صورت نیاز آن را دوباره آموزش دهم؟

- چگونه می توانم نیاز به نصب یک چارچوب بزرگ مانند TensorFlow یا PyTorch را بر روی دستگاه محدود خود حذف کنم؟

- چگونه یک یا چند مدل را با برنامه لبه خود به عنوان یک API ساده در معرض دید قرار دهم؟

- چگونه می توانم یک مجموعه داده جدید با بارگذاری ها و پیش بینی های ثبت شده توسط دستگاه های لبه ایجاد کنم؟

- چگونه می توانم همه این وظایف را به طور خودکار انجام دهم (MLOps به علاوه ML@Edge)؟

در بخش بعدی، پاسخ تمام این سوالات را از طریق موارد استفاده مثال و معماری های مرجع ارائه می کنیم. ما همچنین بحث می کنیم که کدام سرویس های AWS را می توانید برای ایجاد راه حل های کامل برای هر یک از سناریوهای بررسی شده ترکیب کنید. با این حال، اگر می خواهید با یک جریان بسیار ساده شروع کنید که نحوه استفاده از برخی از خدمات ارائه شده توسط AWS برای ایجاد راه حل ML@Edge را توضیح می دهد، این یک مثال است:

با SageMaker، می توانید به راحتی یک مجموعه داده تهیه کنید و مدل های ML را بسازید که در دستگاه های لبه مستقر شده اند. با Amazon SageMaker Neo، می توانید مدلی را که آموزش داده اید در دستگاه لبه خاصی که انتخاب کرده اید کامپایل و بهینه کنید. پس از کامپایل مدل، برای اجرای آن فقط به یک زمان اجرای سبک (ارائه شده توسط سرویس) نیاز دارید. Amazon SageMaker Edge Manager مسئولیت مدیریت چرخه عمر تمام مدل های ML استقرار یافته در ناوگان دستگاه های لبه شما را بر عهده دارد. Edge Manager می تواند ناوگان تا میلیون ها دستگاه را مدیریت کند. یک عامل، نصب شده در هر یک از دستگاه های لبه، مدل های ML مستقر شده را به عنوان یک API در معرض برنامه کاربردی قرار می دهد. عامل همچنین مسئول جمعآوری معیارها، بارهای بار و پیشبینیهایی است که میتوانید از آنها برای نظارت یا ساخت یک مجموعه داده جدید برای آموزش مجدد مدل در صورت نیاز استفاده کنید. در نهایت، با خطوط لوله آمازون SageMaker، می توانید یک خط لوله خودکار با تمام مراحل مورد نیاز برای ساخت، بهینه سازی و استقرار مدل های ML در ناوگان دستگاه های خود ایجاد کنید. سپس این خط لوله خودکار می تواند با رویدادهای ساده ای که شما تعریف می کنید، بدون دخالت انسان راه اندازی شود.

مورد استفاده 1

فرض کنید یک سازنده هواپیما می خواهد قطعات و ابزارها را در آشیانه تولید شناسایی و ردیابی کند. برای بهبود بهره وری، تمام قطعات مورد نیاز و ابزار صحیح باید در هر مرحله از تولید در دسترس مهندسان باشد. ما می خواهیم بتوانیم به سوالاتی مانند: قسمت A کجاست پاسخ دهیم؟ یا ابزار B کجاست؟ ما چندین دوربین IP قبلاً نصب و به یک شبکه محلی متصل شدهایم. دوربین ها کل آشیانه را پوشش می دهند و می توانند ویدیوهای HD را در زمان واقعی از طریق شبکه پخش کنند.

پانوراما AWS در این مورد به خوبی جا می شود AWS Panorama یک دستگاه ML و سرویس مدیریت شده را ارائه می دهد که به شما امکان می دهد بینایی کامپیوتری (CV) را به ناوگان دوربین های IP موجود خود اضافه کنید و خودکار کنید. AWS Panorama به شما این امکان را می دهد که CV را به دوربین های پروتکل اینترنت (IP) موجود خود اضافه کنید و کارهایی را که به طور سنتی به بازرسی و نظارت انسانی نیاز دارند، خودکار کنید.

در معماری مرجع زیر، اجزای اصلی برنامه را نشان میدهیم که روی یک دستگاه پانوراما AWS اجرا میشوند. Panorama Application SDK گرفتن ویدئو از جریان های دوربین، انجام استنتاج با خط لوله ای از چندین مدل ML و پردازش نتایج با استفاده از کد پایتون در حال اجرا در داخل یک ظرف را آسان می کند. میتوانید مدلهایی را از هر کتابخانه معروف ML مانند TensorFlow، PyTorch یا TensorRT اجرا کنید. نتایج حاصل از مدل را می توان با سیستم های تجاری در شبکه محلی شما ادغام کرد و به شما امکان می دهد به رویدادها در زمان واقعی پاسخ دهید.

راه حل شامل مراحل زیر است:

- یک دستگاه پانوراما AWS را به همان شبکه محلی متصل و پیکربندی کنید.

- آموزش یک مدل ML (تشخیص اشیا) برای شناسایی قطعات و ابزارها در هر فریم.

- یک برنامه پانوراما AWS بسازید که پیشبینیهای مدل ML را دریافت میکند، مکانیزم ردیابی را برای هر شی اعمال میکند و نتایج را به یک پایگاه داده بلادرنگ ارسال میکند.

- اپراتورها می توانند پرس و جوهایی را برای یافتن قطعات و ابزارها به پایگاه داده ارسال کنند.

مورد استفاده 2

برای استفاده بعدی، تصور کنید که ما در حال ایجاد یک داشکام برای وسایل نقلیه هستیم که قادر به پشتیبانی از راننده در بسیاری از موقعیتها، مانند اجتناب از عابران پیاده، بر اساس برد CV25 از Ambaralla. میزبانی مدل های ML در دستگاهی با منابع سیستم محدود می تواند دشوار باشد. در این مورد، بیایید فرض کنیم که در حال حاضر یک مکانیسم تحویل هوایی (OTA) به خوبی تثبیت شده برای استقرار اجزای برنامه مورد نیاز روی دستگاه لبه داریم. با این حال، ما همچنان از توانایی استقرار OTA خود مدل سود میبریم و در نتیجه چرخه عمر برنامه و چرخه عمر مدل را جدا میکنیم.

Amazon SageMaker Edge Manager و Amazon SageMaker Neo مناسب برای این مورد استفاده است.

Edge Manager استفاده از ابزارهای آشنای مشابه را در ابر یا در دستگاه های لبه برای توسعه دهندگان ML edge آسان می کند. زمان و تلاش لازم برای تولید مدلها را کاهش میدهد، در حالی که به شما امکان میدهد به طور مداوم کیفیت مدل را در ناوگان دستگاه خود کنترل و بهبود دهید. SageMaker Edge شامل یک مکانیسم استقرار OTA است که به شما کمک می کند تا مدل ها را مستقل از برنامه یا سیستم عامل دستگاه در ناوگان مستقر کنید. را عامل Edge Manager به شما امکان می دهد چندین مدل را روی یک دستگاه اجرا کنید. عامل دادههای پیشبینی را بر اساس منطقی که شما کنترل میکنید، مانند فواصل زمانی، جمعآوری میکند و آنها را در فضای ابری آپلود میکند تا بتوانید بهطور دورهای مدلهای خود را در طول زمان دوباره آموزش دهید. SageMaker Edge مدلهای شما را بهصورت رمزنگاری امضا میکند تا بتوانید در حین حرکت از ابر به دستگاه لبه، تأیید کنید که دستکاری نشده است.

Neo یک کامپایلر بهعنوان یک سرویس است و بهویژه در این مورد مناسب مناسب است. Neo بهطور خودکار مدلهای ML را برای استنتاج در نمونههای ابری و دستگاههای لبه بهینه میکند تا سریعتر و بدون کاهش دقت اجرا شوند. شما با یک مدل ML که با یکی از آنها ساخته شده است شروع می کنید چارچوب های پشتیبانی شده و در SageMaker یا هر جای دیگری آموزش دیده است. سپس پلتفرم سخت افزاری مورد نظر خود را انتخاب می کنید، (به لیست مراجعه کنید دستگاه های پشتیبانی شده). با یک کلیک، Neo مدل آموزش دیده را بهینه می کند و آن را در بسته ای کامپایل می کند که می تواند با استفاده از زمان اجرا سبک SageMaker Edge اجرا شود. کامپایلر از یک مدل ML برای اعمال بهینه سازی های عملکردی استفاده می کند که بهترین عملکرد موجود را برای مدل شما در نمونه ابری یا دستگاه لبه استخراج می کند. سپس مدل را به عنوان نقطه پایانی SageMaker یا در دستگاه های لبه پشتیبانی شده مستقر کرده و شروع به پیش بینی می کنید.

نمودار زیر این معماری را نشان می دهد.

گردش کار راه حل شامل مراحل زیر است:

- توسعهدهنده نمونه نهایی را میسازد، آموزش میدهد، تأیید میکند و میسازد که باید در dashcam مستقر شود.

- برای کامپایل کردن مدل آموزش دیده، نئو را فراخوانی کنید.

- عامل SageMaker Edge بر روی دستگاه Edge، در این مورد داشکم، نصب و پیکربندی شده است.

- یک بسته استقرار با یک مدل امضا شده و زمان اجرا که توسط عامل SageMaker Edge برای بارگیری و فراخوانی مدل بهینه شده استفاده می شود، ایجاد کنید.

- بسته را با استفاده از مکانیزم استقرار OTA موجود مستقر کنید.

- برنامه edge برای استنتاج با عامل SageMaker Edge تعامل دارد.

- عامل را می توان (در صورت نیاز) پیکربندی کرد تا داده های ورودی نمونه را در زمان واقعی از برنامه برای اهداف نظارت و اصلاح مدل ارسال کند.

مورد استفاده 3

فرض کنید مشتری شما در حال توسعه برنامهای است که ناهنجاریها را در مکانیسمهای یک توربین بادی (مانند گیربکس، ژنراتور یا روتور) تشخیص میدهد. هدف این است که با اجرای روشهای حفاظت محلی در پرواز، آسیب وارده به تجهیزات را به حداقل برسانیم. این توربین ها بسیار گران هستند و در مکان هایی قرار دارند که به راحتی قابل دسترسی نیستند. هر توربین را می توان با یک دستگاه NVIDIA Jetson برای نظارت بر داده های حسگر از توربین مجهز کرد. سپس ما به یک راه حل برای گرفتن داده ها و استفاده از یک الگوریتم ML برای تشخیص ناهنجاری ها نیاز داریم. همچنین برای به روز نگه داشتن نرم افزار و مدل های ML روی دستگاه به مکانیزم OTA نیاز داریم.

AWS IoT Greengrass V2 همراه با Edge Manager به خوبی در این مورد استفاده می شود. AWS IoT Greengrass یک سرویس زمان اجرای لبه اینترنت اشیا و سرویس ابری منبع باز است که به شما کمک می کند برنامه های اینترنت اشیا را در دستگاه های خود بسازید، استقرار و مدیریت کنید. میتوانید از AWS IoT Greengrass برای ساخت برنامههای لبه با استفاده از ماژولهای نرمافزاری از پیش ساخته شده به نام استفاده کنید. اجزاء، که می تواند دستگاه های لبه شما را به خدمات AWS یا خدمات شخص ثالث متصل کند. این توانایی AWS IoT Greengrass، استقرار دارایی ها را در دستگاه ها، از جمله عامل SageMaker Edge، آسان می کند. AWS IoT Greengrass مسئول مدیریت چرخه عمر برنامه است، در حالی که Edge Manager چرخه عمر مدل ML را جدا می کند. این به شما انعطافپذیری میدهد تا با استقرار نسخههای جدید اپلیکیشن لبه و مدلهای ML به طور مستقل، کل راهحل را تکامل دهید. نمودار زیر این معماری را نشان می دهد.

راه حل شامل مراحل زیر است:

- توسعهدهنده نمونه نهایی را میسازد، آموزش میدهد، اعتبار میبخشد و میسازد که باید در توربین بادی مستقر شود.

- برای کامپایل کردن مدل آموزش دیده، نئو را فراخوانی کنید.

- یک مؤلفه مدل با استفاده از Edge Manager با ادغام AWS IoT Greengrass V2 ایجاد کنید.

- AWS IoT Greengrass V2 را راه اندازی کنید.

- یک جزء استنتاج با استفاده از AWS IoT Greengrass V2 ایجاد کنید.

- برنامه edge برای استنتاج با عامل SageMaker Edge تعامل دارد.

- عامل را می توان (در صورت نیاز) پیکربندی کرد تا داده های ورودی نمونه را در زمان واقعی از برنامه برای اهداف نظارت و اصلاح مدل ارسال کند.

مورد استفاده 4

برای استفاده نهایی ما، اجازه دهید به یک کشتی حامل کانتینر نگاه کنیم، جایی که هر کانتینر دارای چند حسگر است و سیگنالی را به زیرساخت محاسباتی و ذخیرهسازی مستقر در محلی ارسال میکند. چالش این است که ما میخواهیم محتوای هر ظرف و وضعیت کالا را بر اساس دما، رطوبت و گازهای داخل هر ظرف بدانیم. ما همچنین می خواهیم تمام کالاهای موجود در هر یک از کانتینرها را ردیابی کنیم. در طول سفر هیچ اتصال اینترنتی وجود ندارد و سفر ممکن است ماه ها طول بکشد. مدلهای ML که روی این زیرساخت اجرا میشوند باید دادهها را از قبل پردازش کرده و اطلاعاتی را برای پاسخ به همه سؤالات ما تولید کنند. داده های تولید شده باید ماه ها به صورت محلی ذخیره شوند. برنامه edge تمام استنتاج ها را در یک پایگاه داده محلی ذخیره می کند و سپس زمانی که کشتی به بندر نزدیک می شود، نتایج را با ابر همگام می کند.

AWS Snowcone و AWS Snowball از خانواده برفی AWS می تواند به خوبی در این مورد استفاده مناسب باشد.

AWS Snowcone یک دستگاه محاسباتی و انتقال داده کوچک، ناهموار و امن است. Snowcone مطابق با استاندارد OSHA برای یک دستگاه قابل حمل یک نفره طراحی شده است. Snowcone شما را قادر می سازد تا بارهای کاری لبه را با استفاده از آن اجرا کنید ابر محاسبه الاستیک آمازون محاسبات (Amazon EC2) و ذخیرهسازی محلی در محیطهای سخت و بدون ارتباط مانند سکوهای نفتی، وسایل نقلیه جستجو و نجات، سایتهای نظامی یا طبقات کارخانه، و همچنین دفاتر دورافتاده، بیمارستانها و سینماها.

Snowball در مقایسه با Snowcone محاسبات بیشتری را اضافه می کند و بنابراین ممکن است برای برنامه های کاربردی تر مناسب باشد. ویژگی Compute Optimized یک پردازنده گرافیکی اختیاری NVIDIA Tesla V100 را به همراه نمونه های EC2 برای تسریع عملکرد برنامه در محیط های غیر متصل فراهم می کند. با گزینه GPU، می توانید برنامه هایی مانند ML پیشرفته و تجزیه و تحلیل ویدیوی حرکتی کامل را در محیط هایی با اتصال کم یا بدون اتصال اجرا کنید.

در بالای نمونه EC2، شما آزادی ایجاد و استقرار هر نوع راه حل لبه را دارید. به عنوان مثال: می توانید استفاده کنید آمازون ECS یا مدیر کانتینر دیگری برای استقرار برنامه edge، Edge Manager Agent و مدل ML به عنوان کانتینرهای جداگانه. این معماری مشابه Use Case 2 خواهد بود (به جز اینکه بیشتر اوقات به صورت آفلاین کار می کند)، با افزودن ابزار مدیریت کانتینر.

نمودار زیر این معماری راه حل را نشان می دهد.

برای پیاده سازی این راه حل، به سادگی دستگاه Snow خود را از کنسول مدیریت AWS و منابع خود را راه اندازی کنید.

نتیجه

در این پست، جنبههای مختلف edge را که ممکن است بر اساس موارد استفاده خود انتخاب کنید، مورد بحث قرار دادیم. ما همچنین درباره برخی از مفاهیم کلیدی پیرامون ML@Edge و اینکه چگونه جداسازی چرخه عمر برنامه و چرخه عمر مدل ML به شما آزادی میدهد تا آنها را بدون وابستگی به یکدیگر تکامل دهید، بحث کردیم. ما تأکید کردیم که چگونه انتخاب دستگاه لبه مناسب برای حجم کاری خود و پرسیدن سؤالات مناسب در طول فرآیند راهحل میتواند به شما کمک کند تا به عقب کار کنید و خدمات AWS مناسب را محدود کنید. ما همچنین موارد استفاده مختلف را همراه با معماری های مرجع ارائه کردیم تا به شما الهام بخشد تا راه حل های خود را ایجاد کنید که برای حجم کاری شما کار می کند.

درباره نویسنده

دینش کومار سوبرامانی یک معمار ارشد راه حل با تیم UKIR SMB، مستقر در ادینبورگ، اسکاتلند است. او در هوش مصنوعی و یادگیری ماشین تخصص دارد. Dinesh از همکاری با مشتریان در سراسر صنایع برای کمک به آنها برای حل مشکلات خود با خدمات AWS لذت می برد. خارج از محل کار، او عاشق گذراندن وقت با خانواده، بازی شطرنج و لذت بردن از موسیقی در ژانرهای مختلف است.

دینش کومار سوبرامانی یک معمار ارشد راه حل با تیم UKIR SMB، مستقر در ادینبورگ، اسکاتلند است. او در هوش مصنوعی و یادگیری ماشین تخصص دارد. Dinesh از همکاری با مشتریان در سراسر صنایع برای کمک به آنها برای حل مشکلات خود با خدمات AWS لذت می برد. خارج از محل کار، او عاشق گذراندن وقت با خانواده، بازی شطرنج و لذت بردن از موسیقی در ژانرهای مختلف است.

سمیر آرائوخو یک معمار راه حل های AI/ML در AWS است. او به مشتریان کمک می کند تا راه حل های AI/ML ایجاد کنند که چالش های تجاری آنها را با استفاده از AWS حل کند. او روی چندین پروژه AI/ML مربوط به بینایی کامپیوتر، پردازش زبان طبیعی، پیش بینی، ML در لبه و غیره کار کرده است. او دوست دارد در اوقات فراغت خود با پروژه های سخت افزاری و اتوماسیون بازی کند و علاقه خاصی به رباتیک دارد.

سمیر آرائوخو یک معمار راه حل های AI/ML در AWS است. او به مشتریان کمک می کند تا راه حل های AI/ML ایجاد کنند که چالش های تجاری آنها را با استفاده از AWS حل کند. او روی چندین پروژه AI/ML مربوط به بینایی کامپیوتر، پردازش زبان طبیعی، پیش بینی، ML در لبه و غیره کار کرده است. او دوست دارد در اوقات فراغت خود با پروژه های سخت افزاری و اتوماسیون بازی کند و علاقه خاصی به رباتیک دارد.

- "

- 100

- 5G

- a

- توانایی

- درباره ما

- شتاب دادن

- شتاب دهنده ها

- در دسترس

- در میان

- عمل

- اضافه

- نشانی

- پیشرفته

- کشاورزی

- AI

- الگوریتم

- معرفی

- اجازه دادن

- اجازه می دهد تا

- قبلا

- هر چند

- آمازون

- تحلیل

- علم تجزیه و تحلیل

- پاسخ

- هر جا

- API

- نرم افزار

- کاربرد

- برنامه های کاربردی

- درخواست

- روش

- رویکردها

- معماری

- معماری

- محدوده

- دور و بر

- مصنوعی

- هوش مصنوعی

- هوش مصنوعی و یادگیری ماشین

- دارایی

- سمعی

- خودکار بودن

- خودکار

- بطور خودکار

- اتوماسیون

- در دسترس

- اجتناب از

- AWS

- قبل از

- سود

- مزایای

- بهترین

- بزرگ داده

- تخته

- می شکند

- به ارمغان بیاورد

- اشکالات

- ساختن

- بنا

- می سازد

- کسب و کار

- دوربین

- قابلیت های

- توانا

- ظرفیت

- گرفتن

- جلب

- مورد

- موارد

- معین

- به چالش

- چالش ها

- شطرنج

- را انتخاب کنید

- طبقه بندی

- ابر

- رمز

- جمع آوری

- جمع آوری

- مجموعه

- بیا

- مشترک

- ارتباط

- شرکت

- مقایسه

- کامل

- پیچیده

- جزء

- اجزاء

- مرکب

- محاسبه

- کامپیوتر

- محاسبه

- مفهوم

- شرط

- گیجی

- اتصال

- متصل

- اتصال

- مصرف

- ظرف

- ظروف

- محتوا

- کنترل

- میتوانست

- زن و شوهر

- پوشش

- ایجاد

- ایجاد شده

- ایجاد

- ایجاد

- مشتری

- مشتریان

- داده ها

- مرکز دادهها

- پایگاه داده

- عمیق تر

- تحویل

- خواسته

- بستگی دارد

- گسترش

- مستقر

- استقرار

- گسترش

- طرح

- طراحی

- جزئیات

- شناسایی شده

- کشف

- توسعه دهنده

- توسعه دهندگان

- در حال توسعه

- دستگاه

- دستگاه ها

- مختلف

- مشکل

- بحث و تبادل نظر

- نمی کند

- پایین

- راننده

- در طی

- هر

- به آسانی

- لبه

- محاسبات لبه

- موثر

- تلاش

- از بین بردن

- جاسازی شده

- تاکید

- را قادر می سازد

- نقطه پایانی

- به پایان می رسد

- انرژی

- تعامل

- مورد تأیید

- وارد می شود

- محیط

- تجهیزات

- به خصوص

- حوادث

- تکامل یابد

- در حال تحول

- مثال

- جز

- تبادل

- موجود

- مفرط

- کارخانه

- کارخانه

- آشنا

- خانواده

- سریعتر

- ویژگی

- شکل

- سرانجام

- نام خانوادگی

- مناسب

- ناوگان

- انعطاف پذیری

- قابل انعطاف

- جریان

- پیروی

- به دنبال آن است

- FRAME

- چارچوب

- رایگان

- آزادی

- از جانب

- کامل

- تولید می کنند

- تولید

- ژنراتور

- هدف

- خوب

- مغازه

- GPU

- GPU ها

- بزرگ

- توری

- گروه

- گروه ها

- سخت افزار

- کمک

- کمک می کند

- زیاد

- بالاتر

- بیمارستان ها

- میزبانی وب

- چگونه

- چگونه

- اما

- HTTPS

- انسان

- صدها نفر

- شناسایی

- تصویر

- تصاویر

- انجام

- مهم

- بهبود

- مشمول

- شامل

- از جمله

- مستقل

- به طور مستقل

- فرد

- لوازم

- اطلاعات

- شالوده

- ورودی

- بینش

- نمونه

- یکپارچه

- ادغام

- اطلاعات

- علاقه

- اینترنت

- اینترنت از چیزهایی که

- اینترنت اشیا

- IP

- IT

- خود

- نگاه داشتن

- کلید

- دانستن

- زبان

- راه اندازی

- یاد گرفتن

- یادگیری

- کتابخانه

- چرخه های زندگی

- سبک

- سبک وزن

- محدود شده

- خطوط

- فهرست

- کوچک

- بار

- بارگیری

- محلی

- به صورت محلی

- محل

- نگاه کنيد

- دستگاه

- فراگیری ماشین

- ماشین آلات

- عمده

- ساخت

- باعث می شود

- ساخت

- مدیریت

- اداره می شود

- مدیریت

- مدیر

- مدیریت

- کتابچه راهنمای

- سازنده

- مکانیزم

- متریک

- نظامی

- میلیون ها نفر

- ذهن

- استخراج معدن

- ML

- موبایل

- برنامه موبایل

- برنامه های موبایل

- گوشی های تلفن همراه

- تحرک

- مدل

- مدل

- پول

- مانیتور

- نظارت بر

- ماه

- بیش

- اکثر

- سینما

- چندگانه

- موسیقی

- طبیعی

- نیازهای

- NEO

- شبکه

- شبکه

- بعد

- به طور معمول

- عدد

- کارت گرافیک Nvidia

- ارائه

- دفاتر

- آنلاین نیست.

- نفت

- کار

- اپراتور

- بهینه سازی

- بهینه

- گزینه

- سفارش

- دیگر

- خود

- بسته

- بخش

- ویژه

- مردم

- کارایی

- شخص

- گوشی های

- فیزیکی

- سکو

- بازی

- بازی

- محبوب

- پتانسیل

- قدرت

- قوی

- پیش گویی

- پیش بینی

- آماده

- مشکلات

- روند

- فرآیندهای

- در حال پردازش

- محصول

- تولید

- بهره وری

- محصولات

- پروژه ها

- محافظت از

- حفاظت

- پروتکل

- ارائه

- ارائه

- فراهم می کند

- منتشر کردن

- هدف

- اهداف

- کیفیت

- خام

- زمان واقعی

- داده های زمان واقعی

- اشاره دارد

- با توجه

- قابل اعتماد

- دور

- نیاز

- ضروری

- مورد نیاز

- منابع

- منابع

- مسئوليت

- محدودیت های

- نتایج

- رباتیک

- نقش

- دویدن

- در حال اجرا

- ایمنی

- همان

- مقیاس

- sdk

- جستجو

- امن

- تیم امنیت لاتاری

- سرویس

- خدمات

- چند

- نشان داده شده

- نشانه ها

- مشابه

- ساده

- تنها

- سایت

- خواب

- کوچک

- برف

- So

- نرم افزار

- راه حل

- مزایا

- حل

- برخی از

- تخصص دارد

- خاص

- مشخصات

- هزینه

- صحنه

- مراحل

- مستقل

- استاندارد

- شروع

- هنوز

- ذخیره سازی

- پرده

- جریان

- پشتیبانی

- پشتیبانی

- حمایت از

- پشتیبانی از

- نظارت

- سیستم

- سیستم های

- هدف

- وظایف

- تیم

- فن آوری

- تسلا

- La

- در نتیجه

- از این رو

- اشیاء

- تفکر

- شخص ثالث

- هزاران نفر

- سه

- از طریق

- سراسر

- توان

- زمان

- با هم

- ابزار

- ابزار

- بالا

- تاپیک

- مسیر

- پیگردی

- به طور سنتی

- قطار

- حمل و نقل

- باعث شد

- وحدت

- استفاده کنید

- وسایل نقلیه

- بررسی

- تصویری

- مجازی

- دید

- راه

- در حین

- ویکیپدیا

- باد

- بي سيم

- بدون

- مهاجرت کاری

- کارگر

- خواهد بود

- XML

- شما