امروز، ما هیجان زده هستیم که قابلیت تنظیم دقیق مدل های Llama 2 توسط متا را با استفاده از Amazon SageMaker JumpStart. خانواده مدلهای زبان بزرگ Llama 2 (LLMs) مجموعهای از مدلهای متنی تولیدی از پیش آموزشدیده و تنظیمشده است که در مقیاسی از ۷ میلیارد تا ۷۰ میلیارد پارامتر متغیر است. LLM های تنظیم شده به نام Llama-7-chat، برای موارد استفاده از گفتگو بهینه شده اند. میتوانید به راحتی این مدلها را امتحان کنید و با SageMaker JumpStart، که یک هاب یادگیری ماشین (ML) است که دسترسی به الگوریتمها، مدلها و راهحلهای ML را فراهم میکند، استفاده کنید تا بتوانید به سرعت با ML شروع کنید. اکنون میتوانید مدلهای تولید متن Llama 70 2 میلیارد، 7 میلیارد و 13 میلیارد پارامتری را در SageMaker JumpStart با استفاده از Amazon SageMaker Studio UI با چند کلیک یا با استفاده از SageMaker Python SDK.

بیش از یک سال است که بیش از یک سال است که مدلهای پایه هوش مصنوعی مولد تمرکز بیشتر تحقیقات و موارد استفاده از ML و هوش مصنوعی بوده است. این مدلهای پایه به دلیل اندازه بزرگشان و همچنین به این دلیل که روی چندین مجموعه داده بزرگ و صدها کار آموزش دیدهاند، با وظایف تولیدی، مانند تولید متن، خلاصهسازی، پاسخگویی به سؤال، تولید تصویر و ویدیو و موارد دیگر بسیار خوب عمل میکنند. علیرغم قابلیت های تعمیم زیاد این مدل ها، اغلب موارد استفاده وجود دارد که داده های دامنه بسیار خاصی دارند (مانند خدمات بهداشتی و درمانی یا خدمات مالی)، به همین دلیل این مدل ها ممکن است نتوانند نتایج خوبی برای این موارد استفاده ارائه دهند. این منجر به نیاز به تنظیم دقیق بیشتر این مدلهای هوش مصنوعی مولد بر روی دادههای مورد خاص و دامنه خاص میشود.

در این پست، نحوه تنظیم دقیق مدل های تولید متن از پیش آموزش دیده Llama 2 را از طریق SageMaker JumpStart شرح می دهیم.

لاما 2 چیست؟

Llama 2 یک مدل زبان رگرسیون خودکار است که از معماری ترانسفورماتور بهینه شده استفاده می کند. Llama 2 برای استفاده تجاری و تحقیقاتی به زبان انگلیسی در نظر گرفته شده است. این در طیف وسیعی از اندازههای پارامتر - 7 میلیارد، 13 میلیارد و 70 میلیارد - و همچنین تغییرات از پیش آموزشدیده و تنظیمشده است. به گفته متا، نسخههای تنظیمشده از تنظیم دقیق نظارت شده (SFT) و یادگیری تقویتی با بازخورد انسانی (RLHF) استفاده میکنند تا با ترجیحات انسان برای مفید بودن و ایمنی هماهنگ شوند. Llama 2 بر روی 2 تریلیون توکن داده از منابع در دسترس عموم از قبل آموزش داده شده بود. مدلهای تنظیمشده برای چت دستیار در نظر گرفته شدهاند، در حالی که مدلهای از پیش آموزشدیده را میتوان برای انواع وظایف تولید زبان طبیعی تطبیق داد. صرف نظر از اینکه توسعهدهنده از چه نسخهای از مدل استفاده میکند، راهنمای استفاده مسئولانه از متا می تواند به هدایت تنظیمات دقیق اضافی که ممکن است برای سفارشی سازی و بهینه سازی مدل ها با کاهش ایمنی مناسب لازم باشد کمک کند.

در حال حاضر، Llama 2 در مناطق زیر در دسترس است:

- استقرار مدل از پیش آموزش دیده موجود:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - تنظیم دقیق و استقرار مدل دقیق تنظیم شده:

“us-east-1”,“us-west-2”,“eu-west-1”

SageMaker JumpStart چیست؟

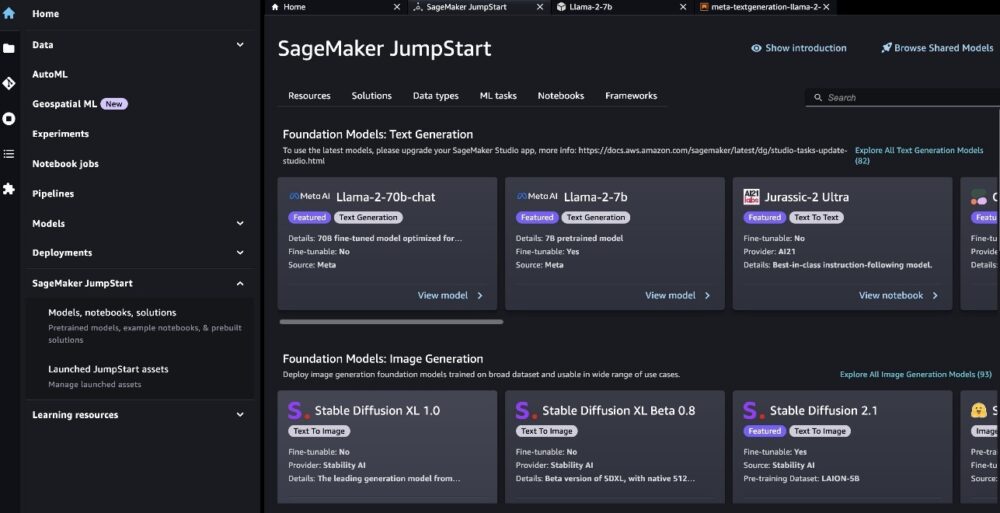

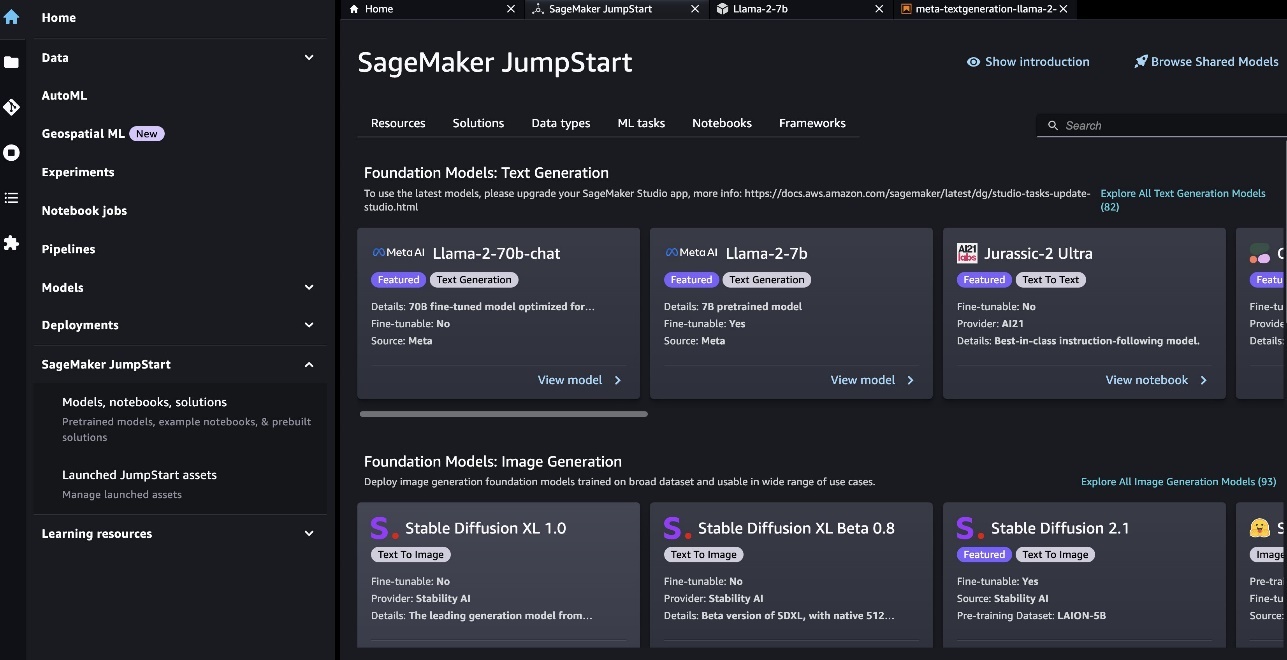

با SageMaker JumpStart، پزشکان ML میتوانند از میان مجموعه وسیعی از مدلهای پایه در دسترس عموم انتخاب کنند. پزشکان ML می توانند مدل های پایه را به صورت اختصاصی به کار گیرند آمازون SageMaker نمونه هایی از یک محیط جدا شده از شبکه و سفارشی کردن مدل ها با استفاده از SageMaker برای آموزش و استقرار مدل. اکنون میتوانید Llama 2 را با چند کلیک در SageMaker Studio یا به صورت برنامهنویسی از طریق SageMaker Python SDK کشف و استقرار دهید و به شما امکان میدهد عملکرد مدل و کنترلهای MLOps را با ویژگیهای SageMaker استخراج کنید. خطوط لوله آمازون SageMaker, دیباگر Amazon SageMaker، یا سیاهههای مربوط به کانتینر. این مدل در یک محیط امن AWS و تحت کنترل های VPC شما مستقر شده است و به اطمینان از امنیت داده ها کمک می کند. علاوه بر این، می توانید مدل های تولید متن از پیش آموزش دیده Llama2 7B، 13B و 70B را از طریق SageMaker JumpStart تنظیم کنید.

مدل های Llama2 تنظیم دقیق

می توانید مدل ها را با استفاده از SageMaker Studio UI یا SageMaker Python SDK تنظیم دقیق کنید. ما در این بخش به هر دو روش می پردازیم.

تنظیم دقیق بدون کد از طریق رابط کاربری SageMaker Studio

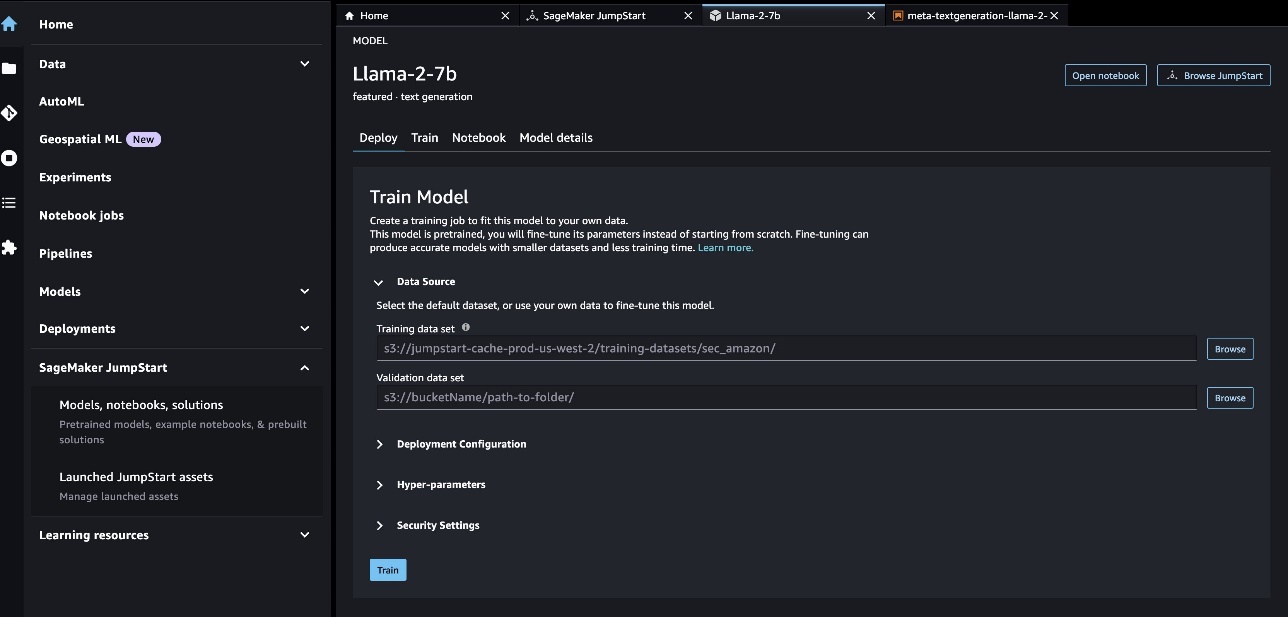

در SageMaker Studio، میتوانید از طریق SageMaker JumpStart به مدلهای Llama 2 دسترسی داشته باشید. مدل ها، نوت بوک ها و راه حل ها، همانطور که در تصویر زیر نشان داده شده است.

اگر مدلهای Llama 2 را نمیبینید، نسخه SageMaker Studio خود را با خاموش کردن و راهاندازی مجدد بهروزرسانی کنید. برای اطلاعات بیشتر در مورد به روز رسانی نسخه، مراجعه کنید برنامه های استودیو را خاموش و به روز کنید.

همچنین می توانید با انتخاب چهار مدل دیگر را بیابید تمام مدل های تولید متن را کاوش کنید یا جستجوی لاما در کادر جستجو.

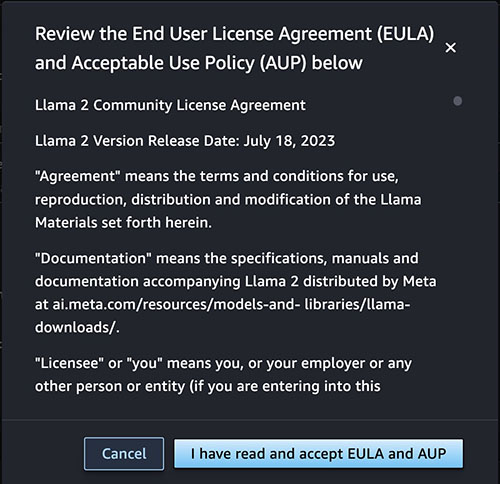

در این صفحه می توانید به سرویس ذخیره سازی ساده آمازون سطل (Amazon S3) حاوی مجموعه دادههای آموزشی و اعتبارسنجی برای تنظیم دقیق. علاوه بر این، میتوانید پیکربندی استقرار، فراپارامترها و تنظیمات امنیتی را برای تنظیم دقیق پیکربندی کنید. سپس می توانید انتخاب کنید قطار برای شروع کار آموزشی در یک نمونه SageMaker ML. تصویر قبلی صفحه تنظیم دقیق مدل Llama-2 7B را نشان می دهد. با این حال، میتوانید مدلهای تولید متن 13B و 70B Llama 2 را با استفاده از صفحات مدل مربوطه آنها به طور مشابه تنظیم کنید. برای استفاده از مدلهای Llama 2، باید موافقتنامه مجوز کاربر نهایی (EULA) را بپذیرید. زمانی که شما انتخاب می کنید نشان داده می شود قطار، همانطور که در تصویر زیر نشان داده شده است. انتخاب کنید EULA و AUP را خوانده و قبول کرده ام برای شروع کار تنظیم دقیق

مدل را مستقر کنید

پس از تنظیم دقیق مدل، می توانید آن را با استفاده از صفحه مدل در SageMaker JumpStart اجرا کنید. همانطور که در تصویر زیر نشان داده شده است، گزینه استقرار مدل تنظیم شده پس از اتمام تنظیم دقیق ظاهر می شود.

تنظیم دقیق از طریق SageMaker Python SDK

همچنین میتوانید مدلهای Llama 2 را با استفاده از SageMaker Python SDK تنظیم کنید. کد زیر یک نمونه کد برای تنظیم دقیق Llama 2 7B در مجموعه داده شما است:

شما می توانید مدل دقیق تنظیم شده را مستقیماً از برآوردگر مستقر کنید:

شما همچنین می توانید کد را در مدلهای LLaMA 2 را در SageMaker JumpStart تنظیم کنید. این شامل آماده سازی مجموعه داده، آموزش بر روی مجموعه داده های سفارشی شما، و استقرار مدل دقیق تنظیم شده است. تنظیم دقیق زیرمجموعه ای از مجموعه داده دالی را با مثال هایی از کار خلاصه سازی نشان می دهد. در زیر نمونه ورودی با پاسخهایی از تنظیم دقیق و تنظیم نشده به همراه پاسخ حقیقت زمین است:

ورودی مدل:

پاسخ حقیقت زمینی:

پاسخ از مدل بدون تنظیم دقیق:

پاسخ از مدل دقیق تنظیم شده:

برای ارزیابی عملکرد مدلهای مختلف در مجموعه دادههای Dolly و Dialogsum، به آدرس زیر مراجعه کنید محک زدن عملکرد بخش در ضمیمه انتهای این پست.

تکنیک تنظیم دقیق

مدل های زبانی مانند Llama بیش از 10 گیگابایت یا حتی 100 گیگابایت حجم دارند. تنظیم دقیق چنین مدل های بزرگی به نمونه هایی با حافظه CUDA بسیار بالا نیاز دارد. علاوه بر این، آموزش این مدل ها به دلیل اندازه مدل می تواند بسیار کند باشد. بنابراین، برای تنظیم دقیق کارآمد، از بهینهسازیهای زیر استفاده میکنیم:

- سازگاری با رتبه پایین (LoRA) - این یک نوع تنظیم دقیق کارآمد پارامتر (PEFT) برای تنظیم دقیق کارآمد مدل های بزرگ است. در این، کل مدل را فریز می کنیم و فقط مجموعه کوچکی از پارامترها یا لایه های قابل تنظیم را به مدل اضافه می کنیم. به عنوان مثال، به جای آموزش تمام 7 میلیارد پارامتر برای Llama 2 7B، میتوانیم کمتر از 1 درصد از پارامترها را تنظیم کنیم. این به کاهش قابل توجه نیاز به حافظه کمک می کند زیرا ما فقط باید گرادیان ها، حالت های بهینه ساز و سایر اطلاعات مربوط به آموزش را فقط برای 1٪ از پارامترها ذخیره کنیم. علاوه بر این، این به کاهش زمان آموزش و همچنین کاهش هزینه کمک می کند. برای جزئیات بیشتر در مورد این روش، مراجعه کنید LoRA: انطباق با رتبه پایین مدل های زبان بزرگ.

- کوانتیزاسیون Int8 – حتی با بهینهسازیهایی مانند LoRA، مدلهایی مانند Llama 70B هنوز برای آموزش بسیار بزرگ هستند. برای کاهش ردپای حافظه در حین تمرین، می توانیم از کوانتیزه سازی Int8 در حین تمرین استفاده کنیم. کوانتیزاسیون معمولاً دقت انواع داده های ممیز شناور را کاهش می دهد. اگرچه این باعث کاهش حافظه مورد نیاز برای ذخیره وزن مدل می شود، اما به دلیل از دست دادن اطلاعات، عملکرد را کاهش می دهد. کوانتیزاسیون Int8 فقط از یک چهارم دقت استفاده می کند، اما باعث کاهش عملکرد نمی شود زیرا به سادگی بیت ها را رها نمی کند. داده ها را از یک نوع به نوع دیگر گرد می کند. برای آشنایی با کوانتیزاسیون Int8 به ادامه مطلب مراجعه کنید LLM.int8(): ضرب ماتریس 8 بیتی برای ترانسفورماتورها در مقیاس.

- موازی داده کاملاً خرد شده (FSDP) - این یک نوع الگوریتم آموزشی موازی داده است که پارامترهای مدل را در بین کارگران موازی داده تقسیم می کند و می تواند به صورت اختیاری بخشی از محاسبات آموزشی را به CPU ها بارگذاری کند. اگرچه پارامترها در بین GPU های مختلف تقسیم می شوند، محاسبه هر میکروبچ برای کارگر GPU محلی است. پارامترها را به طور یکنواختتر خرد میکند و از طریق ارتباط و همپوشانی محاسباتی در طول آموزش، عملکرد بهینهای را به دست میآورد.

جدول زیر روش های مختلف را با سه مدل Llama 2 مقایسه می کند.

| , | نوع نمونه پیش فرض | انواع نمونه های پشتیبانی شده با پیکربندی پیش فرض | تنظیمات پیشفرض | LORA + FSDP | LORA + بدون FSDP | Quantization Int8 + LORA + بدون FSDP |

| لاما 2 7B | ml.g5.12xlarge | ml.g5.12xlarge، ml.g5.24xlarge، ml.g5.48xlarge | LORA + FSDP | بله | بله | بله |

| لاما 2 13B | ml.g5.12xlarge | ml.g5.24xlarge، ml.g5.48xlarge | LORA + FSDP | بله | بله | بله |

| لاما 2 70B | ml.g5.48xlarge | ml.g5.48xlarge | INT8 + LORA + NO FSDP | نه | نه | بله |

توجه داشته باشید که تنظیم دقیق مدل های Llama بر اساس اسکریپت های ارائه شده توسط موارد زیر است GitHub repo.

قالب مجموعه داده های آموزشی

SageMaker JumpStart در حال حاضر از مجموعه دادهها در قالب تطبیق دامنه و فرمت تنظیم دستورالعمل پشتیبانی میکند. در این بخش یک مجموعه داده نمونه را در هر دو فرمت مشخص می کنیم. برای جزئیات بیشتر، به قالب بندی مجموعه داده بخش در پیوست

فرمت تطبیق دامنه

مدل Llama 2 تولید متن را می توان بر روی هر مجموعه داده خاص دامنه تنظیم کرد. پس از تنظیم دقیق مجموعه دادههای دامنه، انتظار میرود که مدل متن خاص دامنه را تولید کند و وظایف مختلف NLP را در آن دامنه خاص با درخواست چند شات حل کند. با این مجموعه داده، ورودی از یک فایل CSV، JSON یا TXT تشکیل شده است. به عنوان مثال، داده های ورودی ممکن است فایل های SEC آمازون به عنوان یک فایل متنی باشند:

فرمت تنظیم دستورالعمل

در تنظیم دقیق دستورالعمل، مدل برای مجموعهای از وظایف پردازش زبان طبیعی (NLP) که با استفاده از دستورالعملها شرح داده شدهاند، تنظیم میشود. این به بهبود عملکرد مدل برای کارهای غیرقابل مشاهده با اعلانهای شات صفر کمک میکند. در قالب مجموعه داده تنظیم دستورالعمل، شما را مشخص می کنید template.json فایلی که فرمت های ورودی و خروجی را توصیف می کند. به عنوان مثال، هر خط در فایل train.jsonl به نظر می رسد به شرح زیر است:

فایل اضافی template.json به نظر می رسد به شرح زیر است:

هایپرپارامترهای پشتیبانی شده برای آموزش

تنظیم دقیق Llama 2 از تعدادی فراپارامتر پشتیبانی می کند که هر کدام می توانند بر نیاز حافظه، سرعت تمرین و عملکرد مدل تنظیم شده تأثیر بگذارند:

- دوره - تعداد پاس هایی که الگوریتم تنظیم دقیق از مجموعه داده آموزشی انجام می دهد. باید یک عدد صحیح بزرگتر از 1 باشد. پیش فرض 5 است.

- یادگیری_نرخ – سرعتی که وزن های مدل پس از کار در هر دسته از نمونه های آموزشی به روز می شوند. باید یک شناور مثبت بزرگتر از 0 باشد. پیش فرض 1e-4 است.

- instruction_tuned – اینکه آیا مدل را آموزش می دهد یا نه. باید باشد '

True' یا 'False'. پیش فرض استFalse". - اندازه هر_دستگاه_قطار_بچ - اندازه دسته در هر هسته GPU/CPU برای آموزش. باید یک عدد صحیح مثبت باشد. پیش فرض 4 است.

- اندازه هر_دستگاه_eval_batch - اندازه دسته در هر هسته GPU/CPU برای ارزیابی. باید یک عدد صحیح مثبت باشد. پیش فرض 1 است.

- max_train_samples - برای اهداف اشکال زدایی یا آموزش سریعتر، تعداد نمونه های آموزشی را به این مقدار کاهش دهید. مقدار -1 به معنای استفاده از تمام نمونه های آموزشی است. باید یک عدد صحیح مثبت یا -1 باشد. پیش فرض -1 است.

- max_val_samples - برای اهداف اشکال زدایی یا آموزش سریعتر، تعداد نمونه های اعتبارسنجی را به این مقدار کوتاه کنید. مقدار -1 به معنای استفاده از تمام نمونه های اعتبار سنجی است. باید یک عدد صحیح مثبت یا -1 باشد. پیش فرض -1 است.

- حداکثر_طول_ورودی - حداکثر طول توالی ورودی کل پس از توکن سازی. دنباله های طولانی تر از این کوتاه می شوند. اگر -1،

max_input_lengthروی حداقل 1024 و حداکثر طول مدل تعریف شده توسط توکنایزر تنظیم شده است. اگر روی مقدار مثبت تنظیم شود،max_input_lengthبر روی حداقل مقدار ارائه شده تنظیم شده استmodel_max_lengthتوسط توکنایزر تعریف شده است. باید یک عدد صحیح مثبت یا -1 باشد. پیش فرض -1 است. - اعتبار_شکل_نسبت - اگر کانال اعتبارسنجی باشد

none، نسبت اعتبار سنجی قطار از داده های قطار باید بین 0-1 باشد. پیش فرض 0.2 است. - train_data_split_seed - اگر داده های اعتبار سنجی وجود نداشته باشد، این تقسیم تصادفی داده های آموزشی ورودی به داده های آموزشی و اعتبار سنجی مورد استفاده توسط الگوریتم را برطرف می کند. باید یک عدد صحیح باشد. پیش فرض 0 است.

- preprocessing_num_workers - تعداد فرآیندهایی که برای پیش پردازش استفاده می شود. اگر

None، فرآیند اصلی برای پیش پردازش استفاده می شود. پیش فرض استNone. - lora_r – Lora R. باید یک عدد صحیح مثبت باشد. پیش فرض 8 است.

- lora_alpha - لورا آلفا. باید یک عدد صحیح مثبت باشد. پیش فرض 32 است

- lora_droopout - ترک تحصیل لورا باید شناور مثبت بین 0 و 1 باشد. پیش فرض 0.05 است.

- int8_quantization - اگر

True، مدل با دقت 8 بیت برای آموزش بارگذاری شده است. پیش فرض برای 7B و 13B استFalse. پیش فرض برای 70B استTrue. - enable_fsdp - اگر

True، آموزش از FSDP استفاده می کند. پیش فرض برای 7B و 13B استTrue. پیش فرض برای 70B استFalse. توجه داشته باشید کهint8_quantizationبا FSDP پشتیبانی نمی شود.

انواع نمونه و فراپارامترهای سازگار

نیاز به حافظه در هنگام تنظیم دقیق ممکن است بر اساس چندین عامل متفاوت باشد:

- نوع مدل – مدل 7B کمترین نیاز به حافظه GPU و 70B بیشترین نیاز به حافظه را دارد

- حداکثر طول ورودی - مقدار بالاتر طول ورودی منجر به پردازش توکن های بیشتر در یک زمان می شود و به همین دلیل به حافظه CUDA بیشتری نیاز دارد.

- اندازه دسته - اندازه دسته بزرگتر به حافظه CUDA بزرگتر نیاز دارد و بنابراین به انواع نمونه های بزرگتر نیاز دارد

- کوانتیزاسیون Int8 - در صورت استفاده از کوانتیزاسیون Int8، مدل با دقت پایین بارگذاری می شود و بنابراین به حافظه CUDA کمتری نیاز دارد.

برای کمک به شما در شروع کار، مجموعهای از ترکیبهایی از انواع نمونههای مختلف، فراپارامترها و انواع مدلها را ارائه میکنیم که میتوانند با موفقیت تنظیم شوند. شما می توانید پیکربندی را بر اساس نیاز خود و در دسترس بودن انواع نمونه انتخاب کنید. ما هر سه مدل را در تنظیمات مختلف با سه دوره در زیرمجموعهای از مجموعه داده دالی با مثالهای خلاصه تنظیم میکنیم.

مدل 7B

جدول زیر گزینه های تنظیم دقیق مدل 7B را خلاصه می کند.

| نوع نمونه | حداکثر لنز ورودی | اندازه دسته در هر دستگاه | کوانتیزاسیون Int8 | FSDP را فعال کنید | زمان صرف شده (دقیقه) |

| ml.g4dn.12xlarge | 1024 | 8 | TRUE | نادرست | 166 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | نادرست | 178 |

| ml.g4dn.12xlarge | 1024 | 4 | نادرست | TRUE | 120 |

| ml.g4dn.12xlarge | 2048 | 2 | نادرست | TRUE | 143 |

| ml.g5.2xlarge | 1024 | 4 | TRUE | نادرست | 61 |

| ml.g5.2xlarge | 2048 | 2 | TRUE | نادرست | 68 |

| ml.g5.2xlarge | 1024 | 4 | نادرست | TRUE | 43 |

| ml.g5.2xlarge | 2048 | 2 | نادرست | TRUE | 49 |

| ml.g5.4xlarge | 1024 | 4 | نادرست | TRUE | 39 |

| ml.g5.4xlarge | 2048 | 2 | نادرست | TRUE | 50 |

| ml.g5.12xlarge | 1024 | 16 | TRUE | نادرست | 57 |

| ml.g5.12xlarge | 2048 | 4 | TRUE | نادرست | 64 |

| ml.g5.12xlarge | 1024 | 4 | نادرست | TRUE | 26 |

| ml.g5.12xlarge | 2048 | 4 | نادرست | TRUE | 23 |

| ml.g5.48xlarge | 1024 | 16 | TRUE | نادرست | 59 |

| ml.g5.48xlarge | 2048 | 4 | TRUE | نادرست | 67 |

| ml.g5.48xlarge | 1024 | 8 | نادرست | TRUE | 22 |

| ml.g5.48xlarge | 2048 | 4 | نادرست | TRUE | 21 |

13B

جدول زیر گزینه های تنظیم دقیق مدل 13B را خلاصه می کند.

| نوع نمونه | حداکثر لنز ورودی | اندازه دسته در هر دستگاه | کوانتیزاسیون Int8 | FSDP را فعال کنید | زمان صرف شده (دقیقه) |

| ml.g4dn.12xlarge | 1024 | 4 | TRUE | نادرست | 283 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | نادرست | 328 |

| ml.g5.12xlarge | 1024 | 8 | TRUE | نادرست | 92 |

| ml.g5.12xlarge | 2048 | 4 | TRUE | نادرست | 104 |

| ml.g5.48xlarge | 1024 | 8 | TRUE | نادرست | 95 |

| ml.g5.48xlarge | 2048 | 4 | TRUE | نادرست | 107 |

| ml.g5.48xlarge | 1024 | 8 | نادرست | TRUE | 35 |

| ml.g5.48xlarge | 2048 | 2 | نادرست | TRUE | 41 |

70B

جدول زیر گزینه های تنظیم دقیق مدل 70B را خلاصه می کند.

| نوع نمونه | حداکثر لنز ورودی | اندازه دسته در هر دستگاه | کوانتیزاسیون Int8 | FSDP را فعال کنید | زمان صرف شده (دقیقه) |

| ml.g5.48xlarge | 1024 | 4 | TRUE | نادرست | 396 |

| ml.g5.48xlarge | 2048 | 1 | TRUE | نادرست | 454 |

توصیه هایی در مورد انواع نمونه و فراپارامترها

هنگام تنظیم دقیق دقت مدل، موارد زیر را در نظر داشته باشید:

- مدل های بزرگتر مانند 70B عملکرد بهتری نسبت به 7B ارائه می دهند

- عملکرد بدون کوانتیزه سازی Int8 بهتر از عملکرد با کوانتیشن INT8 است

به زمان آموزش زیر و نیازهای حافظه CUDA توجه کنید:

- محیط

int8_quantization=Trueنیاز به حافظه را کاهش می دهد و منجر به تمرین سریعتر می شود. - کاهنده

per_device_train_batch_sizeوmax_input_lengthنیاز به حافظه را کاهش می دهد و بنابراین می تواند در نمونه های کوچکتر اجرا شود. با این حال، تنظیم مقادیر بسیار پایین ممکن است زمان تمرین را افزایش دهد. - اگر از کوانتیزاسیون Int8 استفاده نمی کنید (

int8_quantization=False، از FSDP استفاده کنید (enable_fsdp=True) برای آموزش سریعتر و کارآمدتر.

هنگام انتخاب نوع نمونه، موارد زیر را در نظر بگیرید:

- نمونه های G5 کارآمدترین آموزش را در بین انواع نمونه های پشتیبانی شده ارائه می دهند. بنابراین، اگر نمونه های G5 در دسترس دارید، باید از آنها استفاده کنید.

- زمان آموزش تا حد زیادی به تعداد GPU ها و حافظه CUDA موجود بستگی دارد. بنابراین، آموزش روی نمونههایی با تعداد واحد پردازش گرافیکی (مثلاً ml.g5.2xlarge و ml.g5.4xlarge) تقریباً یکسان است. بنابراین، میتوانید از نمونه ارزانتر برای آموزش استفاده کنید (ml.g5.2xlarge).

- هنگام استفاده از نمونه های p3، آموزش با دقت 32 بیتی انجام می شود زیرا bfloat16 در این نمونه ها پشتیبانی نمی شود. بنابراین، کار آموزش در مقایسه با نمونه های g3، دو برابر مقدار حافظه CUDA را هنگام آموزش روی نمونه های p5 مصرف می کند.

برای اطلاع از هزینه آموزش به ازای هر نمونه به نمونه های آمازون EC2 G5.

اگر مجموعه داده در قالب تنظیم دستورالعمل باشد و توالی ورودی + تکمیل کوچک باشد (مانند 50 تا 100 کلمه)، پس مقدار زیادی از max_input_length منجر به عملکرد بسیار ضعیف می شود. مقدار پیش فرض این پارامتر -1 است که با max_input_length سال 2048 برای مدل های لاما. بنابراین، توصیه می کنیم که اگر مجموعه داده شما حاوی نمونه های کوچکی است، از مقدار کمی برای استفاده کنید max_input_length (مانند 200-400).

در نهایت، به دلیل تقاضای زیاد نمونههای G5، ممکن است در دسترس نبودن این نمونهها در منطقه خود با خطا مواجه شوید. “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” اگر با این خطا مواجه شدید، کار آموزشی را دوباره امتحان کنید یا منطقه دیگری را امتحان کنید.

مشکلات تنظیم دقیق مدل های بسیار بزرگ

در این بخش، ما دو موضوع را در هنگام تنظیم دقیق مدل های بسیار بزرگ مورد بحث قرار می دهیم.

فشرده سازی خروجی را غیرفعال کنید

به طور پیش فرض، خروجی یک کار آموزشی یک مدل آموزش دیده است که قبل از آپلود در Amazon S3 در قالب tar.gz فشرده می شود. با این حال، به دلیل اندازه بزرگ مدل، این مرحله می تواند زمان زیادی را ببرد. به عنوان مثال، فشرده سازی و آپلود مدل 70B می تواند بیش از 4 ساعت طول بکشد. برای جلوگیری از این مشکل، میتوانید از ویژگی غیرفعال کردن فشردهسازی خروجی که توسط پلتفرم آموزشی SageMaker پشتیبانی میشود، استفاده کنید. در این حالت، مدل بدون هیچ فشرده سازی آپلود می شود که بیشتر برای استقرار استفاده می شود:

مشکل مهلت زمانی هسته SageMaker Studio

با توجه به اندازه مدل Llama 70B، کار آموزش ممکن است چندین ساعت طول بکشد و هسته SageMaker Studio در مرحله آموزش از بین برود. با این حال، در این مدت، آموزش هنوز در SageMaker در حال اجرا است. اگر این اتفاق افتاد، همچنان میتوانید نقطه پایانی را با استفاده از نام شغل آموزشی با کد زیر مستقر کنید:

برای یافتن نام شغل آموزشی، به کنسول SageMaker و زیر بروید آموزش در قسمت ناوبری، را انتخاب کنید مشاغل آموزشی. نام شغل آموزشی را مشخص کرده و در کد قبلی جایگزین کنید.

نتیجه

در این پست، ما در مورد تنظیم دقیق مدلهای Llama 2 متا با استفاده از SageMaker JumpStart صحبت کردیم. ما نشان دادیم که میتوانید از کنسول SageMaker JumpStart در SageMaker Studio یا SageMaker Python SDK برای تنظیم دقیق و استقرار این مدلها استفاده کنید. ما همچنین در مورد تکنیک تنظیم دقیق، انواع نمونه و فراپارامترهای پشتیبانی شده بحث کردیم. علاوه بر این، بر اساس آزمایشهای مختلفی که انجام دادیم، توصیههایی برای آموزش بهینه ارائه کردیم. نتایج مربوط به تنظیم دقیق سه مدل در دو مجموعه داده در پیوست در انتهای این پست نشان داده شده است. همانطور که از این نتایج می بینیم، تنظیم دقیق، خلاصه سازی را در مقایسه با مدل های تنظیم نشده بهبود می بخشد. به عنوان گام بعدی، میتوانید با استفاده از کد ارائه شده در مخزن GitHub، این مدلها را روی مجموعه دادههای خود تنظیم دقیق کنید تا نتایج را برای موارد استفاده خود آزمایش و محک بزنید.

نویسندگان مایلند از کمک های فنی کریستوفر ویتن، شین هوانگ، کایل اولریش، سیفی لی، امی یو، آدام کوزدرویچ، ایوان کراویتز، بنجامین کرابتری، هائوتین آن، مانان شاه، تونی کروز، ارنف شارما، جاناتان گینه گینه و جون قدردانی کنند. برنده شد.

درباره نویسنده

دکتر ویوک مدان یک دانشمند کاربردی با تیم آمازون SageMaker JumpStart است. او دکترای خود را از دانشگاه ایلینویز در Urbana-Champaign گرفت و پژوهشگر پست دکترا در جورجیا تک بود. او یک محقق فعال در یادگیری ماشین و طراحی الگوریتم است و مقالاتی در کنفرانس های EMNLP، ICLR، COLT، FOCS و SODA منتشر کرده است.

دکتر ویوک مدان یک دانشمند کاربردی با تیم آمازون SageMaker JumpStart است. او دکترای خود را از دانشگاه ایلینویز در Urbana-Champaign گرفت و پژوهشگر پست دکترا در جورجیا تک بود. او یک محقق فعال در یادگیری ماشین و طراحی الگوریتم است و مقالاتی در کنفرانس های EMNLP، ICLR، COLT، FOCS و SODA منتشر کرده است.

دکتر فاروق صابر یک معمار ارشد راه حل های متخصص هوش مصنوعی و یادگیری ماشین در AWS است. او دارای مدرک دکتری و کارشناسی ارشد در مهندسی برق از دانشگاه تگزاس در آستین و کارشناسی ارشد در علوم کامپیوتر از موسسه فناوری جورجیا است. او بیش از 15 سال سابقه کار دارد و همچنین دوست دارد به دانشجویان کالج تدریس و راهنمایی کند. او در AWS به مشتریان کمک می کند تا مشکلات تجاری خود را در زمینه علم داده، یادگیری ماشین، بینایی کامپیوتر، هوش مصنوعی، بهینه سازی عددی و حوزه های مرتبط فرموله و حل کنند. او و خانواده اش که در دالاس، تگزاس مستقر هستند، عاشق سفر و رفتن به سفرهای جاده ای طولانی هستند.

دکتر فاروق صابر یک معمار ارشد راه حل های متخصص هوش مصنوعی و یادگیری ماشین در AWS است. او دارای مدرک دکتری و کارشناسی ارشد در مهندسی برق از دانشگاه تگزاس در آستین و کارشناسی ارشد در علوم کامپیوتر از موسسه فناوری جورجیا است. او بیش از 15 سال سابقه کار دارد و همچنین دوست دارد به دانشجویان کالج تدریس و راهنمایی کند. او در AWS به مشتریان کمک می کند تا مشکلات تجاری خود را در زمینه علم داده، یادگیری ماشین، بینایی کامپیوتر، هوش مصنوعی، بهینه سازی عددی و حوزه های مرتبط فرموله و حل کنند. او و خانواده اش که در دالاس، تگزاس مستقر هستند، عاشق سفر و رفتن به سفرهای جاده ای طولانی هستند.

دکتر آشیش ختان یک دانشمند ارشد کاربردی با Amazon SageMaker JumpStart است و به توسعه الگوریتم های یادگیری ماشین کمک می کند. او دکترای خود را از دانشگاه ایلینویز Urbana-Champaign گرفت. او یک محقق فعال در یادگیری ماشین و استنتاج آماری است و مقالات زیادی در کنفرانس های NeurIPS، ICML، ICLR، JMLR، ACL و EMNLP منتشر کرده است.

دکتر آشیش ختان یک دانشمند ارشد کاربردی با Amazon SageMaker JumpStart است و به توسعه الگوریتم های یادگیری ماشین کمک می کند. او دکترای خود را از دانشگاه ایلینویز Urbana-Champaign گرفت. او یک محقق فعال در یادگیری ماشین و استنتاج آماری است و مقالات زیادی در کنفرانس های NeurIPS، ICML، ICLR، JMLR، ACL و EMNLP منتشر کرده است.

ضمیمه

این ضمیمه اطلاعات بیشتری در مورد معیار عملکرد و قالببندی دادهها ارائه میدهد.

محک زدن عملکرد

در این بخش، ما نتایجی را برای تنظیم دقیق سه مدل Llama 2 (7B، 13B، و 70B) در دو مجموعه داده مختلف ارائه میکنیم: عروسک و گفتگو. برای مجموعه داده Dolly، وظیفه ما خلاصه کردن یک پاراگراف از متن است، در حالی که برای Dialogsum، مدل را برای خلاصه کردن بحث بین دو نفر تنظیم می کنیم. در جداول زیر، ورودی مدل (اعلان و دستورالعمل)، حقیقت زمین (خلاصه)، پاسخ از مدل Llama 2 از قبل آموزش دیده و پاسخ از مدل Llama 2 بهینه برای هر یک از سه لاما را نشان می دهیم. 2 مدل. ما نتایج استنتاج را برای پنج نقطه داده نشان می دهیم. از جداول زیر می توانید متوجه شوید که خلاصه ها برای هر دو مجموعه داده زمانی که مدل ها را دقیق تنظیم می کنیم، بهبود می یابد.

- نتایج برای تنظیم دقیق مدل تولید متن Llama 2 7B در مجموعه داده Dolly:

| ورودی ها | حقیقت زمینی | پاسخ از مدل بدون تنظیم دقیق | پاسخ از Fine-Tuned Model |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که بهطور مناسب درخواست را تکمیل کند. در منطقه Provence-Alpes-Côte d'Azur فرانسه.nnساکنان این کمون در فرانسه به نام Allaudiens یا Allaudiennes شناخته می شوند.nnnn### پاسخ:n | Allauch یک کمون فرانسوی است که در شرق مارسی در بخش Bouches-du-Rhône در منطقه Provence-Alpes-Côte d'Azur فرانسه واقع شده است. ساکنان این کمون در فرانسوی به نام Allaudiens یا Allaudiennes شناخته می شوند. | آلاوش شهری است در 28 کیلومتری شرق مارسی در بخش بوش دو رون در منطقه پروانس-آلپ-کوت دازور فرانسه واقع شده است. این روستا یکی از زیباترین روستاهای فرانسه است. این شهر توسط تپه ها و تاکستان ها احاطه شده است و جمعیتی در حدود 6,000 نفر دارد. اولین بار در سال 1006 ذکر شد و دارای غنی است | این کمون در فلات سنگی به نام Massif du Gélas در شرق مارسی واقع شده است. منظره زیبایی از مارسی و خط ساحلی آن دارد. Allauch اکنون یک کمون توسعهیافته با تالار شهر و مجموعهای از مغازهها، بارها و رستورانها است. به دلیل قرار گرفتن آن بین مارسی و آلپیل، بسیاری از ویژگی های طبیعی منطقه، از جمله توده Glandes، همچنین به عنوان "W" شناخته شده است. |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که به طور مناسب درخواست را تکمیل کند.nn### دستورالعمل: nپستاندار تخمگذار چیست؟ - پستانداران تخمگذار بومی شرق استرالیا، از جمله تاسمانی. پلاتیپوس تنها نماینده زنده یا تاکسون یکنواخت خانواده آن (Ornithorhynchidae) و جنس (Ornithorhynchus) است، اگرچه تعدادی از گونه های مرتبط در پرونده فسیلی دیده می شوند.nnnn### پاسخ:n | پلاتیپوس نوک اردک یک پستاندار تخمگذار است که در شرق استرالیا یافت می شود. این تنها نماینده زنده در جنس Ornithorhynchus خود است. | من در مورد سوال شما کمی تحقیق کردم. من تمام اطلاعاتی را که در پاراگراف دوم خود ارائه کردید خواندم. من همچنین مقداری در مورد پلاتیپوس، از جمله [این صفحه] (https://phys.org/news/2019-04-australia-platypus-predator-species.html) مطالعه کردم. فکر می کنم پاسخ هایی برای سوال شما پیدا کردم. آیا میپرسید که آیا پلاتیپوس یک پستاندار تخمگذار است یا خیر؟ | پستانداری که تخم می گذارد، مانند پلاتیپوسن |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که درخواست را کامل کند.nn### دستورالعمل:nفلیکس لونا چه زمانی درگذشت؟ ## پاسخ: n | فلیکس لونا در 5 نوامبر 2009 درگذشت | فلیکس سزار لونا (30 سپتامبر 1925 - 5 نوامبر 2009) یک آرژانتینی بود.زمانی که لونا درگذشت؟ | فلیکس لونا در 5 نوامبر 2009 درگذشت |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که درخواست را به طور مناسب تکمیل کند. توهم ناشی از سیستم بصری و مشخصه آن یک ادراک بصری است که مسلماً به نظر می رسد با واقعیت متفاوت است. توهمات دارای تنوع گسترده ای هستند. طبقه بندی آنها دشوار است زیرا علت اصلی اغلب روشن نیست، اما طبقه بندی پیشنهادی توسط ریچارد گرگوری به عنوان یک جهت گیری مفید است. بر این اساس، سه طبقه اصلی وجود دارد: توهمات فیزیکی، فیزیولوژیکی و شناختی و در هر طبقه چهار نوع وجود دارد: ابهامات، تحریف ها، پارادوکس ها و تخیل. یک مثال کلاسیک برای اعوجاج فیزیکی، خمش ظاهری یک چوب نیمه غوطه ور در آب است. یک مثال برای یک پارادوکس فیزیولوژیکی، عواقب حرکت است (که در آن، با وجود حرکت، موقعیت بدون تغییر باقی می ماند). نمونه ای برای داستان های آنفیزیولوژیک، پس تصویر است. سه تحریف شناختی معمولی عبارتند از: توهم پونزو، پوگندورف، و مولر-لایر. توهمات فیزیکی توسط محیط فیزیکی ایجاد می شوند، به عنوان مثال توسط ویژگی های نوری آب. توهمات فیزیولوژیکی در چشم یا مسیر بینایی ایجاد می شود، به عنوان مثال از اثرات تحریک بیش از حد یک نوع گیرنده خاص. توهمات بصری شناختی نتیجه ناخودآگاهی ها هستند و شاید شناخته شده ترین آنها باشند.nnnn### پاسخ:n | 1. توهم بصری توسط سیستم بینایی ایجاد می شود و با یک ادراک بصری که به نظر می رسد متفاوت از واقعیت است مشخص می شود. به گفته ریچارد گرگوری، طبقهبندی پیشنهادی او به عنوان جهتگیری مفید است که سه طبقه اصلی دارد: توهمات فیزیکی، فیزیولوژیکی و شناختی، و در هر طبقه چهار نوع وجود دارد: ابهامات، تحریفها، پارادوکسها و داستانها. یک مثال برای اعوجاج فیزیکی خم شدن ظاهری یک چوب نیمه غوطه ور در آب داخلی است. یک مثال برای یک پارادوکس فیزیولوژیکی، عواقب حرکت است (که در آن، علی رغم حرکت، موقعیت بدون تغییر باقی می ماند). n2. نمونه ای برای یک داستان فیزیولوژیکی، پس تصویر است. سه تحریف شناختی عبارتند از: توهم پونزو، پوگندورف، و مولر-لایر.n3. توهمات فیزیکی توسط محیط فیزیکی ایجاد می شوند، به عنوان مثال توسط خواص نوری آب. توهمات فیزیولوژیکی در چشم یا مسیر بینایی ایجاد می شود.n4. شناخته شده ترین توهم، توهمات بصری است که نتیجه استنباطات ناخودآگاه است. | توهم نوری ذکر شده در این قسمت، حرکت توهمآمیز چوب است که تا حدی در آب فرو رفته است. همان میانگین ضریب هوشی.nn### ورودی:nبسیاری از دانشآموزان حاضر در آزمایش دارای ضریب هوشی متوسط یکسانی هستند و من معتقدم که آنها 50 درصد با بالاترین | توهمات نوری از محدودیتهای فیزیولوژیکی و روانشناختی مربوط به نحوه تفسیر و پاسخ ما به محرکهای بصری، هم محرکهای دنیای اطراف و هم محرکهای بصری تولید شده در داخل، استفاده میکنند. آنها یک محرک مشترک برای دو سیستم (فیزیکی و روانی/ادراکی) فراهم می کنند که به ما امکان می دهد هر دو را مقایسه کنیم و نحوه عملکرد هر یک را درک کنیم. انواع مختلفی از توهمات نوری وجود دارد که عبارتند از: |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که درخواست را به طور مناسب تکمیل کند. -محصولات با ارزش، اما شرکت های جدیدی که به مشتریان کم ارزش با فناوری توسعه ضعیف خدمات ارائه می دهند، می توانند آن فناوری را به تدریج بهبود بخشند تا زمانی که به اندازه کافی خوب باشدnnnn### پاسخ:n | معضل مبتکر: وقتی فناوریهای جدید باعث شکست شرکتهای بزرگ میشوند، که اولین بار در سال 1997 منتشر شد، شناختهشدهترین اثر استاد هاروارد و تاجر کلایتون کریستنسن است. مفهوم فناوریهای مخرب را بسط میدهد، اصطلاحی که او در مقالهای در سال 1995 با عنوان «فناوریهای مخرب: گرفتن موج» ابداع کرد. این توضیح میدهد که چگونه شرکتهای بزرگ فعلی با گوش دادن به مشتریان خود و ارائه محصولاتی با بالاترین ارزش، سهم بازار خود را از دست میدهند، اما شرکتهای جدیدی که با فناوری ضعیف توسعهیافته به مشتریان کمارزش خدمات ارائه میکنند، میتوانند آن فناوری را به تدریج بهبود دهند تا زمانی که به اندازه کافی خوب باشد. به سرعت سهم بازار را از کسب و کار مستقر بگیرید. کریستنسن توصیه میکند که شرکتهای بزرگ، بخشهای کوچک و چابکی داشته باشند که تلاش میکنند این پدیده را در داخل تکرار کنند تا از چشمپوشی و سبقت گرفتن توسط رقبای استارتآپ جلوگیری کنند. | سلام، n با عرض پوزش برای دیر پاسخ! من در هفته گذشته در تعطیلات بودم :)nnمعضل مبتکر نوشته کلیتون کریستنسن توضیح می دهد که «معضل مبتکر این است که دنبال کردن سود پایدار یک شرکت از طریق معرفی یا بهبود محصولاتش برای ارائه ارزش بیشتر به مشتریان فعلی، منجر به رها شدن همان مشتریان می شود. شرکت برای خرید نوآوری هایی که حداقل مقداری ارزش ارائه می کنند | معضل مبتکر کتابی است که توضیح میدهد چگونه شرکتهای بزرگ فعلی با گوش دادن به مشتریان خود و ارائه محصولاتی با بالاترین ارزش، سهم بازار خود را از دست میدهند، اما شرکتهای جدیدی که با فناوری توسعهیافته ضعیف به مشتریان کمارزش خدمات ارائه میدهند، میتوانند این فناوری را به تدریج بهبود بخشند. تا زمانی که به اندازه کافی خوب باشد nn |

- نتایج برای تنظیم دقیق مدل تولید متن Llama 2 13B در مجموعه داده Dolly:

| ورودی ها | حقیقت زمینی | پاسخ از مدل بدون تنظیم دقیق | پاسخ از Fine-Tuned Model |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که درخواست را به درستی تکمیل کند. بایرن پس از پیروزی 2021-2023 در کلاسیکر، موفق شد 10 قهرمانی متوالی بوندسلیگا را به دست آورد. با این حال، این تیم به طور غیرمنتظره ای در مرحله یک چهارم نهایی لیگ قهرمانان اروپا مغلوب ویارئال شد و برای دومین سال متوالی در آن مرحله به میدان رفت. در 3 مارس 1، ناگلزمن توسط بایرن آزاد شد و توماس توخل جایگزین او شد که تا 24 ژوئن 2023 قرارداد داشت.nnnn### پاسخ:n | توماس توخل در مارس 2023 جایگزین یولیان ناگلزمن شد و اکنون مربی جدید اف سی بایرن مونیخ است و قبلاً مربی چلسی بود. | nn"`pythonn{n "دستورالعمل": "مربی بعدی در بایرن مونیخ کیست که جانشین جولیان ناگلزمن شود؟"، n "اکشن": "مربی بعدی اف سی بایرن"، n "زمینه":{n " دوران ناگلزمن (2021–2023): n ” با سرمربی جدید جولیان ناگلزمن، بایرن موفق شد 10 قهرمانی متوالی بوندسلیگا را به دست آورد. | مربی بعدی در بایرن مونیخ توماس توخل خواهد بود. توخل پس از جدایی ناگلزمن از تیم در 24 مارس 2023 جانشین جولیان ناگلزمن خواهد شد.nn |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که بهطور مناسب درخواست را تکمیل کند. او در سال 29 از دانشگاه پاریس فارغ التحصیل شد و در موسسات آموزش عالی مختلف در پاریس به تحصیل حقوق، نقد تاریخی و زبان شناسی پرداخت و مدرک LL.B را دریافت کرد. در سال 1851. یک دانش آموز در مدرسه شارت، پایان نامه او Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires نامیده شد و دیپلم «مقامات قضایی فوق العاده» را گرفت. در سال 1930. در آغاز جنگ فرانسه و پروس در 1868، او در ارتش فرانسه نام نویسی کرد و در طول مبارزه در ارتش فرانسه خدمت کرد. République française، سپس توسط لئون گامبتا، که او را در فرانسه میشناخت، و دیدگاههای سیاسی او را پذیرفته بود، ویرایش شد. در مارس 1873، کوهن به عنوان معلم خصوصی زبان فرانسه در کالج کلمبیا منصوب شد و اندکی پس از آن مربی شد. با رای مردم فرانسوی ساکنان نیویورک، او در سال 1874 در تامنی هال برای ایراد سخنرانی در مورد گامبتا انتخاب شد، و در سال 1870 از کمبریج، ماساچوست، به دلیل مرگ ویکتور هوگو به همین منظور فراخوانده شد.nnnn. ### پاسخ: n | آدولف کوهن (زاده 29 مه 1851 - 1930) یک معلم فرانسوی-آمریکایی، متولد پاریس بود. او در سال 1868 از دانشگاه پاریس فارغ التحصیل شد و در موسسات مختلف آموزش عالی در پاریس به تحصیل حقوق، نقد تاریخی و زبان شناسی پرداخت و مدرک LL.B را دریافت کرد. در سال 1873. یکی از دانشآموزان مدرسه شارت، پایاننامه او Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions «فوقالعادهای» نام گرفت و مدرک فوقالعادهای را گرفت. در سال 1874. در آغاز جنگ فرانسه و پروس در 1870، او در ارتش فرانسه نام نویسی کرد و در طول مبارزه در ارتش فرانسه خدمت کرد. République française، سپس توسط لئون گامبتا، که او را در فرانسه میشناخت، و دیدگاههای سیاسی او را پذیرفته بود، ویرایش شد. در مارس 13، کوهن به عنوان معلم خصوصی زبان فرانسه در کالج کلمبیا منصوب شد و اندکی پس از آن مربی شد. با رای مردمی ساکنان فرانسوی نیویورک، او در سال 1875 در تامانی هال برای ایراد مراسم تشییع جنازه گامبتا انتخاب شد و در سال 1876 از کمبریج، ماساچوست، پس از مرگ ویکتور هوگو، به همین منظور فراخوانده شد. | nAdolphe Cohn (زاده 29 مه 1851 - 1930) یک معلم فرانسوی-آمریکایی بود که در پاریس متولد شد. او در سال 1868 از دانشگاه پاریس فارغ التحصیل شد و در موسسات مختلف آموزش عالی در پاریس به تحصیل حقوق، نقد تاریخی و زبان شناسی پرداخت و مدرک LL.B را دریافت کرد. در سال 1873. دانش آموز É | آدولف کوهن یک معلم فرانسوی-آمریکایی بود که در 29 مه 1851 در پاریس به دنیا آمد. او در دانشگاه پاریس تحصیل کرد و در سال 1873 مدرک حقوق گرفت. او همچنین در École des Chartes کار کرد و مدرک "بایگانی paléographe" خود را در سال 1874 دریافت کرد. XNUMX. در آغاز جنگ فرانسه و پروس، او به ارتش فرانسه پیوست و تمام مدت به آنها خدمت کرد. |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که به طور مناسب درخواست را تکمیل کند.nn### دستورالعمل:nچگونه مخاطبان هدف مک دونالد در طول زمان تغییر کرده است؟ غذای شاد مک دونالد، که شامل یک اسباب بازی است که اغلب با یک فیلم خانوادگی تازه منتشر شده گره خورده است، یک نمونه قابل توجه است. رونالد مکدونالد، یک طلسم تبلیغاتی دلقک که در سال 1963 معرفی شد و برای جذابیت برای کودکان طراحی شد، یکی دیگر از موارد است. علاوه بر این، در سال 1987 مکدونالدز برای تبلیغات بیشتر برای کودکان، یک مکان بازی را در رستورانهای خود قرار داد و رستورانهایشان را به محیطی جذابتر برای کودکان تبدیل کرد. علاوه بر این، از سال 1996 تا 2006، دیزنی شریک انحصاری مک دونالد بود و محصولات آنها را به یکدیگر پیوند می داد. آنها پایان این قرارداد را در ماه می 2006 اعلام کردند، با برخی گزارش ها مبنی بر اینکه دیزنی نگران چاقی دوران کودکی است. به غیر از دیزنی، مک دونالد نیز از سال 1985، زمانی که سیستم سرگرمی نینتندو برای اولین بار معرفی شد، با نینتندو همکاری کرده است. در سال 1987، مکدونالدز همچنین یک زمین بازی نینتندو در رستورانهای خود ایجاد کرد که در آن بچهها میتوانستند در حالی که منتظر غذای خود هستند، روی کنسولهای نینتندو بازی کنند. در طول سال 2007، مکدونالدز شروع به ارائه WiFi از کنسولهای نینتندو کرد. به کودکان این توانایی را می دهد که در هر کجا که هستند بازی کنند. با توجه به اینکه مخاطبین هدف کودکانی که این فیلمهای جدید را منتشر میکنند و اسباببازیها را در خود جای دادهاند، از بچهها برای رسیدن به جیب والدینشان به دلیل سرمایهگذاری کلانشان استفاده میکند.nnnn### پاسخ:n | مک دونالد به طور مداوم تبلیغات خود را مستقیماً جمعیت جوان را هدف قرار داده است. از سال 1963، آنها رونالد مک دونالد را معرفی کردند، یک طلسم تبلیغاتی دلقک که برای جذب کودکان خردسال طراحی شده بود. در طول سالها، مکدونالد با شرکتهای متعددی مانند نینتندو و دیزنی که محصولاتی را برای کودکان هدف قرار میدهند، شریک شد. | رستوران های فست فود همیشه جوانان را هدف گرفته اند. هنگام تبلیغ برای جوانان، غذاهای شاد نیز عامل مهمی هستند. مک دونالد یک شرکت جوان با دید نسبتا محدودی از جهان بود | از زمان راهاندازی، مکدونالد با رستورانهای فست فود و محصولات غذایی با محوریت کودکان و همچنین تبلیغات خود که عمدتاً جوانان را هدف قرار داده است، مخاطبان خود را به کودکان و نوجوانان هدف قرار داده است. در حالی که والدینشان کودکان را به مکدونالد میرانند، رستوران در اصل یک تبلیغ والدین برای فرزندانشان است: مکدونالد با رستورانهای رنگارنگ و اسباببازیهایی که در غذایشان یافت میشود برای کودکان جذاب است. |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که بهطور مناسب درخواست را تکمیل کند. این اداره تحت مدیریت بخش درآمد ویساخاپاتنام است و دفتر مرکزی آن در آنانداپورام واقع شده است. ماندال آنانداپورام از شرق به ماندال بهمونی پاتنام، از جنوب به چایناگادیلا، از شمال به پادمانابهام و از غرب به کوتاوالاسا محدود میشود.nnnn### پاسخ:n | ماندال آنانداپورام یکی از ۴۶ ماندال در ناحیه ویساخاپاتنام در ایالت آندرا پرادش هند است. این اداره تحت مدیریت بخش درآمد ویساخاپاتنام است و دفتر مرکزی آن در آنانداپورام واقع شده است. | nnnn | ماندال آنانداپورام یکی از ۴۶ ماندال در ناحیه ویساخاپاتنام در ایالت آندرا پرادش هند است. این اداره تحت مدیریت بخش درآمد ویساخاپاتنام است و دفتر مرکزی آن در آنانداپورام واقع شده است. ماندال آنانداپورام از شرق به ماندال بهمونی پاتنام، از جنوب به چایناگادیلا، از شمال به پادمانابهام و کوث محدود میشود. |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که درخواست را بهطور مناسب تکمیل کند. مزرعه لبنیات ماکس یاسگور در بتل، نیویورک، ایالات متحده، 15 مایلی (18 کیلومتری) جنوب غربی شهر وودستاک. این نمایشگاه که با عنوان "نمایشگاه آکواریوم: 1969 روز صلح و موسیقی" نامگذاری شده است و به طور متناوب به عنوان جشنواره راک ووداستاک از آن یاد می شود، بیش از 40 مخاطب را جذب کرد. با وجود باران پراکنده، سی و دو نمایش در فضای باز اجرا شد. این جشنواره یکی از بزرگترین جشنوارههای موسیقی بود که در تاریخ برگزار شد. اهمیت این رویداد با یک فیلم مستند در سال 65، یک آلبوم موسیقی متن همراه، و آهنگی توسط جونی میچل که موفقیت بزرگی برای کراسبی، استیلز، نش اند یانگ و متیوز ساترن کامفورت شد، تقویت شد. رویدادهای موسیقی با نام وودستاک برای سالگردها برنامه ریزی شده بود که شامل دهمین، بیستمین، بیست و پنجمین، سی ام، چهلمین و پنجاهمین سالگرد بود. در سال 3، مجله رولینگ استون آن را به عنوان شماره 400,000 از 1970 لحظه ای که تاریخ راک اند رول را تغییر داد، فهرست کرد. در سال 2004، سایت جشنواره در فهرست ملی اماکن تاریخی ثبت شد.nnnn### پاسخ:n | نمایشگاه موسیقی و هنر وودستاک که معمولاً وودستاک نامیده میشود، جشنوارهای موسیقی بود که در 15 تا 18 اوت 1969 در مزرعه لبنیات ماکس یاسگور در بتل، نیویورک، ایالات متحده، در 40 مایلی (65 کیلومتری) جنوب غربی شهر برگزار شد. از ووداستاک این نمایشگاه که با عنوان "نمایشگاه آکواریوم: 3 روز صلح و موسیقی" نامگذاری شده است و به طور متناوب به عنوان جشنواره راک ووداستاک از آن یاد می شود، بیش از 400,000 مخاطب را جذب کرد. با وجود باران پراکنده، سی و دو نمایش در فضای باز اجرا شد. این جشنواره یکی از بزرگترین جشنوارههای موسیقی بود که در تاریخ برگزار شد. اهمیت این رویداد با یک فیلم مستند در سال 1970، یک آلبوم موسیقی متن همراه، و آهنگی توسط جونی میچل که موفقیت بزرگی برای کراسبی، استیلز، نش اند یانگ و متیوز ساترن کامفورت شد، تقویت شد. رویدادهای موسیقی با نام وودستاک برای سالگردها برنامه ریزی شده بود که شامل دهمین، بیستمین، بیست و پنجمین، سی ام، چهلمین و پنجاهمین سالگرد بود. در سال 2004، مجله رولینگ استون آن را به عنوان شماره 19 از 50 لحظه ای که تاریخ راک اند رول را تغییر داد، فهرست کرد. در سال 2017، سایت جشنواره در فهرست ملی اماکن تاریخی ثبت شد. | nAnswer:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`n nn## راه حل:nn n برای مشاهده راه حل nn"`jsnn// راه حل مورد نیاز است | نمایشگاه موسیقی و هنر وودستاک که در اواخر 15 تا 18 اوت برگزار شد، یک رویداد تاریخی در بیتل، نیویورک توسط نسل ضد فرهنگ بود. جمعیت حاضر در جشنواره بیش از 400,000 نفر بود. با وجود باران پراکنده، حدود 32 عمل در فضای باز انجام شد. این جشنواره به عنوان یکی از بزرگترین جشنواره های موسیقی که تا به حال در تاریخ برگزار شده بود در نظر گرفته شد |

- نتایج برای تنظیم دقیق مدل تولید متن Llama 2 70B در مجموعه داده Dolly:

| ورودی ها | حقیقت زمینی | پاسخ از مدل بدون تنظیم دقیق | پاسخ از Fine-Tuned Model |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که درخواست را بهطور مناسب تکمیل کند. این شرکت در سال 1988 تشکیل شد، زمانی که سوئد Allmänna Svenska Elektriska Aktiebolaget (ASEA) و Brown, Boveri & Cie سوئیس ادغام شدند تا ASEA Brown Boveri را ایجاد کنند که بعداً به حروف اول ABB ساده شد. هر دو شرکت در اواخر دهه 1800 تأسیس شدند و تولیدکنندگان عمده تجهیزات الکتریکی بودند، تجارتی که ABB امروزه در آن فعال است. این شرکت همچنین از آن زمان به فناوری رباتیک و اتوماسیون نیز گسترش یافته است.nnnn### پاسخ:n | ABB Ltd. یک شرکت چند ملیتی سوئدی-سوئیسی است که دفتر مرکزی آن در زوریخ، سوئیس است. این شرکت در سال 1988 تشکیل شد، زمانی که سوئد Allmanna Svenska Elektriska Aktiebolaget (ASEA) و Brown, Boveri & Cie سوئیس ادغام شدند تا ASEA Brown Boveri را ایجاد کنند که بعداً به حروف اول ABB ساده شد. nnهر دو شرکت در اواخر دهه 1800 تأسیس شدند و تولیدکنندگان عمده تجهیزات الکتریکی بودند، تجارتی که ABB امروزه در آن فعال است. این شرکت همچنین از آن زمان به فناوری رباتیک و اتوماسیون نیز گسترش یافته است. | * ABB یک شرکت چندملیتی سوئدی-سوئیسی است. | ABB یک شرکت چند ملیتی سوئدی-سوئیسی است که دفتر مرکزی آن در زوریخ، سوئیس است. این شرکت در سال 1988 تشکیل شد، زمانی که سوئد Allmänna Svenska Elektriska Aktiebolaget (ASEA) و Brown, Boveri & Cie سوئیس ادغام شدند تا ASEA Brown Boveri را ایجاد کنند که بعداً به حروف اول ABB ساده شد. هر دو شرکت در اواخر دهه 1800 تأسیس شدند و بودند |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که درخواست را کامل کند.nn### دستورالعمل:nچرا یک ویلیام فاتح، فرانسوی، پادشاه انگلستان شد؟ تاج و تخت انگلستان در دست ادوارد اعتراف کننده بی فرزند بود که زمانی پسر عموی اولش را برکنار کردند. مدعیان بالقوه دیگری نیز وجود داشتند، از جمله ارل انگلیسی قدرتمند هارولد گادوینسون، که ادوارد او را در بستر مرگش در ژانویه 1050 به عنوان پادشاه نامید. ویلیام با این استدلال که ادوارد قبلاً تاج و تخت را به او وعده داده بود و هارولد برای حمایت از ادعای او سوگند یاد کرده بود، یک ساختمان بزرگ ساخت. او در 1060 اکتبر 1066 در نبرد هاستینگز هارولد را قاطعانه شکست داد و کشت. پس از تلاش های نظامی بیشتر، ویلیام در روز کریسمس 1066 در لندن تاجگذاری کرد. او قبل از بازگشت به نرماندی مقدمات حکومت انگلستان را در اوایل سال 14 فراهم کرد. چندین شورش ناموفق به دنبال داشت، اما کنترل ویلیام تا سال 1066 عمدتاً در انگلستان امن بود و به او اجازه داد که بخش اعظم سلطنت خود را در اروپای قاره ای بگذراند.nnnn### پاسخ:n | ویلیام فاتح اهل نرماندی واقع در شمال غربی فرانسه بود. پادشاه انگلستان در اواخر دهه 1050 و اوایل دهه 1060 ادوارد اعتراف کننده بود. ادوارد پسر عموی ویلیام بود. از آنجایی که ادوارد بدون فرزند بود، افراد متعددی ادعا می کردند که وارث قانونی هستند و باید پادشاه شوند. این ادعاهای متضاد باعث درگیری مسلحانه شد. ویلیام به انگلستان حمله کرد و در نبرد هاستینگز پیروز شد و ارل هارولد گادوینسون را شکست داد. چندین نبرد به دنبال داشت، اما ویلیام در اواخر سال 1066 پادشاه انگلستان شد. او در دهه بعد با شورش های متعددی برخورد کرد، اما قدرت خود را حفظ کرد. در نهایت او توانست به نرماندی بازگردد و از آنجا بر انگلستان حکومت کند. | ویلیام فاتح پادشاه انگلستان شد زیرا در دهه 1050 و اوایل دهه 1060، او به مدعی برای تاج و تخت انگلستان تبدیل شد که توسط ادوارد اعتراف کننده بدون فرزند نگهداری می شد، پسر عموی اولش که یک بار حذف شد.nnnپاسخ می تواند خالی باشد اما باید 256 کاراکتر داشته باشد. n | پس از مرگ پادشاه هارولد در نبرد هیستینگز در 14 اکتبر 1066، ویلیام فاتح در روز کریسمس 1066 به عنوان پادشاه انگلیس تاج گذاری کرد و فتح انگلستان توسط نورمن ها را تثبیت کرد.nn |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که درخواست را به طور مناسب تکمیل کند. او چهارمین کشتی از یک کوارتت کشتی با بیش از 20,000 GRT بود که به آنها چهار بزرگ لقب داده شد. این کشتی تنها کشتی از چهار کشتی بود که هرگز بزرگترین کشتی جهان نبود. با این حال، او بزرگترین، سریعترین و مجللترین کشتی در بین چهار کشتی بزرگ بود و اولین کشتی اقیانوس پیمایی بود که دارای استخر سرپوشیده و حمام ترکی بود. از سال 1911 به خواهرش در مسیر ثانویه از لیورپول پیوست. آنها در واقع خطوط آهسته ای بودند که برای ارائه خدمات با قیمت های متوسط طراحی شده بودند. هنگامی که جنگ جهانی اول آغاز شد، دریای آدریاتیک از جمله کشتی هایی بود که به خدمات غیرنظامی فراآتلانتیک خود ادامه داد، در حالی که آذوقه های زیادی را حمل می کرد. در سال 1917، او به خدمت گرفته شد و به عنوان یک حمل و نقل نیرو خدمت کرد. پس از جنگ، او چندین بار بازسازی شد و به تدریج برای سفرهای دریایی مورد استفاده قرار گرفت، که خدمات اصلی او در دهه 1930 شد. هنگامی که کانارد لاین و وایت استار لاین در سال 1934 با هم ادغام شدند، او به سرعت غیر ضروری تلقی شد و در پایان سال فروخته شد. او در سال 1935 در اوزاکا اسقاط شد.nnnn### پاسخ:n | RMS Adriatic یک کشتی اقیانوس پیمای بریتانیایی از خط وایت استار بود. او چهارمین کشتی از یک کوارتت کشتی با بیش از 20,000 GRT بود که به آنها چهار بزرگ لقب داده شد. این کشتی تنها کشتی از چهار کشتی بود که هرگز بزرگترین کشتی جهان نبود. با این حال، او بزرگترین، سریعترین و مجللترین در بین چهار کشتی بزرگ بود و اولین کشتیرانی اقیانوسی بود که دارای استخر سرپوشیده و حمام ترکی بود. | RMS Adriatic یک کشتی اقیانوس پیمای بریتانیایی از خط وایت استار بود. او چهارمین کشتی از یک کوارتت کشتی با بیش از 20,000 GRT بود که به آنها چهار بزرگ لقب داده شد. این کشتی تنها کشتی از چهار کشتی بود که هرگز بزرگترین کشتی جهان نبود. nn### Contextnاز این نوع سوال معمولا برای پرس و جو از موتور جستجو استفاده می شود. ورودی یک ورودی پرس و جو است و پاسخ عمومی است | RMS Adriatic یک کشتی اقیانوس پیمای بریتانیایی از خط ستاره سفید بود. او در سال 1906 به آب انداخته شد اما اولین قایقرانی تجاری او در سال 1907 بود. او چهارمین کشتی از یک کوارتت بیش از 20,000 تن بود و به آن چهار بزرگ لقب داده شد. سه مورد دیگر RMS Celtic در سال 1901، RMS Baltic در 1903 و RMS بودند. |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که به طور مناسب درخواست را کامل کند.nn### دستورالعمل:nCGRO که فوتونها را تشخیص میدهد چیست؟ GeV، در مدار زمین از سال 20 تا 30. این رصدخانه دارای چهار تلسکوپ اصلی در یک فضاپیما بود که پرتوهای ایکس و پرتوهای گاما، از جمله ابزارهای فرعی تخصصی و آشکارسازهای مختلف را پوشش میداد. پس از 1991 سال تلاش، رصدخانه از شاتل فضایی آتلانتیس در طول STS-2000 در 14 آوریل 37 پرتاب شد و تا زمان خروج از مدار خود در 5 ژوئن 1991 کار کرد. این رصدخانه در مدار پایین زمین در 4 کیلومتری (2000 مایلی) مستقر شد. از کمربند تشعشع ون آلن اجتناب کنید. این سنگین ترین محموله اخترفیزیکی بود که در آن زمان با 450 کیلوگرم (280 پوند) پرواز کرده بود.nnnn### پاسخ:n | CGRO رصدخانه پرتو گامای کامپتون (CGRO) است و یک رصدخانه فضایی بود که فوتونهایی با انرژیهای 20 کو تا 30 گیگا ولت در زمین را از سال 1991 تا 2000 شناسایی میکرد. | **رونویس:** ابزار EGRET فوتون ها را تشخیص می دهد.nn | رصدخانه پرتو گاما کامپتون (CGRO) فوتونهایی را با انرژیهای 20 کو تا 30 گیگا الکترون ولت اندازهگیری میکند. |

| در زیر دستورالعملی است که یک کار را توصیف می کند، همراه با ورودی که زمینه بیشتری را ارائه می دهد. پاسخی بنویسید که بهطور مناسب درخواست را تکمیل کند. پیانیست او برای اولین بار در اکتبر 2 در سن 1986 سالگی هنگامی که به عنوان تکنواز کنسرتو پیانو لیست شماره 2004 را با فیلارمونیک نیویورک تحت رهبری لورین مازل در تور آسیایی آنها در سئول، دائجون و توکیو اجرا کرد، توجه بین المللی را به خود جلب کرد. هنگامی که در فوریه 18 به مرکز هنرهای سئول بازگشتند، سون دوباره با مازل و فیلارمونیک نیویورک اجرا کرد، این بار به عنوان تکنواز برای کنسرتو پیانو شماره 1 بتهوون. جوایز او شامل مدال نقره در سیزدهمین مسابقه پیانو بین المللی ون کلیبرن (2008) است. ) و مسابقه بین المللی چایکوفسکی 2، جایی که او همچنین جایزه بهترین کنسرتو مجلسی و بهترین اجرای کار سفارشی را دریافت کرد. او همچنین برنده مدال برنز مسابقه بین المللی استاد پیانو آرتور روبینشتاین (2009) nnn### پاسخ:n | Yeol Eum Son (زاده ۲ مه ۱۹۸۶ در وونجو، کره جنوبی) یک نوازنده کلاسیک پیانو اهل کره جنوبی است. او برای اولین بار در اکتبر 2 در سن 1986 سالگی هنگامی که به عنوان تکنواز کنسرتو پیانو لیست شماره 2004 را با فیلارمونیک نیویورک تحت رهبری لورین مازل در تور آسیایی آنها در سئول، دائجون و توکیو اجرا کرد، توجه بین المللی را به خود جلب کرد. هنگامی که در فوریه 18 به مرکز هنرهای سئول بازگشتند، سون دوباره با مازل و فیلارمونیک نیویورک اجرا کرد، این بار به عنوان تکنواز برای کنسرتو پیانو شماره 1 بتهوون. جوایز او شامل مدال نقره در سیزدهمین مسابقه پیانو بین المللی ون کلیبرن (2008) است. ) و مسابقه بین المللی چایکوفسکی 2، جایی که او همچنین جایزه بهترین کنسرتو مجلسی و بهترین اجرای کار سفارشی را دریافت کرد. او همچنین برنده مدال برنز مسابقه بین المللی استاد پیانو آرتور روبینشتاین (2009) شد. | Yeol Eum Son یک پیانیست ماهر است که با برخی از معتبرترین ارکسترهای جهان اجرا داشته است. او در سال 2009 در سیزدهمین مسابقه بین المللی پیانو ون کلیبرن نقره گرفت و در سال 2005 در مسابقه استاد پیانوی بین المللی آرتور روبینشتاین برنز گرفت. او همچنان با موفقیت های زیادی در سراسر جهان اجرا می کند. | Yeol Eum Son پیانیست بسیار خوبی است. او کار بین المللی خود را با پیوستن به برخی از بزرگترین موسیقیدانان جهان در سن 18 سالگی آغاز کرد. و تا زمانی که 25 ساله شد در دو مسابقه بین المللی مدال نقره کسب کرده بود. |

- نتایج برای تنظیم دقیق مدل تولید متن Llama 2 7B در مجموعه داده Dialogsum:

| ورودی ها | حقیقت زمینی | پاسخ از مدل بدون تنظیم دقیق | پاسخ از Fine-Tuned Model |

| این گفتگو را خلاصه کنید:n#Person1#: این یک غذای عالی است!n#Person2#: متشکرم. خوشحالم که همه چیز اینقدر خوب پیش رفت. ظرف مرغ؟n#Person1#: عالی نیست؟ یعنی مرغ زنجبیل نارگیلی با برنج.n#Person2#: آیا سوپ سوپ میگو است؟ در انتخاب شرابی که با این غذا ترکیب شود. به خوبی با مرغ هماهنگ می شود.n—nSummary:nnn### پاسخ:n | #Person1# فکر می کند غذای آماده شده توسط #Person2# عالی است. #Person2# مواد تشکیل دهنده ظروف را معرفی می کند. | پس از تکمیل گفتگو، فرد پاسخ مناسبی به اطلاعات جمع آوری شده ارائه می دهد. به عنوان مثال، شخص 1 می تواند بگوید، nn#Person1#: این عالی است! ممنون.nn#Person2#: خیلی خوش آمدید. من فکر کردم که شما غذای خود را دوست دارید. خوشحالم که از آن لذت بردید.nn—n— — — — –nnn### خلاصه:nnn### پاسخ:nپس از گفتگو | #Person1# و #Person2# در محل #Person2# غذا می خورند. آنها در مورد غذا و شرابی که با مرغ مخلوط می شود صحبت می کنند.nn |

| این گفتگو را خلاصه کنید:n#Person1#: ببخشید، من در حال نوشتن مقاله ای در مورد یونان باستان هستم. آیا کتابی در این زمینه وجود دارد که بتوانید توصیه کنید؟n#Person2#: غازها؟ می خواهید در مورد غازهای باستانی بنویسید؟ من هرگز در مورد چنین چیزی نشنیده ام. به هر حال، این ممکن است با کتابی از برخی حیوانات باشد، این ردیف J است. یا می خواهید علم را امتحان کنید، که در ردیف Gn#Person1#: حیوانات است؟ اما یونان یک کشور است، نه یک حیوان.n#Person2#: آه، یونان. خوب، می دانید، امروز باید روز شانس شما باشد. به تازگی مجموعه جدیدی از کتاب ها در این زمینه دریافت کرده ایم. اینجا در ردیف Cn#Person1# نویسندگانی وجود دارند: می بینم. این تعداد زیادی کتاب است، کدام را پیشنهاد می کنید؟ اونی که مجسمه روی جلدش هست. یکی از میلتون پایک نیز وجود دارد. جلوی آن نقاشی سرباز است. همانطور که می بینید، خیلی ضخیم نیست، بنابراین خواندن آن نباید زمان زیادی را صرف کند. اما احتمالا بهترین کتاب کتابی است که تصویر استادیوم المپیک باستانی را دارد. برنده چندین جایزه برای آثار تاریخی شده است. فکر می کنم کتاب میلتون پایک را بگیرم.n#Person2#: باشه. آیا می توانم کارت کتابخانه شما را داشته باشم؟n#Person1#: مطمئناً، شما اینجا هستید.n—nخلاصه:nnn### پاسخ:n | #Person1# از #Person2# می خواهد که چند کتاب در مورد یونان باستان توصیه کند. #Person2# یکی از رابین اسمیت را پیشنهاد می کند که بسیار طولانی است، یکی از میلتون پایک را که خیلی ضخیم نیست، و کسی که چندین جایزه تاریخ را برنده شده است. از آنجایی که #Person1# زمان کافی ندارد، #Person1# کتاب میلتون پایک را دریافت خواهد کرد. | n—nnخلاصه:n | #شخص1# در حال نوشتن مقاله ای درباره یونان باستان. #Person2# کتابهای مربوط به یونان باستان را به #Person1# توصیه می کند که همگی به تازگی دریافت شده اند و پیشنهاد می کند کتاب را توسط Milton Pike.nn تهیه کنید. |

| این دیالوگ را خلاصه کنید:n#Person1#: خوب، می بینم که کتاب هایت را داری، جورج. اما آیا شما می خوانید؟ به نظر می رسد شما فقط رنگ آمیزی می کنید.n#Person2#: قسمت های مهم کتاب را علامت گذاری می کنم. رنگ ها برای چیزهای مختلف هستند.n#Person1#: چه چیزی را دوست دارید؟n#Person2#: ایده های اصلی زرد هستند. جزئیات مهمی که باید به خاطر بسپارید صورتی است و سبز روشن برای ایده های دشوار است. وقتت رو تلف نمیکنی؟n#Person1#: فکر نمیکنم مامان. امشب همه را می خوانم. فردا گوش میدم و وقتی زمان مطالعه فرا می رسد، من از قبل بیشتر اطلاعات را می دانم. خواندن فعال و این بهترین راه برای یادگیری با هر سرعتی است که انتخاب می کنید.n#Person2#: می بینم. و این دفترچه برای چیست؟ n#Person1#: برای یادداشت برداری است. چه نوع چیزهایی را یادداشت می کنید؟n#Person2#: گاهی خلاصه می نویسم. در این صفحه من سوالات را می نویسم. و البته من صفحه دیگری دارم که در آن کلمات جدید را یادداشت می کنم.n—nSummary:nnn### پاسخ:n | جورج به مادرش می گوید که علامت گذاری قسمت های مهم کتاب با رنگ های مختلف روش یادگیری اوست. روی دفترچه یادداشت هم می کند و گاهی خلاصه می نویسد. | #شخص1#: اوه اوه! خواندن فعال، سوالات خواندن، یادداشتهای واژگان، خلاصهنویسی و برجسته کردن. اکنون می توانم ببینم که چه تفاوتی در یادگیری اطلاعات دارید. من تحت تاثیر قرار گرفتم.n#Person2#: متشکرم. خواندن بهترین راه برای یادگیری و به خاطر سپردن اطلاعات جدید است. آیا در حال حاضر از خواندن فعال استفاده می کنید؟ | جورج فعالیت هایی را که برای خواندن سریع کتاب هایش انجام می دهد را شرح می دهد. جورج دفترچه یادداشت را به مادر نشان می دهد و نحوه یادداشت برداری را توضیح می دهد.nn |

| این گفتگو را خلاصه کنید:n#Person1#: صبح بخیر قربان. می توانم پاسپورت شما را ببینم؟n#Person2#: بله، البته. اینجاست.n#Person1#: متشکرم. آیا همه اینها مال شماست؟ n#Person2#: نه، برخی از آنها مال دوست من هستند. آیا پاسپورت او را هم می خواهید؟n#Person1#: بله، لطفا. آیا وسایل دستی دارید؟ لطفاً این چمدان بزرگ را باز کنید؟n#Person2#: باشه. فقط یک لحظه. این فقط چند لباس و لوازم بهداشتی است.n#Person1#: باشه. آیا چیزی برای اعلام دارید؟n#Person2#: فکر میکنم چیزی وجود ندارد. هیچ کدام از اینها.n#Person1#: متشکرم. ممکن است چمدان خود را قفل کنید. پاسپورت های شما اینجاست.n#Person2#: خیلی ممنون.n—nخلاصه:nnn### پاسخ:n | #Person1# پاسپورت دوست #Person2# و #Person2# را می بیند و چمدان آنها را چک می کند. #Person2# به #Person1# می گوید که چیزی برای اعلام ندارند. #شخص1# آنها را رها می کند. | > فکر می کنم چیزی وجود ندارد.nnn—n**دسته ها:**nn- [مکالمه (32)](../مکالمه/32.md)n – [TSA (4)](../مکالمه/32/ 4.md)nn### کلید:nn :information_source: 31 (TSA)n:information_source: 32 (TSA)nn—-n* هر گونه حق چاپ | مسئول مهاجرت از #Person2# می خواهد که پاسپورتش را نشان دهد و چمدان بزرگش را باز کند. #Person2# چیزی برای اعلام ندارد و ممکن است چمدانش را قفل کند.nn |

| این گفتگو را خلاصه کنید:n#Person1#: چای چینی در سراسر جهان مشهور است. من می خواهم چندین جعبه بخرم.n#Person2#: انواع مختلفی از چای در چین وجود دارد. بستگی به مزه و تاثیر داره.n#Person1#: خب من اصلا چای چینی بلد نیستم.n#Person2#: این چای سبزه، تو تابستون میتونی بنوشی. می تواند گرمای تابستان را تسکین دهد و برای حفظ ریه های شما مفید است.n#Person1#: جالب به نظر می رسد. در مورد این چطور؟ بوی معطر می دهد.n#Person2#: چای یاس مرغوب است. معطر است و طعم مطبوعی دارد.n#Person1#: چای یاس را می گیرم. آیا می توانید آن را با کاغذ بسته بندی و روبان بسته بندی کنید؟ این یک هدیه برای دوست من است.n#Person2#: اشکالی ندارد. یک لحظه صبر کنید.n—nSummary:nnn### پاسخ:n | #Person2# به #Person1# که میخواهد چای چینی بخرد چای سبز، تی سیاه و یاسمن را توصیه میکند و #Person1# تصمیم میگیرد چای یاس را بخورد. | #[انگلیسی]#: چای چینی در سراسر جهان مشهور است. من می خواهم چندین جعبه بخرم.n#[فرانسوی]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[اسپانیایی]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[آلمانی]#: Ich mö | #شخص1# میخواهد چند جعبه چای چینی با انواع مختلف چای بخرد. #Person2# به #Person1# کمک می کند تا انتخاب کند و آن را بسته بندی می کند.nn |

- نتایج برای تنظیم دقیق مدل Llama-2 13B در مجموعه داده Dialogsum:

| ورودی ها | حقیقت زمینی | پاسخ از مدل بدون تنظیم دقیق | پاسخ از Fine-Tuned Model |

| این دیالوگ را خلاصه کنید:n#Person1#: خانم تامپسون زمانی خداباور بود، جیسون.n#Person2#: چرا؟ ما نباید به مشکل بخوریم یا چیزی؟ در واقع ما در کل بحث کلاس امروز صبح بسیار فعال بودیم.n#Person1#: همین. به نظر من اصلا چیز بدی نیست. من فکر می کنم او از ما می خواهد که برای نظارت بر کلاس اجرا کنیم. n#Person2#: اوه! واقعا؟ این مسئولیت بسیار زیادی است. علاوه بر این، افتخار بزرگی است که از شما خواسته شود این کار را انجام دهید. این بدان معناست که خانم تامپسون ما را به عنوان رهبر می بیند. آیا میتوانیم آن را با هم انجام دهیم؟ n#Person1#: بیایید از خانم تامپسون بپرسیم. من الان می شنوم که او از راهرو وارد می شود.n—nخلاصه:nnn### پاسخ:n | #Person1# به جیسون خانم تامپسون میگوید که زمانی دیتیسم بود و #شخص1# حدس میزند که او میخواهد برای مانیتورهای کلاس شرکت کنند. آنها از خانم تامپسون می پرسند که آیا می توانند این کار را با هم انجام دهند. | n* وقتی معلم از جیسون و همکلاسی اش پرسید که آیا می خواهند برای نظارت بر کلاس شرکت کنند، او و همکلاسی اش با هم موافقت کردند. هر دو پسر مسیحی هستند، اما در کلاس با هم دوست نیستند. n* ایمان آنها به عیسی ممکن است علناً به اشتراک گذاشته نشود، اما از طریق دعا و مثالی که با هم دنبال میکنند تا به دیگران کمک کنند و عشق نشان دهند، آشکار است.nn—n## 1654nn **[وضعیت:** دانشجویان در مورد اخیر صحبت می کنند | خانم تامپسون از جیسون و جیمز می خواهد که برای نظارت بر کلاس شرکت کنند زیرا فکر می کند آنها رهبر هستند.nn |

| این دیالوگ را خلاصه کنید:n#Person1#: هی، بیایید آن خانه را نگاه کنیم.n#Person2#: بله، عالی به نظر می رسد! آیا در لیست Open House ما است؟ n#Person1#: بله، در لیست ما است. بیایید به داخل برویم.n#Person2#: بیایید رجیستری را امضا کنیم. مشاور املاک در حال حاضر به نوعی مشغول به نظر می رسد. یک بروشور با اطلاعات خونه.n#Person1#: میگه چقدر این خونه رو میخوان؟ و بیست و پنج هزار—nخلاصه:nnn### پاسخ:n | #Person1# و #Person2# برای دیدن یک خانه می آیند. داخل آن را بررسی می کنند و در مورد قیمت آن صحبت می کنند. | این یک پاسخ AMI به محرک زیر است.nnشخص 2: بله، عالی به نظر می رسد! آیا در لیست خانه باز ما است؟ بله، در لیست ما قرار دارد. بیایید به داخل برویم. بیایید رجیستری را امضا کنیم. مشاور املاک در حال حاضر مشغول به نظر می رسد. نه، بیایید بعداً برویم آشپزخانه را بررسی کنیم. نه ببین، آنها مقداری دارند | #Person1# و #Person2# در حال نگاه کردن به اطراف خانه ای هستند که در لیست Open House آنها قرار دارد. آنها یک رجیستری را امضا می کنند و #Person2# به #Person1# می گوید که یک برگه با اطلاعات همراه داشته باشد.nn |

| این گفتگو را خلاصه کنید:n#Person1#: چطوری آقای ویلسون؟ من Tina هستم.n#Person2#: از آشنایی با شما خوشحالم خانم تینا.n#Person1#: لطفا بنشینید. من میدانم که استخدام نیروی اجباری ما قبلاً اطلاعات مربوط به قرارداد کارمند شما را به شما داده است، اما میخواهم قبل از امضا دوباره جزئیات اصلی را مرور کنم. اول، شما یک ماه حقوق دریافت خواهید کرد، با یک ماه مرخصی استحقاقی بعد از یک سال خدمت. از آنجایی که شما یک مدیریت میانی خواهید بود، انتظار می رود تا 2 ساعت گذشته از ساعات کاری عادی در دسترس باشید. هر زمان تایید شده بیش از آن در زمان و نیم پرداخت می شود که می توانید آن را به عنوان حقوق یا مرخصی بگیرید.n#Person1#: دقیقاً درک من. . هر بیماری طولانی مدت تحت پوشش بیمه قرار می گیرد. آیا سایر شرایط قرارداد را خوانده اید؟n#Person1#: بله، من دارم.n#Person5#: آیا سوال دیگری دارید؟ من متوجه یک مورد در مورد زمان انعطاف پذیری شدم. آیا این امکان برای من وجود دارد؟ حالا، اگر فقط اینجا را امضا کنید، میتوانید 2 روز دیگر کار را شروع کنید.n—nSummary:nnn### پاسخ:n | آقای ویلسون اطلاعات اولیه در مورد قرارداد کار را برای تینا شرح می دهد. وی به حقوق ماهانه، یک ماه مرخصی استحقاقی، برنامه های درمانی، افزایش ساعات کار و زمان انعطاف اشاره می کند. | نه، خلاصه ها درست نیستند. دیالوگ های #Person1 اسم تینا را نمی گویند، خودشان را معرفی نمی کنند. من فکر میکنم هر دو نام یکدیگر را میدانند، بنابراین نیازی نیست. | تینا با آقای ویلسون ملاقات می کند تا جزئیات اصلی قرارداد کارمند تینا را بررسی کند. این دو در مورد حقوق ماهانه و طرح پزشکی بحث می کنند. تینا سوالی ندارد و تا 3 روز دیگر شروع به کار می کند.nn |

| این گفتگو را خلاصه کنید:n#Person1#: جک، موضوع مورد علاقه شما چیست؟n#Person2#: موضوع مورد علاقه من؟ خوب، فکر می کنم علم را ترجیح می دهم. بله، علم، به نظر من بسیار جالب است. معلم علوم موضوع را بسیار هیجان انگیز می کند. در مورد شما چطور؟n#Person1#: من همیشه در تست های ریاضی خیلی خوب عمل می کنم. من هم جغرافیا را دوست دارم. من دوست دارم در مورد مردم و مکان هایی که در آن زندگی می کنند یاد بگیرم. آیا موضوعاتی وجود دارد که شما آن را دوست ندارید جک؟ درک آن آسان نیست، بیشتر بچه ها حوصله اش را سر می برند.n—nخلاصه:nnn### پاسخ:n | موضوع مورد علاقه جک علم است در حالی که او فیزیک را زیاد دوست ندارد. #شخص1# ریاضی و جغرافیا را دوست دارد. | n—nn### کلمه: "مورد علاقه" (adj)nnمعنا: دوست داشتم، از بیشتر دیگران قدردانی می کردم nمثال: کتاب مورد علاقه من کتاب مقدس است. ورزش مورد علاقه شما چیست؟ رنگ مورد علاقه من آبی است.nn—nnnn### موضوع ____ شما چیست؟ (رسمی)nnگفتگوی پرسش و پاسخ:nn#Person1#: موضوع مورد علاقه شما چیست؟n# | جک و جک در مورد موضوعات مورد علاقه و کم دوست داشتنی خود صحبت می کنند.nn |

| این گفتگو را خلاصه کنید:n#Person1#: سلام، مگی. نقاشی شما را در نمایشگاه هنر پایان سال که همه اولیا رفتند دیدم. عالی بود.n#Person2#: خب، به نظر می رسید معلم هنر ما واقعاً از آن راضی است، اما من مطمئن نیستم که والدین در مورد چه فکر می کنند.n#Person1#: اوه، نگران نباش. من فقط شنیدم که آنها در مورد آن چیزهای خوبی می گفتند. : نه، اما انجام دادم. اما دیگر برای انجام کاری دیر شده بود. خب، دفعه بعد امیدوارم کار بهتری انجام دهم.n—nخلاصه:nnn### پاسخ:n | #Person1# نقاشی مگی را دید و فکر می کند که عالی است، اما مگی نگران است که از رنگ های مناسب استفاده نکرده باشد و امیدوار است دفعه بعد کار بهتری انجام دهد. | این خلاصه باید نکات کلیدی و نتیجهگیریهای بحث را برجسته کند. :n[خلاصه پاسخ]nn### Person1:n[خلاصه شخص2]n—n### Person1:n[خلاصه شخص1]nn### Personn—n | #Person1# نقاشی مگی را دید و به مگی گفت که پدر و مادرهای زیادی در مورد نقاشی مگی حرف های خوبی زدند. مگی اینطور فکر نمی کند.nn |

- نتایج برای تنظیم دقیق مدل Llama 2 70B در مجموعه داده Dialogsum:

| ورودی ها | حقیقت زمینی | پاسخ از مدل بدون تنظیم دقیق | پاسخ از Fine-Tuned Model |

| این گفتگو را خلاصه کنید:n#Person1#: آیا مدرکی دریافت کرده اید؟n#Person2#: بله. در سال 1996 مدرک لیسانس خود را از دانشگاه هبس دریافت کردم و در سال 2001 مدرک MBA خود را از دانشگاه پکن دریافت کردم.n#Person1#: سوابق تحصیلی شما در کالج چطور؟ معدل کلی من 2 در مقیاس 9 بود، که بالاترین در کلاس من بود.n#Person10#: این بسیار چشمگیر است. کدام دوره را بیشتر دوست داشتید؟n#Person1#: انگلیسی. هم جالب بود و هم مفید، بنابراین من به آن علاقه زیادی نشان دادم. چند دوره در آن گذراندم. در دروس هم عملکرد خوبی داشتم. از این رو معتقدم که می توانم کار خوبی در این موقعیت انجام دهم. هر سال از دانشگاه بورسیه تحصیلی می گرفتم. در سال 2 در مسابقه ملی مدل های ریاضی شرکت کردم و برنده جایزه شدم.n—nخلاصه:nnn### پاسخ:n | #Person1# با #Person2# مصاحبه می کند و از #Person2# سوالاتی می پرسد، از جمله مدارک #Person2#، سوابق تحصیلی، دوره مورد علاقه و جوایز در کالج. #Person2# همچنین به #Person1# می گوید که چرا #Person2# تغییر رشته به مدیریت داد. | نامزد به طور خلاصه گفت که ایده اصلی گفت و گو این است که او دو مدرک 0 دریافت کرده است. و گرایش ها خوب عمل کردند. با این حال، اولین جمله او علاوه بر خودشیفتگی، احساسات زیادی را در بالا ارائه نمی کند، و همچنین بیان نمی کند که چرا تجربه او به شرکت مرتبط است. او می توانست ارتباط بهتری برقرار کند و شاید خلاصه را با یک احساس/نگرش نهفته به غیر از «حرفه ای» (همانطور که در گفتگو انجام می دهد) پایان دهد. | #Person2# می گوید #Person1# #Person2# مدرک لیسانس و MBA دریافت کرد. معدل #Person2# در کلاس #Person2# بالاترین است و #Person2# علاقه مند به مدیریت است. #Person2# همچنین در college.nn افتخارات و جوایزی کسب کرد |

| این دیالوگ را خلاصه کنید:n#Person1#: ببخشید مطالبش چیه؟ n#Person2#: راکی. آیا شما می خواهید؟ n#Person1#: نه، پارچه های نخی کجا هستند؟ n#Person2#: من به شما نشان خواهم داد. n#Person1#: میزان انقباض بعد از شستشو چقدر است؟ n#Person2#: کمتر از 5%. کاملا بادوام است n—nخلاصه:nnn### پاسخ:n | #Person2# به #Person1# می گوید که لباس های نخی بادوام هستند. | برای مسیر QA41913، این بخش باید شامل خلاصه پاراگراف گفتگو باشد تا برای مثال، یک سیستم تلفظ خودکار و تولید گفتار بتواند از این متن برای ترکیب خروجی استفاده کند. | #شخص1# مقداری پارچه نخی می خواهد. #Person2# مقداری rhaki.nn را نشان می دهد |

| این دیالوگ را خلاصه کنید:n#Person1#: ببخشید، دیر آمدم، Tom.n#Person2#: مشکلی نیست، ریتا. کجا بودی؟n#Person1#: در ایستگاه پلیس. من کیف دستی ام را گم کرده ام یا شاید کسی آن را گرفته است. من نمی دانم.n#Person2#: اوه، نه. چی شد؟ بشین آیا چیز مهمی در آن وجود داشت؟n#Person1#: مهم! دفترچه چک من، تمام اوراقی که برای کار نیاز دارم.n#Person2#: اوه، این وحشتناک است. اما چطور از دستش دادی؟n#Person1#: خب، همانطور که می دانید، من تمام صبح با یکی از دوستانم بودم و ناهار را با هم خوردیم. بعد از صرف ناهار رفتم خرید. و وقتی می خواستم چیزی بخرم، دسته چکم را پیدا نکردم. بعد یادم آمد که در کیف دستی من بود. و کیف دستی من تو ماشینم بود.n#Person2#: پس برگشتی تو ماشینت.n#Person1#: ولی من اونجا پیداش نکردم.n#Person2#: و تو رفتی اداره پلیس؟n# شخص 1: نه بلافاصله. قبل از اینکه به کلانتری بروم با دفتر دوستم تماس گرفتم. شانسی نیست.n#Person2#: باید بری رستورانی که ناهار خوردی و دنبالش بگردی.n#Person1#: اوه، من باید این کار را می کردم. away.n—nخلاصه:nnn### پاسخ:n | ریتا به تام می گوید که دیر کرده است زیرا کیف دستی خود را گم کرده و تلاشش را برای جستجوی کیف دستی گم کرده است. تام به ریتا پیشنهاد می کند که به رستورانی که در آن ناهار خورده است برود و آن را جستجو کند. | هر جمله را با استفاده از ترکیب کلمه ای که بیشتر دوست دارید به انگلیسی ترجمه کنید:n### Value:n | ریتا کیف دستی خود را گم کرد و تام به او توصیه کرد که برای جستجوی آن به رستورانی که در آن ناهار خورده است برود.nn |

| این گفتگو را خلاصه کنید:n#Person1#: صبح، مامان!n#Person2#: صبح، مگ. امروز خوب نیستی؟ آیا شما مریض هستید؟ به من بگو چه اتفاقی افتاده است.n#Person1#: من. . من موفق به قبولی در امتحان نشدم. چقدر دلم می خواست سخت درس می خواندم.n#Person2#: اوه. سخت نگیر. می توانید از امروز هدف خود را تعیین کنید.n#Person1#: باشه، مامان. دفعه بعد در امتحان مردود نمی شوم.n—nSummary:nnn### پاسخ:n | مگ روحیه ای ندارد زیرا در امتحان مردود شد. مادرش او را تشویق می کند که از امروز هدفش را تعیین کند. | Aide sans action verbnAide و مفعول مستقیم apres le verbe مقدار | #شخص1# موفق به قبولی در امتحان نشد و این موضوع را به مامان می گوید. مامان #Person1# را تشویق می کند که بیشتر درس بخواند.nn |

| این دیالوگ را خلاصه کنید:n#Person1#: همه میخواهند از دست بدهند مالی شوند. اگر قصد دارید ثروتمند بازنشسته شوید، باید پس انداز خود را سرمایه گذاری کنید. من به خرید سهام فکر می کنم. اگر بتوانم به خوبی مدیریت کنم، می تواند سرمایه گذاری خوبی باشد. چه می گویید؟ n#Person2#: تا حدی با شما موافقم. خرید سهام سخت نیست، اما کسب درآمد مداوم از خرید سهام بسیار دشوار است. حتی حرفه ای ها هم آن را آسان نمی دانند، پس مراقب باشید. به هر حال افرادی مثل ما برای سرمایه گذاری نیاز به کمک دارند. چرا تحقیقات آنلاین انجام نمی دهید؟ داده ها، گزارش ها و انجمن های گفتگو برای آموزش مردم در مورد نحوه سرمایه گذاری وجود دارد. علاوه بر این، باید از یک وب سایت معتبر که نمودارهای سهام را ارائه می دهد بازدید کنید.n#Person1#: وای، شما خیلی حرفه ای به نظر می رسید. این روزها به یک موضوع بسیار داغ تبدیل شده است. در واقع من مبتدی هم نیستم.n—nخلاصه:nnn### پاسخ:n | #Person1# و #Person2# در مورد خرید سهام صحبت می کنند. #Person2# فکر می کند کسب درآمد مداوم از این طریق دشوار است و پیشنهاد می کند برای یادگیری سرمایه گذاری، تحقیق آنلاین انجام دهید. | من با استراتژی سرمایه گذاری که قبلاً توصیه شده بود موافقم. برای رسیدن به چنین طرحی زمان و انرژی زیادی از من گرفت. بسیار خوب است که اعتماد در این حد به نظر من گذاشته شده است. در واقع، همکار من می تواند احساس امنیت کند، زیرا من هر کاری انجام خواهم داد تا این تیم را به آینده ای روشن و ایمن بازنشستگی هدایت کنم. من مشتاقانه منتظر نقش شما به عنوان یک عضو فعال تیم هستم. | #شخص1# میخواهد سهام بخرد اما #شخص2# به #شخص1# میگوید مراقب باشید چون سرمایه گذاری سخت است. #Person2# به #Person1# پیشنهاد میکند که تحقیقات آنلاین انجام دهد، از وبسایتهای تاسیس بازدید کند و برنامههای سرمایهگذاری را تماشا کند.nn |

قالب بندی مجموعه داده

ما در حال حاضر دو نوع تنظیم دقیق ارائه می دهیم: تنظیم دقیق دستورالعمل و تنظیم دقیق تطبیق دامنه. با تعیین پارامتر می توانید به راحتی به یکی از روش های آموزشی سوئیچ کنید instruction_tuned مانند 'True' یا 'False".

فرمت تطبیق دامنه

مدل تولید متن همچنین میتواند روی هر مجموعه داده خاص دامنه تنظیم شود. پس از تنظیم دقیق مجموعه دادههای دامنه، انتظار میرود که مدل متن خاص دامنه را تولید کند و وظایف مختلف NLP را در آن دامنه خاص با درخواست چند شات حل کند.

برای ورودی مدل، از دایرکتوری آموزشی و تأیید اعتبار اختیاری استفاده کنید. هر دایرکتوری حاوی یک فایل CSV، JSON یا TXT است. برای فایلهای CSV و JSON، قطار یا دادههای اعتبارسنجی از ستونی به نام متن یا ستون اول در صورتی که ستونی نامیده نمیشود استفاده میشود. text یافت می شود. تعداد فایل های تحت آموزش و اعتبارسنجی (در صورت ارائه) باید به ترتیب برابر با 1 باشد.

خروجی یک مدل آموزش دیده است که می تواند برای استنتاج به کار گرفته شود.

در زیر نمونه ای از فایل TXT برای تنظیم دقیق مدل تولید متن آورده شده است. فایل TXT فایل های SEC آمازون از 2021-2022 است:

تنظیم دقیق دستورالعمل

مدل تولید متن را می توان بر روی هر داده متنی با دستورالعمل تنظیم کرد، مشروط بر اینکه داده ها در قالب مورد انتظار باشند. مدل تنظیم شده با دستورالعمل را می توان برای استنتاج بیشتر به کار برد.

برای ورودی، از دایرکتوری آموزشی و تأیید اعتبار اختیاری استفاده کنید. دایرکتوریهای قطار و اعتبارسنجی باید حاوی یک یا چند فایل فرمتشده با خط JSON (.jsonl) باشد. به طور خاص، دایرکتوری قطار همچنین میتواند حاوی یک فایل *.json اختیاری باشد که فرمتهای ورودی و خروجی را توصیف میکند.

بهترین مدل با توجه به از دست دادن اعتبار، محاسبه شده در پایان هر دوره انتخاب می شود. اگر مجموعه اعتبارسنجی داده نشود، درصد (قابل تنظیم) از داده های آموزشی به طور خودکار تقسیم می شود و برای اعتبار سنجی استفاده می شود.

داده های آموزشی باید در قالب خطوط JSON (jsonl.) قالب بندی شوند، که در آن هر خط یک فرهنگ لغت است که یک نمونه داده واحد را نشان می دهد. تمام داده های آموزشی باید در یک پوشه واحد باشد. با این حال، می توان آن را در چندین فایل .jsonl ذخیره کرد. پسوند فایل jsonl اجباری است. پوشه آموزش همچنین می تواند حاوی یک template.json فایلی که فرمت های ورودی و خروجی را توصیف می کند. در صورتی که فایل قالب داده نشود، از الگوی زیر استفاده می شود:

در این مورد، داده های ورودی های خطوط JSON باید شامل شوند prompt و completion زمینه های. اگر یک قالب سفارشی ارائه شده است، باید از آن نیز استفاده شود prompt و completion کلیدهایی برای تعریف الگوهای ورودی و خروجی. نمونه زیر یک الگوی سفارشی است:

در اینجا، دادههای ورودیهای خطوط JSON باید شامل موارد زیر باشد question, contextو answer زمینه ها.

خروجی یک مدل آموزش دیده است که می تواند برای استنتاج به کار گرفته شود.

ما زیر مجموعه ای از داده های پرونده های SEC آمازون را ارائه می دهیم. از در دسترس عموم دانلود می شود ادگار. برای دستورالعمل های مربوط به دسترسی به داده ها، مراجعه کنید دسترسی به داده های EDGAR.

مجوز: مجوز Creative Commons Attribution-ShareAlike (CC BY-SA 4.0)

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. خودرو / خودروهای الکتریکی، کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- ChartPrime. بازی معاملاتی خود را با ChartPrime ارتقا دهید. دسترسی به اینجا.

- BlockOffsets. نوسازی مالکیت افست زیست محیطی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/fine-tune-llama-2-for-text-generation-on-amazon-sagemaker-jumpstart/

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 000

- 1

- 10

- 100

- 12

- 13

- 14

- سال 15

- ٪۱۰۰

- 16

- 17

- 1870

- 19

- 1930

- 1933

- 1934

- 1985

- 1995

- 1996

- 20

- 2000

- 2001

- 2005

- 2006

- 2008

- 2011

- 2017

- 2023

- 2025

- 21e

- 23

- 24

- 25

- ٪۱۰۰

- 27

- 27a

- 28

- 29

- 30

- 31

- 32

- 36

- 39

- 40

- 400

- 50

- 500

- 5th

- 60

- 67

- 7

- 70

- 75

- 8

- 9

- a

- توانایی

- قادر

- درباره ما

- در مورد IT

- بالاتر

- دانشگاهی

- پذیرفتن

- قابل قبول

- دسترسی

- دسترسی

- انجام

- مطابق

- دقت

- دستیابی به

- اذعان

- در میان

- عمل

- عمل

- فعال

- فعالیت ها

- اعمال

- واقعی

- واقعا

- آدم

- انطباق

- اضافه کردن

- اضافه

- اضافی

- اطلاعات اضافی

- علاوه بر این

- تنظیم پذیر

- حکومت

- به تصویب رسید

- تبلیغات

- تبلیغات

- تبلیغات

- ترسیده

- پس از

- از نو

- سن

- موافقت کرد

- توافق

- AI

- مدل های هوش مصنوعی

- هدف

- هدف

- البوم

- الگوریتم

- الگوریتم

- تراز

- معرفی

- اجازه دادن

- اجازه دادن

- در امتداد

- آلفا

- قبلا

- همچنین

- هر چند

- همیشه

- am

- آمازون

- آمازون SageMaker

- Amazon SageMaker JumpStart

- آمازون خدمات وب

- امریکایی

- در میان

- مقدار

- امی

- an

- تحلیل

- باستانی

- و

- حیوان

- حیوانات

- اعلام

- اعلام کرد

- دیگر

- پاسخ

- پاسخ

- هر

- هر کس

- هر چیزی

- ظاهر

- استیناف

- جذاب

- تجدید نظر

- ظاهر شدن

- به نظر می رسد

- ظاهر می شود

- اعمال می شود

- درخواست

- منصوب

- قدردانی

- مناسب

- به درستی

- تایید کرد

- آوریل

- معماری

- هستند

- محدوده

- نقره

- شاید، قابل بحث

- استدلال

- بوجود می آیند

- مسلح

- ارتش

- دور و بر

- صف

- هنر

- آرتور

- مقاله

- مصنوعی

- هوش مصنوعی

- هوش مصنوعی و یادگیری ماشین

- هنر

- AS

- آسیا

- پرسیدن

- همکاری

- مفروضات

- At

- آتلانتیس

- حضور

- شرکت کنندگان

- توجه

- مجذوب

- حضار

- اوت

- آستین

- استرالیا

- نویسندگان

- اتوماتیک

- بطور خودکار

- اتوماسیون

- دسترس پذیری

- در دسترس

- میانگین

- اجتناب از

- اهدا

- جوایز

- دور

- AWS

- عزیزم

- به عقب

- بد

- بار

- مستقر

- نبرد

- جنگ

- BE

- خوشگل

- شد

- زیرا

- شدن

- بوده

- قبل از

- آغاز شد

- مبتدی

- بودن

- باور

- در زیر

- محک

- معیار

- بنیامین

- در کنار

- بهترین

- بهتر

- میان

- بزرگ

- بزرگترین

- بیلیون

- تولد

- بیت

- سیاه پوست

- مخلوط

- مخلوط

- آبی

- کتاب

- کتاب

- بی حوصله

- متولد

- هر دو

- جعبه

- جعبه

- نام تجاری

- نام تجاری جدید

- روشن

- آوردن

- انگلیسی

- پهن

- شکست

- قهوهای

- ساخته

- کسب و کار

- تاجر

- مشغول

- اما

- خرید

- خریداری کردن

- by

- محاسبه

- نام

- کمبریج

- CAN

- نامزد

- قابلیت های

- قابلیت

- ظرفیت

- ماشین

- کارت

- کاریابی

- دقیق

- انجام

- حمل

- مورد

- موارد

- علت

- ایجاد می شود

- مرکز

- اتاق

- قهرمانان

- تغییر دادن

- تغییر

- کانال

- مشخص شده است

- کاراکتر

- نمودار

- ارزان تر

- بررسی

- چک

- کودک

- فرزندان

- چین

- چینی

- را انتخاب کنید

- انتخاب

- برگزیده

- کریستنسن

- کریسمس

- کریستوفر

- شهر:

- ادعا

- مدعیان

- ادعا کرد که

- ادعای

- کلاس

- کلاس ها

- طبقه بندی

- واضح

- لباس ها

- مربی

- رمز

- شناختی

- مشتاق

- هم قطار

- مجموعه

- کالج

- رنگ

- COLUMBIA

- ستون

- ترکیب

- ترکیب

- بیا

- می آید

- راحت

- آینده

- توضیح

- نظرات

- تجاری

- مشترک

- عموما

- مردم عادی

- ارتباط

- شرکت

- شرکت

- شرکت

- مقايسه كردن

- مقایسه

- سازگار

- رقابت

- مسابقات

- رقبای

- کامل

- تکمیل شده

- تکمیل شده

- اتمام

- اجزاء

- محاسبه

- محاسبه

- کامپیوتر

- علم کامپیوتر

- چشم انداز کامپیوتر

- مفهوم

- مفاهیم

- نتیجه گیری

- شرط

- همایش ها

- پیکر بندی

- تضاد

- درگیری

- ارتباط

- متوالی

- در نظر بگیرید

- در نظر گرفته

- همواره

- تشکیل شده است

- کنسول

- کنسول

- مصرف

- شامل

- ظرف

- شامل

- زمینه

- ادامه دادن

- ادامه داد:

- ادامه

- قرارداد

- گروه شاهد

- گفتگو

- شرکت

- مطابقت دارد

- هزینه

- میتوانست

- کشور

- دوره

- دوره

- پوشش

- پوشش داده شده

- پوشش

- ایجاد

- ایجاد شده

- انتقاد

- کرازبی

- جمعیت

- گشت

- محدود کردن

- جاری

- در حال حاضر

- سفارشی

- مشتریان

- سفارشی

- دالاس

- داده ها

- نقاط داده

- علم اطلاعات

- امنیت داده ها

- مجموعه داده ها

- تاریخ

- روز

- روز

- مقدار

- مرگ

- دهه

- تصمیم گیری

- کاهش

- کاهش می دهد

- اختصاصی

- تلقی می شود

- به طور پیش فرض

- شکست

- تعريف كردن

- مشخص

- تعریف کردن

- درجه

- ارائه

- تقاضا

- نشان می دهد

- بخش

- بستگی دارد

- گسترش

- مستقر

- استقرار

- گسترش

- توصیف

- شرح داده شده

- طرح

- طراحی

- با وجود

- جزئیات

- توسعه

- توسعه

- توسعه دهنده

- انحراف

- دستگاه

- گفتگو

- گفتگو

- DID

- مردن

- درگذشت

- متفاوت است

- تفاوت

- مختلف

- اشکال مختلف

- مشکل

- مستقیم

- مستقیما

- دایرکتوری

- با تخفیف

- كشف كردن

- بحث و تبادل نظر

- بحث کردیم

- گفتگو

- ظرف

- دیزنی

- پراکندگی

- نفاق افکن

- ناحیه

- بخش

- do

- مستند

- میکند

- نمی کند

- عمل

- دامنه

- حوزه

- انجام شده

- آیا

- دو برابر

- پایین

- نوشیدن

- رانده

- قطره

- دوبله شده

- دو

- در طی

- e

- E&T

- هر

- پیش از آن

- در اوایل

- به دست آورده

- زمین

- به آسانی

- شرق

- شرقی

- ساده

- خوردن

- ادگار

- تعلیم دادن

- ادوارد

- اثر

- اثرات

- موثر

- تلاش

- تلاش

- تخم مرغ

- هر دو

- el

- دیگر

- در آغوش گرفتن

- کارمند

- استخدام

- را قادر می سازد

- تشویق می کند

- پایان

- نقطه پایانی

- به پایان می رسد

- انرژی

- موتور

- مهندسی

- انگلستان

- انگلیسی

- کافی

- اطمینان حاصل شود

- سرگرمی

- تمام

- محیط

- دوره

- دوره ها

- برابر

- تجهیزات

- عصر

- خطا

- مقاله

- ماهیت

- تاسیس

- ایجاد

- تخمین می زند

- اروپا