آمپر یک برنامه رادیویی زنده جدید از آمازون است. با Amp، میتوانید برنامه رادیویی خود را میزبانی کنید و آهنگهایی را از کاتالوگ آمازون موزیک پخش کنید، یا برنامههایی را که سایر کاربران Amp میزبانی میکنند تنظیم کرده و گوش دهید. در محیطی که محتوا فراوان و متنوع است، بسیار مهم است که تجربه کاربری را مطابق با سلیقه هر کاربر تنظیم کنید، بنابراین آنها می توانند به راحتی نمایش هایی را که دوست دارند پیدا کنند و محتوای جدیدی را کشف کنند که از آن لذت می برند.

Amp از یادگیری ماشین (ML) برای ارائه توصیههای شخصی برای نمایشهای زنده و آتی Amp در صفحه اصلی برنامه استفاده میکند. توصیهها با استفاده از یک مدل جنگل تصادفی با استفاده از ویژگیهایی که نشاندهنده محبوبیت یک نمایش (مانند تعداد شنیدن و لایک)، محبوبیت یک سازنده (مانند تعداد کل دفعاتی که نمایشهای اخیر پخش شدهاند) و وابستگیهای شخصی یک کاربر محاسبه میشوند. به موضوع و سازنده نمایش وابستگی ها یا به طور ضمنی از داده های رفتاری کاربر یا به طور صریح از موضوعات مورد علاقه (مانند موسیقی پاپ، بیسبال، یا سیاست) همانطور که در نمایه های کاربر آنها ارائه شده است، محاسبه می شود.

این قسمت 2 از مجموعه استفاده از تجزیه و تحلیل داده و ML برای Amp و ایجاد یک پلت فرم لیست توصیه نمایش شخصی است. این پلتفرم از زمان راهاندازی خود در ماه مه ۲۰۲۲، ردیابی معیارهای تعامل مشتری (پسندیدن یک نمایش، دنبال کردن یک سازنده، فعال کردن اعلانهای نمایش آینده) را ۳ درصد افزایش داده است.

به مراجعه قسمت 1 برای یادگیری نحوه جمع آوری و پردازش داده های رفتاری با استفاده از داده ها و سیستم های تحلیلی.

بررسی اجمالی راه حل

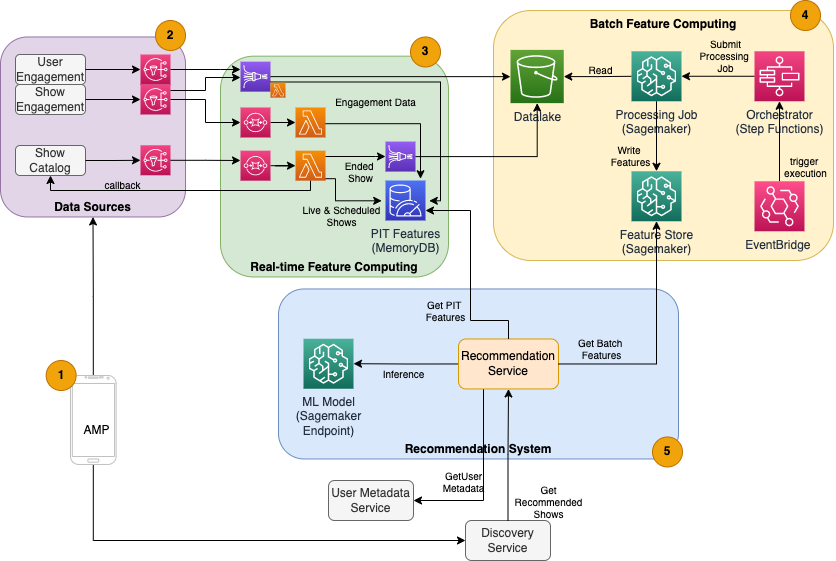

توصیهکننده نمایش مبتنی بر ML برای Amp دارای پنج جزء اصلی است که در نمودار معماری زیر نشان داده شده است:

- اپلیکیشن موبایل آمپر

- سرویسهای بکاند که دادههای رفتاری را جمعآوری میکنند، مانند لایکها و دنبالکردنها، و همچنین اطلاعات مربوط به نمایش را پخش میکنند، مانند بهروزرسانیهای وضعیت هنگام پخش برنامهها.

- دریافت بیدرنگ دادههای رفتاری و نمایشی، و محاسبات و ذخیرهسازی ویژگیهای بلادرنگ (آنلاین).

- محاسبات و ذخیره سازی ویژگی دسته ای (آفلاین).

- یک سیستم توصیهکننده که درخواستهای دریافتی از پشتیبان برنامه را برای دریافت لیست نمایشها مدیریت میکند. این شامل استنتاج بلادرنگ برای رتبهبندی نمایشها بر اساس ویژگیهای شخصی و غیرشخصی میشود.

این پست بر روی قسمت های 3، 4 و 5 تمرکز دارد تا جزئیات زیر را شرح دهد:

نمودار زیر معماری سطح بالا و اجزای آن را نشان می دهد.

در بخشهای بعدی، جزئیات بیشتری در مورد محاسبات ویژگی بلادرنگ، محاسبه ویژگی دستهای، استنتاج بلادرنگ، سلامت عملیاتی و نتایجی که مشاهده کردیم، ارائه میکنیم.

محاسبات ویژگی بلادرنگ

برخی از ویژگیها، مانند تعداد لایکها و شنیدنها برای یک برنامه، باید به طور مداوم پخش شوند و همانطور که هستند استفاده شوند، در حالی که برخی دیگر، مانند تعداد جلسات گوش دادن بیش از 5 دقیقه، باید در زمان واقعی به عنوان داده خام تبدیل شوند. برای جلسات پخش می شود. این نوع ویژگیها که در آن مقادیر باید در زمان استنتاج محاسبه شوند، نامیده میشوند نقطه در زمان ویژگی های (PIT) دادههای ویژگیهای PIT باید به سرعت بهروزرسانی شوند و آخرین نسخه باید با تأخیر کم نوشته و خوانده شود (زیر ۲۰ میلیثانیه برای هر کاربر برای ۱۰۰۰ نمایش). دادهها همچنین باید در یک ذخیرهسازی بادوام باشند، زیرا دادههای ناقص یا ناقص ممکن است باعث بدتر شدن توصیهها و تجربه ضعیف مشتری شود. علاوه بر تأخیر خواندن/نوشتن، ویژگیهای PIT به زمان بازتاب کم نیز نیاز دارند. زمان بازتاب زمانی است که طول می کشد تا یک ویژگی پس از انتشار رویدادهای کمک کننده برای خواندن در دسترس باشد، به عنوان مثال، زمان بین علاقه شنونده به نمایش و به روز رسانی ویژگی PIT LikeCount.

منابع دادهها خدمات پشتیبان هستند که مستقیماً به برنامه خدمات میدهند. برخی از داده ها به معیارهایی تبدیل می شوند که سپس از طریق آن پخش می شوند سرویس اطلاع رسانی ساده آمازون (Amazon SNS) به شنوندگان پایین دستی مانند خط لوله تبدیل ویژگی ML. یک پایگاه داده در حافظه مانند MemoryDB یک سرویس ایده آل برای ذخیره سازی بادوام و عملکرد فوق العاده سریع در حجم های بالا است. جزء محاسباتی که ویژگی ها را در MemoryDB تبدیل و می نویسد Lambda است. ترافیک برنامه بسته به زمان و روز از الگوهای روزانه و هفتگی اوج و نزول پیروی می کند. لامبدا امکان مقیاسبندی خودکار به حجم رویدادهای ورودی را فراهم میکند. ماهیت مستقل هر تبدیل متریک مجزا نیز باعث میشود لامبدا، که به تنهایی یک سرویس بدون حالت است، برای این مشکل مناسب باشد. قرار دادن سرویس صف ساده آمازون (Amazon SQS) بین Amazon SNS و Lambda نه تنها از از دست رفتن پیام جلوگیری می کند، بلکه به عنوان یک بافر برای انفجارهای غیرمنتظره ترافیکی عمل می کند که محدودیت های همزمانی لامبدا از پیش تنظیم شده ممکن است برای ارائه کافی نباشد.

محاسبات ویژگی دسته ای

ویژگیهایی که از دادههای رفتاری تاریخی برای نشان دادن ذائقه در حال تکامل کاربر استفاده میکنند، برای محاسبه پیچیدهتر هستند و نمیتوانند در زمان واقعی محاسبه شوند. این ویژگیها توسط یک فرآیند دستهای محاسبه میشوند که هر چند وقت یکبار، برای مثال یک بار در روز اجرا میشود. دادهها برای ویژگیهای دستهای باید از پرسوجو سریع برای فیلتر کردن و تجمیع دادهها پشتیبانی کنند و ممکن است دورههای زمانی طولانی را در بر گیرند، بنابراین حجم بیشتری خواهند داشت. از آنجا که ویژگی های دسته ای نیز بازیابی و به عنوان ورودی برای استنتاج بلادرنگ ارسال می شوند، همچنان باید با تأخیر کم خوانده شوند.

جمعآوری دادههای خام برای محاسبات ویژگی دستهای نیاز به زمان بازتاب زیر دقیقهای را ندارد که ویژگیهای PIT دارند، که باعث میشود رویدادها را طولانیتر بافر کرد و معیارها را به صورت دستهای تغییر داد. این راه حل از Kinesis Data Firehose، یک سرویس مدیریت شده برای ورود سریع داده های جریان به چندین مقصد، از جمله سرویس ذخیره سازی ساده آمازون (Amazon S3) برای معیارهای پایدار در دریاچه داده S3 که در محاسبات آفلاین استفاده می شود. Kinesis Data Firehose یک بافر رویداد و ادغام Lambda را برای جمعآوری، تبدیل دستهای و تداوم این معیارها در Amazon S3 فراهم میکند تا بعداً توسط محاسبات ویژگی دستهای مورد استفاده قرار گیرد. محاسبات ویژگی دستهای مانند ویژگیهای PIT نیازمندیهای خواندن/نوشتن با تأخیر کم را ندارند، که این امر آمازون S3 را به انتخاب بهتری تبدیل میکند زیرا فضای ذخیرهسازی کمهزینه و بادوام را برای ذخیرهسازی این حجم زیادی از معیارهای تجاری فراهم میکند.

مدل اولیه ML ما از 21 ویژگی دسته ای استفاده می کند که روزانه با استفاده از داده های گرفته شده در 2 ماه گذشته محاسبه می شود. این داده ها شامل تاریخچه پخش و تعامل برنامه برای هر کاربر است و با تعداد کاربران و دفعات استفاده از برنامه افزایش می یابد. مهندسی ویژگی در این مقیاس به یک فرآیند خودکار برای جمعآوری دادههای ورودی مورد نیاز، پردازش موازی و صدور نتیجه به ذخیرهسازی مداوم نیاز دارد. زیرساخت پردازش فقط برای مدت زمان محاسبات مورد نیاز است. پردازش SageMaker تصاویر Docker از پیش ساخته شده را ارائه می دهد که شامل Apache Spark و سایر وابستگی های مورد نیاز برای اجرای کارهای پردازش داده های توزیع شده در مقیاس بزرگ است. زیرساخت های اساسی برای یک کار پردازش به طور کامل توسط SageMaker مدیریت می شود. منابع خوشه ای برای مدت زمان کار شما تهیه می شوند و پس از اتمام کار پاکسازی می شوند.

هر مرحله در فرآیند دستهای - جمعآوری دادهها، مهندسی ویژگیها، تداوم ویژگیها - بخشی از یک جریان کاری است که به مدیریت خطا، تلاش مجدد و انتقال وضعیت در بین آنها نیاز دارد. با توابع مرحله AWS، می توانید یک ماشین حالت ایجاد کنید و گردش کار خود را به چند مرحله پیش پردازش و پس پردازش و همچنین مرحله ای برای تداوم ویژگی ها در فروشگاه ویژگی SageMaker یا سایر داده ها در Amazon S3 تقسیم کنید. یک ماشین حالت در توابع مرحله می تواند از طریق راه اندازی شود پل رویداد آمازون برای خودکار کردن محاسبات دسته ای برای اجرا در یک برنامه زمان بندی مشخص، مانند یک بار در روز در ساعت 10:00 UTC.

پس از محاسبه ویژگی ها، آنها باید نسخه بندی و ذخیره شوند تا در طول استنتاج و همچنین آموزش مجدد مدل خوانده شوند. به جای ایجاد سرویس ذخیره سازی و مدیریت ویژگی های خود، می توانید از فروشگاه ویژگی SageMaker استفاده کنید. Feature Store یک مخزن کاملاً مدیریت شده و هدفمند برای ذخیره، اشتراکگذاری و مدیریت ویژگیهای مدلهای ML است. تاریخچه ویژگیهای ML را در فروشگاه آفلاین (Amazon S3) ذخیره میکند و همچنین APIهایی را برای یک فروشگاه آنلاین فراهم میکند تا امکان خواندن با تأخیر پایین بیشتر ویژگیهای اخیر را فراهم کند. فروشگاه آفلاین میتواند دادههای تاریخی را برای آموزش و آزمایش بیشتر مدل ارائه کند، و فروشگاه آنلاین میتواند توسط APIهای رو به رو مشتری شما برای دریافت ویژگیها برای استنتاج در زمان واقعی فراخوانی شود. همانطور که ما خدمات خود را برای ارائه محتوای شخصیشدهتر تکامل میدهیم، پیشبینی میکنیم که مدلهای ML اضافی را آموزش دهیم و با کمک فروشگاه ویژگی، ویژگیهای جستجو، کشف و استفاده مجدد را در میان این مدلها آموزش دهیم.

استنتاج بلادرنگ

استنتاج بلادرنگ معمولاً مستلزم میزبانی مدلهای ML در پشت نقاط پایانی است. شما می توانید این کار را با استفاده از وب سرورها یا کانتینرها انجام دهید، اما این کار به تلاش و زیرساخت مهندسی ML برای مدیریت و نگهداری نیاز دارد. SageMaker استقرار مدل های ML را در نقاط پایانی بلادرنگ آسان می کند. SageMaker به شما امکان آموزش و آپلود مدل های ML و میزبانی آنها را با ایجاد و پیکربندی نقاط پایانی SageMaker می دهد. استنتاج بلادرنگ الزامات زمان تأخیر پایین برای رتبهبندی نمایشها را هنگام مرور آنها در صفحه اصلی Amp برآورده میکند.

علاوه بر میزبانی مدیریت شده، SageMaker مقیاس بندی نقطه پایانی مدیریت شده را ارائه می دهد. استنباط SageMaker به شما امکان میدهد یک خطمشی مقیاسبندی خودکار با تعداد نمونههای حداقل و حداکثر و استفاده از هدف برای شروع مقیاسگذاری تعریف کنید. به این ترتیب، شما به راحتی می توانید با تغییر تقاضا، مقیاس را به داخل یا خارج کنید.

سلامت عملیات

تعداد رویدادهایی که این سیستم برای محاسبه ویژگی های بلادرنگ انجام می دهد، مطابق با الگوی طبیعی استفاده از برنامه (ترافیک بیشتر یا کمتر بر اساس زمان روز یا روز هفته) تغییر می کند. به طور مشابه، تعداد درخواست هایی که برای مقیاس های استنتاج بلادرنگ با تعداد کاربران همزمان برنامه دریافت می کند. این خدمات همچنین به دلیل تبلیغات خود در رسانههای اجتماعی توسط سازندگان محبوب، اوجهای غیرمنتظرهای در ترافیک دریافت میکنند. اگرچه مهم است که اطمینان حاصل شود که سیستم میتواند برای سرویسدهی موفقیتآمیز و مقرون به صرفه به ترافیک ورودی بالا و پایین شود، اما نظارت بر معیارهای عملیاتی و هشدار برای هرگونه مشکل عملیاتی غیرمنتظره برای جلوگیری از از دست رفتن دادهها و خدمات به مشتریان نیز مهم است. نظارت بر سلامت این خدمات با استفاده آسان است CloudWatch آمازون. معیارهای حیاتی سلامت خدمات مانند خطاها و تأخیر عملیات و همچنین معیارهای استفاده مانند حافظه، دیسک و استفاده از CPU خارج از جعبه با استفاده از CloudWatch در دسترس هستند. تیم توسعه ما از داشبوردهای معیارها و نظارت خودکار استفاده میکند تا اطمینان حاصل شود که میتوانیم با در دسترس بودن بالا (99.8٪) و تأخیر کم (کمتر از 200 میلیثانیه برای دریافت نمایشهای توصیهشده برای هر کاربر) به مشتریان خود خدمات ارائه دهیم.

اندازه گیری نتیجه

قبل از توصیهکننده نمایش مبتنی بر ML که در این پست توضیح داده شد، یک الگوریتم اکتشافی سادهتر که Amp را بر اساس موضوعات شخصی مورد علاقه کاربر که در نمایهاش گزارش میشود، نشان میدهد. ما یک تست A/B راهاندازی کردیم تا تأثیر تغییر به توصیهکنندههای مبتنی بر ML با دادههای کاربر از تعاملات قبلی برنامهشان را اندازهگیری کنیم. ما بهبودهایی در معیارهایی مانند مدت زمان گوش دادن و تعداد اقدامات تعامل (پسندیدن یک نمایش، دنبال کردن سازنده نمایش، روشن کردن اعلانها) را به عنوان شاخصهای موفقیت شناسایی کردیم. آزمایش A/B با دریافت 50 درصد از کاربران توصیههای نمایشی که از طریق توصیهگر مبتنی بر ML برای آنها رتبهبندی شده است، 3 درصد افزایش در معیارهای تعامل مشتری و 0.5 درصد بهبود در مدت زمان پخش را نشان داده است.

نتیجه

با خدمات هدفمند، تیم Amp توانست API توصیه شخصی نمایشی را همانطور که در این پست توضیح داده شده است را در کمتر از 3 ماه برای تولید عرضه کند. این سیستم همچنین برای بارهای غیرقابل پیش بینی ایجاد شده توسط میزبان های معروف نمایش یا کمپین های بازاریابی که می تواند هجوم کاربران را ایجاد کند، به خوبی مقیاس می شود. این راه حل از خدمات مدیریت شده برای پردازش، آموزش و میزبانی استفاده می کند که به کاهش زمان صرف شده برای نگهداری روزانه سیستم کمک می کند. ما همچنین قادر به نظارت بر همه این خدمات مدیریت شده از طریق CloudWatch برای اطمینان از سلامت مداوم سیستم های در حال تولید هستیم.

آزمایش A/B اولین نسخه توصیهکننده مبتنی بر ML Amp در برابر رویکرد مبتنی بر قانون (که فقط براساس موضوعات مورد علاقه مشتری نشان میدهد) نشان داده است که توصیهکننده مبتنی بر ML مشتریان را در معرض محتوای با کیفیت بالاتر از موضوعات متنوعتر قرار میدهد. ، که منجر به افزایش تعداد فالو و اعلان های فعال می شود. تیم Amp به طور مداوم در حال کار برای بهبود مدل ها برای ارائه توصیه های بسیار مرتبط است.

برای کسب اطلاعات بیشتر در مورد فروشگاه ویژه، مراجعه کنید فروشگاه ویژگی آمازون SageMaker و سایر موارد استفاده مشتری را در وبلاگ یادگیری ماشین AWS.

درباره نویسندگان

لاله گوپتا یک معمار راه حل در خدمات وب آمازون است. او با آمازون برای طراحی، ساخت و استقرار راه حل های فناوری در AWS کار می کند. او به مشتریان در اتخاذ بهترین شیوه ها در هنگام استقرار راه حل در AWS کمک می کند و از علاقه مندان به Analytics و ML است. او در اوقات فراغت خود از شنا، پیاده روی و بازی های رومیزی لذت می برد.

لاله گوپتا یک معمار راه حل در خدمات وب آمازون است. او با آمازون برای طراحی، ساخت و استقرار راه حل های فناوری در AWS کار می کند. او به مشتریان در اتخاذ بهترین شیوه ها در هنگام استقرار راه حل در AWS کمک می کند و از علاقه مندان به Analytics و ML است. او در اوقات فراغت خود از شنا، پیاده روی و بازی های رومیزی لذت می برد.

دیوید کو یک معمار راه حل در خدمات وب آمازون است. او با مشتریان AWS برای طراحی، ساخت و استقرار راه حل های فناوری در AWS کار می کند. او با مشتریان رسانه و سرگرمی کار می کند و به فناوری های یادگیری ماشین علاقه مند است. در اوقات فراغت خود به این فکر می کند که با اوقات فراغت خود چه کار کند.

دیوید کو یک معمار راه حل در خدمات وب آمازون است. او با مشتریان AWS برای طراحی، ساخت و استقرار راه حل های فناوری در AWS کار می کند. او با مشتریان رسانه و سرگرمی کار می کند و به فناوری های یادگیری ماشین علاقه مند است. در اوقات فراغت خود به این فکر می کند که با اوقات فراغت خود چه کار کند.

مانولیا مک کورمیک یک مهندس توسعه نرم افزار Sr برای Amp در آمازون است. او سیستمهای توزیعشده را با استفاده از AWS طراحی و میسازد تا به برنامههای رو به رو مشتری خدمت کند. او از خواندن و پختن دستور العمل های جدید در اوقات فراغت خود لذت می برد.

مانولیا مک کورمیک یک مهندس توسعه نرم افزار Sr برای Amp در آمازون است. او سیستمهای توزیعشده را با استفاده از AWS طراحی و میسازد تا به برنامههای رو به رو مشتری خدمت کند. او از خواندن و پختن دستور العمل های جدید در اوقات فراغت خود لذت می برد.

جف کریستوفرسن یک مهندس داده Sr. برای Amp در آمازون است. او برای طراحی، ساخت و استقرار راهحلهای Big Data در AWS کار میکند که بینشهای عملی را ایجاد میکند. او به تیمهای داخلی در اتخاذ راهحلهای مقیاسپذیر و خودکار کمک میکند و از علاقهمندان به تجزیه و تحلیل و دادههای بزرگ است. در اوقات فراغت خود، زمانی که او سوار یک جفت اسکی نیست، می توانید او را روی دوچرخه کوهستان خود پیدا کنید.

جف کریستوفرسن یک مهندس داده Sr. برای Amp در آمازون است. او برای طراحی، ساخت و استقرار راهحلهای Big Data در AWS کار میکند که بینشهای عملی را ایجاد میکند. او به تیمهای داخلی در اتخاذ راهحلهای مقیاسپذیر و خودکار کمک میکند و از علاقهمندان به تجزیه و تحلیل و دادههای بزرگ است. در اوقات فراغت خود، زمانی که او سوار یک جفت اسکی نیست، می توانید او را روی دوچرخه کوهستان خود پیدا کنید.

- AI

- آی هنر

- مولد هنر ai

- ربات ai

- آمازون SageMaker

- هوش مصنوعی

- گواهی هوش مصنوعی

- هوش مصنوعی در بانکداری

- ربات هوش مصنوعی

- ربات های هوش مصنوعی

- نرم افزار هوش مصنوعی

- آموزش ماشین AWS

- بلاکچین

- کنفرانس بلاک چین ai

- coingenius

- هوش مصنوعی محاوره ای

- کنفرانس کریپتو ai

- راه حل های مشتری

- دل-ه

- یادگیری عمیق

- گوگل ai

- فراگیری ماشین

- افلاطون

- افلاطون آی

- هوش داده افلاطون

- بازی افلاطون

- PlatoData

- بازی پلاتو

- مقیاس Ai

- نحو

- زفیرنت