در دنیایی که به طور فزاینده ای داده محور است، شرکت ها باید بر جمع آوری اطلاعات فیزیکی ارزشمند و تولید اطلاعاتی که به آن نیاز دارند، اما نمی توانند به راحتی آن ها را جمع آوری کنند، تمرکز کنند. دسترسی به داده ها، مقررات و انطباق، منبع فزاینده ای از اصطکاک برای نوآوری در تجزیه و تحلیل و هوش مصنوعی (AI) است.

برای بخش های بسیار تنظیم شده مانند خدمات مالی، مراقبت های بهداشتی، علوم زیستی، خودروسازی، رباتیک، و تولید، مشکل حتی بیشتر است. این باعث ایجاد موانعی برای طراحی سیستم، به اشتراک گذاری داده (داخلی و خارجی)، کسب درآمد، تجزیه و تحلیل و یادگیری ماشین (ML) می شود.

داده های مصنوعی ابزاری است که به بسیاری از چالش های داده، به ویژه هوش مصنوعی و مسائل تجزیه و تحلیل مانند حفاظت از حریم خصوصی، انطباق با مقررات، دسترسی، کمبود داده، و تعصب می پردازد. این همچنین شامل به اشتراک گذاری داده ها و زمان رسیدن به داده ها (و بنابراین زمان ورود به بازار) می شود.

داده های مصنوعی به صورت الگوریتمی تولید می شوند. این ویژگی ها و الگوهای آماری را از داده های منبع منعکس می کند. اما نکته مهم این است که هیچ نقطه داده حساس، خصوصی یا شخصی ندارد.

شما از داده های مصنوعی سؤال می کنید و همان پاسخ هایی را می گیرید که از داده های واقعی می خواهید.

در ما پست قبلی, ما نشان دادیم که چگونه از شبکه های متخاصم مانند شبکه های متخاصم مولد (GANS) برای تولید مجموعه داده های جدولی برای تقویت آموزش مدل تقلب اعتباری استفاده کنیم.

برای اینکه ذینفعان کسب و کار داده های مصنوعی را برای پروژه های ML و تجزیه و تحلیل خود بکار گیرند، ضروری است که نه تنها اطمینان حاصل شود که داده های مصنوعی تولید شده با هدف و برنامه های مورد انتظار پایین دست مطابقت دارد، بلکه آنها نیز قادر به اندازه گیری و نشان دادن کیفیت هستند. داده های تولید شده

با افزایش تعهدات قانونی و اخلاقی در حفظ حریم خصوصی، یکی از نقاط قوت داده مصنوعی، توانایی حذف اطلاعات حساس و اصلی در حین ترکیب آن است. بنابراین، علاوه بر کیفیت، به معیارهایی برای ارزیابی خطر نشت اطلاعات خصوصی، در صورت وجود، و ارزیابی اینکه فرآیند تولید هیچ یک از دادههای اصلی را «به خاطر سپردن» یا کپی نمیکند، نیاز داریم.

برای دستیابی به همه اینها، میتوان کیفیت دادههای مصنوعی را به ابعاد ترسیم کرد که به کاربران، ذینفعان و ما برای درک بهتر دادههای تولید شده کمک میکند.

سه بعد ارزیابی کیفیت داده های مصنوعی

داده های مصنوعی تولید شده با سه بعد کلیدی اندازه گیری می شود:

- وفاداری

- سودمندی

- حریم خصوصی

اینها برخی از سوالات مربوط به هر داده مصنوعی تولید شده است که باید با گزارش کیفیت داده مصنوعی پاسخ داده شود:

- این داده های مصنوعی در مقایسه با مجموعه آموزشی اصلی چقدر شبیه است؟

- این داده مصنوعی چقدر برای برنامه های پایین دست ما مفید است؟

- آیا اطلاعاتی از داده های آموزشی اصلی به داده های مصنوعی درز کرده است؟

- آیا دادهای که در دنیای واقعی حساس تلقی میشود (از سایر مجموعههای دادهای که برای آموزش مدل استفاده نمیشود) به طور سهوی توسط مدل ما سنتز شده است؟

معیارهایی که هر یک از این ابعاد را برای کاربران نهایی ترجمه می کنند تا حدودی انعطاف پذیر هستند. از این گذشته، داده هایی که باید تولید شوند می توانند از نظر توزیع، اندازه و رفتار متفاوت باشند. همچنین باید درک و تفسیر آنها آسان باشد.

در نهایت، معیارها باید کاملاً مبتنی بر داده باشد و نیازی به دانش قبلی یا اطلاعات خاص دامنه نداشته باشد. با این حال، اگر کاربر بخواهد قوانین و محدودیتهای خاصی را اعمال کند که برای یک دامنه تجاری خاص اعمال میشود، باید بتواند آنها را در طول فرآیند سنتز تعریف کند تا مطمئن شود که وفاداری دامنه خاص رعایت شده است.

در بخش های بعدی به هر یک از این معیارها با جزئیات بیشتری نگاه می کنیم.

معیارهایی برای درک درستی

در هر پروژه علم داده، ما باید بفهمیم که آیا یک جامعه نمونه خاص با مشکلی که در حال حل آن هستیم مرتبط است یا خیر. به طور مشابه، برای فرآیند ارزیابی ارتباط داده های مصنوعی تولید شده، باید آن را از نظر ارزیابی کنیم. وفاداری نسبت به اصل

نمایش بصری این معیارها درک آنها را آسان تر می کند. میتوانیم نشان دهیم که آیا اصل و نسبت مقولهها رعایت میشود، همبستگی بین متغیرهای مختلف حفظ میشود و غیره.

تجسم داده ها نه تنها به ارزیابی کیفیت داده های مصنوعی کمک می کند، بلکه به عنوان یکی از مراحل اولیه در چرخه حیات علم داده برای درک بهتر داده ها جای می گیرد.

بیایید با جزئیات بیشتر به برخی از معیارهای وفاداری بپردازیم.

مقایسه های آماری اکتشافی

در مقایسههای آماری اکتشافی، ویژگیهای مجموعه دادههای اصلی و مصنوعی با استفاده از معیارهای آماری کلیدی، مانند میانگین، میانه، انحراف استاندارد، مقادیر متمایز، مقادیر گمشده، حداقل، حداکثر، محدوده چارک برای ویژگیهای پیوسته، و تعداد مورد بررسی قرار میگیرند. رکوردها در هر دسته، مقادیر از دست رفته در هر دسته، و بیشتر کاراکترهای موجود برای ویژگی های دسته بندی.

این مقایسه باید بین مجموعه داده های نگهدارنده اصلی و داده های مصنوعی انجام شود. این ارزیابی نشان می دهد که آیا مجموعه داده های مقایسه شده از نظر آماری مشابه هستند یا خیر. اگر آنها اینطور نباشند، ما درک خواهیم کرد که کدام ویژگی ها و معیارها متفاوت هستند. در صورت مشاهده تفاوت قابل توجه، باید آموزش مجدد و بازسازی داده های مصنوعی با پارامترهای مختلف را در نظر بگیرید.

این تست به عنوان یک غربالگری اولیه عمل می کند تا مطمئن شود که داده های مصنوعی وفاداری معقولی به مجموعه داده اصلی دارند و بنابراین می توانند آزمایش های دقیق تری را انجام دهند.

امتیاز تشابه هیستوگرام

امتیاز تشابه هیستوگرام، توزیع های حاشیه ای هر ویژگی از مجموعه داده های مصنوعی و اصلی را اندازه گیری می کند.

امتیاز شباهت بین صفر و یک محدود می شود، با امتیاز یک نشان می دهد که توزیع های داده مصنوعی کاملاً با توزیع های داده های اصلی همپوشانی دارند.

امتیاز نزدیک به یک به کاربران این اطمینان را می دهد که مجموعه داده های نگهدارنده و مجموعه داده مصنوعی از نظر آماری مشابه هستند.

امتیاز اطلاعات متقابل

امتیاز اطلاعات متقابل، وابستگی متقابل دو ویژگی، عددی یا مقوله ای را اندازه گیری می کند، که نشان می دهد با مشاهده ویژگی دیگر، چه مقدار اطلاعات را می توان از یک ویژگی به دست آورد.

اطلاعات متقابل می تواند روابط غیر خطی را اندازه گیری کند، و درک جامع تری از کیفیت داده های مصنوعی ارائه می دهد زیرا به ما امکان می دهد تا میزان حفظ روابط متغیر را درک کنیم.

نمره یک نشان می دهد که وابستگی متقابل بین ویژگی ها به طور کامل در داده های مصنوعی ثبت شده است.

امتیاز همبستگی

امتیاز همبستگی اندازه گیری می کند که چگونه همبستگی های موجود در مجموعه داده اصلی در داده های مصنوعی ثبت شده است.

همبستگی بین دو یا چند ستون برای برنامه های کاربردی ML بسیار مهم است، که به کشف روابط بین ویژگی ها و متغیر هدف کمک می کند و به ایجاد یک مدل آموزش دیده کمک می کند.

امتیاز همبستگی بین صفر و یک محدود میشود و امتیاز یک نشان میدهد که همبستگیها کاملاً مطابقت دارند.

برخلاف دادههای جدولی ساختیافته، که معمولاً در مسائل داده با آنها مواجه میشویم، برخی از انواع دادههای ساختیافته رفتار خاصی دارند که مشاهدات گذشته احتمال تأثیرگذاری بر مشاهدات زیر را دارند. اینها به عنوان داده های سری زمانی یا متوالی شناخته می شوند - به عنوان مثال، مجموعه داده با اندازه گیری ساعتی دمای اتاق.

این رفتار به این معنی است که نیاز به تعریف معیارهای خاصی وجود دارد که می تواند به طور خاص کیفیت این مجموعه داده های سری زمانی را اندازه گیری کند.

نمره خود همبستگی و خود همبستگی جزئی

اگرچه خودهمبستگی شبیه همبستگی است، رابطه یک سری زمانی را در مقدار فعلی آن همانطور که با مقادیر قبلی آن مرتبط است نشان می دهد. حذف اثرات تاخیرهای زمانی قبلی، همبستگی جزئی را به همراه دارد. بنابراین، امتیاز خودهمبستگی اندازهگیری میکند که دادههای مصنوعی تا چه حد خود همبستگیهای مهم یا همبستگیهای جزئی را از مجموعه داده اصلی دریافت کردهاند.

معیارهایی برای درک سودمندی

اکنون ممکن است از نظر آماری متوجه شده باشیم که داده های مصنوعی مشابه مجموعه داده اصلی است. علاوه بر این، ما همچنین باید ارزیابی کنیم که مجموعه داده سنتز شده در هنگام آموزش بر روی چندین الگوریتم ML در مسائل رایج علم داده چقدر خوب عمل می کند.

با استفاده از موارد زیر سودمندی معیارها، هدف ما ایجاد اعتماد به نفس است که میتوانیم در برنامههای پاییندستی در رابطه با نحوه عملکرد دادههای اصلی به عملکرد واقعی دست یابیم.

امتیاز پیش بینی

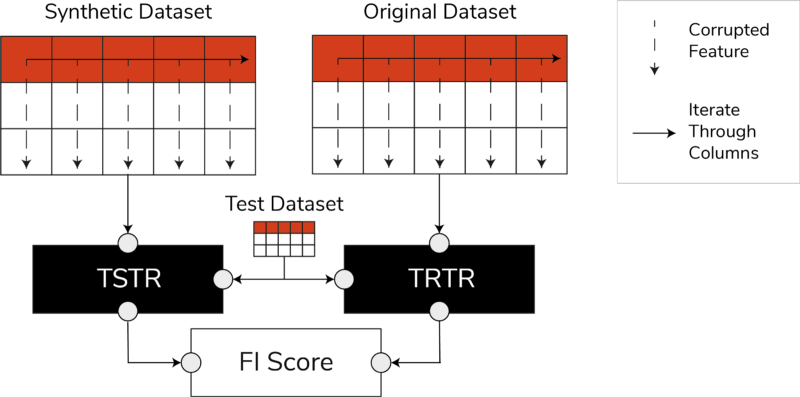

اندازه گیری عملکرد داده های مصنوعی در مقایسه با داده های واقعی اصلی می تواند از طریق مدل های ML انجام شود. امتیاز مدل پاییندستی، کیفیت دادههای مصنوعی را با مقایسه عملکرد مدلهای ML که در هر دو مجموعه داده مصنوعی و اصلی آموزش داده شدهاند و روی دادههای آزمایش پنهان از مجموعه داده اصلی تأیید شده است، ضبط میکند. این یک را فراهم می کند امتیاز تست واقعی قطار مصنوعی (TSTR). و یک آموزش واقعی تست واقعی (TRTR) به ترتیب نمره.

امتیازات TSTR، TRTR و امتیاز اهمیت ویژگی (تصویر توسط نویسنده)

این امتیاز طیف گستردهای از الگوریتمهای ML قابل اعتماد را برای وظایف رگرسیون یا طبقهبندی در بر میگیرد. استفاده از چندین طبقهبندی کننده و رگرسیون اطمینان حاصل میکند که امتیاز در اکثر الگوریتمها قابل تعمیمتر است، به طوری که دادههای مصنوعی ممکن است در آینده مفید تلقی شوند.

در پایان، اگر امتیاز TSTR و امتیاز TRTR قابل مقایسه باشند، این نشان میدهد که دادههای مصنوعی کیفیت مورد استفاده برای آموزش مدلهای موثر ML برای کاربردهای دنیای واقعی را دارند.

امتیاز اهمیت ویژگی

امتیاز اهمیت ویژگی (FI) که بسیار با امتیاز پیشبینی مرتبط است، آن را با افزودن قابلیت تفسیر به امتیازات TSTR و TRTR گسترش میدهد.

امتیاز F1 تغییرات و ثبات ترتیب اهمیت ویژگی را با امتیاز پیشبینی مقایسه میکند. مجموعهای از دادههای ترکیبی در صورتی از کاربرد بالایی در نظر گرفته میشود که دارای همان ترتیب اهمیت ویژگیها با دادههای واقعی اصلی باشد.

QScore

برای اطمینان از اینکه مدلی که بر روی دادههای تازه تولید شده ما آموزش داده شده است به همان سؤالات پاسخ میدهد که مدلی که با استفاده از دادههای اصلی آموزش داده شده است، از Qscore استفاده میکنیم. این عملکرد پایین دستی داده های مصنوعی را با اجرای بسیاری از پرس و جوهای تصادفی مبتنی بر تجمع بر روی مجموعه داده های مصنوعی و اصلی (و نگهدارنده) اندازه گیری می کند.

ایده در اینجا این است که هر دوی این پرس و جوها باید نتایج مشابهی را ارائه دهند.

یک QScore بالا اطمینان می دهد که برنامه های کاربردی پایین دستی که از عملیات پرس و جو و تجمیع استفاده می کنند می توانند تقریباً ارزشی برابر با مجموعه داده اصلی ارائه دهند.

معیارهایی برای درک حریم خصوصی

با خلوت مقرراتی که در حال حاضر وجود دارد، یک الزام اخلاقی و یک الزام قانونی برای اطمینان از محافظت از اطلاعات حساس است.

قبل از اینکه این دادههای مصنوعی آزادانه به اشتراک گذاشته شوند و برای برنامههای کاربردی پایین دستی مورد استفاده قرار گیرند، باید معیارهای حریم خصوصی را در نظر بگیریم که میتواند به ذینفعان کمک کند تا درک کنند که دادههای مصنوعی تولید شده در مقایسه با دادههای اصلی از نظر گستردگی اطلاعات لو رفته کجا قرار دارند. علاوه بر این، ما باید تصمیمات مهمی در مورد نحوه اشتراک گذاری و استفاده از داده های مصنوعی بگیریم.

امتیاز دقیق مسابقه

یک ارزیابی مستقیم و شهودی از حریم خصوصی، جستجوی کپیهایی از دادههای واقعی در میان رکوردهای مصنوعی است. امتیاز بازی دقیق تعداد رکوردهای واقعی را که می توان در میان مجموعه مصنوعی یافت می کند.

امتیاز باید صفر باشد و بیان می کند که هیچ اطلاعات واقعی همانطور که در داده های مصنوعی وجود ندارد. این معیار قبل از ارزیابی معیارهای حریم خصوصی بیشتر به عنوان یک مکانیسم غربالگری عمل می کند.

امتیاز حریم خصوصی همسایه ها

علاوه بر این، امتیاز حریم خصوصی همسایگان نسبت رکوردهای مصنوعی را اندازه گیری می کند که ممکن است از نظر شباهت بسیار نزدیک به رکوردهای واقعی باشد. این بدان معنی است که، اگرچه آنها کپی مستقیم نیستند، اما نقاط بالقوه نشت حریم خصوصی و منبع اطلاعات مفید برای حملات استنتاج هستند.

امتیاز با انجام جستجوی نزدیکترین همسایگان با ابعاد بالا بر روی داده های مصنوعی همپوشانی با داده های اصلی محاسبه می شود.

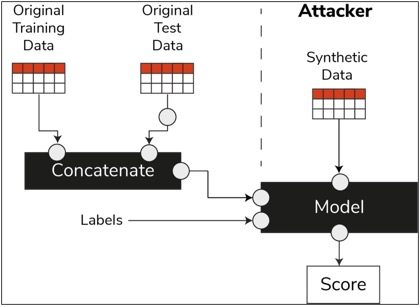

امتیاز استنتاج عضویت

در چرخه حیات علم داده، زمانی که یک مدل آموزش داده شد، دیگر نیازی به دسترسی به نمونه های آموزشی ندارد و می تواند روی داده های دیده نشده پیش بینی کند. به طور مشابه، در مورد ما، هنگامی که مدل سینت سایزر آموزش داده شد، می توان نمونه هایی از داده های مصنوعی را بدون نیاز به داده های اصلی تولید کرد.

از طریق نوعی حمله به نام "حمله استنتاج عضویت"، مهاجمان می توانند سعی کنند داده هایی را که برای ایجاد داده های مصنوعی استفاده شده است، بدون دسترسی به داده های اصلی، آشکار کنند. این منجر به به خطر افتادن حریم خصوصی می شود.

امتیاز استنتاج عضویت احتمال موفقیت آمیز بودن حمله استنتاج عضویت را اندازه گیری می کند.

امتیاز پایین امکان استنباط را نشان می دهد که یک رکورد خاص عضوی از مجموعه داده آموزشی بوده که منجر به ایجاد داده های مصنوعی شده است. به عبارت دیگر، حملات می توانند جزئیات یک رکورد فردی را استنتاج کنند و در نتیجه حریم خصوصی را به خطر بیندازند.

امتیاز استنتاج عضویت بالا نشان می دهد که مهاجم بعید است تشخیص دهد که آیا یک رکورد خاص بخشی از مجموعه داده اصلی مورد استفاده برای ایجاد داده های مصنوعی است یا خیر. این همچنین به این معنی است که اطلاعات هیچ فردی از طریق داده های مصنوعی به خطر نیفتاده است.

مفهوم نگهدارنده

بهترین روش مهمی که باید دنبال کنیم این است که مطمئن شویم داده های مصنوعی به اندازه کافی عمومی هستند و با داده های اصلی که بر روی آن آموزش داده شده اند بیش از حد مناسب نیستند. در جریان علم داده معمولی، در حالی که مدلهای ML مانند طبقهبندیکننده جنگل تصادفی میسازیم، دادههای آزمایشی را کنار میگذاریم، مدلها را با استفاده از دادههای آموزشی آموزش میدهیم و معیارها را روی دادههای آزمایشی دیده نشده ارزیابی میکنیم.

به طور مشابه، برای دادههای مصنوعی، نمونهای از دادههای اصلی را کنار میگذاریم - که عموماً به عنوان یک مجموعه داده نگهدارنده یا دادههای آزمایش پنهانشده دیده نمیشود - و دادههای مصنوعی تولید شده را در مقابل مجموعه دادههای نگهدارنده ارزیابی میکنیم.

انتظار می رود مجموعه داده نگهدارنده نمایشی از داده های اصلی باشد، اما زمانی که داده های مصنوعی تولید شده اند دیده نمی شود. بنابراین، داشتن امتیازهای مشابه برای همه معیارها هنگام مقایسه نسخه اصلی با مجموعه دادههای مصنوعی و ذخیرهسازی ضروری است.

وقتی امتیازات مشابهی به دست میآید، میتوانیم ثابت کنیم که نقاط داده مصنوعی نتیجه به خاطر سپردن نقاط داده اصلی نیستند، در حالی که همان وفاداری و کاربرد را حفظ میکنند.

افکار نهایی

جهان شروع به درک اهمیت استراتژیک داده های مصنوعی کرده است. به عنوان دانشمندان داده و تولیدکنندگان داده، وظیفه ما این است که به داده های مصنوعی که تولید می کنیم اعتماد ایجاد کنیم و مطمئن شویم که برای یک هدف هستند.

داده های مصنوعی در حال تبدیل شدن به یک ابزار ضروری در جعبه ابزار توسعه علم داده است. MIT Technology Review کرده است اشاره کرد داده های مصنوعی به عنوان یکی از فناوری های پیشرفت در سال 2022. ادعا می کند که ما نمی توانیم ساخت مدل های هوش مصنوعی با ارزش عالی را بدون داده های مصنوعی تصور کنیم. گارتنر.

مطابق با مک کینزیدادههای مصنوعی هزینهها و موانعی را که در غیر این صورت هنگام توسعه الگوریتمها یا دسترسی به دادهها با آنها مواجه میشد، به حداقل میرساند.

تولید داده های مصنوعی در مورد شناخت برنامه های کاربردی پایین دست و درک مبادلات بین ابعاد مختلف برای کیفیت داده های مصنوعی است.

خلاصه

به عنوان استفاده کننده از داده های مصنوعی، ضروری است که زمینه استفاده از هر نمونه مصنوعی را در آینده تعریف کنیم. درست مانند دادههای واقعی، کیفیت دادههای مصنوعی به مورد استفاده در نظر گرفته شده و همچنین پارامترهای انتخاب شده برای ترکیب بستگی دارد.

به عنوان مثال، نگه داشتن مقادیر پرت در داده های مصنوعی مانند داده های اصلی برای یک مورد استفاده از کشف تقلب مفید است. با این حال، در موارد استفاده از مراقبتهای بهداشتی با نگرانیهای حفظ حریم خصوصی مفید نیست، زیرا معمولاً موارد پرت میتواند نشت اطلاعات باشد.

علاوه بر این، یک معاوضه بین وفاداری، سودمندی و حریم خصوصی وجود دارد. داده ها را نمی توان برای هر سه به طور همزمان بهینه کرد. این معیارها به ذینفعان امکان می دهد تا آنچه را که برای هر مورد استفاده ضروری است اولویت بندی کنند و انتظارات از داده های مصنوعی تولید شده را مدیریت کنند.

در نهایت، وقتی مقادیر هر معیار را میبینیم و زمانی که آنها انتظارات را برآورده میکنند، ذینفعان میتوانند به راهحلهایی که با استفاده از دادههای مصنوعی ایجاد میکنند، اطمینان داشته باشند.

موارد استفاده برای داده های مصنوعی ساخت یافته طیف وسیعی از کاربردها از داده های آزمایشی برای توسعه نرم افزار تا ایجاد بازوهای کنترل مصنوعی در آزمایشات بالینی را پوشش می دهد.

برای کشف این فرصت ها تماس بگیرید یا یک PoC برای نشان دادن ارزش ایجاد کنید.

فارس حداد رهبر داده ها و بینش ها در تیم پیگیری های استراتژیک AABG است. او به شرکت ها کمک می کند تا با موفقیت به داده محور تبدیل شوند.

فارس حداد رهبر داده ها و بینش ها در تیم پیگیری های استراتژیک AABG است. او به شرکت ها کمک می کند تا با موفقیت به داده محور تبدیل شوند.

- پیشرفته (300)

- AI

- آی هنر

- مولد هنر ai

- ربات ai

- آموزش ماشین آمازون

- هوش مصنوعی

- گواهی هوش مصنوعی

- هوش مصنوعی در بانکداری

- ربات هوش مصنوعی

- ربات های هوش مصنوعی

- نرم افزار هوش مصنوعی

- آموزش ماشین AWS

- بلاکچین

- کنفرانس بلاک چین ai

- coingenius

- هوش مصنوعی محاوره ای

- کنفرانس کریپتو ai

- دل-ه

- یادگیری عمیق

- گوگل ai

- فراگیری ماشین

- افلاطون

- افلاطون آی

- هوش داده افلاطون

- بازی افلاطون

- PlatoData

- بازی پلاتو

- مقیاس Ai

- نحو

- نحوه فنی

- زفیرنت