GPT چت, SLAB, انتشار پایدارو سایر هوش مصنوعی های مولد جهان را طوفان کرده اند. آنها شعر و تصاویر افسانه ای خلق می کنند. آنها به هر گوشه دنیای ما نفوذ می کنند، از بازاریابی گرفته تا نوشتن خلاصه های قانونی و کشف دارو. به نظر میرسد که آنها پوستر داستان موفقیت آمیزش ذهن انسان و ماشین هستند.

اما در زیر کاپوت، چیزها کمتر هلویی به نظر می رسند. این سیستمها انرژی عظیمی هستند و به مراکز دادهای نیاز دارند که هزاران تن انتشار کربن را بیرون میریزند - که بیشتر بر آب و هوای بیثبات تاکید میکنند - و میلیاردها دلار را جذب میکنند. با پیچیدهتر شدن و استفاده گستردهتر از شبکههای عصبی، مصرف انرژی احتمالاً بیش از پیش افزایش مییابد.

جوهر زیادی روی هوش مصنوعی مولد ریخته شده است رد پای کربن. تقاضای انرژی آن می تواند سقوط آن باشد که مانع از توسعه با رشد بیشتر شود. با استفاده از سختافزار فعلی، «انتظار میرود که هوش مصنوعی مولد اگر همچنان به سختافزار محاسباتی استاندارد تکیه کند، به زودی متوقف شود». گفت: دکتر هچن وانگ در آزمایشگاه های اینتل.

زمان آن فرا رسیده است که هوش مصنوعی پایدار بسازیم.

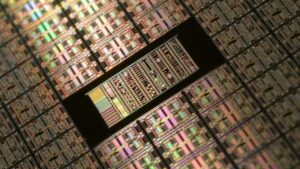

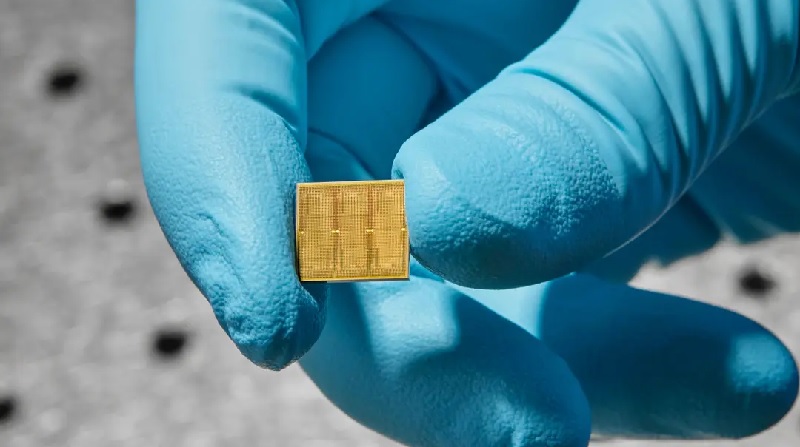

این هفته یک مطالعه IBM گامی عملی در این راستا برداشت. آنها یک تراشه آنالوگ 14 نانومتری با 35 میلیون واحد حافظه ایجاد کردند. برخلاف تراشههای فعلی، محاسبات مستقیماً در آن واحدها انجام میشود و نیاز به انتقال دادهها به عقب و جلو را برطرف میکند و در نتیجه باعث صرفهجویی در انرژی میشود.

وانگ گفت که انتقال داده ها می تواند مصرف انرژی را از 3 تا 10,000 برابر بیشتر از آنچه برای محاسبات واقعی لازم است افزایش دهد.

این تراشه زمانی که با دو وظیفه تشخیص گفتار به چالش کشیده شد بسیار کارآمد بود. یکی، دستورات گفتار گوگل، کوچک اما کاربردی است. در اینجا، سرعت کلید است. دیگری، Librispeech، یک سیستم بزرگ است که به رونویسی گفتار به متن کمک می کند و توانایی تراشه برای پردازش حجم عظیمی از داده ها را کاهش می دهد.

هنگامی که تراشه در مقابل رایانههای معمولی قرار میگیرد، به همان اندازه دقیق عمل میکند، اما کار را سریعتر و با انرژی بسیار کمتر به پایان میرساند و از کمتر از یک دهم مقداری که معمولاً برای برخی کارها نیاز است استفاده میکند.

به گفته تیم تحقیقاتی، "اینها، طبق دانش ما، اولین نمایش سطوح دقت تجاری مرتبط در یک مدل تجاری مرتبط ... با کارایی و موازی سازی عظیم" برای یک تراشه آنالوگ است.

بایت های مغزی

این به سختی اولین تراشه آنالوگ است. با این حال، این ایده محاسبات نورومورفیک را به قلمرو عملی سوق می دهد - تراشه ای که روزی می تواند تلفن، خانه هوشمند و سایر دستگاه های شما را با کارایی نزدیک به مغز نیرو دهد.

اوم، چی؟ بیایید پشتیبان گیری کنیم.

رایانه های فعلی بر روی ساخته شده اند معماری فون نویمان. آن را به عنوان خانه ای با اتاق های متعدد در نظر بگیرید. یکی، واحد پردازش مرکزی (CPU)، داده ها را تجزیه و تحلیل می کند. دیگری حافظه را ذخیره می کند.

برای هر محاسبه، کامپیوتر باید داده ها را بین آن دو اتاق به عقب و جلو انتقال دهد و زمان و انرژی می گیرد و بازده را کاهش می دهد.

مغز در مقابل، محاسبات و حافظه را در یک آپارتمان استودیویی ترکیب می کند. اتصالات قارچ مانند آن که سیناپس نامیده می شوند، هم شبکه های عصبی را تشکیل می دهند و هم خاطرات را در یک مکان ذخیره می کنند. سیناپسها بسیار انعطافپذیر هستند و میزان اتصال آنها را با سایر نورونها بر اساس حافظه ذخیرهشده و یادگیریهای جدید تنظیم میکنند - خاصیتی به نام "وزن". مغز ما با تنظیم این وزنه های سیناپسی به سرعت خود را با یک محیط در حال تغییر سازگار می کند.

IBM در طراحی پیشرو بوده است تراشه های آنالوگ آن تقلید محاسبات مغزی. یک پیشرفت بزرگ در سال 2016 آمد، زمانی که تراشه ای را بر اساس مواد جذابی که معمولاً در سی دی های قابل بازنویسی یافت می شود معرفی کردند. این ماده حالت فیزیکی خود را تغییر می دهد و وقتی با الکتریسیته کوبیده می شود، از یک سوپ غلیظ به ساختارهای کریستال مانند تغییر شکل می دهد - شبیه به 0 و 1 دیجیتال.

نکته اینجاست: تراشه می تواند در حالت ترکیبی نیز وجود داشته باشد. به عبارت دیگر، مشابه یک سیناپس بیولوژیکی، سیناپس مصنوعی میتواند تعداد بیشماری از وزنهای مختلف را رمزگذاری کند - نه فقط دودویی - که به آن اجازه میدهد تا چندین محاسبات را بدون نیاز به جابجایی یک بیت داده جمعآوری کند.

جکیل و هاید

مطالعه جدید بر اساس کارهای قبلی با استفاده از مواد تغییر فاز نیز ساخته شده است. اجزای اصلی "کاشی های حافظه" هستند. هر کدام با هزاران ماده تغییر فاز در یک ساختار شبکه ای پر شده است. کاشی ها به راحتی با یکدیگر ارتباط برقرار می کنند.

هر کاشی توسط یک کنترلکننده محلی قابل برنامهریزی کنترل میشود و به تیم اجازه میدهد تا مؤلفه را - شبیه به یک نورون - با دقت تغییر دهد. این تراشه همچنین صدها فرمان را به ترتیب ذخیره میکند و یک جعبه سیاه از انواع ایجاد میکند که به آنها اجازه میدهد دوباره به درون آن بگردند و عملکرد آن را تجزیه و تحلیل کنند.

به طور کلی، تراشه حاوی 35 میلیون ساختار حافظه تغییر فاز بود. این اتصالات بالغ بر 45 میلیون سیناپس بود که بسیار دور از مغز انسان بود، اما در یک تراشه 14 نانومتری بسیار چشمگیر بود.

این اعداد بیحسکننده مشکلی را برای مقداردهی اولیه تراشه هوش مصنوعی ایجاد میکنند: به سادگی پارامترهای زیادی برای جستجو وجود دارد. این تیم با برنامهریزی وزنهای سیناپسی قبل از شروع محاسبات، با مشکل مهدکودک هوش مصنوعی مقابله کردند. (این کمی شبیه چاشنی کردن یک ماهیتابه چدنی جدید قبل از پختن با آن است.)

وانگ، که در این مطالعه شرکت نداشت، توضیح داد که آنها «تکنیکهای آموزش شبکهای خود را با مزایا و محدودیتهای سختافزار در ذهن تنظیم کردند» و سپس وزنها را برای بهینهترین نتایج تعیین کردند.

نتیجه داد. در یک آزمایش اولیه، تراشه بهراحتی 12.4 تریلیون عملیات در ثانیه را برای هر وات توان انجام داد. وانگ گفت: مصرف انرژی "ده ها یا حتی صدها برابر بیشتر از قوی ترین CPU ها و GPU ها است."

این تراشه یک فرآیند محاسباتی هستهای را تحت شبکههای عصبی عمیق تنها با چند جزء سختافزاری کلاسیک در کاشیهای حافظه میخکوب کرد. در مقابل، کامپیوترهای سنتی به صدها یا هزاران ترانزیستور (واحد اساسی که محاسبات را انجام می دهد) نیاز دارند.

صحبت از شهر

تیم در مرحله بعد تراشه را به دو وظیفه تشخیص گفتار به چالش کشید. هر کدام بر جنبه متفاوتی از تراشه تاکید داشتند.

اولین آزمایش سرعت زمانی بود که با یک پایگاه داده نسبتاً کوچک به چالش کشیده شد. با استفاده از دستورات گفتار گوگل در پایگاه داده، این کار به تراشه هوش مصنوعی نیاز داشت که 12 کلمه کلیدی را در مجموعه ای از تقریباً 65,000 کلیپ از هزاران نفر که 30 کلمه کوتاه صحبت می کنند شناسایی کند («کوچک» در دنیای یادگیری عمیق نسبی است). هنگام استفاده از یک معیار پذیرفته شده-MLPerf- تراشه هفت برابر سریعتر عمل کرد نسبت به کارهای قبلی.

این تراشه همچنین زمانی که با یک پایگاه داده بزرگ به چالش کشیده شد، درخشید. کتابداری. مجموعه شامل بیش از 1,000 ساعت گفتار خواندنی انگلیسی است که معمولاً برای آموزش هوش مصنوعی برای تجزیه گفتار و رونویسی خودکار گفتار به متن استفاده میشود.

به طور کلی، تیم از پنج تراشه استفاده کرد تا در نهایت بیش از 45 میلیون وزن را با استفاده از داده های 140 میلیون دستگاه تغییر فاز رمزگذاری کند. وقتی این تراشه در برابر سختافزار معمولی قرار گرفت، تقریباً 14 برابر انرژی کارآمدتر بود - تقریباً 550 نمونه را در هر ثانیه در هر وات مصرف انرژی پردازش میکرد - با نرخ خطای کمی بیش از 9 درصد.

اگرچه تراشه های آنالوگ چشمگیر هستند، اما هنوز در مراحل ابتدایی خود هستند. وانگ گفت: آنها وعدههای بزرگی برای مبارزه با مشکلات پایداری مرتبط با هوش مصنوعی نشان میدهند، اما مسیر رو به جلو نیازمند رفع چند مانع دیگر است.

یکی از عوامل، دقیقتر کردن طراحی خود فناوری حافظه و اجزای اطراف آن است، یعنی نحوه چیدمان تراشه. تراشه جدید آیبیام هنوز شامل تمام عناصر مورد نیاز نیست. گام مهم بعدی، ادغام همه چیز در یک تراشه واحد و در عین حال حفظ کارایی آن است.

در بخش نرمافزاری، ما همچنین به الگوریتمهایی نیاز داریم که بهطور خاص برای تراشههای آنالوگ تنظیم شوند، و نرمافزارهایی که به راحتی کد را به زبان قابل فهم ماشینها ترجمه کنند. از آنجایی که این تراشه ها به طور فزاینده ای از نظر تجاری قابل دوام می شوند، توسعه برنامه های کاربردی اختصاصی رویای آینده تراشه آنالوگ را زنده نگه می دارد.

وانگ میگوید: «دههها طول کشید تا اکوسیستمهای محاسباتی که در آنها CPUها و GPUها با موفقیت عمل میکنند، شکل بگیرد. و احتمالا سالها طول می کشد تا محیط مشابهی برای هوش مصنوعی آنالوگ ایجاد شود.

تصویر های اعتباری: رایان لاوین برای IBM

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. خودرو / خودروهای الکتریکی، کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- ChartPrime. بازی معاملاتی خود را با ChartPrime ارتقا دهید. دسترسی به اینجا.

- BlockOffsets. نوسازی مالکیت افست زیست محیطی. دسترسی به اینجا.

- منبع: https://singularityhub.com/2023/08/25/ibms-brain-inspired-analog-chip-aims-to-make-ai-more-sustainable/

- : دارد

- :است

- :نه

- $UP

- 000

- 1

- 10

- 12

- 14

- 30

- 9

- a

- توانایی

- بالاتر

- پذیرفته

- انباشتن

- دقت

- به درستی

- واقعی

- وفق دادن

- در برابر

- AI

- اهداف

- الگوریتم

- معرفی

- اجازه دادن

- اجازه می دهد تا

- قبلا

- همچنین

- مقدار

- an

- تحلیل

- تجزیه و تحلیل

- و

- دیگر

- هر جا

- اپارتمان

- برنامه های کاربردی

- هستند

- مصنوعی

- AS

- مرتبط است

- At

- اتوماتیک

- به عقب

- مستقر

- اساسی

- BE

- شدن

- بوده

- قبل از

- شروع

- مزایای

- میان

- میلیاردها

- بیت

- سیاه پوست

- هر دو

- جعبه

- مغز

- دستیابی به موفقیت

- ساختن

- ساخته

- اما

- by

- محاسبات

- نام

- CAN

- کربن

- CDS

- مراکز

- مرکزی

- به چالش کشیده شد

- تبادل

- کودک

- تراشه

- چیپس

- نقل و انتقال بانکی

- کلیپ های

- رمز

- ترکیب

- تجاری

- عموما

- ارتباط

- اجزاء

- محاسبه

- محاسبات

- کامپیوتر

- کامپیوتر

- محاسبه

- اتصال

- اتصالات

- مصرف

- شامل

- موجود

- شامل

- ادامه

- کنتراست

- کنترل

- کنترل کننده

- معمولی

- هسته

- میتوانست

- ایجاد

- ایجاد شده

- ایجاد

- اعتبار

- بحرانی

- جاری

- داده ها

- مرکز دادهها

- پایگاه داده

- مجموعه داده ها

- روز

- دهه

- کاهش می دهد

- اختصاصی

- عمیق

- یادگیری عمیق

- تقاضا

- طرح

- طراحی

- در حال توسعه

- پروژه

- دستگاه ها

- مختلف

- DIG

- دیجیتال

- جهت

- مستقیما

- کشف

- میکند

- دلار

- سقوط

- dr

- رویا

- دارو

- هر

- اکوسیستم

- اثر

- بهره وری

- موثر

- عناصر

- انرژی

- مصرف انرژی

- انگلیسی

- محیط

- به همان اندازه

- خطا

- ایجاد

- حتی

- در نهایت

- همیشه در حال تغییر

- هر

- همه چیز

- وجود داشته باشد

- توضیح داده شده

- عامل

- بسیار

- بازی Far Cry

- شگفت انگیز

- سریعتر

- کمی از

- نام خانوادگی

- قابل انعطاف

- برای

- خط مقدم

- فرم

- چهارم

- به جلو

- یافت

- از جانب

- بیشتر

- آینده

- مولد

- هوش مصنوعی مولد

- گوگل

- GPU ها

- توری

- رشد می کند

- دست

- اتفاق می افتد

- سخت افزار

- آیا

- داشتن

- کمک می کند

- اینجا کلیک نمایید

- زیاد

- بالاتر

- خیلی

- صفحه اصلی

- کاپوت

- ساعت ها

- خانه

- چگونه

- اما

- HTML

- HTTPS

- انسان

- صدها نفر

- موانع

- ترکیبی

- آی بی ام

- اندیشه

- if

- تصویر

- تصاویر

- موثر

- in

- در دیگر

- افزایش

- به طور فزاینده

- اول

- ادغام

- اینتل

- به

- معرفی

- گرفتار

- IT

- ITS

- خود

- کار

- JPG

- تنها

- نگاه داشتن

- کلید

- کلید واژه ها

- دانش

- آزمایشگاه

- زبان

- بزرگ

- یادگیری

- قانونی

- کمتر

- سطح

- پسندیدن

- احتمالا

- محدودیت

- محلی

- محل

- به دنبال

- ماشین آلات

- حفظ

- ساخت

- بسیاری

- بازار یابی (Marketing)

- عظیم

- ماده

- مصالح

- حداکثر عرض

- خاطرات

- حافظه

- میلیون

- ذهن

- بیش

- اکثر

- حرکت

- چندگانه

- بی شمار

- طبیعت

- نزدیک

- تقریبا

- نیاز

- ضروری

- نیازهای

- شبکه

- شبکه های عصبی

- محاسبات نورومورفیک

- نورون ها

- جدید

- تراشه جدید

- بعد

- به طور معمول

- تعداد

- of

- on

- ONE

- به سوی

- کار

- عملیات

- بهینه

- or

- دیگر

- ما

- خارج

- روی

- بسته بندی شده

- پارامترهای

- مسیر

- مردم

- برای

- در صد

- کارایی

- انجام

- انجام می دهد

- تلفن

- فیزیکی

- حفره دار

- افلاطون

- هوش داده افلاطون

- PlatoData

- شعر

- قدرت

- قوی

- عملی

- دقت

- در حال حاضر

- قبلی

- شاید

- مشکل

- مشکلات

- روند

- در حال پردازش

- وعده

- ویژگی

- هل می دهد

- به سرعت

- نرخ

- خواندن

- قلمرو

- به رسمیت شناختن

- نسبی

- نسبتا

- مربوط

- تکیه

- ضروری

- نیاز

- استراحت كردن

- نتایج

- اتاق

- تقریبا

- سعید

- همان

- صرفه جویی کردن

- دوم

- به دنبال

- به نظر می رسد

- دنباله

- تنظیم

- هفت

- شکل

- کوتاه

- نشان

- طرف

- مشابه

- به سادگی

- تنها

- صعود

- کوچک

- هوشمند

- خانه هوشمند

- So

- نرم افزار

- برخی از

- بزودی

- مصنوعی

- صحبت کردن

- به طور خاص

- سخنرانی - گفتار

- تشخیص گفتار

- گفتار به متن

- سرعت

- Spot

- استاندارد

- دولت

- گام

- هنوز

- opbevare

- ذخیره شده

- پرده

- طوفان

- داستان

- به شدت

- ساختار

- ساختار

- استودیو

- مهاجرت تحصیلی

- موفقیت

- داستان موفقیت

- موفقیت

- اطراف

- پایداری

- قابل تحمل

- محل تماس دو عصب

- سیناپس

- سیستم

- سیستم های

- گرفتن

- صورت گرفته

- طول می کشد

- کار

- وظایف

- تیم

- تکنیک

- پیشرفته

- آزمون

- نسبت به

- که

- La

- جهان

- شان

- آنها

- سپس

- آنجا.

- اینها

- آنها

- اشیاء

- فکر می کنم

- کسانی که

- هزاران نفر

- از طریق

- زمان

- بار

- به

- لحن

- هم

- در زمان

- سنتی

- قطار

- تریلیون

- دور زدن

- دو

- زیر

- اساسی

- فهمیدن

- واحد

- واحد

- جهان

- بر خلاف

- استفاده

- با استفاده از

- معمولا

- بسیار

- قابل اعتماد

- فرار

- بود

- we

- هفته

- چی

- چه زمانی

- که

- در حین

- WHO

- به طور گسترده ای

- اراده

- با

- در داخل

- بدون

- کلمات

- مهاجرت کاری

- مشغول به کار

- جهان

- نوشته

- سال

- هنوز

- شما

- زفیرنت