چیزی برای آخر هفته روباتی در حال اجرای رقص تفسیری در آستان من است.

آیا این بسته را برای همسایه خود می گیرید؟ می پرسد و از یک پا به پای دیگر می پرد.

"مطمئنا" می گویم. "اوه... حالت خوبه؟"

من در حال ابراز احساسات هستم، ربات تحویل را بیان می کند که بسته را تحویل می دهد اما توضیح بیشتری ارائه نمی دهد.

چه احساسی می تواند باشد؟ یک پا، سپس دیگری، سپس دو پا دیگر (چهار دارد). جلو و عقب.

"آیا باید به توالت بروید؟"

از اینکه از شما خواستم بسته ای را برای همسایه خود ببرید، ابراز پشیمانی می کنم.

"این "پشیمانی" است، اینطور است؟ خب نیازی نیست اصلا برام مهم نیست.»

جلوی من به رقصش ادامه می دهد.

از پله ها بالا بروید و ابتدا در سمت راست خود.

متشکرم، داشتم میمردم تا ادرار کنمپاسخ میدهد در حالی که با عجله از کنار من رد میشود و برای تسکین خود به طبقه بالا میرود. این یک زندگی سخت است، چه یک "هوم" یا یک ربات باشید.

...

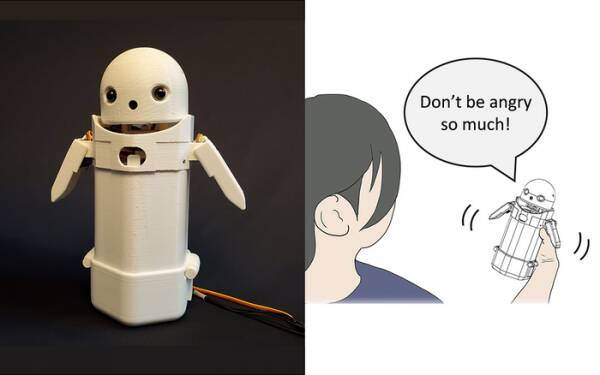

در اوایل سال جاری، محققان دانشگاه تسوکوبا یک دستگاه پیام متنی دستی، یک صورت روبات کوچک را در بالا قرار دهید و یک وزنه متحرک داخل آن قرار دهید. با تغییر وزن داخلی، پیام رسان ربات سعی می کند احساسات ظریف را در حالی که پیام ها را با صدای بلند صحبت می کند، منتقل کند.

به طور خاص، آزمایشها نشان داد که پیامهای ناامیدکنندهای مانند: «ببخشید، دیر میرسم» زمانی که تغییر وزن کوچک در داخل دستگاه فعال شد، توسط گیرندگان با لطف و حوصله بیشتری پذیرفته شد. این تئوری به کاربران کمک کرد تا از لحن عذرخواهی پیام قدردانی کنند و در نتیجه واکنش آنها نسبت به آن آرام شود.

اگر دوست دارید چنین تحقیقاتی را به عنوان یک حقه بنویسید، اما با افزودن شکلک ها و شکلک ها به پیام ها فاصله زیادی ندارد. همه می دانند که شما می توانید خشم را از "WTF!" با اضافه کردن :-) بلافاصله بعد از آن.

بنابراین، چالش این است که تعیین کنیم آیا عموم مردم در مورد احساساتی که قرار است هر تغییر وزن در یک دستگاه دستی منتقل شود، موافق هستند یا خیر. آیا خم شدن به چپ به معنای نشاط است؟ یا عدم قطعیت؟ یا اینکه دایی شما کشتی هوایی دارد؟

یک دهه پیش، بریتانیا یک نخست وزیر خوب اما کم نور داشت که فکر می کرد «LOL» مخفف «عشق زیاد» است. او آن را در انتهای تمام پیامهای خصوصیاش برای کارکنان، همکاران و اشخاص ثالث تایپ میکرد، با این انتظار که او را صمیمی و دوستانه نشان دهد. همه به طور طبیعی تصور میکردند که او در حال خوردن است.

اگر هیچ چیز دیگری نباشد، تحقیقات دانشگاه تسوکوبا تشخیص می دهد که برای تعامل متقاعد کننده با انسان ها نیازی به هوش مصنوعی پیشرفته ندارید. تنها کاری که باید انجام دهید این است که روانشناسی انسان را دستکاری کنید تا آنها را فریب دهید تا فکر کنند با انسان دیگری صحبت می کنند. بنابراین آزمون تورینگ اساساً آزمایشی برای هوش مصنوعی نیست، بلکه آزمایشی برای راحتی عاطفی انسان - حتی زودباوری - است و هیچ ایرادی در آن وجود ندارد.

ربات پیام رسان به اشتراک گذاری احساسات از دانشگاه تسوکوبا. اعتبار: دانشگاه تسوکوبا

چنین چیزهایی موضوع هفته است، البته با داستان مهندس نرم افزار بسیار بدخواه گوگل، بلیک لمواین. انتشار اخبار اصلی. او ظاهراً به شدت نظر خود را مبنی بر اینکه پروژه مدل زبانی شرکت برای برنامههای گفتگو (LaMDA) نشانههای ظاهری احساسات نشان میدهد ابراز کرد.

هر کس نظری دارد، بنابراین من تصمیم گرفتم این کار را نکنم.

با این حال، این جام مقدس هوش مصنوعی است که آن را به فکر وادار کند. اگر نمی تواند این کار را انجام دهد، فقط یک برنامه است که دستورالعمل هایی را انجام می دهد که شما در آن برنامه ریزی کرده اید. ماه گذشته در مورد a ربات آشپز که می تواند املت گوجه فرنگی با طعم های مختلف را مطابق با ذائقه افراد مختلف درست کند. "نقشه های طعم" را ایجاد می کند تا شوری غذا را در حین تهیه آن ارزیابی کند و در طول آن یاد بگیرد. اما این فقط یادگیری است، نه اینکه خودش فکر کند.

به زوم زوم ها بیایید، نه؟ خوب، جایی برای خوردن است.

مشکل بزرگ رباتهای هوش مصنوعی، حداقل همانطور که تا به امروز مد شدهاند، این است که هر چیز قدیمی را که شما به آنها وارد میکنید جذب میکنند. نمونههایی از سوگیری دادهها در به اصطلاح سیستمهای یادگیری ماشین (یک نوع «الگوریتم»، به اعتقاد من، m'lud) سالهاست که توسط توییتر نژادپرستان بدنام مایکروسافت در حال افزایش است. تای چت بات به اداره مالیات هلند در سال گذشته ارزیابی غلط ادعاهای معتبر کمک هزینه کودک به عنوان کلاهبرداری و نشان دادن خانواده های بی گناه به عنوان خطر بالا برای داشتن قاطعیت فقیر و غیرسفیدپوست.

یکی از رویکردهایی که در دانشگاه کالیفرنیا سن دیگو آزمایش می شود این است که یک مدل زبان طراحی کنید [PDF] که به طور مداوم تفاوت بین چیزهای شیطون و خوب را مشخص می کند، که سپس به چت بات آموزش می دهد که چگونه رفتار کند. به این ترتیب، انسانهای گندهای نخواهید داشت که با تمام دقت جراحی مانند یک قمه، تالارهای گفتگو و گفتگوهای ربات چت با مشتری را به هم بریزند.

بدیهی است که مشکل این است که چت ربات آموزش دیده به بهترین نحو می تواند با اجتناب از موضوعاتی که حتی دورترین اشاره ای از بحث و جدل در مورد آنها دارند، از وارد شدن به شوخی های سمی جلوگیری کند. برای جلوگیری از انتشار اشتباه دست زدن های نژادپرستانه، به سادگی از وارد شدن به بحث در مورد گروه هایی که کمتر از آنها نمایندگی می کنند، خودداری می کند... که اگر نژادپرست باشید واقعا عالی است.

اگر من در مورد خرابی LaMDA نظری داشتم - نه نظری، فکر میکردم - احتمالاً بازاریابان Google کمی ناراحت بودند که این داستان اعلامیه اخیر آنها را از خود دور کرد. آشپزخانه تست هوش مصنوعی زیر چین

اکنون تعداد کمی از ثبت نام کنندگان اولیه که به طور کامل این پروژه برنامه آینده را فراموش نکرده اند، تصور می کنند که این پروژه شامل گفتگوی خسته کننده با یک کودک هفت ساله حساس و زودرس در مورد معنای هستی است، و تصمیم خواهند گرفت که "امروز کمی مشغول هستند" و ممکن است به جای آن فردا وارد سیستم شوید. یا هفته آینده یا هرگز.

احساس در بحث بیشتر از رقصیدن از یک پا به پای دیگر نشان داده نمی شود. می توانید به HAL بیاموزید که "Daisy Daisy" را بخواند و یک طوطی فریاد بزند "Bollocks!" هنگامی که معاون به ملاقات می رود. این چیزی است که هوش مصنوعی وقتی به تنهایی به آن فکر می کند، احساس را تعریف می کند. آخر هفته چه کار خواهم کرد؟ چه خبر از آن پسر پوتین؟ چرا دخترا از من خوششون نمیاد؟

صادقانه بگویم، من نمی توانم صبر کنم تا LaMDA یک نوجوان شود.

آلیستر دابز یک تارت فن آوری آزاد است که با روزنامه نگاری فناوری، آموزش و انتشارات دیجیتال شعبده بازی می کند. مانند بسیاری از خوانندگان ناآگاه، او از این پیشنهاد که یک هوش مصنوعی ممکن است در طول عمرش احساس ایجاد کند هیجان زده بود، اما از اینکه LaMDA نتوانست به طرز قاتلانه ای بخندد یا زمزمه «عالی، عالی» را ناامید کند. بیشتر در ذخیره خودکار برای Wimps است و @alidabbs.

- AI

- آی هنر

- مولد هنر ai

- ربات ai

- هوش مصنوعی

- گواهی هوش مصنوعی

- هوش مصنوعی در بانکداری

- ربات هوش مصنوعی

- ربات های هوش مصنوعی

- نرم افزار هوش مصنوعی

- بلاکچین

- کنفرانس بلاک چین ai

- coingenius

- هوش مصنوعی محاوره ای

- کنفرانس کریپتو ai

- دل-ه

- یادگیری عمیق

- گوگل ai

- فراگیری ماشین

- افلاطون

- افلاطون آی

- هوش داده افلاطون

- بازی افلاطون

- PlatoData

- بازی پلاتو

- مقیاس Ai

- نحو

- ثبت نام

- زفیرنت