آمازون SageMaker استقرار مدلهای یادگیری ماشین (ML) را برای استنتاج بلادرنگ ساده میکند و انتخاب گستردهای از نمونههای ML را که شامل CPUها و شتابدهندهها میشوند، ارائه میکند. استنتاج AWS. بهعنوان یک سرویس کاملاً مدیریتشده، میتوانید استقرار مدلهای خود را مقیاسبندی کنید، هزینههای استنتاج را به حداقل برسانید، و مدلهای خود را به طور مؤثرتری در تولید با کاهش بار عملیاتی مدیریت کنید. یک نقطه پایانی استنتاج بلادرنگ SageMaker از یک نقطه پایانی HTTP و نمونههای ML تشکیل شده است که در چندین منطقه در دسترس برای دسترسی بالا مستقر شدهاند. SageMaker مقیاس خودکار برنامه می تواند به صورت پویا تعداد نمونه های ML ارائه شده برای یک مدل را در پاسخ به تغییرات در حجم کاری تنظیم کند. نقطه پایانی درخواست های دریافتی را با استفاده از یک الگوریتم گرد-رابین به طور یکنواخت به نمونه های ML توزیع می کند.

هنگامی که مدلهای ML مستقر در نمونهها، تماسهای API را از تعداد زیادی مشتری دریافت میکنند، توزیع تصادفی درخواستها میتواند زمانی که تنوع زیادی در درخواستها و پاسخهای شما وجود نداشته باشد، بسیار خوب عمل کند. اما در سیستم هایی با بار کاری هوش مصنوعی مولد، درخواست ها و پاسخ ها می توانند بسیار متغیر باشند. در این موارد، اغلب مطلوب است که تعادل بار با در نظر گرفتن ظرفیت و استفاده از نمونه به جای تعادل بار تصادفی انجام شود.

در این پست، ما درباره استراتژی مسیریابی SageMaker (LOR) و اینکه چگونه میتواند تأخیر را برای انواع خاصی از بارهای کاری استنتاج بلادرنگ با در نظر گرفتن ظرفیت و استفاده از نمونههای ML به حداقل برساند، بحث میکنیم. ما در مورد مزایای آن نسبت به مکانیسم مسیریابی پیش فرض و اینکه چگونه می توانید LOR را برای استقرار مدل خود فعال کنید صحبت می کنیم. در نهایت، ما یک تجزیه و تحلیل مقایسه ای از بهبود تاخیر با LOR نسبت به استراتژی مسیریابی پیش فرض مسیریابی تصادفی ارائه می کنیم.

استراتژی SageMaker LOR

به طور پیش فرض، نقاط پایانی SageMaker دارای یک استراتژی مسیریابی تصادفی هستند. SageMaker اکنون از یک استراتژی LOR پشتیبانی میکند که به SageMaker اجازه میدهد تا درخواستها را بهطور بهینه به نمونهای که برای ارائه آن درخواست مناسب است، هدایت کند. SageMaker با نظارت بر بار نمونه های پشت نقطه پایانی شما و مدل ها یا اجزای استنتاجی که در هر نمونه مستقر شده اند، این امکان را فراهم می کند.

نمودار تعاملی زیر سیاست مسیریابی پیشفرض را نشان میدهد که در آن درخواستهایی که به نقاط پایانی مدل میآیند به صورت تصادفی به نمونههای ML ارسال میشوند.

نمودار تعاملی زیر استراتژی مسیریابی را نشان میدهد که در آن SageMaker درخواست را به نمونهای هدایت میکند که کمترین تعداد درخواستهای معوق را دارد.

به طور کلی، مسیریابی LOR برای مدلهای پایه یا مدلهای هوش مصنوعی زمانی که مدل شما در صدها میلیثانیه تا دقیقه پاسخ میدهد، به خوبی کار میکند. اگر پاسخ مدل شما تأخیر کمتری داشته باشد (تا صدها میلی ثانیه)، ممکن است از مسیریابی تصادفی سود بیشتری ببرید. صرف نظر از این، توصیه می کنیم بهترین الگوریتم مسیریابی را برای حجم کاری خود تست و شناسایی کنید.

نحوه تنظیم استراتژی های مسیریابی SageMaker

SageMaker اکنون به شما اجازه می دهد تا تنظیم کنید RoutingStrategy پارامتر هنگام ایجاد EndpointConfiguration برای نقاط پایانی متفاوت RoutingStrategy مقادیری که توسط SageMaker پشتیبانی می شوند عبارتند از:

LEAST_OUTSTANDING_REQUESTSRANDOM

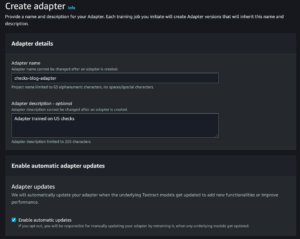

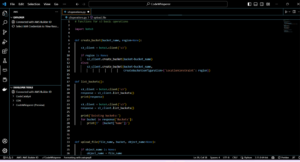

در زیر نمونه ای از استقرار یک مدل در نقطه پایانی استنتاج است که LOR را فعال کرده است:

- پیکربندی نقطه پایانی را با تنظیم ایجاد کنید

RoutingStrategyasLEAST_OUTSTANDING_REQUESTS: - نقطه پایانی را با استفاده از پیکربندی نقطه پایانی ایجاد کنید (بدون تغییر):

نتایج عملکرد

ما معیار عملکرد را برای اندازهگیری تأخیر استنتاج سرتاسر و توان عملیاتی اجرا کردیم codegen2-7B مدل میزبانی شده روی نمونههای ml.g5.24xl با مسیریابی پیشفرض و نقاط پایانی مسیریابی هوشمند. مدل CodeGen2 متعلق به خانواده مدلهای زبان اتورگرسیو است و در صورت درخواست انگلیسی کدهای اجرایی تولید میکند.

همانطور که در جدول زیر نشان داده شده است، در تجزیه و تحلیل خود، تعداد نمونه های ml.g5.24xl را در پشت هر نقطه پایانی برای هر اجرای آزمایشی افزایش دادیم، همانطور که در جدول زیر نشان داده شده است.

| تست | تعداد کاربران همزمان | تعداد موارد |

| 1 | 4 | 1 |

| 2 | 20 | 5 |

| 3 | 40 | 10 |

| 4 | 60 | 15 |

| 5 | 80 | 20 |

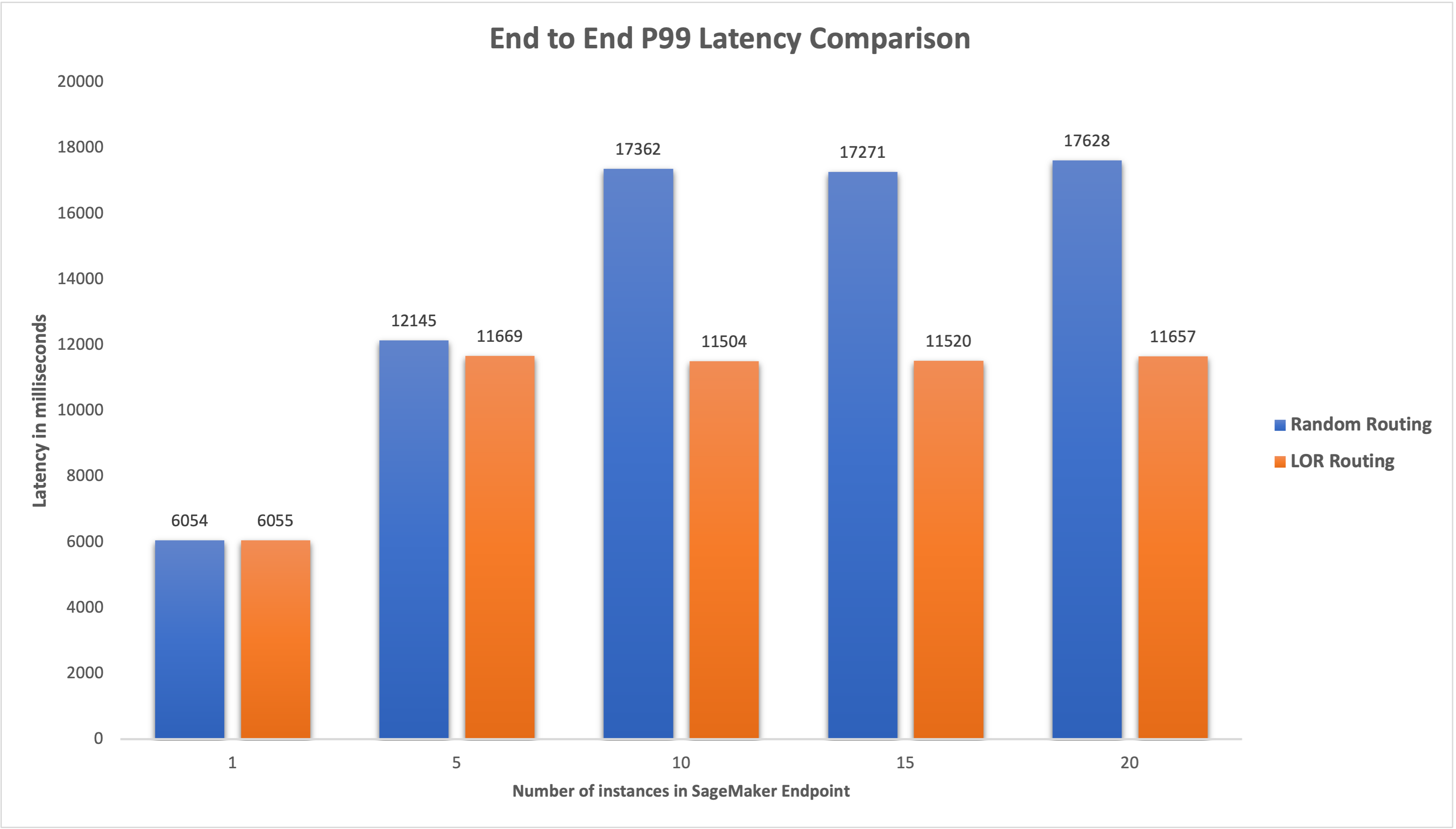

ما تأخیر انتها به انتها P99 را برای هر دو نقطه پایانی اندازهگیری کردیم و زمانی که تعداد نمونهها از 4 به 33 مورد افزایش یافت، 5 تا 20 درصد بهبود در تأخیر مشاهده کردیم، همانطور که در نمودار زیر نشان داده شده است.

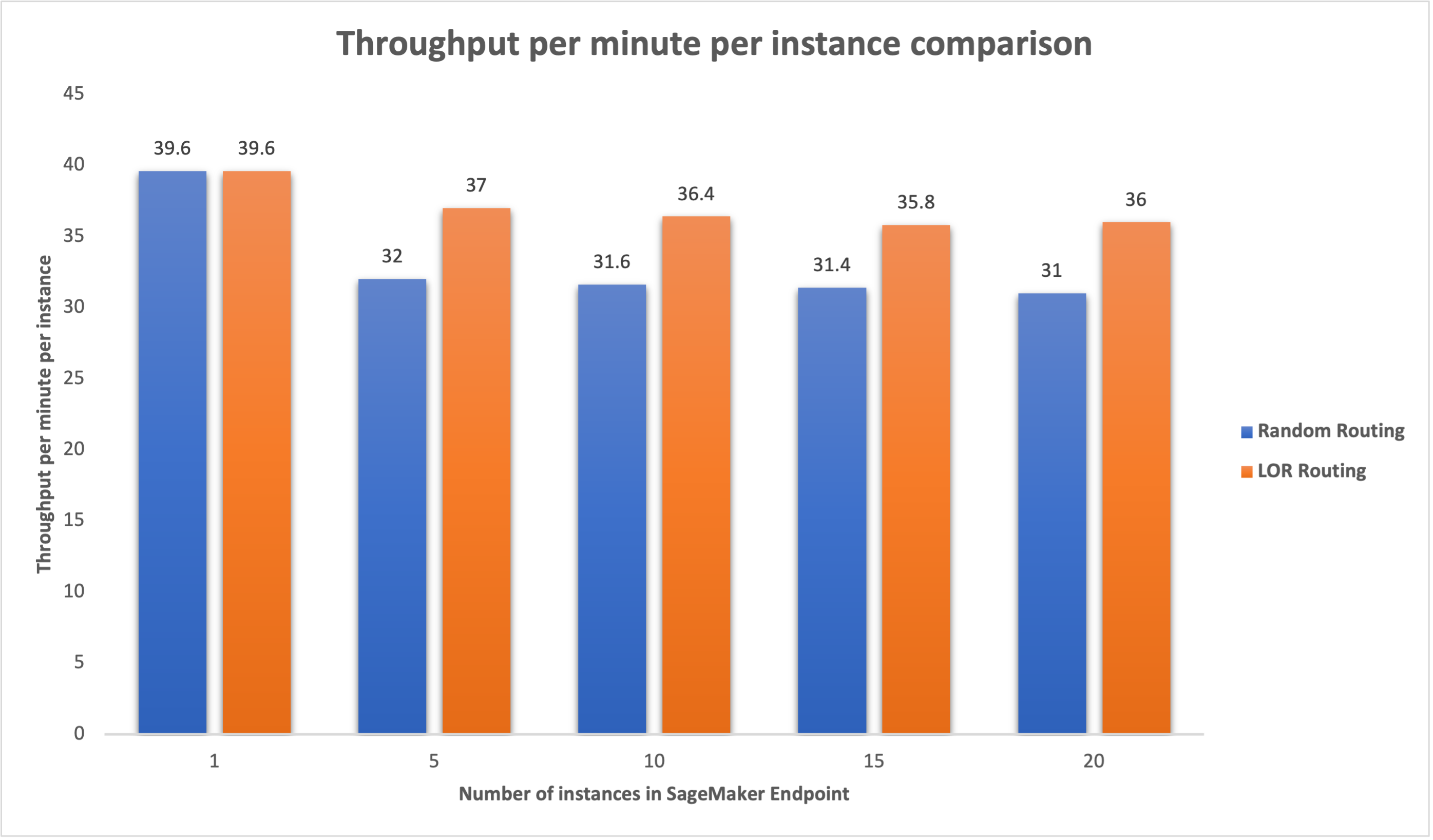

به طور مشابه، زمانی که تعداد نمونهها از 15 به 16 مورد افزایش یافت، 5 تا 20 درصد بهبود در توان خروجی در هر دقیقه در هر نمونه مشاهده شد.

این نشان میدهد که مسیریابی هوشمند میتواند توزیع ترافیک را در بین نقاط پایانی بهبود بخشد، که منجر به بهبود در تأخیر انتها به انتها و توان عملیاتی کلی میشود.

نتیجه

در این پست استراتژی های مسیریابی SageMaker و گزینه جدید فعال کردن مسیریابی LOR را توضیح دادیم. ما توضیح دادیم که چگونه LOR را فعال کنید و چگونه می تواند برای استقرار مدل شما مفید باشد. تستهای عملکرد ما بهبود تاخیر و توان عملیاتی را در طول استنتاج بلادرنگ نشان داد. برای کسب اطلاعات بیشتر در مورد ویژگی های مسیریابی SageMaker، مراجعه کنید مستندات. ما شما را تشویق میکنیم که حجم کار استنتاج خود را ارزیابی کنید و تعیین کنید که آیا با استراتژی مسیریابی بهینه پیکربندی شدهاید یا خیر.

درباره نویسنده

جیمز پارک یک معمار راه حل در خدمات وب آمازون است. او با Amazon.com برای طراحی، ساخت و استقرار راه حل های فناوری در AWS کار می کند و علاقه خاصی به هوش مصنوعی و یادگیری ماشین دارد. در اوقات فراغت او از جستجوی فرهنگ های جدید، تجربیات جدید و به روز ماندن با آخرین روندهای فناوری لذت می برد. می توانید او را در آن پیدا کنید لینک.

جیمز پارک یک معمار راه حل در خدمات وب آمازون است. او با Amazon.com برای طراحی، ساخت و استقرار راه حل های فناوری در AWS کار می کند و علاقه خاصی به هوش مصنوعی و یادگیری ماشین دارد. در اوقات فراغت او از جستجوی فرهنگ های جدید، تجربیات جدید و به روز ماندن با آخرین روندهای فناوری لذت می برد. می توانید او را در آن پیدا کنید لینک.

Venugopal Pai یک معمار راه حل در AWS است. او در بنگالورو، هند زندگی می کند و به مشتریان بومی دیجیتال کمک می کند تا برنامه های خود را در AWS مقیاس و بهینه کنند.

Venugopal Pai یک معمار راه حل در AWS است. او در بنگالورو، هند زندگی می کند و به مشتریان بومی دیجیتال کمک می کند تا برنامه های خود را در AWS مقیاس و بهینه کنند.

دیوید نیگندا یک مهندس ارشد توسعه نرم افزار در تیم آمازون SageMaker است که در حال حاضر روی بهبود گردش کار یادگیری ماشین تولید و همچنین راه اندازی ویژگی های استنتاج جدید کار می کند. در اوقات فراغت خود سعی می کند با بچه هایش همگام باشد.

دیوید نیگندا یک مهندس ارشد توسعه نرم افزار در تیم آمازون SageMaker است که در حال حاضر روی بهبود گردش کار یادگیری ماشین تولید و همچنین راه اندازی ویژگی های استنتاج جدید کار می کند. در اوقات فراغت خود سعی می کند با بچه هایش همگام باشد.

دیپتی راغا یک مهندس توسعه نرم افزار در تیم آمازون SageMaker است. کار فعلی او بر ایجاد ویژگی هایی برای میزبانی کارآمد مدل های یادگیری ماشین تمرکز دارد. او در اوقات فراغت خود از سفر، پیاده روی و پرورش گیاهان لذت می برد.

دیپتی راغا یک مهندس توسعه نرم افزار در تیم آمازون SageMaker است. کار فعلی او بر ایجاد ویژگی هایی برای میزبانی کارآمد مدل های یادگیری ماشین تمرکز دارد. او در اوقات فراغت خود از سفر، پیاده روی و پرورش گیاهان لذت می برد.

آلن تان یک مدیر ارشد محصول با SageMaker است که تلاشها را برای استنتاج مدلهای بزرگ رهبری میکند. او علاقه زیادی به استفاده از یادگیری ماشینی در حوزه تجزیه و تحلیل دارد. خارج از محل کار، او از فضای باز لذت می برد.

آلن تان یک مدیر ارشد محصول با SageMaker است که تلاشها را برای استنتاج مدلهای بزرگ رهبری میکند. او علاقه زیادی به استفاده از یادگیری ماشینی در حوزه تجزیه و تحلیل دارد. خارج از محل کار، او از فضای باز لذت می برد.

داوال پاتل یک معمار اصلی یادگیری ماشین در AWS است. او با سازمانهایی از شرکتهای بزرگ گرفته تا استارتآپهای متوسط در زمینه مشکلات مربوط به محاسبات توزیعشده و هوش مصنوعی کار کرده است. او بر روی یادگیری عمیق از جمله دامنه های NLP و Computer Vision تمرکز دارد. او به مشتریان کمک می کند تا به استنباط مدل با عملکرد بالا در SageMaker دست یابند.

داوال پاتل یک معمار اصلی یادگیری ماشین در AWS است. او با سازمانهایی از شرکتهای بزرگ گرفته تا استارتآپهای متوسط در زمینه مشکلات مربوط به محاسبات توزیعشده و هوش مصنوعی کار کرده است. او بر روی یادگیری عمیق از جمله دامنه های NLP و Computer Vision تمرکز دارد. او به مشتریان کمک می کند تا به استنباط مدل با عملکرد بالا در SageMaker دست یابند.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/minimize-real-time-inference-latency-by-using-amazon-sagemaker-routing-strategies/

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 1

- 100

- 125

- 150

- 17

- 1870

- 20

- 7

- 9

- a

- قادر

- درباره ما

- شتاب دهنده ها

- رسیدن

- در میان

- AI

- مدل های هوش مصنوعی

- آلن

- الگوریتم

- اجازه می دهد تا

- آمازون

- آمازون SageMaker

- آمازون خدمات وب

- Amazon.com

- در میان

- an

- تحلیل

- علم تجزیه و تحلیل

- و

- API

- برنامه های کاربردی

- با استفاده از

- هستند

- محدوده

- مصنوعی

- هوش مصنوعی

- AS

- At

- خودکار

- دسترس پذیری

- AWS

- برج میزان

- موازنه

- BE

- پشت سر

- متعلق

- معیار

- سود

- مزایای

- بهترین

- هر دو

- پهن

- ساختن

- بنا

- بار

- اما

- by

- تماس ها

- CAN

- ظرفیت

- موارد

- معین

- تغییر دادن

- تبادل

- مشتریان

- رمز

- COM

- آینده

- اجزاء

- کامپیوتر

- چشم انداز کامپیوتر

- محاسبه

- رقیب

- پیکر بندی

- پیکربندی

- توجه

- با توجه به

- تشکیل شده است

- هزینه

- ایجاد

- جاری

- در حال حاضر

- مشتریان

- تاریخ

- عمیق

- یادگیری عمیق

- به طور پیش فرض

- گسترش

- مستقر

- گسترش

- اعزام ها

- طرح

- مشخص کردن

- پروژه

- مختلف

- بحث و تبادل نظر

- توزیع شده

- محاسبات توزیع شده

- توزیع

- حوزه

- در طی

- بطور پویا

- هر

- به طور موثر

- موثر

- تلاش

- قادر ساختن

- فعال

- تشویق

- پشت سر هم

- نقطه پایانی

- مهندس

- انگلیسی

- شرکت

- ارزیابی

- مثال

- تجارب

- توضیح داده شده

- خیلی

- خانواده

- امکانات

- سرانجام

- پیدا کردن

- تمرکز

- پیروی

- برای

- بنیادین

- از جانب

- کاملا

- سوالات عمومی

- تولید می کند

- مولد

- هوش مصنوعی مولد

- GIF

- داده

- گراف

- در حال رشد

- آیا

- he

- کمک می کند

- او

- زیاد

- او را

- خود را

- میزبان

- میزبانی

- چگونه

- چگونه

- HTML

- HTTPS

- صدها نفر

- شناسایی

- if

- نشان می دهد

- بهبود

- بهبود

- ارتقاء

- بهبود

- in

- از جمله

- وارد شونده

- افزایش

- هندوستان

- نمونه

- اطلاعات

- تعاملی

- علاقه

- به

- IT

- ITS

- JPG

- نگاه داشتن

- بچه ها

- زبان

- بزرگ

- شرکت های بزرگ

- تاخیر

- آخرین

- راه اندازی

- برجسته

- یاد گرفتن

- یادگیری

- کمترین

- لینک

- زندگی

- بار

- خیلی

- کاهش

- دستگاه

- فراگیری ماشین

- باعث می شود

- مدیریت

- اداره می شود

- مدیر

- روش

- ممکن است..

- اندازه

- مکانیزم

- میلی ثانیه

- دقیقه

- دقیقه

- ML

- مدل

- مدل

- نظارت بر

- بیش

- چندگانه

- جدید

- nlp

- نه

- اکنون

- عدد

- of

- پیشنهادات

- غالبا

- on

- قابل استفاده

- بهینه سازی

- گزینه

- or

- سازمان های

- ما

- خارج

- خارج از منزل

- خارج از

- برجسته

- روی

- به طور کلی

- پارامتر

- ویژه

- احساساتی

- برای

- کارایی

- گیاهان

- افلاطون

- هوش داده افلاطون

- PlatoData

- سیاست

- ممکن

- پست

- در حال حاضر

- اصلی

- مشکلات

- محصول

- مدیر تولید

- تولید

- پرسیدن

- تصادفی

- اعم

- نسبتا

- زمان واقعی

- گرفتن

- توصیه

- کاهش

- مراجعه

- بدون در نظر گرفتن

- مربوط

- درخواست

- درخواست

- پاسخ

- پاسخ

- مسیر

- مسیریابی

- دویدن

- حکیم ساز

- مقیاس

- به دنبال

- انتخاب

- ارشد

- خدمت

- سرویس

- خدمات

- تنظیم

- محیط

- او

- نشان داد

- نشان داده شده

- نشان می دهد

- هوشمند

- نرم افزار

- توسعه نرم افزار

- مزایا

- تنش

- نوپا

- اقامت

- ساده

- استراتژی ها

- استراتژی

- چنین

- پشتیبانی

- پشتیبانی از

- سیستم های

- جدول

- مصرف

- صحبت

- تیم

- پیشرفته

- آزمون

- تست

- نسبت به

- که

- La

- محوطه

- شان

- آنجا.

- اینها

- این

- توان

- زمان

- به

- ترافیک

- سفر

- روند

- انواع

- کاربران

- با استفاده از

- ارزشها

- متغیر

- بسیار

- دید

- we

- وب

- خدمات وب

- خوب

- بود

- چه زمانی

- که

- در حین

- اراده

- با

- مهاجرت کاری

- مشغول به کار

- گردش کار

- کارگر

- با این نسخهها کار

- شما

- شما

- زفیرنت

- مناطق