معرفی

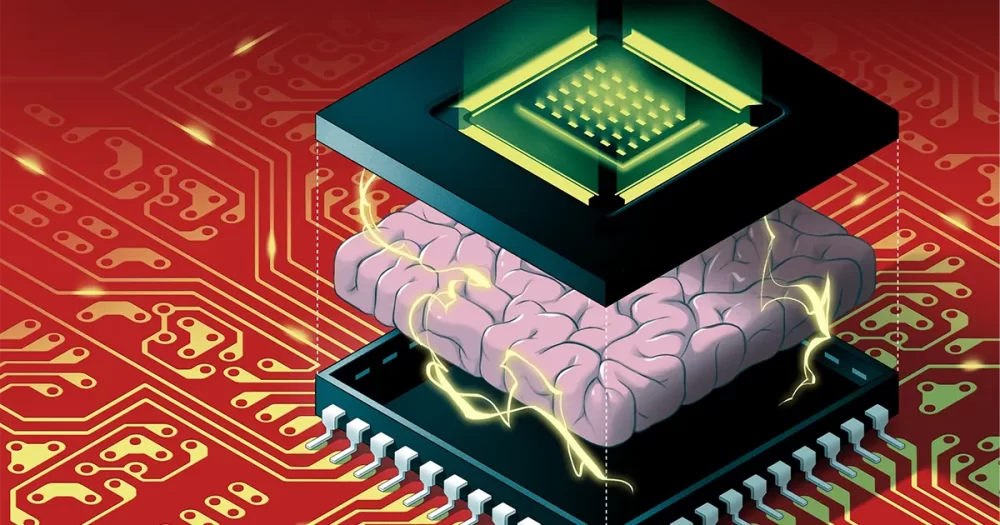

الگوریتم های هوش مصنوعی نمی توانند با سرعت فعلی خود به رشد خود ادامه دهند. الگوریتمهایی مانند شبکههای عصبی عمیق – که به طور ضعیفی از مغز الهام میگیرند، با چندین لایه از نورونهای مصنوعی که از طریق مقادیر عددی به نام وزن به یکدیگر متصل شدهاند، هر سال بزرگتر میشوند. اما این روزها، پیشرفتهای سختافزاری دیگر با حجم عظیم حافظه و ظرفیت پردازشی مورد نیاز برای اجرای این الگوریتمهای عظیم هماهنگ نیست. به زودی، اندازه الگوریتم های هوش مصنوعی ممکن است به دیوار برخورد کند.

و حتی اگر بتوانیم سختافزار را برای پاسخگویی به نیازهای هوش مصنوعی افزایش دهیم، مشکل دیگری وجود دارد: اجرای آنها بر روی رایانههای سنتی مقدار زیادی انرژی را هدر میدهد. انتشار کربن بالای تولید شده از اجرای الگوریتمهای بزرگ هوش مصنوعی در حال حاضر برای محیط زیست مضر است و با بزرگتر شدن الگوریتمها بدتر میشود.

یک راه حل به نام محاسبات نورومورفیک، از مغزهای بیولوژیکی الهام می گیرد تا طرح هایی با انرژی کارآمد ایجاد کند. متأسفانه، در حالی که این تراشه ها می توانند از رایانه های دیجیتال در صرفه جویی در انرژی پیشی بگیرند، آنها فاقد قدرت محاسباتی مورد نیاز برای اجرای یک شبکه عصبی عمیق قابل توجه هستند. نادیده گرفتن آنها برای محققان هوش مصنوعی آسان شده است.

سرانجام در ماه اوت تغییر کرد وایر وان, H.-S. فیلیپ وانگ, گرت کوونبرگس و همکارانشان یک تراشه نورومورفیک جدید را نشان داد NeuRRAM نام دارد که شامل 3 میلیون سلول حافظه و هزاران نورون است که در سخت افزار آن برای اجرای الگوریتم ها تعبیه شده است. از نوع نسبتا جدیدی از حافظه به نام رم مقاومتی یا RRAM استفاده می کند. برخلاف تراشههای RRAM قبلی، NeuRRAM طوری برنامهریزی شده است که به صورت آنالوگ کار کند تا انرژی و فضای بیشتری ذخیره کند. در حالی که حافظه دیجیتال باینری است - ذخیره سلول های حافظه آنالوگ 1 یا 0 در تراشه NeuRRAM هر کدام می توانند چندین مقدار را در یک محدوده کاملاً پیوسته ذخیره کنند. این به تراشه اجازه می دهد تا اطلاعات بیشتری را از الگوریتم های عظیم هوش مصنوعی در همان مقدار فضای تراشه ذخیره کند.

در نتیجه، تراشه جدید میتواند به خوبی رایانههای دیجیتال در وظایف پیچیده هوش مصنوعی مانند تشخیص تصویر و گفتار عمل کند و نویسندگان ادعا میکنند که تا ۱۰۰۰ برابر انرژی کارآمدتر است و این امکان را برای تراشههای کوچک برای اجرای الگوریتمهای پیچیدهتر فراهم میکند. در دستگاههای کوچکی که قبلاً برای هوش مصنوعی مانند ساعتهای هوشمند و تلفنها نامناسب بودند.

محققانی که در این کار شرکت نکردهاند، عمیقاً تحت تأثیر نتایج قرار گرفتهاند. گفت: "این مقاله بسیار منحصر به فرد است." ژونگروی وانگ، محقق قدیمی RRAM در دانشگاه هنگ کنگ. در سطوح مختلف - در سطح دستگاه، در سطح معماری مدار، و در سطح الگوریتم مشارکت دارد.

ایجاد خاطرات جدید

در رایانههای دیجیتال، هدر رفتن مقادیر زیادی انرژی در حین اجرای الگوریتمهای هوش مصنوعی ناشی از یک نقص طراحی ساده و فراگیر است که هر محاسباتی را ناکارآمد میکند. به طور معمول، حافظه رایانه - که داده ها و مقادیر عددی را در حین محاسبه خرد می کند - در مادربرد دور از پردازنده، جایی که محاسبات انجام می شود، قرار می گیرد.

وان، دانشمند کامپیوتر سابقاً در دانشگاه استنفورد که اخیراً به استارتآپ هوش مصنوعی Aizip نقل مکان کرده است، میگوید: برای اطلاعاتی که از طریق پردازنده در جریان است، «مثل این است که شما هشت ساعت را در رفت و آمد میگذرانید، اما دو ساعت کار میکنید.

معرفی

رفع این مشکل با تراشه های همه کاره جدید که حافظه و محاسبات را در یک مکان قرار می دهند، ساده به نظر می رسد. همچنین به نحوه پردازش اطلاعات مغز ما نزدیکتر است، زیرا بسیاری از عصبشناسان معتقدند که محاسبات درون جمعیتهای نورونها اتفاق میافتد، در حالی که خاطرات زمانی شکل میگیرند که سیناپسهای بین نورونها اتصالات آنها را تقویت یا ضعیف میکنند. اما ایجاد چنین دستگاههایی دشوار است، زیرا اشکال فعلی حافظه با فناوری پردازندهها ناسازگار است.

دانشمندان علوم کامپیوتر چندین دهه پیش موادی را برای ایجاد تراشههای جدید توسعه دادند که محاسبات را در جایی که حافظه ذخیره میشود انجام میدهند - فناوری به نام محاسبه در حافظه. اما با عملکرد بسیار خوب رایانه های دیجیتال سنتی، این ایده ها برای دهه ها نادیده گرفته شد.

وانگ، استاد دانشگاه استنفورد، گفت: «این کار، درست مانند بسیاری از کارهای علمی، به نوعی فراموش شده بود.

در واقع، اولین چنین دستگاهی حداقل به سال 1964 برمی گردد، زمانی که مهندسان برق در استنفورد کشف کردند که می توانند مواد خاصی به نام اکسیدهای فلزی را دستکاری کنند تا توانایی آنها برای هدایت الکتریسیته روشن و خاموش شود. این مهم است زیرا توانایی یک ماده برای تغییر بین دو حالت، ستون فقرات ذخیره سازی حافظه سنتی را فراهم می کند. به طور معمول، در حافظه دیجیتال، حالت ولتاژ بالا با 1 و ولتاژ پایین با 0 مطابقت دارد.

برای اینکه یک دستگاه RRAM حالتها را تغییر دهد، ولتاژی را روی الکترودهای فلزی که به دو سر اکسید فلز متصل هستند اعمال میکنید. به طور معمول، اکسیدهای فلزی عایق هستند، به این معنی که آنها الکتریسیته را هدایت نمی کنند. اما با ولتاژ کافی، جریان افزایش می یابد و در نهایت از نقاط ضعیف ماده عبور می کند و مسیری را به سمت الکترود در سمت دیگر ایجاد می کند. هنگامی که جریان عبور کرد، می تواند آزادانه در آن مسیر جریان یابد.

وونگ این فرآیند را به رعد و برق تشبیه می کند: وقتی بار کافی در یک ابر جمع می شود، به سرعت مسیری با مقاومت کم پیدا می کند و رعد و برق به آن برخورد می کند. اما بر خلاف رعد و برق که مسیر آن ناپدید می شود، مسیر عبور از اکسید فلز باقی می ماند، به این معنی که به طور نامحدود رسانا می ماند. و این امکان وجود دارد که مسیر رسانا را با اعمال ولتاژ دیگری به ماده پاک کنید. بنابراین محققان می توانند یک RRAM را بین دو حالت تغییر دهند و از آنها برای ذخیره حافظه دیجیتال استفاده کنند.

محققان قرن میانی پتانسیل محاسبات با انرژی کارآمد را تشخیص ندادند و با الگوریتمهای کوچکتری که با آن کار میکردند به آن نیاز نداشتند. تا اوایل دهه 2000، با کشف اکسیدهای فلزی جدید، محققان به این احتمالات پی بردند.

وونگ که در آن زمان در IBM کار میکرد، به یاد میآورد که یکی از همکاران برنده جایزه که روی RRAM کار میکرد اعتراف کرد که فیزیک را کاملاً درک نکرده است. وونگ به یاد میآورد: «اگر او آن را درک نمیکند، شاید من نباید سعی کنم آن را بفهمم.»

اما در سال 2004، محققان سامسونگ الکترونیکس اعلام کردند که این کار را انجام داده اند حافظه RRAM با موفقیت یکپارچه شد ساخته شده بر روی یک تراشه محاسباتی سنتی، نشان می دهد که یک تراشه محاسباتی در حافظه ممکن است در نهایت امکان پذیر شود. وونگ تصمیم گرفت حداقل تلاش کند.

تراشه های محاسباتی در حافظه برای هوش مصنوعی

برای بیش از یک دهه، محققانی مانند Wong برای ایجاد فناوری RRAM تا حدی کار کردند که بتواند به طور قابل اعتماد وظایف محاسباتی پرقدرت را انجام دهد. در حدود سال 2015، دانشمندان کامپیوتر شروع به شناسایی پتانسیل عظیم این دستگاههای کم مصرف برای الگوریتمهای بزرگ هوش مصنوعی کردند، که در حال رشد بودند. در آن سال، دانشمندان دانشگاه کالیفرنیا، سانتا باربارا نشان داد که دستگاه های RRAM می توانند بیشتر از صرفاً حافظه را به روشی جدید ذخیره کنند. آنها می توانند وظایف محاسباتی اساسی را خودشان انجام دهند - از جمله اکثر محاسباتی که در نورون های مصنوعی شبکه عصبی انجام می شود، که وظایف ضرب ماتریس ساده ای هستند.

در تراشه NeuRRAM، نورونهای سیلیکونی در سختافزار تعبیه شدهاند و سلولهای حافظه RRAM وزنها را ذخیره میکنند - مقادیری که قدرت اتصالات بین نورونها را نشان میدهند. و از آنجایی که سلولهای حافظه NeuRRAM آنالوگ هستند، وزنهایی که ذخیره میکنند نشاندهنده طیف کامل حالتهای مقاومتی است که هنگام تغییر دستگاه بین حالت مقاومت کم به حالت مقاومت بالا رخ میدهد. این امر حتی بازده انرژی بالاتری را نسبت به حافظه RRAM دیجیتالی که میتواند به دست آورد را ممکن میسازد، زیرا تراشه میتواند بسیاری از محاسبات ماتریس را به صورت موازی انجام دهد - به جای اینکه مانند نسخههای پردازش دیجیتال، به صورت قفلی یکی پس از دیگری انجام شود.

اما از آنجایی که پردازش آنالوگ هنوز چندین دهه از پردازش دیجیتال عقب است، هنوز مشکلات زیادی وجود دارد که باید برطرف شود. یکی این است که تراشه های RRAM آنالوگ باید به طور غیرعادی دقیق باشند زیرا نقص در تراشه فیزیکی می تواند باعث تغییر و نویز شود. (برای تراشههای سنتی، با تنها دو حالت، این عیوب تقریباً چندان مهم نیستند.) این امر اجرای الگوریتمهای هوش مصنوعی را برای دستگاههای RRAM آنالوگ بهطور قابلتوجهی سختتر میکند، با توجه به اینکه دقت، مثلاً، تشخیص یک تصویر در صورتی که وضعیت رسانایی دستگاه RRAM در هر زمان دقیقاً یکسان نیست.

وونگ گفت: "وقتی به یک مسیر روشنایی نگاه می کنیم، هر بار متفاوت است." "بنابراین در نتیجه، RRAM درجه خاصی از تصادفی را نشان می دهد - هر بار که آنها را برنامه ریزی می کنید کمی متفاوت است." وونگ و همکارانش ثابت کردند که دستگاههای RRAM میتوانند وزنهای پیوسته هوش مصنوعی را ذخیره کنند و همچنان به دقت رایانههای دیجیتالی باشند، اگر الگوریتمها برای عادت به نویز روی تراشه آموزش داده شوند، پیشرفتی که آنها را قادر به تولید تراشه NeuRRAM کرد.

معرفی

مشکل اصلی دیگری که آنها باید حل میکردند، انعطافپذیری لازم برای پشتیبانی از شبکههای عصبی متنوع بود. در گذشته، طراحان تراشه مجبور بودند دستگاههای RRAM کوچک را در یک ناحیه در کنار نورونهای سیلیکونی بزرگتر ردیف کنند. دستگاههای RRAM و نورونها بدون قابلیت برنامهریزی با سیم سخت متصل بودند، بنابراین محاسبات فقط در یک جهت انجام میشد. برای پشتیبانی از شبکههای عصبی با محاسبات دو طرفه، سیمها و مدارهای اضافی لازم بود که نیاز به انرژی و فضا را افزایش میداد.

بنابراین تیم Wong یک معماری تراشه جدید طراحی کرد که در آن دستگاه های حافظه RRAM و نورون های سیلیکونی با هم مخلوط می شدند. این تغییر کوچک در طراحی باعث کاهش کل مساحت و صرفه جویی در مصرف انرژی شد.

گفت: "من فکر می کردم [این تنظیم] واقعا زیبا بود." ملیکا پیوند، یک محقق نورومورفیک در موسسه فدرال فناوری سوئیس زوریخ. "من قطعا آن را یک کار پیشگامانه می دانم."

برای چندین سال، تیم Wong با همکاران برای طراحی، ساخت، آزمایش، کالیبره و اجرای الگوریتمهای AI بر روی تراشه NeuRRAM کار کرد. آنها استفاده از انواع دیگر حافظه های نوظهور را در نظر گرفتند که می توانند در تراشه های محاسباتی در حافظه نیز استفاده شوند، اما RRAM به دلیل مزایای آن در برنامه نویسی آنالوگ و به دلیل اینکه ادغام با مواد محاسباتی سنتی نسبتاً آسان بود، برتری داشت.

نتایج اخیر آنها نشاندهنده اولین تراشه RRAM است که میتواند چنین الگوریتمهای هوش مصنوعی بزرگ و پیچیدهای را اجرا کند - شاهکاری که قبلاً فقط در شبیهسازیهای نظری امکانپذیر بود. گفت: "وقتی صحبت از سیلیکون واقعی می شود، این قابلیت وجود نداشت." آنوپ داس، دانشمند کامپیوتر در دانشگاه درکسل. "این کار اولین نمایش است."

Cauwenberghs گفت: «سیستمهای هوش مصنوعی دیجیتال انعطافپذیر و دقیق هستند، اما درجهای از کارایی کمتری دارند. اکنون، Cauwenberghs گفت، تراشه آنالوگ RRAM انعطافپذیر، دقیق و کم مصرف آنها «برای اولین بار شکاف را پر کرده است».

افزایش مقیاس

طراحی تیم، تراشه NeuRRAM را کوچک نگه میدارد - فقط به اندازه یک ناخن - در حالی که 3 میلیون دستگاه حافظه RRAM را فشرده میکند که میتوانند به عنوان پردازنده آنالوگ عمل کنند. و در حالی که می تواند شبکه های عصبی را حداقل به خوبی کامپیوترهای دیجیتال اجرا کند، تراشه همچنین (و برای اولین بار) می تواند الگوریتم هایی را اجرا کند که محاسبات را در جهات مختلف انجام می دهند. تراشه آنها میتواند ولتاژی را به ردیفهای آرایه RRAM وارد کند و خروجیها را از ستونها بخواند، همانطور که برای تراشههای RRAM استاندارد است، اما همچنین میتواند این کار را از ستونها به ردیفها به عقب انجام دهد، بنابراین میتوان از آن در شبکههای عصبی که کار میکنند استفاده کرد. با داده هایی که در جهات مختلف جریان دارند.

مانند خود فناوری RRAM، این مدت طولانی امکان پذیر بوده است، اما هیچ کس فکر نمی کند این کار را انجام دهد. "چرا قبلاً به این موضوع فکر نکردیم؟" پیوند پرسید. "در گذشته، من نمی دانم."

داس گفت: "این در واقع فرصت های زیادی را باز می کند." به عنوان مثال، او توانایی یک سیستم ساده برای اجرای الگوریتم های عظیم مورد نیاز برای شبیه سازی های فیزیک چند بعدی یا اتومبیل های خودران را ذکر کرد.

با این حال اندازه یک مسئله است. اکنون بزرگترین شبکه های عصبی حاوی میلیاردها وزن هستند، نه میلیون ها وزن موجود در تراشه های جدید. Wong قصد دارد با قرار دادن چندین تراشه NeuRRAM روی هم، مقیاس را افزایش دهد.

پایین نگه داشتن هزینه های انرژی در دستگاه های آینده یا کاهش بیشتر آنها به همان اندازه مهم خواهد بود. یکی از راه های رسیدن به آنجا این است کپی کردن مغز حتی با دقت بیشتری از سیگنال ارتباطی مورد استفاده بین نورون های واقعی استفاده می کند: سنبله الکتریکی. این سیگنالی است که زمانی که اختلاف ولتاژ بین داخل و خارج سلول به یک آستانه بحرانی می رسد، از یک نورون به نورون دیگر شلیک می شود.

گفت: «چالشهای بزرگی در آنجا وجود دارد تونی کنیونمحقق نانوتکنولوژی در دانشگاه کالج لندن. "اما ما هنوز هم ممکن است بخواهیم در این جهت حرکت کنیم، زیرا ... اگر از میخ های بسیار پراکنده استفاده می کنید، به احتمال زیاد بازده انرژی بیشتری خواهید داشت." کنیون خاطرنشان کرد، برای اجرای الگوریتمهایی که روی تراشه NeuRRAM فعلی افزایش مییابند، احتمالاً به معماری کاملاً متفاوتی نیاز است.

در حال حاضر، کارایی انرژی که این تیم هنگام اجرای الگوریتمهای هوش مصنوعی بزرگ روی تراشه NeuRRAM به دست آورد، امید جدیدی ایجاد کرده است که فناوریهای حافظه ممکن است آینده محاسباتی با هوش مصنوعی را نشان دهند. شاید روزی ما حتی بتوانیم 86 میلیارد نورون مغز انسان و تریلیون ها سیناپسی که آنها را بدون تمام شدن توانشان به هم متصل می کنند، مطابقت دهیم.