این پست شما را با رایجترین چالشهایی که مشتریان هنگام جستجوی اسناد داخلی با آن مواجه میشوند، راهنمایی میکند و راهنماییهای دقیقی را در مورد نحوه استفاده از خدمات AWS برای ایجاد یک ربات مکالمه هوش مصنوعی که اطلاعات داخلی را مفیدتر میکند، به شما ارائه میدهد.

داده های بدون ساختار 80 درصد از کل داده ها را تشکیل می دهند موجود در سازمانها، متشکل از مخازن کتابچههای راهنما، فایلهای PDF، پرسشهای متداول، ایمیلها و سایر اسناد که هر روز افزایش مییابد. امروزه کسبوکارها بر مخازن اطلاعات داخلی در حال رشد مستمر تکیه میکنند و مشکلات زمانی به وجود میآیند که حجم دادههای ساختاریافته غیرقابل مدیریت شود. اغلب، کاربران در حال مطالعه و بررسی بسیاری از منابع داخلی مختلف برای یافتن پاسخ های مورد نیاز خود هستند.

انجمنهای پرسش و پاسخ داخلی میتوانند به کاربران در دریافت پاسخهای بسیار خاص کمک کنند، اما به زمان انتظار طولانیتری نیز نیاز دارند. در مورد سؤالات متداول داخلی خاص شرکت، زمان انتظار طولانی منجر به کاهش بهره وری کارکنان می شود. تالارهای پرسش و پاسخ به دلیل تکیه بر پاسخ های نوشته شده دستی به سختی قابل مقیاس هستند. با هوش مصنوعی مولد، در حال حاضر یک تغییر پارادایم در نحوه جستجو و یافتن اطلاعات توسط کاربران وجود دارد. گام منطقی بعدی استفاده از هوش مصنوعی مولد برای متراکم کردن اسناد بزرگ به اطلاعات با اندازه کوچکتر برای مصرف آسان تر کاربر است. به جای صرف زمان طولانی برای خواندن متن یا انتظار برای پاسخ، کاربران میتوانند خلاصههایی را در زمان واقعی بر اساس چندین مخزن اطلاعات داخلی موجود تولید کنند.

بررسی اجمالی راه حل

این راه حل به مشتریان اجازه می دهد تا با استفاده از یک مدل ترانسفورماتور، پاسخ های منتخب به سؤالات پرسیده شده در مورد اسناد داخلی را برای ایجاد پاسخ به سؤالات مربوط به داده هایی که در مورد آنها آموزش ندیده اند، بازیابی کنند، تکنیکی که به عنوان اعلان ضربه صفر شناخته می شود. با اتخاذ این راه حل، مشتریان می توانند از مزایای زیر بهره مند شوند:

- بر اساس منابع موجود اسناد داخلی، پاسخ دقیق به سوالات را بیابید

- با استفاده از مدلهای زبان بزرگ (LLM) برای ارائه پاسخهای تقریباً فوری به سؤالات پیچیده با استفاده از اسنادی با بهروزترین اطلاعات، زمانی را که کاربران صرف جستجوی پاسخها میکنند، کاهش دهید.

- سوالات پاسخ داده شده قبلی را از طریق داشبورد متمرکز جستجو کنید

- استرس ناشی از صرف زمان برای خواندن دستی اطلاعات برای جستجوی پاسخ را کاهش دهید

بازیابی نسل افزوده (RAG)

Retrieval Augmented Generation (RAG) با یافتن پاسخ ها از پایگاه دانش شما و استفاده از LLM برای خلاصه کردن اسناد در پاسخ های مختصر، برخی از کاستی های پرس و جوهای مبتنی بر LLM را کاهش می دهد. لطفا این را بخوان پست برای یادگیری نحوه پیاده سازی رویکرد RAG با آمازون کندرا. خطرات و محدودیت های زیر با پرس و جوهای مبتنی بر LLM مرتبط است که رویکرد RAG با آمازون کندرا به آنها رسیدگی می کند:

- توهمات و قابلیت ردیابی - LLMS بر روی مجموعه داده های بزرگ آموزش داده می شود و پاسخ هایی را در مورد احتمالات ایجاد می کند. این می تواند منجر به پاسخ های نادرست شود که به عنوان توهم شناخته می شوند.

- سیلوهای چندگانه داده – برای ارجاع دادهها از منابع متعدد در پاسخ شما، باید یک اکوسیستم رابط را برای جمعآوری دادهها راهاندازی کنید. دسترسی به چندین مخزن دستی و زمان بر است.

- امنیت – هنگام استقرار رباتهای مکالمه با RAG و LLM، امنیت و حریم خصوصی ملاحظات مهمی هستند. با وجود استفاده درک آمازون برای فیلتر کردن دادههای شخصی که ممکن است از طریق درخواستهای کاربر ارائه شود، بسته به دادههای دریافت شده، احتمال نمایش ناخواسته اطلاعات شخصی یا حساس وجود دارد. این بدان معناست که کنترل دسترسی به چت بات برای جلوگیری از دسترسی ناخواسته به اطلاعات حساس بسیار مهم است.

- ارتباط داده ها - LLMS بر روی داده ها تا تاریخ خاصی آموزش داده شده است، به این معنی که اطلاعات اغلب جاری نیستند. هزینه مربوط به مدل های آموزشی در داده های اخیر بالا است. برای اطمینان از پاسخهای دقیق و بهروز، سازمانها مسئولیت بهروزرسانی منظم و غنیسازی محتوای اسناد نمایهشده را دارند.

- هزینه - هزینه های مربوط به استقرار این راه حل باید برای مشاغل مورد توجه قرار گیرد. هنگام اجرای این راه حل، کسب و کارها باید بودجه و عملکرد مورد نیاز خود را به دقت ارزیابی کنند. اجرای LLM می تواند به منابع محاسباتی قابل توجهی نیاز داشته باشد که ممکن است هزینه های عملیاتی را افزایش دهد. این هزینهها میتواند به محدودیتی برای برنامههایی تبدیل شود که نیاز به کار در مقیاس بزرگ دارند. با این حال، یکی از مزایای AWS ابر این انعطاف پذیری است که فقط برای آنچه استفاده می کنید پرداخت کنید. AWS یک مدل قیمتگذاری ساده، ثابت و قابل پرداخت ارائه میکند، بنابراین فقط برای منابعی که مصرف میکنید هزینه دریافت میکنید.

استفاده از Amazon SageMaker JumpStart

برای مدلهای زبان مبتنی بر ترانسفورماتور، سازمانها میتوانند از استفاده سود ببرند آمازون SageMaker JumpStart که مجموعه ای از مدل های یادگیری ماشینی از پیش ساخته شده را ارائه می دهد. Amazon SageMaker JumpStart طیف گستردهای از مدلهای اساسی تولید متن و پاسخگویی به سؤال (Q&A) را ارائه میکند که میتوان آنها را به راحتی اجرا و استفاده کرد. این راه حل یک مدل FLAN T5-XL Amazon SageMaker JumpStart را ادغام می کند، اما جنبه های مختلفی وجود دارد که باید در نظر داشته باشید. انتخاب مدل فونداسیون.

ادغام امنیت در گردش کار ما

پیروی از بهترین شیوه های ستون امنیتی از چارچوب خوش معماری, Cognito آمازون برای احراز هویت استفاده می شود. آمازون Cognito User Pools را می توان با ارائه دهندگان هویت شخص ثالث که از چندین چارچوب مورد استفاده برای کنترل دسترسی پشتیبانی می کنند، از جمله Open Authorization (OAuth)، OpenID Connect (OIDC)، یا Security Assertion Markup Language (SAML) ادغام کرد. شناسایی کاربران و اقدامات آنها به راه حل اجازه می دهد تا قابلیت ردیابی را حفظ کند. راه حل نیز از شناسایی اطلاعات شناسایی شخصی (PII) Amazon Comprehend قابلیت شناسایی خودکار و ویرایش PII. PII ویرایش شده شامل آدرسها، شمارههای تامین اجتماعی، آدرسهای ایمیل و سایر اطلاعات حساس است. این طراحی تضمین می کند که هر PII ارائه شده توسط کاربر از طریق پرس و جو ورودی، ویرایش می شود. PII ذخیره نمی شود، توسط Amazon Kendra استفاده نمی شود، یا به LLM تغذیه نمی شود.

راه حل

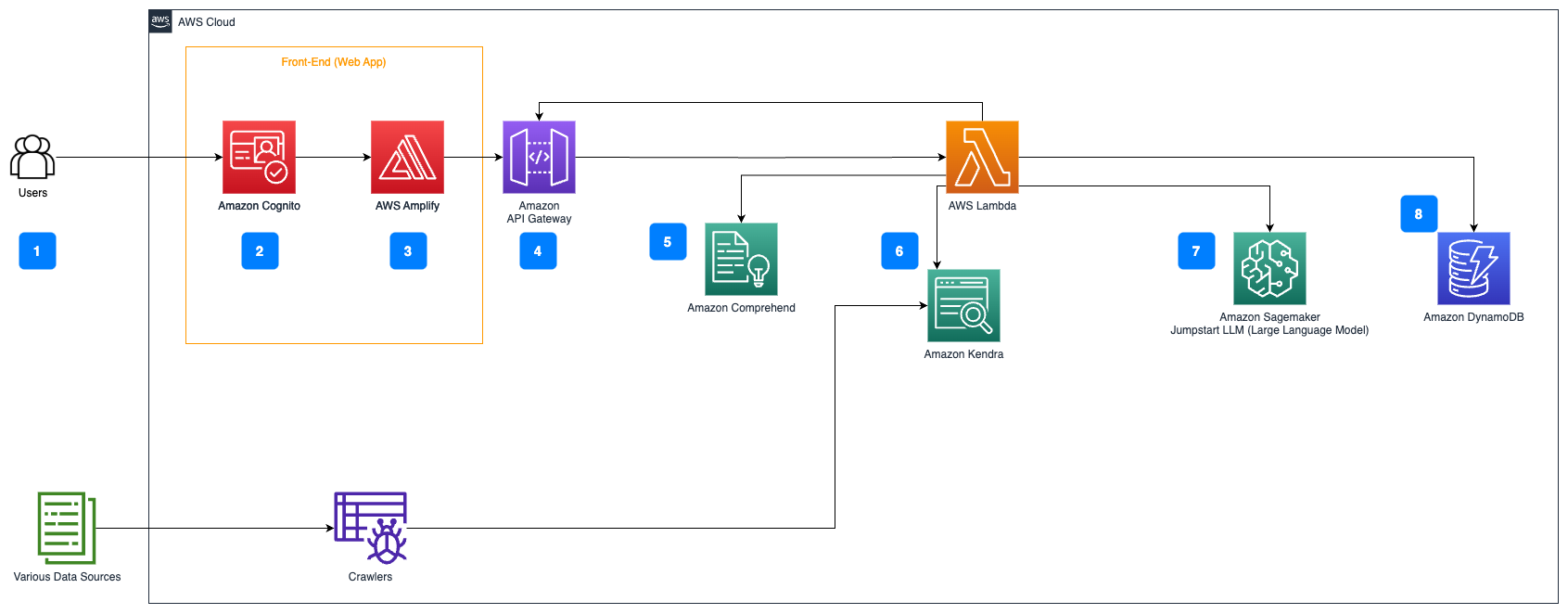

مراحل زیر گردش کار پاسخ به سؤال را در جریان اسناد شرح می دهد:

- کاربران درخواستی را از طریق یک رابط وب ارسال می کنند.

- Cognito آمازون برای احراز هویت، اطمینان از دسترسی ایمن به برنامه وب استفاده می شود.

- جلوی برنامه وب روی میزبانی می شود AWS تقویت کنید.

- دروازه API آمازون میزبان یک REST API با نقاط پایانی مختلف برای رسیدگی به درخواستهای کاربر که با استفاده از Amazon Cognito احراز هویت میشوند.

- ویرایش PII با درک آمازون:

- پردازش پرس و جو کاربر: زمانی که کاربر یک درخواست یا ورودی ارسال می کند، ابتدا از Amazon Comprehend ارسال می شود. این سرویس متن را تجزیه و تحلیل می کند و هر موجودیت PII موجود در پرس و جو را شناسایی می کند.

- استخراج PII: آمازون Comprehend موجودیت های PII شناسایی شده را از درخواست کاربر استخراج می کند.

- بازیابی اطلاعات مربوطه با آمازون کندرا:

- آمازون کندرا برای مدیریت فهرستی از اسناد استفاده می شود که حاوی اطلاعاتی است که برای ایجاد پاسخ به سؤالات کاربر استفاده می شود.

- La بازیابی QA LangChain ماژول برای ساخت یک زنجیره مکالمه استفاده می شود که اطلاعات مربوط به درخواست های کاربر را دارد.

- ادغام با Amazon SageMaker JumpStart:

- تابع AWS Lambda از کتابخانه LangChain استفاده می کند و با یک پرس و جو پر از زمینه به نقطه پایانی Amazon SageMaker JumpStart متصل می شود. نقطه پایانی Amazon SageMaker JumpStart به عنوان رابط LLM مورد استفاده برای استنتاج عمل می کند.

- ذخیره پاسخ ها و برگرداندن آن به کاربر:

- پاسخ از LLM در ذخیره می شود آمازون DynamoDB به همراه پرس و جو کاربر، مهر زمانی، یک شناسه منحصر به فرد، و سایر شناسه های دلخواه برای مورد مانند دسته سوال. ذخیره پرسش و پاسخ به عنوان آیتم های مجزا به عملکرد AWS Lambda اجازه می دهد تا به راحتی تاریخچه مکالمه کاربر را بر اساس زمان پرسیده شدن سؤالات بازسازی کند.

- در نهایت، پاسخ از طریق یک درخواست HTTP از طریق پاسخ ادغام API API Gateway REST به کاربر ارسال می شود.

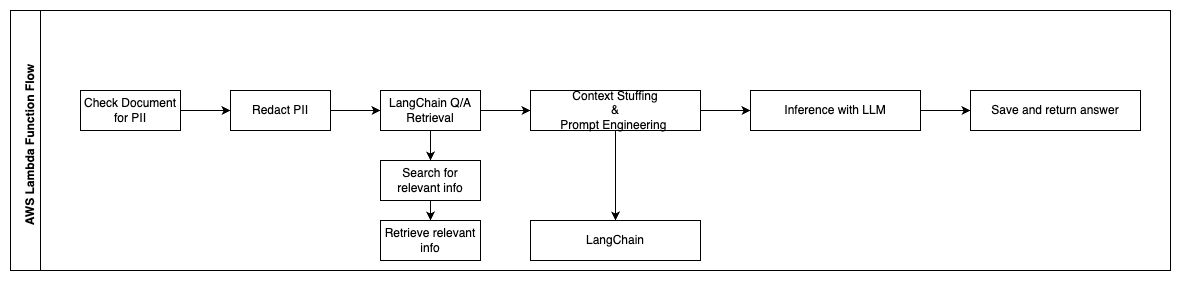

مراحل زیر توابع AWS Lambda و جریان آنها را در فرآیند توصیف می کند:

- هر PII / اطلاعات حساس را بررسی و ویرایش کنید

- زنجیره بازیابی QA LangChain

- جستجو و بازیابی اطلاعات مربوطه

- Context Stuffing & Prompt Engineering

- استنباط با LLM

- پاسخ را برگردانید و آن را ذخیره کنید

موارد استفاده

موارد استفاده تجاری زیادی وجود دارد که مشتریان می توانند از این گردش کار استفاده کنند. بخش زیر نحوه استفاده از گردش کار را در صنایع مختلف و عمودی توضیح می دهد.

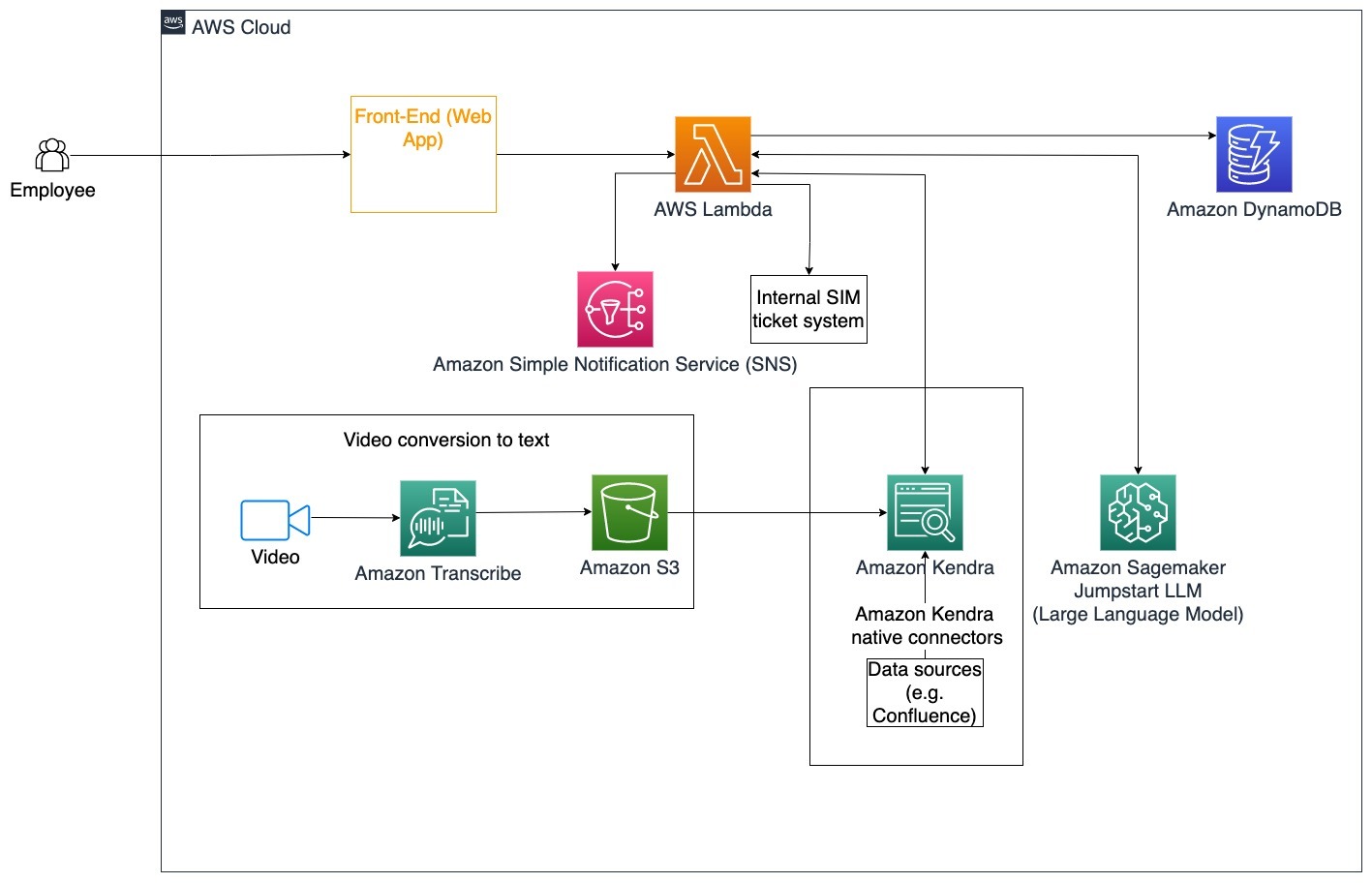

کمک به کارکنان

آموزش سازمانی با طراحی خوب می تواند رضایت کارکنان را بهبود بخشد و زمان لازم برای جذب کارکنان جدید را کاهش دهد. با رشد سازمان ها و افزایش پیچیدگی، درک بسیاری از منابع اسناد داخلی برای کارکنان دشوار است. اسناد داخلی در این زمینه شامل دستورالعملهای شرکت، سیاستها و رویههای عملیاتی استاندارد است. برای این سناریو، یک کارمند در مورد چگونگی ادامه و ویرایش بلیط داخلی صدور بلیط سوال دارد. کارمند می تواند به ربات مکالمه هوش مصنوعی (AI) دسترسی داشته باشد و از آن برای درخواست و اجرای مراحل بعدی برای یک بلیط خاص استفاده کند.

مورد استفاده خاص: حل مشکلات را برای کارکنان بر اساس دستورالعمل های شرکت به صورت خودکار انجام دهید.

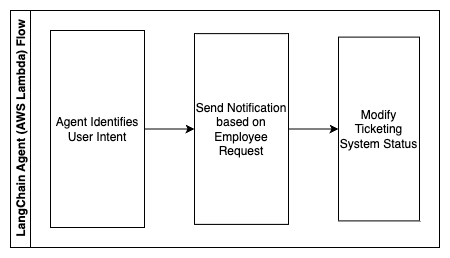

مراحل زیر توابع AWS Lambda و جریان آنها را در فرآیند توصیف می کند:

- عامل LangChain برای شناسایی هدف

- ارسال اعلان بر اساس درخواست کارمند

- تغییر وضعیت بلیط

در این نمودار معماری، فیلم های آموزشی شرکتی را می توان از طریق دریافت کرد آمازون رونوشت برای جمع آوری گزارشی از این اسکریپت های ویدئویی. علاوه بر این، محتوای آموزشی شرکتی ذخیره شده در منابع مختلف (به عنوان مثال، Confluence، Microsoft SharePoint، Google Drive، Jira، و غیره) را می توان برای ایجاد فهرست از طریق اتصال دهنده های Amazon Kendra استفاده کرد. برای آشنایی بیشتر با مجموعه بومی این مقاله را بخوانید اتصال دهنده ها شما می توانید در آمازون کندرا به عنوان یک منبع استفاده کنید. خزنده آمازون Kendra سپس میتواند از اسکریپتهای ویدیوی آموزشی شرکتی و اسناد ذخیرهشده در این منابع دیگر برای کمک به ربات مکالمه در پاسخ به سؤالات خاص دستورالعملهای آموزشی شرکت استفاده کند. عامل LangChain مجوزها را تأیید می کند، وضعیت بلیط را تغییر می دهد و افراد صحیح را با استفاده از سرویس اطلاع رسانی ساده آمازون مطلع می کند (آمازون SNS).

تیم های پشتیبانی مشتری

حل سریع سوالات مشتری تجربه مشتری را بهبود می بخشد و وفاداری به برند را تشویق می کند. پایگاه مشتری وفادار به افزایش فروش کمک می کند، که به نتیجه نهایی کمک می کند و تعامل مشتری را افزایش می دهد. تیمهای پشتیبانی مشتری انرژی زیادی را صرف ارجاع به بسیاری از اسناد داخلی و نرمافزار مدیریت ارتباط با مشتری میکنند تا به سؤالات مشتری در مورد محصولات و خدمات پاسخ دهند. اسناد داخلی در این زمینه میتواند شامل اسکریپتهای تماس عمومی پشتیبانی مشتری، کتابهای راهنما، دستورالعملهای تشدید و اطلاعات تجاری باشد. ربات محاوره ای مولد هوش مصنوعی به بهینه سازی هزینه کمک می کند زیرا از طرف تیم پشتیبانی مشتری پرس و جوها را بررسی می کند.

مورد استفاده خاص: رسیدگی به درخواست تعویض روغن بر اساس سابقه خدمات و طرح خدمات مشتری خریداری شده.

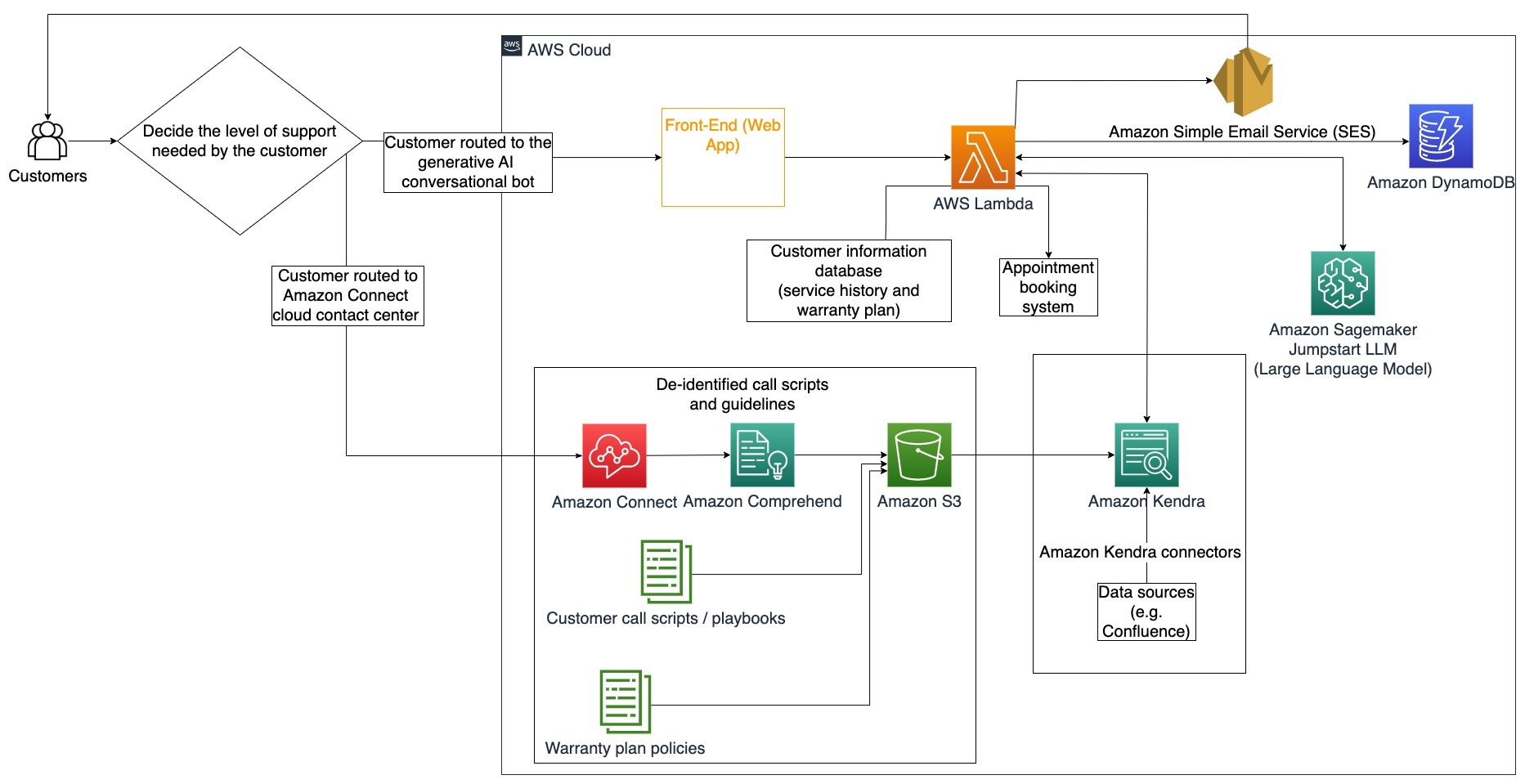

در این نمودار معماری، مشتری به ربات مکالمه هوش مصنوعی یا ربات محاوره ای مولد هدایت می شود آمازون اتصال مرکز تماس. این تصمیم می تواند بر اساس سطح پشتیبانی مورد نیاز یا در دسترس بودن عوامل پشتیبانی مشتری باشد. عامل LangChain قصد مشتری را شناسایی می کند و هویت را تأیید می کند. نماینده LangChain همچنین سابقه خدمات و طرح پشتیبانی خریداری شده را بررسی می کند.

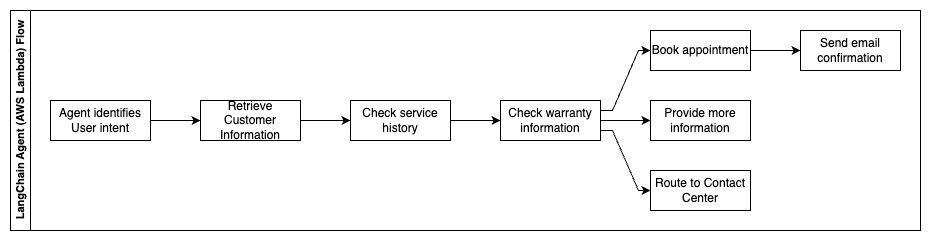

مراحل زیر توابع AWS Lambda و جریان آنها را در فرآیند توصیف می کند:

- عامل LangChain قصد را شناسایی می کند

- بازیابی اطلاعات مشتری

- تاریخچه خدمات مشتری و اطلاعات گارانتی را بررسی کنید

- قرار ملاقات رزرو کنید، اطلاعات بیشتر ارائه دهید یا مسیر رسیدن به مرکز تماس را بگیرید

- ارسال ایمیل تایید

آمازون کانکت برای جمعآوری گزارشهای صوتی و چت و Amazon Comprehend برای حذف اطلاعات شناسایی شخصی (PII) از این گزارشها استفاده میشود. خزنده آمازون Kendra سپس میتواند از گزارشهای صوتی و چت ویرایششده، اسکریپتهای تماس مشتری و خطمشیهای طرح پشتیبانی خدمات مشتری برای ایجاد فهرست استفاده کند. پس از تصمیم گیری، ربات مکالمه هوش مصنوعی مولد تصمیم می گیرد که آیا یک قرار رزرو کند، اطلاعات بیشتری ارائه دهد یا مشتری را برای کمک بیشتر به مرکز تماس هدایت کند. برای بهینهسازی هزینه، عامل LangChain همچنین میتواند با استفاده از توکنهای کمتر و یک مدل زبان بزرگ کمهزینه برای درخواستهای مشتری با اولویت پایینتر، پاسخهایی تولید کند.

خدمات مالی

شرکت های خدمات مالی برای رقابتی ماندن و رعایت مقررات مالی بر استفاده به موقع از اطلاعات متکی هستند. با استفاده از یک ربات مکالمه هوش مصنوعی مولد، تحلیلگران و مشاوران مالی می توانند با اطلاعات متنی به صورت مکالمه تعامل داشته باشند و زمان و تلاش لازم برای تصمیم گیری آگاهانه بهتر را کاهش دهند. خارج از سرمایه گذاری و تحقیقات بازار، یک ربات مکالمه هوش مصنوعی مولد همچنین می تواند با انجام وظایفی که به طور سنتی به تلاش و زمان بیشتری نیاز دارد، توانایی های انسان را افزایش دهد. به عنوان مثال، یک موسسه مالی متخصص در وام های شخصی می تواند نرخ پردازش وام ها را افزایش دهد و در عین حال شفافیت بهتری را برای مشتریان فراهم کند.

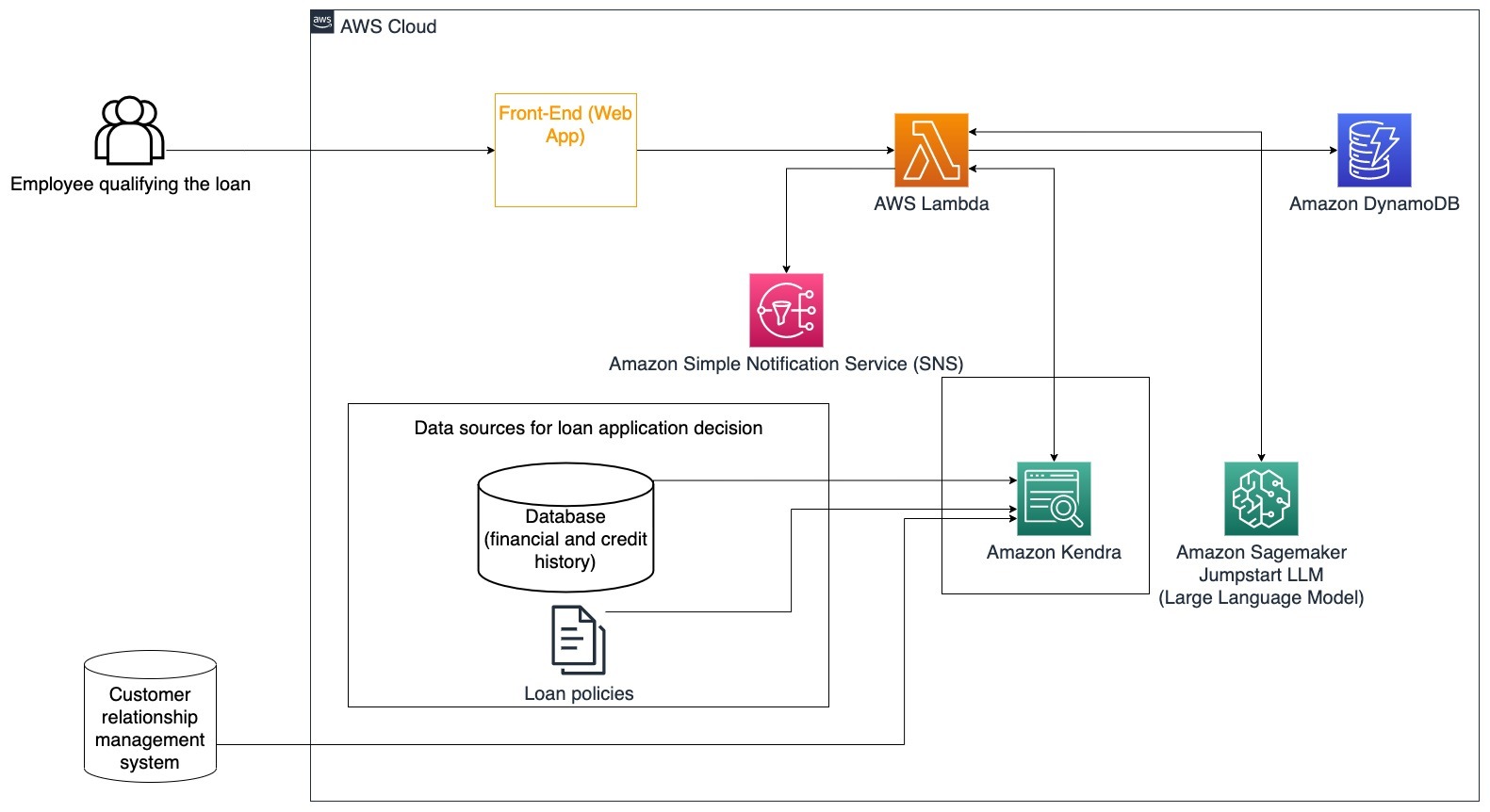

مورد استفاده خاص: از تاریخچه مالی مشتری و برنامه های وام قبلی برای تصمیم گیری و توضیح تصمیم وام استفاده کنید.

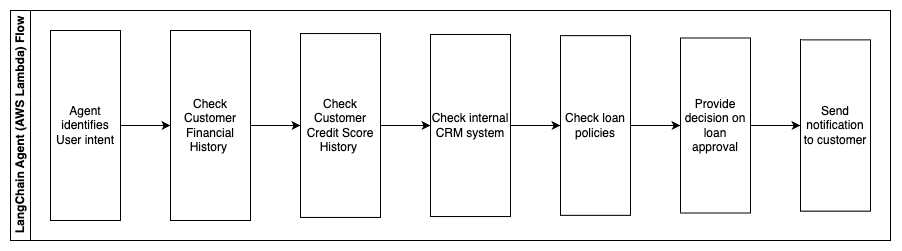

مراحل زیر توابع AWS Lambda و جریان آنها را در فرآیند توصیف می کند:

- عامل LangChain برای شناسایی هدف

- تاریخچه امتیاز مالی و اعتباری مشتری را بررسی کنید

- سیستم مدیریت ارتباط با مشتری داخلی را بررسی کنید

- سیاست های استاندارد وام را بررسی کنید و تصمیمی را برای کارمندانی که واجد شرایط وام هستند را پیشنهاد دهید

- ارسال اعلان به مشتری

این معماری داده های مالی مشتری ذخیره شده در یک پایگاه داده و داده های ذخیره شده در ابزار مدیریت ارتباط با مشتری (CRM) را ترکیب می کند. این نقاط داده برای تصمیم گیری بر اساس سیاست های وام داخلی شرکت استفاده می شود. مشتری میتواند سوالات روشنکنندهای بپرسد تا بفهمد چه وامهایی واجد شرایط هستند و شرایط وامهایی که میتوانند بپذیرند. اگر ربات مکالمه هوش مصنوعی مولد نتواند درخواست وام را تأیید کند، کاربر همچنان میتواند درباره بهبود امتیازات اعتباری یا گزینههای تأمین مالی جایگزین سؤال بپرسد.

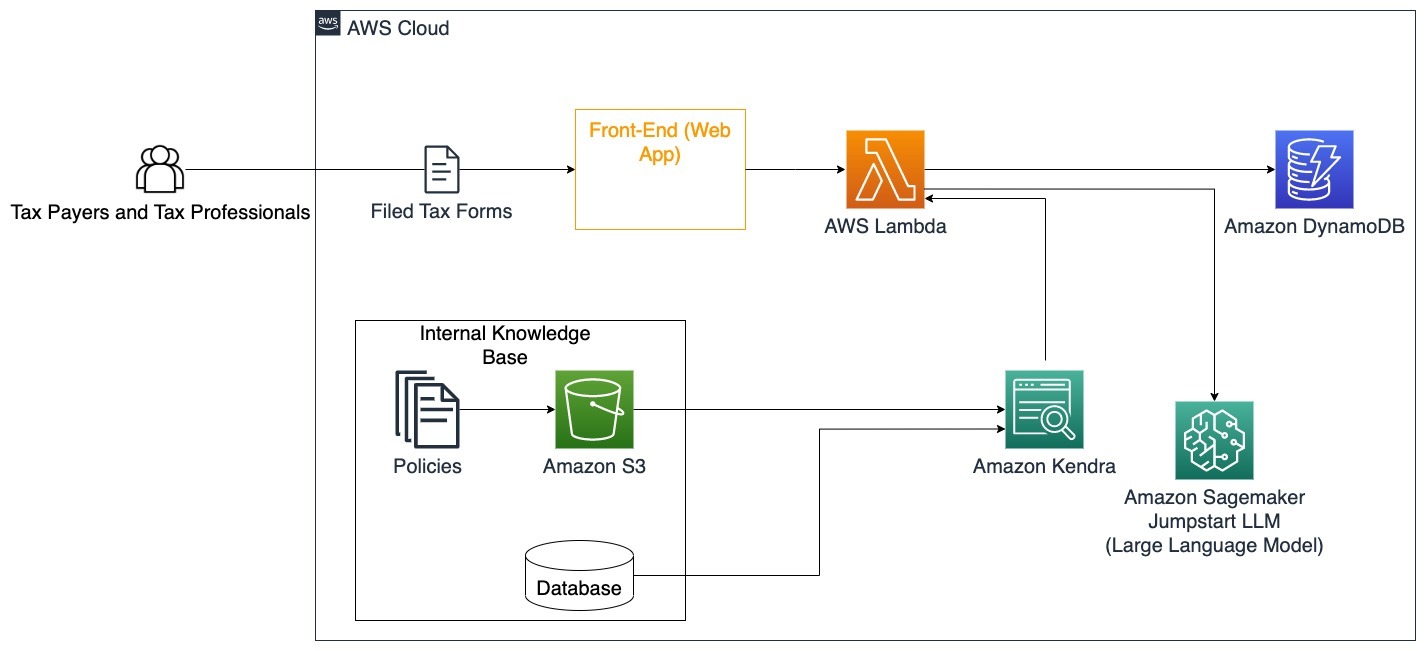

دولت

رباتهای مکالمه هوش مصنوعی مولد میتوانند با سرعت بخشیدن به فرآیندهای ارتباطی، کارایی و تصمیمگیری به نفع نهادهای دولتی باشند. رباتهای مکالمه هوش مصنوعی مولد همچنین میتوانند دسترسی فوری به پایگاههای دانش داخلی را برای کمک به کارمندان دولت در بازیابی سریع اطلاعات، خطمشیها و رویهها (یعنی معیارهای واجد شرایط بودن، فرآیندهای درخواست، و خدمات و پشتیبانی شهروندان) فراهم کنند. یک راه حل یک سیستم تعاملی است که به مالیات دهندگان و متخصصان مالیاتی اجازه می دهد تا به راحتی جزئیات و مزایای مربوط به مالیات را پیدا کنند. می توان از آن برای درک سوالات کاربران، خلاصه کردن اسناد مالیاتی و ارائه پاسخ های واضح از طریق مکالمات تعاملی استفاده کرد.

کاربران می توانند سوالاتی مانند:

- مالیات بر ارث چگونه کار می کند و آستانه مالیات چقدر است؟

- می توانید مفهوم مالیات بر درآمد را توضیح دهید؟

- عوارض مالیاتی هنگام فروش ملک دوم چیست؟

علاوه بر این، کاربران می توانند به راحتی فرم های مالیاتی را به یک سیستم ارسال کنند، که می تواند به تأیید صحت اطلاعات ارائه شده کمک کند.

این معماری نشان می دهد که چگونه کاربران می توانند فرم های مالیاتی تکمیل شده را در راه حل بارگذاری کنند و از آن برای تأیید تعاملی و راهنمایی در مورد نحوه تکمیل دقیق اطلاعات لازم استفاده کنند.

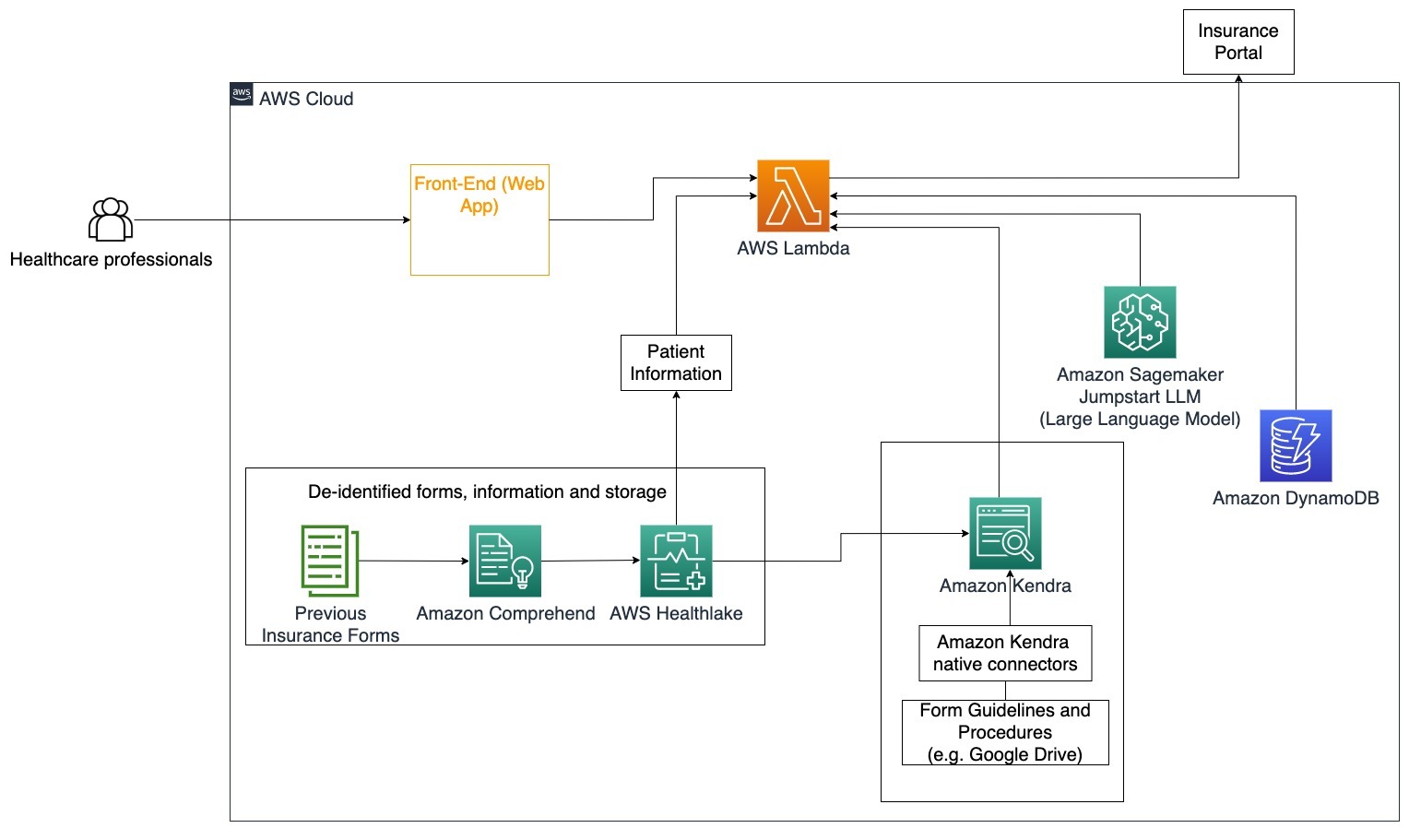

بهداشت و درمان

کسبوکارهای مراقبتهای بهداشتی این فرصت را دارند که استفاده از مقادیر زیادی از اطلاعات داخلی بیمار را خودکار کنند، در حالی که به سؤالات رایج در مورد موارد استفاده مانند گزینههای درمان، ادعاهای بیمه، آزمایشهای بالینی و تحقیقات دارویی نیز پاسخ میدهند. استفاده از یک ربات مکالمه هوش مصنوعی مولد، امکان تولید سریع و دقیق پاسخهای مربوط به اطلاعات سلامت از پایگاه دانش ارائه شده را فراهم میکند. به عنوان مثال، برخی از متخصصان مراقبت های بهداشتی زمان زیادی را صرف پر کردن فرم ها برای ارائه مطالبات بیمه می کنند.

در محیط های مشابه، مدیران کارآزمایی بالینی و محققان باید اطلاعاتی در مورد گزینه های درمانی بیابند. یک ربات مکالمه هوش مصنوعی مولد می تواند از رابط های از پیش ساخته شده در آمازون کندرا برای بازیابی مرتبط ترین اطلاعات از میلیون ها سند منتشر شده از طریق تحقیقات مداوم انجام شده توسط شرکت های داروسازی و دانشگاه ها استفاده کند.

مورد استفاده خاص: خطاها و زمان مورد نیاز برای تکمیل و ارسال فرم های بیمه را کاهش دهید.

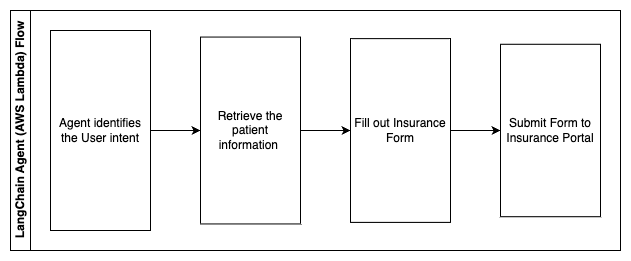

در این نمودار معماری، یک متخصص مراقبت های بهداشتی می تواند از ربات مکالمه هوش مصنوعی مولد استفاده کند تا بفهمد چه فرم هایی باید برای بیمه پر شود. سپس نماینده LangChain میتواند فرمهای مناسب را بازیابی کند و اطلاعات مورد نیاز را برای بیمار اضافه کند و همچنین برای بخشهای تشریحی فرمها بر اساس بیمهنامه و فرمهای قبلی پاسخ دهد. متخصص مراقبت های بهداشتی می تواند پاسخ های داده شده توسط LLM را قبل از تایید و تحویل فرم به پورتال بیمه ویرایش کند.

مراحل زیر توابع AWS Lambda و جریان آنها را در فرآیند توصیف می کند:

- عامل LangChain برای شناسایی هدف

- اطلاعات مورد نیاز بیمار را بازیابی کنید

- فرم بیمه را بر اساس اطلاعات بیمار و دستورالعمل فرم پر کنید

- پس از تایید کاربر فرم را به درگاه بیمه ارسال کنید

AWS HealthLake برای ذخیره ایمن داده های سلامت از جمله فرم های بیمه قبلی و اطلاعات بیمار، و Amazon Comprehend برای حذف اطلاعات شناسایی شخصی (PII) از فرم های بیمه قبلی استفاده می شود. سپس خزنده آمازون کندرا می تواند از مجموعه فرم ها و دستورالعمل های بیمه برای ایجاد شاخص استفاده کند. پس از تکمیل فرم(های) توسط هوش مصنوعی مولد، فرم(های) بررسی شده توسط متخصص پزشکی می تواند به پورتال بیمه ارسال شود.

برآورد هزینه

هزینه استقرار راه حل پایه به عنوان اثبات مفهوم در جدول زیر نشان داده شده است. از آنجایی که راه حل پایه به عنوان یک اثبات مفهوم در نظر گرفته می شود، Amazon Kendra Developer Edition به عنوان یک گزینه کم هزینه استفاده شد، زیرا حجم کار در حال تولید نبود. فرض ما برای Amazon Kendra Developer Edition 730 ساعت فعال در ماه بود.

برای Amazon SageMaker، ما این فرض را کردیم که مشتری از نمونه ml.g4dn.2xlarge برای استنتاج بلادرنگ، با یک نقطه پایان استنتاج در هر نمونه استفاده میکند. می توانید اطلاعات بیشتری در مورد قیمت گذاری Amazon SageMaker و انواع نمونه های استنتاج موجود بیابید اینجا کلیک نمایید.

| محصولات | منابع مصرف شده | برآورد هزینه در هر ماه به دلار |

| AWS تقویت کنید | 150 دقیقه ساخت 1 گیگابایت داده ارائه شده است 500,000 درخواست |

15.71 |

| دروازه API آمازون | 1M REST API تماس دارد | 3.5 |

| AWS لامبدا | 1 میلیون درخواست مدت زمان هر درخواست 5 ثانیه 2 گیگابایت حافظه اختصاص داده شده است |

160.23 |

| آمازون DynamoDB | 1 میلیون مطالعه 1 میلیون می نویسد ذخیره سازی 100 GB |

26.38 |

| آمازون Sagemaker | استنتاج بلادرنگ با ml.g4dn.2xlarge | 676.8 |

| آمازون کندرا | نسخه توسعه دهنده با 730 ساعت در ماه 10,000 سند اسکن شده 5,000 پرس و جو در روز |

821.25 |

| . | . | هزینه کل: 1703.87 |

* Amazon Cognito دارای یک ردیف رایگان از 50,000 کاربر فعال ماهانه است که از استخرهای کاربران Cognito یا 50 کاربر ماهانه فعال که از ارائه دهندگان هویت SAML 2.0 استفاده می کنند.

پاکسازی

برای صرفه جویی در هزینه ها، تمام منابعی را که به عنوان بخشی از آموزش استفاده کرده اید حذف کنید. می توانید هر نقطه پایانی SageMaker را که ممکن است از طریق کنسول SageMaker ایجاد کرده باشید حذف کنید. به یاد داشته باشید، حذف فهرست کندرا آمازون اسناد اصلی را از فضای ذخیرهسازی شما حذف نمیکند.

نتیجه

در این پست، ما به شما نشان دادیم که چگونه می توانید دسترسی به اطلاعات داخلی را با جمع بندی از چندین مخزن در زمان واقعی ساده کنید. پس از تحولات اخیر LLMهای تجاری موجود، امکانات هوش مصنوعی مولد آشکارتر شده است. در این پست، راههایی برای استفاده از سرویسهای AWS برای ایجاد یک ربات چت بدون سرور که از هوش مصنوعی مولد برای پاسخ به سوالات استفاده میکند، به نمایش گذاشتیم. این رویکرد دارای یک لایه احراز هویت و تشخیص PII Amazon Comprehend است تا هرگونه اطلاعات حساس ارائه شده در پرس و جو کاربر را فیلتر کند. چه افرادی در بخش مراقبت های بهداشتی باشند که تفاوت های ظریف را برای ارائه ادعاهای بیمه درک می کنند یا منابع انسانی قوانین خاص شرکت را درک می کنند، چندین صنعت و بخش عمودی وجود دارند که می توانند از این رویکرد سود ببرند. یک مدل پایه آمازون SageMaker JumpStart موتور پشت ربات چت است، در حالی که یک رویکرد پر کردن زمینه با استفاده از تکنیک RAG برای اطمینان از اینکه پاسخ ها با دقت بیشتری به اسناد داخلی ارجاع می دهند استفاده می شود.

برای کسب اطلاعات بیشتر در مورد کار با هوش مصنوعی مولد در AWS، مراجعه کنید معرفی ابزارهای جدید برای ساخت با هوش مصنوعی در AWS. برای راهنمایی عمیق تر در مورد استفاده از تکنیک RAG با خدمات AWS، مراجعه کنید با استفاده از Amazon Kendra، LangChain و مدل های زبان بزرگ، به سرعت برنامه های هوش مصنوعی مولد با دقت بالا را روی داده های سازمانی بسازید.. از آنجایی که رویکرد در این وبلاگ LLM agnostic است، هر LLM را می توان برای استنتاج استفاده کرد. در پست بعدی، راههایی را برای پیادهسازی این راهحل با استفاده از Amazon Bedrock و Amazon Titan LLM بیان میکنیم.

درباره نویسنده

آبیشک مالیگهالی شیوالینگایاه یک معمار ارشد راه حل خدمات هوش مصنوعی در AWS است. او علاقه زیادی به ساخت برنامه های کاربردی با استفاده از Generative AI، Amazon Kendra و NLP دارد. او حدود 10 سال تجربه در ساخت راه حل های داده و هوش مصنوعی برای ایجاد ارزش برای مشتریان و شرکت ها دارد. او حتی یک چت بات (شخصی) برای سرگرمی ساخته است تا به سوالاتی در مورد حرفه و سفر حرفه ای خود پاسخ دهد. خارج از محل کار او از ساختن پرتره از خانواده و دوستان لذت می برد و عاشق خلق آثار هنری است.

آبیشک مالیگهالی شیوالینگایاه یک معمار ارشد راه حل خدمات هوش مصنوعی در AWS است. او علاقه زیادی به ساخت برنامه های کاربردی با استفاده از Generative AI، Amazon Kendra و NLP دارد. او حدود 10 سال تجربه در ساخت راه حل های داده و هوش مصنوعی برای ایجاد ارزش برای مشتریان و شرکت ها دارد. او حتی یک چت بات (شخصی) برای سرگرمی ساخته است تا به سوالاتی در مورد حرفه و سفر حرفه ای خود پاسخ دهد. خارج از محل کار او از ساختن پرتره از خانواده و دوستان لذت می برد و عاشق خلق آثار هنری است.

مدا آیه یک معمار راه حل در AWS، مستقر در آستین، تگزاس است. او اخیراً در دسامبر 2022 از دانشگاه تگزاس در دالاس با مدرک کارشناسی ارشد خود در علوم کامپیوتر با تخصص در سیستم های هوشمند با تمرکز بر AI / ML فارغ التحصیل شد. او علاقه مند است در مورد AI/ML و استفاده از خدمات AWS برای کشف راه حل هایی که مشتریان می توانند از آنها بهره مند شوند بیشتر بیاموزد.

مدا آیه یک معمار راه حل در AWS، مستقر در آستین، تگزاس است. او اخیراً در دسامبر 2022 از دانشگاه تگزاس در دالاس با مدرک کارشناسی ارشد خود در علوم کامپیوتر با تخصص در سیستم های هوشمند با تمرکز بر AI / ML فارغ التحصیل شد. او علاقه مند است در مورد AI/ML و استفاده از خدمات AWS برای کشف راه حل هایی که مشتریان می توانند از آنها بهره مند شوند بیشتر بیاموزد.

هوگو تسه یک معمار راه حل در AWS مستقر در سیاتل، واشنگتن است. او دارای مدرک کارشناسی ارشد فناوری اطلاعات از دانشگاه ایالتی آریزونا و مدرک لیسانس اقتصاد از دانشگاه شیکاگو است. او عضو انجمن حسابرسی و کنترل سیستم های اطلاعاتی (ISACA) و کنسرسیوم صدور گواهینامه امنیت سیستم اطلاعات بین المللی (ISC)2 است. او از کمک به مشتریان برای بهره مندی از فناوری لذت می برد.

هوگو تسه یک معمار راه حل در AWS مستقر در سیاتل، واشنگتن است. او دارای مدرک کارشناسی ارشد فناوری اطلاعات از دانشگاه ایالتی آریزونا و مدرک لیسانس اقتصاد از دانشگاه شیکاگو است. او عضو انجمن حسابرسی و کنترل سیستم های اطلاعاتی (ISACA) و کنسرسیوم صدور گواهینامه امنیت سیستم اطلاعات بین المللی (ISC)2 است. او از کمک به مشتریان برای بهره مندی از فناوری لذت می برد.

ایمن ایشیموه یک معمار راه حل در AWS مستقر در سیاتل، واشنگتن است. او دارای مدرک کارشناسی ارشد در رشته مهندسی نرم افزار و فناوری اطلاعات از دانشگاه اوکلند است. او تجربه قبلی در توسعه نرم افزار، به ویژه در ساخت میکروسرویس برای برنامه های کاربردی وب توزیع شده دارد. او مشتاق کمک به مشتریان برای ایجاد راه حل های قوی و مقیاس پذیر در سرویس های ابری AWS به دنبال بهترین شیوه ها است.

ایمن ایشیموه یک معمار راه حل در AWS مستقر در سیاتل، واشنگتن است. او دارای مدرک کارشناسی ارشد در رشته مهندسی نرم افزار و فناوری اطلاعات از دانشگاه اوکلند است. او تجربه قبلی در توسعه نرم افزار، به ویژه در ساخت میکروسرویس برای برنامه های کاربردی وب توزیع شده دارد. او مشتاق کمک به مشتریان برای ایجاد راه حل های قوی و مقیاس پذیر در سرویس های ابری AWS به دنبال بهترین شیوه ها است.

شروین سورش یک معمار راه حل در AWS مستقر در آستین، تگزاس است. او فارغ التحصیل کارشناسی ارشد در مهندسی نرم افزار با تمرکز در محاسبات ابری و مجازی سازی و لیسانس در مهندسی کامپیوتر از دانشگاه ایالتی سن خوزه است. او علاقه زیادی به استفاده از فناوری برای کمک به بهبود زندگی افراد با هر زمینهای دارد.

شروین سورش یک معمار راه حل در AWS مستقر در آستین، تگزاس است. او فارغ التحصیل کارشناسی ارشد در مهندسی نرم افزار با تمرکز در محاسبات ابری و مجازی سازی و لیسانس در مهندسی کامپیوتر از دانشگاه ایالتی سن خوزه است. او علاقه زیادی به استفاده از فناوری برای کمک به بهبود زندگی افراد با هر زمینهای دارد.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. خودرو / خودروهای الکتریکی، کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- ChartPrime. بازی معاملاتی خود را با ChartPrime ارتقا دهید. دسترسی به اینجا.

- BlockOffsets. نوسازی مالکیت افست زیست محیطی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- قادر

- درباره ما

- پذیرفتن

- دسترسی

- دسترسی

- حساب ها

- دقیق

- به درستی

- اقدامات

- فعال

- اضافه کردن

- علاوه بر این

- آدرس

- خطاب به

- مدیران

- تصویب

- مشاوران

- پس از

- عامل

- عاملان

- تجمیع

- AI

- خدمات هوش مصنوعی

- AI / ML

- معرفی

- اجازه می دهد تا

- در امتداد

- همچنین

- جایگزین

- آمازون

- دروازه API آمازون

- Cognito آمازون

- درک آمازون

- آمازون کندرا

- آمازون SageMaker

- Amazon SageMaker JumpStart

- آمازون خدمات وب

- مقدار

- مقدار

- an

- تحلیلگران

- تجزیه و تحلیل

- و

- پاسخ

- پاسخ

- هر

- API

- ظاهر

- کاربرد

- برنامه های کاربردی

- وقت ملاقات

- روش

- تصویب

- معماری

- هستند

- بوجود می آیند

- آریزونا

- دور و بر

- مقاله

- مصنوعی

- هوش مصنوعی

- هوش مصنوعی (AI)

- آثار هنری

- AS

- پرسیدن

- جنبه

- ارزیابی کنید

- همکاری

- کمک

- وابسته

- مرتبط است

- انجمن

- فرض

- At

- حسابرسی

- افزوده شده

- آستین

- تأیید اعتبار

- تصدیق

- مجوز

- خودکار بودن

- بطور خودکار

- دسترس پذیری

- در دسترس

- AWS

- AWS لامبدا

- به عقب

- پس زمینه

- پایه

- مستقر

- BE

- خرس

- زیرا

- شدن

- شود

- بوده

- قبل از

- از طرف

- پشت سر

- سود

- مزایای

- بهترین

- بهترین شیوه

- بهتر

- بلاگ

- کتاب

- ربات

- هر دو

- رباتها

- پایین

- نام تجاری

- بودجه

- ساختن

- بنا

- ساخته

- کسب و کار

- کسب و کار

- اما

- by

- صدا

- CAN

- قابلیت های

- کاریابی

- Осторожно

- مورد

- موارد

- دسته بندی

- ایجاد می شود

- مرکز

- متمرکز

- معین

- گواهی

- زنجیر

- چالش ها

- تغییر دادن

- متهم

- chatbot

- بررسی

- چک

- شیکاگو

- ادعای

- واضح

- بالینی

- آزمایش های بالینی

- ابر

- محاسبات ابری

- خدمات ابر

- جمع آوری

- مجموعه

- تجاری

- مشترک

- ارتباط

- شرکت

- شرکت

- شرکت

- رقابتی

- تکمیل شده

- تکمیل

- پیچیده

- پیچیدگی

- مطابق

- درک

- کامپیوتر

- مهندسی رایانه

- علم کامپیوتر

- محاسبه

- غلظت

- مفهوم

- مختصر

- انجام

- تلاقی

- اتصال

- متصل

- توجه

- ملاحظات

- در نظر گرفته

- استوار

- شامل

- کنسول

- کنسرسیوم

- مصرف

- مصرف

- تماس

- تماس با مرکز

- شامل

- محتوا

- زمینه

- به طور مداوم

- کمک می کند

- کنترل

- کنترل

- راحتی

- گفتگو

- محاورهای

- گفتگو

- شرکت

- اصلاح

- هزینه

- هزینه

- خزنده

- ایجاد

- ایجاد ارزش

- ایجاد شده

- ایجاد

- اعتبار

- ضوابط

- بحرانی

- CRM

- بسیار سخت

- سرپرستی

- جاری

- در حال حاضر

- مشتری

- نامزدی مشتری

- تجربه مشتری

- خدمات مشتری

- پشتیبانی مشتریان

- مشتریان

- روزانه

- دالاس

- داده ها

- نقاط داده

- مجموعه داده ها

- پایگاه داده

- تاریخ

- دسامبر

- تصمیم گیری

- تصمیم

- تصمیم گیری

- تصمیم گیری

- درجه

- تحویل داده

- بستگی دارد

- مستقر

- استقرار

- توصیف

- طرح

- با وجود

- جزئیات

- شناسایی شده

- کشف

- توسعه دهنده

- پروژه

- تحولات

- مختلف

- مشکل

- كشف كردن

- توزیع شده

- مستندات

- اسناد و مدارک

- میکند

- نمی کند

- راندن

- مدت

- e

- آسان تر

- به آسانی

- اقتصاد (Economics)

- اکوسیستم

- چاپ

- بهره وری

- تلاش

- هر دو

- شایستگی

- پست الکترونیک

- ایمیل

- کارمند

- کارکنان

- را قادر می سازد

- تشویق می کند

- نقطه پایانی

- انرژی

- نامزدی

- موتور

- مهندسی

- غنی سازی

- اطمینان حاصل شود

- تضمین می کند

- حصول اطمینان از

- سرمایه گذاری

- شرکت

- اشخاص

- خطاهای

- تشدید

- تخمین زدن

- و غیره

- حتی

- مثال

- اجرا کردن

- موجود

- گران

- تجربه

- توضیح دهید

- توضیح می دهد

- استخراج

- عصاره ها

- چهره

- خانواده

- ویژگی

- تغذیه

- کمتر

- شکل

- پرونده

- پر کردن

- پر شده

- پر كردن

- فیلتر

- مالی

- اطلاعات مالی

- تاریخچه مالی

- موسسه مالی

- تامین مالی

- پیدا کردن

- پیدا کردن

- نام خانوادگی

- انعطاف پذیری

- جریان

- تمرکز

- پیروی

- برای

- فرم

- اشکال

- انجمن

- یافت

- پایه

- چارچوب

- رایگان

- دوستان

- از جانب

- سرگرمی

- تابع

- توابع

- بیشتر

- افزایش

- دروازه

- تولید می کنند

- نسل

- مولد

- هوش مصنوعی مولد

- دریافت کنید

- داده

- می دهد

- دادن

- گوگل

- دولت

- تا حد زیادی

- شدن

- در حال رشد

- رشد می کند

- راهنمایی

- دستورالعمل ها

- دسته

- دستگیره

- اداره

- آیا

- داشتن

- he

- سلامتی

- اطلاعات سلامتی

- بهداشت و درمان

- کمک

- کمک

- کمک می کند

- او

- زیاد

- خیلی

- خود را

- تاریخ

- دارای

- میزبانی

- میزبان

- ساعت ها

- چگونه

- چگونه

- اما

- hr

- HTML

- HTTPS

- انسان

- i

- شناسه

- شناسه ها

- شناسایی می کند

- شناسایی

- شناسایی

- هویت

- if

- نشان می دهد

- انجام

- اجرای

- پیامدهای

- بهبود

- را بهبود می بخشد

- بهبود

- in

- در عمق

- نادرست

- شامل

- شامل

- از جمله

- درآمد

- مالیات بر درآمد

- افزایش

- افزایش

- شاخص

- نمایه شده

- فهرستها

- افراد

- لوازم

- اطلاع دادن

- اطلاعات

- سیستم های اطلاعاتی

- فن آوری اطلاعات

- اطلاع

- وراثت

- ورودی

- نمونه

- فوری

- در عوض

- موسسه

- موسسات

- بیمه

- یکپارچه

- ادغام

- ادغام

- اطلاعات

- هوشمند

- قصد

- تعامل

- تعاملی

- علاقه مند

- رابط

- داخلی

- بین المللی

- به

- سرمایه گذاری

- موضوع

- IT

- اقلام

- سفر

- JPG

- نگاه داشتن

- دانش

- شناخته شده

- زبان

- بزرگ

- لایه

- رهبری

- یاد گرفتن

- یادگیری

- کمتر

- سطح

- بهره برداری

- کتابخانه

- محدودیت

- محدودیت

- لاین

- زندگی

- LLM

- وام

- وام

- ورود به سیستم

- منطقی

- طولانی

- مدت زمان طولانی

- دیگر

- نگاه کنيد

- خیلی

- دوست دارد

- کم هزینه

- کاهش

- وفادار

- وفاداری

- دستگاه

- فراگیری ماشین

- ساخته

- حفظ

- ساخت

- باعث می شود

- ساخت

- مدیریت

- مدیریت

- روش

- کتابچه راهنمای

- دستی

- بسیاری

- بازار

- تحقیقات بازار

- کارشناسی ارشد

- ممکن است..

- به معنی

- پزشکی

- عضو

- حافظه

- خدمات میکرو

- مایکروسافت

- میلیون

- میلیون ها نفر

- ذهن

- ML

- مدل

- مدل

- ماژول ها

- ماه

- ماهیانه

- بیش

- اکثر

- چندگانه

- بومی

- لازم

- نیاز

- ضروری

- نیازهای

- جدید

- بعد

- nlp

- اخطار

- تعداد

- اوکلند

- اوت

- of

- پیشنهادات

- غالبا

- نفت

- on

- شبانه روزی

- یک بار

- ONE

- مداوم

- فقط

- باز کن

- کار

- عملیاتی

- قابل استفاده

- فرصت

- بهینه سازی

- گزینه

- گزینه

- or

- سفارش

- سازمان های

- اصلی

- دیگر

- ما

- خارج

- طرح کلی

- خارج از

- روی

- نمونه

- بخش

- بخش

- گذشت

- احساساتی

- بیمار

- پرداخت

- مردم

- برای

- کارایی

- مجوز

- شخصی

- اطلاعات شخصی

- شخصا

- دارویی

- ستون

- برنامه

- افلاطون

- هوش داده افلاطون

- PlatoData

- لطفا

- نقطه

- نقطه

- سیاست

- استخرها

- پورتال

- پرتره

- فرصت

- امکان

- پست

- صفحه اصلی

- شیوه های

- در حال حاضر

- جلوگیری از

- قبلی

- قبلا

- قیمت گذاری

- مدل قیمت گذاری

- قبلا

- اولویت

- خلوت

- مشکلات

- روش

- ادامه

- روند

- فرآوری شده

- فرآیندهای

- در حال پردازش

- تولید

- بهره وری

- محصولات

- حرفه ای

- حرفه ای

- ویژگی

- ارائه

- ارائه

- ارائه دهندگان

- ارائه

- منتشر شده

- خریداری شده

- پرسش و پاسخ

- واجد شرایط شدن

- مقدماتی

- نمایش ها

- سوال

- سوالات

- سریع

- به سرعت

- محدوده

- نرخ

- خواندن

- مطالعه

- زمان واقعی

- اخیر

- تازه

- كاهش دادن

- را کاهش می دهد

- مراجعه

- ارجاع

- با توجه

- به طور منظم

- مقررات

- ارتباط

- ربط

- مربوط

- تکیه

- بقایای

- به یاد داشته باشید

- برداشتن

- درخواست

- درخواست

- نیاز

- ضروری

- مورد نیاز

- تحقیق

- محققان

- وضوح

- رفع

- منابع

- پاسخ

- پاسخ

- مسئوليت

- REST

- نتیجه

- عودت

- بررسی

- راست

- خطرات

- تنومند

- مسیر

- در حال اجرا

- s

- حکیم ساز

- حراجی

- سان

- سن خوزه

- رضایت

- ذخیره

- مقیاس پذیر

- مقیاس

- سناریو

- علم

- نمره

- اسکریپت

- جستجو

- جستجو

- سیاتل

- دوم

- ثانیه

- بخش

- امن

- ایمن

- تیم امنیت لاتاری

- فروش

- ارسال

- ارشد

- حساس

- فرستاده

- بدون سرور

- خدمت

- سرویس

- خدمات

- تنظیم

- مجموعه

- تنظیمات

- چند

- او

- تغییر

- کاستی ها

- باید

- نمایش داده شده

- نشان داد

- نشان داده شده

- سیلوهای

- مشابه

- ساده

- ساده کردن

- پس از

- تنها

- اندازه

- کوچکتر

- So

- آگاهی

- نرم افزار

- توسعه نرم افزار

- مهندسی نرم افزار

- راه حل

- مزایا

- برخی از

- منبع

- منابع

- متخصص

- خاص

- به طور خاص

- خرج کردن

- هزینه

- استاندارد

- دولت

- وضعیت

- ماندن

- گام

- مراحل

- هنوز

- ذخیره سازی

- opbevare

- ذخیره شده

- ذخیره سازی

- فشار

- چاشنی

- قابل توجه

- چنین

- نشان می دهد

- خلاصه کردن

- پشتیبانی

- سیستم

- سیستم های

- جدول

- طول می کشد

- وظایف

- مالیات

- تیم

- تیم ها

- پیشرفته

- قوانین و مقررات

- وابسته به تکزاس

- متن

- متن

- که

- La

- اطلاعات

- شان

- خودشان

- سپس

- آنجا.

- اینها

- آنها

- شخص ثالث

- این

- از طریق

- بلیط

- فروش بلیط

- ردیف

- زمان

- زمان بر

- بموقع

- بار

- برچسب زمان

- تیتان

- به

- امروز

- نشانه

- ابزار

- ابزار

- قابلیت ردیابی

- به طور سنتی

- آموزش دیده

- آموزش

- ترانسفورماتور

- شفافیت

- رفتار

- محاکمه

- آزمایش های

- آموزش

- انواع

- ناتوان

- فهمیدن

- درک

- منحصر به فرد

- دانشگاه ها

- دانشگاه

- دانشگاه شیکاگو

- در جریان روز

- به روز شده

- به روز رسانی

- استفاده کنید

- مورد استفاده

- استفاده

- کاربر

- کاربران

- استفاده

- با استفاده از

- استفاده کنید

- استفاده

- با استفاده از

- ارزش

- مختلف

- تایید

- بررسی

- عمودی

- از طريق

- تصویری

- فیلم های

- صدا

- صبر کنيد

- منتظر

- بود

- واشنگتن

- راه

- we

- وب

- برنامه تحت وب

- برنامه های وب

- خدمات وب

- خوب

- بود

- چی

- چه زمانی

- چه

- که

- در حین

- WHO

- وسیع

- دامنه گسترده

- با

- در داخل

- مهاجرت کاری

- گردش کار

- کارگر

- خواهد بود

- کتبی

- سال

- شما

- شما

- زفیرنت