از آنجایی که شرکت ها به طور فزاینده ای قابلیت های هوش مصنوعی (AI) را به مجموعه محصولات خود اضافه می کنند، کارشناسان امنیت سایبری هشدار می دهند که اجزای یادگیری ماشینی (ML) در برابر انواع جدید حملات آسیب پذیر هستند و باید از آنها محافظت شود.

استارتآپ HiddenLayer که در 19 جولای راهاندازی شد، قصد دارد به شرکتها کمک کند از مدلهای حساس یادگیری ماشینی خود و دادههای مورد استفاده برای آموزش این مدلها بهتر محافظت کنند. این شرکت اولین محصولات خود را با هدف شناسایی و پاسخ ML منتشر کرده است که هدف آن سختتر کردن مدلها در برابر حمله و همچنین محافظت از دادههای مورد استفاده برای آموزش آن مدلها است.

کریستوفر سستیتو، مدیر عامل HiddenLayer میگوید: خطرات تئوری نیستند: بنیانگذاران شرکت در Cylance زمانی کار کردند که محققان راههایی برای دور زدن موتور هوش مصنوعی شرکت برای شناسایی بدافزارها پیدا کردند.

او می گوید: «آنها از طریق خود محصول به مدل حمله کردند و به اندازه کافی با مدل تعامل کردند تا ... مشخص کنند که مدل ضعیف ترین کجاست.

Sestito انتظار دارد حملات علیه سیستمهای AI/ML افزایش یابد زیرا شرکتهای بیشتری این ویژگیها را در محصولات خود گنجاندهاند.

او میگوید: «AI و ML سریعترین فناوریهایی هستند که تا به حال دیدهایم، بنابراین ما انتظار داریم که سریعترین رشد بردارهای حملهای باشند که تاکنون دیدهایم.»

نقص در مدل یادگیری ماشین

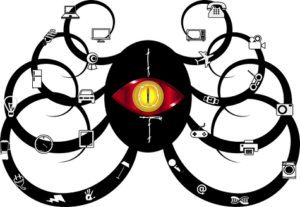

ML تبدیل به یک ابزار ضروری برای نسل بعدی محصولات بسیاری از شرکتها شده است، اما کسبوکارها معمولاً بدون در نظر گرفتن پیامدهای امنیتی، ویژگیهای مبتنی بر هوش مصنوعی را اضافه میکنند. از جمله تهدیدات فرار از مدل، مانند تحقیقات انجام شده علیه Cylance، و استخراج عملکردی است، که در آن مهاجمان می توانند یک مدل را جستجو کنند و یک سیستم معادل عملکردی بر اساس خروجی ها بسازند.

دو سال پیش، مایکروسافت، MITRE، و شرکت های دیگر ماتریس تهدید یادگیری ماشین متخاصم را ایجاد کرد فهرست کردن تهدیدات بالقوه علیه سیستم های مبتنی بر هوش مصنوعی. در حال حاضر به عنوان تغییر نام تجاری چشم انداز تهدید خصمانه برای سیستم های هوش مصنوعی (ATLAS)، فرهنگ لغت حملات احتمالی نشان می دهد که فناوری های نوآورانه حملات ابتکاری را جذب می کنند.

بر خلاف آسیبپذیریهای امنیت سایبری سنتی که به سیستمهای نرمافزاری و سختافزاری خاص گره خوردهاند، آسیبپذیریهای ML متخاصم با محدودیتهای ذاتی زیربنای الگوریتمهای ML فعال میشوند. صفحه پروژه ATLAS در GitHub. «دادهها را میتوان به روشهای جدید تسلیحاتی کرد که مستلزم گسترش نحوه مدلسازی رفتار دشمن سایبری، برای انعکاس بردارهای تهدید در حال ظهور و چرخه حیات حمله یادگیری ماشینی متخاصم است که به سرعت در حال تکامل است.»

این تهدید عملی برای سه بنیانگذار HiddenLayer - Sestito، Tanner Burns و James Ballard - که در Cylance با هم کار می کردند به خوبی شناخته شده است. در آن زمان، محققان Skylight Cyber کد خوب شناخته شده را اضافه کرد - در واقع، فهرستی از رشتهها از بازی Rocket League's executable - برای فریب دادن فناوری Cylance به این باور که 84٪ از بدافزارها واقعاً خوش خیم هستند.

سستیتو گفت: «ما تلاشهای امدادی را پس از اینکه مدل یادگیری ماشین ما مستقیماً از طریق محصولمان مورد حمله قرار گرفت هدایت کردیم و متوجه شدیم که این یک مشکل بزرگ برای هر سازمانی است که مدلهای ML را در محصولات خود به کار میگیرد.» بیانیه ای که راه اندازی HiddenLayer را اعلام می کند.

به دنبال دشمنان در زمان واقعی

هدف HiddenLayer ایجاد سیستمی است که می تواند عملکرد سیستم های ML را نظارت کند و بدون نیاز به دسترسی به داده ها یا محاسبات، تعیین کند که آیا نرم افزار با استفاده از یکی از روش های متخاصم شناخته شده مورد حمله قرار گرفته است یا خیر.

Sestito می گوید: "ما در حال بررسی تعاملات رفتاری با مدل ها هستیم - این می تواند یک آدرس IP یا نقطه پایانی باشد." "ما در حال تجزیه و تحلیل هستیم که آیا این مدل همانطور که برای استفاده در نظر گرفته شده است استفاده می شود یا ورودی ها و خروجی ها در حال اهرم هستند یا درخواست کننده تصمیمات آنتروپی بسیار بالایی می گیرد."

او می گوید که توانایی انجام تحلیل رفتاری در زمان واقعی، تشخیص و پاسخ ML شرکت را از سایر رویکردها متمایز می کند. HiddenLayer میگوید علاوه بر این، این فناوری نیازی به دسترسی به مدل خاص یا دادههای آموزشی ندارد و مالکیت معنوی را عایقتر میکند.

Sestito میگوید، این رویکرد همچنین به این معنی است که سربار عامل امنیتی کوچک است، در حدود 1 یا 2 میلیثانیه.

او میگوید: «ما در حال بررسی ورودیها پس از بردار شدن دادههای خام هستیم، بنابراین عملکرد بسیار کمی وجود دارد.