مدلهای زبان بزرگ (LLM) انقلابی در زمینه پردازش زبان طبیعی (NLP) ایجاد کردهاند و کارهایی مانند ترجمه زبان، خلاصهسازی متن و تحلیل احساسات را بهبود میبخشند. با این حال، همانطور که این مدلها همچنان در اندازه و پیچیدگی رشد میکنند، نظارت بر عملکرد و رفتار آنها به طور فزایندهای چالش برانگیز شده است.

نظارت بر عملکرد و رفتار LLM ها یک وظیفه حیاتی برای اطمینان از ایمنی و اثربخشی آنها است. معماری پیشنهادی ما راهحلی مقیاسپذیر و قابل تنظیم برای نظارت آنلاین LLM ارائه میکند و تیمها را قادر میسازد راهحل نظارت شما را با موارد استفاده و نیازهای خاص شما تنظیم کنند. با استفاده از خدمات AWS، معماری ما در زمان واقعی رفتار LLM را مشاهده میکند و تیمها را قادر میسازد تا به سرعت هر گونه مشکل یا ناهنجاری را شناسایی و رسیدگی کنند.

در این پست، ما چند معیار برای نظارت بر LLM آنلاین و معماری مربوطه آنها را برای مقیاس با استفاده از خدمات AWS نشان میدهیم. CloudWatch آمازون و AWS لامبدا. این یک راه حل قابل تنظیم فراتر از آنچه با آن ممکن است ارائه می دهد ارزیابی مدل مشاغل با بستر آمازون.

بررسی اجمالی راه حل

اولین چیزی که باید در نظر گرفت این است که معیارهای مختلف نیاز به ملاحظات محاسباتی متفاوتی دارند. یک معماری مدولار، که در آن هر ماژول بتواند داده های استنتاج مدل را دریافت کند و معیارهای خود را تولید کند، ضروری است.

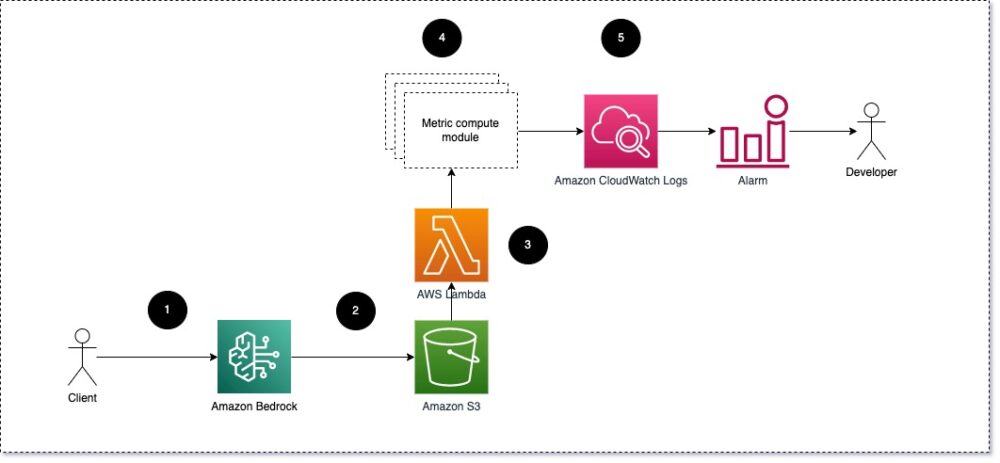

ما پیشنهاد میکنیم که هر ماژول درخواستهای استنتاج ورودی را به LLM ببرد و جفتهای اعلان و تکمیل (پاسخ) را به ماژولهای محاسبه متریک ارسال کند. هر ماژول مسئول محاسبه معیارهای خود با توجه به اعلان ورودی و تکمیل (پاسخ) است. این معیارها به CloudWatch منتقل میشوند، که میتواند آنها را جمعآوری کند و با هشدارهای CloudWatch برای ارسال اعلانها در شرایط خاص کار کند. نمودار زیر این معماری را نشان می دهد.

شکل 1: ماژول محاسبه متریک - نمای کلی راه حل

گردش کار شامل مراحل زیر است:

- کاربر به عنوان بخشی از یک برنامه یا رابط کاربری درخواستی را از Amazon Bedrock می کند.

- Amazon Bedrock درخواست و تکمیل (پاسخ) را در آن ذخیره می کند سرویس ذخیره سازی ساده آمازون (Amazon S3) طبق پیکربندی ثبت احضار.

- فایل ذخیره شده در Amazon S3 یک رویداد ایجاد می کند که محرک های یک تابع لامبدا تابع ماژول ها را فراخوانی می کند.

- ماژول ها معیارهای مربوطه خود را به معیارهای CloudWatch.

- آژیر می تواند تیم توسعه را از مقادیر متریک غیرمنتظره مطلع کند.

دومین موردی که هنگام اجرای نظارت LLM باید در نظر گرفت، انتخاب معیارهای مناسب برای ردیابی است. اگرچه معیارهای بالقوه زیادی وجود دارد که می توانید از آنها برای نظارت بر عملکرد LLM استفاده کنید، ما برخی از گسترده ترین آنها را در این پست توضیح می دهیم.

در بخشهای بعدی، ما تعدادی از معیارهای ماژول مربوطه و معماری ماژول محاسبه متریک مربوطه را برجسته میکنیم.

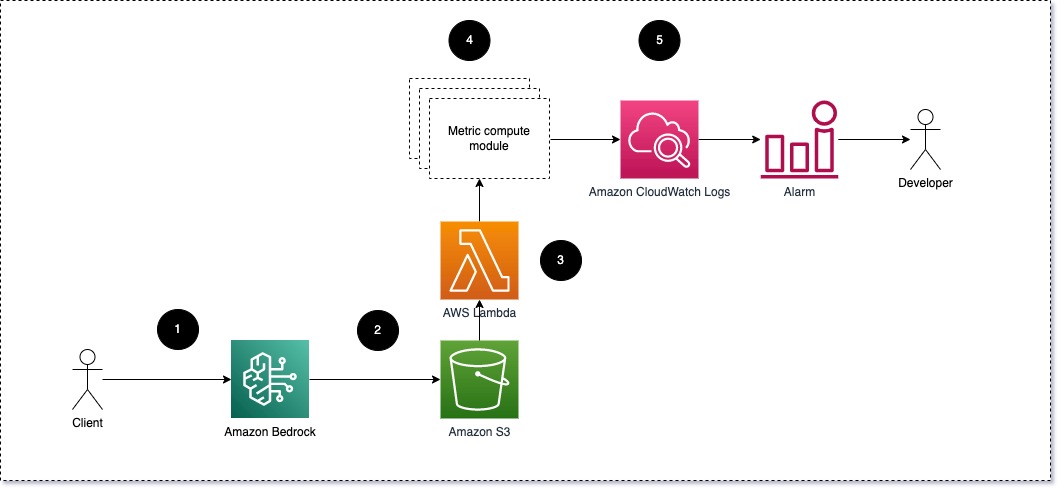

شباهت معنایی بین اعلان و تکمیل (پاسخ)

هنگام اجرای LLM ها، می توانید اعلان و تکمیل (پاسخ) را برای هر درخواست رهگیری کنید و با استفاده از یک مدل جاسازی آنها را به جاسازی تبدیل کنید. جاسازی ها بردارهایی با ابعاد بالا هستند که معنای معنایی متن را نشان می دهند. آمازون تایتان چنین مدل هایی را از طریق Titan Embeddings ارائه می دهد. با گرفتن فاصله ای مانند کسینوس بین این دو بردار، می توانید کمیت کنید که اعلان و تکمیل (پاسخ) چقدر از نظر معنایی مشابه هستند. شما می توانید استفاده کنید SciPy or یادگیری برای محاسبه فاصله کسینوس بین بردارها نمودار زیر معماری این ماژول محاسبه متریک را نشان می دهد.

شکل 2: ماژول محاسبه متریک - شباهت معنایی

این گردش کار شامل مراحل کلیدی زیر است:

- یک تابع Lambda یک پیام جریانی را از طریق دریافت می کند آمازون کینسیس حاوی یک جفت اعلان و تکمیل (پاسخ).

- این تابع یک تعبیه برای هر دو دستور و تکمیل (پاسخ) دریافت می کند و فاصله کسینوس بین دو بردار را محاسبه می کند.

- این تابع آن اطلاعات را به معیارهای CloudWatch ارسال می کند.

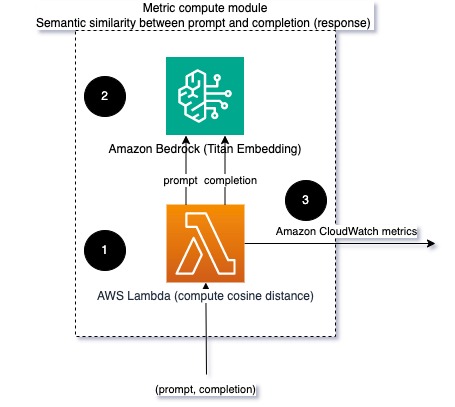

احساسات و سمیت

نظارت بر احساسات به شما امکان می دهد لحن کلی و تأثیر احساسی پاسخ ها را بسنجید، در حالی که تجزیه و تحلیل سمیت معیار مهمی از وجود زبان توهین آمیز، بی احترامی یا مضر در خروجی های LLM را ارائه می دهد. هر گونه تغییر در احساسات یا مسمومیت باید به دقت بررسی شود تا اطمینان حاصل شود که مدل مطابق انتظار رفتار می کند. نمودار زیر ماژول محاسبه متریک را نشان می دهد.

شکل 3: ماژول محاسبه متریک - احساسات و سمیت

گردش کار شامل مراحل زیر است:

- یک تابع Lambda یک جفت اعلان و تکمیل (پاسخ) را از طریق Amazon Kinesis دریافت می کند.

- از طریق AWS Step Functions ارکستراسیون، تابع فراخوانی می شود درک آمازون برای شناسایی احساس و سمیت.

- این تابع اطلاعات را در معیارهای CloudWatch ذخیره می کند.

برای اطلاعات بیشتر در مورد تشخیص احساسات و سمیت با آمازون Comprehend، مراجعه کنید یک پیشبینیکننده سمیت مبتنی بر متن قوی بسازید و با استفاده از تشخیص سمیت آمازون Comprehend، محتوای مضر را پرچمگذاری کنید.

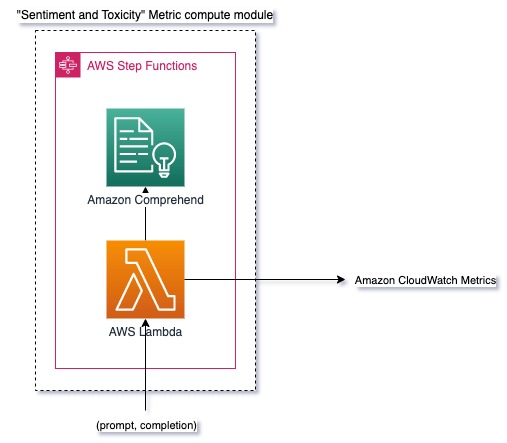

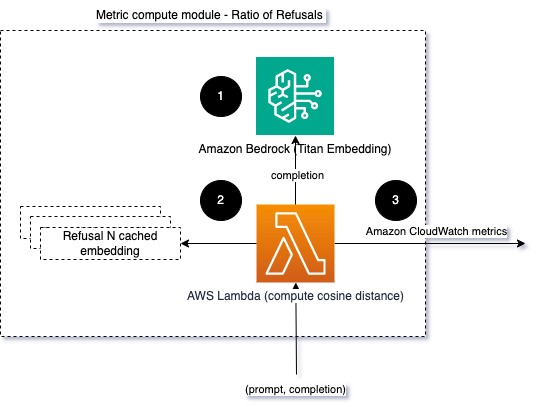

نسبت امتناع

افزایش امتناع ها، مانند زمانی که یک LLM به دلیل کمبود اطلاعات، تکمیل را انکار می کند، می تواند به این معنی باشد که یا کاربران مخرب سعی می کنند از LLM به روش هایی استفاده کنند که برای جیلبریک کردن آن در نظر گرفته شده است، یا اینکه انتظارات کاربران برآورده نمی شود و آنها پاسخ های کم ارزش دریافت می کنند. یکی از راههای سنجش تعداد دفعات وقوع این اتفاق، مقایسه رد استانداردهای مدل LLM با پاسخهای واقعی از LLM است. به عنوان مثال، موارد زیر برخی از عبارات امتناع رایج آنتروپیک Claude v2 LLM هستند:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

در مجموعهای ثابت از اعلانها، افزایش این امتناعها میتواند سیگنالی باشد که مدل بیش از حد محتاط یا حساس شده است. حالت معکوس نیز باید ارزیابی شود. این می تواند سیگنالی باشد که مدل اکنون بیشتر مستعد درگیر شدن در مکالمات سمی یا مضر است.

برای کمک به یکپارچگی مدل و نسبت امتناع مدل، میتوانیم پاسخ را با مجموعهای از عبارات امتناع شناخته شده از LLM مقایسه کنیم. این می تواند یک طبقه بندی واقعی باشد که می تواند توضیح دهد که چرا مدل درخواست را رد کرده است. میتوانید فاصله کسینوس بین پاسخ و پاسخهای امتناع شناخته شده را از مدل تحت نظارت بگیرید. نمودار زیر این ماژول محاسبه متریک را نشان می دهد.

شکل 4: ماژول محاسبه متریک - نسبت رد

گردش کار شامل مراحل زیر است:

- یک تابع Lambda یک اعلان و تکمیل (پاسخ) دریافت می کند و با استفاده از آمازون تایتان از پاسخ تعبیه می شود.

- این تابع فاصله کسینوس یا اقلیدسی بین پاسخ و درخواستهای امتناع موجود در حافظه پنهان را محاسبه میکند.

- تابع این میانگین را به معیارهای CloudWatch ارسال می کند.

یکی دیگر از گزینه استفاده از آن است تطبیق فازی برای یک رویکرد ساده اما کمتر قدرتمند برای مقایسه ردهای شناخته شده با خروجی LLM. رجوع به اسناد پایتون برای مثال

خلاصه

قابلیت مشاهده LLM یک روش حیاتی برای اطمینان از استفاده قابل اعتماد و قابل اعتماد از LLM است. نظارت، درک، و اطمینان از دقت و قابلیت اطمینان LLM ها می تواند به شما در کاهش خطرات مرتبط با این مدل های هوش مصنوعی کمک کند. با نظارت بر توهمات، تکمیلهای بد (پاسخها) و درخواستها، میتوانید مطمئن شوید که LLM شما در مسیر خود باقی میماند و ارزش مورد نظر شما و کاربرانتان را ارائه میکند. در این پست، چند معیار را برای نمایش نمونهها مورد بحث قرار دادیم.

برای کسب اطلاعات بیشتر در مورد ارزیابی مدل های فونداسیون مراجعه کنید از SageMaker Clarify برای ارزیابی مدل های فونداسیون استفاده کنید، و موارد اضافی را مرور کنید نمونه نوت بوک در مخزن GitHub ما موجود است. همچنین میتوانید راههایی را برای عملیاتی کردن ارزیابیهای LLM در مقیاس بزرگ کشف کنید عملیاتی کردن ارزیابی LLM در مقیاس با استفاده از خدمات Amazon SageMaker Clarify و MLOps. در پایان توصیه می کنیم به مدل های زبان بزرگ را از نظر کیفیت و مسئولیت ارزیابی کنید برای کسب اطلاعات بیشتر در مورد ارزیابی LLM.

درباره نویسنده

برونو کلاین یک مهندس ارشد یادگیری ماشین با AWS Professional Services Analytics Practice است. او به مشتریان کمک می کند تا راه حل های کلان داده و تجزیه و تحلیل را پیاده سازی کنند. خارج از محل کار، او از گذراندن وقت با خانواده، مسافرت و امتحان غذای جدید لذت می برد.

برونو کلاین یک مهندس ارشد یادگیری ماشین با AWS Professional Services Analytics Practice است. او به مشتریان کمک می کند تا راه حل های کلان داده و تجزیه و تحلیل را پیاده سازی کنند. خارج از محل کار، او از گذراندن وقت با خانواده، مسافرت و امتحان غذای جدید لذت می برد.

رشابه لوخنده یک مهندس ارشد داده و ML با تمرین تجزیه و تحلیل خدمات حرفه ای AWS است. او به مشتریان کمک می کند تا راه حل های کلان داده، یادگیری ماشین و تجزیه و تحلیل را پیاده سازی کنند. خارج از محل کار، او از گذراندن وقت با خانواده، مطالعه، دویدن و بازی گلف لذت می برد.

رشابه لوخنده یک مهندس ارشد داده و ML با تمرین تجزیه و تحلیل خدمات حرفه ای AWS است. او به مشتریان کمک می کند تا راه حل های کلان داده، یادگیری ماشین و تجزیه و تحلیل را پیاده سازی کنند. خارج از محل کار، او از گذراندن وقت با خانواده، مطالعه، دویدن و بازی گلف لذت می برد.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- : دارد

- :است

- :نه

- :جایی که

- 1

- 100

- 143

- 32

- 455

- 7

- a

- درباره ما

- دقت

- واقعی

- اضافی

- نشانی

- تجمیع

- AI

- دستیار هوش مصنوعی

- مدل های هوش مصنوعی

- اجازه می دهد تا

- همچنین

- هر چند

- am

- آمازون

- درک آمازون

- آمازون کینسیس

- آمازون SageMaker

- آمازون خدمات وب

- an

- تحلیل

- علم تجزیه و تحلیل

- و

- اختلالات

- آنتروپیک

- هر

- کاربرد

- روش

- رویکردها

- معماری

- هستند

- AS

- دستیار

- مرتبط است

- At

- در دسترس

- میانگین

- AWS

- خدمات حرفه ای AWS

- توابع مرحله AWS

- بد

- BE

- شدن

- رفتار

- بودن

- میان

- خارج از

- بزرگ

- بزرگ داده

- هر دو

- اما

- by

- تماس ها

- CAN

- نمی توان

- مورد

- موارد

- محتاط

- به چالش کشیدن

- انتخاب

- طبقه بندی

- نزدیک

- مشترک

- مقايسه كردن

- مقایسه

- اتمام

- پیچیدگی

- درک

- محاسبه

- محاسبه

- محاسبه

- شرایط

- پیکر بندی

- در نظر بگیرید

- ملاحظات

- تشکیل شده است

- محتوا

- زمینه

- ادامه دادن

- گفتگو

- میتوانست

- ایجاد شده

- ایجاد

- بحرانی

- مشتریان

- سفارشی

- داده ها

- ارائه

- نشان دادن

- تشخیص

- پروژه

- تیم توسعه

- نمودار

- مختلف

- بحث کردیم

- فاصله

- do

- دو

- هر

- اثر

- هر دو

- تعبیه کردن

- را قادر می سازد

- را قادر می سازد

- تعامل

- مهندس

- کافی

- اطمینان حاصل شود

- حصول اطمینان از

- ارزیابی

- ارزیابی

- ارزیابی

- ارزیابی

- ارزیابی

- واقعه

- مثال

- مثال ها

- موجود

- انتظارات

- انتظار می رود

- توضیح دهید

- اکتشاف

- خانواده

- کمی از

- رشته

- شکل

- پرونده

- سرانجام

- نام خانوادگی

- ثابت

- پیروی

- غذا

- برای

- پایه

- از جانب

- تابع

- توابع

- اندازه گیری

- می شود

- گرفتن

- GitHub

- گلف

- شدن

- اتفاق می افتد

- مضر

- آیا

- he

- کمک

- مفید

- کمک می کند

- نماد

- صادق

- چگونه

- اما

- HTML

- HTTP

- HTTPS

- i

- شناسایی

- نشان می دهد

- تأثیر

- انجام

- اجرای

- مهم

- بهبود

- in

- شامل

- وارد شونده

- افزایش

- به طور فزاینده

- اطلاعات

- ورودی

- تمامیت

- مورد نظر

- رابط

- به

- معکوس

- فراخوانی میکند

- مسائل

- IT

- ITS

- فرار از زندان

- شغل ها

- JPG

- کلید

- شناخته شده

- عدم

- زبان

- بزرگ

- یاد گرفتن

- یادگیری

- کمتر

- LLM

- به دنبال

- دستگاه

- فراگیری ماشین

- ساخت

- باعث می شود

- مخرب

- بسیاری

- متوسط

- معنی

- اندازه

- حافظه

- پیام

- با

- متری

- متریک

- کاهش

- ML

- MLO ها

- مدل

- مدل

- پیمانهای

- ماژول ها

- ماژول ها

- مانیتور

- نظارت

- نظارت بر

- بیش

- طبیعی

- پردازش زبان طبیعی

- لازم

- جدید

- nlp

- اطلاعیه ها

- اکنون

- of

- توهین آمیز

- پیشنهادات

- غالبا

- on

- ONE

- آنهایی که

- آنلاین

- گزینه

- or

- تنظیم و ارکستراسیون

- ما

- تولید

- خروجی

- خارج از

- به طور کلی

- مروری

- خود

- جفت

- جفت

- بخش

- گذشت

- عبور

- برای

- کارایی

- عبارات

- افلاطون

- هوش داده افلاطون

- PlatoData

- بازی

- ممکن

- پست

- پتانسیل

- قوی

- تمرین

- حضور

- در حال پردازش

- تولید کردن

- حرفه ای

- پرسیدن

- پیشنهاد شده

- ارائه

- فراهم می کند

- پــایتــون

- کیفیت

- به سرعت

- نسبت

- مطالعه

- زمان واقعی

- دریافت

- توصیه

- مراجعه

- امتناع

- رد

- مربوط

- قابلیت اطمینان

- قابل اعتماد

- مخزن

- نشان دادن

- درخواست

- درخواست

- نیاز

- مورد نیاز

- احترام

- قابل احترام

- پاسخ

- پاسخ

- مسئوليت

- انقلابی

- راست

- خطرات

- تنومند

- در حال اجرا

- ایمنی

- حکیم ساز

- نگهداری می شود

- مقیاس پذیر

- مقیاس

- دوم

- بخش

- معنایی

- ارسال

- می فرستد

- ارشد

- حساس

- احساس

- خدمات

- تنظیم

- شیفت

- باید

- نمایشگاه

- سیگنال

- مشابه

- ساده

- اندازه

- راه حل

- مزایا

- برخی از

- فضایی

- خاص

- هزینه

- استاندارد

- گام

- مراحل

- ذخیره سازی

- ساده

- جریان

- چنین

- نشان می دهد

- مطمئن

- خیاط

- گرفتن

- مصرف

- کار

- وظایف

- تیم

- تیم ها

- تکنیک

- متن

- که

- La

- اطلاعات

- شان

- آنها

- آنجا.

- اینها

- آنها

- چیز

- این

- از طریق

- زمان

- تیتان

- به

- TONE

- مسیر

- دگرگون کردن

- ترجمه

- سفر

- قابل اعتماد

- تلاش

- دو

- درک

- غیر منتظره

- استفاده کنید

- استفاده

- کاربر

- رابط کاربری

- کاربران

- با استفاده از

- ارزش

- ارزشها

- از طريق

- دید

- مسیر..

- راه

- we

- وب

- خدمات وب

- چی

- چه شده است

- چه زمانی

- در حالیکه

- که

- چرا

- ویکیپدیا

- با

- مهاجرت کاری

- گردش کار

- شما

- شما

- زفیرنت