معرفی

در یادگیری ماشین، مبادله بایاس واریانس یک مفهوم اساسی است که بر عملکرد هر مدل پیشبینیکننده تأثیر میگذارد. این به تعادل ظریف بین خطای سوگیری و خطای واریانس یک مدل اشاره دارد، زیرا به حداقل رساندن هر دو به طور همزمان غیرممکن است. ایجاد تعادل مناسب برای دستیابی به عملکرد مطلوب مدل بسیار مهم است.

در این مقاله کوتاه، سوگیری و واریانس را تعریف میکنیم، توضیح میدهیم که چگونه بر مدل یادگیری ماشین تأثیر میگذارند، و توصیههای عملی در مورد نحوه برخورد با آنها در عمل ارائه میکنیم.

درک تعصب و واریانس

قبل از پرداختن به رابطه بین سوگیری و واریانس، اجازه دهید تعریف کنیم که این اصطلاحات در یادگیری ماشین چه چیزی را نشان می دهند.

خطای سوگیری به تفاوت بین پیش بینی یک مدل و مقادیر صحیحی که سعی در پیش بینی آن دارد (واقعیت زمین) اشاره دارد. به عبارت دیگر، سوگیری خطایی است که یک مدل به دلیل مفروضات نادرست خود در مورد توزیع داده های اساسی مرتکب می شود. مدلهای بایاس بالا اغلب خیلی سادهاند و نمیتوانند پیچیدگی دادهها را به تصویر بکشند و منجر به عدم تناسب میشوند.

از سوی دیگر، خطای واریانس به حساسیت مدل نسبت به نوسانات کوچک در داده های آموزشی اشاره دارد. مدلهای واریانس بالا بیش از حد پیچیده هستند و تمایل دارند به جای الگوی اساسی، نویز را در دادهها منطبق کنند، که منجر به بیش از حد برازش میشود. این منجر به عملکرد ضعیف در داده های جدید و نادیده می شود.

تعصب زیاد میتواند منجر به عدم تناسب شود، جایی که مدل برای ثبت پیچیدگی دادهها بسیار ساده است. در مورد داده ها مفروضات قوی ایجاد می کند و نمی تواند رابطه واقعی بین متغیرهای ورودی و خروجی را بدست آورد. از سوی دیگر، واریانس بالا می تواند منجر به بیش از حد برازش شود، جایی که مدل بسیار پیچیده است و نویز در داده ها را به جای رابطه اساسی بین متغیرهای ورودی و خروجی یاد می گیرد. بنابراین، مدلهای بیشبرازش تمایل دارند با دادههای آموزشی خیلی نزدیک برازش کنند و به خوبی به دادههای جدید تعمیم نخواهند داد، در حالی که مدلهای کمبرازش حتی قادر به برازش دقیق دادههای آموزشی نیستند.

همانطور که قبلا ذکر شد، سوگیری و واریانس با هم مرتبط هستند و یک مدل خوب بین خطای بایاس و خطای واریانس تعادل برقرار می کند. مبادله بایاس واریانس فرآیند یافتن تعادل بهینه بین این دو منبع خطا است. مدلی با بایاس کم و واریانس کم احتمالاً هم در آموزش و هم در داده های جدید عملکرد خوبی خواهد داشت و کل خطا را به حداقل می رساند.

معاوضه تعصب-واریانس

دستیابی به تعادل بین پیچیدگی مدل و توانایی آن برای تعمیم به داده های ناشناخته، هسته اصلی مبادله بایاس واریانس است. به طور کلی، یک مدل پیچیده تر بایاس کمتر اما واریانس بالاتری خواهد داشت، در حالی که مدل ساده تر سوگیری بالاتر اما واریانس کمتری خواهد داشت.

از آنجایی که به حداقل رساندن سوگیری و واریانس به طور همزمان غیرممکن است، یافتن تعادل بهینه بین آنها در ساخت یک مدل یادگیری ماشینی قوی بسیار مهم است. به عنوان مثال، با افزایش پیچیدگی یک مدل، واریانس را نیز افزایش می دهیم. این به این دلیل است که یک مدل پیچیدهتر به احتمال زیاد با نویز در دادههای آموزشی مطابقت دارد که منجر به بیش از حد برازش میشود.

از طرف دیگر، اگر مدل را خیلی ساده نگه داریم، سوگیری را افزایش خواهیم داد. این به این دلیل است که یک مدل سادهتر نمیتواند روابط زیربنایی را در دادهها ثبت کند، که منجر به عدم تناسب میشود.

هدف آموزش مدلی است که به اندازه کافی پیچیده باشد تا بتواند روابط زیربنایی در داده های آموزشی را به تصویر بکشد، اما نه آنقدر پیچیده که با نویز داده های آموزشی مطابقت داشته باشد.

معاوضه بایاس-واریانس در عمل

برای تشخیص عملکرد مدل، ما معمولاً خطاهای قطار و اعتبارسنجی را محاسبه و مقایسه میکنیم. یک ابزار مفید برای تجسم این، نمودار منحنیهای یادگیری است که عملکرد مدل را در قطار و دادههای اعتبارسنجی در طول فرآیند آموزش نمایش میدهد. با بررسی این منحنی ها، می توان تعیین کرد که آیا یک مدل بیش از حد برازش (واریانس بالا)، عدم تناسب (بایاس زیاد)، یا مناسب (تعادل بهینه بین بایاس و واریانس) است.

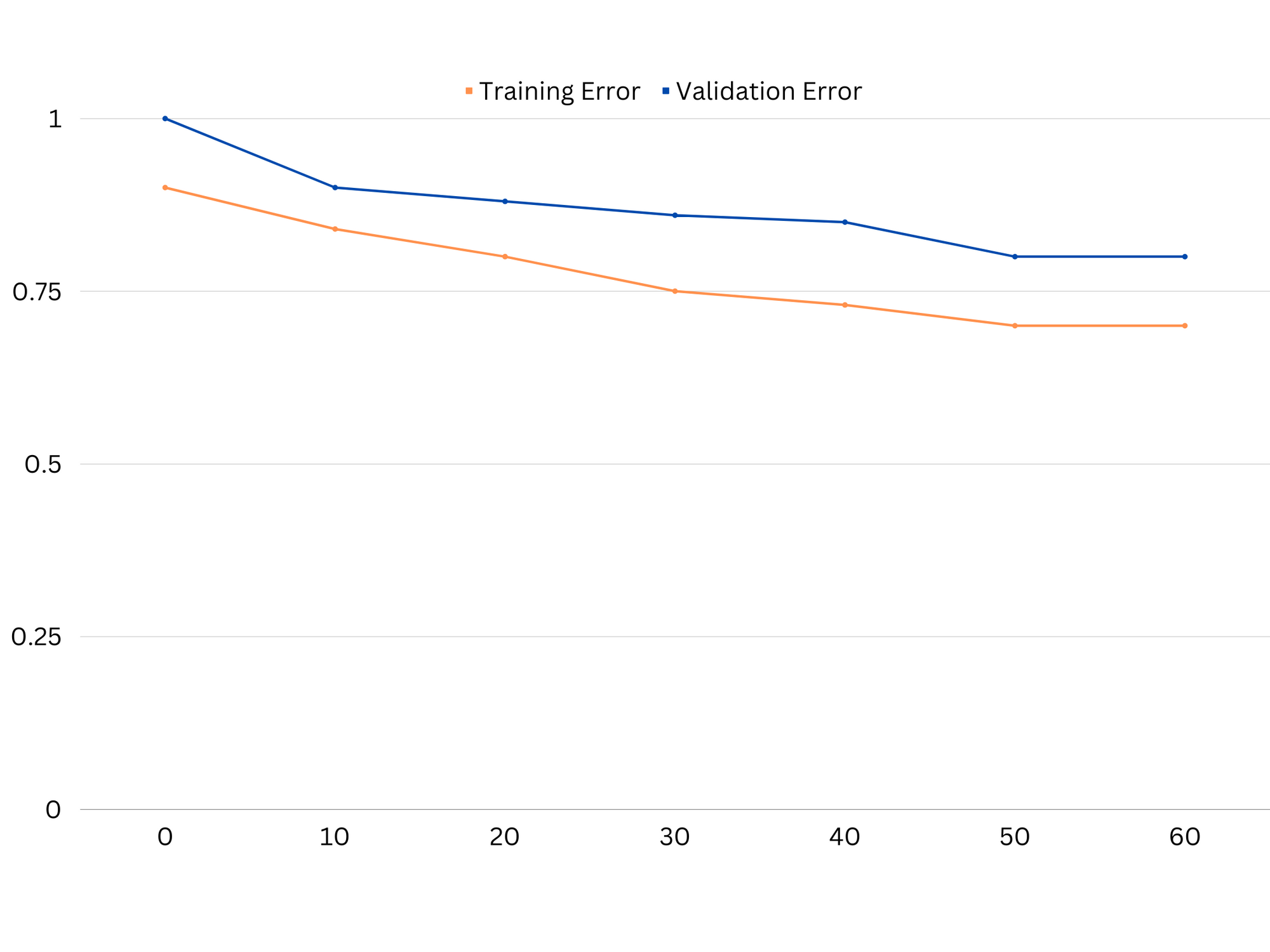

نمونه ای از منحنی های یادگیری یک مدل زیر برازش. هم خطای قطار و هم خطای اعتبارسنجی زیاد است.

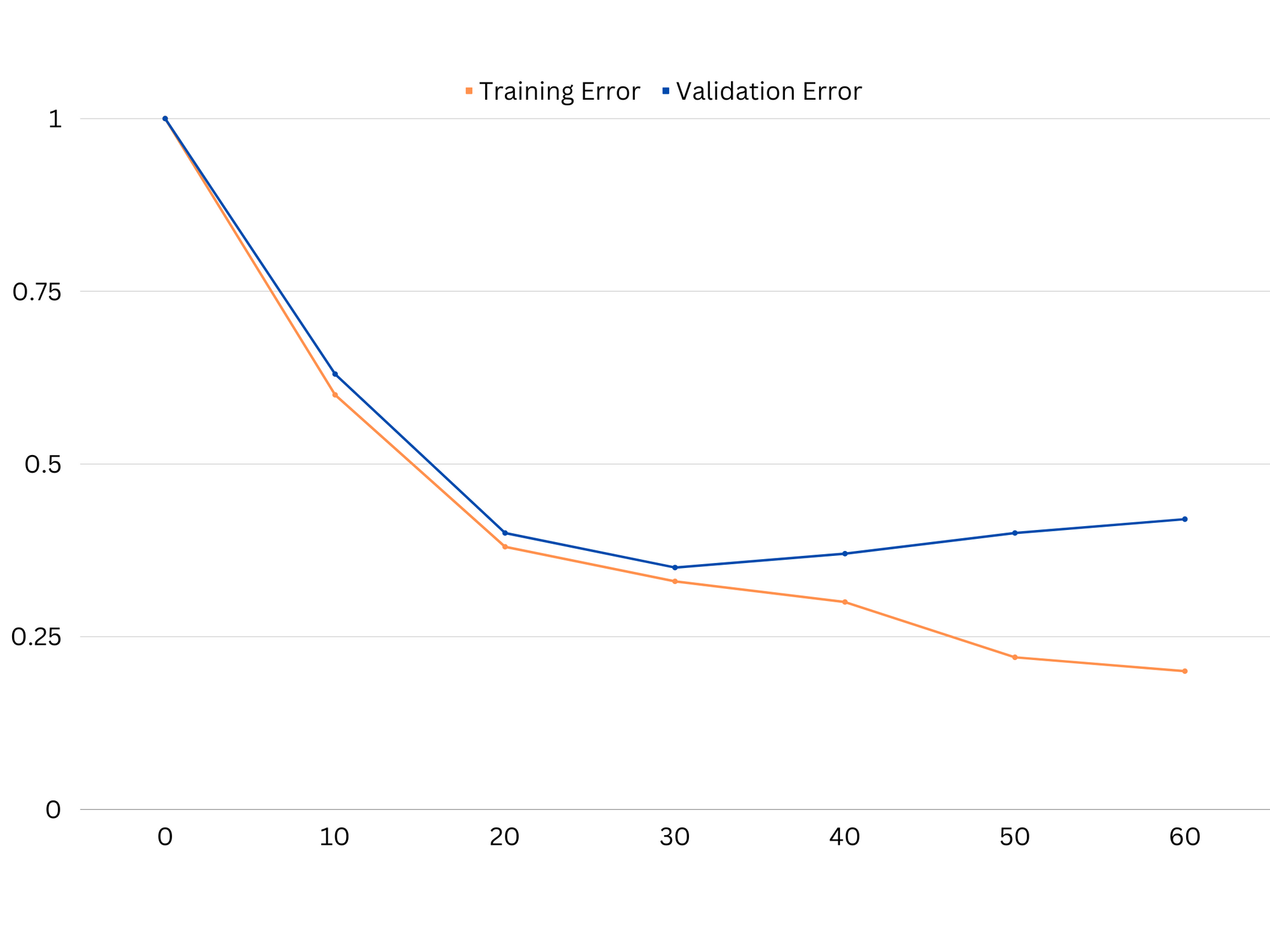

در عمل، عملکرد پایین در دادههای آموزشی و اعتبارسنجی نشان میدهد که مدل بسیار ساده است و منجر به عدم تناسب میشود. از سوی دیگر، اگر مدل در دادههای آموزشی بسیار خوب عمل کند اما در دادههای آزمایش ضعیف باشد، احتمالاً پیچیدگی مدل بسیار زیاد است و در نتیجه بیش از حد برازش میشود. برای رفع کمبود، میتوانیم با افزودن ویژگیهای بیشتر، تغییر الگوریتم یادگیری یا انتخاب فراپارامترهای مختلف، پیچیدگی مدل را افزایش دهیم. در مورد برازش بیش از حد، باید منظم کردن مدل یا استفاده از تکنیکهایی مانند اعتبارسنجی متقابل برای بهبود قابلیتهای تعمیم آن را در نظر بگیریم.

نمونه ای از منحنی های یادگیری یک مدل بیش از حد برازش. خطای قطار کاهش می یابد در حالی که خطای اعتبار سنجی شروع به افزایش می کند. مدل قادر به تعمیم نیست.

منظمسازی تکنیکی است که میتواند برای کاهش خطای واریانس در مدلهای یادگیری ماشین مورد استفاده قرار گیرد و به پرداختن به مبادله بایاس واریانس کمک کند. تعدادی از تکنیک های منظم سازی مختلف وجود دارد که هر کدام مزایا و معایب خاص خود را دارند. برخی از تکنیکهای منظمسازی رایج عبارتند از رگرسیون رج، رگرسیون کمند و منظمسازی شبکه الاستیک. همه این تکنیکها با افزودن یک عبارت جریمه به تابع هدف مدل، که از مقادیر شدید پارامتر جلوگیری میکند و مدلهای سادهتر را تشویق میکند، به جلوگیری از برازش بیش از حد کمک میکند.

رگرسیون ریج، همچنین به عنوان منظم سازی L2 شناخته می شود، یک جریمه متناسب با مجذور پارامترهای مدل اضافه می کند. این تکنیک منجر به مدل هایی با مقادیر پارامتر کوچکتر می شود که می تواند منجر به کاهش واریانس و بهبود تعمیم شود. با این حال، انتخاب ویژگی را انجام نمی دهد، بنابراین همه ویژگی ها در مدل باقی می مانند.

راهنمای عملی و عملی ما برای یادگیری Git را با بهترین روش ها، استانداردهای پذیرفته شده در صنعت و برگه تقلب شامل بررسی کنید. دستورات Google Git را متوقف کنید و در واقع یاد گرفتن آی تی!

رگرسیون کمند، یا منظم سازی L1، یک عبارت جریمه متناسب با مقدار مطلق پارامترهای مدل اضافه می کند. این تکنیک میتواند منجر به مدلهایی با مقادیر پارامتر پراکنده شود که با صفر کردن برخی از پارامترها، به طور موثر انتخاب ویژگی را انجام میدهند. این می تواند منجر به مدل های ساده تری شود که تفسیر آنها آسان تر است.

منظم سازی توری الاستیک ترکیبی از هر دو تنظیم L1 و L2 است که امکان تعادل بین رگرسیون رج و کمند را فراهم می کند. با کنترل نسبت بین دو عبارت پنالتی، توری الاستیک می تواند به مزایای هر دو تکنیک، مانند تعمیم بهبود یافته و انتخاب ویژگی دست یابد.

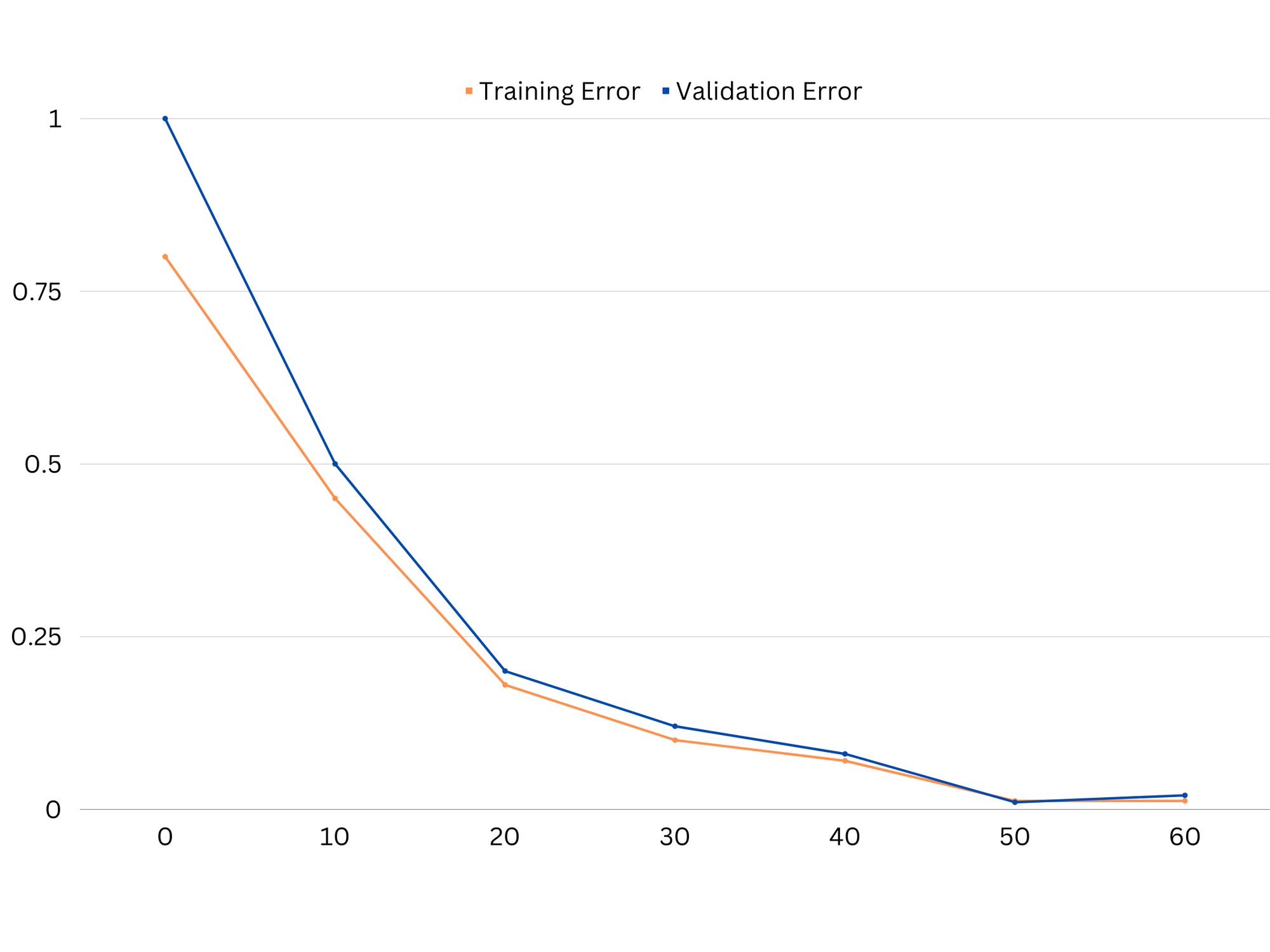

نمونه ای از منحنی های یادگیری مدل برازش خوب.

نتیجه گیری

مبادله بایاس واریانس یک مفهوم مهم در یادگیری ماشینی است که اثربخشی و خوبی یک مدل را تعیین می کند. در حالی که سوگیری زیاد منجر به عدم تناسب و واریانس بالا منجر به بیش از حد برازش میشود، یافتن تعادل بهینه بین این دو برای ساخت مدلهای قوی که به خوبی به دادههای جدید تعمیم میدهند، ضروری است.

با کمک منحنیهای یادگیری، میتوان مشکلات بیشبرازش یا عدم تناسب را شناسایی کرد و با تنظیم پیچیدگی مدل یا اجرای تکنیکهای منظمسازی، میتوان عملکرد هم در دادههای آموزشی و اعتبارسنجی و هم دادههای تست را بهبود بخشید.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoAiStream. Web3 Data Intelligence دانش تقویت شده دسترسی به اینجا.

- ضرب کردن آینده با آدرین اشلی. دسترسی به اینجا.

- خرید و فروش سهام در شرکت های PRE-IPO با PREIPO®. دسترسی به اینجا.

- منبع: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :است

- :نه

- :جایی که

- 1

- 12

- 20

- 8

- a

- توانایی

- قادر

- درباره ما

- مطلق

- به درستی

- رسیدن

- دستیابی به

- واقعا

- اضافه کردن

- نشانی

- می افزاید:

- مزایای

- نصیحت

- اثر

- موثر بر

- الگوریتم

- معرفی

- اجازه دادن

- همچنین

- an

- و

- هر

- هستند

- مقاله

- AS

- برج میزان

- تعادل

- BE

- زیرا

- مزایای

- میان

- تعصب

- مرز

- هر دو

- بنا

- اما

- by

- محاسبه

- CAN

- قابلیت های

- گرفتن

- مورد

- متغیر

- انتخاب

- نزدیک

- ترکیب

- مقايسه كردن

- پیچیده

- پیچیدگی

- مفهوم

- در نظر بگیرید

- کنترل

- هسته

- اصلاح

- بسیار سخت

- داده ها

- مقدار

- کاهش می دهد

- مشخص کردن

- تعیین می کند

- تفاوت

- مختلف

- صفحه نمایش

- توزیع

- میکند

- دو

- هر

- پیش از آن

- آسان تر

- به طور موثر

- اثر

- تشویق می کند

- کافی

- خطا

- خطاهای

- حتی

- در حال بررسی

- مثال

- توضیح دهید

- مفرط

- عدم

- نتواند

- ویژگی

- امکانات

- پیدا کردن

- مناسب

- مناسب

- نوسانات

- تمرکز

- برای

- تابع

- اساسی

- سوالات عمومی

- رفتن

- هدف

- خوب

- زمین

- راهنمایی

- دست

- دست

- آیا

- کمک

- کمک

- زیاد

- بالاتر

- در تردید بودن

- چگونه

- چگونه

- اما

- HTTPS

- شناسایی

- if

- اجرای

- غیر ممکن

- بهبود

- بهبود یافته

- in

- در دیگر

- شامل

- مشمول

- افزایش

- افزایش

- ورودی

- به

- معرفی

- IT

- ITS

- نگاه داشتن

- شناخته شده

- L1

- l2

- رهبری

- برجسته

- منجر می شود

- یادگیری

- اجازه

- LG

- پسندیدن

- احتمالا

- ll

- کم

- کاهش

- دستگاه

- فراگیری ماشین

- باعث می شود

- ذکر شده

- به حداقل رساندن

- مدل

- مدل

- بیش

- لازم

- خالص

- جدید

- سر و صدا

- عدد

- هدف

- of

- غالبا

- on

- بهینه

- or

- دیگر

- ما

- خارج

- تولید

- خود

- پارامتر

- پارامترهای

- الگو

- انجام

- کارایی

- انجام

- انجام می دهد

- افلاطون

- هوش داده افلاطون

- PlatoData

- فقیر

- محبوب

- ممکن

- عملی

- تمرین

- پیش بینی

- پیش گویی

- جلوگیری از

- مشکلات

- روند

- ارائه

- نسبتا

- نسبت

- كاهش دادن

- کاهش

- اشاره دارد

- مربوط

- ارتباط

- روابط

- ماندن

- نشان دادن

- نتیجه

- نتیجه

- نتایج

- راست

- حلقه

- تنومند

- s

- انتخاب

- حساسیت

- محیط

- سایه

- ورق

- کوتاه

- باید

- ساده

- به طور همزمان

- کوچک

- کوچکتر

- So

- برخی از

- منابع

- مربع

- Stackabuse

- استانداردهای

- توقف

- قوی

- چنین

- حاکی از

- تکنیک

- مدت

- قوانین و مقررات

- آزمون

- نسبت به

- که

- La

- شان

- آنها

- آنجا.

- اینها

- آنها

- این

- سراسر

- به

- هم

- ابزار

- جمع

- قطار

- آموزش

- انتقال

- درست

- حقیقت

- امتحان

- دو

- به طور معمول

- ناتوان

- اساسی

- ناشناخته

- استفاده

- با استفاده از

- اعتبار سنجی

- ارزش

- ارزشها

- بسیار

- we

- خوب

- چی

- چه

- که

- در حین

- اراده

- با

- کلمات

- زفیرنت

- صفر