Monet AWS-asiakkaamme tarjoavat palveluna tutkimusta, analytiikkaa ja business intelligencea. Tämäntyyppisen tutkimuksen ja liiketoimintatiedon avulla loppuasiakkaat voivat pysyä markkinoiden ja kilpailijoiden edellä, tunnistaa kasvumahdollisuuksia ja käsitellä ongelmia ennakoivasti. Jotkut finanssipalvelualan asiakkaistamme esimerkiksi tekevät tutkimusta osakkeille, hedge-rahastoille ja sijoitusrahastoyhtiöille auttaakseen heitä ymmärtämään trendejä ja tunnistamaan portfoliostrategioita. Terveysalalla yhä suurempi osa terveystutkimuksesta on nykyään tietopohjaista. Suuri osa tutkimuksesta sisältää sellaisen tiedon analysointia, joka alun perin kerättiin diagnostiikkaa, hoitoa tai muita tutkimusprojekteja varten ja jota käytetään nyt uusiin tutkimustarkoituksiin. Nämä terveystutkimuksen muodot ovat johtaneet tehokkaaseen primaariseen ennaltaehkäisyyn uusien tapausten välttämiseksi, sekundaariseen ennaltaehkäisyyn varhaisen havaitsemisen varmistamiseksi ja ennaltaehkäisyyn parantamaan tautien hallintaa. Tutkimustulokset paitsi parantavat elämänlaatua, myös auttavat vähentämään terveydenhuoltokuluja.

Asiakkailla on tapana sulattaa tiedot julkisista ja yksityisistä lähteistä. Sitten he soveltavat vakiintuneita tai mukautettuja luonnollisen kielen käsittelymalleja (NLP) tehdäkseen yhteenvedon ja tunnistaakseen trendin ja luodakseen oivalluksia näiden tietojen perusteella. Tällaisissa tutkimustehtävissä käytetyt NLP-mallit käsittelevät suuria malleja ja sisältävät yleensä pitkiä artikkeleita, joista tehdään yhteenveto korpuksen koon mukaan – ja omistettuja päätepisteitä, joita ei tällä hetkellä ole kustannusoptimoitu. Nämä sovellukset vastaanottavat saapuvan liikenteen purskeen eri vuorokaudenaikoina.

Uskomme, että asiakkaat hyötyisivät suuresti mahdollisuudesta skaalata nollaan ja lisätä päättelykykyään tarpeen mukaan. Tämä optimoi tutkimuskustannukset, eikä silti vaaranna päätelmien laatua. Tämä viesti käsittelee Hugging Facea yhdessä Amazon Sage Maker asynkroninen päättely voi auttaa saavuttamaan tämän.

Voit rakentaa tekstin yhteenvetomalleja useilla syväoppimiskehyksillä, kuten TensorFlow, PyTorch ja Apache MXNet. Näissä malleissa on tyypillisesti suuri syöttökuorma useita erikokoisia tekstiasiakirjoja. Kehittyneet syväoppimismallit vaativat laskentaintensiivistä esikäsittelyä ennen mallin päättelyä. Käsittelyajat voivat olla jopa muutaman minuutin pitkiä, mikä poistaa mahdollisuuden suorittaa reaaliaikaisia päätelmiä siirtämällä hyötykuormia HTTP API:n kautta. Sen sijaan sinun on käsiteltävä syöttöhyötykuormia asynkronisesti objektivarastosta, kuten Amazonin yksinkertainen tallennuspalvelu (Amazon S3), jossa on automaattinen jonotus ja ennalta määritetty samanaikaisuuskynnys. Järjestelmän pitäisi pystyä vastaanottamaan tilailmoituksia ja vähentämään tarpeettomia kustannuksia puhdistamalla resursseja tehtävien valmistuttua.

SageMaker auttaa datatieteilijöitä ja kehittäjiä valmistelemaan, rakentamaan, kouluttamaan ja ottamaan käyttöön korkealaatuisia koneoppimismalleja (ML) nopeasti yhdistämällä laajan joukon ML:tä varten suunniteltuja ominaisuuksia. SageMaker tarjoaa edistyneimmät avoimen lähdekoodin mallin palvelevat säilöt XGBoostille (astia, SDK), Scikit-Learn (astia, SDK), PyTorch (astia, SDK), TensorFlow (astia, SDK) ja Apache MXNet (astia, SDK).

- Reaaliaikainen päätelmä päätepisteet sopivat työkuormille, jotka on käsiteltävä pienillä latenssivaatimuksilla ms:n tai sekuntien luokkaa.

- Erämuunnos sopii erinomaisesti suurten tietoerien offline-ennusteisiin.

- Amazon SageMaker -palvelimeton johtopäätös (esikatselutilassa, eikä tätä kirjoitettaessa suositella tuotannollisiin työmääriin) on tarkoitukseen rakennettu päättelyvaihtoehto, jonka avulla ML-mallien käyttöönotto ja skaalaaminen on helppoa. Serverless Inference on ihanteellinen työkuormille, joissa on joutojaksoja liikennespurttien välillä ja jotka kestävät kylmäkäynnistystä.

- Asynkroninen päättely päätepisteet jonottavat saapuvia pyyntöjä. Ne sopivat ihanteellisesti työkuormille, joissa pyyntökoot ovat suuria (jopa 1 Gt) ja päätelmien käsittelyajat ovat minuuttien luokkaa (jopa 15 minuuttia). Asynkronisen päättelyn avulla voit säästää kustannuksissa skaalaamalla ilmentymien määrän automaattisesti nollaan, kun käsiteltäviä pyyntöjä ei ole.

Ratkaisun yleiskatsaus

Tässä viestissä otamme käyttöön a PEGASUS malli joka oli valmiiksi koulutettu tekemään tekstin yhteenveto Halaaminen kasvot että SageMaker-isännöintipalvelut. Käytämme Hugging Facen mallia yksinkertaisuuden vuoksi. Voit kuitenkin hienosäätää mallia mukautetun tietojoukon perusteella. Voit myös kokeilla muita mallissa saatavilla olevia malleja Halaava Face Model Hub. Tarjoamme myös tätä mallia isännöivän asynkronisen päättelypäätepisteen, josta voit saada ennusteita.

Asynkronisen päättelyn päätepisteen päätelmien käsittelijä odottaa artikkelin syöttöhyötykuormana. Artikkelin tiivistetty teksti on tulos. Tulos tallennetaan tietokantaan trendien analysointia varten tai syötetään myöhempään analyysiin. Tämä loppupään analyysi saa tietoa oivalluksista, jotka auttavat tutkimuksessa.

Osoitamme, kuinka asynkroniset päättelypäätepisteet mahdollistavat käyttäjän määrittämät samanaikaisuus- ja valmistumisilmoitukset. Määritämme päätepisteen takana olevien ilmentymien automaattisen skaalauksen skaalaamaan nollaan, kun liikenne vähenee, ja skaalaamaan takaisin, kun pyyntöjono täyttyy.

Käytämme myös amazonin pilvikello mittareita, joilla seurataan jonon kokoa, kokonaiskäsittelyaikaa ja käsiteltyjä kutsuja.

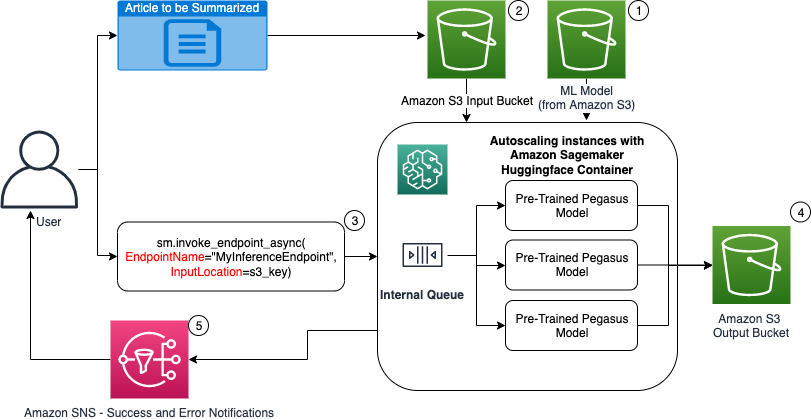

Seuraavassa kaaviossa näytämme vaiheet, jotka liittyvät päättelyyn asynkronisen päättelyn päätepisteen avulla.

- Meidän esikoulutettu PEGASUS ML-mallia isännöidään ensin skaalauspäätepisteessä.

- Käyttäjä lataa yhteenvedon tekevän artikkelin syöte-S3-ämpäriin.

- Asynkroninen päättelypäätepiste kutsutaan API:n avulla.

- Kun päättely on valmis, tulos tallennetaan lähtöön S3.

- An Amazonin yksinkertainen ilmoituspalvelu (Amazon SNS) -ilmoitus lähetetään käyttäjälle, joka ilmoittaa suoritetusta onnistumisesta tai epäonnistumisesta.

Luo asynkroninen päättelypäätepiste

Luomme asynkronisen päätepäätepisteen, joka on samanlainen kuin reaaliaikainen isännöity päätepiste. Vaiheisiin kuuluu SageMaker-mallin luominen, jota seuraa päätepisteen määrittäminen ja päätepisteen käyttöönotto. Ero näiden kahden tyyppisten päätepisteiden välillä on, että asynkronisen päättelyn päätepisteen konfiguraatio sisältää an AsyncInferenceConfig -osio. Tässä määritämme S3-tulospolun päätepistekutsun tuloksille ja sisällytämme valinnaisesti SNS-aiheita onnistumis- ja epäonnistumisilmoituksiin. Määritämme myös asiakkaan määrittämän samanaikaisten kutsujen enimmäismäärän esiintymää kohden. Katso seuraava koodi:

Katso lisätietoja API:sta, jolla luodaan päätepistekonfiguraatio asynkronista päättelyä varten Luo asynkroninen päättelypäätepiste.

Kutsu asynkroninen päättelypäätepiste

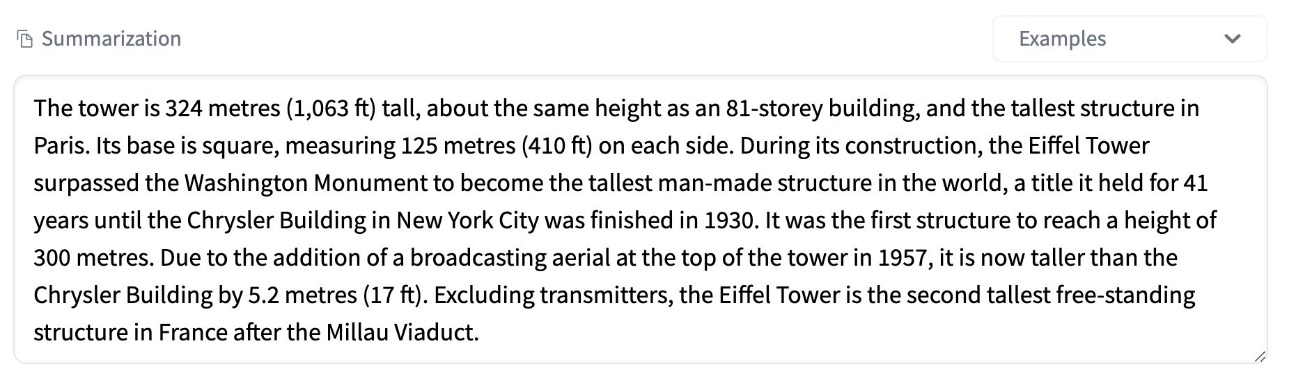

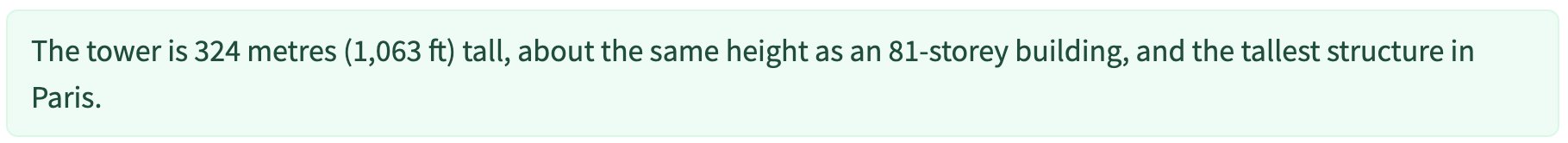

Seuraava kuvakaappaus näyttää lyhyen artikkelin, jota käytämme syöttöhyötykuormanamme:

Seuraava koodi lataa artikkelin muodossa input.json tiedosto Amazon S3:lle:

Käytämme Amazon S3 URI:tä syötettävään hyötykuormatiedostoon päätepisteen kutsumiseksi. Vastausobjekti sisältää tulossijainnin Amazon S3:ssa tulosten hakemiseksi valmistumisen jälkeen:

Seuraavassa kuvakaappauksessa näkyy näytetulosteen yhteenveto:

Katso lisätietoja sovellusliittymästä asynkronisen päättelyn päätepisteen kutsumiseksi Kutsu asynkroninen päättelypäätepiste.

Aseta kutsupyynnöt jonoon käyttäjän määrittelemällä samanaikaisuudella

Asynkronisen päättelyn päätepiste asettaa kutsupyynnöt automaattisesti jonoon. Tämä on täysin hallittu jono, jossa on erilaisia seurantamittareita, eikä se vaadi lisämäärityksiä. Se käyttää MaxConcurrentInvocationsPerInstance parametri edellisessä päätepisteen kokoonpanossa käsittelemään uusia pyyntöjä jonosta sen jälkeen, kun aiemmat pyynnöt on suoritettu. MaxConcurrentInvocationsPerInstance on SageMaker-asiakkaan mallisäiliöön lähettämien samanaikaisten pyyntöjen enimmäismäärä. Jos arvoa ei anneta, SageMaker valitsee sinulle optimaalisen arvon.

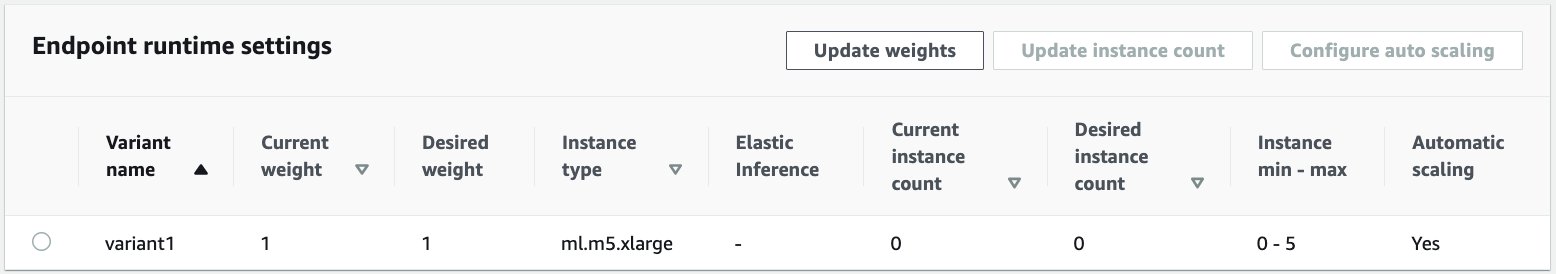

Automaattinen skaalaus esiintymissä asynkronisen päättelyn päätepisteessä

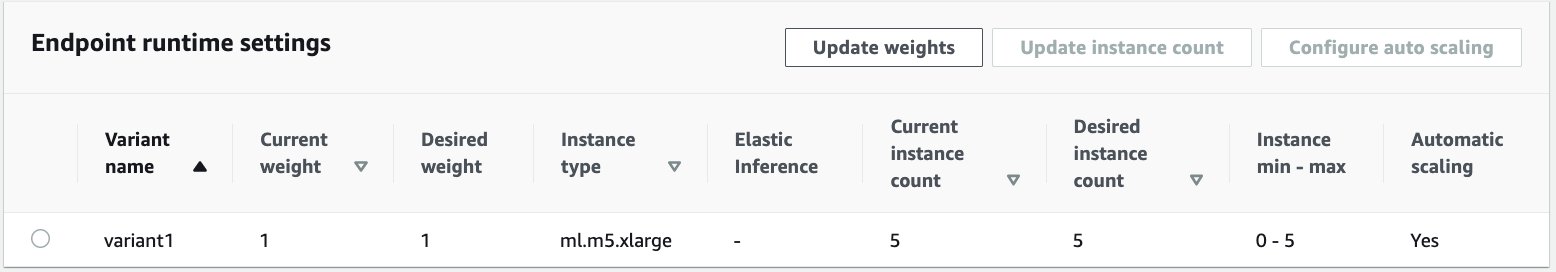

Asetamme automaattisen skaalauskäytännön vähimmäiskapasiteetiksi nolla ja enimmäiskapasiteetiksi viiteen esiintymään. Toisin kuin reaaliaikaiset isännöidyt päätepisteet, asynkroniset päättelypäätepisteet tukevat ilmentymien skaalausta nollaan asettamalla vähimmäiskapasiteetiksi nollaan. Käytämme ApproximateBacklogSizePerInstance metriikka skaalauskäytännön kokoonpanolle, jossa on viisi kohdejonoa esiintymää kohden skaalauksen lisäämiseksi. Asetamme jäähtymisjakson ScaleInCooldown 120 sekuntiin ja ScaleOutCooldown 120 sekuntiin. Arvo for ApproximateBacklogSizePerInstance valitaan liikenteen ja herkkyytesi skaalausnopeudelle perusteella. Mitä nopeammin skaalaat, sitä vähemmän kustannuksia sinulle aiheutuu, mutta sitä todennäköisemmin joudut skaalaamaan uudelleen, kun uusia pyyntöjä saapuu. Mitä hitaammin skaalaat, sitä enemmän kustannuksia sinulle aiheutuu, mutta sitä vähemmän todennäköisesti pyyntö tulee, kun olet alimitoitettu.

Lisätietoja asynkronisen päättelyn päätepisteen automaattisesta skaalauksesta API:sta on kohdassa Skaalaa automaattisesti asynkronisen päättelyn päätepisteen.

Määritä ilmoitukset asynkronisesta päättelypäätepisteestä

Luomme kaksi erillistä SNS-aihetta onnistumis- ja virheilmoituksia varten kullekin päätepisteen kutsun tulokselle:

Muita ilmoitusvaihtoehtoja ovat S3-säihön lähdön säännöllinen tarkistaminen tai S3-säilö-ilmoitusten käyttäminen AWS Lambda toiminto tiedoston latauksessa. SNS-ilmoitukset sisältyvät päätepisteen määritysosaan, kuten aiemmin on kuvattu.

Lisätietoja ilmoitusten määrittämisestä asynkronisesta päätepisteestä on kohdassa Tarkista ennusteiden tulokset.

Tarkkaile asynkronista päättelypäätepistettä

Valvomme asynkronisen päättelyn päätepistettä sisäänrakennetuilla CloudWatch-lisämittareilla, jotka ovat ominaisia asynkronisille päätelmille. Esimerkiksi seuraamme jonon pituutta kussakin tapauksessa ApproximateBacklogSizePerInstance ja jonon kokonaispituus ApproximateBacklogSize.

Täydellinen luettelo mittareista on kohdassa Asynkronisten päätelmien päätepisteiden seuranta.

Voimme optimoida päätepisteen kokoonpanon saadaksemme kustannustehokkaimman esiintymän korkealla suorituskyvyllä. Voimme esimerkiksi käyttää ilmentymää Amazon Elastic Inferencen tai AWS Inferentian kanssa. Voimme myös asteittain nostaa samanaikaisuustasoa suorituskyvyn huippuun asti samalla kun säädämme muita mallipalvelin- ja säilöparametreja.

CloudWatch-kaaviot

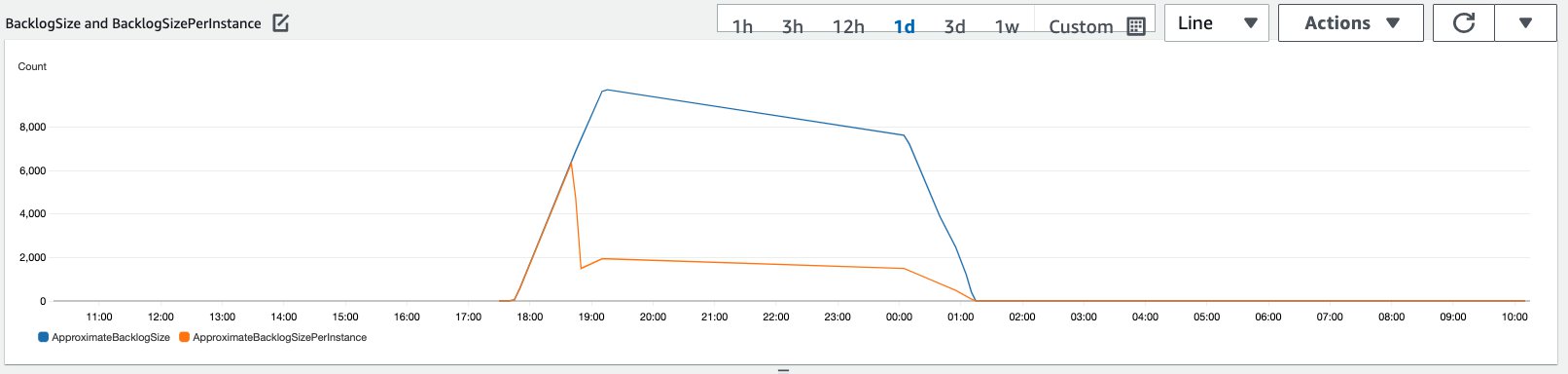

Simuloimme 10,000 XNUMX päättelypyynnön liikennettä, jotka virtasivat tietyn ajanjakson aikana asynkroniseen päättelypäätepisteeseen, joka on otettu käyttöön edellisessä osiossa kuvatulla automaattisella skaalauskäytännöllä.

Seuraavassa kuvakaappauksessa näkyy ilmentymien mittareita ennen kuin pyyntöjä alettiin virrata. Aloitamme reaaliaikaisesta päätepisteestä, jossa ei ole käynnissä esiintymiä:

Seuraava kaavio näyttää, kuinka BacklogSize ja BacklogSizePerInstance mittarit muuttuvat, kun automaattinen skaalaus käynnistyy ja päätepisteen kuormitus jaetaan useiden esiintymien kesken, jotka on määritetty osana automaattista skaalausprosessia.

Kuten seuraavassa kuvakaappauksessa näkyy, esiintymien määrä kasvoi päätelmien määrän kasvaessa:

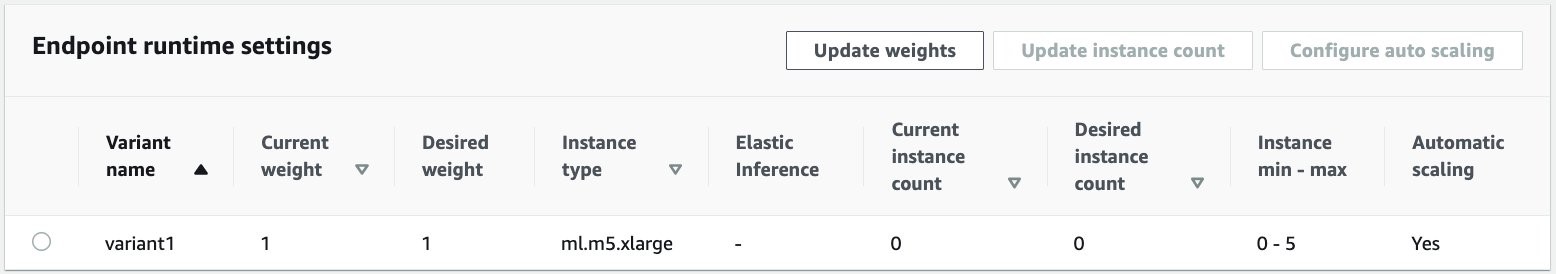

Seuraavassa kuvakaappauksessa näkyy, kuinka skaalaus tuo päätepisteen takaisin nollan käynnissä olevan ilmentymän alkutilaan:

Puhdistaa

Kun kaikki pyynnöt on suoritettu, voimme poistaa päätepisteen samalla tavalla kuin reaaliaikaisten isännöityjen päätepisteiden poistaminen. Huomaa, että jos asetamme asynkronisten päätepisteiden vähimmäiskapasiteetin nollaan, esiintymismaksuja ei synny sen jälkeen, kun se skaalautuu nollaan.

Jos olet ottanut käyttöön päätepisteen automaattisen skaalauksen, varmista, että poistat päätepisteen rekisteröinnin skaalautuvaksi kohteeksi ennen päätepisteen poistamista. Voit tehdä tämän suorittamalla seuraavan koodin:

Muista poistaa päätepisteesi käytön jälkeen, sillä sinua veloitetaan tässä esittelyssä käytetyistä esiintymistä.

Sinun on myös poistettava S3-objektit ja SNS-aiheet. Jos loit muita AWS-resursseja kuluttaaksesi ja toimiaksesi SNS-ilmoitusten kanssa, voit myös poistaa ne.

Yhteenveto

Tässä viestissä osoitimme, kuinka SageMakerin uutta asynkronista päättelykykyä käytetään käsittelemään tyypillistä suurta syöttöhyötykuormaa, joka on osa yhteenvetotehtävää. Päätelmien tekemiseen käytimme Hugging Facen mallia ja käytimme sitä asynkroniseen päättelypäätepisteeseen. Selitimme purskeliikenteen, mallien korkeiden käsittelyaikojen ja tutkimusanalytiikkaan liittyvien suurten hyötykuormien yhteiset haasteet. Asynkronisen päättelyn päätepisteen luontainen kyky hallita sisäisiä jonoja, ennalta määritettyjä samanaikaisuusrajoja, määrittää vastausilmoituksia ja skaalata automaattisesti nollaan auttoi meitä vastaamaan näihin haasteisiin. Tämän esimerkin täydellinen koodi on saatavilla osoitteessa GitHub.

Aloita SageMakerin asynkronisen päättelyn käyttäminen tutustumalla Asynkroninen päättely.

Tietoja Tekijät

Dinesh Kumar Subramani on vanhempi ratkaisuarkkitehti UKIR SMB -tiimissä Edinburghissa Skotlannissa. Hän on erikoistunut tekoälyyn ja koneoppimiseen. Dinesh nauttii työskentelystä asiakkaiden kanssa eri toimialoilla auttaakseen heitä ratkaisemaan ongelmansa AWS-palveluiden kanssa. Työn ulkopuolella hän rakastaa viettää aikaa perheensä kanssa, pelata shakkia ja nauttia musiikista eri genreissä.

Dinesh Kumar Subramani on vanhempi ratkaisuarkkitehti UKIR SMB -tiimissä Edinburghissa Skotlannissa. Hän on erikoistunut tekoälyyn ja koneoppimiseen. Dinesh nauttii työskentelystä asiakkaiden kanssa eri toimialoilla auttaakseen heitä ratkaisemaan ongelmansa AWS-palveluiden kanssa. Työn ulkopuolella hän rakastaa viettää aikaa perheensä kanssa, pelata shakkia ja nauttia musiikista eri genreissä.

Raghu Ramesha on ML Solutions -arkkitehti Amazon SageMaker Service -tiimin kanssa. Hän keskittyy auttamaan asiakkaita rakentamaan, ottamaan käyttöön ja siirtämään ML-tuotannon työmäärät SageMakeriin suuressa mittakaavassa. Hän on erikoistunut koneoppimiseen, tekoälyyn ja tietokonenäköalueisiin, ja hänellä on tietojenkäsittelytieteen maisterin tutkinto UT Dallasista. Vapaa-ajallaan hän nauttii matkustamisesta ja valokuvaamisesta.

Raghu Ramesha on ML Solutions -arkkitehti Amazon SageMaker Service -tiimin kanssa. Hän keskittyy auttamaan asiakkaita rakentamaan, ottamaan käyttöön ja siirtämään ML-tuotannon työmäärät SageMakeriin suuressa mittakaavassa. Hän on erikoistunut koneoppimiseen, tekoälyyn ja tietokonenäköalueisiin, ja hänellä on tietojenkäsittelytieteen maisterin tutkinto UT Dallasista. Vapaa-ajallaan hän nauttii matkustamisesta ja valokuvaamisesta.

- Coinsmart. Euroopan paras Bitcoin- ja kryptopörssi.

- Platoblockchain. Web3 Metaverse Intelligence. Tietoa laajennettu. VAPAA PÄÄSY.

- CryptoHawk. Altcoinin tutka. Ilmainen kokeilu.

- Lähde: https://aws.amazon.com/blogs/machine-learning/improve-high-value-research-with-hugging-face-and-amazon-sagemaker-asynchronous-inference-endpoints/

- "

- 000

- 100

- poikki

- Toiminta

- toiminta

- lisä-

- osoite

- kehittynyt

- AI

- Kaikki

- Amazon

- määrä

- analyysi

- Analytics

- Toinen

- api

- Hakemus

- sovellukset

- artikkeli

- artikkelit

- keinotekoinen

- tekoäly

- Keinotekoinen älykkyys ja koneoppiminen

- auto

- saatavissa

- keskimäärin

- AWS

- perusta

- ovat

- reunus

- rakentaa

- sisäänrakennettu

- liiketoiminta

- bisnesvaisto

- Voi saada

- kyvyt

- Koko

- tapauksissa

- haasteet

- muuttaa

- peritään

- maksut

- tarkkailun

- shakki

- Siivous

- koodi

- Yhteinen

- Yritykset

- kilpailijat

- Tietojenkäsittelyoppi

- Konfigurointi

- kuluttaa

- Kontti

- Kontit

- sisältää

- kustannustehokas

- kustannukset

- Luominen

- Asiakkaat

- Dallas

- tiedot

- tietokanta

- päivä

- sopimus

- omistautunut

- sijoittaa

- levityspinnalta

- Detection

- kehittäjille

- eri

- Sairaus

- asiakirjat

- ei

- verkkotunnuksia

- alas

- Varhainen

- Tehokas

- päätepiste

- vakiintunut

- esimerkki

- odottaa

- kulut

- Kasvot

- Epäonnistuminen

- perhe

- nopeampi

- Fed

- taloudellinen

- rahoituspalvelut

- Etunimi

- jälkeen

- muoto

- lomakkeet

- Ilmainen

- toiminto

- varat

- tuottaa

- suuri

- Kasvu

- terveys

- terveydenhuollon

- Hedge-rahastot

- auttaa

- auttaa

- tätä

- Korkea

- pitää

- Miten

- Miten

- HTTPS

- tunnistaa

- parantaa

- sisältää

- mukana

- Kasvaa

- kasvoi

- teollisuuden

- teollisuus

- tiedot

- oivalluksia

- Älykkyys

- investointi

- osallistuva

- kysymykset

- IT

- Kieli

- suuri

- oppiminen

- Led

- Taso

- Lista

- kuormitus

- sijainti

- Pitkät

- kone

- koneoppiminen

- johto

- markkinat

- Metrics

- ML

- malli

- mallit

- seuranta

- eniten

- MS

- Musiikki

- Luonnollinen

- ilmoituksen

- Ilmoittamisesta

- Mahdollisuudet

- Vaihtoehto

- Vaihtoehdot

- tilata

- Muut

- suorituskyky

- aikoja

- valokuvaus

- politiikka

- salkku

- ennustus

- Ennusteet

- Ehkäisy

- preview

- ensisijainen

- yksityinen

- ongelmia

- prosessi

- tuotanto

- hankkeet

- toimittaa

- tarjoaa

- julkinen

- tarkoituksiin

- laatu

- nopeasti

- Ramppi

- reaaliaikainen

- vastaanottaa

- vähentää

- edellyttää

- vaatimukset

- tutkimus

- resurssi

- Esittelymateriaalit

- vastaus

- tulokset

- ajaa

- juoksu

- skaalautuva

- Asteikko

- skaalaus

- tiede

- tutkijat

- toissijainen

- sektori

- serverless

- palvelu

- Palvelut

- setti

- asetus

- yhteinen

- samankaltainen

- Yksinkertainen

- Koko

- Ratkaisumme

- SOLVE

- erikoistunut

- nopeus

- menot

- Alkaa

- alkoi

- alkaa

- Osavaltio

- Tila

- pysyä

- Levytila

- verkkokaupasta

- strategiat

- menestys

- tuki

- Tukee

- järjestelmä

- Kohde

- tehtävät

- joukkue-

- aika

- yhdessä

- Aiheet

- Seuranta

- liikenne

- hoito

- Trendit

- ymmärtää

- us

- käyttää

- yleensä

- arvo

- visio

- onko

- sisällä

- Referenssit

- työskentely

- kirjoittaminen

- nolla-