Koneoppimismallin (ML) rakentamisprosessi on iteratiivinen, kunnes löydät ehdokasmallin, joka toimii hyvin ja on valmis otettavaksi käyttöön. Kun datatieteilijät iteroivat tätä prosessia, he tarvitsevat luotettavan menetelmän seuratakseen kokeita helposti ymmärtääkseen, kuinka kukin malliversio on rakennettu ja miten se suoriutui.

Amazon Sage Maker antaa tiimille mahdollisuuden hyödyntää laajaa valikoimaa ominaisuuksia ML-mallien nopeaan valmistelemiseen, rakentamiseen, kouluttamiseen, käyttöönottoon ja seurantaan. Amazon SageMaker -putkistot tarjoaa toistettavan prosessin iterointiin mallinrakennustoimintojen kautta, ja se on integroitu Amazon SageMaker -kokeilut. Oletusarvoisesti jokainen SageMaker-putki on liitetty kokeiluun, ja jokaista sen ajoa seurataan kokeiluna kyseisessä kokeessa. Sitten iteraatioita seurataan automaattisesti ilman lisävaiheita.

Tässä viestissä tarkastelemme lähemmin motivaatiota, jonka taustalla on automaattinen prosessi, jolla seurataan kokeiluja ja putkien sisäisiä ominaisuuksia.

Miksi on tärkeää pitää kokeilusi järjestyksessä?

Otetaan hetki taaksepäin ja yritetään ymmärtää, miksi on tärkeää järjestää kokeita koneoppimista varten. Kun datatieteilijät lähestyvät uutta ML-ongelmaa, heidän on vastattava moniin erilaisiin kysymyksiin tietojen saatavuudesta siihen, kuinka he mittaavat mallin suorituskykyä.

Alussa prosessi on täynnä epävarmuutta ja erittäin iteratiivinen. Tämän seurauksena tämä kokeiluvaihe voi tuottaa useita malleja, joista jokainen on luotu omista syötteistään (tietojoukot, koulutusskriptit ja hyperparametrit) ja tuottaa omia tulosteita (mallin artefaktit ja arviointimittarit). Haasteena on sitten pitää kirjaa kaikista näistä kunkin iteroinnin tuloista ja lähdöistä.

Datatieteilijät yleensä kouluttavat monia erilaisia malliversioita, kunnes he löytävät datamuunnosten, algoritmien ja hyperparametrien yhdistelmän, joka johtaa mallin parhaiten toimivaan versioon. Jokainen näistä ainutlaatuisista yhdistelmistä on yksi kokeilu. Kokeilun käyttämien syötteiden, algoritmien ja hyperparametrien jäljitettävän tietueen avulla datatieteen tiimi voi helposti toistaa vaiheensa.

Automaattinen prosessi kokeiden seurantaa varten parantaa kykyä toistaa ja ottaa käyttöön tiettyjä malliversioita, jotka toimivat hyvin. Pipelinesin natiiviintegraatio Experimentsin kanssa tekee kokeilujen automaattisen seurannan ja hallinnan putkiajon aikana helppoa.

SageMaker-kokeilujen edut

SageMaker Experimentsin avulla datatieteilijät voivat organisoida, seurata, vertailla ja arvioida koulutusiteraatioitaan.

Aloitetaan ensin yleiskatsauksella siitä, mitä voit tehdä kokeiluilla:

- Järjestä kokeita – Experiments strukturoi kokeilun huipputason entiteetillä nimeltä an kokeilu joka sisältää joukon tutkimuksissa. Jokainen kokeilu sisältää joukon vaiheita nimeltä koekomponentit. Jokainen kokeilukomponentti on yhdistelmä tietojoukkoja, algoritmeja ja parametreja. Voit kuvata kokeet ylimmän tason kansioksi hypoteesien järjestämistä varten, kokeilut kunkin ryhmätestiajon alikansioiksi ja kokeilukomponentit tiedostoina jokaiselle testiajon esiintymälle.

- Seuraa kokeita – Kokeiden avulla datatutkijat voivat seurata kokeita. Se tarjoaa mahdollisuuden määrittää SageMaker-töitä automaattisesti kokeiluun yksinkertaisten konfiguraatioiden ja seuranta-SDK:iden kautta.

- Vertaa ja arvioi kokeita – Kokeiden integrointi kanssa Amazon SageMaker Studio helpottaa datavisualisaatioiden tuottamista ja erilaisten kokeiden vertailua. Voit myös käyttää kokeilutietoja Python SDK:n kautta luodaksesi oman visualisoinnin käyttämällä haluamiasi piirustuskirjastoja.

Jos haluat lisätietoja Experiments-sovellusliittymistä ja SDK:ista, suosittelemme seuraavaa dokumentaatiota: Luo kokeilu ja Amazon SageMaker Experiments Python SDK.

Jos haluat sukeltaa syvemmälle, suosittelemme tutustumaan amazon-sagemaker-examples/sagemaker-experiments GitHub-arkisto lisää esimerkkejä varten.

Integrointi putkien ja kokeiden välillä

Mallinrakennusputkistot, jotka ovat osa Pipelinejä, on suunniteltu ML:ää varten, ja niiden avulla voit organisoida mallinrakennustehtäviäsi liukuhihnatyökalulla, joka sisältää alkuperäisiä integraatioita muihin SageMaker-ominaisuuksiin sekä joustavuuden laajentaa putkilinjaasi SageMakerin ulkopuolella suoritetuilla vaiheilla. . Jokainen vaihe määrittää toimenpiteen, jonka putkilinja suorittaa. Vaiheiden väliset riippuvuudet määritellään suoralla asyklisellä graafilla (DAG), joka on rakennettu käyttämällä Pipelines Python SDK:ta. Voit rakentaa SageMaker-putkilinjan ohjelmallisesti saman SDK:n kautta. Kun liukuhihna on otettu käyttöön, voit halutessasi visualisoida sen työnkulun Studiossa.

Putket integroituvat automaattisesti kokeiluihin luomalla automaattisesti kokeilun ja kokeilun jokaista ajoa varten. Putkilinjat luovat automaattisesti kokeen ja kokeilun jokaiselle liukuhihnan ajolle ennen vaiheiden suorittamista, ellei jompaakumpaa tai molempia näistä syötteistä ole määritetty. Ajettaessa liukuhihnan SageMaker-työtä, liukuhihna liittää kokeen kokeiluun ja liittää kokeiluun kaikki työn luomat kokeilukomponentit. Määrittämällä oman kokeilusi tai kokeiluversiosi ohjelmallisesti voit hienosäätää kokeilujen järjestämistä.

Tässä esimerkissä esittämämme työnkulku koostuu sarjasta vaiheita: esikäsittelyvaihe, jossa syöttötietojoukot jaetaan harjoitus-, testi- ja validointitietojoukoiksi; viritysvaihe hyperparametreidemme virittämiseksi ja harjoitustyön aloittamiseksi mallin kouluttamiseksi käyttämällä Sisäänrakennettu XGBoost-algoritmi; ja lopuksi mallivaihe SageMaker-mallin luomiseksi parhaiten koulutetusta malliartefaktista. Pipelines tarjoaa myös useita alkuperäisesti tuettuja askeltyypit tässä viestissä käsiteltyjen asioiden ulkopuolella. Havainnollistamme myös, kuinka voit seurata putkilinjasi työnkulkua ja luoda mittareita ja vertailukaavioita. Lisäksi näytämme, kuinka luotu uusi kokeilu voidaan liittää olemassa olevaan kokeiluun, joka on saatettu luoda ennen putkilinjan määrittämistä.

SageMaker Pipelines -koodi

Voit tarkastella ja ladata muistikirjan osoitteesta GitHub-arkisto liittyy tähän viestiin. Katsomme Pipelines-kohtaista koodia ymmärtääksemme sitä paremmin.

Liukulinjat mahdollistavat parametrien välittämisen ajon aikana. Tässä määritämme käsittely- ja opetusilmentymien tyypit ja laskut ajon aikana esiasetetuilla oletusarvoilla:

Seuraavaksi määritimme käsittelykomentosarjan, joka lataa ja jakaa syötetietojoukon harjoitus-, testi- ja validointiosiin. Käytämme SKLearnProcessor tämän esikäsittelyvaiheen suorittamiseen. Tätä varten määritämme prosessoriobjektin, jonka ilmentymätyyppi ja määrä tarvitaan käsittelytyön suorittamiseen.

Pipelinesin avulla voimme saavuttaa tietojen versioinnin ohjelmallisesti käyttämällä suorituskohtaisia muuttujia, kuten ExecutionVariables.PIPELINE_EXECUTION_ID, joka on liukuhihnaajon yksilöllinen tunnus. Voimme esimerkiksi luoda ainutlaatuisen avaimen lähtötietojoukon tallentamiseksi Amazonin yksinkertainen tallennuspalvelu (Amazon S3), joka sitoo ne tiettyyn putkilinjaan. Täydellinen muuttujien luettelo on kohdassa Suoritusmuuttujat.

Sitten siirrymme luomaan estimaattoriobjektin XGBoost-mallin kouluttamiseksi. Asetamme joitain staattisia hyperparametreja, joita käytetään yleisesti XGBoostin kanssa:

Teemme luomillemme malleille hyperparametrivirityksen käyttämällä a ContinuousParameter alue lambda. Yhden mittarin valitseminen objektiiviseksi mittariksi kertoo virittimelle (ilmentymä, joka suorittaa hyperparametrien viritystöitä), että arvioit koulutustyön tämän tietyn mittarin perusteella. Viritin palauttaa parhaan yhdistelmän, joka perustuu tämän objektiivisen metriikan parhaaseen arvoon, mikä tarkoittaa parasta yhdistelmää, joka minimoi parhaan keskimääräisen neliövirheen (RMSE).

Viritysvaihe suorittaa useita kokeita, joiden tavoitteena on määrittää paras malli testatuista parametrialueista. Menetelmän kanssa get_top_model_s3_uri, luokittelemme malliartefaktin S50 URI:n 3 tehokkainta versiota ja poimimme vain parhaiten suoriutuneen version (määritämme k=0 paras) SageMaker-mallin luomiseksi.

Kun liukuhihna suoritetaan, se luo koekomponentteja jokaiselle hyperparametrin viritystyölle ja jokaiselle liukuhihnan vaiheiden luomalle SageMaker-työlle.

Voit edelleen määrittää putkien integrointia kokeiluihin luomalla a PipelineExperimentConfig objekti ja välitä se liukuhihnaobjektille. Nämä kaksi parametria määrittävät luotavan kokeilun nimen ja kokeilun, joka viittaa koko putkilinjan ajoon.

Jos haluat liittää putkiajon olemassa olevaan kokeiluun, voit välittää sen nimen, jolloin Pipelines liittää uuden kokeilun siihen. Voit estää kokeilun ja kokeilun luomisen ajettavalle liukuhihnalle asettamalla pipeline_experiment_config että None.

Välitämme instanssityypit ja -määrät parametreina ja ketjutamme edelliset vaiheet seuraavaan järjestykseen. Liukuhihnan työnkulku määritellään implisiittisesti siten, että vaiheen tuotokset ovat toisen vaiheen syötteitä.

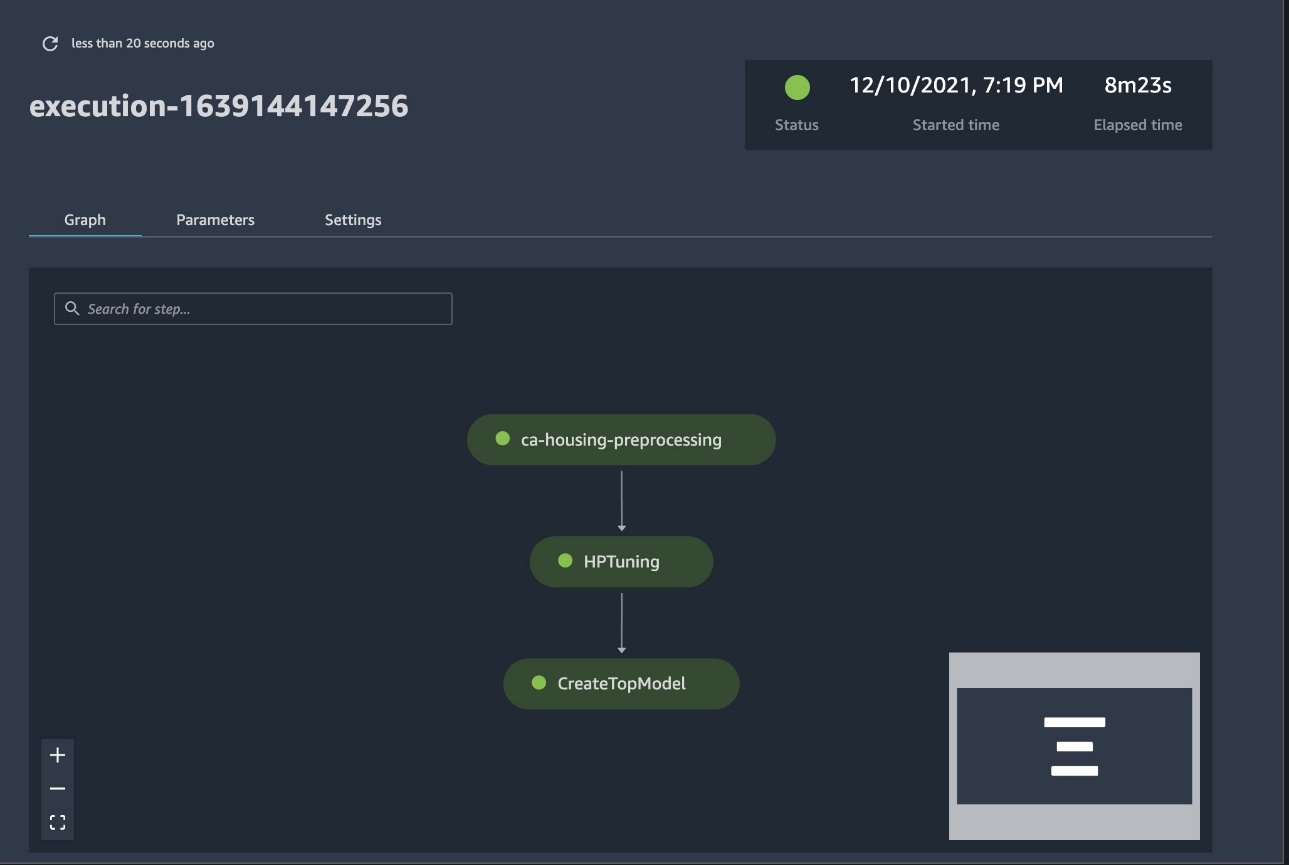

Täysi putkilinja on nyt luotu ja valmis käyttöön. Lisäämme putkiin suoritusroolin ja käynnistämme sen. Täältä voimme siirtyä SageMaker Studio Pipelines -konsoliin ja seurata jokaista vaihetta visuaalisesti. Voit myös käyttää linkitettyjä lokeja konsolista putkilinjan virheenkorjausta varten.

Edellisessä kuvakaappauksessa näkyy vihreällä onnistuneesti suoritettu putki. Saamme yhden kokeilun mittarit liukuhihnan ajosta seuraavalla koodilla:

Vertaa kunkin kokeilukomponentin mittareita

Voit piirtää hyperparametrivirityksen tulokset Studiossa tai muiden Python-piirtokirjastojen kautta. Näytämme molemmat tavat tehdä tämä.

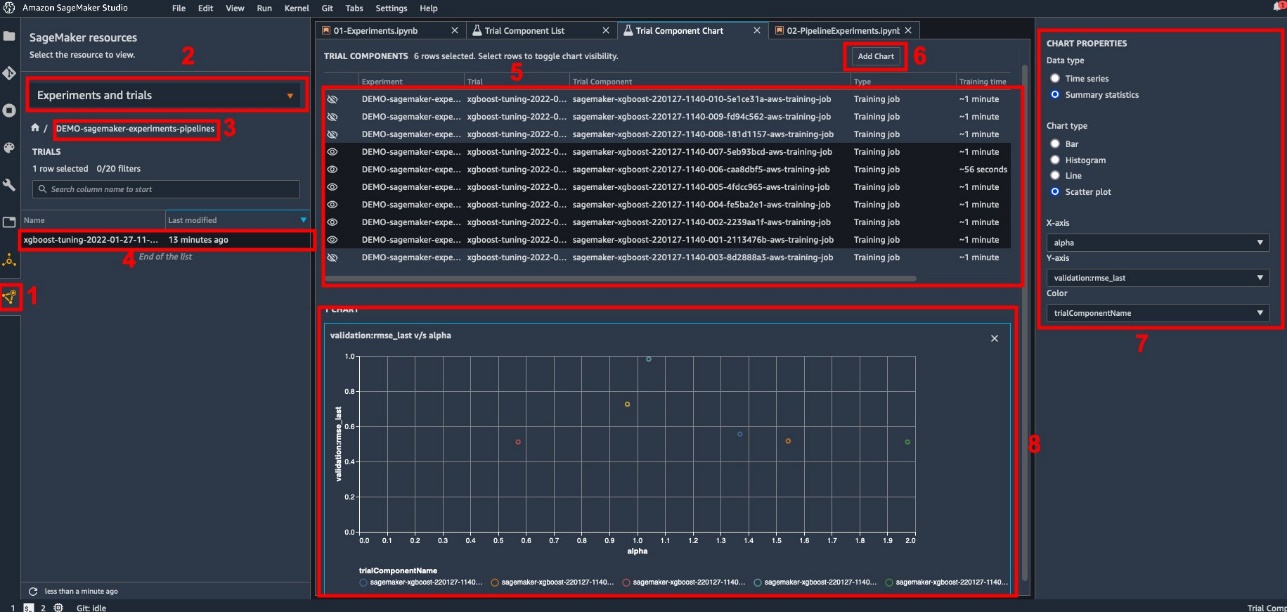

Tutustu koulutus- ja arviointimittareihin Studiossa

Studio tarjoaa interaktiivisen käyttöliittymän, jossa voit luoda interaktiivisia juonia. Vaiheet ovat seuraavat:

- Valita Kokeilut ja kokeet mistä SageMaker-resurssit -kuvake vasemmalla sivupalkissa.

- Valitse kokeilusi avataksesi sen.

- Valitse (klikkaa hiiren oikealla painikkeella) kiinnostava kokeilu.

- Valita Avaa kokeilukomponenttiluettelossa.

- lehdistö siirtyminen valitaksesi koulutustöitä edustavat kokeilukomponentit.

- Valita Lisää kaavio.

- Valita Uusi kaavio ja muokkaa sitä piirtämään analysoitavat kerätyt tiedot. Valitse käyttötapauksessamme seuraava:

- varten Tietotyyppi¸ valitse Yhteenvetotilastot.

- varten Kaavion tyyppi¸ valitse Hajontapiirros.

- varten X-akseli, valitse

lambda. - varten Y-akseli, valitse

validation:rmse_last.

Uusi kaavio ilmestyy ikkunan alaosaan, ja siinä on merkintä "8".

Voit sisällyttää enemmän tai vähemmän koulutustehtäviä painamalla siirtyminen ja valitse silmäkuvake interaktiivisemman kokemuksen saamiseksi.

Analyysi SageMaker-kokeiluilla

Kun putkiajo on valmis, voimme nopeasti visualisoida, kuinka mallin eri muunnelmia verrataan koulutuksen aikana kerättyihin mittareihin. Aiemmin vietimme kaikki kokeilutiedot osoitteeseen a Panda DataFrame käyttämällä ExperimentAnalytics. Voimme toistaa Studiossa saadun juonen Matplotlib-kirjaston avulla.

Yhteenveto

SageMaker Pipelinesin ja SageMaker Experimentsin välinen natiivi integraatio antaa datatutkijoille mahdollisuuden automaattisesti järjestää, seurata ja visualisoida kokeita mallinkehityksen aikana. Voit luoda kokeita järjestääksesi kaiken mallinkehitystyösi, kuten seuraavat:

- Yrityskäyttötapaus, jota käsittelet, kuten kokeilun luominen asiakkaiden vaihtuvuuden ennustamiseksi

- Datatieteen tiimin omistama kokeilu koskien esimerkiksi markkinointianalytiikkaa

- Erityinen datatieteen ja ML-projekti

Tässä viestissä perehdymme putkistoihin näyttääksemme, kuinka voit käyttää sitä yhdessä kokeiden kanssa täysin automatisoidun päästä päähän -työnkulun järjestämiseen.

Seuraavana vaiheena voit käyttää näitä kolmea SageMaker-ominaisuutta – Studio, Experiments ja Pipelines – seuraavassa ML-projektissasi.

Ehdotetut lukemat

Tietoja kirjoittajista

Paolo di Francesco on ratkaisuarkkitehti AWS:ssä. Hänellä on kokemusta tietoliikenne- ja ohjelmistosuunnittelusta. Hän on intohimoinen koneoppimisesta ja keskittyy tällä hetkellä käyttämään kokemustaan auttaakseen asiakkaita saavuttamaan tavoitteensa AWS:ssä, erityisesti MLOps-keskusteluissa. Työn ulkopuolella hän nauttii jalkapallon pelaamisesta ja lukemisesta.

Paolo di Francesco on ratkaisuarkkitehti AWS:ssä. Hänellä on kokemusta tietoliikenne- ja ohjelmistosuunnittelusta. Hän on intohimoinen koneoppimisesta ja keskittyy tällä hetkellä käyttämään kokemustaan auttaakseen asiakkaita saavuttamaan tavoitteensa AWS:ssä, erityisesti MLOps-keskusteluissa. Työn ulkopuolella hän nauttii jalkapallon pelaamisesta ja lukemisesta.

Mario Bourgoin on AWS:n Senior Partner Solutions Architect, AI/ML-asiantuntija ja MLOpsin maailmanlaajuinen tekninen johtaja. Hän työskentelee yritysasiakkaiden ja kumppaneiden kanssa, jotka ottavat käyttöön tekoälyratkaisuja pilvessä. Hänellä on yli 30 vuoden kokemus koneoppimisesta ja tekoälystä startup-yrityksissä ja yrityksissä alkaen yhden ensimmäisistä kaupallisista koneoppimisjärjestelmistä big datalle. Mario viettää vapaa-aikansa leikkimällä kolmen belgialaisen Tervurenin kanssa, valmistaen illallista perheelleen ja oppien matematiikkaa ja kosmologiaa.

Mario Bourgoin on AWS:n Senior Partner Solutions Architect, AI/ML-asiantuntija ja MLOpsin maailmanlaajuinen tekninen johtaja. Hän työskentelee yritysasiakkaiden ja kumppaneiden kanssa, jotka ottavat käyttöön tekoälyratkaisuja pilvessä. Hänellä on yli 30 vuoden kokemus koneoppimisesta ja tekoälystä startup-yrityksissä ja yrityksissä alkaen yhden ensimmäisistä kaupallisista koneoppimisjärjestelmistä big datalle. Mario viettää vapaa-aikansa leikkimällä kolmen belgialaisen Tervurenin kanssa, valmistaen illallista perheelleen ja oppien matematiikkaa ja kosmologiaa.

Ganapathi Krishnamoorthi on vanhempi ML Solutions -arkkitehti AWS:ssä. Ganapathi tarjoaa ohjeellisia ohjeita startup- ja yritysasiakkaille, jotka auttavat heitä suunnittelemaan ja ottamaan käyttöön pilvisovelluksia laajassa mittakaavassa. Hän on erikoistunut koneoppimiseen ja keskittyy auttamaan asiakkaita hyödyntämään tekoälyä/ML:ää liiketoimintansa tulosten saavuttamiseksi. Kun hän ei ole töissä, hän nauttii ulkoilusta ja musiikin kuuntelusta.

Ganapathi Krishnamoorthi on vanhempi ML Solutions -arkkitehti AWS:ssä. Ganapathi tarjoaa ohjeellisia ohjeita startup- ja yritysasiakkaille, jotka auttavat heitä suunnittelemaan ja ottamaan käyttöön pilvisovelluksia laajassa mittakaavassa. Hän on erikoistunut koneoppimiseen ja keskittyy auttamaan asiakkaita hyödyntämään tekoälyä/ML:ää liiketoimintansa tulosten saavuttamiseksi. Kun hän ei ole töissä, hän nauttii ulkoilusta ja musiikin kuuntelusta.

Valerie Sonthakith on AWS:n ratkaisuarkkitehti, joka työskentelee pelialalla ja tekoälyratkaisuja ottavien kumppaneiden kanssa. Hän pyrkii rakentamaan uransa Computer Visionin ympärille. Vapaa-ajallaan Valerie viettää sen matkustaakseen, löytääkseen uusia ruokapaikkoja ja muuttaakseen talonsa sisustusta.

Valerie Sonthakith on AWS:n ratkaisuarkkitehti, joka työskentelee pelialalla ja tekoälyratkaisuja ottavien kumppaneiden kanssa. Hän pyrkii rakentamaan uransa Computer Visionin ympärille. Vapaa-ajallaan Valerie viettää sen matkustaakseen, löytääkseen uusia ruokapaikkoja ja muuttaakseen talonsa sisustusta.

- AI

- ai taide

- ai taiteen generaattori

- ai robotti

- Amazon Sage Maker

- tekoäly

- tekoälyn sertifiointi

- tekoäly pankkitoiminnassa

- tekoäly robotti

- tekoälyrobotit

- tekoälyohjelmisto

- AWS-koneoppiminen

- blockchain

- blockchain-konferenssi ai

- coingenius

- keskustelullinen tekoäly

- kryptokonferenssi ai

- dall's

- syvä oppiminen

- google ai

- koneoppiminen

- Platon

- plato ai

- Platonin tietotieto

- Platon peli

- PlatonData

- platopeliä

- mittakaava ai

- syntaksi

- zephyrnet