Données des utilisateurs : l’alimentation vitale des LLM

Oui! RT @bryce j'adore cette citation « Si vous ne payez pas pour cela, vous n'êtes pas le client ; vous êtes le produit vendu. http://bit.ly/93JYCJ

– Tim O'Reilly (@timoreilly) 2 septembre 2010

Restez au courant des actualités cryptographiques, recevez des mises à jour quotidiennes dans votre boîte de réception.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- :possède

- :est

- :ne pas

- 7

- 8

- a

- capacité

- Absolute

- Selon

- Avec cette connaissance vient le pouvoir de prendre

- s'adapter

- adresser

- Ajoute

- Avancée

- depuis

- accepte

- AI

- Services d'IA

- Systèmes d'IA

- vise

- Alexa

- Aligne

- Tous

- permet

- aussi

- toujours

- Amazon

- an

- ainsi que

- Anthropique

- anticiper

- tous

- en vigueur

- SONT

- AS

- assumer

- At

- disponibles

- en évitant

- conscients

- basé

- BE

- car

- va

- cru

- avantageux

- Améliorée

- jusqu'à XNUMX fois

- by

- CAN

- prétentions

- CLIENTS

- commercial

- engagement

- commits

- Sociétés

- Société

- compétitif

- concept

- Préoccupations

- constamment

- contenu

- contexte

- continuellement

- des bactéries

- Pratique

- conversations

- droit d'auteur

- pourriez

- crucial

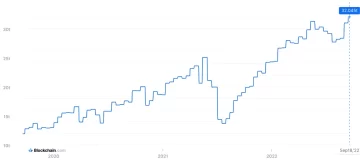

- Crypto

- Crypto Nouvelles

- Courant

- des clients

- Clients

- Tous les jours

- Foncé

- données

- confidentialité des données

- débat

- décennies

- Décrypter

- profond

- l'apprentissage en profondeur

- Réglage par défaut

- Défendre

- livrer

- dépend

- rejette

- différends

- Diversité

- do

- document

- dollars

- Ne pas

- pendant

- Revenus

- Edge

- efficacité

- non plus

- participation

- améliorer

- Assure

- essential

- éthique

- éthique

- exemple

- échange

- d'experience

- les

- ampleur

- externe

- Pour

- Ancien

- Fondée

- Gratuit

- De

- gagner

- générer

- généré

- génère

- génératif

- IA générative

- obtenez

- obtention

- géants

- Donner

- Go

- subvention

- saisir

- Pousse

- fortement

- honnête

- honneur

- Cependant

- http

- HTTPS

- humain

- idéaux

- if

- améliorer

- in

- individuel

- d'information

- intellectuel

- propriété intellectuelle

- intentions

- interactions

- interne

- IP

- IT

- SES

- lui-même

- ACTIVITES

- langue

- gros

- Nouveautés

- Droit applicable et juridiction compétente

- conduire

- APPRENTISSAGE

- apprentissage

- Légal

- Levier

- comme

- Flamme

- LLM

- love

- a prendre une

- Fabrication

- Mai..

- Médias

- Meta

- des millions

- modèle

- numériques jumeaux (digital twin models)

- PLUS

- (en fait, presque toutes)

- réseaux

- neural

- les réseaux de neurones

- Nouveauté

- nouvelles

- obtention

- of

- on

- OpenAI

- or

- en apparence

- autrement

- nos

- ande

- sorties

- plus de

- propre

- Possède

- payé

- les parties

- fête

- motifs

- Payer

- payant

- personnel

- Personnalisation

- Personnalisé

- Photos

- Platon

- Intelligence des données Platon

- PlatonDonnées

- politique

- défaillances

- power

- solide

- pratiques

- prévoir

- Prédictions

- préférences

- répandue

- la confidentialité

- Privé

- Produit

- Produit

- instructions

- propriété

- fournir

- fournit

- public

- confiance publique

- publiquement

- Devis

- course

- RE

- monde réel

- reçoit

- affiner

- Considérer

- relatif

- libérer

- pertinent

- Signalé

- demandes

- chercheurs

- responsables

- Révélé

- droits

- rivaux

- rt

- Ryan

- s

- dire

- dit

- scène

- service

- Services

- set

- Partager

- devrait

- Scepticisme

- So

- Réseaux sociaux

- réseaux sociaux

- vendu

- ÉPELER

- porte-parole

- Commencez

- Déclaration

- rester

- étapes

- Système

- tandem

- technologie

- géants de la technologie

- techniques

- conditions

- texte

- qui

- La

- leur

- Les

- Ces

- l'ont

- this

- Tim

- à

- aujourd'hui

- top

- Train

- qualifié

- Formation

- Transparence

- Trends

- La confiance

- sous

- comprendre

- compréhension

- prochain

- a actualisé

- Actualités

- mis à jour

- téléchargé

- utilisé

- d'utiliser

- Utilisateur

- utilisateurs

- en utilisant

- Précieux

- divers

- version

- Vidéos

- vital

- Voix

- le volume

- était

- we

- ont été

- quand

- que

- qui

- why

- sera

- comprenant

- Word

- pourra

- Vous n'avez

- Votre

- zéphyrnet