Les éditeurs numériques recherchent en permanence des moyens de rationaliser et d'automatiser leurs workflows multimédias afin de générer et de publier de nouveaux contenus aussi rapidement que possible.

De nombreux éditeurs disposent d'une grande bibliothèque d'images d'archives qu'ils utilisent pour leurs articles. Ces images peuvent être réutilisées plusieurs fois pour différentes histoires, en particulier lorsque l'éditeur a des images de célébrités. Très souvent, un journaliste peut avoir besoin de recadrer une célébrité souhaitée à partir d'une image à utiliser pour son prochain article. Il s'agit d'une tâche manuelle et répétitive qui devrait être automatisée. Parfois, un auteur peut vouloir utiliser une image d'une célébrité, mais elle contient deux personnes et la célébrité principale doit être coupée de l'image. D'autres fois, les images de célébrités peuvent avoir besoin d'être reformatées pour être publiées sur une variété de plates-formes telles que les mobiles, les médias sociaux ou les actualités numériques. De plus, un auteur peut avoir besoin de modifier le rapport d'aspect de l'image ou de mettre la célébrité au point.

Dans cet article, nous montrons comment utiliser Amazon Reconnaissance pour effectuer une analyse d'image. Amazon Rekognition facilite l'ajout de cette fonctionnalité à vos applications sans aucune expertise en machine learning (ML) et est fourni avec diverses API pour répondre à des cas d'utilisation tels que la détection d'objets, la modération de contenu, la détection et l'analyse de visages, et la reconnaissance de texte et de célébrités, que nous utiliser dans cet exemple.

La fonction de reconnaissance des célébrités in Amazon Reconnaissance reconnaît automatiquement des dizaines de milliers de personnalités bien connues dans des images et des vidéos à l'aide de ML. La reconnaissance de célébrité peut détecter non seulement la présence de la célébrité donnée, mais également l'emplacement dans l'image.

Présentation de la solution

Dans cet article, nous montrons comment nous pouvons transmettre une photo, un nom de célébrité et un rapport d'aspect pour l'image produite afin de pouvoir générer une image recadrée de la célébrité donnée capturant son visage au centre.

Lorsque vous travaillez avec le API de détection de célébrités Amazon Rekognition, de nombreux éléments sont renvoyés dans la réponse. Voici quelques éléments de réponse clés :

- MatchConfiance – Un score de confiance de correspondance qui peut être utilisé pour contrôler le comportement de l'API. Nous vous recommandons d'appliquer un seuil approprié à ce score dans votre application pour choisir votre point de fonctionnement préféré. Par exemple, en définissant un seuil de 99 %, vous pouvez éliminer les faux positifs, mais vous risquez de manquer certaines correspondances potentielles.

- Nom, identifiant et URL - Le nom de la célébrité, un identifiant Amazon Rekognition unique et une liste d'URL telles que le lien IMDb ou Wikipedia de la célébrité pour plus d'informations.

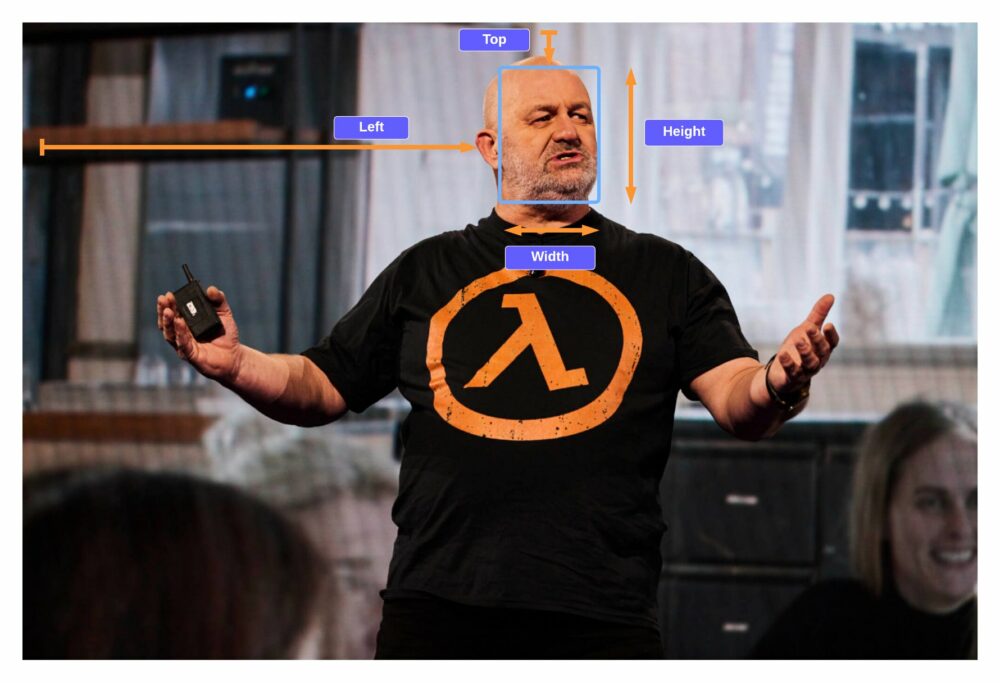

- Boîte englobante - Coordonnées de l'emplacement de la boîte englobante rectangulaire pour chaque visage de célébrité reconnu.

- Genre connu – Identité de genre connue pour chaque célébrité reconnue.

- Les Émotions – Émotion exprimée sur le visage de la célébrité, par exemple, heureux, triste ou en colère.

- pose – Pose du visage de la célébrité, en utilisant trois axes de roulis, de tangage et de lacet.

- Smile – Que la célébrité soit souriante ou non.

Une partie de la réponse de l'API d'Amazon Rekognition inclut le code suivant :

Dans cet exercice, nous montrons comment utiliser l'élément de zone de délimitation pour identifier l'emplacement du visage, comme illustré dans l'exemple d'image suivant. Toutes les dimensions sont représentées sous forme de rapports de la taille globale de l'image, de sorte que les nombres dans la réponse sont compris entre 0 et 1. Par exemple, dans l'exemple de réponse de l'API, la largeur de la zone de délimitation est de 0.1, ce qui implique que la largeur du visage est de 10 % de la largeur totale de l'image.

Avec cette boîte englobante, nous pouvons maintenant utiliser la logique pour nous assurer que le visage reste dans les bords de la nouvelle image que nous créons. Nous pouvons appliquer un rembourrage autour de cette boîte englobante pour garder le visage au centre.

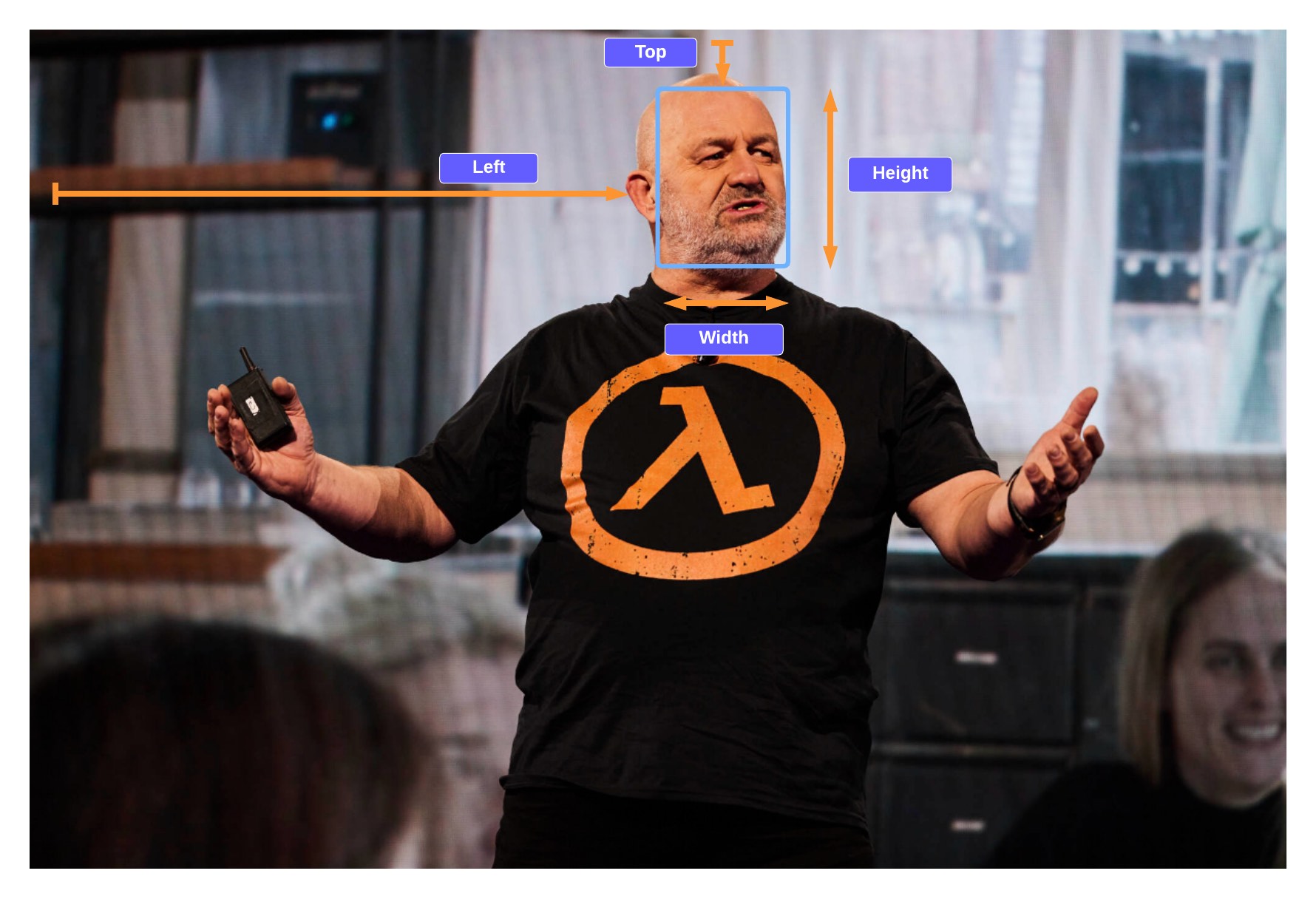

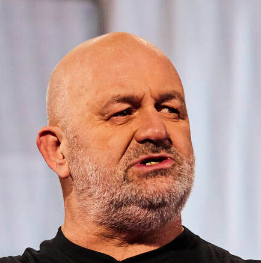

Dans les sections suivantes, nous montrons comment créer la sortie d'image recadrée suivante avec Werner Vogels avec une mise au point nette.

Nous lançons une Amazon Sage Maker notebook, qui fournit un environnement Python dans lequel vous pouvez exécuter le code pour transmettre une image à Amazon Rekognition, puis modifier automatiquement l'image en mettant l'accent sur la célébrité.

Le code effectue les étapes de haut niveau suivantes :

- Faire une demande au

recognize_celebritiesAPI avec l'image et le nom de la célébrité donnés. - Filtrez la réponse pour les informations de la zone de délimitation.

- Ajoutez un peu de rembourrage à la boîte englobante de sorte que nous capturions une partie de l'arrière-plan.

Pré-requis

Pour cette procédure pas à pas, vous devez disposer des prérequis suivants:

Télécharger l'exemple d'image

Téléchargez votre exemple d'image de célébrité dans votre compartiment S3.

Exécutez le code

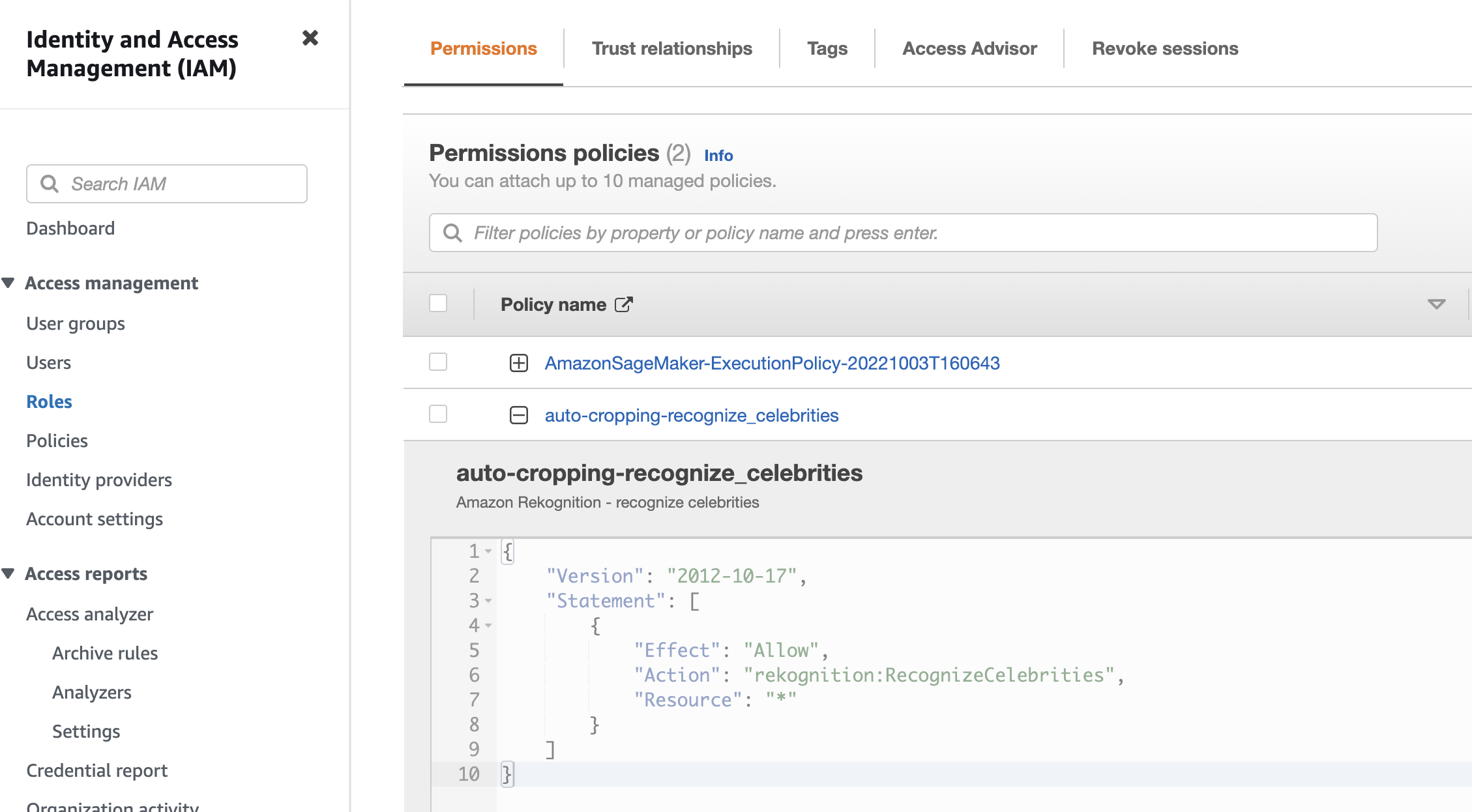

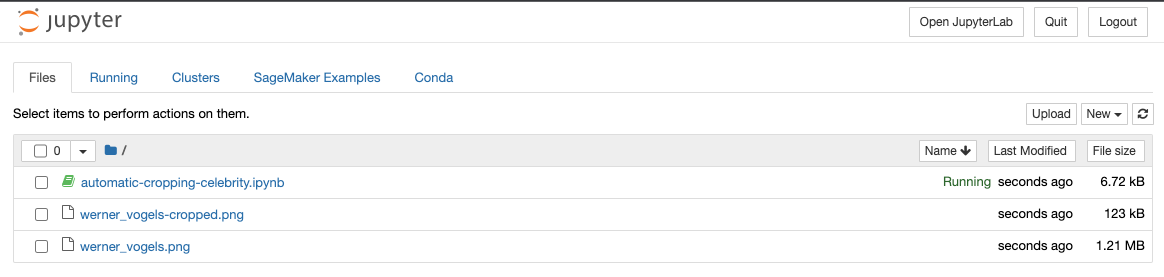

Pour exécuter le code, nous utilisons un bloc-notes SageMaker, mais n'importe quel IDE fonctionnerait également après l'installation de Python, pillow et Boto3. Nous créons un cahier SageMaker ainsi que le Gestion des identités et des accès AWS (IAM) avec les autorisations requises. Effectuez les étapes suivantes :

- Créer le carnet et nommez-le

automatic-cropping-celebrity.

La stratégie d'exécution par défaut, qui a été créée lors de la création du bloc-notes SageMaker, a une stratégie simple qui donne au rôle les autorisations d'interagir avec Amazon S3.

- Mettre à jour le

Resourcecontrainte avec le nom du compartiment S3 :

- Créez une autre stratégie à ajouter au rôle IAM du bloc-notes SageMaker pour pouvoir appeler le Reconnaître les célébrités API:

- Sur la console SageMaker, choisissez Instances de bloc-notes dans le volet de navigation.

- Localisez le

automatic-cropping-celebritycahier et choisissez Ouvrez Jupyter. - Selectionnez Nouveauté et les conda_python3 comme noyau pour votre ordinateur portable.

Pour les étapes suivantes, copiez les blocs de code dans votre notebook Jupyter et exécutez-les en choisissant Courir.

- Tout d'abord, nous importons des fonctions d'assistance et des bibliothèques :

- Définir des variables

- Créer un client de service

- Fonction pour reconnaître les célébrités

- Fonction pour obtenir la boîte englobante de la célébrité donnée :

- Fonction pour ajouter du rembourrage à la boîte englobante, nous capturons donc un arrière-plan autour du visage

- Fonction pour enregistrer l'image dans le stockage de l'ordinateur portable et dans Amazon S3

- Utiliser le Python

main()fonction pour combiner les fonctions précédentes pour compléter le flux de travail d'enregistrement d'une nouvelle image recadrée de notre célébrité :

Lorsque vous exécutez ce bloc de code, vous pouvez voir que nous avons trouvé Werner Vogels et créé une nouvelle image avec son visage au centre.

L'image sera enregistrée dans le bloc-notes et également téléchargée dans le compartiment S3.

Vous pouvez inclure cette solution dans un flux de travail plus important; par exemple, une maison d'édition peut souhaiter publier cette capacité en tant que point final pour reformater et redimensionner les images à la volée lors de la publication d'articles de célébrités sur plusieurs plates-formes.

Nettoyer

Pour éviter d'encourir des frais futurs, supprimez les ressources :

- Sur la console SageMaker, sélectionnez votre bloc-notes et sur la Actions menu, choisissez Arrêter.

- Après l'arrêt du notebook, sur le Actions menu, choisissez Supprimer.

- Sur la console IAM, supprimez le rôle d'exécution SageMaker que vous avez créé.

- Sur la console Amazon S3, supprimez l'image d'entrée et tous les fichiers de sortie de votre compartiment S3.

Conclusion

Dans cet article, nous avons montré comment nous pouvons utiliser Amazon Rekognition pour automatiser une tâche autrement manuelle de modification d'images pour prendre en charge les workflows multimédias. Ceci est particulièrement important dans le secteur de l'édition où la vitesse est importante pour diffuser rapidement du nouveau contenu et sur plusieurs plates-formes.

Pour plus d'informations sur l'utilisation des ressources multimédias, reportez-vous à L'intelligence des médias est devenue plus intelligente avec Media2Cloud 3.0

À propos de l’auteur

Marc Watkins est un architecte de solutions au sein de l'équipe des médias et du divertissement. Il aide les clients à créer des solutions AI/ML qui résolvent leurs défis commerciaux à l'aide d'AWS. Il a travaillé sur plusieurs projets d'IA/ML liés à la vision par ordinateur, au traitement du langage naturel, à la personnalisation, au ML à la périphérie, etc. Loin de la vie professionnelle, il aime passer du temps avec sa famille et voir ses deux petits grandir.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- Platoblockchain. Intelligence métaverse Web3. Connaissance Amplifiée. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/automatic-image-cropping-with-amazon-rekognition/

- :est

- $UP

- 1

- 10

- 100

- 11

- 7

- 8

- 9

- a

- Capable

- A Propos

- accès

- Action

- En outre

- Après

- AI / ML

- Tous

- Amazon

- Amazon Reconnaissance

- selon une analyse de l’Université de Princeton

- et les

- Une autre

- api

- Apis

- Application

- applications

- Appliquer

- Application

- SONT

- autour

- sur notre blog

- AS

- d'aspect

- Outils

- At

- auteur

- automatiser

- Automatisation

- Automatique

- automatiquement

- AWS

- HACHES

- fond

- BE

- jusqu'à XNUMX fois

- Block

- Blocs

- Box

- boîtes

- la performance des entreprises

- by

- Appelez-nous

- CAN

- capturer

- Capturer

- cas

- Celeb

- célébrités

- Célébrité

- Canaux centraux

- globaux

- Change

- des charges

- Selectionnez

- choose

- code

- combiner

- Société

- complet

- ordinateur

- Vision par ordinateur

- confiance

- Console

- contient

- contenu

- continuellement

- des bactéries

- pourriez

- engendrent

- créée

- La création

- récolte

- Clients

- Réglage par défaut

- démontrer

- voulu

- détecté

- Détection

- différent

- numérique

- dimensions

- Commande

- download

- e

- chacun

- Edge

- effet

- élément

- éléments

- éliminé

- Endpoint

- Divertissement

- Environment

- notamment

- exemple

- exécution

- Exercises

- nous a permis de concevoir

- exprimé

- Visage

- visages

- famille

- célèbre

- Déposez votre dernière attestation

- Fichiers

- Focus

- Abonnement

- Pour

- le format

- trouvé

- fraiche entreprise

- De

- fonction

- fonctions

- plus

- avenir

- Sexe

- générer

- obtenez

- obtention

- donné

- donne

- Croissance

- heureux vous

- Vous avez

- la taille

- aide

- de haut niveau

- Comment

- How To

- Cependant

- HTML

- http

- HTTPS

- ID

- identifier

- Identite

- image

- satellite

- importer

- important

- in

- comprendre

- inclut

- industrie

- d'information

- contribution

- installer

- Intelligence

- interagir

- IT

- journaliste

- jpg

- XNUMX éléments à

- ACTIVITES

- connu

- langue

- gros

- lancer

- apprentissage

- bibliothèques

- Bibliothèque

- VIE

- comme

- LINK

- Liste

- peu

- locales

- emplacement

- recherchez-

- click

- machine learning

- a prendre une

- FAIT DU

- Manuel

- de nombreuses

- Match

- compte

- Médias

- Menu

- pourrait

- ML

- Breeze Mobile

- modération

- modifier

- PLUS

- plusieurs

- prénom

- Nature

- Traitement du langage naturel

- Navigation

- Besoin

- Besoins

- Nouveauté

- nouvelles

- cahier

- numéros

- objet

- Détection d'objet

- of

- on

- d'exploitation

- de commander

- Autre

- autrement

- sortie

- global

- pain

- particulièrement

- chemin

- Personnes

- Effectuer

- effectue

- autorisations

- Personnalités

- Personnalisation

- Emplacement

- Plateformes

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Point

- politique

- Post

- défaillances

- préféré

- conditions préalables

- présence

- primaire

- traitement

- professionels

- projets

- fournit

- publier

- éditeur

- éditeurs

- Édition

- mettre

- Python

- vite.

- augmenter

- rapidement

- rapport

- reconnaissance

- reconnaître

- reconnu

- reconnaît

- recommander

- en relation

- reste

- répétitif

- représenté

- nécessaire

- conditions

- ressource

- Resources

- réponse

- résultat

- Résultats

- retourner

- ROI

- Rôle

- Roulent

- Courir

- sagemaker

- Épargnez

- économie

- But

- les sections

- service

- mise

- plusieurs

- devrait

- montrer

- montré

- étapes

- Taille

- plus intelligents

- So

- Réseaux sociaux

- réseaux sociaux

- sur mesure

- Solutions

- RÉSOUDRE

- quelques

- vitesse

- Dépenses

- carré

- Déclaration

- Étapes

- stock

- arrêté

- storage

- Stories

- Histoire

- rationaliser

- tel

- convient

- Support

- Tâche

- équipe

- qui

- La

- leur

- Les

- Ces

- milliers

- trois

- порог

- fiable

- fois

- à

- top

- Total

- expérience unique et authentique

- prochain

- téléchargé

- utilisé

- variété

- divers

- version

- Vidéos

- vision

- walkthrough

- personne(s) regarde(nt) cette fiche produit

- façons

- WELL

- bien connu

- que

- qui

- largeur

- Wikipédia

- sera

- comprenant

- dans les

- sans

- activités principales

- workflows

- de travail

- pourra

- Vous n'avez

- Votre

- zéphyrnet